BentoML推出llm-optimizer开源框架:让LLM性能调优变简单?

目录

前言:LLM部署中“沉默的痛点”

一、“终结者”登场:`llm-optimizer`是什么?

二、核心功能拆解:`llm-optimizer`如何化繁为简?

2.1 自动化基准测试:告别繁琐的手动试错

2.2 约束驱动的优化:只看你真正需要的结果

2.3 性能预估:在开跑前就“预知未来”

2.4 结果可视化:让复杂的性能数据一目了然

三、实战场景:一个典型的优化流程是怎样的?

四、 `llm-optimizer`的真正价值:为谁解决了什么问题?

结语:LLM性能优化的“民主化”时代

🎬 攻城狮7号:个人主页

🔥 个人专栏:《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 BentoML推出llm-optimizer开源框架

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言:LLM部署中“沉默的痛点”

在人工智能领域,成功训练出一个强大的大型语言模型(LLM)只是完成了“上半场”。如何将这个模型高效地部署到实际生产环境中,提供稳定、快速的服务,才是决定其价值的“下半场”。而在这个下半场中,性能调优无疑是最令人头疼的环节之一。

对于许多开发者和运维工程师来说,这个过程就像是在进行一场“炼丹”:

(1)选择太多:我应该用vLLM还是SGLang作为推理后端?

(2)参数复杂:张量并行(TP)和数据并行(DP)怎么组合?批处理大小(Batch Size)设为多少最合适?预填充的分块大小(Chunked Prefill Size)应该是多少?

(3)目标矛盾:我想要低延迟,又想要高吞吐量,这两者往往是相互矛盾的,如何找到那个最佳的平衡点?

(4)过程繁琐:整个过程充满了大量的手动试错。工程师需要编写测试脚本,启动服务,运行客户端,记录数十个不同配置下的性能指标,然后将数据导入Excel表格,手动绘制图表进行分析……这个过程不仅耗时耗力,而且极度依赖个人经验。

最终,找到一个“最优”配置,往往带有几分运气的成分。这种复杂、低效且充满不确定性的工作,是阻碍LLM技术快速落地的一大障碍。

一、“终结者”登场:`llm-optimizer`是什么?

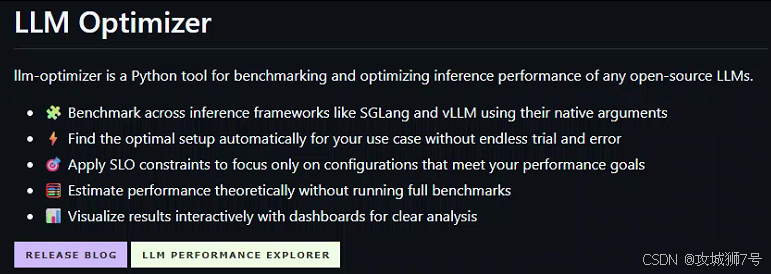

为了终结这种“炼丹玄学”,知名的开源AI应用框架团队BentoML推出了`llm-optimizer`。

简单来说,`llm-optimizer`是一个开源的Python工具,其核心目标只有一个:将LLM推理性能的基准测试和优化过程自动化、简单化、标准化。

它不是要创造一种新的推理引擎,而是要做一个“聪明的指挥官”。它能够调度现有的主流推理框架(如vLLM和SGLang),系统性地测试各种参数组合,并以最直观的方式将结果呈现给开发者,帮助他们快速做出明智的决策。

二、核心功能拆解:`llm-optimizer`如何化繁为简?

`llm-optimizer`通过四大核心功能,将原本复杂的调优工作,变成了一套清晰、高效的工程流程。

2.1 自动化基准测试:告别繁琐的手动试错

这是`llm-optimizer`最基础也最强大的功能。开发者不再需要手动编写循环测试脚本,只需通过一行命令,就能定义一个完整的“实验空间”。

例如,在文档的示例中,这样一行参数:

--server-args "tp_size*dp_size=[(1,4),(2,2),(4,1)];chunked_prefill_size=[2048,4096,8192]"`llm-optimizer`会自动将其解析为一个测试矩阵,它会遍历3种不同的并行策略和3种不同的预填充大小,总共9种服务器配置。如果客户端再设置3种不同的并发数,那么它就会自动地、无人值守地完成全部27次基准测试,并将结果结构化地保存在一个JSON文件中。

这种“声明式”的测试方法,将工程师从重复的体力劳动中解放了出来。

2.2 约束驱动的优化:只看你真正需要的结果

在进行性能测试时,并非所有结果都有意义。例如,一个吞吐量极高的配置,如果它的首次响应时间(TTFT)长达5秒,那么对于一个实时聊天机器人应用来说,这个结果是完全不可接受的,属于“无效配置”。

`llm-optimizer`深刻理解这一点,因此引入了约束条件(Constraints)功能。开发者可以在运行时设定自己的服务等级目标(SLO)。

例如,一个 latency (延迟) 优先的场景,可以这样设置:

--constraints "ttft:median<300ms;itl:p99<50ms"这行命令告诉`llm-optimizer`:我只关心那些“首个token响应时间的中位数小于300毫秒”,并且“后续token生成延迟的99分位数小于50毫秒”的配置。

工具会自动过滤掉所有不满足这些条件的测试结果。这样一来,开发者就可以从海量的可能性中,精准地聚焦于那些对业务真正有价值的、可行的配置方案。

2.3 性能预估:在开跑前就“预知未来”

完整的基准测试虽然精确,但仍然需要消耗宝贵的GPU时间和计算资源。有时候,我们只想快速地对不同硬件、不同模型的性能有一个大致的了解。

为此,`llm-optimizer`提供了一个极其有用的`estimate`(预估)命令。通过理论计算,它可以快速预测出某个模型在特定GPU(如A100, H100)上的大致性能表现,包括延迟、吞吐量和并发极限等。

这个功能就像一个“水晶球”,让开发者在投入实际资源进行详细测试之前,就能对方案的可行性进行初步判断和规划,极大地提高了决策效率。

2.4 结果可视化:让复杂的性能数据一目了然

当几十上百次测试完成后,开发者会得到一个包含大量数据的JSON文件。直接阅读这些数字是枯燥且低效的。

`llm-optimizer`内置了一个交互式可视化工具。开发者只需一条命令,就能启动一个本地Web服务,在浏览器中以图表的形式直观地探索测试结果。

其中最有价值的是帕累托前沿(Pareto Frontier)分析图。这个图表清晰地展示了“延迟”与“吞吐量”这两个核心指标之间的权衡关系。开发者可以直观地看到,哪些配置在牺牲最少延迟的情况下获得了最大的吞吐量提升。通过交互式的图表,找到那个最符合自己业务需求的“最佳平衡点”,变得前所未有的简单。

三、实战场景:一个典型的优化流程是怎样的?

假设一个团队需要为一个在线编程助手部署`Llama-3.1-8B-Instruct`模型,他们有4台H100 GPU,业务要求是首token延迟必须低于300毫秒。

使用`llm-optimizer`的流程会是这样的:

(1)初步预估:先运行`llm-optimizer estimate`命令,输入模型、GPU配置和约束条件,快速了解在该硬件上达成目标的可能性,并获得一些推荐的参数范围。

(2)定义测试空间:根据预估结果,编写一条`llm-optimizer`基准测试命令。在`--server-args`中定义不同的张量并行组合(如`(1,4), (2,2), (4,1)`),在`--client-args`中设置不同的并发用户数。

(3)执行自动化测试:运行命令,然后去喝杯咖啡。`llm-optimizer`会自动完成所有的测试,并将满足`ttft<300ms`约束的结果保存下来。

(4)可视化分析:测试完成后,运行`llm-optimizer visualize`命令,在浏览器中打开仪表盘。

(5)决策:在帕累托前沿图上,找到在满足延迟约束的前提下,吞吐量最高的那个配置点,查看其对应的具体参数,完成决策。

整个过程从几天甚至几周的手动劳动,被缩短到了几个小时的自动化流程。

四、 `llm-optimizer`的真正价值:为谁解决了什么问题?

`llm-optimizer`的问世,其核心价值在于降低了高性能LLM部署的技术门槛。

它尤其对以下群体意义重大:

(1)中小型企业和团队:他们通常没有庞大的运维团队和无限的GPU预算去进行漫长的手动调优。`llm-optimizer`让他们能以极低的成本,获得企业级的性能优化能力。

(2)应用开发者:他们更关心业务逻辑而非底层性能。这个工具让他们可以不必成为性能专家,也能为自己的应用找到一个高效的部署方案。

(3)MLOps工程师:他们可以利用`llm-optimizer`将性能测试和调优流程标准化,并集成到CI/CD流水线中,实现持续的性能监控和优化。

结语:LLM性能优化的“民主化”时代

`llm-optimizer`的出现,是LLM工具链生态走向成熟的重要标志。它代表了一种趋势:将那些过去依赖于少数专家“手艺”的复杂工作,通过设计精良的工具,转变为标准化的、自动化的工程问题。

通过消除繁琐的手动试错,提供清晰的决策依据,`llm-optimizer`正在推动LLM性能优化的“民主化”。它让更多的开发者能够跨越部署的鸿沟,将强大的AI模型真正应用到千行百业中去。在这个充满竞争的人工智能时代,这样的工具正是加速创新的关键催化剂。

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!