IEEE TGRS 2025 | 突破小波U-Net局限,ASCNet实现更精准的红外去条纹!

红外成像系统在安防监控、海洋监视等领域应用广泛,但其固有的成像机制常导致图像出现列条纹噪声,严重影响图像质量和下游任务(如目标检测)的性能。

现有去条纹方法,特别是基于U型网络的模型,普遍存在两大挑战:1)解码器(升采样器)的先验假设与编码特征的实际噪声分布不匹配,导致跨层级的语义鸿沟;2) 未能充分建模条纹噪声的全局列特征,难以将其与背景中的垂直结构精确分离。针对这些问题,本文提出了一种新颖的红外图像去条纹网络——非对称采样校正网络(ASCNet)。该网络通过创新的非对称采样结构和全局列特征增强模块,实现了对条纹噪声的精准解耦。具体地,ASCNet采用**残差哈尔离散小波变换(RHDWT)作为下采样器,融合了条纹方向先验与数据驱动的语义信息;同时,采用像素重组(Pixel Shuffle, PS)作为上采样器,避免了固定的先验解码,从而保留了列维度语义的连续性。此外,设计的列非均匀性校正模块(CNCM)**通过建立列、空间和自依赖的长程关系,有效增强了全局列特征。实验证明,ASCNet在合成与真实数据集上均超越了现有技术。

另外,我整理了TPAMI 2025 CV相关论文合集,一共227篇。感兴趣的可以dd!希望能帮到你~

原文、姿.料 这儿~

一、论文基本信息

基本信息

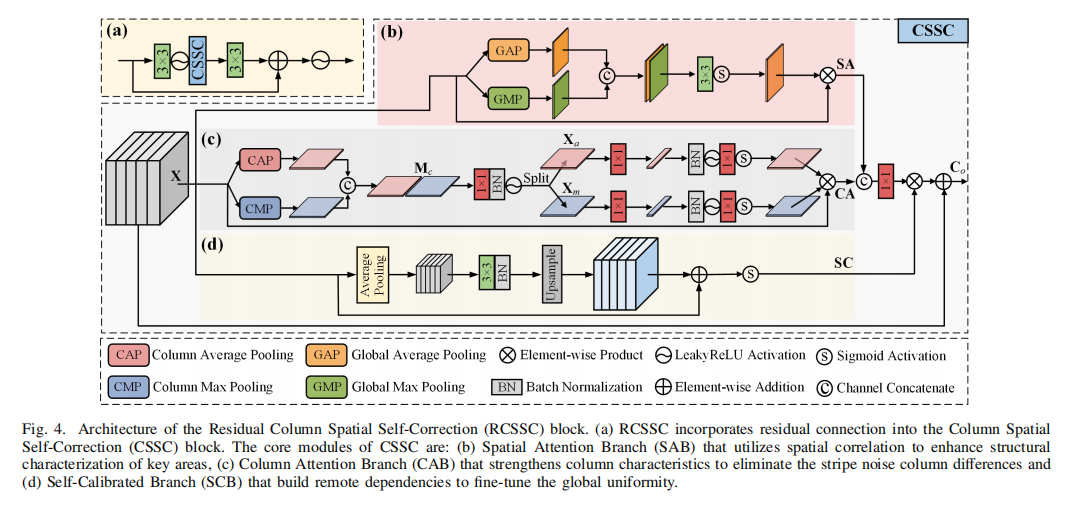

- 论文标题:ASCNet: Asymmetric Sampling Correction Network for Infrared Image Destriping

- 作者:Shuai Yuan, Hanlin Qin, Xiang Yan, Shiqi Yang, Shuowen Yang, Naveed Akhtar, Huixin Zhou

- 作者单位:Xidian University, The University of Melbourne

- 代码链接:https://github.com/xdFai/ASCNet

- 论文链接:https://arxiv.org/pdf/2401.15578v3

摘要精炼

本文旨在解决红外图像去条纹任务中的两大核心问题:现有U型网络中的跨层级语义鸿沟以及对全局列特征的表征不足。为此,论文提出了一种名为非对称采样校正网络(ASCNet) 的深度学习模型。

其核心技术贡献在于一个创新的非对称U型框架,该框架包含三个关键组件:1) 残差哈尔离散小波变换(RHDWT),一种新型下采样器,它并行地融合了条纹的方向先验知识和数据驱动的语义交互,以丰富特征表示;2) 像素重组(Pixel Shuffle, PS),作为上采样器,避免了带有强先验假设的解码,从而实现了无语义偏差的图像重建;3) 列非均匀性校正模块(CNCM),该模块通过捕捉长程依赖关系中的列、空间和自依赖信息,有效地区分条纹与场景的垂直结构。论文的关键结论是,ASCNet在合成和真实数据集上的去条纹效果,无论是在视觉质量还是定量指标上,均显著优于当前最先进的单图像去条纹方法,并能提升下游红外小目标检测任务的性能。

二、研究背景与相关工作

研究背景

红外(IR)成像系统在军事、安防和工业领域至关重要。然而,由于焦平面阵列(FPA) 探测器单元响应不一致以及其独特的列式信号读出机制,红外图像普遍存在垂直的条纹噪声。这种噪声不仅降低了图像的视觉质量,还严重干扰了后续的计算机视觉任务,如红外小目标检测(IRSTD)。传统的去条纹方法,如基于滤波、统计或优化的模型,过分依赖手工设计的先验,在复杂场景下效果有限。因此,开发一种能够精确区分并去除条纹噪声,同时完好保留图像细节的深度学习模型,是当前该领域面临的核心挑战和迫切需求。

相关工作

现有的去条纹方法主要分为两类。模型驱动方法利用条纹的结构特性,通过滤波、总变分或稀疏表示等手段进行分离,但这些方法通常难以处理复杂场景和多变的噪声模式。学习驱动方法,特别是基于CNN的模型,展现了更强的特征表达能力。

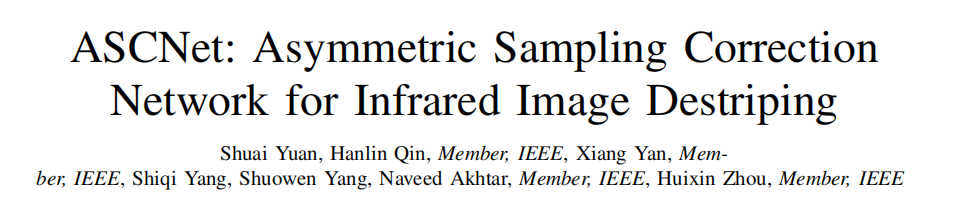

早期的CNN模型感受野有限,而后续的残差网络、多尺度U型网络和注意力机制虽有改进,但仍存在局限。尤其是在采用离散小波变换(DWT) 作为 U 型网络采样器的方案中,虽然DWT能有效分解条纹的方向特征,但其对应的逆离散小波变换(IDWT) 上采样器带有固定的重构先验,当特征经过卷积层混合后(语义串扰),这种先验会破坏特征的列语义连续性,导致去条纹不彻底或引入伪影。本文方法正是为了解决这一特定问题而提出的。

三、主要贡献与创新

1. 提出非对称采样校正网络(ASCNet)

设计了一种新颖的非对称采样U型网络架构。通过创新的采样器组合与特征校正模块,实现了连续的列语义建模和对全局列关系的全面表示,从而精确地将条纹噪声与背景场景分离开。

2. 引入像素重组(PS)以解决语义鸿沟

针对传统小波U型网络中存在的语义串扰问题,首次将像素重组(Pixel Shuffle)作为上采样器引入红外图像去条纹任务。PS不依赖固定的线性计算,有效弥合了跨层级的列语义鸿沟,实现了无语义偏差的稳定图像恢复。

3. 设计残差哈尔离散小波变换(RHDWT)

提出了一种新型的下采样器RHDWT。它并行地结合了基于模型的哈尔小波变换(HDWT)(提供条纹方向先验)和基于数据的残差卷积(提供跨通道语义交互),从而实现了对条纹特征的更全面描述。

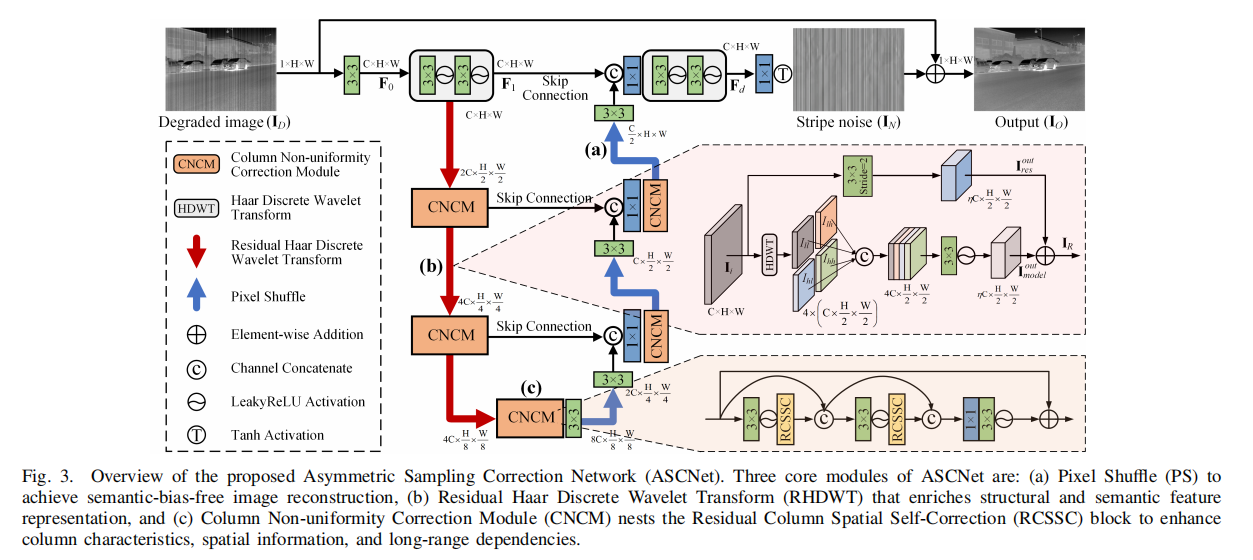

4. 构建列非均匀性校正模块(CNCM)

设计了CNCM模块,通过融合长程的列均匀性、空间相关性和自依赖信息,能够充分捕捉全局上下文中的列特征模式,从而有效增强特征,更好地区分条纹与图像的自然垂直纹理。

四、研究方法与原理

总体框架与核心思想

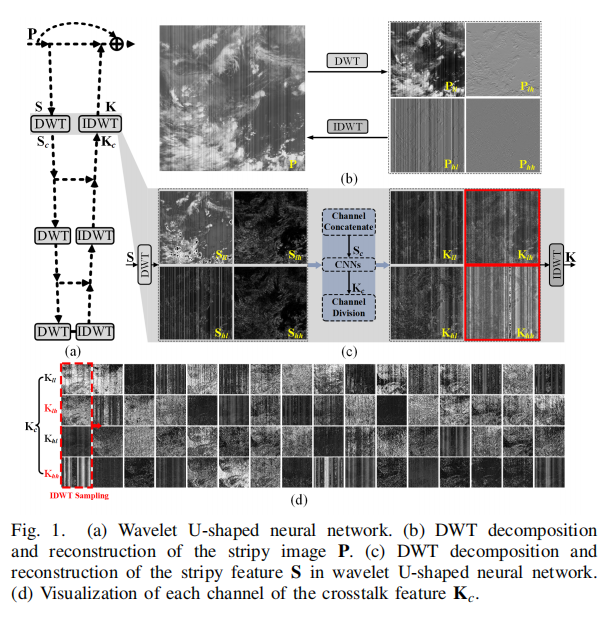

ASCNet的总体框架是一个经过精心设计的非对称U型编解码网络,其核心思想是在下采样时充分利用条纹的方向先验,在特征增强时聚焦全局列信息,在上采样时保持列语义的连续性。

如上图所示,其设计哲学可以概括为“非对称处理”和“分阶段精细校正”:

- 非对称采样:编码器(下采样)采用本文提出的RHDWT模块,它结合了小波变换的方向分解能力和标准卷积的语义捕捉能力。解码器(上采样)则采用Pixel Shuffle,它直接通过像素重排来恢复分辨率,避免了IDWT等方法中固有的、可能与编码特征不匹配的线性重构先验,从而解决了语义鸿沟问题。

- 分阶段精细校正:在网络的编码、解码以及跳跃连接的各个阶段,都嵌入了CNCM模块。该模块专门用于分析和增强特征图中的列特性,确保在不同尺度下都能有效抑制条纹噪声,同时保留有用的图像结构。

关键实现与评估原理

关键实现细节

-

RHDWT实现: 该模块由两个并行分支构成。给定输入特征 IiI_iIi,输出 IRI_RIR 的计算方式为:

IR=fδ3×3([Φ(Ii)])+fs=23×3(Ii)I_R = f_{\delta}^{3\times3}([\Phi(I_i)]) + f_{s=2}^{3\times3}(I_i) IR=fδ3×3([Φ(Ii)])+fs=23×3(Ii)

其中,Φ(⋅)\Phi(\cdot)Φ(⋅) 代表HDWT操作,它将特征分解为四个子带并拼接;fδ3×3(⋅)f_{\delta}^{3\times3}(\cdot)fδ3×3(⋅) 是一个3x3卷积层,用于融合子带信息(模型驱动分支);fs=23×3(⋅)f_{s=2}^{3\times3}(\cdot)fs=23×3(⋅) 是一个步长为2的3x3卷积(残差分支),用于捕捉数据驱动的语义。 -

CNCM实现: 该模块的核心是残差列空间自校正(RCSSC) 块。RCSSC包含三个关键分支:

- 列注意力分支(CAB):对特征图按列进行全局平均池化和最大池化,以捕捉列的整体统计特性,生成列注意力权重,强化列间一致性。

- 空间注意力分支(SAB):采用标准的通道维度池化,生成空间注意力图,用于增强关键区域的结构特征。

- 自校正分支(SCB):通过下采样、卷积和上采样操作,建立特征图内部的长程依赖关系,利用低分辨率的全局上下文来校准原始分辨率的特征。

核心评估原理与指标

- 有参考评估:对于合成噪声图像,采用业界标准的峰值信噪比(PSNR) 和 结构相似性指数(SSIM) 作为核心评估指标。PSNR衡量像素级别的重建误差,SSIM衡量结构、亮度和对比度的相似性,二者越高表示去条纹效果越好。

- 无参考评估:对于真实世界的条纹图像(无干净参考),采用粗糙度指数(ρ) 和 自然图像质量评估器(NIQE)。ρ越低表示图像越平滑(条纹越少),NIQE越低表示图像的统计特性越接近自然图像。

五、实验结果与分析

实验设置

- 数据集: 训练集包含从ICSRN、INFRARED和CVC09三个公开红外数据集中选取的共270张图像,通过数据增强生成了18万个训练块。测试集包含来自这三个数据集的75张图像。

- 评估指标: PSNR, SSIM, ρ, NIQE。

- 对比基线: 包含10种SOTA方法,如GF、UTV(传统方法)和DMRN、TSWEU、Restormer、DSCGAN(深度学习方法)。

- 关键超参: 模型基础通道数设置为32,使用Adam优化器,初始学习率为0.001,采用余弦退火策略调整,训练100个epoch。

核心实验与结论

【指令】: 仅选择一项最能体现本文贡献的核心实验进行阐述。

- 实验目的: 该实验旨在全面、定量地验证ASCNet在多种合成条纹噪声下,相较于其他SOTA方法的优越性。这是评估模型性能和泛化能力最直接的证据。

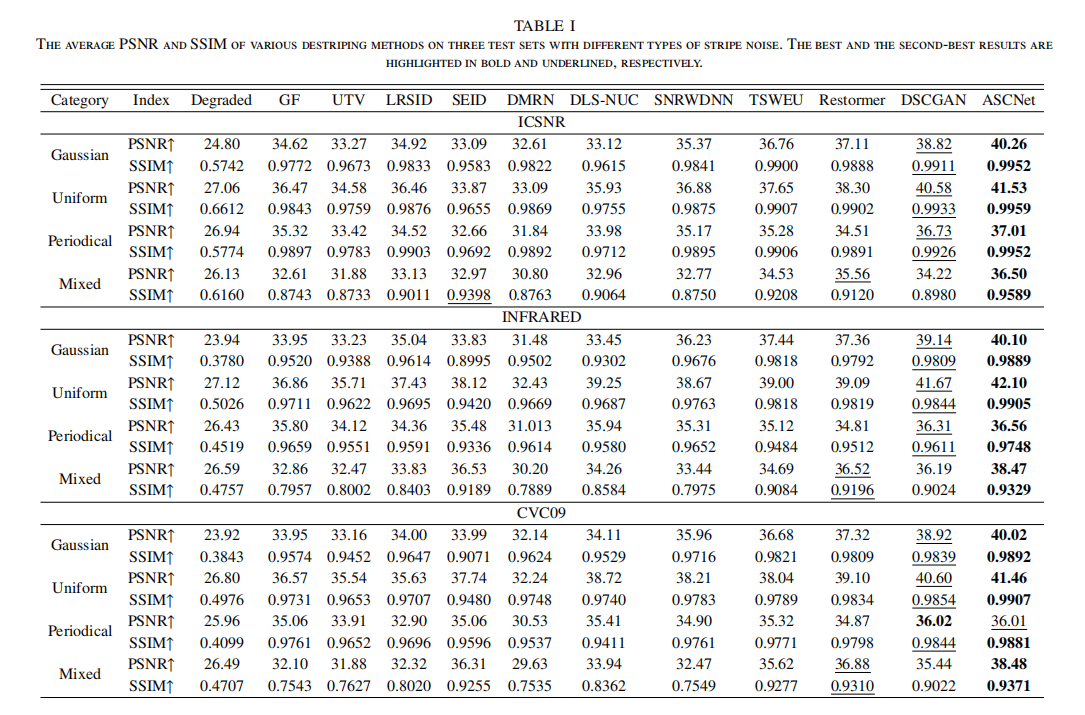

- 关键结果: 实验在ICSRN、INFRARED和CVC09三个测试集上,分别对高斯、均匀、周期性和混合四种噪声类型进行了测试。结果如表I 所示,ASCNet在所有12个测试场景中均取得了最高的PSNR和SSIM值。例如,在INFRARED数据集和均匀噪声下,ASCNet的PSNR达到42.10dB,比次优的DSCGAN高出0.43dB,比著名的Restormer高出3.01dB。在更具挑战性的混合噪声场景下,ASCNet的优势同样显著,表明其强大的噪声抑制和细节保持能力。

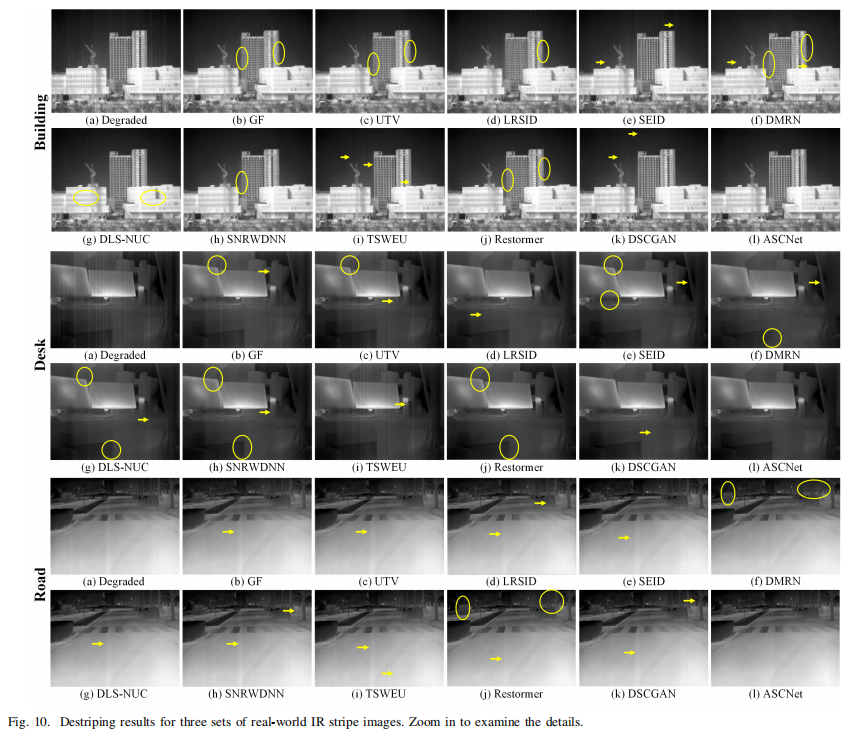

- 作者结论: 作者基于这些压倒性的定量结果得出结论:ASCNet通过其独特的非对称采样架构和列校正机制,能够比现有方法更有效地去除各种类型的条纹噪声。无论噪声分布如何,ASCNet都能稳健地恢复出更接近原始图像的高质量结果,证明了其设计的有效性和先进性。在真实场景的测试中(如上图所示),ASCNet也展现了最佳的视觉效果和最优的NIQE指标,进一步证实了其在实际应用中的泛化能力。

六、论文结论与启示

总结

本文成功识别并解决了红外图像去条纹领域中,基于小波U型网络存在的“语义串扰”和“列特征建模不足”的核心痛点。通过提出一个创新的非对称采样校正网络(ASCNet),论文构建了一条清晰的技术路线:利用RHDWT下采样器融合先验与数据驱动信息进行有效编码,借助Pixel Shuffle上采样器避免语义偏差以实现精确解码,并贯穿全程使用CNCM模块来精细化校正全局列特征。

从问题定义、方法创新到实验验证,整个逻辑链条完整且有力。大量的定量和定性实验结果,以及在下游任务上的应用验证,均证明了ASCNet相较于现有最先进方法的卓越性能和实用价值。

展望

论文的结论部分主要聚焦于对本文工作的总结和成果的强调,未明确提出未来的研究方向。但基于其研究内容,可以得到的启示是:

- 采样器设计的再思考:非对称采样策略的成功表明,针对特定任务(如去条纹)设计专用的下采样/上采样器,而非直接套用通用结构,是提升模型性能的有效途径。

- 长程依赖建模的重要性:CNCM模块的有效性突显了在图像复原任务中,建立跨越整个特征图的全局依赖关系对于区分噪声和信号的重要性。未来可探索更高效的长程依赖建模机制。