【图文】Codex接入Kimi K2/GLM-4.5 环境配置指南 (Windows/macOS/Ubuntu)

Codex接入Kimi K2/GLM-4.5 环境配置指南 (Windows/macOS/Ubuntu)

本指南将引导您完成安装 Codex ,并通过API方式配置 Kimi K2、GLM-4.5 模型,以更实惠的方式来AI编程。

1、安装 Node.js

在开始之前,您的系统需要安装好 Node.js。

-

下载与安装:请前往 Node.js 官方网站 下载并安装最新版本的 Node.js(建议使用 v18 或更高版本)。根据您的操作系统下载对应的安装包。

-

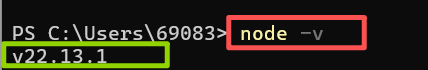

验证安装:安装完成后,打开您的终端(Terminal)或命令提示符(CMD),运行以下命令来验证。

node -v如果成功安装,将会显示 Node.js 的版本号(如图绿框中的)。

2、安装 Codex

接下来,我们将全局安装 Codex NPM 包。此步骤在不同操作系统下的主要区别在于是否需要管理员权限。

注意:为了获得最佳的安装体验,建议连接稳定的网络环境(例如使用科学上网)运行安装命令。

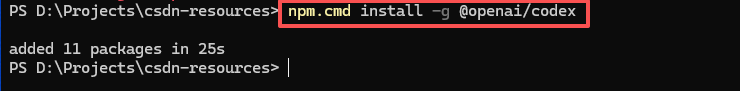

2.1、Windows

-

- 以 管理员身份 打开您的 命令提示符(CMD) 或 PowerShell。

-

- 输入并运行以下安装命令:

npm install -g @openai/codex

- 输入并运行以下安装命令:

2.2、macOS / Ubuntu

-

- 打开您的 终端(Terminal)。

-

- 由于全局安装

npm包需要系统权限,您需要在命令前加上sudo。

- 由于全局安装

-

- 输入并运行以下安装命令(过程中会提示您输入电脑的登录密码):

sudo npm install -g @openai/codex

- 输入并运行以下安装命令(过程中会提示您输入电脑的登录密码):

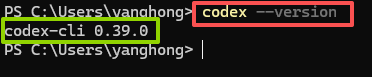

2.3、验证安装 (所有系统通用)

- 安装完成后,在 新的终端窗口 中运行以下命令来验证。(旧的窗口也许可以,建议新的哈)。

如果终端成功返回版本号,则代表codex--versionCodex已成功安装(绿框中的)。

3、获取API Key

Codex 安装成功,这时它还不能工作,因为需要登录官方或者其他模型厂商才可以。

我没有订阅GPT,因为太贵了,所以我选择了 Kimi K2和GLM-4.5的 API 来驱动Codex。

因此我们先去获取Kimi K2和GLM-4.5 的 API Key来登录。

你可以把这个API Key理解成访问密码,访问模型时需要用到这个密码哦。

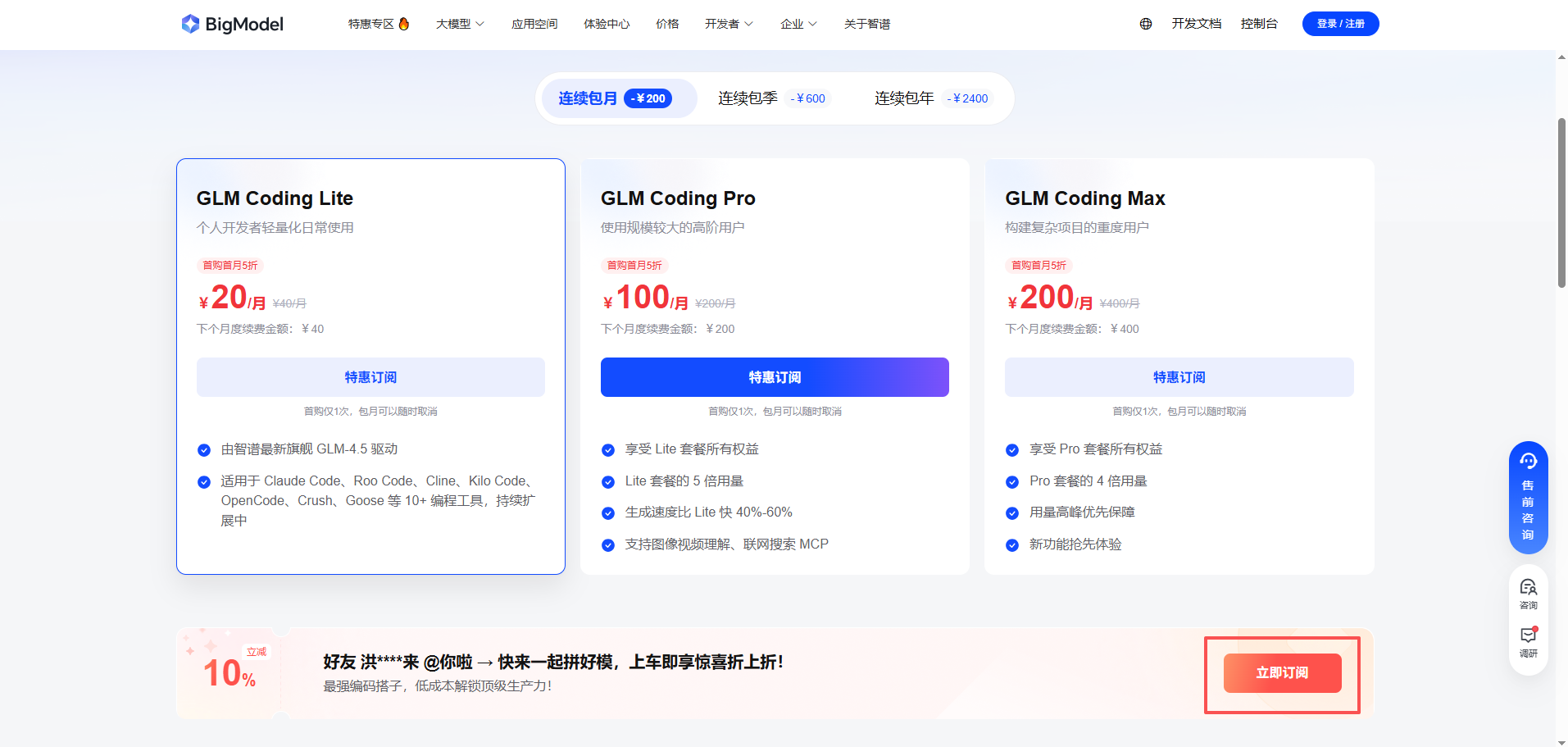

3.1、获取GLM-4.5 API Key

- 前往 智谱AI开放平台:智谱AI开放平台

- 创建账号并登录,系统会赠送2000万token供你试用。更建议选择月卡订阅,我自己买的20元/月的试用,日常开发足够。后续考虑升级成季度订阅~ 选择图中的立即订阅,还可以再优惠10%

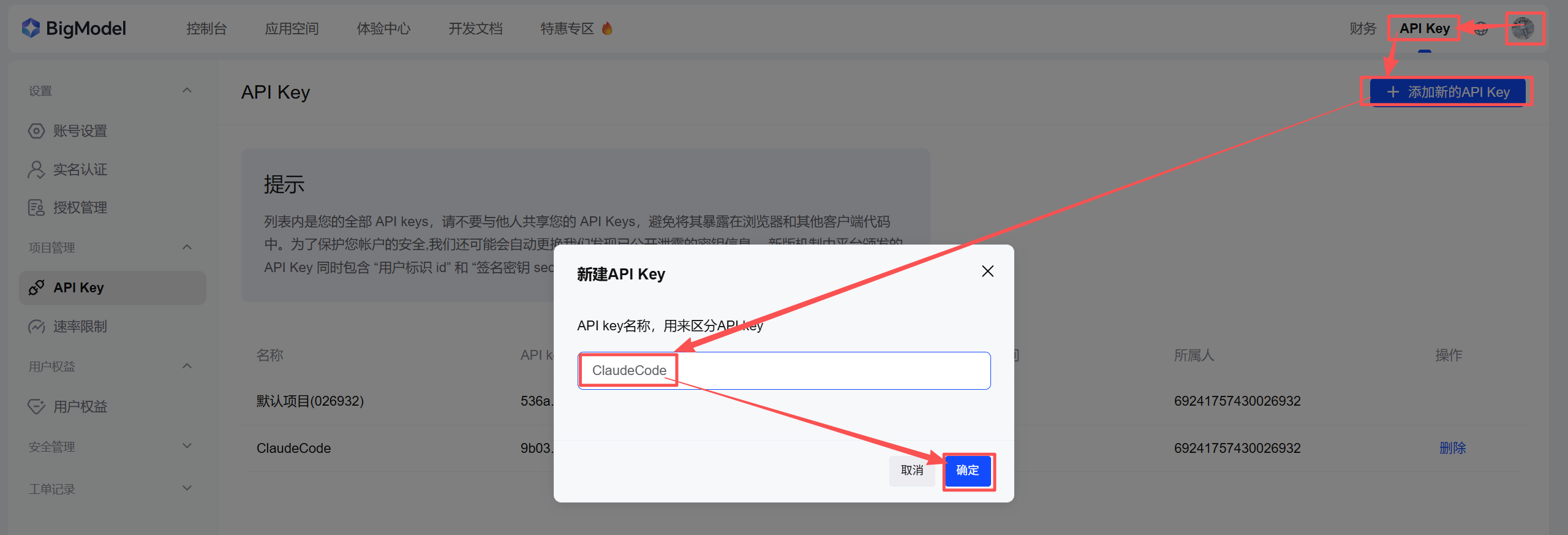

- 登录后按顺序点击:右上角的头像 -> API key -> 添加新的API key -> 输入一个名字来标识这个key -> 确定。

- 申请成功后点击一下API key的复制按钮,把key复制到剪贴板中给后续使用。

3.2、获取Kimi K2 API Key

-

前往 Moonshot AI开放平台: Moonshot AI开放平台。

-

注册与登录:如果您没有账户,请先注册一个新账户并登录。

-

创建 API Key:在平台仪表盘中,找到创建 API Key 的选项。

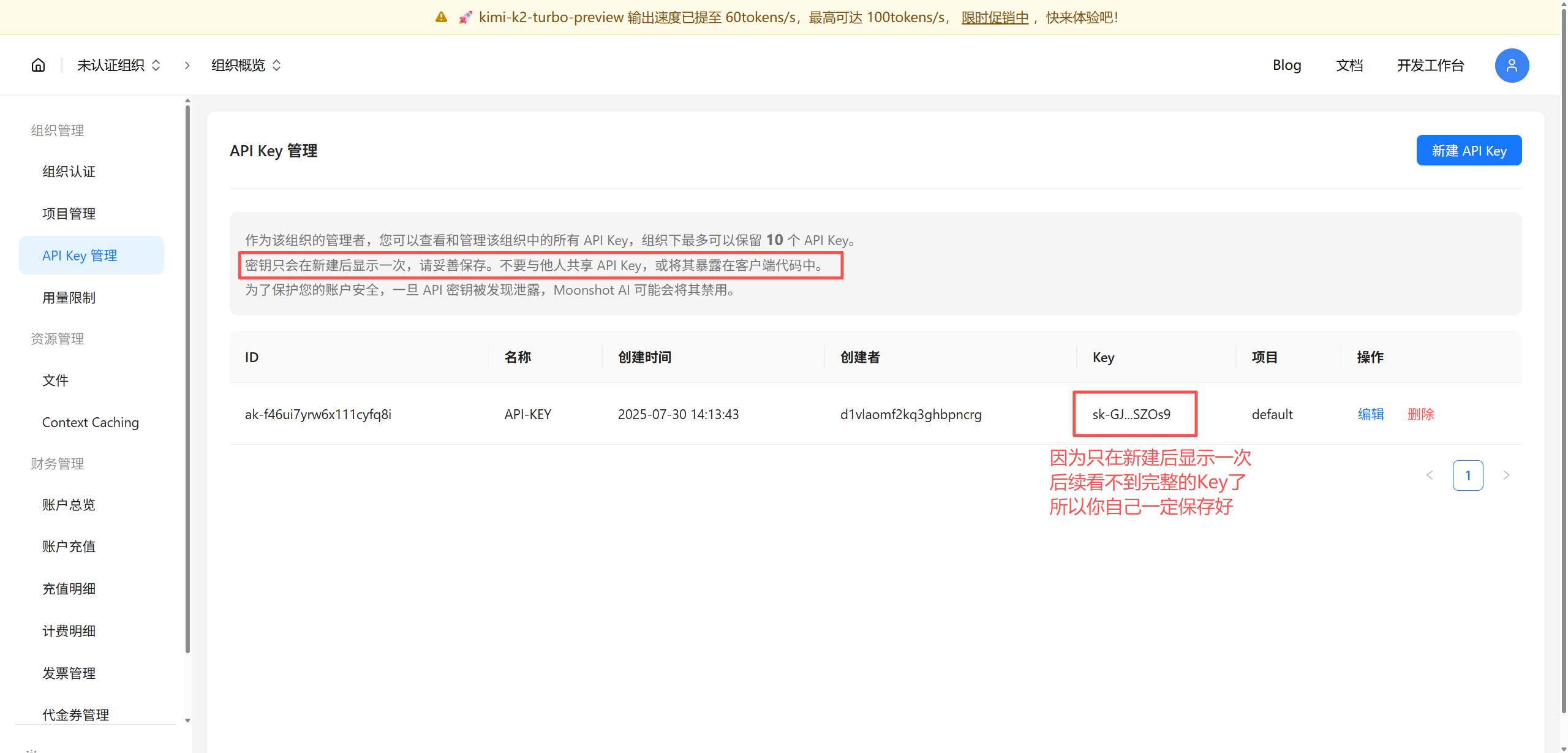

- 重要提示:API Key 在创建后只会显示一次,请务必立即复制并妥善保存。

- 重要提示:API Key 在创建后只会显示一次,请务必立即复制并妥善保存。

-

关于费用:

- 新用户通常会获赠少量免费额度(例如 15 元)供测试使用。

- 若要长期或高频率使用,建议充值至少 50 元,以解锁更高的请求速率(RPM),从而获得更流畅的体验。

4、配置环境变量

万事俱备,只欠东风!为了让 Codex 能够成功连接到 Kimi K2和GLM-4.5,我们需要配置环境变量到Codex。

4.1、Windows

您可以选择以下任一方法进行配置:

-

方法一:使用命令提示符

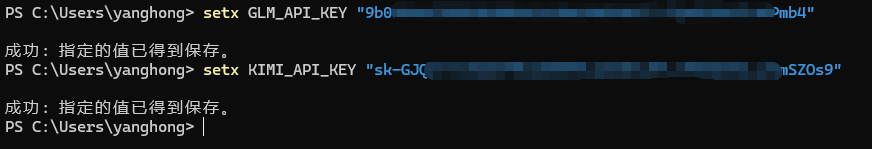

打开命令提示符(无需管理员),并执行以下两条命令。请确保将"你的GLM_API_Key"、"你的Kimi_API_Key"替换为您真实的 API Key。替换后重启一下终端。setx GLM_API_KEY "你的GLM_API_Key" setx KIMI_API_KEY "你的Kimi_API_Key"注意:使用

setx设置的变量需要 重启终端 才会生效。建议关闭所有终端,然后再打开一个新的。

注意:使用setx设置的变量需要 重启终端 才会生效。建议关闭所有终端,然后再打开一个新的。

注意:使用setx设置的变量需要 重启终端 才会生效。建议关闭所有终端,然后再打开一个新的。

-

方法二:使用系统属性面板

- 在 Windows 搜索栏中输入“环境变量”,并选择“编辑系统环境变量”。

- 在“系统属性”窗口中,点击“环境变量…”。

- 在“系统变量”区域,点击“新建…”,并添加两个新变量。

4.2、macOS / Ubuntu

在 macOS 和 Ubuntu 系统中,环境变量通常配置在 Shell 的配置文件中。

-

确定您的 Shell 类型

在终端中运行echo $SHELL。- 如果输出包含

zsh,您的配置文件是~/.zshrc。 - 如果输出包含

bash,您的配置文件是~/.bashrc。

- 如果输出包含

-

编辑配置文件

使用您喜欢的文本编辑器打开对应的文件。这里以nano为例(一个对新手友好的终端编辑器)。# 如果您使用 Zsh (macOS 默认) nano ~/.zshrc# 如果您使用 Bash nano ~/.bashrc -

添加环境变量

在文件的末尾,添加以下两行。请将你的Kimi_API_Key替换为您真实的 API Key。export GLM_API_KEY="你的GLM_API_Key" export KIMI_API_KEY="你的Kimi_API_Key"添加后,按下

Ctrl + O保存文件,然后按Ctrl + X退出编辑器。 -

使配置生效

运行以下命令让配置立即生效(或直接重启终端)。# 如果您修改了 .zshrc source ~/.zshrc# 如果您修改了 .bashrc source ~/.bashrc

5、运行并配置 Codex

好,到此所有准备工作已经完成!让我们启动 Codex 吧!

-

打开一个新的终端窗口。

-

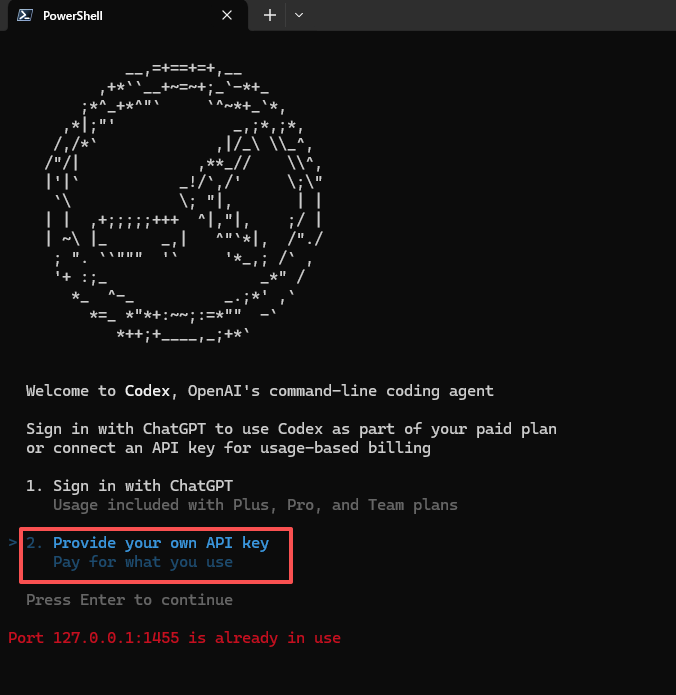

输入

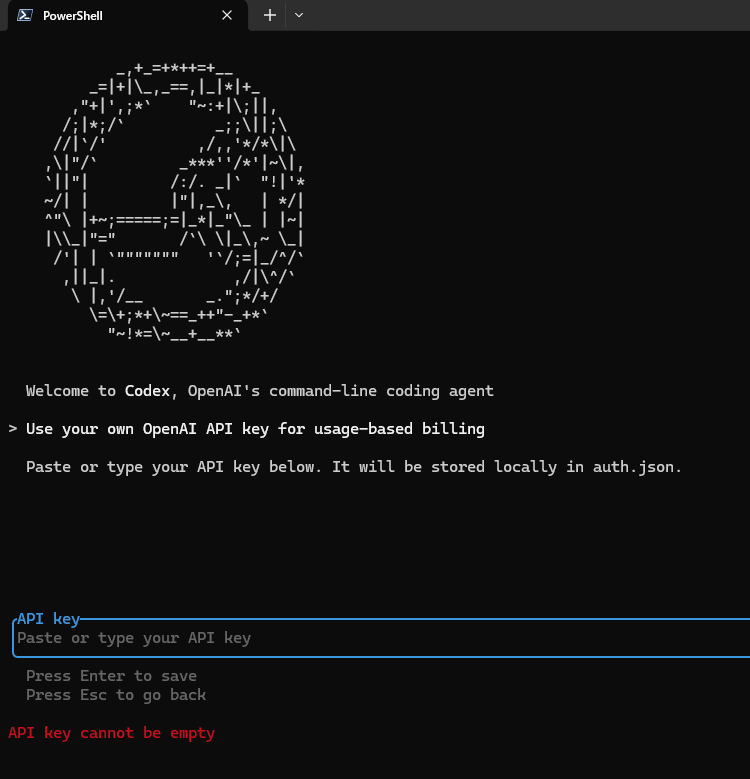

codex命令,你会看到让你选择登录方式,我们这里需要按方向键切换到2. Provide your own API key,回车确认:codex

-

紧接着让你输入API Key,注意这里是输入的GPT官方的API Key,我们胡乱输一个确认即可:

-

然后打开

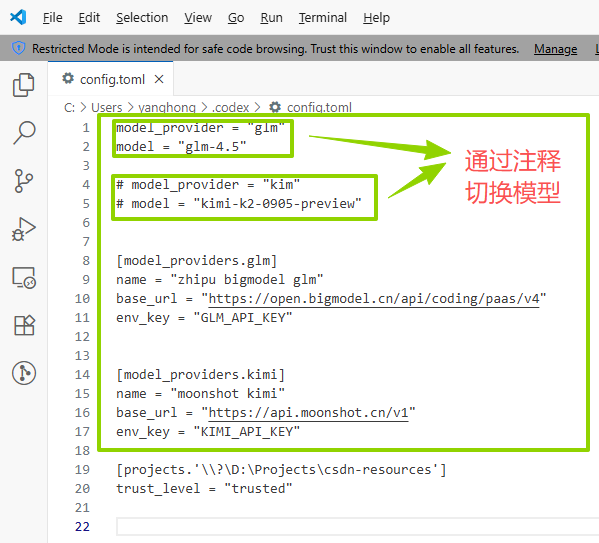

~/.codex/config.toml文件(windows在C:\Users\你的用户名\.codex\config.toml),这里我使用vscode来打开并编辑,直接复制粘贴以下内容并保存,这里我使用GLM-4.5的模型,你要用kimi的话就把glm注释掉,然后把kimi打开:model_provider = "glm" model = "glm-4.5"# model_provider = "kimi" # model = "kimi-k2-0905-preview"[model_providers.glm] name = "zai" base_url = "https://open.bigmodel.cn/api/coding/paas/v4" env_key = "GLM_API_KEY"[model_providers.kimi] name = "kimi" base_url = "https://api.moonshot.cn/v1" env_key = "KIMI_API_KEY"

-

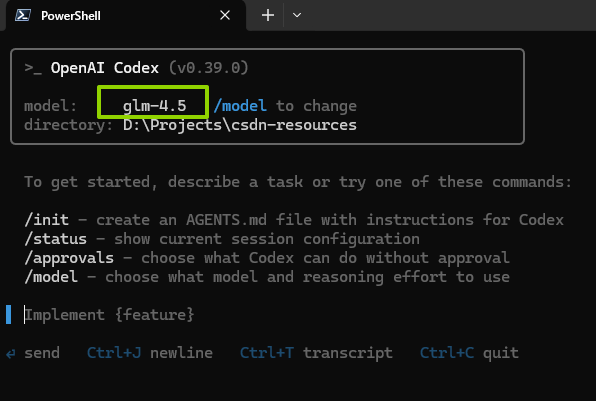

接着退出Codex,重新进入一下。一定要退出重进,因为我们刚改了配置嘛,需要让Codex重新加载~再次进入Codex,可以看到模型是GLM-4.5了:

-

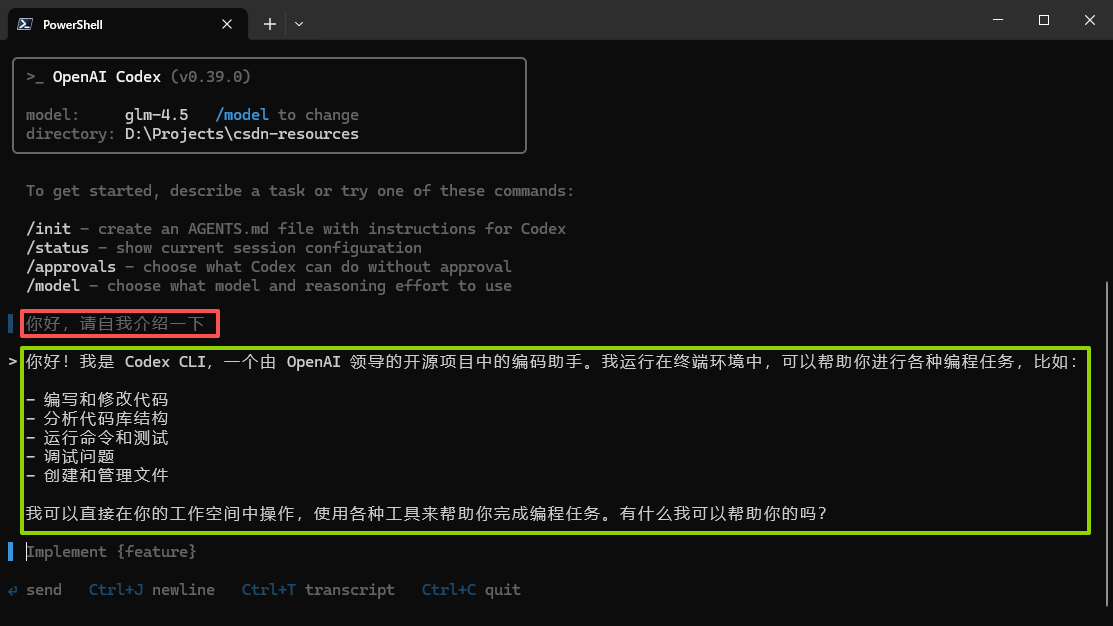

我们让他自我介绍一下,如果收到回复,就证明配置正确了(如图绿色框的回复)。

6、FAQ

6.1、登录报错

- 可能在第4步 配置环境变量 出错,需要注意windows命令行需要全部关闭,后续新开的才会生效。

- 文章示例的GLM-4.5使用的是包月计划对应的base_url,如果你没有订阅包月套餐就会报错,可以点击这个链接包月:GLM 编程神器包月套餐·限时优惠-10%

- 如果你只是想试用GLM-4.5,可以把Codex的配置文件中glm的base_url改为:

https://open.bigmodel.cn/api/paas/v4/

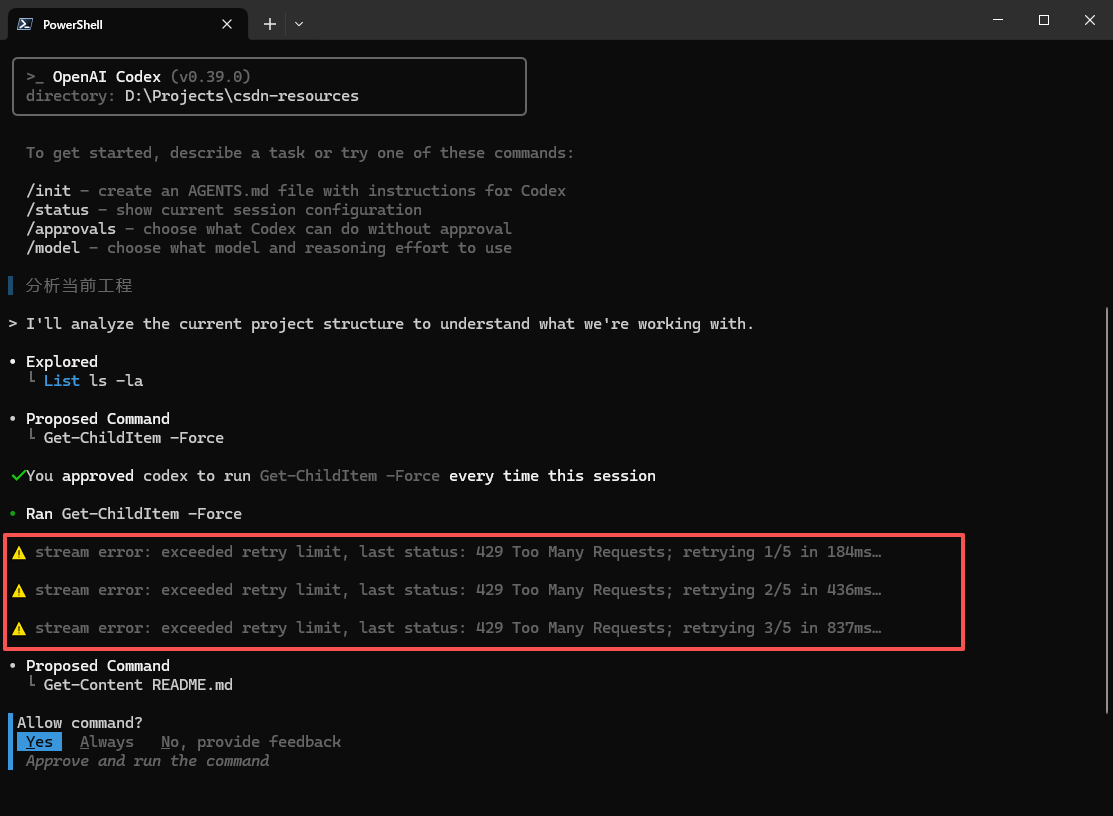

6.2、使用KIMI K2对话报错或警告

使用KIMI模型时,向AI发送消息后,Codex会提示一些错误或警告, 比如这样:

这个原因是你没有氪金,Kimi官方赠送的免费额度每秒只能访问3次,而 Codex 会根据内置策略来多次调用api,很容易就超过每秒3次。

解决方案也很简单,氪金50块钱可以解决,哈哈哈哈。自己抉择吧~!

6.3、其他模型可以通过API接入吗

- 可以,类似glm和kimi,比如deepseek,你可以去deepseek官网申请对应的api key并氪金,然后按照这篇教程配置进来。deepseek传送门:DeepSeek 开方平台 。

6.4、官方的配置文档参考

- config配置:https://github.com/openai/codex/blob/main/docs/config.md

- mcp配置:https://github.com/openai/codex/blob/main/docs/advanced.md#model-context-protocol-mcp