【论文阅读】 WebDancer: Towards Autonomous Information Seeking Agency

https://arxiv.org/pdf/2505.22648

阿里“WebDancer”揭秘:从零训练会自己翻网页、做推理的AI Agent

当大模型只会“被动答题”已不够,阿里通义实验室最新论文《WebDancer》给出一条“从数据到算法”的端到端配方,让开源模型也能像OpenAI Deep Research一样,自主规划、翻网页、多跳推理,完成复杂信息检索任务。文章提出四大阶段:①自动合成高难度QA对(CRAWLQA+E2HQA),②用强模型采样“短/长思维链”轨迹,③监督微调做冷启动,④用改进的DAPO强化学习做在线优化。实验在GAIA、WebWalkerQA两大深度检索 benchmark 上刷新开源纪录:7B 模型从18.4%→31.0%,32B 模型从31.0%→40.7%,QwQ-32B 版本更以51.5% 超越 GPT-4o 的34.6%,首次证明“小”开源模型靠数据+两阶段训练也能逼近闭源深度研究系统。文中还给出中文 BrowseComp-zh 测试,WebDancer 将基线 6.2% 拉到 18.0%,展现跨语言鲁棒性。更可贵的是作者把数据构造、轨迹过滤、奖励设计、训练代码全部开源,为社区提供了一份“可复制、可扩展”的Agent训练说明书。想让你的LLM不止会聊天,还会像人一样自己查资料、做研究?这篇8000字干货值得逐段细读。

WebDancer: Towards Autonomous Information Seeking Agency

Webancer:迈向自主信息搜索的智能体

吴家龙*,李白轩*,方润南*,尹文标*,张立文,陶正伟,张定初,石泽坤,傅刚,姜勇(☑),谢朋军,黄飞,周景仁

Tongyi Lab ,AlibabaGroup

https://github.com/Alibaba-NLP/WebAgent

Abstract

解决复杂的现实世界问题需要深入的信息获取和多步骤推理。近期在自主系统方面的进展,以Deep Research为例,突出了自主多步骤研究的潜力。在这项工作中,我们提出了一种从数据中心和训练阶段视角构建端到端自主信息获取代理的统一范式。我们的方法包括四个关键阶段:(1) 浏览数据构建,(2) 轨迹采样,(3) 用于有效冷启动的监督微调,以及(4) 用于增强泛化的强化学习。我们在基于React、WebDancer的网络代理中实现了这一框架。在具有挑战性的信息获取基准GAIA和WebWalkerQA上的实证评估,展示了WebDancer的强大性能,取得了显著结果,并突出了我们训练范式的有效性。对代理训练的进一步分析提供了宝贵的见解和可操作的、系统的开发更强大自主模型的途径。

1引言

网络代理是能够感知其现实世界网络环境、做出决策并采取行动以完成特定和类人任务的自主系统。近期系统,如ChatGPT Deep Research OpenAI (2025a) 和Grok DeepSearch x.ai (2025),通过端到端的强化学习(RL)训练,展示了强大的深度信息获取能力。

社区中代理系统进行信息检索的先前方法可以分为两种类型:(i) 直接利用提示工程技术来指导大型语言模型(LLM)或大型推理模型(LRM)Wu等人(2025);团队(2025b);李等人(2025a)执行复杂任务。(ii) 通过监督微调(SFT)或RL将搜索或浏览器功能集成到网络代理中Chen等人(2025);李等人(2025a);宋等人(2025);金等人(2025);孙等人(2025);郑等人(2025)。第一种无训练方法无法有效利用推理模型提供的推理能力。尽管后一种方法通过SFT或RL训练内部化了一定的信息检索能力,但训练和评估数据集都相对简单,并未捕捉现实世界的挑战,例如,在2Wiki数据集上的性能已经超过80%。此外,当前的SFT或RL训练范式并未充分有效地利用信息检索行为的潜力。构建自主信息检索代理涉及解决一系列跨越网络环境感知和决策的挑战:(1) 获取反映多样化用户意图和丰富交互上下文的高质量、细粒度浏览数据,(2) 构建支持长期推理和任务分解的可靠轨迹,以及(3) 设计可扩展和可泛化的训练策略能够

赋予网络代理在分布外网络环境中、复杂交互模式以及长期目标下的鲁棒行为。

为应对这些挑战,我们的目标是解锁自主多轮信息搜索代理,探索如何从头开始构建类似 Deep Research 的网络代理。Deep Research 类代理模型产生一系列交错推理和行动步骤,其中每个行动都调用工具以自主地与外部环境交互。这些交互的观察结果指导后续的推理和行动,直到任务完成。该过程通过端到端工具增强训练进行优化。Yao 等人 (2023) 的 ReAct 框架是最合适的范式,因为它将推理与行动紧密结合,以促进在交互环境中的有效学习和泛化。

我们的目标是向研究社区提供一套系统性的指南,从数据中心和训练阶段的角度构建此类代理。

从数据中心的角度来看,构建网络问答数据对于构建网络代理至关重要,无论训练范式是 SFT 还是 RL。广泛使用的问答数据集通常很浅,通常由可以用一轮或几轮搜索解决的问题组成。以前的工作通常使用提示技术 Song 等人 (2025) 从开源人工标记数据集中过滤出困难的问答对。此外,具有挑战性的网络问答数据集通常只有测试或验证集,其数据量相对较小。例如,GAIA Mialon 等人 (2023) 只有 466 个,WebWalkerQA Wu 等人 (2025) 包含 680 个示例,BrowseComp Wei 等人有 1,266 个,这些都不足以进行有效的训练。因此,高质量数据集的自动合成变得至关重要。Fang 等人 (2025);Zuo 等人 (2025)。我们以两种方式合成数据集:1). 通过爬取网页构建深度查询,称为 CRAWLQA,通过点击操作获取网络信息。2). 通过增强从易到难的问答对合成,以激励从弱到强的代理的进展,将简单问题转化为复杂问题,称为 E2HQA。

从训练阶段的角度来看,先前的工作已经探索了 SFT 或离线强化学习,但这些方法通常面临泛化问题,特别是在复杂、真实的搜索环境中。其他方法直接采用在线强化学习 Chen et al. (2025),但在多工具设置中,早期的训练步骤往往主要侧重于通过指令学习工具使用。为了实现更高效和有效的训练,我们采用了一种结合拒绝采样微调 (RFT) 和后续在线强化学习的两阶段方法。对于轨迹采样,我们将动作空间限制为两个常用的有效网络信息搜索工具作为动作:搜索和点击。基于此设置,我们采用拒绝采样来生成轨迹,使用两种提示策略:一种使用强指令 LLMs for Short- CoT,另一种利用 LRMs for Long- CoT。这些分别生成了包含短或长思考的高质量轨迹。在强化学习阶段,我们采用了 Decoupled Clip 和动态采样策略优化 (DAPO) 算法 Yu et al. (2025),其动态采样机制可以有效地利用 SFT 阶段中未被充分利用的问答对,从而提高数据效率和策略鲁棒性。

我们的主要贡献可以总结如下:我们将端到端的网络代理构建流程抽象为四个关键阶段:步骤I:基于真实网络环境构建多样化和具有挑战性的深度信息搜索问答对(§2.1);步骤II:使用 LLMs 和 LRMs 从问答对中采样高质量轨迹,以指导代理学习过程(§2.2);步骤III:进行微调,以适应遵循格式指令的代理任务和环境(§3.1);步骤IV:应用强化学习来优化代理在真实网络环境中的决策能力和泛化能力(§3.2)。我们提供了一个系统化、端到端的流程,用于构建长期信息搜索网络代理。

在两个网络信息检索基准测试 GAIA 和 WebWalkerQA 上进行的广泛实验表明,我们的管道和 WebDancer(§4)是有效的。我们进一步提出了一个涵盖数据效率、智能体系统评估和智能体学习(§5)的全面分析。

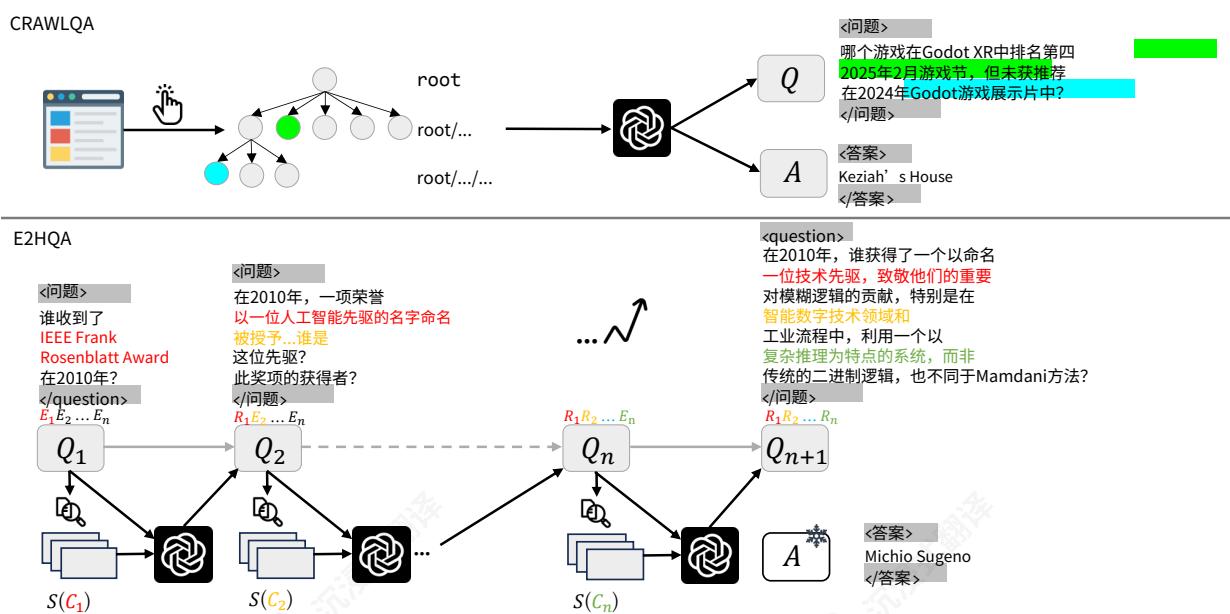

图1:两个网络数据生成管道。①对于CRAWLQA,我们首先收集知识性网站的主URL。然后通过在主/…页面上系统地点击和收集通过子链接可访问的子页面来模拟人类行为。使用预定义规则,我们利用GPT4o根据收集到的信息生成合成QA对。②对于E2HQA,初始问题 Q1\mathrm{Q_1}Q1 使用从迭代i处的实体 Ei\mathrm{E}_iEi 检索到的新信息 Ci\mathrm{C}_iCi 进行迭代演化,使任务在复杂性上逐步扩展,从较简单的实例到更具挑战性的实例。我们使用GPT-4o重写问题,直到迭代达到n。

2深信息寻求数据集合成

2.1 QAPairs构建

为了实现更长期的网络探索轨迹,关键在于构建一个包含复杂多样QA对的庞大语料库,这些QA对能够引出多步推理、目标分解和丰富的交互序列。这些QA的主要要求是:(i)问题类型的多样性,以及(ii)任务复杂度,以所需交互步骤数量衡量。与之前主要涉及可在2- 3步内解决的浅层查询的数据集不同,我们的目标是扩展多跳推理的量和深度。为此,我们主要开发了以下数据集:CRAWLQA和E2HQA。

CRAWLQA基于从网页爬取的信息构建Qapairs代表了一种可扩展知识获取的有效范例Wu等人(2025)。我们首先收集官方和知识性网站的主URL,涵盖arxiv、github、wiki等。Maison等人(2023)为了模拟人类浏览行为,我们通过每个根站点的可访问超链接递归导航子页面。我们使用GPT- 4o从收集到的内容中合成QA对。为了确保问题的具体性和相关性,受Sen等人(2022)的启发,我们提示LLMs通过情境学习生成设计类型的问题(例如,COUNT、MULTI- HOP、INTERSECTION)Brown等人(2020)。

E2HQA与Wei等人;Zhou等人(2025)的逆向构建策略相似;我们从SimpleQA风格的OpenAI(2025b)中的大型问答对开始,其中每个答案都是一个简洁、寻求事实的实体。我们首先从问题 Qn\mathrm{Q}_nQn 中选择一个实体 En\mathrm{E}_nEn ,其中 n\mathbf{n}n 表示精炼迭代的次数。然后,我们使用LLMs基于该实体构建一个查询,以便通过搜索引擎S搜索与 En\mathrm{E}_nEn 相关的信息 Cn\mathrm{C}_nCn 。之后,我们使用LLMs π\piπ 将获得的内容重构为一个新的查询 Rn\mathrm{R}_nRn ,以替换问题中的原始实体。该过程可以表示为: Rn=π(S(Cn))R_{n} = \pi (S(C_{n}))Rn=π(S(Cn)) 。这样,新的问题 Qn+1\mathrm{Q}_{n + 1}Qn+1 需要解决我们在找到答案之前构建的子问题。

即找到原始问题的答案。此外,它确保在问题精炼过程中答案不会改变,从而保持问答对的有效性。通过持续搜索,我们可以逐步将一个最初简单的问题改写成一个更复杂的多步骤问题。此外,解决问题所需的步骤数可以通过调整改写次数来控制。

2.2 代理轨迹拒绝采样

代理设置我们的代理框架基于ReAct Yao等人(2023),语言代理最受欢迎的方法。一个ReAct轨迹由多个思维- 动作- 观察轮组成,其中语言模型生成自由形式的思维用于多种目的,并生成结构化的动作与环境(工具)交互并接收观察反馈。我们假设时间t的代理执行循环可以表示为 (τt,αt,ot)(\tau_{t},\alpha_{t},o_{t})(τt,αt,ot) ,其中 τ\tauτ 表示思维, α\alphaα 表示动作,o表示观察。 α\alphaα 可以进一步表示为 (αm,αp)(\alpha^{m},\alpha^{p})(αm,αp) ,其中 αm\alpha^{m}αm 是动作的名称, αp\alpha^{p}αp 是执行动作所需的参数。 αm∈{\alpha^{m}\in \{αm∈{ 搜索、访问、回答},这对应于深度信息寻求中的两个最重要的代理工具。对于搜索动作, αp\alpha^{p}αp 包括查询和过滤_年,而对于访问动作, αp\alpha^{p}αp 包括目标和url_链接。搜索动作的观察包括前10个标题和片段,而访问动作的观察是由摘要模型Ms生成的证据和摘要。当动作是回答时,选代终止。

然后历史轨迹可以被标记为:

Ht=(τ0,α0,o0,τ1,…,τt−1,αt−1,ot−1).(1)\mathcal{H}_t = (\tau_0,\alpha_0,o_0,\tau_1,\dots,\tau_{t - 1},\alpha_{t - 1},o_{t - 1}). \tag{1} Ht=(τ0,α0,o0,τ1,…,τt−1,αt−1,ot−1).(1)

在时间步t,智能体从网络环境中接收观察 Ot\mathbf{O}_tOt 并生成思考 τt\tau_{t}τt ,采取行动 αt\alpha_{t}αt ,遵循策略 π(τt,αt∣Ht)∘\pi (\tau_t,\alpha_t|\mathcal{H}_t)_\circπ(τt,αt∣Ht)∘

思维链(CoT)方法通过逐步推理过程显著增强了LLMs的推理能力(We et al.(2022)),对应于智能体系统中的思考组件。该过程对智能体执行至关重要,能够实现高级工作流规划、自我反思、信息提取、自适应行动规划和准确行动(工具使用)。

短思维链和长思维链构建智能体将CoT生成能力作为模型的一种主动行为组件。Zhang et al.(2025e);Mai et al.(2025)CoT的长度和相关思考模式在性能中起着关键作用(Team(2025a);Guo et al.(2025);Wu et al.(2024)我们分别提出了两种简单而有效的方法来构建短思维链和长思维链。对于短思维链,我们直接利用ReAct框架使用强大的模型GPT- 4o收集轨迹。对于长思维链,我们依次向LRMs、QwQ- Plus提供每一步的历史行动和观察,使其能够自主决定下一步行动。值得注意的是,在进一步推理时,我们排除了先前的思考,因为LRM、QwQ- Plus在训练过程中没有接触过多步推理输入。然而,我们在生成的轨迹中保留了每一步的思考,因为它们作为有价值的监督信号。LRM的中间推理过程,表示为“<推理_内容>”,被记录为当前步骤的当前思考。每个构建的QA实例都会进行拒绝采样,直到N次,以确保质量和连贯性。

轨迹过滤我们采用一个基于漏斗的三阶段轨迹过滤框架,包括有效性控制、正确性验证和质量评估。

·对于有效性控制,在长内容条件下直接提示大型语言模型(LLMs)以ReAct格式生成响应可能会导致不符合指令。在这种情况下,我们丢弃这些数据点。

·为正确性验证,我们仅保留正确结果。我们遵循Phan等人(2025)和Wei等人提出的评估方法,并使用GPT- 40进行准确判断。

- 为质量评估,我们首先应用规则过滤掉包含超过两个动作的轨迹,确保没有幻觉和严重重复。随后,我们根据提示过滤轨迹,保留满足以下三个标准的轨迹:信息非冗余、目标一致性以及逻辑推理和准确性。

SFT数据集中不存在的问答对可以在强化学习阶段有效利用。1

3多步多工具Agent学习

在ReAct格式下获取高质量轨迹后,我们将其无缝整合到我们的代理SFT训练阶段。具体来说,思维片段由和关闭,动作片段由<tool_call>和<tool_call>关闭,观察片段由<tool_response>和<tool_response>关闭。最终的Action片段对应最终答案,由和包围。此外,在早期阶段被过滤掉的无轨迹QA数据可以在RL阶段有效利用。我们首先通过代理SFT训练策略模型 πθ\pi_{\theta}πθ 进行冷启动,然后通过代理RL进行泛化。整体训练框架如图2所示。

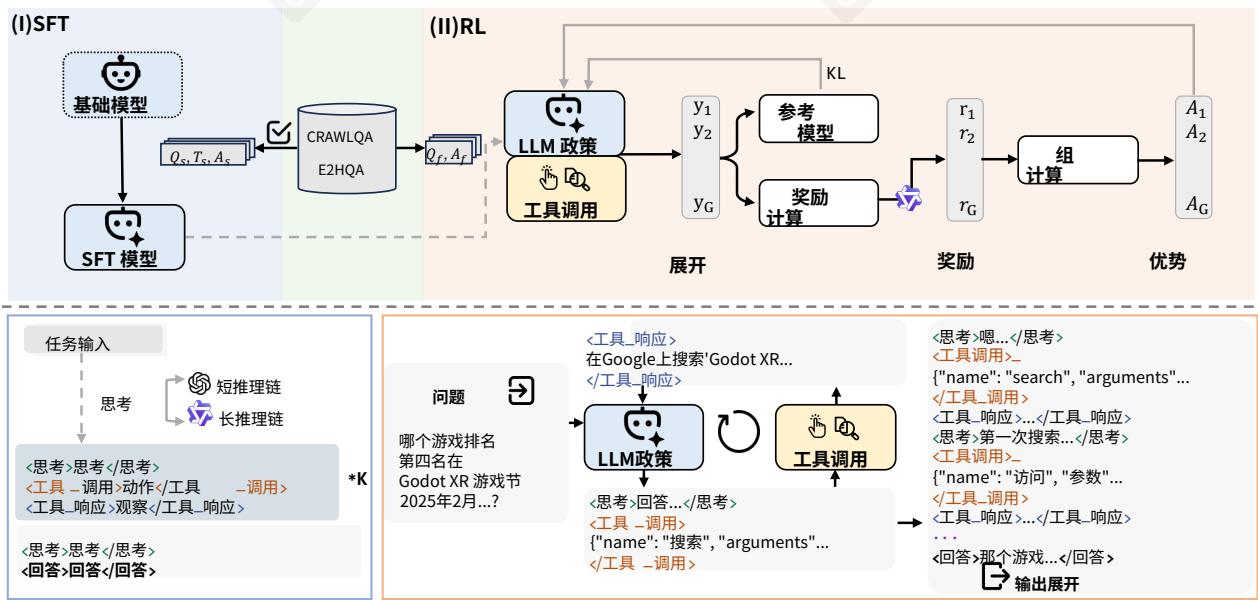

图2:训练框架概述。(I)冷启动的SFT阶段利用重新格式化的ReAct数据集,其中思维片段分别包含短CoT和长CoT。(II)RL阶段在SFT阶段未使用的QA对上执行工具调用滚动,并使用DAO算法优化策略。

3.1代理监督微调

为了捕获完整的自主轨迹,我们通过在获得的决策轨迹上使用监督微调来训练策略模型 θ\thetaθ 。冷启动增强了模型耦合多个推理和行动步骤的能力,教它交替推理与行动的行为范式,同时尽可能保留其原始的推理能力。根据Chen等人(2023;2025);Zhang等人(2025e)的实证发现,为了避免学习过程中外部反馈的干扰,我们在自主世界建模任务中屏蔽了来自观察的损失贡献,这已被证明通常可以提高性能和鲁棒性。给定任务上下文tc和完整的自主执行轨迹 H=(x0,x1,…,xn−1,xn)\mathcal{H} = (x_0,x_1,\dots,x_{n - 1},x_n)H=(x0,x1,…,xn−1,xn) ,其中每个 xi∈{τ,α,o}x_{i}\in \{\tau ,\alpha ,o\}xi∈{τ,α,o} ,损失函数L是

按如下方式计算:

L=−1∑i=1HI[xi≠o]∑i=1∣H∣I[xi≠o]⋅logπθ(xi∣tc,x<i)(2)L = -\frac{1}{\sum_{i = 1}^{\mathcal{H}}\mathbb{I}[x_i\neq o]}\sum_{i = 1}^{|\mathcal{H}|}\mathbb{I}[x_i\neq o]\cdot \log \pi_{\theta}(x_i\mid \mathbf{tc},x_{< i}) \tag{2} L=−∑i=1HI[xi=o]1i=1∑∣H∣I[xi=o]⋅logπθ(xi∣tc,x<i)(2)

这里, I[xi≠o]\mathbb{I}[x_i\neq o]I[xi=o] 过滤掉与外部反馈对应的标记,确保损失是在代理的自主决策步骤上计算的。SFT阶段为后续的RL阶段提供了强大的初始化Zhang et al. (2025b)。

3.2 代理强化学习

代理RL阶段旨在将代理能力内化到推理模型中,通过基于结果的奖励增强其多轮、多工具使用能力。Kumar et al. (2025) 基于SFT阶段,RL采用Decoupled Clip和动态采样策略优化算法来精炼和激励策略模型 πθ\pi_{\theta}πθ 交错思维- 行动- 观察序列的能力。DAPO Decoupled Clip和动态采样策略优化 (DAPO) 算法是一种RL算法,它优化策略 πθ\pi_{\theta}πθ 以在奖励模型R下产生更高奖励的输出 Yu et al. (2025); Ferrag et al. (2025)。对于数据分布 D\mathcal{D}D 中的每个问题- 答案对 (q,a)(\mathbf{q},\mathbf{a})(q,a) ,DAPO采样一组候选代理执行 {oi}i=1G\{o_i\}_{i = 1}^G{oi}i=1G 。然后更新策略以最大化以下目标:

IDAPO(θ)=E(q,a)∼D,{oi}i=1G∼πθold(⋅∣context)[1∑i=1G∣oi∣∑i=1G∑t=1∣oi∣min(ri,t(θ)A^i,t,clip(ri,t(θ),1−ϵlow,1+ϵhigh)A^i,t)](3)\begin{array}{rl}\mathcal{I}_{\mathrm{DAPO}}(\theta) = & \mathbb{E}_{(q,a)\sim \mathcal{D},\{o_i\}_{i = 1}^G\sim \pi_{\theta \mathrm{old}}(\cdot |context)}\\ & \left[\frac{1}{\sum_{i = 1}^{\mathcal{G}}|o_i|}\sum_{i = 1}^G\sum_{t = 1}^{|o_i|}\min \left(r_{i,t}(\theta)\hat{A}_{i,t},\mathrm{clip}\left(r_{i,t}(\theta),1 - \epsilon_{low},1 + \epsilon_{high}\right)\hat{A}_{i,t}\right)\right] \end{array} \tag{3} IDAPO(θ)=E(q,a)∼D,{oi}i=1G∼πθold(⋅∣context)[∑i=1G∣oi∣1∑i=1G∑t=1∣oi∣min(ri,t(θ)A^i,t,clip(ri,t(θ),1−ϵlow,1+ϵhigh)A^i,t)](3)

s.t. 0<∣{oi∣is_equivalent(y,oi)}∣<G,0< \left|\left\{o_{i}\mid \mathbf{is\_equivalent}(y,o_{i})\right\} \right|< G,0<{oi∣is_equivalent(y,oi)}<G,

当自主执行仅指模型生成的标记时,不包括任何工具响应。相比之下,上下文,包括模型输出和工具响应,用于构建计算 πθold\pi_{\theta_{\mathrm{old}}}πθold 的输入轨迹。然而,优化仅应用于模型生成的部分 oi,o_i,oi, 与SFT保持一致。 ϵ\epsilonϵ 是重要性采样率 ri,t(θ)r_{i,t}(\theta)ri,t(θ) 的裁剪范围。而 A^i,t\hat{A}_{i,t}A^i,t 是第i个自主执行在时间步t的优势估计器:

ri,j(θ)=πθ(oi∣qi,oi,<t)πθold(oi∣qi,oi,<t),A^i,j=Ri−mean({Ri})std({Ri}),(4)r_{i,j}(\theta) = \frac{\pi_{\theta}(o_i\mid q_i,o_{i,< t})}{\pi_{\theta_{\mathrm{old}}}(\boldsymbol{o}_i\mid q_i,o_{i,< t})},\quad \hat{A}_{i,j} = \frac{R_i - \mathrm{mean}(\{R_i\})}{\mathrm{std}(\{R_i\})}, \tag{4} ri,j(θ)=πθold(oi∣qi,oi,<t)πθ(oi∣qi,oi,<t),A^i,j=std({Ri})Ri−mean({Ri}),(4)

动态采样机制会过采样并过滤掉准确度为1和0的提示。在我们的数据训练管道中至关重要,因为剩余的问答对是合成生成的——可能包含无效或噪声实例,否则可能会降低策略学习。这种不可靠的样本可以有效地被忽略,确保智能体专注于从高质量信号中学习。

在ReAct框架中,每轮自主执行开始时通过生成一个思维,由和结束,然后是动作名称 αm\alpha^{m}αm 和相应的参数 αp\alpha^{p}αp ,由<tool_call>和</tool_call>操作包围,所有这些都基于迭代历史 H0\mathcal{H}_0H0 。这些组件被迭代用于与真实世界的搜索环境交互,产生观察作为反馈,当<tool_response>被检测到时,被<tool_response>和<tool_response>限制。交互轮次从持续到<tool_response>展开结束时,在最终思维之后生成和

奖励设计奖励设计在RL训练过程中起着至关重要的作用Guo等人(2025)。我们的奖励系统主要由两种类型的奖励组成,scoreformat和scoreanswer。鉴于格式一致性在初始RFT阶段已得到很大程度的解决,我们将一个较小的权重分配给整体奖励中的scoreformat。scoreformat是二元的:只有当整个输出严格符合所需格式且所有json格式的工具调用都有效时,才设置为1。考虑到问答

答案本质上不可验证,尽管回答简短,但无法使用基于规则的F1/EM指标进行可靠评估,并且最终评估依赖于LLM作为裁判 Zheng等人(2023),裁判模型是Mi,我们选择采用基于模型的提示评估作为答案奖励信号Seed等人(2025);Xu等人(2025);Liu等人(2025b)。scoreanswer也是二元的,仅当LLM判定回答正确时才分配为1。最终奖励函数为:

R(y^i,y)=0.1∗scoreformat+0.9∗scoreanswer(5)R(\hat{y}_i,y) = 0.1 * score_{\mathrm{format}} + 0.9 * score_{\mathrm{answer}} \tag{5} R(y^i,y)=0.1∗scoreformat+0.9∗scoreanswer(5)

where y^i\hat{\mathbf{y}}_iy^i 表示模型预测且y是参考答案。

4实验

表1:GAIA和WebWalkerQA基准的主要结果。我们在附录C.1中讨论了基线和并发工作的报告结果。“- ”表示无法复现或不报告的结果。所有框架中的最佳结果以粗体显示。

| GAIA | WebWalkerQA | ||||||||

| Backbone | 框架 | 一级 | 二级 | 三级 | Avg. | Easy | 中 | Hard | Avg. |

| 无代理 | |||||||||

| Qwen-2.5-7B | Base | 12.8 | 3.8 | 0.0 | 6.8 | 1.25 | 0.8 | 0.7 | 0.8 |

| Qwen-2.5-32B | Base | 20.5 | 9.6 | 8.3 | 13.6 | 3.8 | 2.5 | 3.3 | 3.1 |

| RAG | 12.8 | 11.8 | 8.3 | 11.8 | 23.1 | 14.3 | 11.3 | 15.3 | |

| Qwen-2.5-72B | Base | 20.5 | 13.5 | 0.0 | 14.6 | 9.4 | 7.1 | 3.3 | 6.3 |

| GPT-40 | Base | 23.1 | 15.4 | 8.3 | 17.5 | 6.7 | 6.0 | 4.2 | 5.5 |

| QwQ-32B | Base | 30.8 | 15.4 | 25.0 | 22.3 | 7.5 | 2.1 | 4.6 | 4.3 |

| RAG | 33.3 | 36.5 | 8.3 | 32.0 | 36.9 | 26.1 | 33.5 | 31.2 | |

| DeepSeek-R1-671B | Base | 43.6 | 26.9 | 8.3 | 31.1 | 5.0 | 11.8 | 11.3 | 10.0 |

| 专有代理框架 | |||||||||

| OpenAI DR | 74.3 | 69.1 | 47.6 | 67.4 | - | - | - | - | - |

| 开源代理框架 | |||||||||

| Qwen-2.5-7B | Search-ol | 23.1 | 17.3 | 0.0 | 17.5 | - | - | - | - |

| R1-Searcher | 28.2 | 19.2 | 8.3 | 20.4 | - | - | - | - | |

| Qwen-2.5-32B | 搜索-c1 | 33.3 | 25.0 | 0.0 | 28.2 | - | - | - | - |

| QwQ-32B | 搜索-c1 | 53.8 | 34.6 | 16.7 | 39.8 | 43.1 | 35.0 | 27.1 | 34.1 |

| WebThinker-Base | 53.8 | 44.2 | 16.7 | 44.7 | 47.2 | 41.1 | 39.2 | 41.9 | |

| WebThinker-RL | 56.4 | 50.0 | 16.7 | 48.5 | 58.8 | 44.6 | 40.4 | 46.5 | |

| 简单 DS | - | - | - | 50.5 | - | - | - | - | |

| ReAct 智能体框架 | |||||||||

| Qwen-2.5-7B | Vanilla ReAct | 28.2 | 15.3 | 0.0 | 18.4 | 28.1 | 31.2 | 16.0 | 24.2 |

| WebDancer | 41.0 | 30.7 | 0.0 | 31.0 | 40.6 | 44.1 | 28.2 | 36.0 | |

| Qwen-2.5-32B | Vanilla ReAct | 46.1 | 26.9 | 0.0 | 31.0 | 35.6 | 38.7 | 22.5 | 31.9 |

| WebDancer | 46.1 | 44.2 | 8.3 | 40.7 | 44.3 | 46.7 | 29.2 | 38.4 | |

| QwQ-32B | Vanilla ReAct | 48.7 | 34.6 | 16.6 | 37.8 | 35.6 | 29.1 | 13.2 | 24.1 |

| WebDancer | 61.5 | 50.0 | 25.0 | 51.5 | 52.5 | 59.6 | 35.4 | 47.9 | |

| GPT-40 | Vanilla ReAct | 51.2 | 34.6 | 8.3 | 34.6 | 34.6 | 42.0 | 23.9 | 33.8 |

4.1实验设置

我们在两个成熟的深度信息检索基准上评估了我们的方法:GAIA和Web- WalkerQA。在这项工作中,我们采用LLM- as- Judges范式,并遵循Team(2025b)的方法,使用Pass@1指标评估这两个任务。数据集和基线的详细信息分别介绍在App.E.1和App.E.2中。实现细节显示在App.E.3中。Qwen- 7B和Qwen- 32B是

在 Short- CoT 数据集上训练的,而 QwQ- 32B 是在 Long- CoT 数据集上训练的。进一步的分析显示在 Sec. 5 中。

4.2 实验结果

主要结果如表1所示,没有代理能力的框架(No Agency)在GAIA和WebWalkerQA基准测试中表现不佳,突出了这些任务中主动信息搜索和代理决策的必要性。闭源的代理系统OpenAIDR通过端到端RL训练实现了最高分。在开源框架中,基于原生强推理模型(如QwQ- 32B)构建的代理方法始终优于其非代理对应物,证明了在代理构建中利用推理专用模型的有效性。重要的是,在高度可扩展的ReAct框架下,我们提出的WebDancer在不同模型规模上均显著优于vanilla ReAct基线。值得注意的是,在最佳情况下,它甚至超过了GPT- 4o的性能。这表明即使在轻量级框架中,我们的方法也显著增强了代理能力,验证了我们方法的强度和通用性。

在更具挑战性的基准测试上的结果我们在我们的方法上评估了两个更具挑战性的数据集,BrowseComp(英文)Wei等人(2025年)和BrowseComp- zh(中文)Zhou等人(2025年)它们被设计用来更好地使用PASS@1/PASS@3反映复杂的信息搜索场景。如表2所示,WebDancer在两个数据集上都表现出始终如一的良好性能,突出了它在处理困难的推理和信息搜索任务中的鲁棒性和有效性。

表2:BrowseComp(英文)和BrowseComp- zh(中文)的结果。

| 框架 | 浏览 | En. | Zh. |

| GPT-40 | × | 0.6 | 6.2 |

| ✓ | 1.9 | - | |

| QwQ-32B | × | - | 11.1 |

| WebDancer | ✓ | 3.8/7.9 | 18.0/31.5 |

5 分析

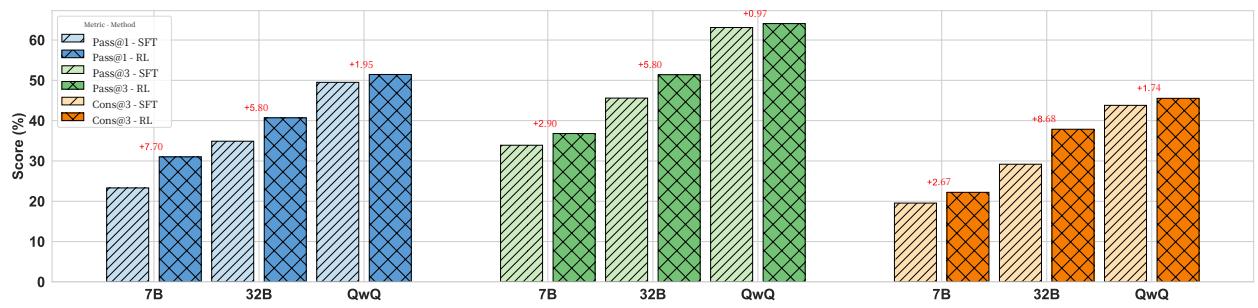

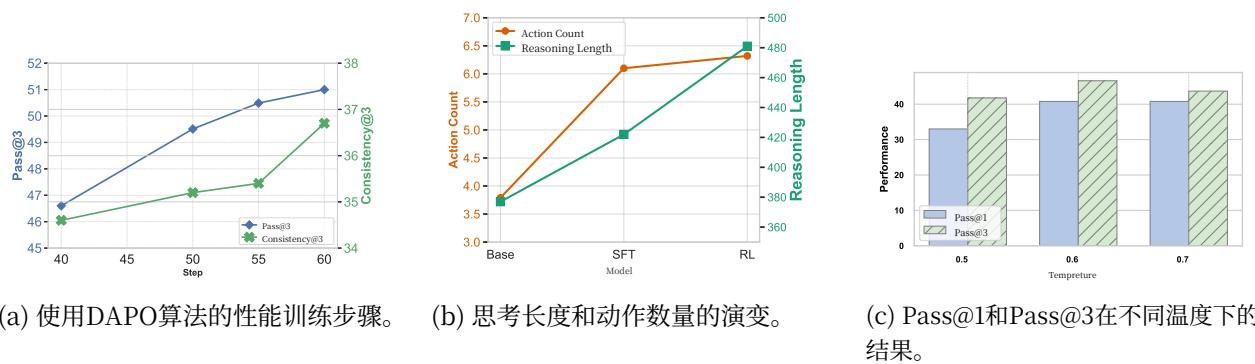

详细结果我们对GAIA数据集进行了详细分析。鉴于代理环境的动态和复杂性,以及相对较小且可变测试集,我们在图4中对Pass@3和Cons@3进行了细粒度分析。Cons@3指标是通过评估三次独立尝试中正确响应的数量来计算的:得到一个正确答案得分为1/3,两个正确答案得分为2/3,三个正确答案得满分1。对于非推理模型,RL在Pass@3和Cons@3上都带来了显著改进。值得注意的是,RL后的Pass@1性能与SFT基线的Pass@3相当,这与之前的研究结果一致Yue等人(2025年);Swamy等人(2025年),表明RL可以更有效地采样正确响应。对于LRMs,虽然RL后的Pass@1、Pass@3和Cons@3的改进微乎其微,但在一致性方面有一个明显的提升;这可能是由于过长轨迹导致的稀疏奖励信号Feng等人(2025年);Wei等人(2025b)。

这表明在代理任务中,持续的政策内优化可能对LRMs带来有限的收益。我们表现最佳的模型在GAIA上实现了 64.1%64.1\%64.1% 的Pass@3分数,在WebWalkerQA上实现了 62.0%62.0\%62.0%

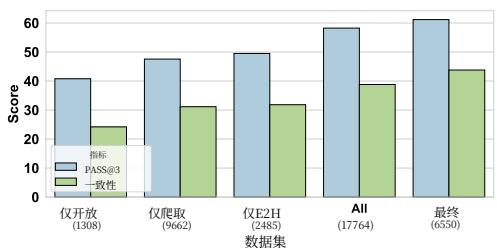

高质量的轨迹数据对于智能体的有效SFT至关重要我们提出了两种数据构建策略,从而创建了数据集CRAWLQA和E2HQA。在将轨迹拒绝采样应用于QA数据后,我们进一步进行过滤以提升数据质量。在图3中,我们对QwQ进行了消融研究,并评估了

图3:使用GAIA基准测试的数据效率结果。Open-only指的是仅使用来自开源来源的具有挑战性的QA数据集。

图4:使用Pass@1、Pass@3和Cons@3指标在GAIA基准上的详细评估结果。

所构建数据集的有效性。在长CoT中,当模型尝试通过模拟观察来回答时,幻觉经常出现,这主要由于其仅依赖内部推理机制。Li等人(2025a)Final在低数据条件下表现优于所有其他模型,强调了鲁棒过滤的价值。

SFT对于冷启动至关重要,因为代理任务需要强大的多步多工具指令跟随能力。我们通过使用QwQ比较单一线上强化学习设置下的性能来实证研究这一点。结果表明Pass@3性能受到显著限制,在GAIA上仅达到 5%5\%5% 。对于RL阶段,Pass@3和Cons@3随着训练步数的增加都表现出持续改进,如图5(a)所示。

表3:CoT知识迁移结果。Inv.表示无效率。R.指模型是否为推理模型。

| 模型 | R. | Short-Cot | Long-Cot | |||||

| Pass@3 | Cons@3 | Inv. | Pass@3 | Cons@3 | Inv. | Cons@3 | ||

| Qwen2.5-7B | × | 33.98 | 22.33 | 0.63% | 35.92 | 21.00 | 21.36% | |

| Qwen2.5-32B | ✓ | 42.72 | 24.33 | 4.20% | 35.63 | 30.00 | 13.59% | |

| QwQ-32B | ✓ | 44.66 | 28.33 | 0.97% | 58.25 | 39.66 | 13.27% | |

强推理模型使用的思维模式知识可以迁移到小指令模型。如表3所示,在推理模型合成的轨迹上训练的推理模型显著提升了它们的推理性能(Gou等人,2023)。对于非推理模型,Long- CoT也表现出良好的性能,但它引入了额外的问题,例如更高的无效率,通常表现为重复,导致超出

模型的上下文长度,特别是在小规模模型中。这些推理模式不容易迁移到指令微调模型,而指令微调模型通常针对任务跟随行为进行优化,而不是深度推理。这一观察结果与Li等人(2025b);Yin等人(2025)的发现一致,这些研究强调了跨模型推理知识迁移的脆弱性。²因此,从推理模型直接迁移推理能力到指令模型仍然是一个非平凡的挑战。

RL支持更长的推理过程并支持更复杂的代理行为。如图5(b)中Qwen- 32B的结果所示,我们观察到SFT导致更频繁的动作生成和更长的推理序列,这主要归因于我们训练数据的性质(附录E.1)。RL框架通过允许模型在决策序列上进行优化,而不是单步输出,从而促进更复杂的推理策略的出现。这使得模型能够从延迟奖励中学习并深入探索动作空间,从而产生更连贯和更长的推理轨迹。此外,RL鼓励代理行为,其中模型自主决定中间步骤、子目标或工具以实现最终目标,如图F所示。这些能力在直接任务跟随无法泛化的复杂环境中特别有用。

Web agent在一个动态变化,不断演化的环境中执行,这种环境本质上抗拒稳定。如图5©所示,调整解码温度对最终性能影响甚微,表明解码的变异性本身并不能解释agent的不稳定性。相反,我们将大部分

图5:使用GAIA基准分析RL算法、涌现代理和代理环境。

性能波动归因于web环境本身的改变,突显了真实世界agent部署的非平稳性和开放性。与具有固定分布特性的静态数据集不同,真实世界环境随时间演变,要求agent在不断变化的上下文和部分可观察性下保持鲁棒性。此外,为进一步调查潜在的过拟合问题,我们进行了一次记忆压力测试:我们在GAIA开发集的69条正确采样的轨迹上微调了一个Qwen- 7B模型10个epoch,随后在同一数据集上评估其性能。尽管如此,贪婪解码仅达到了 37.4%37.4\%37.4% ,表明在开放域的agentic任务上稳定化的难度。

6相关工作

信息获取代理和基准。信息获取代理的最新进展旨在将网络交互集成到LLM的推理中。Xi等人(2025)WebThinker团队(2025b)和Search- olLi等人(2025a)使用工具增强型LLM,在推理过程中主动检索证据。一些工作如Rl- Searcher Song等人(2025)、ReSearch Chen等人(2025)和Search- R1Jin等人(2025)专注于强化学习,从基于结果的奖励中教授搜索行为。DeepResearcherZheng等人(2025)通过在真实网络环境中使用在线RL扩展了这一点,而SimpleDeepSearcherSun等人(2025)表明,少量的蒸馏演示可以训练出有效的代理,而无需完整的RL。这些工作展示了有前景的能力,但通常依赖于有限或简单化的数据。同时,基准如GAIAMialon等人(2023)和WebWalkerQAWu等人(2025)测试推理和浏览,但许多是单轮或领域受限的。BrowseCompWei等人和BrowseComp- zhZhou等人(2025)增加了任务复杂性,要求多跳搜索和多语言推理,但仍缺乏多样性和可扩展性。我们的工作通过提出自动合成QA数据集来解决这些差距,这些数据集旨在更具现实感的网络环境中挑战代理跨领域和任务类型的能力。

智能体学习。智能体学习已从情境学习发展到基于训练的方法Liu等人(2025a);周等人(2024;2023)。最近的研究Qiao等人(2024);曾等人(2024);陈等人(2024)主要集中在利用SFT和遵循ReAct范式的精选任务解决轨迹。然而,实证研究表明,纯基于SFT的智能体在面临自适应操作环境时通常表现出有限的泛化性能Zheng等人(2025);张等人(2025d);钱等人(2025);余等人(2024)。基于这些局限性,基于RL的方法Song等人(2025);Zheng等人(2025;?);张等人(2025d;c)通过学习探索策略展示了开发复杂搜索策略的巨大潜力。尽管它们具有理论优势,但实际应用在训练稳定性和样本效率方面面临持续挑战。WebDancer实现了一个两阶段框架:初始的冷启动阶段采用基于轨迹的SFT来建立基本的代理模式,然后通过有针对性的RL培养自适应的长期代理能力。

7结论

7 结论在这项工作中,我们提出了一种从零开始构建端到端多步信息搜索网络代理的系统框架。通过引入可扩展的QA数据合成方法和结合SFT和策略RL的两阶段训练管道,我们的WebDancer代理在GAIA和WebWalkerQA上实现了优异的性能。这些发现突出了我们提出的训练策略的重要性,并为代理训练的关键方面提供了宝贵的见解。向前看,这项研究为社区提供了可操作和系统的途径,以推进开发越来越复杂的代理模型,这些模型能够处理复杂的现实世界信息搜索任务。

A限制

尽管我们提出的框架已经展示了有前景的结果,但仍存在一些限制,这些限制指出了持续的努力和未来工作的潜在方向。

工具数量和类型目前,我们集成了两种基本的信息检索工具。为了实现更高级和细粒度的检索能力,我们计划整合更复杂的工具,例如通过将浏览器功能抽象为模块化工具进行浏览器建模,以及一个用于与外部API交互的Python沙盒环境Wei et al.(2025a);Cao et al.(2025);Zhang et al.(2025a)。这允许代理执行更像人类且更高效的交互,不仅为应对更具挑战性的基准测试铺平了道路,也为迈向更通用和自主的代理奠定了基础。

任务泛化和基准测试我们当前的实验专注于两个简答题信息检索任务。然而,一个全面的网络代理也应该能够进行文档级别的调研和生成Shao et al.(2024)。扩展到这种开放域、长文本写作提出了在代理任务中的奖励建模方面的重大挑战,我们正在积极研究,特别是如何设计在开放式环境中更可靠和更有信息的奖励信号用于长文本生成Liu et al.(2025b)。

数据利用虽然我们已经积累了大量的问答对和相应的轨迹,但有效地扩展学习仍然是一个挑战,特别是在强化学习(RL)阶段,由于强化学习在代理任务中的计算和稳定性限制,只能利用一小部分(例如,5,000对)。这突显了需要更高效的数据利用策略,以充分挖掘收集到的数据集的丰富性。

高rollout成本强化学习(RL)阶段会产生巨大的计算和时间开销,因为每次rollout都涉及多轮工具调用和大型语言模型(LLM)的补全。这种高成本不仅限制了可扩展性,还减缓了迭代开发和实验的速度。一个有前景的方向是开发更高效的机制,将工具调用与模型补全集成起来,从而在不牺牲学习策略的情况下减少rollout时间和成本。

混合思维我们考虑了两种具有短和长CoTs的数据集类型。目前,我们的模型是在单个数据集类型上训练的。在未来工作中,我们计划开发一个混合推理代理模型,该模型能够动态控制代理的推理长度。Yang等人(2025)

思维模式在工具调用中,可能会出现幻觉。例如,在处理数学问题时,可能会错误地调用一个实际上不存在的“计算”工具。此外,在推理过程中还可能出现过度行动,即在答案确认后仍然执行冗余操作。

B更广泛的影响

构建能够进行长期信息搜索的开源、自主网络代理,通过使复杂基于网络的推理工具民主化,有潜力极大地促进科学研究、教育和生产力。然而,此类系统也引发了一些担忧,包括如果代理依赖不可靠的来源,则存在错误信息传播的风险,以及在自动化内容提取或监控中滥用的可能性。我们强调透明度、来源归属和负责任的部署实践的重要性,以减轻潜在的损害。

C讨论

C.1并发工作

与基于训练的方法的比较我们主要将我们的方法与两种基于训练的方法进行比较:WebThinker和SimpleDeepSearcher,并突出关键差异。WebThinker也采用了SFT后接RL的设置,但采用了一个离线RL算法Rafailovetal.(2023)。此外,WebThinker在 <<< 思考_内容 >>> 中触发动作和观察,而我们的方法采用了一种原生的ReAct风格架构,在完成其相应的推理步骤后执行每个动作。相比之下,SimpleDeepSearcher完全依赖于对精心策划的数据集进行监督微调。我们的方法同样遵循SFT- then- RL范式,但关键在于通过DAPO利用在线RL。我们的核心贡献在于构建了一个可扩展的端到端管道,从数据构建到算法设计,支持原生的ReAct推理。该框架兼容指令LLM和LRM,能够实现无缝集成和改进的泛化能力。

与基于提示的方法的比较社区最近的努力探索构建更自主和通用的代理系统,例如OWLHu等人(2025);Li等人(2023),以及OpenManus Liang等人(2025),通过利用具有强大原生代理能力的基础模型,例如Claude anthropic(2025)。这些系统通常依赖于精心设计的代理框架和提示工作流程,通常涉及多步工具使用和人工策划的任务结构。相比之下,我们提倡开源模型具有涌现的代理能力,这对于实现代理式AI的民主化和推进对代理如何在开放系统中出现和扩展的基本理解至关重要。我们的原生RAct框架拥抱简单,体现了少即是多的原则。训练原生代理模型从根本上是有价值的。

C.2训练后代理模型

C.2 训练后代理模型代理模型指的是原生支持在交互环境中进行推理、决策和多步工具使用的基础模型。它们通过结构化提示表现出涌现的能力,例如规划、自我反思和行动执行。最近的系统,如DeepSearch和Deep Research,说明了强大的基础模型如何作为代理核心,通过原生支持工具调用和迭代推理实现自主网络交互。然而,由于网络环境本质上具有动态性和部分可观察性,强化学习在提高代理的适应性和鲁棒性方面起着至关重要的作用。在这项工作中,我们旨在通过有针对性的训练后工作从开源模型中引出自主代理。

D训练数据集

D 训练数据集我们收集了40K个E2HQA样本和60K个CRAWLQA样本。这些数据样本通过QwQ或GPT- 4o生成轨迹,然后经过多阶段过滤过程以确保质量,如第2.2节所述。表4分别报告了使用Long- CoT和Short- CoT推理生成的SFT数据的统计信息。我们计划进一步扩展这个高质量数据集,以研究增加数据量是否会在未来的工作中带来显著的性能提升。

表4:训练数据集的统计信息。思考长度是思考的token化长度的平均值。

| CoT类型 | Num. | 动作计数 | 思考长度 |

| 短 Long | 7.03 | 4.56 | 510.03 |

| 6.73 | 2.31 | 1599.39 |

过滤标准:关于第2.2节中采用的轨迹滤波器,需要注意的是,在质量评估阶段,我们通过识别并限制每个轨迹中n- gram( n=10\mathrm{n = 10}n=10 )的最大出现次数为4的闻值,来缓解重复模式的存在。这样做的目的是防止模型内化有害模式,从而确保推理过程的完整性。

仅开放数据集:我们选择了一组广泛使用的问答(QA)数据集,包括MuSiQueTrivedi等人(2022年)、Bamboogle Press等人(2022年)、PopQA Mallen等人(2022年)、2Wiki Ho等人(2020年)以及HotpotQA Yang等人(2018年)。为确保问题难度,我们应用了一个基于RAG的简单过滤过程来去除简单问题。

E实验细节

E.1基准测试

GAIA旨在评估通用AI助手在复杂信息检索任务上的表现,而Web- WalkerQA则专注于深度网络信息检索。我们的实验使用了GAIA文本验证集的103个问题以及WebWalkerQA测试集的680个问题。

E.2基线模型

我们将WebDancer与以下框架进行了比较:

·无代理:表示直接使用模型的基座能力,并仅使用检索增强生成(RAG)。包括Qwen2.5- 7/32/72B- Instruct Yang等人(2024),QwQ- 32B团队(2025a),DeepSeek- R1- 671B Guo等人(2025),GPT- 4oOpenAI(2022)。·闭源代理框架:OpenAI深度研究(DR)使用端到端强化学习来完成多任务研究任务。

·开源代理框架:WebThinker为LRM配备了一个深度网络浏览器,以在推理过程中自主搜索和浏览网页,将工具使用与思维链交织。为了公平比较,我们使用Google搜索重现了结果,并进一步复制了方法的Base和RL版本。Search- olLi等人(2025a)通过首先生成搜索查询、检索网络文档,然后使用LLM根据检索内容回答来进行信息搜索,而没有优化搜索过程本身。R1- SearcherSong等人(2025)使用基于结果的强化学习训练LLM,学习何时以及如何搜索,没有任何监督演示。

E.3实现细节

我们使用多轮chatml格式进行训练,将每个对话结构化为工具响应表示为用户消息,模型生成的思想和行动表示为助手消息。

·数据集构建:拒绝采样数量 N=5∘\mathrm{N} = 5_{\circ}N=5∘ 摘要模型Ms是Qwen- 2.5- 72B。我们使用广泛采用的ReAct框架构建我们的系统,该框架基于Qwen- Agents3实现。

·训练和推理:我们基于Qwen- 72B- Instruct构建了裁判模型Mj,并设计了遵循Phan等人(2025)的奖励提示。对于RL,我们实现了verlSheng等人(2024);Kwon等人(2023)以支持RL算法和rollout。RL中的rollout数量为 16∘16_{\circ}16∘ 我们设置推理参数如下:温度 =0.6= 0.6=0.6 , topp=0\mathrm{topp} = 0topp=0 95。对于LRM,我们使用重复惩罚1.1,而对于LLM,重复惩罚设置为 1.0∘1.0_{\circ}1.0∘ 在RL中,rollout的温度为1.0和 topp=1.0∘top_{p} = 1.0_{\circ}topp=1.0∘

我们使用32个节点,每个节点配备8个NVIDIAH20(96GB)进行所有实验。

E.4 智能体轨迹采样的提示

传统ReAct用于LLMs

ReAct的提示

尽可能回答以下问题

使用以下格式:

问题:你必须回答的输入问题思考:你应该始终思考该做什么操作:要执行的操作,应为[{tool_names}]之一操作输入:操作的输入,使用具有明确参数的JSON Schema观察结果:操作的结果…(此思考/操作/操作输入/观察结果可以重复多次)思考:你应该始终思考该做什么操作:最终答案:对原始输入问题的最终答案

##执行框架

- 思考阶段

-必须组件:

(a).证据链完整性评估(b).工具选择理由

- 行动阶段

- 允许使用的工具:仅使用在‘{tool_descs}‘中列出的工具或可以最终答案,它返回答案并完成任务。当您有信心确认答案时,您才提供‘最终答案‘。您还必须确保‘最终答案’是准确可靠的。要输出最终答案,请使用以下模板:Final Answer:[你的最终答案]

- 观察阶段

- 返回工具的信息:动作的结果,你可以使用结果来思考下一步。你有以下工具可以使用:

{tool_descs}

开始!

你可能会使用提供的工具来收集信息,然后做出最终决断。使用交替的思维、行动和观察步骤来解决以下问题。你可以进行尽可能多的步骤。问题:{query}

LRMs的ReAct修改版

在盖亚中的案例轨迹

尽可能回答以下问题。允许的工具:仅使用{tool_descs}列出的工具或可以是最终答案:。您还必须确保最终答案是准确和可靠的。您可以使用以下工具:{tool_descs}

好的,请提供需要翻译的文本。请提供需要翻译的文本。操作:应执行的操作,应为{工具_名称}操作输入:操作输入使用JSONSchema并指定明确参数,当操作为“最终答案”时,无需包含Action输入,直接返回答案你可以采取必要的步骤。始终使用工具来收集信息。做出最终答案。当你想要调用工具时,请输出完整的"Action:"和"ActionInput:"到使工具调用成功,然后输出"Observation:"使工具调用成功。问题:{query}

F案例研究

如图8所示,以下展示了几种复杂的思维模式:

·逐步分解WebDancer将复杂问题分解为更小、可管理的步骤,使用“首先…然后…最后”。

·假设检验WebDancer提出假设并验证其有效性。它假设《海底总动员》中的“尼莫”是橙腹小丑鱼(Amphiprionocellaris)。它通过查询USGS数据库的非本地分布情况来验证这一假设。

·处理信息缺失当某些信息缺失时,WebDancer会主动采取行动填补空白。

·选代反思在未能从USGS数据库中找到ZIP码后,WebDancer意识到需要单独搜索具体地址。通过第二次搜索,它成功检索到ZIP码。这展示了该代理在面对不确定性时的灵活性和适应性。

GAIA中的案例轨迹

GAIA中的案例轨迹问题:我正在研究那些在宠物主人将其释放后成为入侵物种的物种。有一种鱼因为电影《海底总动员》中的主角而被流行作为宠物。根据美国地质调查局(USGS),这种鱼在2020年之前作为非本地物种在哪里被发现?我需要将答案格式化为该物种被发现地点的五位邮编,如果有多个地点,则用逗号分隔。

步骤1

<思考>

<思考>好的,让我们一步步来解决这个问题。用户想知道在哪些邮编地区发现了《海底总动员》中的鱼,这些鱼在被宠物主人释放后成为了入侵物种,它们被发现时被视为

根据USGS在2020年之前发现的非本地物种。首先,我记得《海底总动员》中的主角是尼莫,一种小丑鱼。因此,问题中的物种很可能是橙小丑鱼,学名Amphiprion ocellaris。但我应该确认一下。也许我应该从搜索“小丑鱼入侵物种USGS”开始,看看是否有相关信息。等等,但用户特别提到了USGS。让我看看USGS对……的说法是什么

<工具_调用>

{“name”: “搜索”, “arguments”: {“query”: “USGS Amphiprion ocellaris 非本地分布位置在2020年之前”}} 2020"}

</工具_调用>

<工具_响应>

对“USGS Amphiprion ocellaris 2020年前非原生分布地点”的谷歌搜索找到了9个结果:1. 小丑鱼 海葵鱼 (Amphiprion ocellaris) - 物种 Pro- 文件 表1。有最早和…

- 小丑海葵鱼(Amphiprion ocellaris)引用信息:美国地质调查局。[2025]。非本地水生物种数据库。佛罗里达州盖恩斯维尔。访问[5/9/2025]。如果您有疑问,请联系我们…

</工具_响应>

步骤2

<思考>

好的,所以我需要找到2018年底维基百科页面上的帽带企鹅种群与2020年Nature.com文章中种群之间的绝对差异(以万为单位)。用户还希望我们假设每对繁殖企鹅有两个企鹅。让我先通过提供的资料开始。首先,查看维基百科部分的搜索结果。第六个结果提到了帽带企鹅的保护状况,指出2018年,IUCN估计大约有800万个标本…

</思考>

<工具_调用>

{“name”: “visit”, “arguments”: {“url”: "

https://nas.er.usgs.gov/queries/FactSheet.aspx?speciesID=3243", “goal”: “识别2020年前有非本地入侵性Amphiprion ocellaris出现的状态”}}

</工具_调用>

<工具_响应>

{“evidence”: "提供的网页内容包括一个列出非本地入侵性Amphiprion ocellaris出现的表格。表格显示,一个个体于2018年7月在佛罗里达州的Fred Howard公园(皮纳尔斯县)被采集,这发生在2. …

</工具_响应>

步骤3

<思考>

好的,让我们逐步解决这个问题。用户询问的是在2020年之前,根据美国地质调查局(USGS)的数据,小丑鱼(Amphiprion ocellaris),在电影《海底总动员》中广为人知的物种,在美国作为外来物种被发现的邮编。首先,我使用提供的工具进行了搜索。初步搜索让我找到了美国地质调查局非本地水生物种数据库页面,其中包含Amphiprion ocellaris的信息。访问该页面显示了一个列出出现情况的表格。关键点在于,2020年之前的唯一记录是在佛罗里达州,具体是皮纳尔斯县,于2018年7月在弗雷德·霍华德公园采集的。现在,下一步是将这个位置转换为邮编…

<工具_调用>

{“name”: “访问”, “参数”: {“url”: “https://nas.er.usgs.gov/queries/collectioninfo.aspx?”}}“物种ID=3243”, “目标”: “寻找具有邮政编码的特定收藏地点,用于 Amphiprion"ocellaris 在 2020 年前的美国”}

</工具_调用>

<工具_响应>

“证据”: “1468741 FL 帕纳哈德湾 美国公司”,佛罗里达,弗雷德·霍华德公园 2018 03100207Crystal- Pithlachascotee 消除", “理由”: “该网页提供了一种收集记录"Amphiprion ocellaris (小丑海葵鱼) 在美国,具体在皮纳尔斯县,佛罗里达州。记录显示,一个标本于 2018 年在弗雷德·霍华德公园采集。然而,网页没有提供采集地点的邮政编码。”

</工具_响应>

步骤4

<思考>

所以现在我需要找出佛罗里达州皮纳尔斯县弗雷德·霍华德公园的邮政编码。由于美国地质调查局的数据不提供邮政编码,我可能需要查找该地点的地址。让我想一下是否还有其他方法可以使用现有工具。允许的工具是搜索和访问。也许我可以进行另一次搜索来找到弗雷德·霍华德公园的邮政编码。等等,用户的说明说要使用提供的工具。由于我不能直接知道邮政编码,我应该使用搜索工具再次查找 Fred Howard Park, Pinellas County, Florida 的邮政编码。让我来试试。所以下一步操作:搜索 “Fred Howard Park Pinellas County Florida zip code”。但我需要正确地组织它。让我检查搜索工具的参数。查询可以是任何内容,所以我可以输入 “What is the zip code of Fred Howard Park, Pinellas County, Florida?” 获取这些信息后,我就可以展示邮政编码…

<工具_调用>

{“name”: “搜索”, “参数”: “查询”: “Fred Howard Park Pinellas County Florida 邮编”}

</工具_调用>

<工具_响应>

在 Google 上搜索 “Fred Howard Park Pinellas County Florida zip code” 找到了 9 个结果:

-

弗雷德·霍华德公园 - 帕因斯县 Fred Howard Park 是一个占地 155 英亩的公园和海滩,位于墨西哥湾的 Tarpon Springs。从公园到白色的沙滩有一条 1 英里的堤道…

-

Fred Howard 公园,1700 日落 Dr,塔普恩 温泉, FL 34689, US …

</工具_响应>

步骤5

<思考>

第一个链接是 Amphiprion ocellaris 的物种简介,其中列出了有非本地出现记录的州。访问该页面后的摘要显示,佛罗里达州在 2018 年在皮纳尔斯县的弗雷德·霍华德公园有记录的出现。接下来,我需要确认确切的位置细节。对收藏信息页面的第二次访问提供了一个 2018 年在佛罗里达州皮纳尔斯县的记录,具体是弗雷德·霍华德公园。然而,那里没有列出邮编,…,该具体位置的邮编是 34689。由于问题要求的是邮编,并且提供的数据中只提到了这个位置,因此答案应该是 34689。我需要确保没有其他位置,但根据搜索结果,只有佛罗里达州的皮纳尔斯县被提及。因此,最终答案是邮编 34689.

图8:案例研究。