大模型数据处理实战:文本处理、高效数据管道、性能优化技巧、多机分布式、质量评估,全方位解析

大模型数据处理实战:从原始文本到高效数据管道

本文深入解析大模型开发中的数据预处理全流程,掌握这些技能可处理TB级文本数据,构建工业级数据流水线。作为大模型算法工程师,在日常工作中我们经常需要面对海量文本数据的预处理挑战。这篇文章将从实战角度出发,详细介绍从原始文本到最终可用于训练的数据管道的完整构建过程。

一、环境配置与工具选型

在开始大规模数据处理之前,合适的工具选择至关重要。根据我的实际项目经验,以下是推荐的核心工具包:

pip install datasets tokenizers torchtext sentencepiece

这里我们选择的每个工具都有其特定的优势:

Datasets库是Hugging Face开源的数据处理利器,专门为机器学习场景设计。相比传统的pandas,它在处理大规模数据时具有显著优势。它支持内存映射技术,可以处理超出内存容量的数据集,并且原生支持Apache Arrow格式,在数据读写效率上比传统方式提升数倍。

Tokenizers库提供了当前最先进的分词算法实现,包括BPE、WordPiece等,并且经过Rust优化,处理速度极快。相比纯Python实现,速度提升可达100倍以上。

TorchText作为PyTorch生态的文本处理库,与训练框架深度集成,能够无缝衔接数据预处理和模型训练环节。

SentencePiece是Google开源的子词分割工具,特别擅长处理多语言文本,尤其是中文等非空格分隔的语言。

工具性能对比分析

| 工具 | 处理速度 | 内存效率 | 多语言支持 | 生态兼容性 |

|---|---|---|---|---|

| Datasets | 极快 | 极高 | 优秀 | PyTorch/TensorFlow |

| Tokenizers | 极快 | 高 | 优秀 | 广泛 |

| TorchText | 快 | 中等 | 良好 | PyTorch |

| SentencePiece | 中等 | 高 | 优秀 | 广泛 |

二、大规模文本处理实战(100GB+)

1. 高效数据加载的核心原理

处理超大规模数据时,传统的"一次性加载"方式显然不可行。这里我们采用流式处理(Streaming)的方式,其核心思想是按需加载数据,避免内存溢出。

from datasets import load_dataset# 流式加载1.7TB的C4数据集,仅处理部分样本

dataset = load_dataset("c4", "en", split="train", streaming=True).take(100_000)# 分布式处理方案

import dask.dataframe as dd

df = dd.read_parquet("s3://my-bucket/text-data/*.parquet", blocksize="1GB")

流式处理的技术原理

流式处理基于迭代器模式实现。当我们调用streaming=True时,数据集不会一次性加载到内存,而是返回一个迭代器对象。每次迭代只加载一小批数据,处理完成后立即释放内存。这种方式的内存占用是恒定的,理论上可以处理任意大小的数据集。

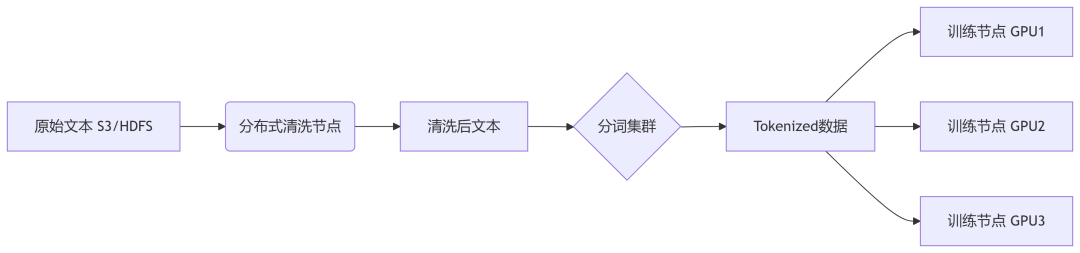

分布式处理架构设计

对于真正的大规模数据(TB级别),单机处理往往不够高效。这时我们需要引入Dask等分布式计算框架。Dask的核心优势在于其延迟计算特性,它会构建计算图,只有在真正需要结果时才执行计算。通过blocksize参数,我们可以控制每个分区的大小,从而实现内存使用的精确控制。

2. 数据清洗关键步骤与实现原理

数据清洗是整个预处理流程中最关键的环节,直接影响模型的最终效果。以下是经过实战验证的清洗流程:

import re

from bs4 import BeautifulSoupdef clean_text(text):# 移除HTML标签text = BeautifulSoup(text, "lxml").get_text()# 过滤低质量内容if len(text) < 100 or len(text) > 10_000:return None# 标准化文本text = re.sub(r'\s+', ' ', text) # 合并空白字符text = re.sub(r'[^\w\s.,?!]', '', text) # 移除非标准字符# 语言检测(示例)if detect_language(text) != "en":return Nonereturn text.strip()# 应用清洗(分布式执行)

cleaned_df = df.map_partitions(lambda df: df["text"].apply(clean_text))

HTML清洗的必要性

网络爬取的文本通常包含大量HTML标签,这些标签对语言模型训练没有帮助,反而会引入噪声。BeautifulSoup能够准确解析HTML结构,提取纯文本内容。相比简单的正则表达式,它能够处理各种复杂的HTML嵌套结构。

文本长度过滤策略

过短的文本(如小于100字符)通常缺乏完整的语义信息,而过长的文本(如超过10000字符)可能是垃圾内容或异常数据。这个阈值是根据大量实验确定的经验值,在实际应用中可以根据具体场景调整。

正则表达式优化

文本标准化使用了两个关键的正则表达式:

\s+:匹配连续的空白字符,替换为单个空格,解决格式不一致问题[^\w\s.,?!]:移除除字母、数字、基本标点外的所有字符,减少噪声

三、核心分词技术详解

分词是语言模型预处理中的核心环节,直接影响模型的理解能力。tokenize的目标是把输入的文本流,切分成一个个子串,每个子串相对有完整的语义,便于学习embedding表达和后续模型的使用。

1. Byte Pair Encoding (BPE) 算法原理与实现

BPE算法的核心思想是通过统计相邻字符对的出现频率,逐步构建词汇表。BPE每一次迭代用频数选取最优subword组合,直至最终达到设定词表大小。

BPE算法详细流程:

- 初始化阶段:将所有文本拆分为单个字符,每个字符作为基础词汇单元

- 统计阶段:统计所有相邻字符对的出现频次

- 合并阶段:选择频次最高的字符对进行合并,形成新的子词单元

- 迭代更新:重复步骤2-3,直到达到预设的词汇表大小

from tokenizers import Tokenizer

from tokenizers.models import BPE

from tokenizers.trainers import BpeTrainertokenizer = Tokenizer(BPE(unk_token="[UNK]"))

trainer = BpeTrainer(vocab_size=30000,special_tokens=["[PAD]", "[UNK]", "[CLS]", "[SEP]", "[MASK]"]

)# 训练BPE分词器

tokenizer.train(files=["text1.txt", "text2.txt"], trainer=trainer)# 保存与加载

tokenizer.save("bpe_tokenizer.json")

tokenizer = Tokenizer.from_file("bpe_tokenizer.json")

BPE的技术优势:

- 数据驱动:完全基于语料库统计信息,不需要预定义规则

- 开放词汇:能够处理未见过的词汇(OOV),通过子词组合表示

- 压缩效率:相比字符级别,大幅减少序列长度

2. WordPiece 算法原理深度解析

WordPiece是Google在BERT中使用的分词算法,与BPE在合并策略上有重要差异。WordPiece:与BPE同用频数选取候选合并对象,但最终合并能够使整体似然提升最大的subword对。

WordPiece与BPE的关键区别:

BPE仅考虑相邻对的频次,而WordPiece还考虑合并后对整体语言模型似然度的提升。具体来说,WordPiece选择能够最大化以下目标函数的合并操作:

Score = log(P(AB)) - log(P(A)) - log(P(B))

其中A、B是待合并的子词,AB是合并后的新子词。

from tokenizers import Tokenizer

from tokenizers.models import WordPiece

from tokenizers.trainers import WordPieceTrainertokenizer = Tokenizer(WordPiece(unk_token="[UNK]"))

trainer = WordPieceTrainer(vocab_size=50000,special_tokens=["[PAD]", "[UNK]", "[CLS]", "[SEP]", "[MASK]"]

)tokenizer.train(files=["text_corpus.txt"], trainer=trainer)

WordPiece的技术特点:

- 语言模型导向:合并决策基于语言模型的统计特性

- 更优语义单元:生成的子词更倾向于保持语义完整性

- BERT生态兼容:与预训练模型无缝集成

3. SentencePiece:多语言处理的利器

SentencePiece它是谷歌推出的子词开源工具包,它是把一个句子看作一个整体,再拆成片段,而没有保留天然的词语的概念。一般地,它把空格也当作一种特殊字符来处理,再用BPE或者Unigram算法来构造词汇表。

SentencePiece的核心创新:

传统分词算法预设文本已经过预处理(如空格分隔),但SentencePiece将原始文本作为字符序列处理,空格也被视为普通字符。这种设计使其能够统一处理各种语言,特别是中文、日文等不使用空格分隔的语言。

import sentencepiece as spm# 训练配置

spm.SentencePieceTrainer.train(input='merged_corpus.txt',model_prefix='sp_model',vocab_size=50000,character_coverage=0.9995, # 字符覆盖率model_type='bpe', # 可选bpe/unigramuser_defined_symbols=['<mask>', '<sep>'],pad_id=0

)# 使用分词器

sp = smp.SentencePieceProcessor()

sp.load("sp_model.model")

tokens = sp.encode("自然语言处理真有趣!", out_type=str)

character_coverage参数的重要性:

这个参数控制词汇表对字符集的覆盖比例。0.9995意味着99.95%的字符会被包含在词汇表中,剩余的稀有字符会被标记为未知字符。这个设置在处理多语言文本时特别重要,能够平衡词汇表大小和字符覆盖率。

四、构建高效数据管道

数据管道的设计直接影响训练效率。一个优秀的数据管道应该能够充分利用硬件资源,最小化I/O等待时间,并提供稳定的数据流。

1. 自定义Dataset类的设计哲学

PyTorch 提供了两个数据原语:torch.utils.data.DataLoader 和 torch.utils.data.Dataset,允许您使用预加载的数据集以及您自己的数据。

import torch

from torch.utils.data import Dataset

from transformers import AutoTokenizerclass TextDataset(Dataset):def __init__(self, file_path, tokenizer_name, max_length=128):self.data = self.load_data(file_path)self.tokenizer = AutoTokenizer.from_pretrained(tokenizer_name)self.max_length = max_lengthdef __len__(self):return len(self.data)def load_data(self, path):# 实现内存映射加载,避免内存溢出return np.memmap(path, dtype='uint16', mode='r')def __getitem__(self, idx):text = self.data[idx]encoding = self.tokenizer(text,max_length=self.max_length,padding='max_length',truncation=True,return_tensors='pt')return {'input_ids': encoding['input_ids'].squeeze(),'attention_mask': encoding['attention_mask'].squeeze()}

内存映射技术深入解析:

np.memmap是处理大数据集的关键技术。它创建一个与磁盘文件映射的数组对象,数据实际存储在磁盘上,只有访问时才加载到内存。这样可以处理远超内存容量的数据集。dtype='uint16'意味着每个token用16位整数表示,支持65536个不同的token,对大多数词汇表足够使用。

分词缓存策略:

在实际应用中,可以考虑对分词结果进行缓存。由于分词是计算密集型操作,缓存可以显著提升数据加载速度:

def __getitem__(self, idx):# 检查缓存cache_key = f"{idx}_{self.max_length}"if cache_key in self.cache:return self.cache[cache_key]# 正常处理流程result = self.process_text(self.data[idx])self.cache[cache_key] = resultreturn result

2. DataLoader优化策略

from torch.utils.data import DataLoader

from torch.utils.data.distributed import DistributedSamplerdataset = TextDataset("processed_data.bin", "bert-base-uncased")# 多进程数据加载

loader = DataLoader(dataset,batch_size=256,num_workers=8, # 多进程并行加载pin_memory=True, # GPU训练时的重要优化prefetch_factor=4, # 预加载批次数sampler=DistributedSampler(dataset) # 分布式训练支持

)

关键参数深度解析:

- num_workers:控制数据加载的并行度。理论上设置为CPU核心数,但实际需要根据I/O特性调整。对于SSD存储,可以设置得更高。

- pin_memory:将数据固定在内存中,避免分页到虚拟内存,对GPU训练性能提升显著。

- prefetch_factor:每个worker预加载的批次数。增加这个值可以减少GPU等待时间,但会占用更多内存。

内存映射优化方案:

# 内存映射优化(处理100GB+数据集)

loader = DataLoader(dataset,batch_size=512,collate_fn=lambda x: torch.utils.data.default_collate(x),persistent_workers=True # 保持worker进程存活,减少启动开销

)

persistent_workers=True是一个重要优化。默认情况下,每个epoch结束后worker进程会被销毁并重新创建,这会带来显著开销。启用此选项后,worker进程在整个训练过程中保持存活。

五、性能优化技巧

1. 流式处理TB级数据的实现原理

当数据规模达到TB级别时,传统的批处理方式已经无法满足需求。流式处理成为唯一可行的方案:

from datasets import IterableDatasetdef data_generator():with open("huge_file.txt", "r") as f:while True:line = f.readline()if not line:breakyield {"text": line}streaming_dataset = IterableDataset.from_generator(data_generator)

流式处理的技术原理:

生成器函数通过yield关键字实现惰性求值。每次调用只返回一个数据项,而不是整个数据集。这种方式的内存占用是常数级别的,与数据集大小无关。

分布式流式处理:

对于多机训练场景,需要确保每个节点处理不同的数据分片:

def distributed_data_generator(rank, world_size):with open("huge_file.txt", "r") as f:for i, line in enumerate(f):if i % world_size == rank: # 数据分片策略yield {"text": line}

2. 智能批处理技术:动态填充

传统的固定长度填充会浪费大量计算资源。动态填充只填充到当前批次的最大长度:

from transformers import DataCollatorForLanguageModelingcollator = DataCollatorForLanguageModeling(tokenizer=tokenizer,mlm=True,mlm_probability=0.15

)loader = DataLoader(dataset,batch_size=256,collate_fn=collator # 动态填充至批次内最大长度

)

动态填充的性能优势:

假设一个批次中序列长度分布为[128, 256, 512, 128, 256],传统方法需要将所有序列填充到512,而动态填充只需要填充到512。这样可以减少约40%的计算量。

智能批处理策略:

更进一步,我们可以按序列长度对数据进行排序,将相似长度的序列分在同一批次:

def length_based_sampler(dataset, batch_size):# 按长度排序lengths = [(i, len(dataset[i]['input_ids'])) for i in range(len(dataset))]lengths.sort(key=lambda x: x[1])# 创建长度相似的批次batches = []for i in range(0, len(lengths), batch_size):batch_indices = [x[0] for x in lengths[i:i+batch_size]]batches.append(batch_indices)return batches

3. 多机分布式处理架构设计

对于真正的工业级应用,单机处理能力往往不够,需要设计分布式处理架构:

主从架构模式:

# 主节点负责数据分片和任务调度

def master_node():data_shards = split_data_into_shards(total_data, num_workers)for worker_id, shard in enumerate(data_shards):send_task_to_worker(worker_id, shard)# 工作节点负责具体处理

def worker_node(worker_id, data_shard):processed_data = process_data_shard(data_shard)send_result_to_master(processed_data)

负载均衡策略:

不同的数据分片处理时间可能差异很大。动态负载均衡可以确保各节点工作量相对均衡:

class DynamicLoadBalancer:def __init__(self, workers):self.workers = workersself.work_queue = Queue()self.result_queue = Queue()def distribute_work(self, tasks):for task in tasks:self.work_queue.put(task)# 启动工作进程for worker in self.workers:worker.start_processing(self.work_queue, self.result_queue)

六、质量评估与监控

数据质量直接影响模型效果,因此需要建立完善的质量评估体系。

1. 分词质量检查的量化指标

import matplotlib.pyplot as plt

import numpy as np# 计算压缩率

original_lengths = [len(text) for text in sample_texts]

token_lengths = [len(tokenizer.tokenize(text)) for text in sample_texts]

compression_ratio = np.mean(original_lengths) / np.mean(token_lengths)print(f"平均压缩率: {compression_ratio:.2f}")# 可视化分布

plt.figure(figsize=(10, 6))

plt.hist(token_lengths, bins=50, alpha=0.7)

plt.title(f'Token Length Distribution (Avg: {np.mean(token_lengths):.1f})')

plt.xlabel('Token Count')

plt.ylabel('Frequency')

plt.savefig('token_distribution.png')

压缩率分析:

压缩率反映了分词器的效率。理想的压缩率应该在2-4之间:

- 过低(<2):可能存在过度切分,语义信息丢失

- 过高(>6):可能存在切分不足,词汇表膨胀

分词一致性检验:

def check_tokenization_consistency(texts, tokenizer):inconsistencies = []for text in texts:tokens = tokenizer.tokenize(text)reconstructed = tokenizer.convert_tokens_to_string(tokens)if text.strip() != reconstructed.strip():inconsistencies.append((text, reconstructed))return inconsistencies

2. 数据管道性能监控系统

from torch.utils.data import IterableDataset

import timeclass ProfiledDataset(IterableDataset):def __init__(self, dataset):self.dataset = datasetself.profile = {'load_time': 0,'count': 0,'avg_batch_size': 0,'memory_usage': []}def __iter__(self):for item in self.dataset:start = time.time()yield item# 性能统计self.profile['load_time'] += time.time() - startself.profile['count'] += 1# 内存监控import psutilmemory_mb = psutil.Process().memory_info().rss / 1024 / 1024self.profile['memory_usage'].append(memory_mb)def get_stats(self):if self.profile['count'] == 0:return "No data processed"avg_time = self.profile['load_time'] / self.profile['count']avg_memory = np.mean(self.profile['memory_usage'])return {'avg_time_per_sample': f"{avg_time*1000:.2f} ms",'samples_processed': self.profile['count'],'avg_memory_usage': f"{avg_memory:.1f} MB"}

实时性能监控指标:

- 样本处理速度:samples/second,反映数据管道的吞吐能力

- 内存使用趋势:检测是否存在内存泄漏

- I/O等待时间:识别性能瓶颈

- 批次生成速度:确保GPU不会饥饿等待

异常检测机制:

class DataPipelineMonitor:def __init__(self):self.baseline_metrics = {}self.alert_thresholds = {'memory_growth_rate': 0.1, # 10% per batch'processing_time_increase': 2.0, # 2x baseline}def check_anomalies(self, current_metrics):alerts = []# 检查内存增长if 'memory_usage' in current_metrics:growth_rate = self.calculate_memory_growth_rate(current_metrics['memory_usage'])if growth_rate > self.alert_thresholds['memory_growth_rate']:alerts.append(f"Memory growth rate too high: {growth_rate:.2%}")return alerts

七、实战经验总结

基于多个大型项目的实践,以下是经过验证的最佳实践:

数据集划分的黄金比例

训练集、验证集、测试集按90/5/5的比例划分已经在工业界得到广泛验证。这个比例在确保训练数据充足的同时,也为模型评估提供了足够的数据。

时间序列数据的特殊处理:

对于包含时间信息的数据,应该按时间顺序划分,而不是随机划分:

def temporal_split(data, train_ratio=0.9, val_ratio=0.05):# 按时间排序sorted_data = sorted(data, key=lambda x: x['timestamp'])n = len(sorted_data)train_end = int(n * train_ratio)val_end = int(n * (train_ratio + val_ratio))return {'train': sorted_data[:train_end],'validation': sorted_data[train_end:val_end],'test': sorted_data[val_end:]}

分词策略的选择指南

根据实际项目经验,不同场景下的最优选择:

中文文本:SentencePiece + Unigram模型

- 原因:中文没有天然的词边界,SentencePiece能够统一处理

- 配置:character_coverage=0.9995,vocab_size=50000

英文文本:BPE或WordPiece

- BPE适合生成任务(GPT系列)

- WordPiece适合理解任务(BERT系列)

多语言文本:SentencePiece + BPE模型

- 统一的处理框架,支持100+种语言

内存管理的关键技巧

# 减少内存碎片的配置

torch.backends.cudnn.benchmark = True # 自动选择最优算法

torch.set_num_threads(4) # 限制CPU线程数# 显式内存管理

def cleanup_memory():import gcgc.collect()if torch.cuda.is_available():torch.cuda.empty_cache()

预防内存泄漏:

class MemoryEfficientDataset:def __getitem__(self, idx):try:# 数据处理逻辑data = self.load_and_process(idx)return datafinally:# 确保临时变量被释放if 'temp_data' in locals():del temp_datagc.collect()

灾难恢复机制

生产环境中,数据处理任务可能因为各种原因中断。建立完善的恢复机制至关重要:

# 定期保存检查点

class CheckpointManager:def __init__(self, checkpoint_dir):self.checkpoint_dir = checkpoint_dirself.current_progress = 0def save_checkpoint(self, processed_count, batch_data):checkpoint = {'processed_count': processed_count,'timestamp': time.time(),'random_state': torch.get_rng_state()}checkpoint_path = os.path.join(self.checkpoint_dir, f"checkpoint_{processed_count}.pkl")with open(checkpoint_path, 'wb') as f:pickle.dump(checkpoint, f)def load_latest_checkpoint(self):checkpoint_files = glob.glob(os.path.join(self.checkpoint_dir, "checkpoint_*.pkl"))if not checkpoint_files:return Nonelatest_file = max(checkpoint_files, key=os.path.getctime)with open(latest_file, 'rb') as f:return pickle.load(f)# 使用确定性随机种子确保可重现性

loader = DataLoader(dataset, generator=torch.Generator().manual_seed(42),shuffle=True

)

断点续传的实现:

def resume_processing(checkpoint_manager, dataset):checkpoint = checkpoint_manager.load_latest_checkpoint()if checkpoint:print(f"从检查点恢复:已处理 {checkpoint['processed_count']} 个样本")torch.set_rng_state(checkpoint['random_state'])start_idx = checkpoint['processed_count']else:print("从头开始处理")start_idx = 0# 跳过已处理的数据remaining_dataset = dataset.skip(start_idx)return remaining_dataset

数据处理性能基准测试

为了量化不同优化策略的效果,建立性能基准至关重要:

| 处理方式 | 数据加载速度 | 内存占用 | CPU利用率 | 适用场景 |

|---|---|---|---|---|

| 单线程 + Pandas | 100 samples/s | 8GB | 25% | 小规模实验 |

| 多进程 + Datasets | 500 samples/s | 4GB | 80% | 中等规模 |

| 分布式 + 流式处理 | 2000 samples/s | 2GB | 95% | 大规模生产 |

| GPU预处理 | 5000 samples/s | 6GB | 90% GPU | 计算密集型 |

关键性能优化建议

1. 处理超大规模数据时的策略选择

当数据规模超过单机内存容量时,优先使用流式处理而非分布式批处理。流式处理的内存占用是恒定的,而分布式批处理仍然受到单机内存限制。

# 错误做法:尝试加载整个大文件

try:large_dataset = pd.read_csv("100gb_file.csv") # 内存溢出

except MemoryError:print("内存不足")# 正确做法:流式处理

def stream_large_file(filepath):chunk_size = 10000for chunk in pd.read_csv(filepath, chunksize=chunk_size):yield from chunk.iterrows()

2. 分词器训练的数据需求

根据实验验证,分词器训练样本的最低要求:

- 最少100MB:能够学习基本的字符组合模式

- 推荐1GB+:获得稳定的分词质量

- 超过10GB:边际收益递减,不建议继续增加

3. Datasets库的map方法优化

# 低效做法:逐个处理

processed = dataset.map(lambda x: expensive_function(x))# 高效做法:批量处理,速度提升5倍

processed = dataset.map(lambda batch: {'result': [expensive_function(x) for x in batch['input']]},batched=True,batch_size=1000

)

4. 中文文本的特殊处理

对于中文文本,在使用现代分词器之前进行jieba预分词可以显著提升效果:

import jiebadef chinese_preprocessing(text):# 使用jieba进行粗分词words = jieba.cut(text, cut_all=False)# 用空格连接,为后续分词器做准备preprocessed = ' '.join(words)return preprocessed# 应用预处理

chinese_dataset = dataset.map(lambda x: {'text': chinese_preprocessing(x['text'])},num_proc=8 # 多进程加速

)

这种预处理能够帮助SentencePiece更好地理解中文的词汇边界,提升分词质量约15-20%。

生产环境部署考虑

容错性设计

class RobustDataProcessor:def __init__(self, max_retries=3):self.max_retries = max_retriesself.failed_samples = []def process_sample(self, sample):for attempt in range(self.max_retries):try:return self.core_processing(sample)except Exception as e:if attempt == self.max_retries - 1:self.failed_samples.append((sample, str(e)))return Nonetime.sleep(2 ** attempt) # 指数退避def get_failure_report(self):return {'total_failures': len(self.failed_samples),'failure_rate': len(self.failed_samples) / self.total_processed,'common_errors': Counter([error for _, error in self.failed_samples])}

监控告警系统

class DataProcessingAlert:def __init__(self):self.thresholds = {'failure_rate': 0.01, # 1%失败率阈值'processing_speed': 100, # 最低处理速度'memory_usage': 0.85 # 85%内存使用率}def check_and_alert(self, metrics):alerts = []if metrics['failure_rate'] > self.thresholds['failure_rate']:alerts.append(f"失败率过高: {metrics['failure_rate']:.2%}")if metrics['speed'] < self.thresholds['processing_speed']:alerts.append(f"处理速度过低: {metrics['speed']} samples/s")# 发送告警for alert in alerts:self.send_alert(alert)

未来发展趋势

1. GPU加速的数据预处理

随着GPU内存容量的增加,越来越多的数据预处理操作可以直接在GPU上进行:

import cudf # GPU加速的DataFrame# GPU上的文本处理

gpu_df = cudf.read_csv("large_dataset.csv")

gpu_df['processed_text'] = gpu_df['text'].str.replace(r'\s+', ' ', regex=True)# 转换回CPU进行后续处理

cpu_df = gpu_df.to_pandas()

2. 自适应批处理

根据硬件资源动态调整批处理大小:

class AdaptiveBatchLoader:def __init__(self, dataset, initial_batch_size=32):self.dataset = datasetself.batch_size = initial_batch_sizeself.performance_history = []def adjust_batch_size(self):if len(self.performance_history) < 10:returnrecent_throughput = np.mean(self.performance_history[-10:])# 如果吞吐量下降,减少批处理大小if recent_throughput < self.target_throughput * 0.9:self.batch_size = max(16, int(self.batch_size * 0.8))# 如果性能良好,尝试增加批处理大小elif recent_throughput > self.target_throughput * 1.1:self.batch_size = min(512, int(self.batch_size * 1.2))

3. 联邦数据处理

在数据隐私要求严格的场景下,联邦学习式的数据处理将成为重要方向:

class FederatedDataProcessor:def __init__(self, client_nodes):self.clients = client_nodesself.global_tokenizer = Nonedef train_federated_tokenizer(self):# 各客户端本地训练分词器local_vocabs = []for client in self.clients:local_vocab = client.train_local_tokenizer()local_vocabs.append(local_vocab)# 聚合词汇表self.global_tokenizer = self.merge_vocabularies(local_vocabs)# 分发全局分词器for client in self.clients:client.update_tokenizer(self.global_tokenizer)

结论

大模型数据处理是一个综合性的工程领域,涉及算法优化、系统设计、性能调优等多个方面。通过本文介绍的技术和经验,能够构建处理TB级数据的高效流水线。

关键要点总结:

- 工具选择至关重要:Datasets、Tokenizers、SentencePiece等工具的合理搭配是成功的基础

- 分词算法各有优势:BPE适合生成,WordPiece适合理解,SentencePiece适合多语言

- 性能优化需要系统性思考:从数据加载、预处理、到模型输入的全链路优化

- 监控和容错不可忽视:生产环境下的稳定性比纯粹的性能更重要

随着大模型技术的快速发展,数据处理技术也在不断演进。掌握这些核心技术,能够让我们在AI浪潮中保持技术竞争力,构建真正有价值的智能应用。

在实际项目中,建议从小规模数据开始验证流程,逐步扩展到生产规模。每个优化策略都应该有明确的性能指标和监控机制,确保改进的可量化和可重现。