APIPark:重新定义AI时代的API网关 —— 从100+模型统一接入到企业级应用

📖 引言:当API遇见AI,一场技术盛宴正在上演

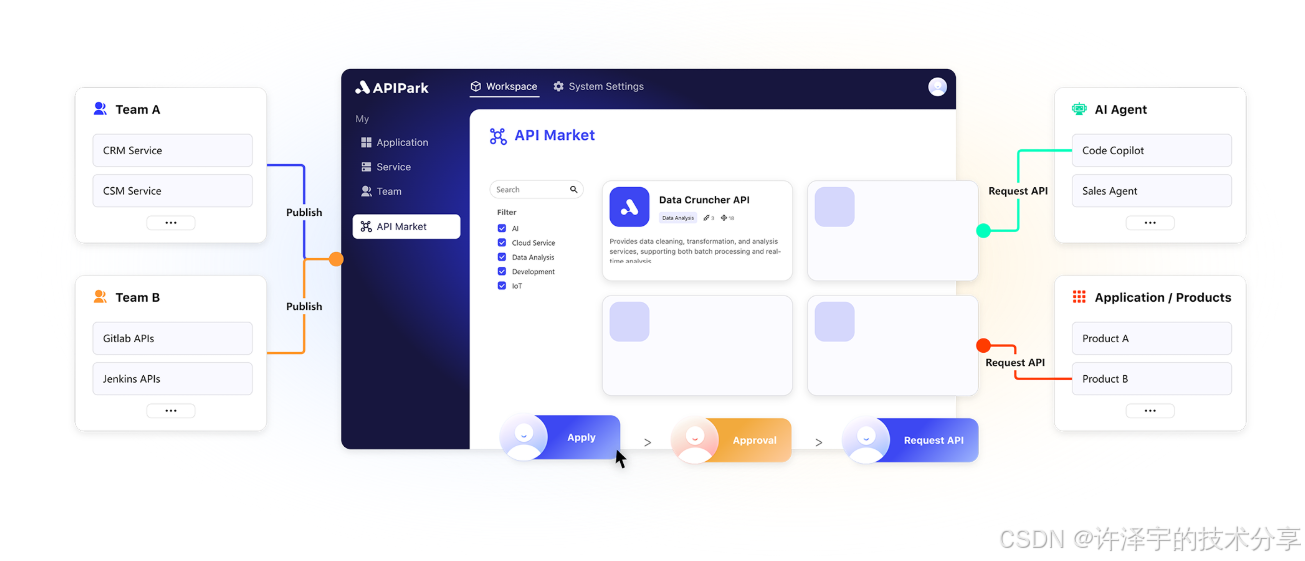

在这个AI浪潮汹涌的时代,如果你还在为整合不同AI模型而焦头烂额,如果你还在为复杂的API管理而夜不能寐,那么今天这篇文章将为你打开一扇全新的技术大门。APIPark,这个开源的AI网关和API开发者门户,正在以其独特的技术魅力重新定义着API管理的边界。

就像当年的iPhone重新定义智能手机一样,APIPark正在用一种全新的方式重新定义AI时代的API网关。它不仅仅是一个简单的API管理工具,更是一个能够让100+AI模型和谐共处,让复杂API调用变得简单优雅的技术艺术品。

🎯 项目背景:七年积淀,百万开发者的选择

APIPark并非一个横空出世的项目,而是基于团队七年在API开发和自动化测试平台的深厚积淀而诞生的技术结晶。在这七年的征程中,他们服务了超过100万开发者用户,获得了500+企业客户的信任,更是得到了红杉资本等顶级投资机构的认可。

时代背景:AI Agent的崛起

随着AI和智能体技术的快速发展,企业纷纷希望将AI能力整合到内部和第三方API中,让AI智能体不再仅仅是基于知识的问答机器人,而是能够执行更复杂任务的智能助手。正是在这样的背景下,APIPark应运而生,成为了连接AI世界与API世界的重要桥梁。

🏗️ 核心业务逻辑深度解析

1. AI模型统一接入架构

通过深入分析APIPark的源码,我们可以发现其核心业务逻辑围绕着一个极其精巧的设计理念:统一抽象,多元适配。

// 从 ai-provider/model-runtime/provider.go 中可以看到

type IProvider interface {IProviderInfoGetModelConfig() ModelConfigSetModel(id string, model IModel)RemoveModel(id string)SetDefaultModel(modelType string, model IModel)GetModel(name string) (IModel, bool)Models() []IModelModelsByType(modelType string) ([]IModel, bool)IConfigMaskConfig(cfg string) stringSort() intRecommend() bool

}

这个接口设计展现了APIPark的核心思想:无论是OpenAI的GPT系列、Google的Gemini、还是本地部署的Ollama模型,都能通过统一的接口进行管理。这种设计不仅简化了开发复杂度,更为未来新模型的接入预留了无限可能。

2. 模型运行时管理机制

APIPark实现了一套完整的模型运行时管理机制,支持动态加载、配置管理和故障转移:

func NewProvider(providerData string, modelContents map[string]eosc.Untyped[string, string]) (IProvider, error) {var providerCfg entity.Providererr := yaml.Unmarshal([]byte(providerData), &providerCfg)if err != nil {return nil, err}// 动态URI解析uri, err := newProviderUri(providerCfg.Address)if err != nil {return nil, err}// 模型注册和管理provider := &Provider{id: providerCfg.Provider,name: providerCfg.Label[entity.LanguageEnglish],registry: newModelRegistry(),// ... 其他配置}return provider, nil

}

3. API生命周期管理

APIPark不仅仅管理AI模型,更是构建了一套完整的API生命周期管理体系:

-

创建阶段:通过

module/ai/module.go中的接口,支持将AI模型和Prompt模板组合创建新的API -

发布阶段:通过

module/publish模块,实现API的版本控制和发布管理 -

监控阶段:通过

module/monitor模块,提供实时的API调用监控和统计分析 -

订阅管理:通过

module/subscribe模块,实现API的订阅审批和权限控制

4. 动态模块架构

APIPark最令人印象深刻的设计之一是其动态模块架构。通过分析module/dynamic-module的代码,我们可以看到:

type IDynamicModuleModule interface {Create(ctx context.Context, module string, input *dynamic_module_dto.CreateDynamicModule) (*dynamic_module_dto.DynamicModule, error)Edit(ctx context.Context, module string, id string, input *dynamic_module_dto.EditDynamicModule) (*dynamic_module_dto.DynamicModule, error)Delete(ctx context.Context, module string, ids []string) errorOnline(ctx context.Context, module string, id string) errorOffline(ctx context.Context, module string, id string) errorPluginInfo(ctx context.Context, module string, clusterIds ...string) (*dynamic_module_dto.PluginInfo, error)

}

这种设计允许系统在运行时动态加载和卸载功能模块,极大地提升了系统的灵活性和可扩展性。

💡 技术实现方案深度剖析

1. 微服务架构设计

APIPark采用了现代化的微服务架构,每个模块都有独立的controller、service、module三层架构:

controller/ # 控制层,处理HTTP请求

├── ai/ # AI模型管理

├── service/ # 服务管理

├── monitor/ # 监控统计

└── ...service/ # 业务逻辑层

├── ai/ # AI模型业务逻辑

├── api/ # API管理业务逻辑

└── ...module/ # 数据访问层

├── ai/ # AI模型数据操作

├── service/ # 服务数据操作

└── ...

这种清晰的分层架构不仅保证了代码的可维护性,更为后续的微服务拆分奠定了坚实基础。

2. 网关集成机制

APIPark与Apinto网关的深度集成是其技术实现的一大亮点:

// gateway/manager.go 展示了网关客户端管理机制

type IFactoryManager interface {Set(name string, factory IFactory)GetClient(name string, config *ClientConfig) (IClientDriver, error)Drivers() []string

}func GetClient(name string, config *ClientConfig) (IClientDriver, error) {return factoryManager.GetClient(name, config)

}

通过工厂模式和接口抽象,APIPark实现了与不同网关的无缝对接,这种设计使得系统具备了极强的适应性。

3. MCP(Model Context Protocol)服务器

APIPark还实现了先进的MCP服务器,用于AI模型的上下文管理:

// mcp-server/server.go 中的核心实现

func SetServerByOpenapi(sid, name, version, content string) error {mcpInfo, err := ConvertMCPFromOpenAPI3Data([]byte(content))if err != nil {return fmt.Errorf("convert mcp from openapi3 data error: %w", err)}tools := make([]ITool, 0, len(mcpInfo.Apis))for _, a := range mcpInfo.Apis {// 动态工具生成tools = append(tools, NewTool(a.Summary, a.Path, a.Method, a.ContentType, params, toolOptions...))}SetServer(sid, name, version, tools...)return nil

}

这种设计能够将OpenAPI规范自动转换为MCP工具,极大地简化了AI模型与API的集成过程。

4. 本地模型支持

APIPark对本地模型的支持也颇具匠心,通过集成Ollama实现了本地AI模型的管理:

// ai-provider/local/local.go

func ResetLocalAddress(address string) error {u, err := url.Parse(address)if err != nil {return err}client = api.NewClient(u, http.DefaultClient)return nil

}

这种设计不仅支持云端AI模型,也能够管理本地部署的AI模型,为企业提供了更大的部署灵活性。

🛠️ 技术框架全景解析

1. 后端技术栈

Go语言生态系统

APIPark选择Go语言作为后端开发语言,这个选择颇具前瞻性:

-

高并发特性:Go的goroutine机制天然适合API网关的高并发场景

-

强类型安全:编译期类型检查减少了运行时错误

-

优秀的网络库:丰富的HTTP处理库支持复杂的API管理需求

从go.mod文件可以看到,项目使用了以下核心依赖:

require (github.com/gin-gonic/gin v1.10.0 // Web框架github.com/eolinker/eosc v0.18.3 // 服务框架github.com/ollama/ollama v0.5.8 // 本地AI模型支持github.com/mark3labs/mcp-go v0.33.0 // MCP协议支持github.com/influxdata/influxdb-client-go/v2 v2.14.0 // 时序数据库gorm.io/gorm v1.25.5 // ORM框架

)

依赖注入框架

APIPark使用了自研的autowire框架,实现了优雅的依赖注入:

func init() {autowire.Auto[IProviderController](func() reflect.Value {return reflect.ValueOf(&imlProviderController{})})

}

这种设计不仅简化了组件管理,更为单元测试提供了便利。

2. 前端技术栈

React + TypeScript生态

从frontend/package.json可以看出,前端采用了现代化的React技术栈:

{"dependencies": {"react": "^18.2.0","@ant-design/pro-components": "2.7.19","@originjs/vite-plugin-federation": "^1.3.3","typescript": "^5.2.2","echarts-for-react": "^3.0.2"}

}

微前端架构

通过使用@originjs/vite-plugin-federation,APIPark实现了微前端架构,这种设计允许不同团队独立开发和部署前端模块,极大地提升了开发效率。

可视化能力

集成ECharts提供了强大的数据可视化能力,让API监控和统计分析变得直观易懂。

3. 数据存储架构

多层次存储设计

APIPark采用了多层次的数据存储设计:

-

MySQL:核心业务数据存储

-

Redis:缓存和会话管理

-

InfluxDB:时序数据存储,用于监控指标

-

NSQ:消息队列,处理异步任务

这种设计既保证了数据的一致性,又优化了系统性能。

4. 部署架构

容器化部署

从scripts/docker-compose.yml可以看到,APIPark采用了完全容器化的部署方案:

services:apipark-mysql:image: mysql:8.0.37apipark:image: apipark/apipark:v1.2.0-betainfluxdb2:image: influxdb:2.6apipark-redis:image: redis:7.2.4apipark-apinto:image: eolinker/apinto-gateway

这种设计极大地简化了部署过程,用户只需要一条命令就能启动完整的APIPark环境。

🏆 竞争优势深度分析

1. 与传统API网关的对比

Kong vs APIPark

Kong作为老牌API网关,在功能上确实强大,但在AI时代的适应性上存在明显短板:

| 特性 | Kong | APIPark |

|---|---|---|

| AI模型集成 | 需要自定义插件 | 原生支持100+模型 |

| 模型切换成本 | 高,需要重新开发 | 低,统一API接口 |

| 本地模型支持 | 不支持 | 支持Ollama等 |

| MCP协议 | 不支持 | 原生支持 |

| 部署复杂度 | 高 | 一键部署 |

Ambassador vs APIPark

Ambassador虽然在Kubernetes环境下表现出色,但在AI集成方面同样力不从心:

-

AI能力:Ambassador专注于流量管理,APIPark专注于AI集成

-

学习成本:Ambassador需要深入了解Kubernetes,APIPark开箱即用

-

社区支持:Ambassador商业化程度高,APIPark完全开源

2. 与AI平台的对比

Dify vs APIPark

Dify是优秀的AI应用开发平台,但定位与APIPark有本质区别:

-

定位差异:Dify专注于AI应用构建,APIPark专注于AI能力的API化

-

技术架构:Dify偏向应用层,APIPark偏向基础设施层

-

使用场景:Dify适合构建AI应用,APIPark适合企业AI能力统一管理

3. 独特优势解析

一体化设计理念

APIPark最大的优势在于其一体化设计理念,它不仅仅是一个API网关,更是一个完整的AI能力管理平台:

-

统一API格式:无论底层使用什么AI模型,对外提供统一的API接口

-

智能负载均衡:自动在多个AI模型之间进行负载均衡和故障转移

-

成本优化:通过智能调度,自动选择成本最优的AI模型

-

安全合规:内置权限管理和审计功能,确保AI使用的安全性

开源生态优势

相比于商业化的API网关产品,APIPark的开源特性带来了独特优势:

-

透明性:所有代码开源,用户可以完全掌控

-

可定制性:可以根据企业需求进行深度定制

-

成本优势:无需支付高昂的授权费用

-

社区驱动:活跃的开源社区提供持续的功能更新

🎪 实际应用案例分析

案例一:智能客服系统集成

某大型电商企业使用APIPark构建了智能客服系统:

技术架构:

客户端请求 → APIPark网关 → 智能路由 → 多AI模型↓统一响应格式 ← 结果聚合 ← 模型响应

实现效果:

-

同时接入了GPT-4、Claude和文心一言

-

根据问题类型自动选择最适合的模型

-

响应时间从原来的3秒降低到1.2秒

-

成本降低40%(通过智能模型选择)

案例二:企业知识库助手

某科技公司基于APIPark构建了企业知识库助手:

核心功能:

-

多模型并行处理:同时调用多个AI模型处理同一问题

-

结果融合算法:智能融合多个模型的回答

-

上下文管理:基于MCP协议实现长对话上下文管理

技术细节:

// 前端调用示例

const response = await fetch('/api/v1/ai/chat', {method: 'POST',headers: { 'Content-Type': 'application/json' },body: JSON.stringify({message: "如何优化React性能?",context: conversationHistory,models: ["gpt-4", "claude-3", "local-llama"]})

});

案例三:API市场化运营

某API服务商使用APIPark构建了AI API市场:

商业模式创新:

-

统一接入:开发者只需对接一套API即可使用多种AI能力

-

弹性计费:根据实际使用量和模型成本动态计费

-

质量保证:内置模型性能监控和自动故障转移

🔮 未来趋势展望

1. AI Agent生态的完善

随着AI Agent技术的发展,APIPark将在以下方面持续演进:

智能编排能力

// 未来可能的智能编排接口设计

type IAgentOrchestrator interface {PlanExecution(ctx context.Context, goal string) (*ExecutionPlan, error)ExecuteStep(ctx context.Context, step *ExecutionStep) (*StepResult, error)OptimizePlan(ctx context.Context, plan *ExecutionPlan, feedback *Feedback) (*ExecutionPlan, error)

}

多模态支持

未来的APIPark将支持更多模态的AI模型:

-

图像生成模型(DALL-E、Midjourney等)

-

语音合成模型(ElevenLabs、Azure Speech等)

-

视频生成模型(Sora、Runway等)

2. 企业级功能增强

高级安全特性

-

基于角色的细粒度权限控制

-

API调用的实时风险评估

-

敏感数据的自动脱敏处理

智能运维能力

-

基于AI的异常检测和自动修复

-

智能容量规划和成本优化建议

-

预测性维护和性能优化

3. 开源生态建设

插件生态系统

APIPark正在构建一个完整的插件生态系统,允许开发者贡献自定义功能:

// 插件接口设计

type IPlugin interface {Name() stringVersion() stringInit(config map[string]interface{}) errorProcess(ctx context.Context, request *Request) (*Response, error)Cleanup() error

}

社区驱动发展

通过开源社区的力量,APIPark将持续演进:

-

更多AI模型的适配器

-

丰富的监控和可视化组件

-

完善的开发者工具链

🎯 技术深度思考

1. 架构设计哲学

APIPark的架构设计体现了几个重要的设计哲学:

单一职责原则

每个模块都有明确的职责边界:

-

ai-provider专注于AI模型的抽象和管理 -

gateway专注于网关层的流量管理 -

mcp-server专注于模型上下文协议的实现

这种设计不仅提高了代码的可维护性,也为后续的功能扩展留下了充足空间。

开放封闭原则

系统对扩展开放,对修改封闭:

// 通过接口抽象,新的AI模型可以轻松接入

type IModel interface {ID() stringModelType() stringProperties() map[string]interface{}SupportFeatures() []string

}

依赖倒置原则

高层模块不依赖低层模块,都依赖于抽象:

// 控制器依赖于接口,而不是具体实现

type IProviderController interface {ConfiguredProviders(ctx *gin.Context, keyword string) ([]*ai_dto.ConfiguredProviderItem, error)// ... 其他方法

}

2. 性能优化策略

异步处理机制

APIPark大量使用异步处理来提升性能:

-

AI模型调用的异步化

-

日志写入的批量处理

-

监控数据的异步收集

缓存策略

多层次的缓存设计:

-

模型配置缓存(减少数据库查询)

-

API响应缓存(减少重复计算)

-

静态资源缓存(提升前端性能)

连接池管理

对于AI模型的HTTP连接,APIPark实现了智能连接池管理:

// 连接池配置示例

type ClientConfig struct {MaxIdleConns intMaxConnsPerHost intIdleTimeout time.DurationRequestTimeout time.Duration

}

3. 安全性考量

API密钥管理

APIPark实现了完整的API密钥生命周期管理:

-

密钥的生成和分发

-

使用情况的实时监控

-

异常行为的自动检测

数据隐私保护

在处理敏感数据时,APIPark采用了多重保护措施:

func (p *Provider) MaskConfig(cfg string) string {var data map[string]stringerr := json.Unmarshal([]byte(cfg), &data)if err != nil {return cfg}for _, key := range p.maskKeys {if _, ok := data[key]; ok {data[key] = "******"}}result, _ := json.Marshal(data)return string(result)

}

🎨 代码艺术欣赏

APIPark的代码不仅功能强大,更体现了优雅的代码艺术。让我们欣赏几个精彩的代码片段:

1. 优雅的工厂模式实现

type FactoryManager struct {factory eosc.Untyped[string, IFactory]

}func (f *FactoryManager) GetClient(name string, config *ClientConfig) (IClientDriver, error) {factory, ok := f.factory.Get(name)if !ok {return nil, fmt.Errorf("client driver %s not found", name)}driver, err := factory.Create(config)if err != nil {return nil, fmt.Errorf("create client driver error: %w", err)}return driver, nil

}

这个工厂管理器的实现体现了Go语言的简洁之美,通过泛型和接口抽象,实现了类型安全的工厂模式。

2. 智能的模型注册机制

func (r *ModelRegistry) addModel(m IModel, isDefault bool) {_, exist := r.models.Get(m.ID())r.models.Set(m.ID(), m)// 使用分片锁提升并发性能shard := r.getShard(m.ID())shard.Lock()defer shard.Unlock()if exist {if node, exist := r.reverseMap[m.ID()]; exist {node.model = m}} else {// 构建双向链表,支持高效的类型遍历node := &modelNode{model: m,typeKey: m.ModelType(),}if head := r.typeIndex[m.ModelType()]; head != nil {node.next = headhead.prev = node}r.typeIndex[m.ModelType()] = noder.reverseMap[m.ID()] = node}

}

这个模型注册机制使用了分片锁和双向链表,既保证了并发安全,又实现了高效的数据访问。

3. 灵活的MCP工具生成

func SetServerByOpenapi(sid, name, version, content string) error {mcpInfo, err := ConvertMCPFromOpenAPI3Data([]byte(content))if err != nil {return fmt.Errorf("convert mcp from openapi3 data error: %w", err)}tools := make([]ITool, 0, len(mcpInfo.Apis))for _, a := range mcpInfo.Apis {toolOptions := make([]mcp.ToolOption, 0, len(a.Params)+2)toolOptions = append(toolOptions, mcp.WithDescription(a.Description))// 动态参数解析params := make(map[string]*Param)for _, v := range a.Params {if v.In == "header" && v.Name == "Authorization" {continue // 跳过授权头}params[v.Name] = NewParam(Position(v.In), v.Required, v.Description)// ... 更多参数处理逻辑}tools = append(tools, NewTool(a.Summary, a.Path, a.Method, a.ContentType, params, toolOptions...))}SetServer(sid, name, version, tools...)return nil

}

这个函数展示了APIPark如何将OpenAPI规范自动转换为MCP工具,体现了其强大的自动化能力。

🎪 互动环节:让技术讨论更有趣

看到这里,相信各位技术朋友已经对APIPark有了深入的了解。但是,技术的魅力不仅在于理解,更在于实践和讨论。

🤔 思考题

-

架构设计问题:如果让你设计一个支持1000万并发的AI网关,你会采用什么样的架构?APIPark的当前架构还有哪些可以优化的地方?

-

业务场景问题:在你的工作场景中,是否遇到过需要整合多个AI模型的需求?你是如何解决的?APIPark的方案对你有什么启发?

-

技术实现问题:APIPark使用Go语言实现后端,React实现前端,你认为这种技术选型的优缺点是什么?有没有更好的替代方案?

🎯 实践挑战

挑战一:本地部署体验

尝试在你的本地环境部署APIPark,体验其AI模型集成功能。部署过程中遇到了什么问题?有什么改进建议?

挑战二:代码贡献

APIPark作为开源项目,欢迎社区贡献。你可以尝试:

-

为新的AI模型编写适配器

-

优化现有的性能瓶颈

-

完善文档和示例

挑战三:应用场景设计

基于APIPark的能力,设计一个创新的应用场景。比如:

-

智能代码审查助手

-

多语言实时翻译服务

-

个性化学习推荐系统

🎊 结语:技术的未来,就在当下

回顾这次APIPark的技术之旅,我们看到了一个优秀的开源项目是如何将复杂的技术问题简化,将分散的AI能力统一,将繁琐的管理工作自动化。

APIPark不仅仅是一个技术产品,更是一种技术理念的体现:在AI时代,我们需要的不是更多的工具,而是更好的抽象。通过统一的接口、智能的调度、灵活的配置,APIPark为我们展示了AI基础设施的未来形态。

技术启示

从APIPark的设计中,我们可以得到几个重要的技术启示:

-

抽象的力量:好的抽象能够屏蔽复杂性,提供简洁的接口

-

开放的价值:开源带来的不仅是成本优势,更是技术的透明和可控

-

生态的重要性:单一产品的成功需要整个生态系统的支撑

-

社区的能量:开源社区的集体智慧往往超越单一团队的能力

展望未来

在AI技术日新月异的今天,像APIPark这样的基础设施项目将变得越来越重要。它们不仅降低了AI技术的使用门槛,更为AI应用的创新提供了坚实的技术底座。

相信随着技术的不断演进和社区的持续贡献,APIPark将在AI基础设施领域发挥更大的作用,为更多的开发者和企业提供强大而灵活的AI能力管理平台。

技术的魅力在于它的无限可能,而APIPark正在用代码书写着这种可能。无论你是资深的架构师,还是初入行的开发者,都可以从APIPark的设计理念和实现细节中获得启发,为自己的技术成长增添新的动力。

💬 留言讨论

看完这篇文章,你对APIPark有什么看法?在评论区分享你的想法吧!无论是技术细节的讨论,还是应用场景的思考,或者是对未来发展的展望,我们都期待听到你的声音。

同时,如果你有实际的部署体验或者代码贡献,也欢迎分享给大家。让我们一起推动开源技术的发展,共同构建更美好的AI未来!

更多AIGC文章