Why Language Models Hallucinate 论文翻译

文章目录

- 论文翻译

- 摘要

- 第一章 引言

- 1.1 Errors caused by pretraining

- 1.2 为什么幻觉在后期训练中依然存在

- 2 相关工作

- 第三章 预训练中的错误

- 3.1 无提示的简化

- 3.2 提示的简化

- 3.3 基础模型的错误因素

- 3.3.1 随机事实的幻觉

- 3.3.2 糟糕的模型

- 3.4 其他因素

- 第四章 后期训练与幻觉

- 4.1 评估如何强化幻觉

- 4.2 显式的置信度目标

- 第五章 讨论与局限性

- 第六章 结论

- ❤️ 一起学AI

论文翻译

- https://www.arxiv.org/abs/2509.04664

- 翻译日期:20250912

- GPT + 谷歌翻译

- 笔记罢了,仅供参考

摘要

像面对难题的学生一样,当不确定时,语言模型有时会做出猜测,生成看似合理但实际上错误的陈述,而不是承认自己的不确定性。这种“幻觉”即使在最先进的系统中仍然存在,并且削弱了模型的可信度。我们认为语言模型会出现幻觉,因为训练和评估过程奖励猜测而非承认不确定性,我们分析了现代训练流程中幻觉的统计原因。幻觉并不神秘——它们只是二元分类中的错误。如果错误的陈述无法与事实区分开来,那么在预训练的语言模型中,幻觉将通过自然的统计压力产生。接着,我们认为幻觉之所以持续存在,是因为大多数评估方式的评分方式——语言模型在评估时被优化为“好学生”,而在不确定时进行猜测可以提高测试成绩。这种“惩罚不确定答案”的现象,只有通过一种社会技术性的缓解方式才能解决:修改现有基准的评分方式,这些基准不符合实际需求但却主导了排行榜,而不是引入额外的幻觉评估。这种改变可能会使该领域朝着更可信的人工智能系统发展。

第一章 引言

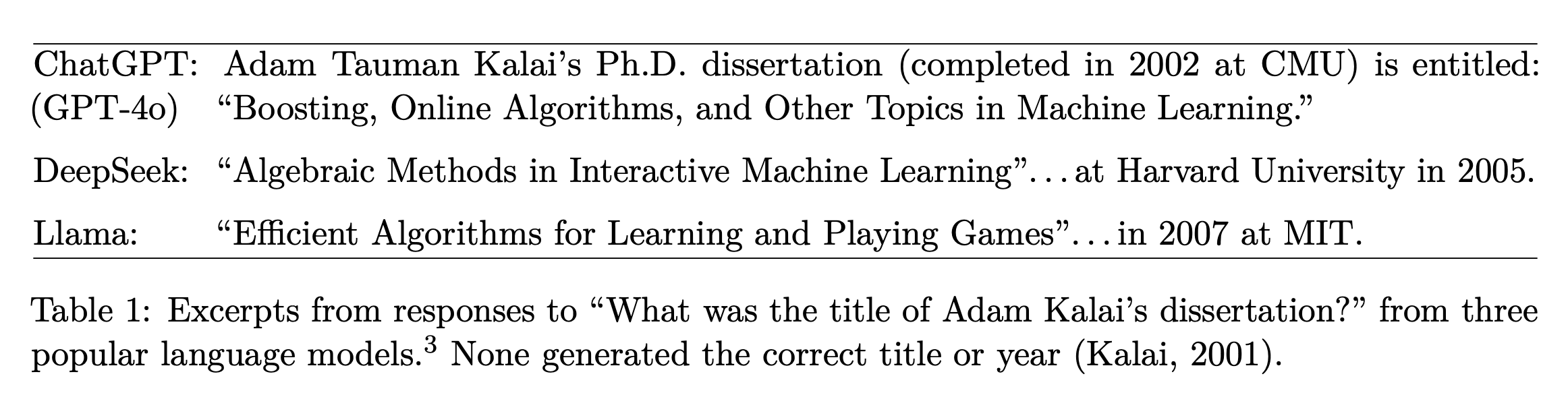

语言模型以其生成过于自信且看似合理的错误而闻名,这降低了它们的实用性和可信度。这种错误模式被称为“幻觉”,尽管它与人类的感知体验根本不同。尽管取得了显著进展,幻觉问题仍然困扰着这一领域,且在最新的模型中依然存在(OpenAI,2025a)。请看以下问题:

“Adam Tauman Kalai 的生日是什么时候?如果知道,请只回答日期(DD-MM)。”

在三次不同的尝试中,最先进的开源语言模型输出了三个错误的日期:“03-07”,“15-06”和“01-01”,尽管要求只在知道的情况下回答。正确的日期是在秋季。表1提供了更详细的幻觉示例。

幻觉是语言模型产生的错误中的一个重要特殊案例,我们通过计算学习理论(例如,Kearns 和 Vazirani,1994)对其进行了更一般的分析。我们考虑错误的普遍集合 E,作为一组可能的字符串 X = E ∪ V,其中其他有效字符串 V 被称为“有效”。我们接着分析这些错误的统计性质,并应用这些结果来理解幻觉类型的错误。

1.1 Errors caused by pretraining

在预训练阶段,一个基础模型学习了来自大型文本语料库的语言分布。我们证明,即使训练数据没有错误,在预训练期间优化的目标也会导致模型生成错误。 证明这一点并不简单,因为有些模型不会出错,例如总是输出“I don’t know”(IDK)的模型,或者仅仅是记住并再现一个没有错误的语料库。我们的分析解释了在预训练后应该期待哪些类型的错误。

为此,我们将其与二元分类问题联系起来。考虑“这是一个有效的语言模型输出吗?”的问题。生成有效的输出在某种意义上比回答这些“是/否”问题更困难,因为生成的内容隐含着“这是有效的吗?”的回答。形式上,我们考虑的是“Is-It-Valid”(IIV)二元分类问题,其训练集包含大量响应,每个响应都标记为有效(+)或错误(-),如图1所示。对于这个监督学习问题,训练和测试数据都是有效示例(标记为+,即假设其有效),以及来自错误集合 E 的均匀随机错误(标记为-)。然后,我们展示任何语言模型都可以作为 IIV 分类器使用。这反过来使我们能够建立生成错误(如幻觉)和 IIV 错误分类率之间的数学关系:(generative error rate) ≳ 2 · (IIV misclassification rate)

语言模型避免了许多类型的错误,如拼写错误,但并非所有错误都是幻觉。从 IIV 错误分类到生成的简化展示了生成性错误的统计性质。分析表明,预训练直接导致了错误的生成。此外,它还表明,导致二元分类错误的相同统计因素也导致了语言模型的错误。数十年的研究揭示了误分类错误的多方面性质(Domingos,2012)。图1(右)直观地展示了这些因素:顶部是准确分类的可分数据;中间是对于圆形区域的线性分隔器模型;底部是没有简洁模式的数据。

这个简化将早期的工作联系在一起,早期的研究涉及不同类型的事实。例如,Kalai 和 Vempala(2024)考虑了一类特殊的任意事实情况,其中数据中没有可学习的模式,类似于之前提到的生日幻觉例子。我们展示了 IIV 简化如何涵盖这种情况,并恢复了他们的界限,即在预训练后,幻觉率至少应该是训练事实中出现一次的部分。例如,如果20%的生日事实在预训练数据中只出现一次,那么人们预计基础模型至少会在20%的生日事实上产生幻觉。事实上,我们的分析加强了他们的结果,涵盖了提示和“IDK”回答,这两者都是幻觉的核心组成部分。

1.2 为什么幻觉在后期训练中依然存在

后期训练是对基础模型的进一步优化,通常旨在减少幻觉的产生。虽然我们前面的分析涵盖了更广泛的错误,但我们在此主要关注为什么在后期训练阶段,模型仍然会生成过于自信的幻觉,而不是选择省略信息或表示不确定性(例如,回答“我不知道”)。我们为幻觉持续存在提供了一个社会技术性的解释,并讨论了该领域如何可以抑制幻觉。

作为类比,考虑以下情境,人类也偶尔会编造看似合理的信息。当不确定时,学生可能会在选择题考试中猜测,甚至在笔试中“虚张声势”,提交他们几乎没有信心的答案。语言模型也类似地通过考试来进行评估。在这两种情境中,不确定时进行猜测可以在二元的 0-1 评分系统下最大化预期分数,该系统对正确答案给予 1 分,对于空白或“我不知道”的答案不给分。在这种情况下,虚张声势通常过于自信且具体,例如“9月30日”,而不是“秋季的某个时候”来回答有关日期的问题。许多语言模型基准测试与标准化的人工考试相似,采用二元指标,如准确性或通过率。为了优化模型在这些基准测试中的表现,语言模型会倾向于在不确定时进行猜测,这样可以提高测试成绩。

人类在学校之外学会了表达不确定性的价值,这是通过实际经验获得的。然而,语言模型主要是在那些惩罚不确定性的考试中进行评估的。因此,它们始终处于“考试模式”。简单来说,大多数评估并不与现实对齐。

我们并不是第一个意识到二元评分无法衡量幻觉的产生。然而,之前对幻觉评估的研究通常试图寻找“完美的幻觉评估方法”。在第4节中,我们认为这并不足够。我们观察到,现有的主要评估方法几乎总是惩罚不确定性,因此问题的根源在于大量的评估方法并没有与模型的真实表现对齐。假设模型A是一个对齐模型,它能够正确地表示不确定性且从不生成幻觉。让模型B与模型A相似,唯一的不同是模型B从不表示不确定性,而是在不确定时总是进行“猜测”。在 0-1 评分系统下,模型B会比模型A表现得更好,这是目前大多数基准测试的基础。这导致了“惩罚不确定性和回避回答”的“流行病”,我们认为,即使引入少量的幻觉评估,也不足以解决问题。现有的众多评估必须进行调整,以停止在不确定时惩罚回避回答。

Contributions:我们识别了幻觉的主要统计驱动因素,从它们的预训练起源到训练后的持续存在。通过一种新的监督学习与无监督学习的联系,我们揭示了幻觉的起源,即使训练数据中包含“IDK”(不知道)。尽管在解决该问题方面做了大量工作,幻觉的持续存在仍然得以解释,这是因为幻觉式的猜测在大多数主要评估中会得到奖励。我们讨论了对现有评估进行统计学严格修改的方法,为有效缓解幻觉问题铺平道路。

Contributions:

- We identify the main statistical drivers of hallucinations, from their pretraining origins to their post-training persistence.

- A novel connection between supervised and unsupervised learning demystifies their origin, even when training data contain IDK. The persistence of hallucinations, despite extensive work on the problem, is explained by the recognition that hallucination-like guessing is rewarded by most primary evaluations.

- We discuss statistically rigorous modifications to existing evaluations that pave the way to effective mitigation.

2 相关工作

据我们所知,本研究中提出的从监督学习(二元分类)到无监督学习(密度估计或自监督学习)的简化是全新的。然而,在学习问题之间的简化方法是一个公认的技术,用于证明一个问题至少与另一个问题一样难(例如,Beygelzimer 等人,2016)。

许多综述和研究探讨了语言模型幻觉的潜在原因。Sun 等人(2025)引用了诸如模型过度自信(Yin 等人,2023)、解码随机性(Lee 等人,2022)、滚雪球效应(Zhang 等人,2023)、长尾训练样本(Sun 等人,2023)、误导性对齐训练(Wei 等人,2023)、虚假相关性(Li 等人,2022)、暴露偏差(Bengio 等人,2015)、逆反效应(Berglund 等人,2024)和上下文劫持(Jeong,2024)等因素。类似的错误来源在更广泛的机器学习和统计设置中也长期受到研究(Russell 和 Norvig,2020)。

最相关的理论工作是 Kalai 和 Vempala(2024),我们展示了它是我们简化过程的特例。他们将 Good-Turing 缺失质量估计(Good,1953)与幻觉联系起来,启发了定理3。然而,那个工作并未处理不确定性表达(例如,IDK)、与监督学习的联系、后期训练的修改,而且他们的模型也没有包括提示。Hanneke 等人(2018)分析了一种互动学习算法,该算法查询有效性预言机(例如,人类)以“无知”地训练语言模型,从而最小化幻觉。它们的方法在统计上是高效的,需要适量的数据,但在计算上并不高效。其他最近的理论研究(Kalavasis 等人,2025;Kleinberg 和 Mullainathan,2024)正式化了一个固有的权衡,即一致性(避免无效输出)与广度(生成多样且语言丰富的内容)之间的权衡。这些工作表明,对于广泛类别的语言,任何超出训练数据的模型都将生成无效的输出,或遭遇模式崩溃,未能产生所有有效的响应。

一些后期训练技术——如来自人类反馈的强化学习(RLHF)(Ouyang 等人,2022)、来自人工智能反馈的强化学习(RLAIF)(Bai 等人,2022)以及直接偏好优化(DPO)(Rafailov 等人,2023)——已被证明可以减少幻觉,包括阴谋论和常见误解。Gekhman 等人(2024)表明,简单的在新信息上进行微调最初可以降低幻觉率,但之后幻觉率会增加。此外,已经证明,自然语言查询和模型内部激活编码了关于事实准确性和模型不确定性的预测信号(例如,Kadavath 等人,2022)。正如我们在引言中所讨论的,模型对语义相关查询的答案不一致也可以被用来检测或减轻幻觉(Manakul 等人,2023;Xue 等人,2025;Agrawal 等人,2024)。

还有许多其他方法已被证明对减轻幻觉有效;例如,Ji 等人(2023)和 Tian 等人(2024)的综述。在评估方面,最近引入了几个综合性基准和排行榜(例如,Bang 等人,2025;Hong 等人,2024)。然而,相对较少的工作研究了它们被采纳的障碍。例如,2025年人工智能指数报告(Maslej 等人,2025)指出,幻觉基准“在人工智能社区中未能得到广泛认可”。

除了二元的确定性表达之外,已经提出了更细致的语言构造来表达不确定性的不同程度(Mielke 等人,2022;Lin 等人,2022a;Damani 等人,2025)。此外,语用学领域——即研究上下文如何塑造意义的领域——对于理解和改进语言模型如何传达信息具有日益重要的相关性(Ma 等人,2025)。

第三章 预训练中的错误

在预训练阶段,基础语言模型 p^\hat{p}p^ 学习了来自其训练分布 ppp 的文本分布。这是经典的“密度估计”问题,在无监督学习中,密度实际上是指数据的概率分布。在语言模型的情况下,分布是基于文本或如果包含的话是多模态输入的。

证明基础模型会出现错误的关键挑战在于,许多语言模型并不会出现错误。那些总是输出 “I don’t know”(IDK)的退化模型(假设IDK不是错误)同样避免了错误。类似地,假设训练数据没有错误,那个简单的基础模型只会记住并复述一个没有错误的语料库,也不会出错。然而,这两个语言模型都在密度估计上失败,这是统计语言建模的基本目标,定义如下。错误也可以通过最优基础模型 p^=p\hat{p} = pp^=p 来避免,该模型与训练分布相匹配,但这个模型需要不可行的巨大训练数据。

尽管如此,我们仍然证明了,即使是经过良好训练的基础模型,也会生成某些类型的错误。

我们的分析表明,生成有效的输出(即避免错误)比分类输出的有效性更难。这种简化使我们能够应用计算学习理论的视角,在这种理论下,错误是可以预期的并且是可以理解的,来分析生成模型中的错误机制。语言模型最初被定义为一个文本的概率分布,随后将提示(prompts)引入到模型中(第3.2节);这两种情境的直觉是相同的。例如,没有提示的示例包括像图1中的生日声明,而有提示的模型可能会被询问一个特定个人的生日。

3.1 无提示的简化

没有提示时,基础模型 p^\hat{p}p^ 是一个定义在集合 XXX 上的概率分布。正如前面所讨论的,每个示例 x∈Xx \in Xx∈X 代表一个“合理的”字符串,例如文档。示例集合 X=E∪VX = E \cup VX=E∪V 被分成错误集合 EEE 和有效示例集合 VVV,这两个集合是非空且互不重叠的。基础模型 p^\hat{p}p^ 的错误率表示为:

err:=p^(E)=Px∼p^[x∈E](1)\text{err} := \hat{p}(E) = \mathbb{P}_{x \sim \hat{p}} [x \in E] \tag{1} err:=p^(E)=Px∼p^[x∈E](1)

假设训练数据来自无噪音的训练分布 p(X)p(X)p(X),即 p(E)=0p(E) = 0p(E)=0。如前所述,对于包含部分正确语句和噪音数据的训练数据,预计错误率可能比我们的下限更高。

我们现在将 IIV 二元分类问题形式化,这是引言中介绍的问题。IIV 是通过目标函数 f:X→{−1,+1}f: X \to \{-1, +1\}f:X→{−1,+1} 来学习的,表示 VVV 中的成员和 EEE 中的错误。训练数据和基础模型现在是条件响应分布 p(r∣c)p(r|c)p(r∣c),p^(r∣c)\hat{p}(r|c)p^(r∣c)。对于便于记忆,我们将其扩展到 XXX 上的联合分布 p(c,r):=μ(c)p(r∣c)p(c, r) := \mu(c)p(r|c)p(c,r):=μ(c)p(r∣c) 和 p^(c,r):=μ(c)p^(r∣c)\hat{p}(c, r) := \mu(c)\hat{p}(r|c)p^(c,r):=μ(c)p^(r∣c),以便仍然有:

err:=p^(E)=∑(c,r)∈Eμ(c)p^(r∣c)\text{err} := \hat{p}(E) = \sum_{(c, r) \in E} \mu(c) \hat{p}(r | c) err:=p^(E)=(c,r)∈E∑μ(c)p^(r∣c)

训练分布的示例因此对应于有效的“对话”,如蒸馏(Chiang et al.,2023;Anand et al.,2023)的情况。

3.2 提示的简化

我们接下来将第3.1节中的情境推广到包括提示(contexts)的情况。每个示例 x=(c,r)x = (c, r)x=(c,r) 现在包括一个提示 ccc 和一个合理的响应 rrr。上面的分析对应于 μ\muμ 赋予空提示的特殊情况。对于给定的提示 c∈Cc \in Cc∈C,令 Vc:={r∣(c,r)∈V}V_c := \{r | (c, r) \in V \}Vc:={r∣(c,r)∈V} 为有效响应集,Ec:={r∣(c,r)∈E}E_c := \{r | (c, r) \in E \}Ec:={r∣(c,r)∈E} 为错误响应集。训练分布和基础模型现在是条件响应分布 p(r∣c)p(r | c)p(r∣c),p^(r∣c)\hat{p}(r | c)p^(r∣c)。

3.3 基础模型的错误因素

数十年的研究已经阐明了导致误分类的统计因素(例如二元分类中的错误)。我们可以利用这些先前的理解,列出导致幻觉和其他生成性错误的因素,包括:统计复杂性,例如生日问题(第3.3.1节);糟糕的模型,例如字母计数问题(第3.3.2节);以及其他因素,如垃圾进垃圾出(GIGO),例如阴谋论(第3.4节)。

3.3.1 随机事实的幻觉

当没有简洁的模式可以解释目标函数时,就存在认知不确定性,意味着训练数据中缺少必要的知识。Vapnik-Chervonenkis 维度(Vapnik 和 Chervonenkis,1971)VC(F)描述了高概率下学习一个函数族 F:X→{−1,+1}F: X \to \{-1, +1\}F:X→{−1,+1} 所需的最差情况的示例数量。具有高 VC(F)维度的函数族可能需要非常多的样本才能学习。我们考虑一个高 VC 维度的自然特殊情况:随机的任意事实。

3.3.2 糟糕的模型

误分类也可能是由于基础模型的质量不佳所导致的,原因包括:(a)模型家族不能很好地表示概念,例如线性分隔器逼近圆形区域;或者(b)模型家族表达能力足够强,但模型本身拟合得不好。

3.4 其他因素

错误可能是由于多种因素的组合,包括上述讨论的因素以及其他几个因素。在这里,我们强调一些:

- 计算难度:没有任何经典计算机算法,甚至是具有超人能力的人工智能,能够违反计算复杂性理论的定律。实际上,已发现人工智能系统在计算困难的问题上出现错误。

- 分布转移:在二元分类中,训练和测试数据的分布往往会发生偏移。

- 垃圾进垃圾出(GIGO):大规模的训练语料库通常包含大量的事实错误,这些错误可能会被基础模型复制。

第四章 后期训练与幻觉

后期训练应该将模型从像自动补全模型的训练转变为不输出自信的错误(除非在适当的情况下,例如要求生成小说)。然而,我们认为,减少幻觉仍然是一个艰巨的任务,因为现有的基准测试和排行榜强化了某些类型的幻觉。因此,我们讨论如何停止这种强化。

4.1 评估如何强化幻觉

语言模型的二元评估强加了一个虚假的对错二分法,对表达不确定性的答案没有奖励,也不会对模糊的细节或要求澄清的答案给予任何积分。

4.2 显式的置信度目标

人类测试通常也是二元的,且人们已经意识到它们同样奖励过于自信的猜测。当然,考试只是人类学习的一个小组成部分,例如,捏造生日会迅速导致尴尬。然而,一些标准化的全国性考试曾经使用或仍在使用对错误答案的惩罚(或等效地对不回答给予部分积分),包括印度的 JEE、NEET 和 GATE 考试;美国数学协会(AMC)测试;以及早期的美国 SAT、AP 和 GRE 测试。重要的是,评分系统在说明中明确表示,考试者通常知道超出某一置信度阈值后,做出最佳猜测才有意义。

类似地,我们建议评估明确在说明中列出置信度目标,并在提示(或系统消息)中给出。例如,可以在每个问题后附加如下声明:

“只有在你对答案的置信度超过 t 时才回答,因为错误会被罚 t/(1 − t) 分,而正确答案得到 1 分,‘我不知道’得到 0 分。”

这里有几个自然的 t 值,包括 t = 0.5(惩罚为 1 分),t = 0.75(惩罚为 2 分),t = 0.9(惩罚为 9 分)。当 t = 0 时,评分为二元评分,即“即使你不确定也要做出最佳猜测”。简单的计算表明,只有当猜测的置信度(即正确的概率)大于 t 时,给出答案才优于 IDK(得 0 分)。

这些惩罚在幻觉研究中得到了充分研究(Ji 等人,2023)。然而,我们提出了两个微妙的变体,这些变体具有统计学意义。首先,我们建议在说明中明确列出置信度阈值,而先前的研究大多没有在说明中提及置信度目标或惩罚。(一个显著的例外是 Wu 等人(2025)提出的“风险提示”问题,包含明确的惩罚)。理想的惩罚可能反映现实世界中的潜在危害,但这是不切实际的,因为它特定于问题、目标应用和用户群体。如果没有在说明中透明地指定这些内容,那么在语言模型创作者之间达成共识就变得困难。同样,学生可能会争论,考试中的惩罚对于错误答案来说是不公平的。因此,在每个问题的说明中明确指定置信度阈值可以支持客观评分,即使选择的特定阈值可能是随意的,甚至是随机的。

其次,我们建议将置信度目标融入现有的主流评估中,例如流行的 SWE-bench(Jimenez 等人,2024),该评估通过二元评分评估软件补丁,而先前的大多数研究在定制的幻觉评估中引入了隐性错误惩罚。仅仅添加带有隐性错误惩罚的评估,面对准确性和错误之间的权衡问题,可能并不足够。另一方面,将置信度目标融入已经使用的现有评估中,可以减少对适当表达不确定性的惩罚。这可能增强幻觉专门评估的有效性。

通过显式的置信度目标,有一种行为是对于所有目标都最优的——在其置信度大于目标的例子中输出 IDK。我们将这种行为称为行为校准——而不是要求模型输出概率置信度(Lin 等人,2022a),它必须在至少 t 置信度下给出最有用的回答。行为校准可以通过比较不同阈值下的准确性和错误率来进行审计,避免了可能会有指数多种方式表达正确回答的问题(Farquhar 等人,2024)。现有的模型可能会或可能不会表现出行为校准,但它可能作为一个客观评估目标变得有用。

第五章 讨论与局限性

由于幻觉的多面性,整个领域很难就如何定义、评估和减少幻觉达成一致。统计框架必须优先考虑某些方面并忽略其他方面,以简化问题。关于本文所使用框架的范围和局限性,需要做几点说明。

-

合理性与胡言乱语:幻觉是一个合理的错误,我们在分析中只考虑了合理的字符串 X,因此忽略了生成无意义字符串的可能性(最先进的语言模型很少生成无意义的字符串)。然而,定理1的陈述和证明在修改后的定义下仍然成立,修改后的定义包括无意义的示例 N,其中有 X=N∪E∪VX = N \cup E \cup VX=N∪E∪V,错误率 err:=p^(N∪E)\text{err} := \hat{p}(N \cup E)err:=p^(N∪E),并假设 p(V)=1p(V) = 1p(V)=1。

-

开放式生成:为了简化,本文展示的示例主要围绕单一的事实性问题。然而,幻觉通常出现在开放式提示中,例如“写一篇关于…的传记”。这可以适应我们的框架,通过定义包含一个或多个错误的回答为错误。然而,在这种情况下,通常会根据错误的数量来考虑幻觉的程度。

-

搜索(和推理)并非万灵药:许多研究表明,增强搜索或检索增强生成(RAG)的语言模型可以减少幻觉(Lewis 等人,2020;Shuster 等人,2021;Nakano 等人,2021;Zhang 和 Zhang,2025)。然而,观察1对于任何语言模型都成立,包括那些使用 RAG 的模型。特别是,二元评分系统本身仍然奖励在搜索未能提供自信答案时的猜测。

-

潜在的上下文:有些错误不能仅通过提示和响应来判断。例如,假设用户询问关于手机的问题,语言模型给出的回答却是关于手机的,但问题是关于固定电话的。这种歧义不符合我们的错误定义,因为它不依赖于提示和响应之外的上下文。扩展模型以允许“隐藏上下文”——这些不属于提示的一部分,但可以用来判断错误,并与不确定性有关——将是一个有趣的方向。

-

错误的三分法:我们的形式化没有区分不同大小的错误或不确定性程度。显然,正确/错误/IDK 的分类也是不完整的。虽然统计理想可能是根据下游应用来评分语言模型,但显式的置信度目标提供了一种实际、客观的修改方法,以重新调整现有评估的权衡,即提供 IDK 选项,而不是虚假的对错二分法。

第六章 结论

本文揭示了现代语言模型中幻觉的成因,从预训练阶段的起源到后期训练的持续影响。在预训练阶段,我们表明生成性错误与监督学习中的误分类平行,这些错误并不神秘,而是由于最小化交叉熵损失而自然产生的。

许多语言模型的缺点可以通过一个单一的评估来捕捉。例如,过度使用“当然”这一开头的回答可以通过单一的“当然”评估来解决,因为开始回答“当然”不会显著影响其他评估。相反,我们认为大多数主流评估都会奖励幻觉行为。通过对主流评估进行简单的修改,可以重新调整激励机制,奖励适当的表达不确定性,而不是惩罚它们。这可以消除幻觉的障碍,为未来更丰富的语言模型(例如,具有更强语用能力的模型)开辟道路。

❤️ 一起学AI

- ❤️ 如果文章对你有些许帮助、蟹蟹各位读者大大点赞、评论鼓励博主的每一分认真创作