全网首发! Nvidia Jetson Thor 128GB DK 刷机与测评(三)常用功能测评 DeepAnything 系列

这篇博客是上一篇博客的续集,所有测试和评测均基于第一篇刷机博客的环境上完成的测测试。博客对 DeepAnything 系列工程在 Nvidia Jetson Thor 上进行部署与测试。

- 《全网首发! Nvidia Jetson Thor 128GB DK 刷机与测评(一)刷机与 OpenCV-CUDA、pytorch CUDA13.0+ 使用》

- 《全网首发! Nvidia Jetson Thor 128GB DK 刷机与测评(二)常用功能测评 Ollama、ChatTTS、Yolov13》

【Note】:除了源码外,这篇博客涉及到的资源我都放在了百度网盘中,你可以直接从网盘内下载:

通过网盘分享的文件:DepthAnything

链接: https://pan.baidu.com/s/18S8WZQnSDEMtznl_g-StyQ?pwd=p285 提取码: p285

--来自百度网盘超级会员v5的分享

【注意】:不必每一个工程都执行,文档在撰写的时候确保单独某个工程通过我们提供的步骤均可独立运行。例如,如果你只想部署 PromptDA,那么你只需要按照 PromptDA 这一小节的内容操作即可,前面的内容可以跳过。

该系列的部署和应用整体而言比较简单,没有核心操作是 避开工程 requlrements.txt 文件中的 torch 安装。

Depth-Anything Series

Depth Anything 系列在这两年有了多次迭代,从最基础的单帧图片的 Depth AnythingV2 到视频的 Video Depth Anything,再到 4K 加速的 PromptDA,这篇博客将对这三个主要工作在 Thor 上部署与测试进行记录。

- Depth-AnythingV2 Github 连接:https://github.com/DepthAnything/Depth-Anything-V2

- Video Depth Anything Github 连接:https://github.com/DepthAnything/Video-Depth-Anything

- PromptDA Github 连接:https://github.com/DepthAnything/PromptDA

Depth-AnythingV2

由于 Depth-AnythingV2 相比较于 V1 版本在性能和细节上均有较大提升,因此这里直接跳过 V1 版本的模型直接测试 V2。

- Depth-AnythingV2 Github 连接:https://github.com/DepthAnything/Depth-Anything-V2

Step1. 创建工作空间

首先创建一个工作空间用来在容器内做路径映射,这里假设为 Desktop/depth_ws:

$ cd Desktop

$ mkdir depth_ws

Step2. 下载源码与资源

进入到 depth_ws 工作空间中拉取源码:

$ cd depth_ws

$ git clone https://github.com/DepthAnything/Depth-Anything-V2.git

然后进入到 Depth-Anything-V2 文件夹创建一个 checkpoints 的文件夹:

$ cd Depth-Anything-V2

$ mkdir checkpoints

可以直接点击下面的链接进行下载模型文件,也可以从我的网盘链接中下载。此处以 Depth-Anything-V2-Large 为例,将下载好的模型文件放在刚才新建的 checkpoints 目录下:

| Model | Params | Checkpoint | Size |

|---|---|---|---|

| Depth-Anything-V2-Small | 24.8M | Download | 99.2 MB |

| Depth-Anything-V2-Base | 97.5M | Download | 390 MB |

| Depth-Anything-V2-Large | 335.3M | Download | 1.34 GB |

| Depth-Anything-V2-Giant | 1.3B | Coming soon |

官方在仓库中提供了一些示例存放在 Depth-Anything-V2/assets 目录下,我在网盘中也存放了一张图片和一段景区视频可以直接从我的网盘中下载 dining-table.jpg、landscape.mp4 这两个文件,这两个文件均为我自己拍摄,不涉及任何版权问题,一张是餐桌照片,另一个是一段景区视频:

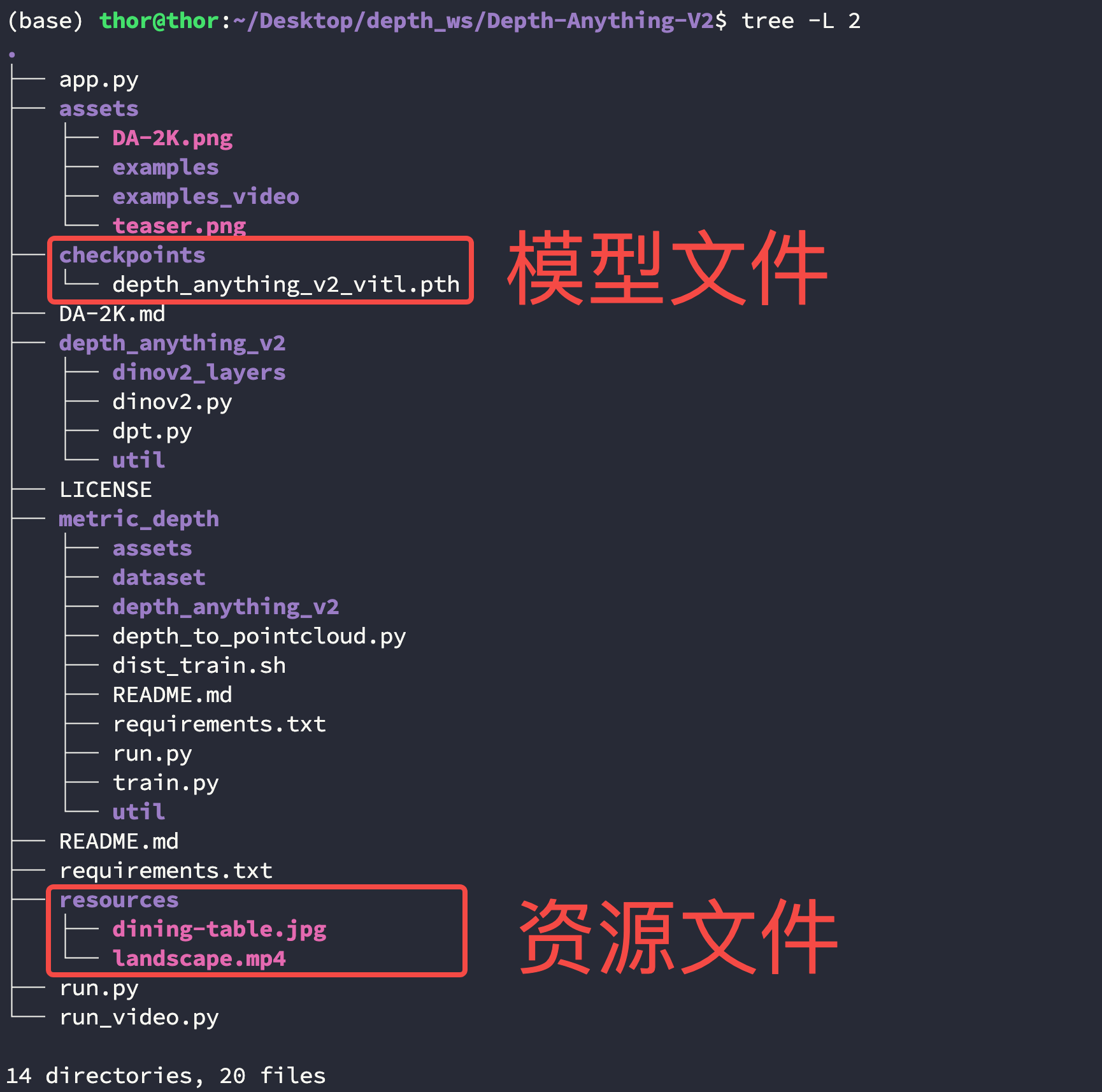

这两个资源放在任何位置都可以,只不过在运行的时候需要指明,此处在Depth-Anything-V2 文件夹创建一个 resources 的文件夹用来存放这两个文件。此时你的 Depth-Anything-V2 文件目录结构应该如下:

$ cd Desktop/depth_ws/Depth-Anything-V2

$ tree -L 2

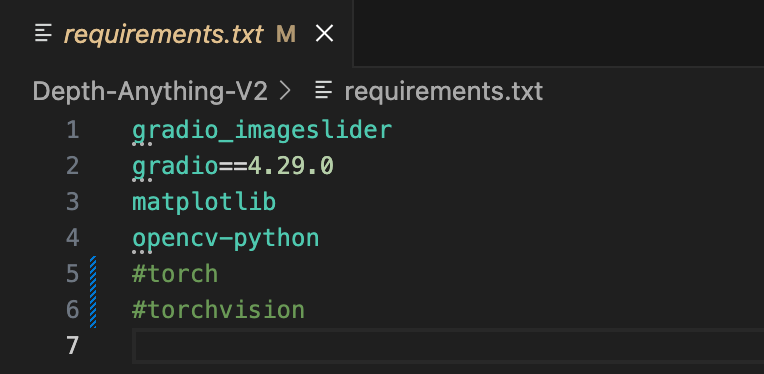

然后修改 Depth-Anything-V2/requirements.txt 文件,将 torch、torchvision

这两行注释掉,效果如下:

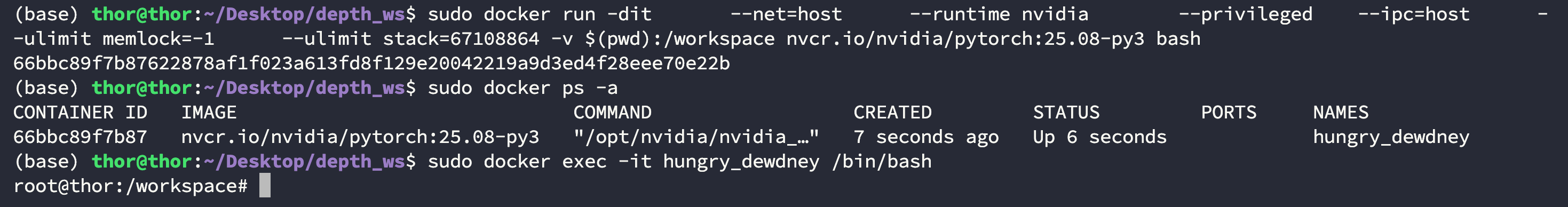

Step3. 启动容器

进入到创建的工作空间中使用下面的命令启动容器:

$ cd Desktop/depth_ws

$ docker run -dit \--net=host \--runtime nvidia \--privileged \--ipc=host \--ulimit memlock=-1 \--ulimit stack=67108864 -v $(pwd):/workspace nvcr.io/nvidia/pytorch:25.08-py3 bash

查看正在运行的容器后直接进入即可:

$ docker ps -aCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

66bbc89f7b87 nvcr.io/nvidia/pytorch:25.08-py3 "/opt/nvidia/nvidia_…" 7 seconds ago Up 6 seconds hungry_dewdney$ sudo docker exec -it hungry_dewdney /bin/bash

进入到 Depth-Anything-V2 目录下安装依赖环境:

$ pip install -r requirements.txt

还需要安装 libgl 库:

$ apt-get update

$ apt-get install libgl1 -y

Step4. 转换图像化和视频

转换图像

首先演示官方仓库中提供的示例,位置在 assets/examples 目录下,这里以 Depth-Anything-V2/assets/examples/demo01.jpg 文件为例:

$ python run.py --img-path ./assets/examples/demo01.jpg

图像会保存到 Depth-Anything-V2/vis_depth 路径下:

如果你在上面下载了我网盘中的示例,那么使用下面的命令进行转换:

$ python run.py --img-path ./resources/dining-table.jpg

图像会保存到 Depth-Anything-V2/vis_depth 路径下:

转换视频

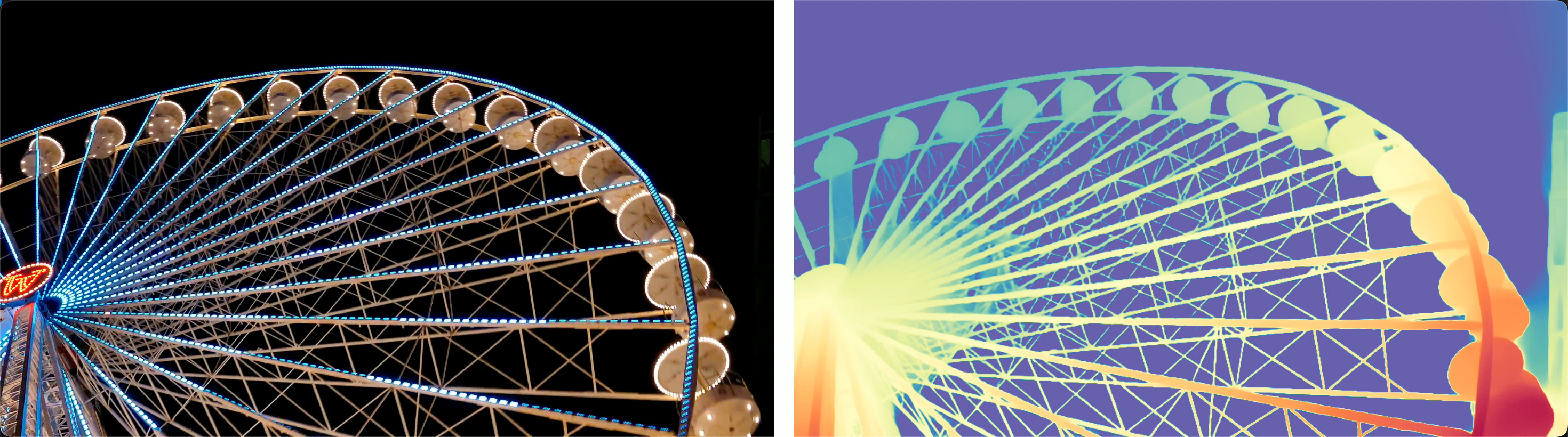

首先演示官方仓库中提供的示例,位置在 assets/examples 目录下,这里以 Depth-Anything-V2/assets/examples_video/ferris_wheel.mp4 文件为例:

$ python run_video.py --video-path ./assets/examples_video/ferris_wheel.mp4

视频会保存到 Depth-Anything-V2/vis_video_depth 路径下:

如果你在上面下载了我网盘中的示例,那么使用下面的命令进行转换:

$ python run_video.py --video-path ./resources/landscape.mp4

视频会保存到 Depth-Anything-V2/vis_video_depth 路径下:

【Note】:图像转换的耗时可能不易察觉,但视频转换时就很容易发现时间有些过长,因此他们团队推出了专供视频转换的仓库 Video Depth Anything。

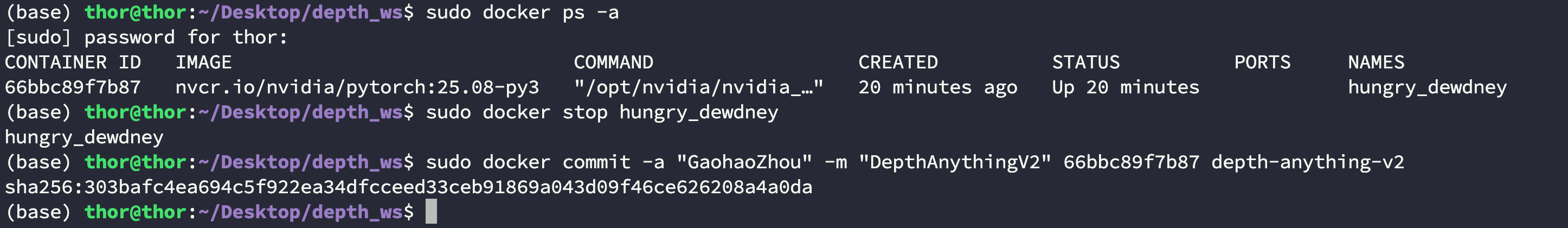

Step5. [可选] 保存容器

如果你将上面的环境配置完成并且后面还会继续使用,那么强烈建议将当前的容器进行保存。

首先使用 Ctrl+C 退出容器并暂停容器并查看容器 ID:

$ docker ps -aCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

66bbc89f7b87 nvcr.io/nvidia/pytorch:25.08-py3 "/opt/nvidia/nvidia_…" 20 minutes ago Up 20 minutes hungry_dewdney$ sudo docker stop hungry_dewdney

然后提交这个容器的信息,附上自己的名字和 commit:

Video Depth Anything

- Video Depth Anything Github 连接:https://github.com/DepthAnything/Video-Depth-Anything

Step1. 创建工作空间

首先创建一个工作空间用来在容器内做路径映射,这里假设为 Desktop/depth_ws:

$ cd Desktop

$ mkdir depth_ws

Step2. 下载源码与资源

进入到 depth_ws 工作空间中拉取源码:

$ cd depth_ws

$ git clone https://github.com/DepthAnything/Video-Depth-Anything.git

然后进入到 Depth-Anything-V2 文件夹创建一个 checkpoints 的文件夹:

$ cd Video-Depth-Anything

$ mkdir checkpoints

可以直接点击下面的链接进行下载模型文件,也可以从我的网盘链接中下载。此处以 Video-Depth-Anything-Large 为例,将下载好的模型文件放在刚才新建的 checkpoints 目录下:

| Model | Params | Checkpoint | Size |

|---|---|---|---|

| Video-Depth-Anything-Small | 28.4M | Download | 111.05 MB |

| Video-Depth-Anything-Base | 113.1M | Download | 437.02 MB |

| Video-Depth-Anything-Large | 381.8M | Download | 1.43 GB |

| Metric-Video-Depth-Anything-Small | 28.4M | Download | 111.05 MB |

| Metric-Video-Depth-Anything-Base | 113.1M | Download | 437.02 MB |

| Metric-Video-Depth-Anything-Large | 381.8M | Download | 1.43 GB |

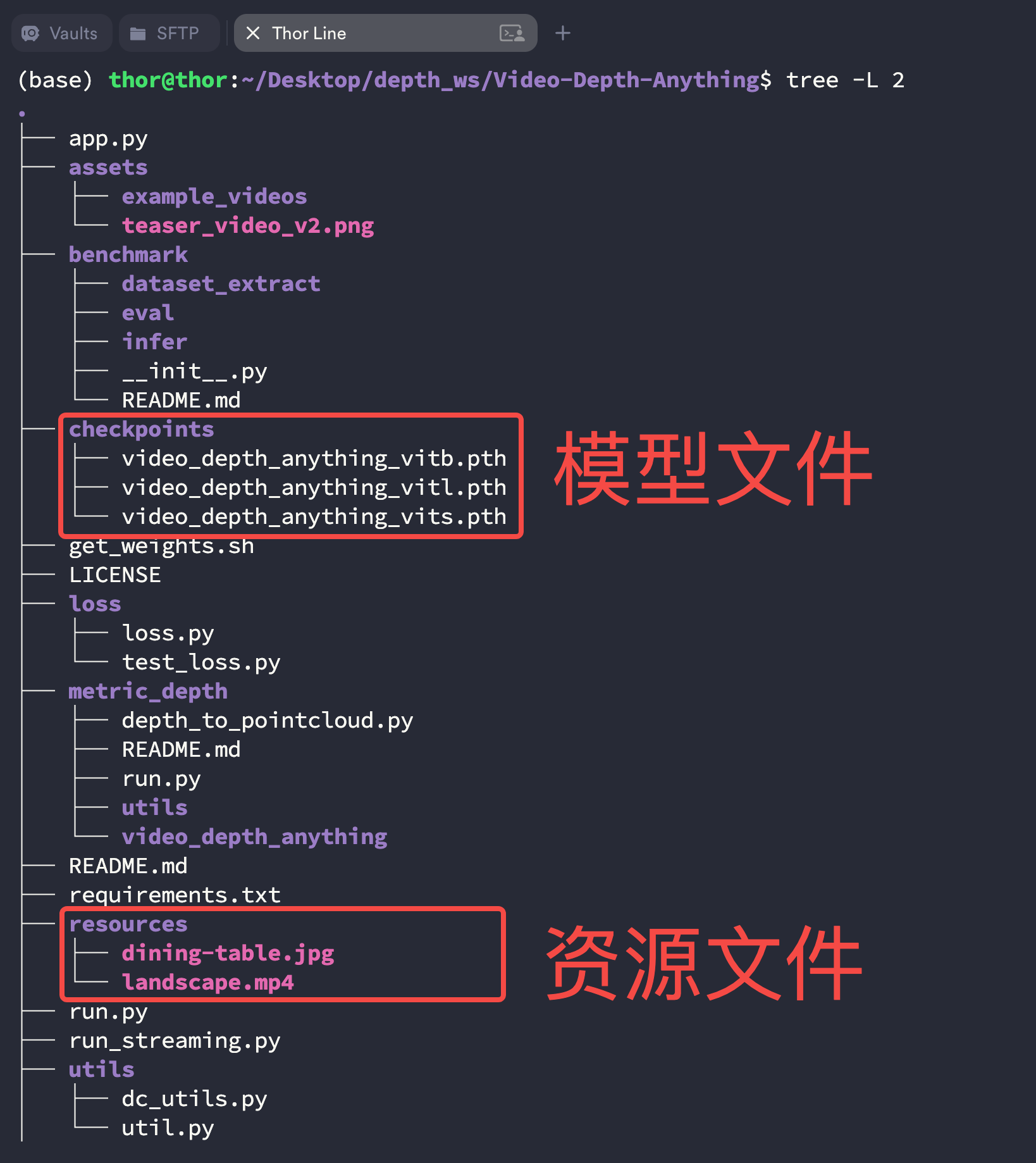

准备一个图片和视频资源,你可以直接从我的网盘中下载 dining-table.jpg、landscape.mp4 这两个文件,这两个文件均为我自己拍摄,不涉及任何版权问题,一张是餐桌照片,另一个是一段景区视频:

这两个资源放在任何位置都可以,只不过在运行的时候需要指明,此处在Depth-Anything-V2 文件夹创建一个 resources 的文件夹用来存放这两个文件。此时你的 Depth-Anything-V2 文件目录结构应该如下:

$ cd Desktop/depth_ws/Video-Depth-Anything

$ tree -L 2

【未完待续,预计 09月14日】