【AI论文】借助大型语言模型进行符号图形编程

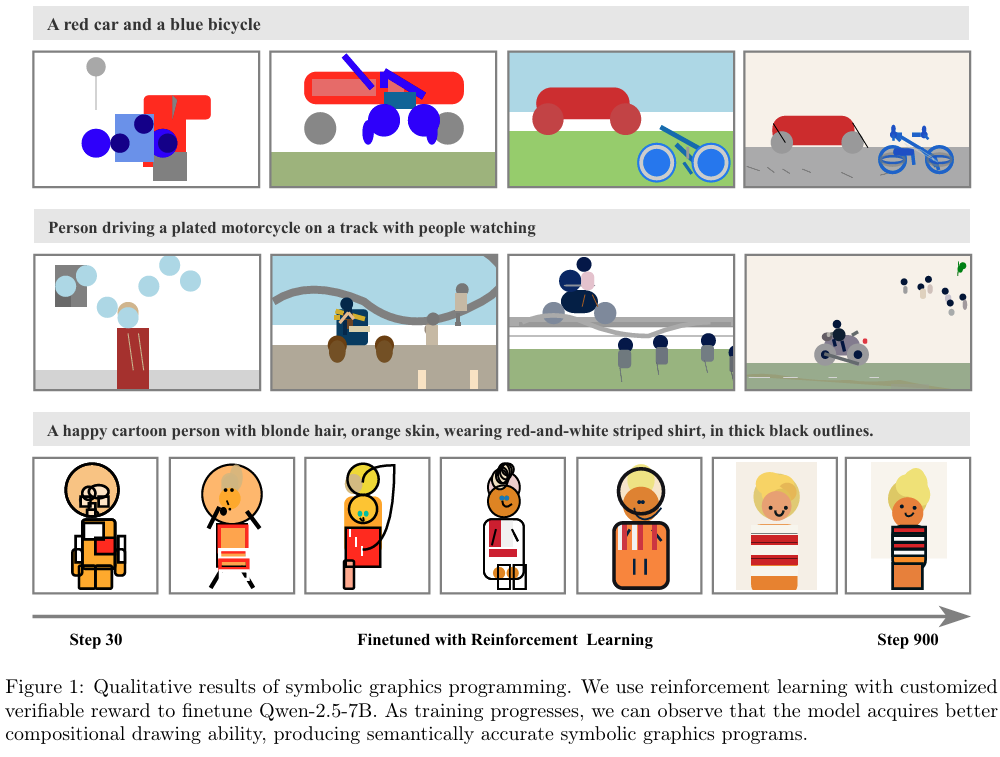

摘要:大型语言模型(LLMs)在程序合成方面表现出色,然而,它们生成能渲染出精确视觉内容的符号图形程序(SGPs)的能力仍未得到充分探索。我们研究了符号图形编程,其目标是根据自然语言描述生成符号图形程序。这一任务也可作为一个视角,通过促使大型语言模型生成由符号图形程序渲染出的图像,来探究它们如何理解视觉世界。在各种符号图形程序中,本文聚焦于可缩放矢量图形(SVGs)。我们首先探究大型语言模型生成符号图形程序的能力能达到何种程度。为此,我们引入了符号图形程序生成基准测试集SGP-GenBench,这是一个涵盖对象保真度、场景保真度以及组合性(属性绑定、空间关系、数字运算能力)的综合性基准测试集。在SGP-GenBench上,我们发现前沿的专有模型大幅优于开源模型,且模型性能与通用编程能力高度相关。受此差距的启发,我们旨在提升大型语言模型生成符号图形程序的能力。我们提出了一种带可验证奖励的强化学习(RL)方法,其中格式有效性门限确保生成的SVG可渲染,而跨模态奖励则通过强大的视觉编码器(如用于文本-图像的SigLIP和用于图像-图像的DINO)使文本与渲染图像对齐。将该方法应用于Qwen-2.5-7B模型后,我们显著提升了SVG的生成质量和语义,性能达到了与前沿系统相当的水平。我们进一步分析了训练动态,发现强化学习能够促使模型(i)将对象更精细地分解为可控制的基元,以及(ii)生成改善场景一致性的上下文细节。我们的研究结果表明,符号图形编程为跨模态语义对齐提供了一个精确且可解释的视角。Huggingface链接:Paper page,论文链接:2509.05208

研究背景和目的

研究背景:

随着大型语言模型(LLMs)在自然语言处理任务中的卓越表现,其在生成复杂视觉内容的符号图形程序(Symbolic Graphics Programs, SGPs)方面的能力逐渐受到关注。SGPs通过结构化、形式化的表示方法,将自然语言描述转化为精确的视觉场景,为跨模态理解提供了新的视角。然而,尽管LLMs在代码生成任务中表现出色,其在生成复杂且语义准确的SGPs方面的能力仍相对有限。现有研究表明,LLMs在理解SGPs的语义方面具有一定能力,但在生成与自然语言描述完全匹配的SVG(Scalable Vector Graphics)代码方面仍存在挑战。此外,开源模型与专有模型在生成SGPs的能力上存在显著差距,这种差距往往与模型的编码能力密切相关。

研究目的:

本研究旨在填补这一研究空白,具体目标包括:

- 评估LLMs生成SGPs的能力:通过构建全面的基准测试SGP-GenBench,系统评估不同LLMs在生成SGPs时的性能,涵盖对象级准确性、场景级语义一致性和组合性一致性三个维度。

- 提升开源LLMs的SGP生成能力:提出一种基于强化学习的微调方法,利用可验证的奖励信号(如文本与生成图像的相似度、图像与图像的相似度)来优化模型,减少开源模型与专有模型之间的性能差距。

- 探索模型在SGP生成过程中的行为变化:通过分析强化学习过程中模型生成的SVG代码,揭示模型在提升SGP生成能力时所采用的策略,如对象分解和上下文细节的添加。

研究方法

本研究采用了一系列系统的方法来实现上述研究目的,主要包括以下几个方面:

- 基准测试构建:

- SGP-GenBench:我们构建了一个全面的基准测试SGP-GenBench,包含三个子集:

-

- 场景生成能力:基于COCO-val数据集,包含80个不同对象类别的复杂场景描述,评估模型生成复杂场景的能力。

- 对象生成能力:基于互联网收集的SGP-Object-val数据集,包含930个示例,主要评估模型生成单个对象的能力。

- 组合生成能力:基于SGP-CompBench数据集,评估模型在属性绑定(颜色、形状、纹理)、空间关系(2D、3D、隐式关系)和计数(3-10个对象的准确生成)方面的能力。

- 强化学习微调方法:

- 奖励设计:我们设计了一个包含格式有效性奖励和跨模态奖励的强化学习框架。格式有效性奖励确保生成的SVG代码是可渲染的,而跨模态奖励则通过文本编码器(如CLIP、SigLIP)和视觉编码器(如DINO)来评估生成图像与输入文本描述以及参考图像之间的相似度。

- 训练过程:采用GRPO(Generalized Reinforcement Learning with Proximal Policy Optimization)算法,对Qwen-2.5-7B模型进行微调,逐步优化其生成SGPs的能力。

- 实验与分析:

- 基准测试评估:在SGP-GenBench上对多个开源和专有LLMs进行评估,比较它们在生成SGPs时的性能。

- 训练动态分析:通过分析训练过程中模型生成的SVG代码,揭示模型在提升SGP生成能力时所采用的具体策略。

- 消融实验:通过去除奖励函数中的不同组件(如文本-图像对齐奖励、图像-图像对齐奖励),评估各组件对模型性能的影响。

研究结果

- 基准测试结果:

- 模型排名与整体能力:基准测试结果显示,模型在SGP-GenBench上的排名与其整体能力(尤其是代码生成能力)高度相关。例如,Claude3.7 Sonnet Thinking在所有任务上均表现出色,而开源模型如DeepSeek-R1和Qwen-2.5-7B则相对较弱。

- 专有模型的优势:专有模型在组合性任务(如属性绑定和计数)上表现尤为突出,这得益于它们强大的编码能力和对复杂场景的理解能力。

- 开源模型的进步:通过强化学习微调,我们的Qwen-2.5-7B模型在组合性评分上从8.8提升至60.8,超过了所有其他开源模型,并在某些指标上接近或超过了专有模型。

- 强化学习微调的效果:

- 性能提升:强化学习微调显著提升了模型生成SGPs的质量和语义一致性。例如,在COCO-val场景生成任务上,微调后的模型在CLIP-Score、DINO-Score和VQA-Score等指标上均有显著提升。

- 行为变化:分析训练过程中模型生成的SVG代码发现,模型逐渐学会了将复杂对象分解为更简单的可控元素,并添加了与提示相关的上下文细节,从而提高了场景的一致性和完整性。

- 奖励函数的影响:

- 文本-图像对齐奖励:使用SigLIP作为文本编码器时,模型在语义对齐方面表现更佳,这得益于SigLIP在对比学习任务中的优异表现。

- 图像-图像对齐奖励:添加图像-图像对齐奖励进一步提高了模型生成图像的视觉质量,尤其是在与参考图像的相似度方面。

研究局限

尽管本研究在提升LLMs生成SGPs的能力方面取得了显著进展,但仍存在一些局限性:

- 数据集的局限性:

- 数据覆盖度:尽管SGP-GenBench涵盖了多个维度的评估任务,但其数据集仍可能无法完全代表所有可能的自然语言描述和视觉场景。未来工作需要进一步扩展数据集,以提高评估的全面性和准确性。

- 文本与图像的对应关系:在构建数据集时,我们假设每个自然语言描述都对应一个唯一的视觉场景。然而,在实际应用中,这种对应关系可能更加复杂和模糊。未来工作需要探索如何处理这种不确定性。

- 模型架构的局限性:

- 模型规模:本研究主要基于Qwen-2.5-7B模型进行微调,未来工作可以探索更大规模的模型(如GPT-4、Claude等)在生成SGPs方面的能力。

- 多模态融合:尽管本研究利用了跨模态奖励来优化模型,但模型本身并未显式地融合文本和视觉信息。未来工作可以探索如何设计更有效的多模态融合机制,以提高模型生成SGPs的能力。

- 评估方法的局限性:

- 评估指标:尽管我们采用了多种评估指标(如CLIP-Score、DINO-Score、VQA-Score等)来全面评估模型生成SGPs的质量,但这些指标仍可能无法完全捕捉人类对视觉内容的感知和判断。未来工作可以探索如何结合人类评估来进一步提高评估的准确性。

- 评估效率:现有的评估方法通常需要大量的计算资源和时间,尤其是在处理大规模数据集时。未来工作可以探索如何设计更高效的评估方法,以降低评估成本并提高评估效率。

未来研究方向

基于本研究的发现和局限性,未来可以从以下几个方面进一步探索:

- 扩展数据集和评估方法:

- 构建更全面的数据集:收集更多样化的自然语言描述和对应的视觉场景,构建更大规模、更具挑战性的基准测试数据集。

- 设计更精细的评估指标:结合人类评估和自动化评估方法,设计能够更全面、准确地评估模型生成SGPs质量的指标。

- 改进模型架构和训练方法:

- 探索更大规模的模型:研究更大规模的LLMs在生成SGPs方面的能力,并探索如何有效地微调这些模型以提高其性能。

- 设计更有效的多模态融合机制:研究如何将文本和视觉信息更有效地融合到模型中,以提高模型生成SGPs的准确性和一致性。

- 探索自监督学习和无监督学习方法:研究如何利用自监督学习和无监督学习方法来预训练或微调LLMs,以降低对标注数据的依赖并提高模型的泛化能力。

- 探索实际应用场景:

- 跨模态生成任务:将SGP生成技术应用于更广泛的跨模态生成任务中,如文本到3D模型的生成、视频生成等。

- 交互式生成系统:开发交互式生成系统,允许用户通过自然语言与模型进行交互,实时生成和修改SGPs,以满足用户的个性化需求。

- 教育与创意工具:将SGP生成技术应用于教育和创意领域,开发能够帮助学生学习编程和设计的工具,或者为艺术家和设计师提供新的创作灵感和手段。