Memory in LLM Agent

Memory in LLM Agent

1 为什么需要“记忆” —— 背景与动机

在构建 LLM Agent(Large Language Model Agent,大语言模型驱动的智能体)的过程中,“记忆”(Memory)是一个绕不开的核心问题。没有记忆的 Agent,通常只能在有限的上下文窗口内工作,难以保持长期一致性和用户个性化体验。本章将从背景、动机和典型需求三个角度出发,解释为什么记忆机制是 LLM Agent 架构的关键组成部分。

1.1 LLM 的上下文窗口限制

当前主流的大语言模型(如 OpenAI GPT 系列、Anthropic Claude、Meta LLaMA、Mistral 等)都依赖 上下文窗口(Context Window) 来维持短期的对话和任务连贯性。然而,这种机制存在天然限制:

- 容量有限:即使是最新的 GPT-4o 或 Claude 3.5,窗口长度通常在 200K tokens 左右。虽然相比早期的 2K–4K 已经大幅提升,但对于长期运行的 Agent 仍然不足。

- 成本增加:窗口越大,推理延迟和计算成本越高。

- 遗忘机制缺失:LLM 在长上下文中容易“注意力稀释”(attention dilution),导致早期信息被遗忘或误解。

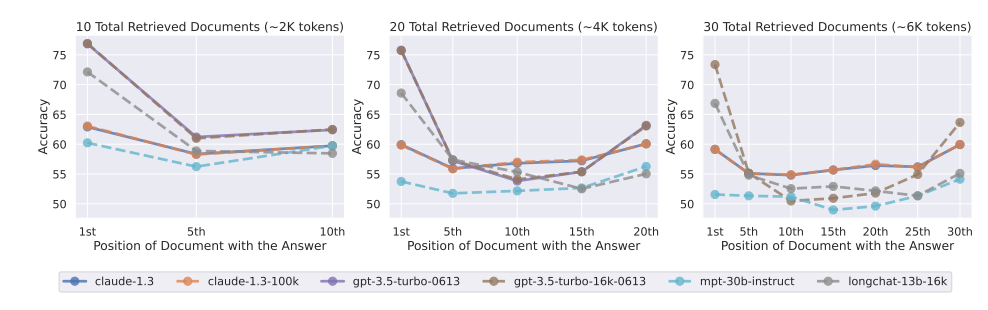

相关研究已经表明,大模型在处理极长上下文时,性能会显著下降。参见 Liu et al., 2024, Lost in the Middle,该论文系统性评估了 LLM 在长上下文下的检索与推理性能。

1.2 多轮交互与长期一致性

现实中的 Agent 需要在 多轮对话 与 长期交互 中表现稳定。例如:

- 个人助理型 Agent:需要记住用户的偏好(如常点的外卖、常用的写作风格)。

- 企业客服 Agent:需要追踪客户历史问题,避免每次重复询问。

- 研究型 Agent:需要在长时间的探索与迭代中保存上下文与任务链条。

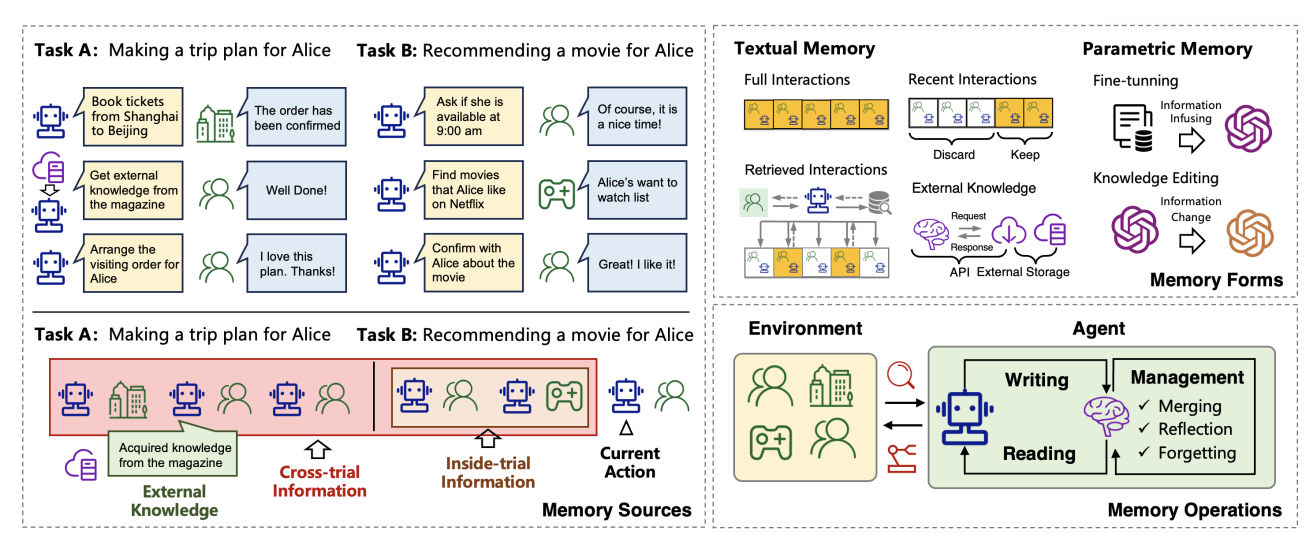

没有记忆机制的 LLM Agent,往往在长时间交互后失去一致性,表现出“健忘”的特征。这一点在 Zhang et al., 2024, A Survey on the Memory Mechanism of LLM-based Agents 中有系统性的总结,作者指出记忆是实现持久化和一致性的关键前提。

1.3 记忆能解决的关键问题

引入记忆机制,能够解决以下几个核心挑战:

-

个性化(Personalization) Agent 能够基于用户历史行为建立“用户画像”,从而提供差异化服务。例如,LangChain 与 LlamaIndex 等框架已支持通过外部数据库记录用户交互并进行定制化。

-

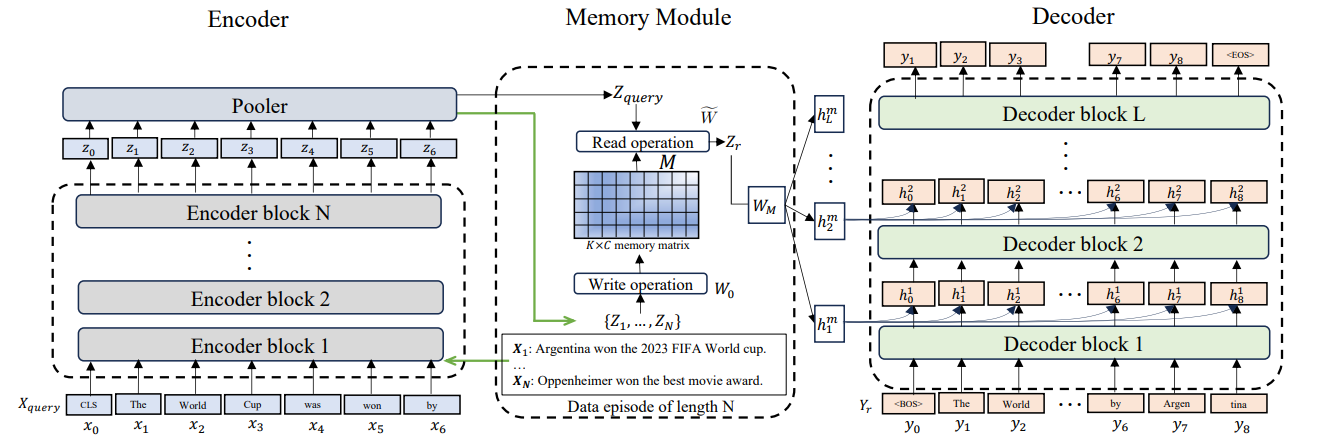

事实更新与知识演化(Knowledge Updating) 世界知识是动态变化的,例如法律法规、股票价格、科研进展。通过记忆机制,Agent 可以在不重新训练模型的情况下,快速更新事实。相关研究见 Das et al., 2024, Larimar: LLMs with Episodic Memory。

-

纠错与自我学习(Error Correction & Self-improvement) 通过保存过去的错误与修正,Agent 可以避免重复犯错。这种“经验回放”(experience replay)与强化学习中的记忆池类似。

-

减少冗余(Efficiency) 避免用户多次输入相同信息,降低 token 消耗与推理延迟。

-

提高决策质量(Decision Making) 通过跨任务回溯,Agent 能更好地推理“因果链”,在复杂决策问题中表现更稳定。

1.4 认知科学类比 —— 从人类记忆看 Agent 记忆

在人类认知科学中,记忆通常分为三类:

- 情景记忆(Episodic Memory):记录具体事件和经历,例如一次对话。

- 语义记忆(Semantic Memory):记录事实与概念,例如“地球围绕太阳旋转”。

- 程序性记忆(Procedural Memory):记录操作与技能,例如骑自行车。

LLM Agent 的记忆机制也可类比于以上分类:

- 情景记忆 → 保存对话历史、事件日志;

- 语义记忆 → 保存知识库、事实索引;

- 程序性记忆 → 保存操作策略或常用任务模版。

这种认知框架在 Tulving, 1972, Episodic and Semantic Memory 中首次提出,对现代 LLM Agent 的记忆机制设计具有启发意义。

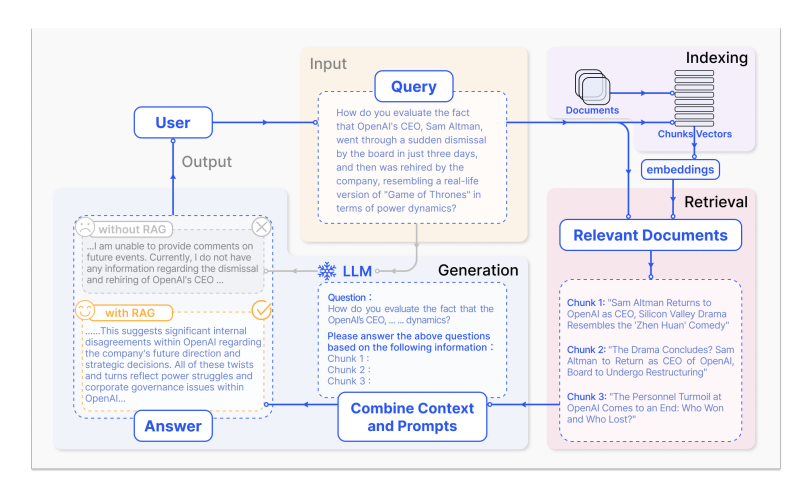

1.5 RAG 与记忆的结合

目前的主流实践是通过 检索增强生成(RAG, Retrieval-Augmented Generation) 来补足 LLM 的记忆不足。

RAG 的典型流程:

- 将对话或文档分割成 chunks

- 使用向量嵌入(embedding)存入外部向量数据库

- 在推理时检索相关内容并拼接到上下文

这类方法本质上是一种“外部记忆”。其关键在于如何高效地选择、压缩和检索信息。关于 RAG 的综述可见 Gao et al., 2024, Retrieval-Augmented Generation for LLMs: A Survey。

综上所述,记忆机制对于 LLM Agent 的重要性可以归纳为三点:

- 突破上下文限制:克服 LLM 的短期记忆约束。

- 支撑长期个性化:让 Agent 能够在多轮、多任务中保持一致性与连续性。

- 提升可靠性与实用性:通过记忆机制,Agent 不仅能“回答问题”,还能逐步演化为“长期陪伴的智能助手”。

2 记忆的分类

在 LLM Agent 中,“记忆”并不是单一形式,而是一个多层次、多类型的系统。合理的分类能够帮助开发者理解不同类型记忆的作用与适用场景,从而在工程实践中做出设计取舍。本章将从 存储时长、功能语义 和 实现机制 三个角度,对 LLM Agent 的记忆进行系统化分类。

2.1 按存储时长划分

从时间跨度的角度,可以将记忆分为三类:

-

短期记忆(Short-term Memory)

- 特点:仅在单次会话或上下文窗口内存在。

- 应用:追踪用户当下输入,维持对话连贯性。

- 局限:一旦会话结束或超过窗口大小即丢失。

- 对应实现:LLM 的上下文窗口(context window)。

-

中期记忆(Mid-term Memory)

- 特点:在数小时到数周的时间跨度内保存信息。

- 应用:如个人助手在一周内记住用户的日程安排。

- 实现方式:外部存储 + 定期压缩为摘要。

-

长期记忆(Long-term Memory)

- 特点:跨越数月甚至数年,支持长期个性化与知识积累。

- 应用:持续跟踪用户的偏好、研究进展、企业知识库。

- 实现方式:基于向量数据库(FAISS、Weaviate、Pinecone 等)或分布式记忆架构。

- 研究参考:Das et al., 2024, Larimar: LLMs with Episodic Memory,提出通过分布式情节记忆机制增强长期知识更新能力。

2.2 按语义/功能划分

从功能角度看,LLM Agent 的记忆可以类比于人类认知科学中的分类(Tulving, 1972, Episodic and Semantic Memory),主要包括:

-

情景记忆(Episodic Memory)

- 定义:记录与用户交互的具体事件或经历(带时间戳、上下文)。

- 应用:对话回溯、事件追踪。

- 示例:用户曾经问过“上周我提到的书名是什么?”

- 技术实现:事件日志 + 索引机制,支持基于时间和语义的检索。

- 研究参考:Das et al., 2024, Larimar: LLMs with Episodic Memory。

-

语义记忆(Semantic Memory)

- 定义:存储抽象化的知识、概念与事实。

- 应用:企业知识库、FAQ 系统、科研事实数据库。

- 示例:Agent 知道“光速约为 3×10^8 m/s”。

- 技术实现:通常与检索增强生成(RAG)结合,基于知识库或外部数据库。

- 综述参考:Gao et al., 2024, Retrieval-Augmented Generation for LLMs: A Survey。

- 程序性记忆(Procedural Memory)

- 定义:存储操作流程、技能与策略。

- 应用:任务自动化(如执行 API 调用、脚本编排)。

- 示例:Agent 学会“如何通过 API 查询天气并生成报告”。

- 技术实现:通常以“工具调用链”(tool chain)或“执行计划”(plan)形式保存,可与 RLHF 或 fine-tuning 结合。

- 最新应用:强化学习结合记忆回放(experience replay)机制,提高 Agent 的任务执行稳定性。

这种三分法有助于开发者在设计时区分“事实知识”与“交互历史”,并明确何种信息需要长期保留,何种只需临时存储。

2.3 按实现机制划分

从工程实现角度,可以将记忆机制分为以下三类:

-

外部检索型记忆(External Retrieval-based Memory)

- 原理:通过外部数据库(如向量库、知识图谱)存储信息,LLM 仅在推理时调用。

- 优点:易扩展、易更新,不需要修改 LLM 参数。

- 缺点:依赖检索质量,可能出现 recall/precision 失衡。

- 案例:RAG(Retrieval-Augmented Generation)。

- 技术综述:Gao et al., 2024, RAG Survey。

-

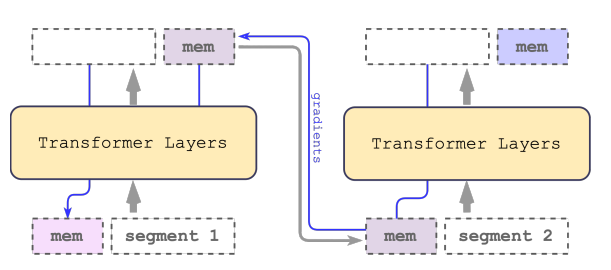

内嵌/可微分记忆(Differentiable / Model-internal Memory)

- 原理:在模型结构中直接集成记忆模块,例如 Memory-augmented Transformer、Recurrent Memory。

- 优点:高效、一体化,能够端到端学习。

- 缺点:训练和推理成本高,更新不灵活。

- 代表性研究:Chen et al., 2024, Recurrent Memory Transformer(arXiv:2207.06881)。

- 混合型记忆(Hybrid Memory)

- 原理:结合外部检索和内部记忆,例如先用外部向量库存储详细事件,再用模型内部记忆存储高层抽象。

- 优点:兼顾可扩展性与推理效率。

- 案例:LangChain / LlamaIndex 框架支持“摘要 + 原始记录”的混合存储方式。

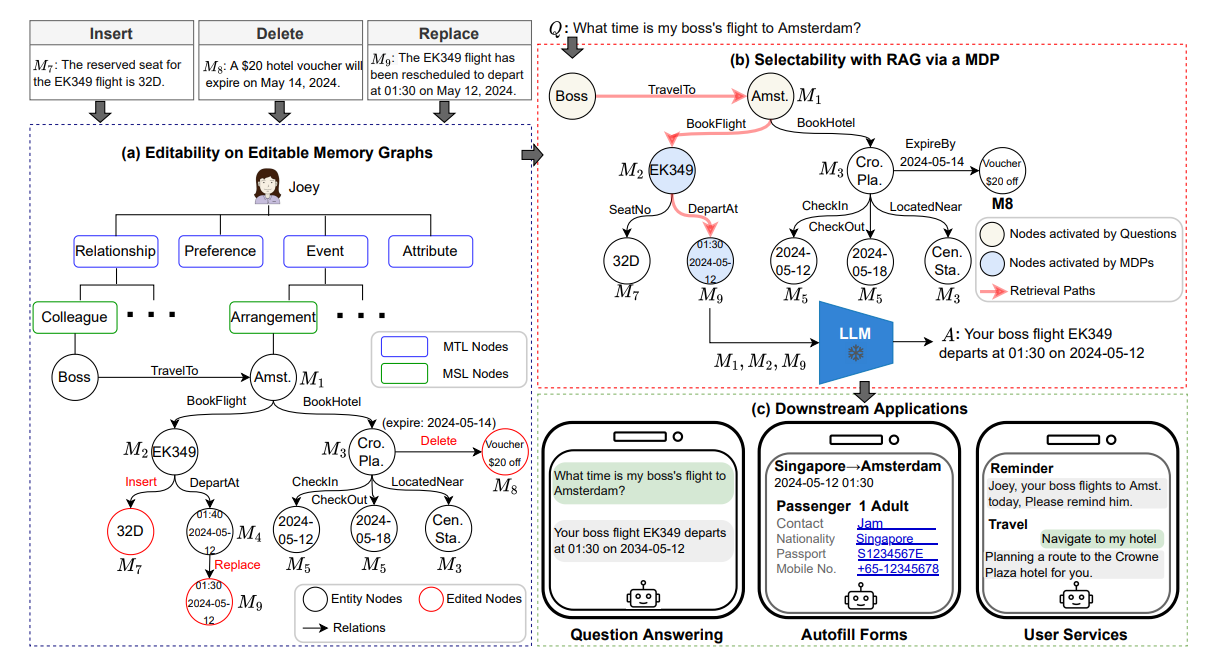

- 最新研究:Wang et al., 2024, EMG-RAG: Crafting Personalized Agents through Retrieval from Smartphone Memories(arXiv:2409.19401)。

通过上述三个维度的分类,可以看出 LLM Agent 的记忆并非单一模块,而是一个 多层次的存储系统。在实际工程中,往往需要:

- 结合时长分类:短期上下文结合长期数据库;

- 结合语义分类:情景记忆辅助个性化,语义记忆提供知识支撑,程序性记忆提高执行力;

- 结合机制分类:外部存储保证扩展性,内部记忆保证实时性,混合架构平衡二者。

3 主要技术路线与实现机制

3.1 检索增强生成(RAG, Retrieval-Augmented Generation)

RAG 是目前最广泛应用的记忆实现方式。它通过将外部知识(文档、对话历史、数据库内容等)存储在 向量数据库 中,并在生成时检索相关内容,再拼接到 LLM 的上下文中,从而突破 LLM 固有的上下文窗口限制。

核心流程:

- 分块(Chunking):将原始信息切分为合适粒度的片段(100–500 tokens 常见)。

- 嵌入(Embedding):使用专门的 embedding 模型(如 OpenAI text-embedding-3-large、Cohere Embed、BGE)将文本转化为向量。

- 存储(Indexing):将向量存储在数据库(FAISS、Weaviate、Pinecone、Milvus 等)。

- 检索(Retrieval):在生成时基于查询语义找到最相关的信息。

- 拼接(Augmentation):将检索结果注入到 prompt,交由 LLM 生成最终回答。

工程注意点:

- Chunk 大小:过小会导致语义丢失,过大会浪费 token。

- 检索精度:需要 reranker(如 BERT-based ranker)进行二次筛选。

- 上下文预算:仅选择最相关的 top-k 结果,避免冗余。

参考Gao et al., 2024, Retrieval-Augmented Generation for Large Language Models: A Survey(arXiv:2312.10997)

3.2 事件/情景记忆(Episodic Memory)

情景记忆记录的是 用户与 Agent 的交互历史,类似人类的“经历”。不同于 RAG 主要聚焦于知识检索,episodic memory 强调 时间序列性 和 上下文回溯。

实现方式:

- 原始记录存储:保存完整的对话/事件日志。

- 摘要压缩(Summarization):对长对话进行多层次摘要,减少存储和检索开销。

- 元数据(Metadata)索引:增加时间戳、情境标签、情感标签等,便于多维度检索。

应用场景:

- “上次会议我们讨论了什么?”

- “帮我回顾一下昨天写的代码思路。”

Das et al., 2024, Larimar: Large Language Models with Episodic Memory(arXiv:2403.11901):提出基于分布式情景记忆机制,支持跨会话追踪与学习。

3.3 可编辑记忆与知识更新(Memory Editing)

现实中的知识不断演变,Agent 的记忆需要 动态更新。例如,当用户搬家后,旧地址应被删除或覆盖,否则会导致错误推荐。

实现机制:

- 直接覆盖:在向量库中删除旧条目,插入新条目。

- 事实纠错(Knowledge Editing):通过精调或局部 LoRA 注入新知识。

- 索引更新:更新嵌入向量,以反映新的知识状态。

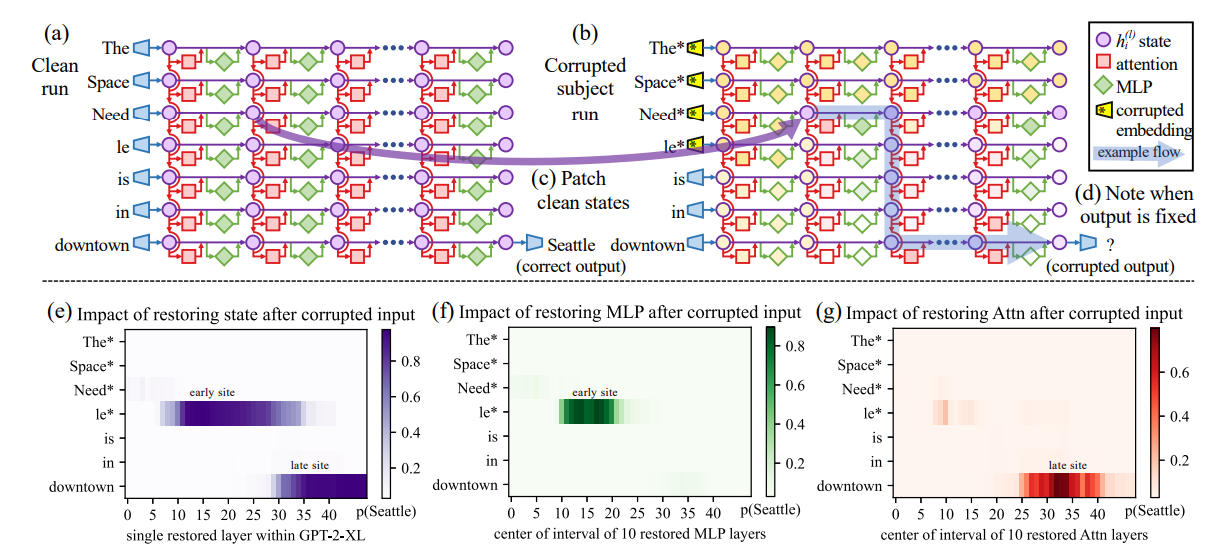

- Meng et al., 2022, Locating and Editing Factual Associations in LLMs(ROME 方法)

- Das et al., 2024, Larimar: Large Language Models with Episodic Memory(arXiv:2403.11901):强调 episodic memory 的动态可更新性。

3.4 学习型记忆(Differentiable / Model-internal Memory)

与 RAG 依赖外部存储不同,学习型记忆直接将“记忆模块”融入模型架构中,使其能够端到端训练。

方法:

- 可微分记忆网络(Memory Networks, Neural Turing Machines):早期方法,可对外部存储进行可微访问。

- Recurrent Memory Transformer:在 Transformer 结构中加入循环记忆单元,用于长期依赖建模。

- Stateful Inference:通过缓存和递归机制,在推理过程中维持状态。

优缺点:

- 优点:高效、紧密集成,避免外部依赖。

- 缺点:训练成本高,更新困难。

Chen et al., 2024, Recurrent Memory Transformer(arXiv:2404.11699)。

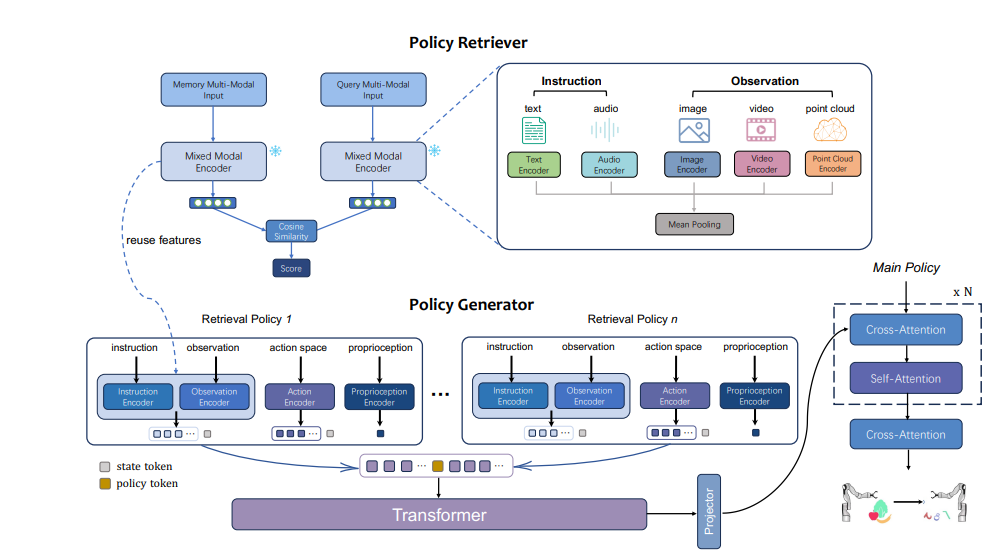

3.5 多模态与具身 Agent 的记忆

对于机器人或虚拟代理,仅有文本记忆是不够的。它们需要整合 多模态数据(图像、语音、动作序列等),形成“具身记忆”。

实现方式:

- 视觉快照 + 文本描述:结合 CV 模型提取图像特征,与文本一起存储。

- 状态日志:记录物理状态(位置、传感器数据)。

- 检索增强:在执行任务时检索过往操作轨迹,避免重复错误。

Li et al., 2024, Retrieval-Augmented Embodied Agents (RAEA)(arXiv:2403.09499):提出在具身任务中引入检索机制,显著提升长期推理与任务执行。

3.6 工程化的记忆堆栈(Memory Stack in Practice)

在实际工程系统中,LLM Agent 的记忆通常由多个层次堆叠而成:

- 缓存层(Cache Layer):短期存储最近对话,低延迟、高速。

- 向量检索层(Vector Store):中长期存储,支持高维检索与扩展。

- 摘要层(Summary Layer):压缩存储历史,减少冗余。

- 日志与审计层(Audit Layer):保证可追踪性和可控性。

例如,LangChain 和 LlamaIndex 提供了 Memory 模块,允许开发者选择不同的存储与检索策略,形成“组合式记忆体系”。

LLM Agent 记忆的主要实现模式:

- RAG:解决外部知识调用问题,灵活高效。

- Episodic Memory:增强交互的连续性与个性化。

- Memory Editing:保证知识动态更新。

- Differentiable Memory:探索端到端集成的未来方向。

- Multimodal & Embodied Memory:面向机器人与多模态 Agent 的新兴实践。

- 工程化 Memory Stack:现实系统的综合性解决方案。

4 记忆的管理策略(Policy)——什么时候写、读、忘

然而,“是否具备记忆” 并不是唯一问题,更关键的是 “如何管理记忆”。如果没有合理的管理策略,记忆会出现以下问题:

- 记忆冗余,导致检索效率下降;

- 信息冲突,造成回答不一致;

- 上下文过载,增加 token 成本;

- 隐私和合规风险。

因此,Agent 必须具备 写入(Write)、读取(Read)、遗忘(Forget) 三方面的策略。本章将介绍各类策略、工程实现方式,以及相关研究成果。

4.1 写入策略(Write Policy)

Agent 并不是接收到所有信息都要写入记忆,否则会造成“信息过载”。 关键在于 何时写入 和 写入什么。常见策略:

-

全量记录

- 保存所有交互、上下文。

- 优点:完整性高,方便追溯。

- 缺点:存储和检索成本极高。

-

触发式写入

- 仅当满足特定条件时才写入,例如:

- 用户显式标记为“重要”

- 检测到新的事实(如用户提供了电话号码、偏好)

- 达到设定的时间或会话节点

- 代表性工作:LangChain 中的

ConversationBufferMemory与ConversationSummaryMemory

- 仅当满足特定条件时才写入,例如:

-

摘要式写入

- 将冗长的对话内容压缩为摘要,再存入记忆。

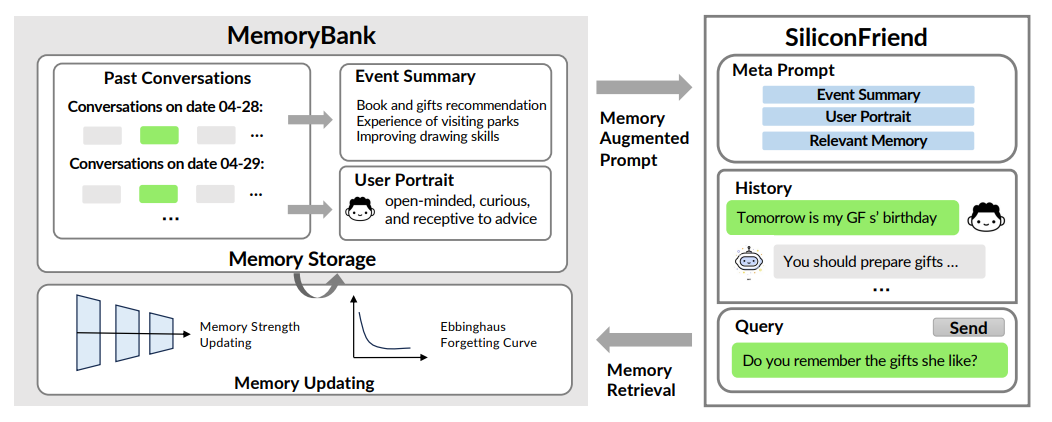

- 参考:Zhang et al., 2023, MemoryBank: Enhancing LLMs with Long-Term Memory (arXiv:2305.10250) 提出通过多层次摘要减少冗余。

工程化需要注意的点:

- 事实与观点区分:用户表达的临时情绪不一定要写入长期记忆。

- 知识更新机制:当新事实出现时,应考虑覆盖旧内容。

4.2 读取策略(Read Policy)

即便存储了大量信息,也必须决定在 生成时读取哪些记忆,否则会造成上下文过载。常见策略:

-

基于向量检索的选择

- 检索与当前 query 最相关的 top-k 记忆。

- 可结合 reranker 提升准确率。

-

基于上下文的动态裁剪

- 根据 prompt 的 token 限制,优先保留高相关度内容。

- 例如 Anthropic 的 Contextual Compression 技术,通过 LLM 自身对候选记忆进行压缩再拼接。

-

基于记忆类型的分层检索

- 例如优先检索 episodic memory(用户交互历史),其次是 semantic memory(知识库),再结合 working memory。

- 类似人脑的“分层激活”。

- Gao et al., 2024, RAG Survey (arXiv:2312.10997) 总结了不同检索策略的性能差异。

4.3 遗忘策略(Forget Policy)

如果所有记忆都永久保存,将导致:

- 存储与检索开销过大

- 知识过时,答案可能错误

- 隐私风险加剧

因此,Agent 需要具备“遗忘”机制。常见策略:

-

基于时间的衰减(Time Decay)

- 设定记忆有效期,超过时限自动归档或删除。

- 适合用户临时性需求(如一次性验证码)。

-

基于使用频率的遗忘(Usage-based Forgetting)

- 类似缓存替换策略(LRU, LFU)。

- 被频繁访问的记忆保留,长期不用的逐步淘汰。

-

基于重要度的遗忘

- 由模型评估记忆的重要性(例如是否包含核心事实)。

- 不重要的信息会被丢弃或转为摘要。

-

人工触发遗忘

- 用户可以显式要求删除或更新(符合 GDPR / CCPA 合规要求)。

Das et al., 2024, Larimar: Large Language Models with Episodic Memory (arXiv:2403.11901) 提出了基于“记忆重加权”的动态遗忘机制。

Khandelwal et al., 2020, Generalization through Memorization (arXiv:1911.00172) 指出长期保留低价值记忆会影响模型泛化。

4.4 综合记忆管理框架

在实际工程中,写、读、忘需要配合,形成完整的记忆管理闭环。一个典型的框架包括:

-

写入层

- 原始记录 + 摘要存储

- 触发式保存重要信息

-

读取层

- 多通道检索(向量检索 + 语义 rerank + 上下文压缩)

- 动态裁剪

-

遗忘层

- 时间衰减 + 使用频率 + 重要性权重

- 人工可控

这种 策略组合 已在 LangChain、LlamaIndex、MemGPT 等系统中得到应用。

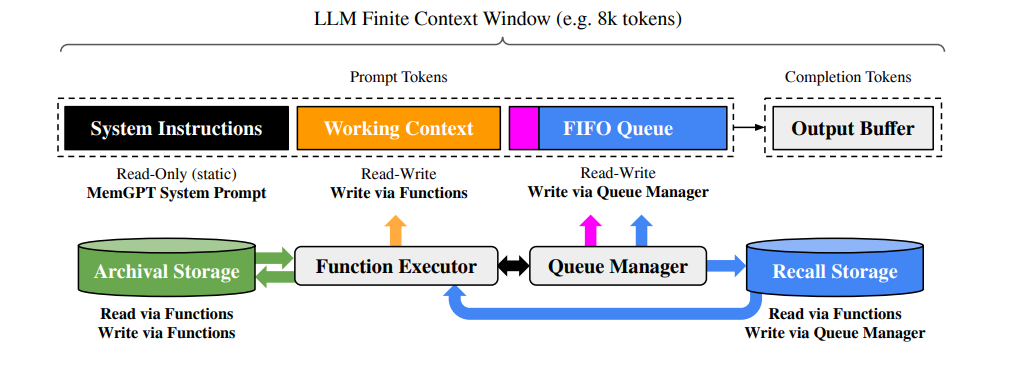

- 例如,MemGPT(Wu et al., 2023, arXiv:2310.08560)实现了“多层内存管理”,支持自动写入、裁剪和遗忘。

记忆管理策略是 LLM Agent 的核心机制之一,其目标是:

- 写入时:避免冗余,确保重要信息被保留

- 读取时:高效检索,保证生成相关性

- 遗忘时:动态清理,提升系统健康度与合规性

可以说,记忆管理是让 LLM Agent 从“记忆一切的黑盒”走向“有序思考的智能体”的关键一步。

5 评估指标与基准

在设计与实现 LLM Agent 的记忆机制后,一个不可或缺的问题是:如何评估记忆的有效性与质量?

仅靠功能实现并不能保证系统的实用性和鲁棒性。评估指标与基准(Benchmark)为开发者提供了 可量化的对比标准,有助于发现不足、优化策略,并推动领域发展。

5.1 评估的核心目标

记忆评估的核心目标可以概括为以下几个方面:

-

准确性(Accuracy)

- 记忆是否能够被正确检索与复现?

- 示例:当用户询问“我昨天告诉你的会议时间是什么?”时,Agent 能否正确回答。

-

完整性(Completeness)

- 记忆是否覆盖了所有关键信息,而非仅仅部分片段?

- 评估指标通常与 召回率(Recall) 相关。

-

时效性(Timeliness)

- 记忆能否反映最新的事实?是否存在“知识过时”问题?

-

相关性(Relevance)

- 在检索过程中,Agent 是否能够挑选出与当前任务最相关的记忆,而不是冗余或噪声信息。

-

效率(Efficiency)

- 检索延迟和存储开销是否可接受?

- 对于在线 Agent,延迟直接影响用户体验。

-

一致性与稳定性(Consistency & Robustness)

- Agent 在不同时间访问同一记忆时,回答是否稳定一致?

- 遇到冲突信息时,能否给出合理解释。

-

合规性与隐私(Compliance & Privacy)

- 是否支持用户删除/修改记忆(GDPR, CCPA 要求)?

- 是否存在敏感数据泄露的风险?

5.2 常用评估指标

定量指标

-

检索准确率(Precision@k) :在 top-k 检索结果中,有多少条与查询真正相关。

-

召回率(Recall@k) : 检索出的相关结果占所有相关结果的比例。

-

F1-score : 平衡准确率和召回率的指标。

-

延迟(Latency) : 记忆写入/读取的时间开销。

-

覆盖率(Coverage) : 长期交互中,Agent 是否遗漏了用户提供的重要事实。

-

漂移率(Drift Rate) : 旧知识被新知识覆盖的程度,以及错误保留的比例。

定性指标

-

人类评估(Human Evaluation) : 人类标注员判断 Agent 是否正确调用了历史记忆。

-

用户满意度(User Satisfaction) : 用户主观打分,例如对连续对话的“上下文感知”体验。

-

解释能力(Explainability) : Agent 是否能解释记忆的来源(例如“这是你上次在 9 月 1 日告诉我的”)。

5.3 基准数据集与评测任务

近年来,多个基准任务专门针对 LLM Agent 的记忆能力进行评估:

-

MemBench

- Xu et al., 2024, MemBench: Towards More Comprehensive Evaluation on the Memory of LLM-based Agents ([arXiv:2506.21605](https://arxiv.org/abs/2506.21605))

- 提供一系列任务,包括事实记忆、对话记忆和更新/删除操作,全面评估 Agent 的记忆管理能力。

-

LongBench

- Bai et al., 2023, LongBench: A Benchmark for Long Context Understanding (arXiv:2308.14508)

- 主要测试长上下文能力,与记忆相关,因为良好的记忆管理能降低对超长上下文的依赖。

-

MemGPT Evaluation

- Wu et al., 2023, MemGPT: Towards LLMs as Operating Systems (arXiv:2310.08560)

- 在多会话交互中测试 Agent 的多层内存管理效果。

-

Episodic Memory Benchmarks

- Das et al., 2024, Larimar: LLMs with Episodic Memory (Das et al., 2024, Larimar: LLMs with Episodic Memory)

- 专注于跨会话追踪与长期交互任务。

5.4 评估流程与方法学

一个典型的记忆评估流程包括:

-

数据准备

- 构建交互历史(对话、事件日志等)。

- 插入事实更新、冲突信息、无关干扰信息。

-

任务设定

- 提出查询,要求 Agent 调用历史记忆。

- 设置删除或修改请求,验证其是否遵循遗忘策略。

-

自动评估 + 人工验证

- 使用 Precision/Recall/F1 等自动指标。

- 辅以人工标注,验证复杂语境下的记忆调用质量。

-

多维度分析

- 分别考察准确性、效率、稳定性、合规性。

5.5 工程实践中的评估挑战

在真实系统中,评估记忆还面临以下挑战:

- 动态环境:用户需求和知识随时间演变,静态基准难以覆盖。

- 多模态数据:文本、图像、语音混合场景评估标准尚不统一。

- 长时间交互:当前多数基准只覆盖几小时到几天的交互,而真实应用可能跨数月甚至数年。

- 用户隐私:评估过程中必须保护用户敏感数据,不可随意公开存储。

记忆评估是 LLM Agent 研发中不可或缺的一环。

- 指标层面:需要平衡准确性、完整性、效率与合规性。

- 基准层面:SORT、MemBench、LongBench 等为研究提供了客观对比平台。

- 实践层面:评估必须结合动态更新、多模态输入和隐私保护。

6 风险、合规与隐私

随着 LLM Agent 逐渐在企业、医疗、金融、教育等关键领域落地,记忆机制的风险与合规问题 成为必须重点考虑的部分。 记忆可以显著提升用户体验,但同时也带来 数据安全、隐私保护、合规性 等多方面的挑战。

本章将从风险识别、合规标准、隐私保护以及最新研究进展展开分析。

6.1 记忆机制带来的主要风险

-

隐私泄露(Privacy Leakage)

- Agent 在长期交互中会保存用户的敏感信息(地址、联系方式、医疗记录等)。

- 若缺乏适当的保护机制,这些信息可能被错误调用、外泄或滥用。

- 相关研究:Carlini et al., 2021, Extracting Training Data from Large Language Models (arXiv:2012.07805) 显示 LLM 可能在生成时泄露训练数据。

-

知识过时与错误传播(Stale/Incorrect Memory)

- 已过期的信息未被遗忘,可能导致决策错误。

- 示例:用户搬家后地址未更新,Agent 仍使用旧数据。

-

数据滥用与不当持久化(Misuse of Data Persistence)

- 如果没有严格的“最小化存储原则”,系统可能存储过量数据,增加风险面。

-

黑箱性与不可控性(Opacity and Lack of Control)

- 用户难以知道 Agent 具体保存了哪些信息。

- 缺少透明的记忆管理接口,增加了信任成本。

-

推理中的偏见与歧视(Bias in Memory-based Reasoning)

- 长期存储的记忆若包含偏见,会在生成中被不断强化。

6.2 法规与合规要求

各国和地区针对数据保护和隐私有明确的法律框架,LLM Agent 的记忆设计必须遵循.

6.3 隐私保护的技术手段

-

数据加密与安全存储

- 使用端到端加密保护存储在记忆中的数据。

- 对检索和索引数据应用加密搜索(如安全向量检索)。

-

差分隐私(Differential Privacy, DP)

- 在数据存储或训练时引入噪声,降低重识别风险。

- 参考:Abadi et al., 2016, Deep Learning with Differential Privacy (arXiv:1607.00133)。

-

联邦学习(Federated Learning)与本地存储

- 将记忆存储在用户设备端,仅在必要时共享嵌入或摘要。

- 避免服务器端集中存储带来的泄露风险。

-

可控遗忘(Machine Unlearning)

- 提供技术手段让系统主动删除某条记忆,并保证不可恢复。

- 参考:Golatkar et al., 2023, Machine Unlearning in LLMs (arXiv:2405.15152)。

-

访问控制与审计机制

- 通过访问日志和权限管理,确保只有被授权的模块才能调用敏感记忆。

6.4 最新研究与发展趋势

-

隐私感知型记忆架构

- 研究重点转向如何在保证功能性的同时,自动识别并标注敏感信息。

-

可解释记忆(Explainable Memory)

- 提供用户接口,展示哪些信息被保存、何时被调用。

- 类似“记忆透明化面板”,提升用户信任度。

-

合规性自动检查工具

- 引入合规模型,对记忆写入/读取进行实时检测,确保满足 GDPR/CCPA/PIPL 要求。

-

跨模态隐私保护

- 具身 Agent 中涉及图像、语音等多模态数据,研究如何在多模态记忆中进行隐私隔离。

7 总结与展望

7.1 核心观点回顾

-

记忆的本质

- 记忆是 LLM Agent 在长时交互中实现“连续性”和“个性化”的关键。

- 从短期上下文缓存(Context Window)到长期持久化存储(Vector DB、Knowledge Base),记忆让 Agent 超越单次调用的限制。

-

记忆的类型与机制

- 短期记忆:基于上下文窗口的即时信息。

- 长期记忆:借助向量数据库、索引检索机制保存用户信息。

- 工作记忆:用于任务执行阶段的动态存储。

- 这些机制的有机组合,塑造了智能体的“人格”和“认知连续性”。

-

记忆的管理策略(Policy)

- 何时写:避免冗余,关注高价值事件。

- 何时读:结合检索与注意力机制,平衡效率与准确性。

- 何时忘:引入“遗忘”机制,减少过时或无用数据干扰。

-

评估指标与基准

- 从 准确性、覆盖率、效率、鲁棒性 等多个维度评估记忆质量。

- 新兴基准(如 MemBench, LongMemEval)为系统化对比提供了工具。

-

风险与合规

- 隐私泄露、数据滥用、知识过时是记忆系统的核心风险。

- 必须遵循 GDPR、CCPA、PIPL 等法规,结合差分隐私、机器遗忘等技术进行防护。

- 可解释与可控的记忆接口将成为提升用户信任的关键。

8.2 发展趋势

-

隐私感知与合规模块化

- 未来的 Agent 将在记忆模块中内置合规检测和隐私保护能力,避免人工审计的高成本。

-

个性化与普适性平衡

- 如何既满足用户高度个性化的需求,又保证跨用户的普适性,是长期研究方向。

-

多模态记忆

- 随着 Agent 能处理图像、语音、视频,记忆将不再局限于文本,如何实现跨模态一致性与隐私保护成为新挑战。

-

人机共管记忆

- 提供用户可操作的记忆面板,让用户参与“选择、删除、标注”,提升透明度和信任度。

-

评估基准标准化

- 随着学术界与工业界合作,未来将出现统一的 Agent Memory Benchmark,推动系统横向对比和优化。

8.3 对开发者的建议

- 在设计记忆系统时,始终坚持 最小化原则(仅保存必要信息)。

- 引入 可控遗忘机制,保证用户能随时删除不需要的记忆。

- 在项目早期就考虑 合规性和风险控制,而不是在部署后再补救。

- 关注最新研究与开源框架,如 LangChain Memory、MemGPT、MemBench 等,结合工程需求选择合适方案。

8.4 总结

记忆赋予 LLM Agent 连续性、个性化与智能性,是未来智能体发展的重要基石。然而,记忆并非越多越好,而是需要在 功能、效率、隐私与合规 之间寻找平衡点。可以预见,未来的 LLM Agent 将走向:

- 更加人性化 —— 记得用户的习惯、偏好和历史,提供自然的交互体验。

- 更加透明与合规 —— 用户能掌控自己的数据,系统自动满足法律与道德要求。

- 更加智能与可靠 —— 记忆成为增强推理和任务执行的重要支撑,而非风险来源。

最终,记忆不仅是技术问题,更是信任问题。 构建安全、透明、合规的记忆系统,将是推动 LLM Agent 真正走向大规模应用的核心关键。