基于密集型复杂城市场景下求解无人机三维路径规划的Q-learning算法研究(matlab)

目录

一 主要内容

二 研究背景与意义

三 相关理论基础

四 运行结果

五 下载链接

一 主要内容

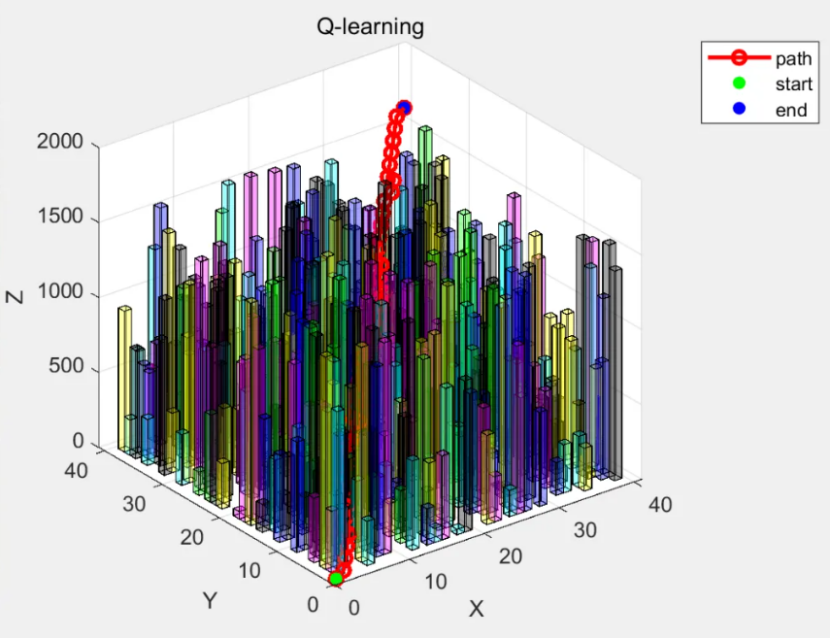

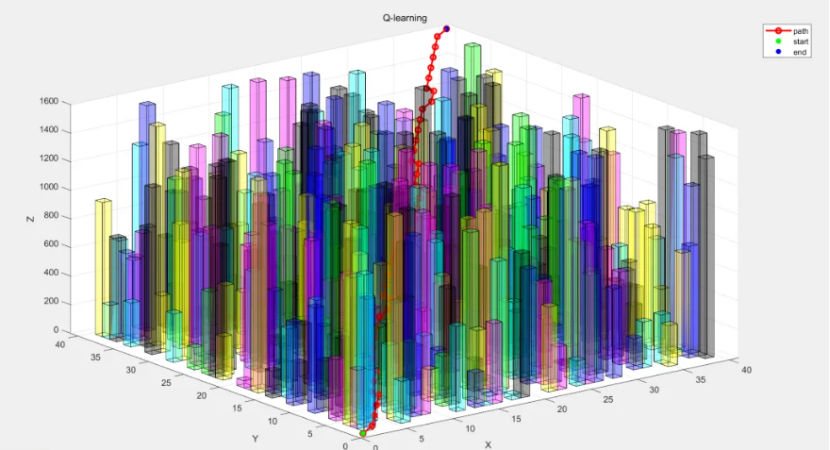

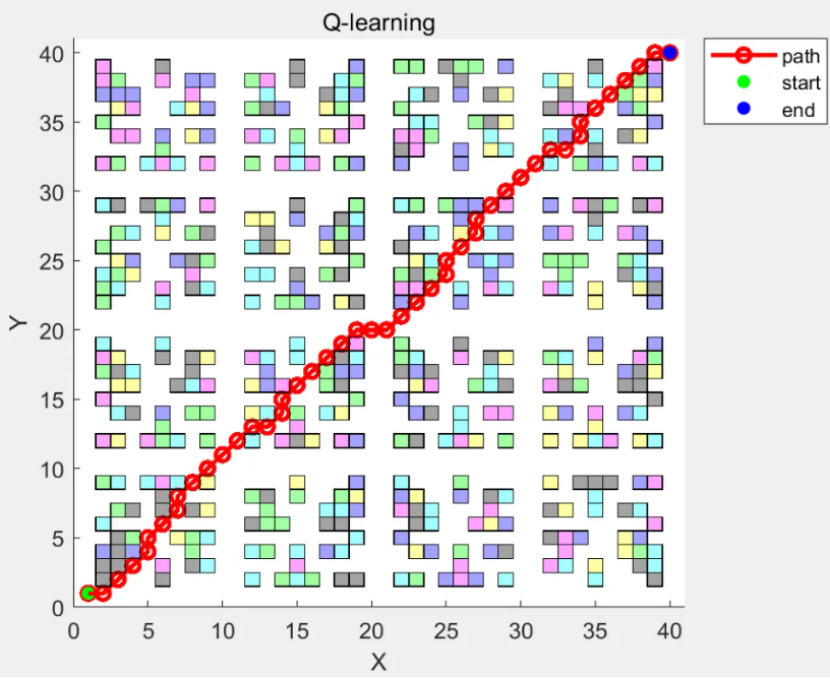

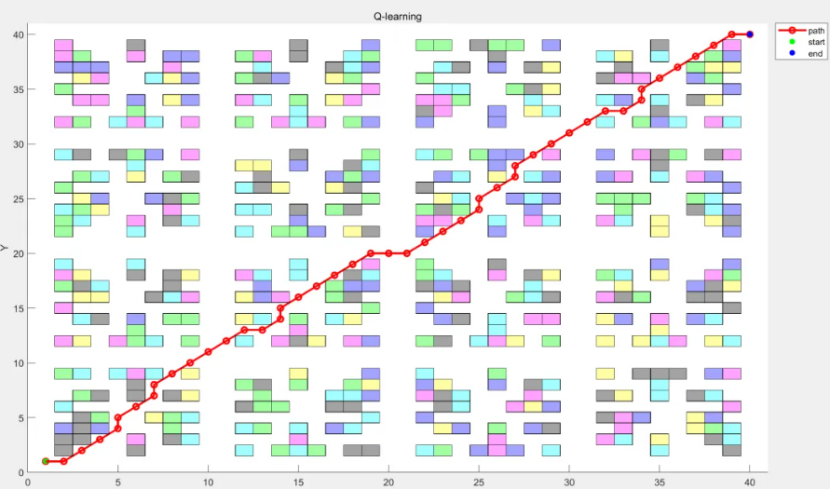

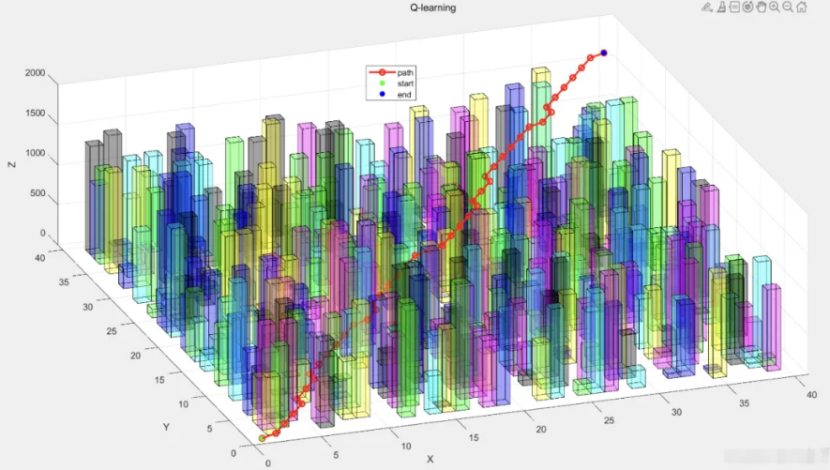

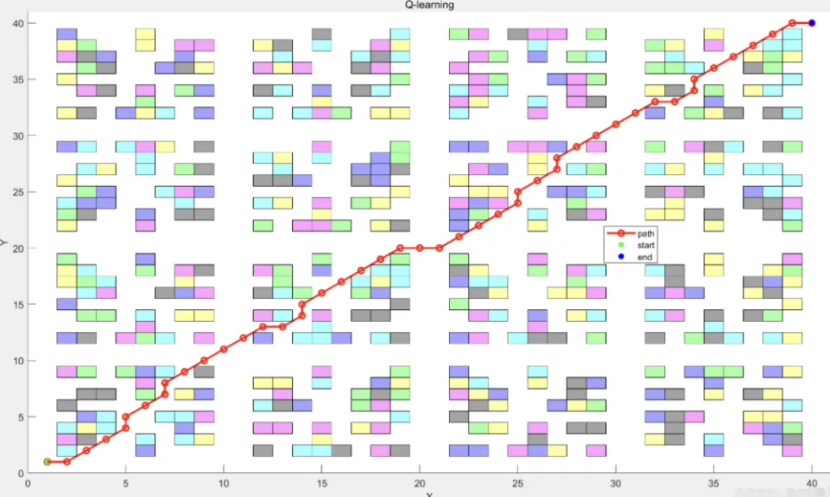

随着无人机在城市物流配送、航拍测绘等领域应用拓展,密集型复杂城市场景下的三维路径规划愈发关键。该场景障碍物密集、三维空间约束复杂且实时性要求高,传统算法难以满足需求。Q-learning算法作为强化学习方法,无需环境模型、可试错学习,适用于此类场景。本文深入研究基于Q-learning的无人机三维路径规划,合理定义状态空间、动作空间与奖励函数,让无人机自主学习最优路径。实验表明,算法能有效避障,规划出较优飞行路径,具备高成功率与适应性。程序采用matlab编写,注释清楚,运行可靠!

二 研究背景与意义

无人机技术在城市应用广泛,但城市场景复杂,建筑物、信号塔等障碍物密集,飞行空间受限,还需考虑飞行安全、能量消耗等。

传统路径规划算法(如A*、Dijkstra算法)在三维复杂空间计算复杂度高、难适应动态环境,无法满足无人机在城市环境的实时性与最优性需求。

强化学习通过与环境交互学习最优策略,为无人机路径规划提供新思路。Q-learning算法无需环境模型、可试错学习,能根据环境奖励信号调整策略,适合复杂城市场景,研究其在无人机三维路径规划的应用具有现实意义。

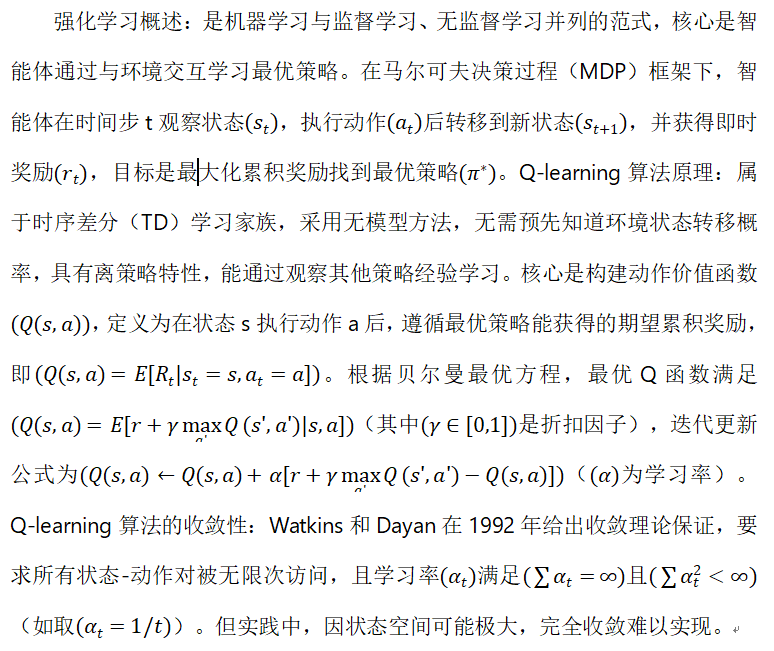

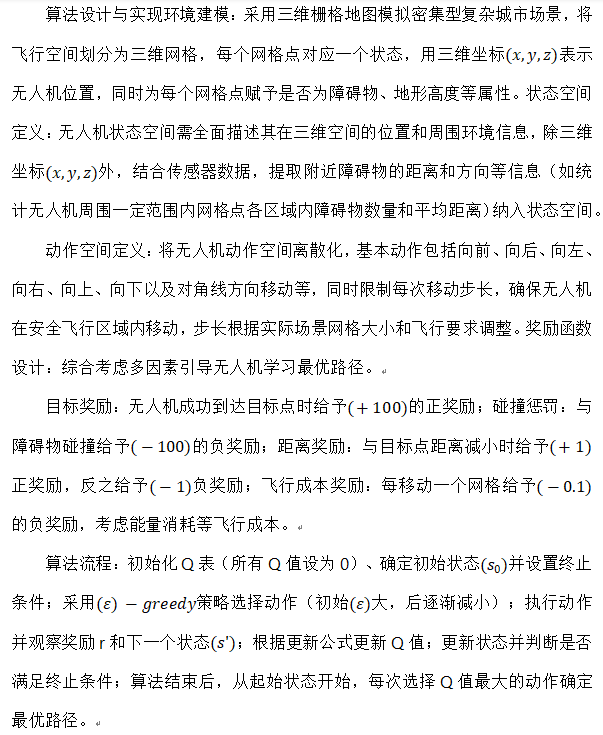

三 相关理论基础

四 运行结果