YOLOv8 Linux 部署指南(GPU CPU 完整版)

1️⃣ 环境准备

-

系统:Linux

-

Python 版本:推荐 3.9

-

安装 Anaconda 或 Miniconda

-

GPU 用户需确认 CUDA 驱动已安装(示例使用 CUDA 11.8)

2️⃣ 手动下载模型与测试图片(可选)

-

创建目录

mkdir -p ~/yolo/models

mkdir -p ~/yolo/images

-

下载 YOLOv8n 模型

YOLOv8n 模型下载地址

保存到:

~/yolo/models/yolov8n.pt

-

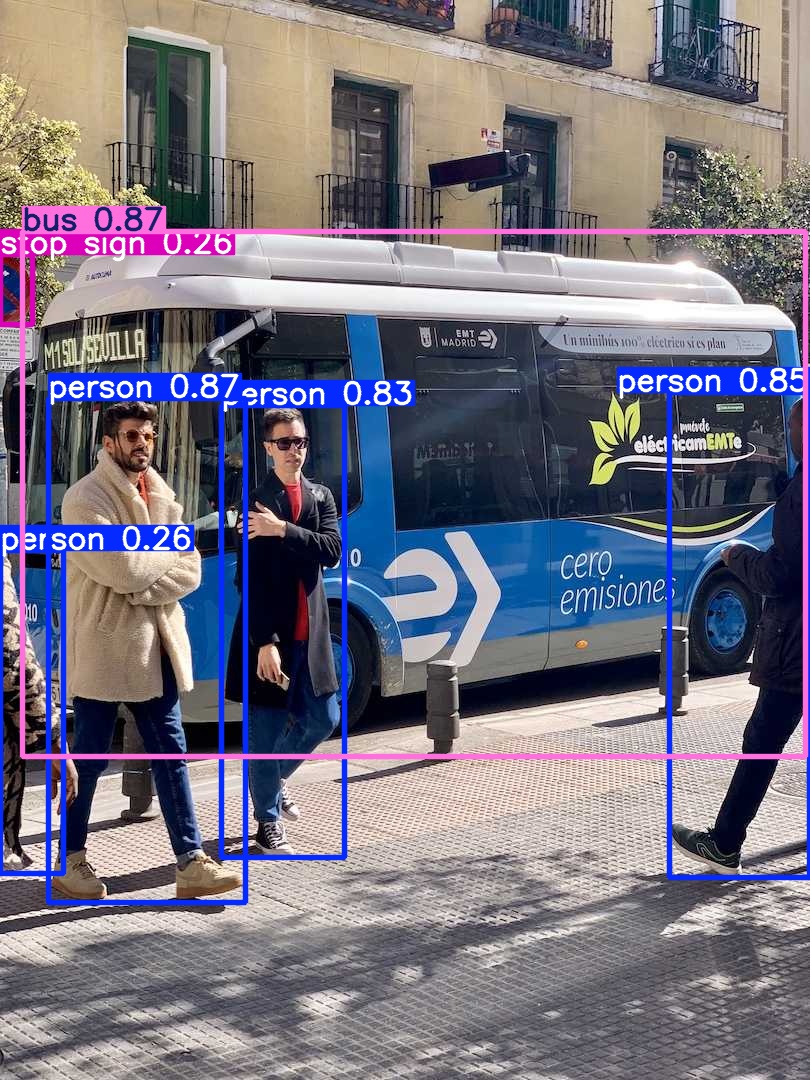

下载测试图片 bus.jpg

bus.jpg 下载地址

保存到:

~/yolo/images/bus.jpg

3️⃣ Linux CPU 一键部署脚本

保存为 deploy-yolov8-linux-cpu.sh:

#!/bin/bashENV_NAME="yolov8-cpu"

PYTHON_VER="3.9"

YOLO_DIR="$HOME/yolo"MODEL_PATH="$YOLO_DIR/models/yolov8n.pt"

IMAGE_PATH="$YOLO_DIR/images/bus.jpg"echo ">>> 创建 conda 环境: $ENV_NAME"

conda create -n $ENV_NAME python=$PYTHON_VER -y

source ~/anaconda3/etc/profile.d/conda.sh

conda activate $ENV_NAMEecho ">>> 安装 YOLOv8 和依赖"

pip install -U pip setuptools wheel

pip install torch torchvision torchaudio

pip install ultralytics onnxruntime tensorboard wandbecho ">>> 验证安装"

yolo predict model="$MODEL_PATH" source="$IMAGE_PATH"

4️⃣ Linux GPU 一键部署脚本

保存为 deploy-yolov8-linux-gpu.sh:

#!/bin/bashENV_NAME="yolov8-gpu"

PYTHON_VER="3.9"

YOLO_DIR="$HOME/yolo"

CUDA_VERSION="cu118"MODEL_PATH="$YOLO_DIR/models/yolov8n.pt"

IMAGE_PATH="$YOLO_DIR/images/bus.jpg"mkdir -p "$YOLO_DIR/models"

mkdir -p "$YOLO_DIR/images"echo ">>> 下载模型和图片"

[ ! -f "$MODEL_PATH" ] && wget -O "$MODEL_PATH" https://github.com/ultralytics/assets/releases/download/v0.0.0/yolov8n.pt

[ ! -f "$IMAGE_PATH" ] && wget -O "$IMAGE_PATH" https://github.com/ultralytics/assets/raw/main/bus.jpgecho ">>> 创建 conda 环境: $ENV_NAME"

conda create -n $ENV_NAME python=$PYTHON_VER -y

source ~/anaconda3/etc/profile.d/conda.sh

conda activate $ENV_NAMEecho ">>> 安装 PyTorch + CUDA 及 YOLOv8"

pip install -U pip setuptools wheel

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/$CUDA_VERSION

pip install ultralytics onnxruntime tensorboard wandbecho ">>> 验证安装"

yolo predict model="$MODEL_PATH" source="$IMAGE_PATH"

5️⃣ 部署流程图

flowchart TDA[创建目录 ~/yolo] --> B[下载模型 yolov8n.pt]A --> C[下载测试图片 bus.jpg]B --> D[创建 conda 环境]C --> D[创建 conda 环境]D --> E[安装 PyTorch + CUDA 或 CPU]E --> F[安装 YOLOv8 和依赖]F --> G[验证安装]G --> H{检测结果生成?}H -- Yes --> I[部署成功 🎉]H -- No --> J[检查依赖或路径]

6️⃣ GPU vs CPU 对比表

| 功能/步骤 | GPU 版本 | CPU 版本 | 说明 |

|---|---|---|---|

| Python 环境 | 3.9 | 3.9 | Conda 环境均可共用 |

| CUDA 驱动 | 必须(示例 CUDA 11.8) | 不需要 | GPU 才能加速推理 |

| 依赖安装 | 带 CUDA 的 PyTorch + YOLOv8 | CPU PyTorch + YOLOv8 | GPU 版本安装带 CUDA 的 PyTorch |

| 模型 & 图片下载 | 自动下载或手动下载均可 | 自动下载或手动下载均可 | 两者一致 |

| 推理速度 | 高速(显卡加速) | 较慢(依赖 CPU 核心) | 显著差异,GPU 推荐大模型或批量推理 |

| 验证步骤 | yolo predict model=MODEL_PATH source=IMAGE_PATH | 相同 | YOLOv8 CLI 一致 |

| 运行脚本 | deploy-yolov8-linux-gpu.sh | deploy-yolov8-linux-cpu.sh | 可直接使用 |

| 适用场景 | 本地训练、大批量推理、速度敏感项目 | 轻量推理、无 GPU 环境 | CPU 可作为备用方案 |

7️⃣ 使用说明

-

保存脚本

-

授权并运行:

chmod +x deploy-yolov8-linux-gpu.sh

./deploy-yolov8-linux-gpu.sh

-

脚本会自动:

-

创建 conda 环境

-

安装 PyTorch + CUDA(GPU)或 CPU 版本

-

安装 YOLOv8 及依赖

-

下载模型和测试图片

-

验证推理

-

-

成功后,在

runs/predict/目录查看检测结果。