架构思维升维:用三层模型穿透技术表象,驾驭复杂系统——淘宝亿级并发架构演进启示录

技术专家的架构困境与破局之道

2012年,淘宝面临前所未有的技术挑战:双11单日交易额突破191亿,但系统频繁出现性能瓶颈和稳定性问题。技术团队发现,单纯“加机器”和“优化代码”已无法解决根本问题——瞬时请求量从平日的20万QPS飙升至200万QPS,数据库连接池爆满,核心服务响应延迟从50ms恶化至2000ms。

问题的根源并非技术储备不足。团队拥有顶尖的Java专家和分布式系统高手,但认知模型没有随系统复杂度升级。工程师们习惯于在“技术层”解决问题(如调整JVM参数、优化SQL),却缺乏穿透表象洞察本质的思维框架。

淘宝架构师团队最终突破这一瓶颈的核心武器,是一套分层思维模型:将系统问题分解为现实层(现象)、技术层(实现)和逻辑层(本质),从而实现从“被动救火”到“主动设计”的思维跃迁。

一、解析三层思维模型:架构师的认知破局框架

1. 现实层(The "What" Layer):现象与诉求的表象

现实层是直接可感知的问题表象。在淘宝早期,包括:

- 性能指标:首页加载时间从2秒恶化至8秒,订单下单失败率从0.5%飙升至15%

- 用户反馈:用户投诉“页面打不开”、“支付失败”、“商品信息错误”

- 监控警报:数据库CPU持续100%,缓存命中率从90%下降至60%

风险警示:若只停留在这一层,团队会陷入“头痛医头”的循环——页面慢就加缓存,失败率高就重启服务。2011年双11期间,团队曾一夜紧急扩容200台服务器,但效果有限。

2. 技术层(The "How" Layer):模式与机制的实现

技术层是为解决现实问题采用的具体技术手段,淘宝采用的技术方案包括:

- 缓存体系:三级缓存架构(本地Caffeine+分布式Redis+CDN),将商品详情页95%的请求在数据库前拦截

- 数据库优化:MySQL主从分离+分库分表,按用户ID哈希分1024表

- 负载均衡:LVS+Nginx组成四级负载体系,支持每秒50万并发连接

- 异步化:订单创建通过RocketMQ异步处理,峰值吞吐量达10万TPS

价值与局限:这些技术组合使淘宝支撑了2013年双11的1.88亿订单(每秒17.5万笔创建)。但若只停留于此,会沦为“技术堆砌者”,无法判断何种模式是最优解。

3. 逻辑层(The "Why" Layer):本质与权衡的核心

逻辑层是驱动技术选择背后的第一性原理和核心权衡(Trade-offs)。淘宝架构师在逻辑层的关键洞察:

- 缓存本质:不是“提高性能”的工具,而是用空间换时间的权衡。决定“缓存什么”和“缓存多久”取决于业务容忍的数据延迟程度

- 分布式本质:不是“扩展性”的银弹,而是用网络开销和复杂度换扩展性的权衡。微服务拆分的粒度取决于业务变更频率和团队协同成本

- 异步本质:不是“提升吞吐量”的手段,而是用时效性换系统弹性的权衡。订单异步化意味着用户无法立即看到创建结果,但系统抗峰值能力提升10倍

架构决策矩阵:任何技术选型都是在五个维度间权衡:

维度 | 描述 | 淘宝案例 |

性能 | 响应速度与吞吐量 | 商品详情页响应<100ms |

一致性 | 数据准确程度 | 库存读写强一致,商品信息最终一致 |

可用性 | 系统正常运行时间 | 99.99%可用性(全年宕机<52分钟) |

成本 | 资源与经济投入 | 通过混部技术提升服务器利用率至40% |

复杂度 | 开发与维护难度 | 引入中间件封装分布式复杂度 |

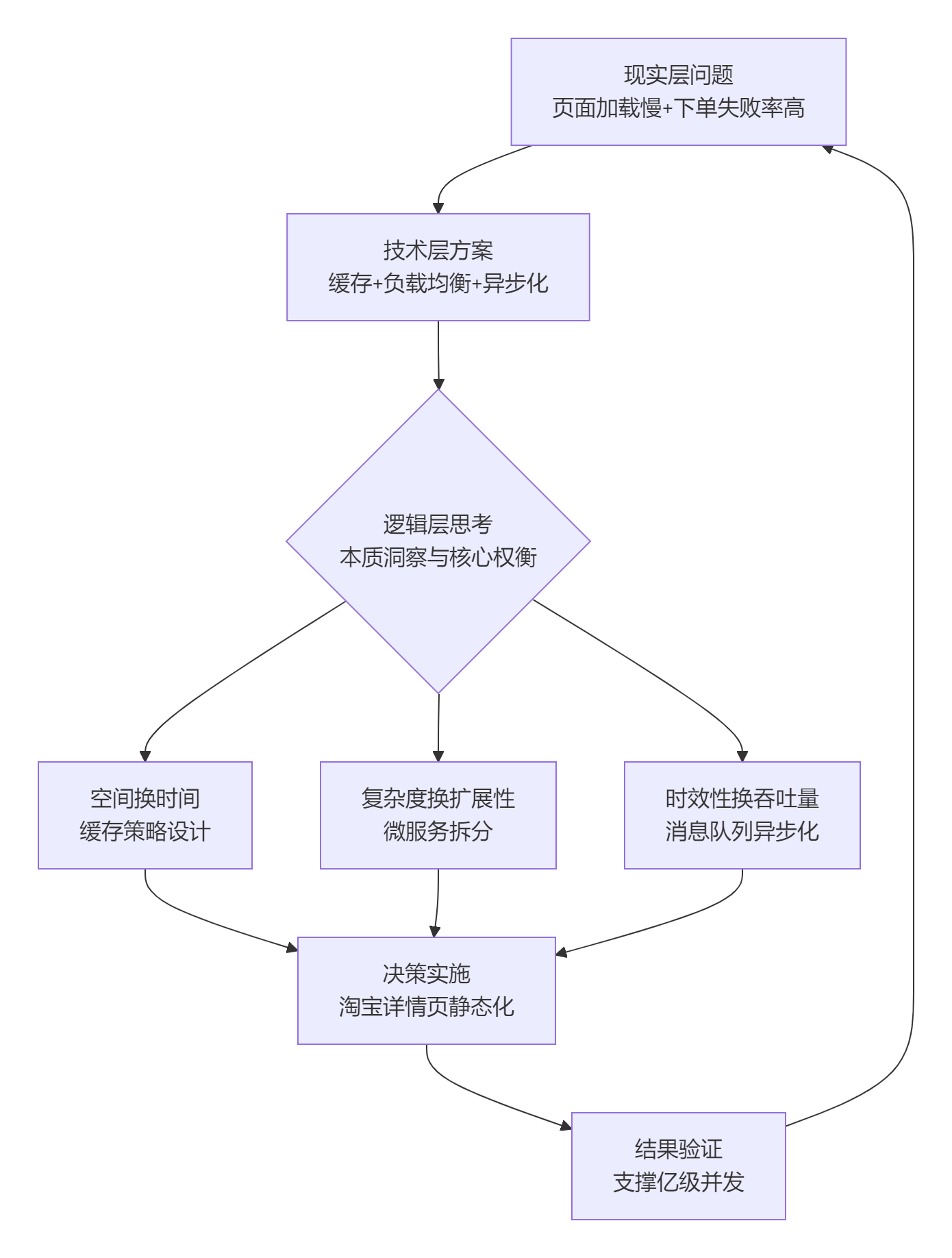

下面是三层思维模型在淘宝架构演进中的综合应用流程:

二、实战演练:三层思维在淘宝核心系统中的应用

商品详情系统(Detail系统)静态化架构演进

2.1 现实层问题与挑战

1.性能瓶颈与体验恶化:2012年前,淘宝商品详情页(Detail系统)面临巨大压力。该系统日均PV(页面浏览量)约占淘宝总PV的25%,每秒需处理约2万个请求,每个页面大小约45KB(压缩后15KB),峰值带宽需求达2Gbps。用户普遍反馈页面加载缓慢,高峰期响应时间从平均的50ms恶化至2000ms以上,下单失败率飙升。

2.资源消耗与成本压力:传统的动态渲染架构严重依赖后端Java应用服务器(如Tomcat集群)和数据库。每次请求都需要执行大量的数据库查询、业务逻辑处理和页面渲染,导致CPU和数据库连接池成为瓶颈。单纯通过“加机器”的垂直扩展方式成本高昂,且效果有限。在2011年双11等大促期间,瞬时流量可达平日数倍甚至数十倍,系统濒临崩溃边缘。

3.业务需求与稳定性冲突:业务要求页面包含实时信息(如价格、库存、优惠),但动态生成这些内容加剧了系统负担。系统稳定性受到严重挑战,亟需一种既能满足业务需求又能保障稳定性的架构方案。

2.2 技术层解决方案与演进

淘宝架构师团队没有局限于单纯的代码优化或硬件扩容,而是实施了一系列架构层面的根本性改造:

1.动静分离:这是最核心的改造。团队对商品详情页的内容进行了深度分析,将其拆分为“静态内容”和“动态内容”。

- 静态内容:商品标题、描述、图片、固定属性等不常变化且与用户无关的信息。这些内容被预渲染成静态HTML文件。

- 动态内容:价格、库存、用户登录信息、个性化推荐等需要实时变动的信息。这些内容通过异步接口调用(如CSI、ESI技术)进行填充。

2.多级缓存体系构建:构建了一个覆盖用户浏览器、CDN、Web服务器、应用服务器的多层次缓存网络。

- CDN缓存:将生成的静态HTML文件推送到全球分布的CDN节点,使用户能从最近节点获取资源,极大降低主站压力和提高响应速度。

- Web服务器缓存:使用定制的Tengine(Nginx)和分布式缓存系统Tair,缓存静态化页面和热点数据。

- 浏览器缓存:利用浏览器缓存机制,减少重复请求。

3.缓存失效机制:为保证静态内容的一致性,设计了主动失效与被动失效相结合的机制。当商品信息变更时,消息中心会通知缓存系统(如Tair)主动清除过期的缓存数据。同时,缓存数据也设置生存时间(TTL),超时后自动失效回源。

4.架构演进三阶段:

- 单机静态化:初期在单机上部署Nginx+Cache+Java,简单但存在扩展性和命中率问题。

- 统一缓存接入层:建立独立的、集中的缓存层(统一接入层),为多个业务系统提供缓存服务,提高了资源利用率和命中率,并简化了维护。

- 全面CDN化:最终将静态化内容推送到CDN边缘节点,实现了最大程度的就近访问和流量卸载。

2.3 逻辑层本质洞察与权衡

架构师认识到,Detail系统的根本矛盾在于海量读请求(占95%)与少量写请求(占5%)对系统资源的竞争。优化的关键不是让读请求更快地通过动态系统,而是彻底避免让大多数读请求进入动态系统。

关键权衡:

- 空间换时间:投入大量的存储空间(CDN、缓存服务器)来存储静态副本,以换取极致的响应速度和吞吐量。这是一个经典且高效的权衡。

- 一致性换性能:接受数据的最终一致性。用户看到的静态信息(如商品描述)可能有短暂延迟,但通过异步接口保障核心动态数据(如库存)的最终准确。牺牲毫秒级的强一致性,换来系统整体的高可用和高性能。

- 复杂度换扩展性:引入了ESI、CSI、分布式缓存、消息队列等一系列复杂技术组件,增加了系统架构的复杂性。但以此换来了系统水平的无限扩展能力,能够从容应对亿级流量。

2.4 成果与影响

通过静态化架构改造,淘宝商品详情系统取得了显著成效:

- 性能提升:系统响应时间从500ms降至20ms以下,用户体验得到质的飞跃。

- 容量与成本:服务器资源消耗减少80%,却支撑了2013年双11等大促活动,以更低的成本承载了更高的流量。

- 稳定性与可用性:系统可用性大幅提升,即使在后台应用服务器出现故障时,用户依然可以浏览商品的静态信息,实现了对后端系统的弱依赖,保证了核心浏览体验不中断。

淘宝大秒系统(秒杀架构)设计

2.1 现实层问题与挑战

1.瞬时流量洪峰:秒杀活动开始时,可能有100万用户同时抢购1万件商品,瞬时QPS(每秒查询率)极高,数据库和缓存系统面临被瞬间击穿的风险。

2.资源竞争与系统雪崩:大量请求同时竞争同一行数据库记录(如商品库存),导致严重的行锁竞争,数据库TPS(每秒事务处理量)下降,RT(响应时间)飙升,最终可能引发连锁反应,导致整个系统瘫痪。

3.公平性与欺诈防控:需要保证秒杀的公平性,防止恶意脚本和“秒杀器”大量囤积商品,损害普通用户利益。

2.2 技术层解决方案与实施

大秒系统的设计体现了极强的针对性和精巧性:

1.热点隔离:将秒杀系统与主站系统进行业务、系统和数据层面的彻底隔离。

- 独立部署:秒杀拥有独立的域名、集群和数据库(热点库),避免秒杀流量影响正常商品交易。

- 数据隔离:热点商品数据存放在独立的缓存和数据库集群中,防止其成为全局瓶颈。

2.动静分离与极致优化:同样采用动静分离。秒杀页面绝大部分内容(商品图片、描述等)被静态化并缓存到CDN和浏览器。用户真正点击“抢购”按钮时,只会发起一个很小的动态请求。

3.分层校验与请求削峰:这是一个核心设计理念,将大量无效请求在抵达数据库之前层层过滤掉,形成一个“漏斗”。

- 前端削峰:引入“答题验证”机制。用户需要先完成一个简单的验证操作才能下单。这不仅能有效防止秒杀器,更重要的是将一秒内的瞬时峰值流量拉长至10秒左右,极大平滑了请求曲线,为后端系统争取了处理时间。

- 后端分层校验:在请求链路的每一层进行校验:

1.前端/接入层:校验用户是否登录、请求频率是否过高等。

2.服务层:校验商品是否处于秒杀时段、用户是否有资格参与等。

3.数据库层:执行最终的库存扣减,保证数据强一致性。绝大多数请求在前几层就被拦截,最终到达数据库的写请求变得非常可控。

4.精准限流与熔断:在系统各个层面设置严格的限流阈值,一旦流量超过处理能力,果断丢弃多余请求,保护系统不被打垮。

2.3 逻辑层本质洞察与权衡

大秒系统的本质不是如何处理高并发,而是如何对稀缺资源(库存)进行公平、安全、高效的分配,同时防止分配过程压垮系统。

关键权衡:

- 一致性换可用性(读场景):在库存校验的早期阶段(如服务层),允许读取到有轻微延迟的库存数据(如通过本地缓存)。这可能导致少量用户看到有库存但最终下单失败,但保护了系统免于被实时强一致性校验压垮。最终在扣减时保证数据库层面的强一致性。

- 延迟换吞吐量:通过“答题”和“队列”引入人为延迟,牺牲了单个请求的响应速度,但换取了系统整体能处理的总请求量(吞吐量)的极大提升,避免了系统崩溃。

- 复杂度换公平性与安全性:引入答题、分层校验、规则引擎等复杂逻辑,增加了系统复杂度,但有效保障了公平性,防止了欺诈,确保了活动的健康运行。

2.4 成果与影响

淘宝大秒系统的设计已成为业界典范:

- 卓越性能:成功支撑了多次双11、小米手机秒杀等大型活动,创造了单机支撑30万QPS、下单减库存TPS达1500/s的纪录。

- 稳定性保障:通过隔离和削峰策略,确保了秒杀活动期间主站系统的平稳运行,实现了“1%的热点不影响99%的正常业务”。

- 业务价值:为平台和商家提供了强大的营销工具,创造了巨大的商业价值,同时通过技术手段保障了用户的公平参与感。

三、培养三层思维:架构师的自我修炼路径

架构师的成长绝非一蹴而就,而是一场贯穿职业生涯的思维升维之旅。它要求你系统性、分层次地锤炼三种核心思维:现实层(发现问题)、技术层(设计解决方案)、逻辑层(洞察本质与权衡)。

3.1 现实层(The "What" Layer)修炼:锤炼问题发现与定义能力

精准识别问题表象背后的本质诉求,避免被表面需求误导。

实践:

- 5Why分析法:对每一个问题持续追问“为什么”,直到触及根源。例如,页面加载慢(表象)→ 因为数据库查询慢(原因1)→ 因为未加索引(原因2)→ 因为表结构设计不合理(根本原因)。

- 用户旅程地图(User Journey Map):绘制用户完成关键操作(如下单、支付)的全流程,识别所有痛点、断点和体验瓶颈。

- 监控数据驱动:建立完善的监控体系(APM、日志、业务指标),学会从P99延迟、错误率、吞吐量等数据中发现问题线索,而不仅仅是依赖用户反馈。

产出:清晰的问题陈述文档,需包含现象、影响范围、初步根因假设。

3.2 技术层(The "How" Layer)修炼:扩充解决方案工具箱

掌握丰富的技术模式与组件,并能准确评估其适用性、优缺点和实现成本。

实践:

- 技术雷达扫描:定期研究行业主流及前沿技术(如通过Gartner报告、技术博客、开源项目),建立自己的技术评估矩阵。例如,对比Kafka与Pulson在消息顺序性、吞吐量、成本上的差异。

- 模式识别与积累:学习并总结架构模式(如微服务、事件驱动、CQRS)、设计模式(如工厂、策略、观察者)和反模式(如巨型服务、循环依赖)。尝试将业务需求映射到这些模式上。

- 深度源码分析:选择1-2个核心依赖的开源中间件(如Redis、RocketMQ),深入理解其核心原理、实现机制和性能边界。这能让你在技术选型和故障排查时更有底气。

产出:技术选型报告、架构设计图(UML/Archimate)、POC(概念验证)代码。

3.3 逻辑层(The "Why" Layer)修炼:洞察本质与权衡的艺术

超越具体技术,把握系统设计的第一性原理和核心权衡(Trade-offs),做出最优决策。

实践:

- 第一性原理思考:追问技术决策背后的物理学、经济学或数学原理。例如,缓存本质是用空间换时间,分布式本质是用网络开销换扩展性。

- 权衡矩阵训练:针对每个重要决策,刻意练习构建权衡矩阵。列出所有可选方案,并从性能、一致性、可用性、成本、复杂度、演进性等维度进行量化评分和取舍。例如,选择CP还是AP?自研还是采购?

- 案例复盘与抽象:深度复盘过往项目(尤其是失败案例),抽象出通用的教训和原则。思考:“如果重来一次,在逻辑层我会做出哪些不同的权衡?”

产出:架构决策记录(ADR)、包含权衡分析的方案评审文档、提炼出的设计原则。

结语:思维的高度决定架构的深度

淘宝从单一应用发展到支撑亿级并发的分布式系统,其演进历程揭示了技术成长的本质规律:技术本身日新月异,但底层逻辑相对稳定。三层思维模型提供了一套强大的认知工具,帮助架构师在技术浪潮中抓住不变的本质。

卓越架构师与普通工程师的关键区别,不在于掌握多少种中间件或编程语言,而在于能否运用分层思维穿透技术表象,洞察业务本质,在多重约束下做出最优权衡。这种思维层面的升维,是每一位技术人通往更高阶职业发展的必经之路。