【LLM微调2】

目录

- 分布式计算

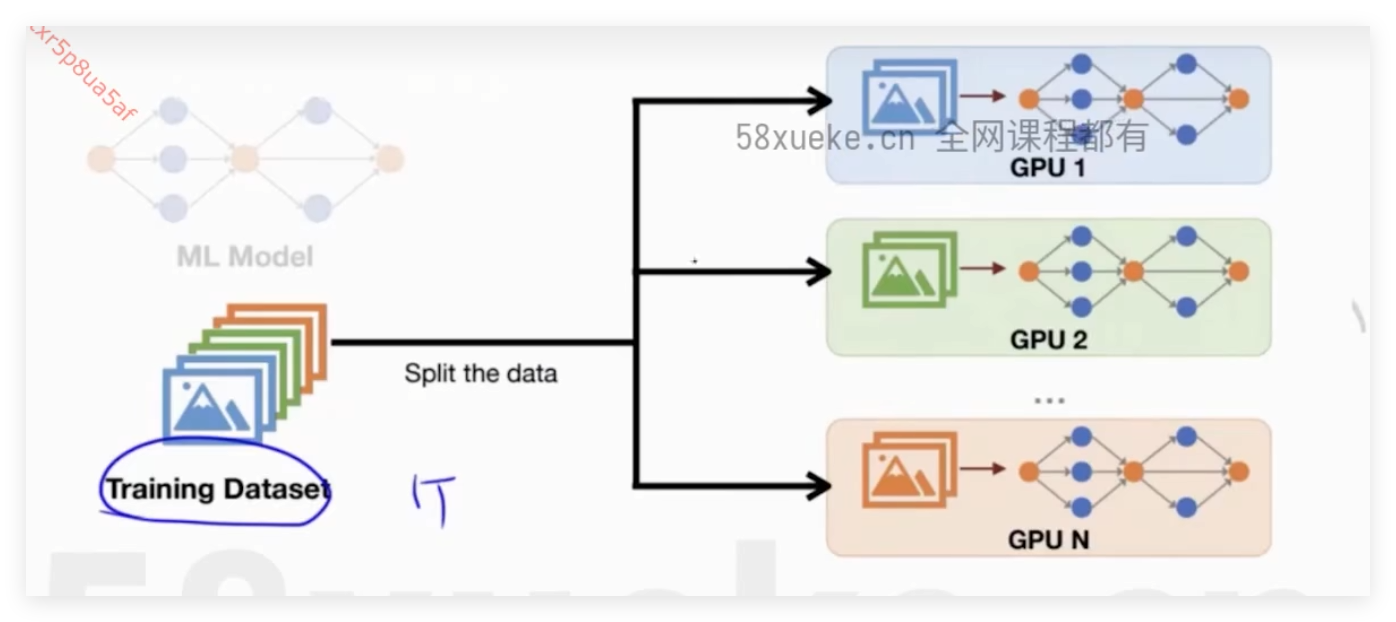

- Data Parallelism

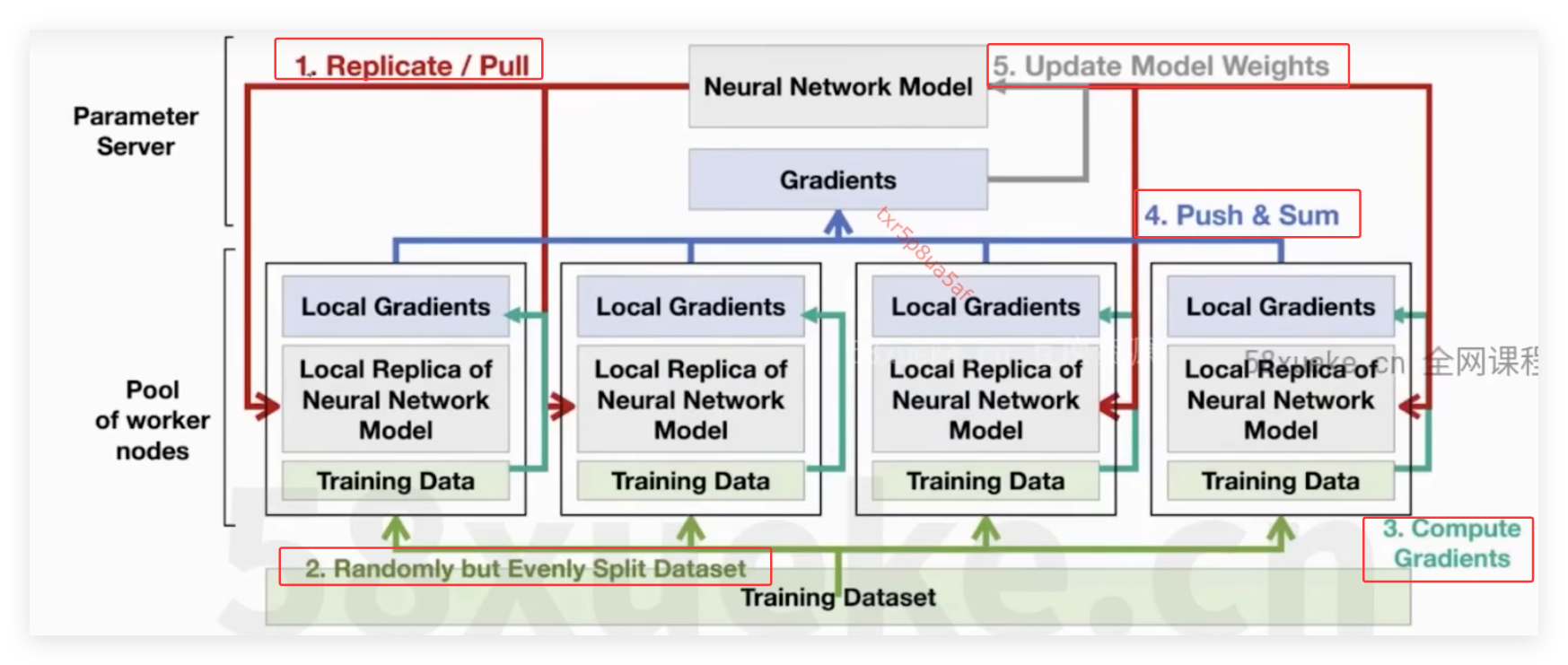

- Parameter server

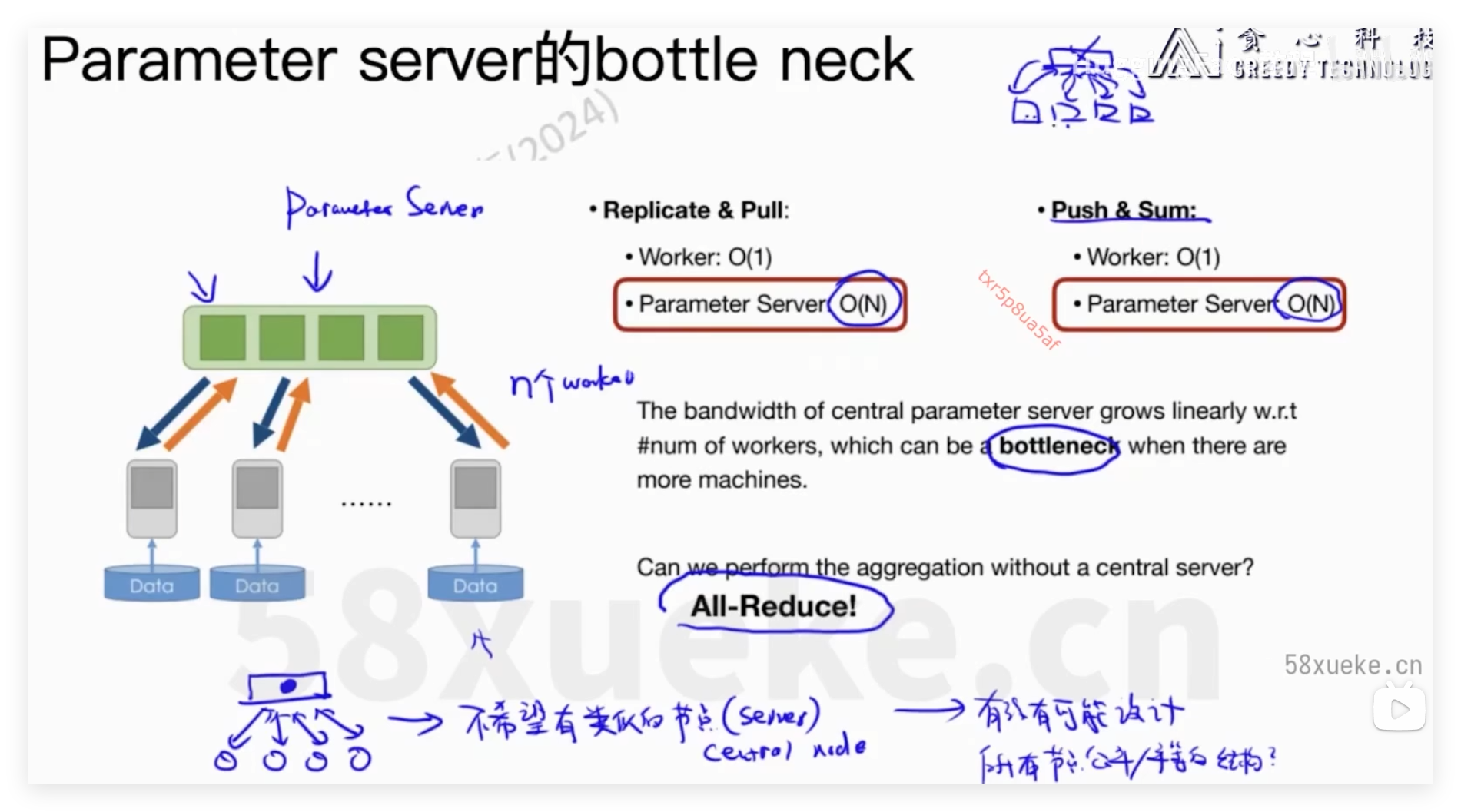

- Bottleneck problem

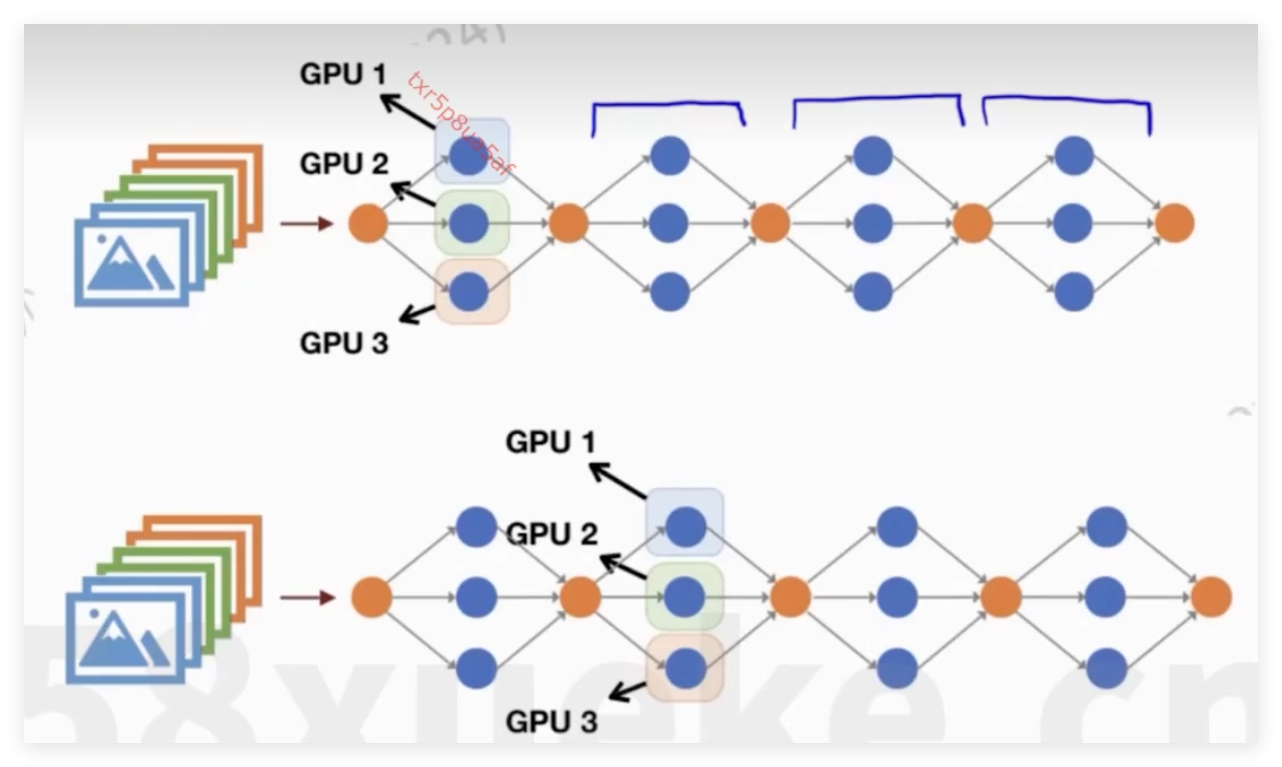

- Pipeline Parallelism

- Tensor Parallelism

分布式计算

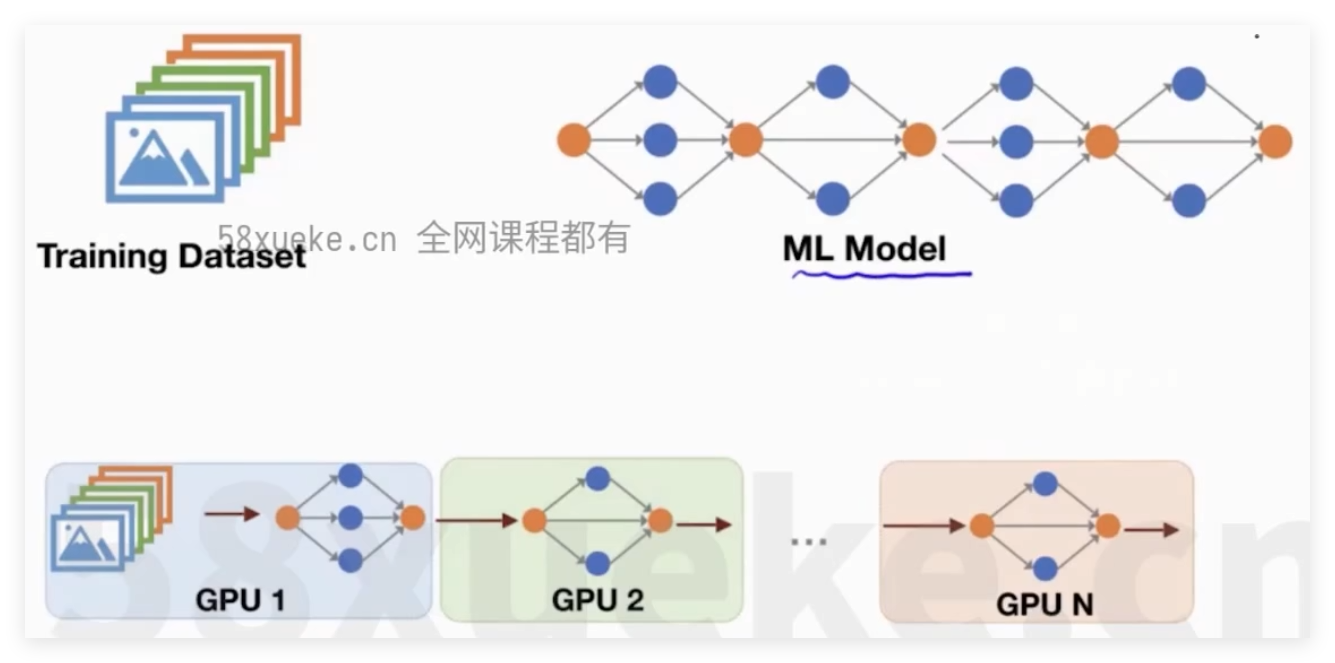

Data Parallelism

Parameter server

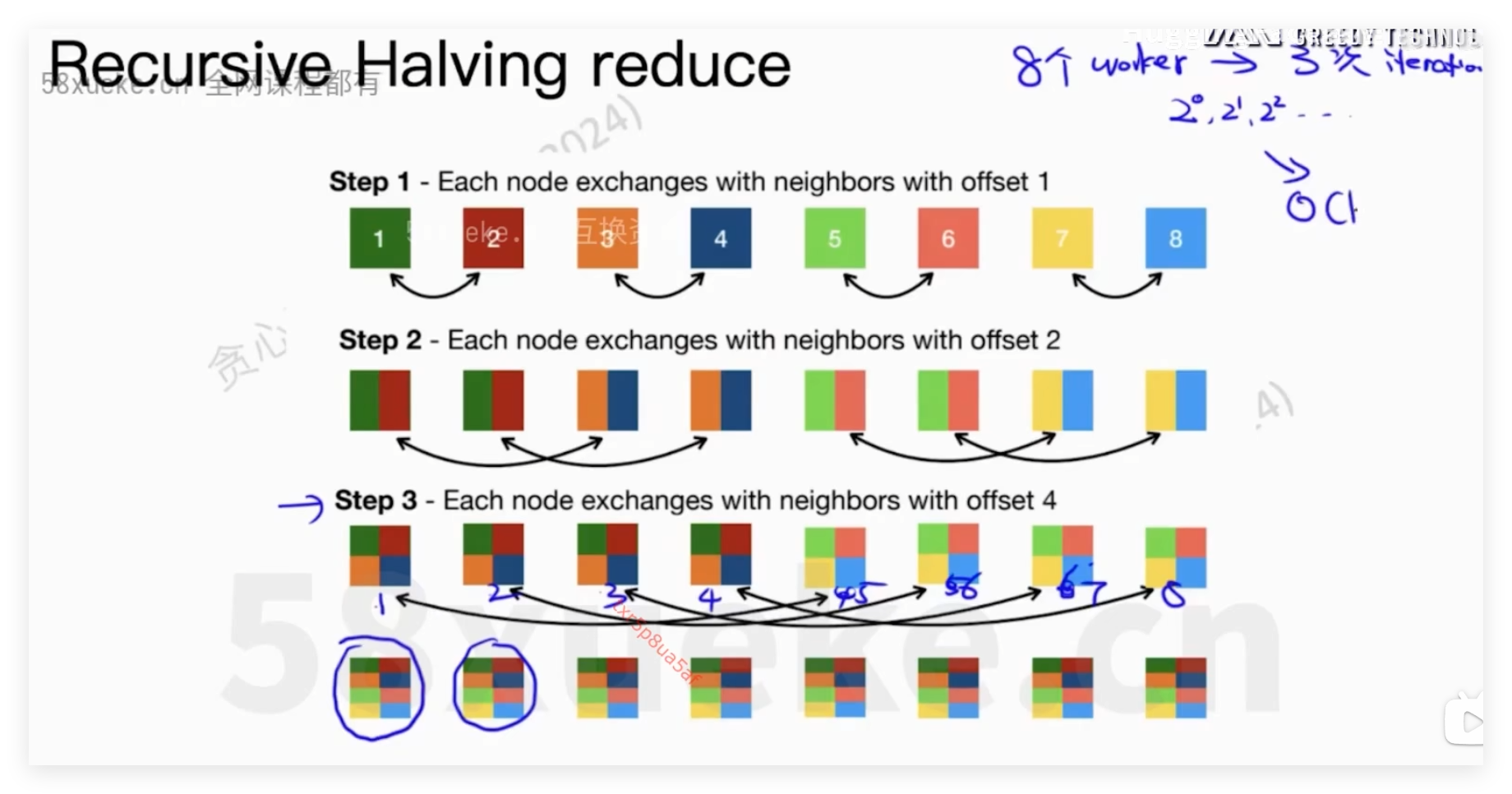

在worker和parameter server之间多次的数据沟通,communication的方式采取:reduce和broadcast方式

- reduce:即将多个worker的梯度结果进行整合,传输给parameter server;

- broadcast:parameter server将同样的梯度更新值传递给各worker

Bottleneck problem

| 瓶颈问题 | 描述 | 可能的影响 | 解决方案 |

|---|---|---|---|

| 通信开销 | 处理器之间同步梯度需要数据传输 | 增加训练时间,特别是在处理器数量多或网络带宽有限时 | 使用梯度压缩、减少同步频率、优化网络拓扑结构 |

| 梯度同步延迟 | 处理器完成梯度计算的时间不一致,导致等待最慢的处理器 | 降低并行效率,影响训练速度 | 异步梯度更新、动态调整负载 |

| 负载不均衡 | 处理器计算能力或内存容量差异导致计算任务完成时间不同 | 加剧梯度同步延迟,降低训练效率 | 动态负载平衡、使用更均匀的数据分割策略 |

| 内存限制 | 每个处理器需要存储模型的完整副本 | 限制了可训练模型的大小 | 模型并行、使用更高效的数据结构和算法 |

| 同步机制 | 确保所有处理器使用相同模型参数的同步操作 | 引入额外开销,尤其在处理器数量多时 | 减少同步次数、使用更高效的同步协议 |

Pipeline Parallelism

Tensor Parallelism