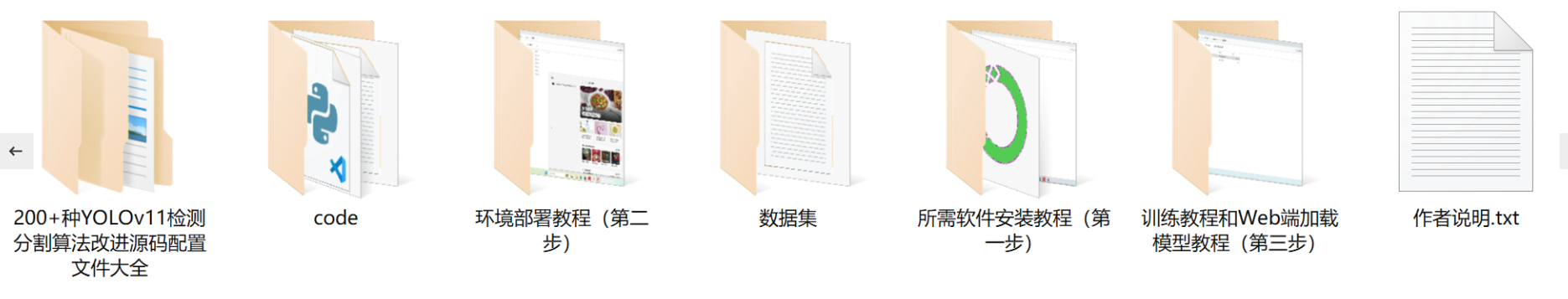

【完整源码+数据集+部署教程】广告牌实例分割系统源码和数据集:改进yolo11-dysample

背景意义

研究背景与意义

随着城市化进程的加快,广告牌作为一种重要的商业宣传媒介,广泛应用于城市的各个角落。广告牌不仅能够有效传达品牌信息,还能吸引路人的注意力,促进消费。然而,随着广告牌数量的增加,如何高效地管理和分析这些广告资源,成为了一个亟待解决的问题。传统的人工监测和管理方式效率低下,且容易出现遗漏和错误。因此,基于计算机视觉技术的广告牌实例分割系统应运而生,旨在通过自动化手段提高广告牌的识别和管理效率。

在这一背景下,YOLO(You Only Look Once)系列模型因其高效的实时检测能力而受到广泛关注。YOLOv11作为该系列的最新版本,进一步提升了检测精度和速度,适用于广告牌的实例分割任务。通过对YOLOv11模型的改进,结合针对广告牌特征的优化策略,可以实现对广告牌的精准定位和分割,为后续的数据分析和管理提供可靠的基础。

本研究基于一个包含2300张广告牌图像的数据集,旨在开发一个高效的广告牌实例分割系统。该数据集专注于单一类别的广告牌,经过精细标注,确保了模型训练的高质量。通过对数据集的深入分析和模型的不断优化,期望能够实现对广告牌的快速识别与分割,进而为广告投放效果评估、城市景观管理等应用提供支持。

总之,基于改进YOLOv11的广告牌实例分割系统不仅具有重要的学术研究价值,还有助于推动广告行业的智能化发展,为城市管理提供新的思路和工具。

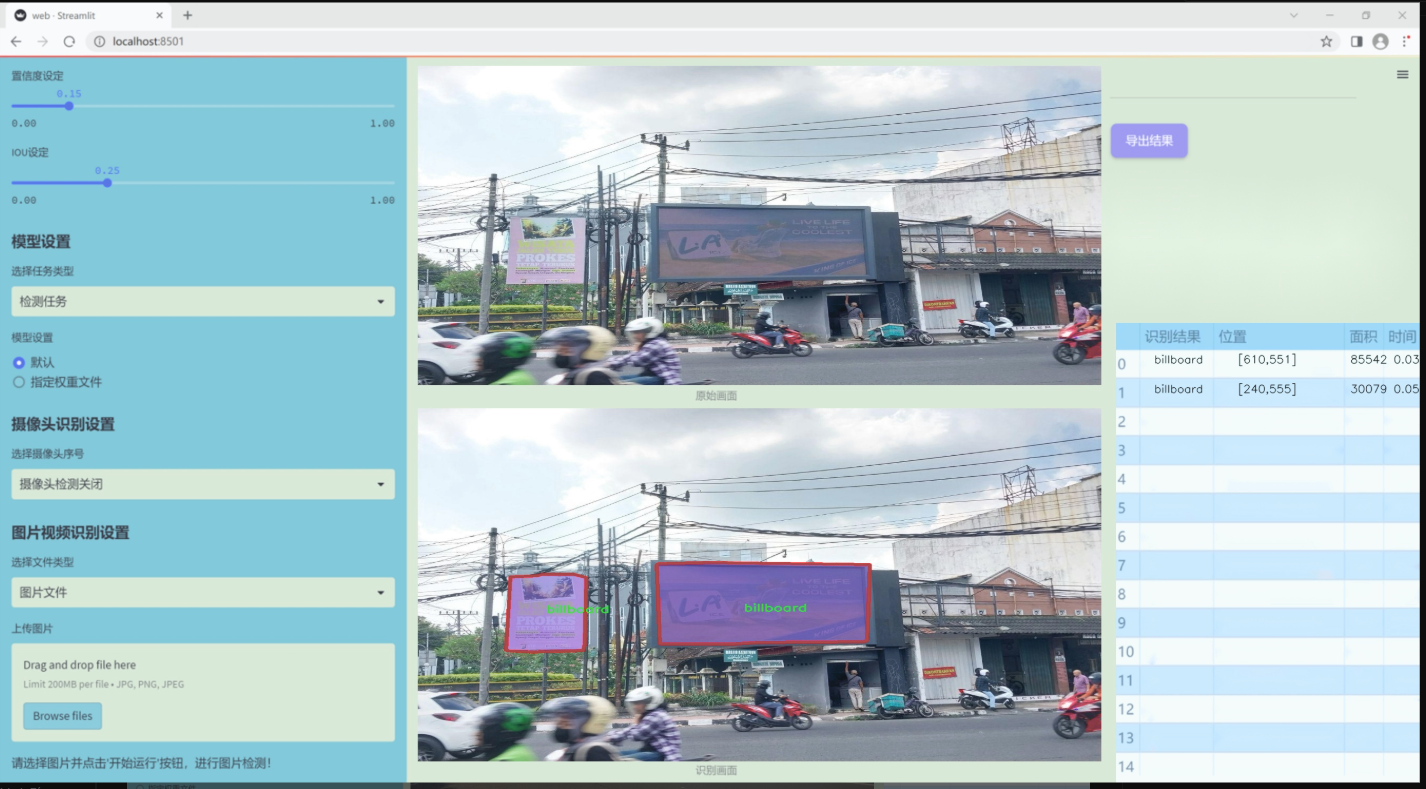

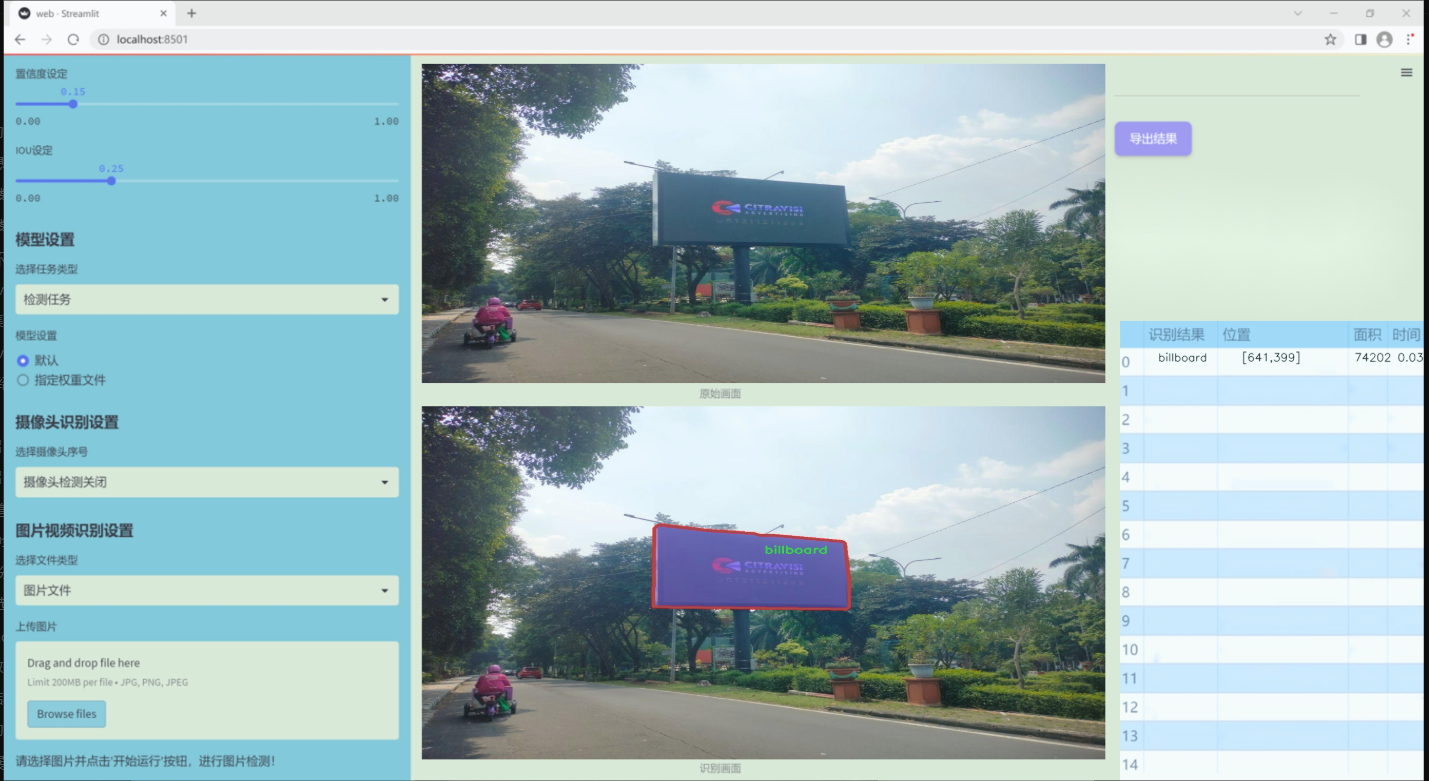

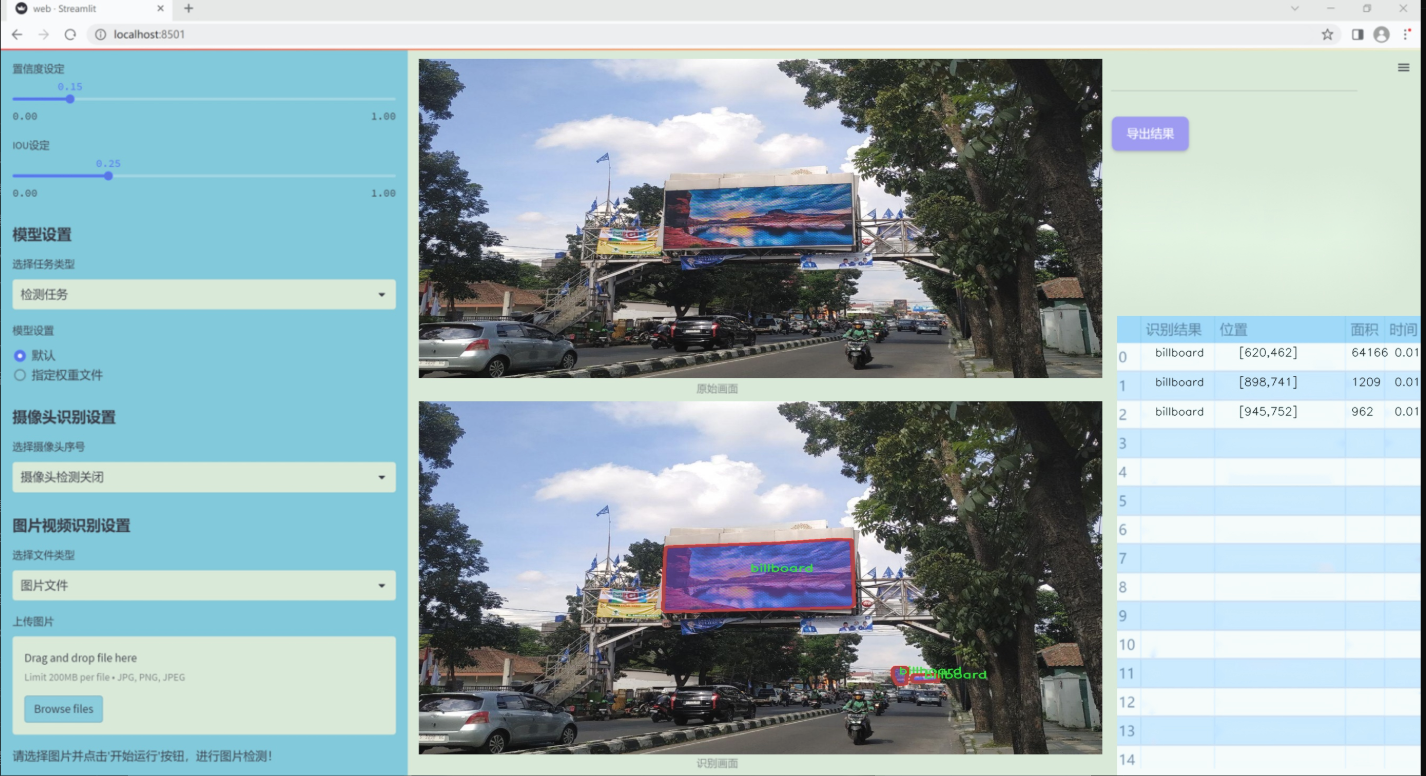

图片效果

数据集信息

本项目数据集信息介绍

本项目所使用的数据集专注于广告牌的实例分割,旨在为改进YOLOv11模型提供高质量的训练数据。该数据集的主题为“billboard-segmentation”,其设计目标是准确识别和分割图像中的广告牌,以提升计算机视觉系统在城市环境中的应用能力。数据集中包含的类别数量为1,唯一的类别名称为“billboard”,这表明该数据集专注于广告牌的检测与分割任务。

在数据集的构建过程中,收集了多种场景下的广告牌图像,包括城市街道、商业区、交通要道等多样化的环境。这些图像不仅涵盖了不同的光照条件和天气变化,还考虑了广告牌的各种形状、尺寸和风格,以确保模型能够在真实世界中表现出色。每张图像都经过精心标注,确保广告牌的边界框和分割掩码准确无误,为模型训练提供了可靠的基础。

此外,数据集的设计还考虑到了多样性和代表性,确保模型能够适应不同地区和文化背景下的广告牌特征。这种多样性不仅有助于提高模型的泛化能力,还能增强其在实际应用中的鲁棒性。通过使用这一数据集,研究人员希望能够推动广告牌检测技术的发展,最终实现更智能的城市环境监测和广告投放分析。

总之,本项目的数据集为改进YOLOv11的广告牌实例分割系统提供了丰富而高质量的训练数据,旨在提升模型在复杂场景中的表现,推动计算机视觉技术在广告领域的应用。

核心代码

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

import itertools

class Conv2d_BN(torch.nn.Sequential):

“”"

带有批归一化的卷积层

“”"

def init(self, in_channels, out_channels, kernel_size=1, stride=1, padding=0, dilation=1,

groups=1, bn_weight_init=1):

super().init()

# 添加卷积层

self.add_module(‘c’, torch.nn.Conv2d(

in_channels, out_channels, kernel_size, stride, padding, dilation, groups, bias=False))

# 添加批归一化层

self.add_module(‘bn’, torch.nn.BatchNorm2d(out_channels))

# 初始化批归一化的权重

torch.nn.init.constant_(self.bn.weight, bn_weight_init)

torch.nn.init.constant_(self.bn.bias, 0)

@torch.no_grad()

def switch_to_deploy(self):"""将模型切换到推理模式,合并卷积和批归一化层"""c, bn = self._modules.values()# 计算新的卷积权重和偏置w = bn.weight / (bn.running_var + bn.eps)**0.5w = c.weight * w[:, None, None, None]b = bn.bias - bn.running_mean * bn.weight / (bn.running_var + bn.eps)**0.5# 创建新的卷积层m = torch.nn.Conv2d(w.size(1) * self.c.groups, w.size(0), w.shape[2:], stride=self.c.stride, padding=self.c.padding, dilation=self.c.dilation, groups=self.c.groups)m.weight.data.copy_(w)m.bias.data.copy_(b)return m

class EfficientViTBlock(torch.nn.Module):

“”"

EfficientViT的基本构建块

“”"

def init(self, type, ed, kd, nh=8, ar=4, resolution=14, window_resolution=7):

super().init()

# 深度卷积和残差连接

self.dw0 = Residual(Conv2d_BN(ed, ed, 3, 1, 1, groups=ed, bn_weight_init=0.))

self.ffn0 = Residual(FFN(ed, int(ed * 2)))

if type == 's':# 使用局部窗口注意力self.mixer = Residual(LocalWindowAttention(ed, kd, nh, attn_ratio=ar, resolution=resolution, window_resolution=window_resolution))self.dw1 = Residual(Conv2d_BN(ed, ed, 3, 1, 1, groups=ed, bn_weight_init=0.))self.ffn1 = Residual(FFN(ed, int(ed * 2)))def forward(self, x):# 前向传播return self.ffn1(self.dw1(self.mixer(self.ffn0(self.dw0(x)))))

class EfficientViT(torch.nn.Module):

“”"

EfficientViT模型

“”"

def init(self, img_size=400, patch_size=16, in_chans=3, stages=[‘s’, ‘s’, ‘s’],

embed_dim=[64, 128, 192], key_dim=[16, 16, 16], depth=[1, 2, 3], num_heads=[4, 4, 4]):

super().init()

# 图像嵌入层self.patch_embed = torch.nn.Sequential(Conv2d_BN(in_chans, embed_dim[0] // 8, 3, 2, 1),torch.nn.ReLU(),Conv2d_BN(embed_dim[0] // 8, embed_dim[0] // 4, 3, 2, 1),torch.nn.ReLU(),Conv2d_BN(embed_dim[0] // 4, embed_dim[0] // 2, 3, 2, 1),torch.nn.ReLU(),Conv2d_BN(embed_dim[0] // 2, embed_dim[0], 3, 1, 1))# 构建各个阶段的块self.blocks1 = []self.blocks2 = []self.blocks3 = []for i, (stg, ed, kd, dpth, nh) in enumerate(zip(stages, embed_dim, key_dim, depth, num_heads)):for d in range(dpth):eval('self.blocks' + str(i + 1)).append(EfficientViTBlock(stg, ed, kd, nh))self.blocks1 = torch.nn.Sequential(*self.blocks1)self.blocks2 = torch.nn.Sequential(*self.blocks2)self.blocks3 = torch.nn.Sequential(*self.blocks3)def forward(self, x):# 前向传播outs = []x = self.patch_embed(x)x = self.blocks1(x)outs.append(x)x = self.blocks2(x)outs.append(x)x = self.blocks3(x)outs.append(x)return outs

创建模型实例

if name == ‘main’:

model = EfficientViT(img_size=224)

inputs = torch.randn((1, 3, 640, 640))

res = model(inputs)

for i in res:

print(i.size())

代码说明:

Conv2d_BN:定义了一个带有批归一化的卷积层,提供了一个方法用于将卷积和批归一化合并为一个卷积层以提高推理效率。

EfficientViTBlock:构建了EfficientViT的基本构建块,包含深度卷积、前馈网络和局部窗口注意力机制。

EfficientViT:整体模型的定义,包含图像嵌入层和多个构建块的组合,支持多种参数配置。

前向传播:在EfficientViT类中实现,逐层处理输入数据并返回多个输出。

这个程序文件 efficientViT.py 实现了一个高效的视觉变换器(Efficient Vision Transformer)模型架构,主要用于下游任务的图像处理。代码中包含了多个类和函数,构成了整个模型的结构。

首先,文件导入了必要的库,包括 PyTorch 及其相关模块,以及用于实现 Squeeze-and-Excitation(SE)机制的 timm 库。接着,定义了一些基础组件,例如 Conv2d_BN 类,它是一个包含卷积层和批归一化层的顺序容器。该类还实现了一个 switch_to_deploy 方法,用于在推理时将批归一化层的参数融合到卷积层中,以提高推理效率。

接下来,replace_batchnorm 函数用于替换模型中的批归一化层,将其替换为恒等映射,以减少推理时的计算开销。

PatchMerging 类用于将输入特征图的补丁合并,增强特征表达能力。它通过多个卷积层和激活函数进行处理,并引入了 Squeeze-and-Excitation 机制来进一步增强特征。

Residual 类实现了残差连接的功能,允许在训练时引入随机失活,以提高模型的鲁棒性。

FFN 类实现了前馈神经网络模块,包含两个卷积层和一个激活函数,用于特征的非线性变换。

CascadedGroupAttention 和 LocalWindowAttention 类实现了局部窗口注意力机制,允许模型在局部区域内进行自注意力计算,从而捕捉更细粒度的特征信息。

EfficientViTBlock 类是一个基本的 EfficientViT 构建块,结合了卷积、前馈网络和注意力机制。它根据指定的类型(如自注意力)选择相应的注意力机制,并通过残差连接进行信息传递。

EfficientViT 类是整个模型的核心,负责构建模型的各个层次结构。它接收图像大小、补丁大小、输入通道数等参数,并根据这些参数构建多个块(blocks),每个块由不同的层组成。模型的前向传播过程将输入图像逐层传递,最终输出多个特征图。

在文件的最后部分,定义了一些不同配置的 EfficientViT 模型(如 EfficientViT_m0 到 EfficientViT_m5),每个配置都包含不同的超参数设置。随后,提供了一些函数(如 EfficientViT_M0 等)用于创建这些模型,并可选择加载预训练权重和替换批归一化层。

最后,update_weight 函数用于更新模型的权重字典,以确保加载的权重与模型结构相匹配。主程序部分则展示了如何实例化一个模型并进行前向传播,输出特征图的尺寸。

整体而言,这个文件实现了一个灵活且高效的视觉变换器模型,适用于各种计算机视觉任务。

10.4 UniRepLKNet.py

以下是经过简化和注释的核心代码部分,主要包含了模型的定义和前向传播的实现。

import torch

import torch.nn as nn

import torch.nn.functional as F

class GRNwithNHWC(nn.Module):

“”"

全局响应归一化层 (Global Response Normalization)

输入假设为 (N, H, W, C) 格式

“”"

def init(self, dim, use_bias=True):

super().init()

self.use_bias = use_bias

self.gamma = nn.Parameter(torch.zeros(1, 1, 1, dim)) # 学习参数 gamma

if self.use_bias:

self.beta = nn.Parameter(torch.zeros(1, 1, 1, dim)) # 学习参数 beta

def forward(self, x):Gx = torch.norm(x, p=2, dim=(1, 2), keepdim=True) # 计算L2范数Nx = Gx / (Gx.mean(dim=-1, keepdim=True) + 1e-6) # 归一化if self.use_bias:return (self.gamma * Nx + 1) * x + self.beta # 应用归一化和偏置else:return (self.gamma * Nx + 1) * x # 应用归一化

class UniRepLKNetBlock(nn.Module):

“”"

UniRepLKNet的基本块

“”"

def init(self, dim, kernel_size, drop_path=0., deploy=False):

super().init()

self.dwconv = nn.Conv2d(dim, dim, kernel_size=kernel_size, stride=1, padding=kernel_size // 2, groups=dim, bias=True)

self.norm = nn.BatchNorm2d(dim) # 使用批归一化

self.se = SEBlock(dim, dim // 4) # Squeeze-and-Excitation块

self.pwconv1 = nn.Linear(dim, dim * 4) # 逐点卷积

self.act = nn.GELU() # 激活函数

self.pwconv2 = nn.Linear(dim * 4, dim) # 逐点卷积

self.drop_path = nn.Identity() if drop_path <= 0 else DropPath(drop_path) # 随机深度

def forward(self, inputs):""" 前向传播 """y = self.se(self.norm(self.dwconv(inputs))) # 通过深度卷积和归一化y = self.pwconv2(self.act(self.pwconv1(y))) # 逐点卷积和激活return self.drop_path(y) + inputs # 残差连接

class UniRepLKNet(nn.Module):

“”"

UniRepLKNet模型

“”"

def init(self, in_chans=3, num_classes=1000, depths=(3, 3, 27, 3), dims=(96, 192, 384, 768)):

super().init()

self.downsample_layers = nn.ModuleList() # 下采样层

self.stages = nn.ModuleList() # 各个阶段的块

# 构建下采样层self.downsample_layers.append(nn.Conv2d(in_chans, dims[0] // 2, kernel_size=3, stride=2, padding=1))for i in range(3):self.downsample_layers.append(nn.Conv2d(dims[i], dims[i + 1], kernel_size=3, stride=2, padding=1))# 构建各个阶段的UniRepLKNet块for i in range(4):stage = nn.Sequential(*[UniRepLKNetBlock(dim=dims[i], kernel_size=3) for _ in range(depths[i])])self.stages.append(stage)def forward(self, x):""" 前向传播 """for stage in self.stages:x = stage(x) # 通过每个阶段return x # 返回最后的输出

示例用法

if name == ‘main’:

inputs = torch.randn((1, 3, 640, 640)) # 随机输入

model = UniRepLKNet() # 创建模型

res = model(inputs) # 前向传播

print(res.shape) # 输出结果的形状

代码注释说明:

GRNwithNHWC: 实现了全局响应归一化层,主要用于对输入进行归一化处理。

UniRepLKNetBlock: 定义了UniRepLKNet的基本块,包含深度卷积、归一化、Squeeze-and-Excitation模块和逐点卷积。

UniRepLKNet: 定义了整个模型结构,包括下采样层和多个UniRepLKNet块的组合。

forward方法: 负责模型的前向传播,依次通过各个层和块进行计算。

该程序文件 UniRepLKNet.py 实现了一个名为 UniRepLKNet 的深度学习模型,主要用于音频、视频、点云、时间序列和图像识别。该模型基于多个现有的网络架构,如 RepLKNet、ConvNeXt、DINO 和 DeiT,结合了它们的优点,提供了一种通用的感知大核卷积网络。

文件中首先导入了必要的库,包括 PyTorch 和一些特定的模块。接着定义了一些辅助类和函数,如 GRNwithNHWC(全局响应归一化层)、NCHWtoNHWC 和 NHWCtoNCHW(用于通道格式转换的层)。这些类和函数为后续的模型构建提供了基础。

get_conv2d 函数用于根据输入参数决定使用哪种卷积实现,支持原生卷积和高效的 iGEMM 大核卷积实现。get_bn 函数则用于返回标准的批归一化层或同步批归一化层,后者适用于小批量数据的情况。

接下来,定义了 Squeeze-and-Excitation Block(SEBlock),它通过自适应平均池化和全连接层来调整通道的权重,从而增强模型的特征表达能力。fuse_bn 函数用于将卷积层和批归一化层融合,以提高推理速度。

DilatedReparamBlock 类实现了稀疏重参数化块,允许使用不同的卷积核和膨胀率组合,从而在保持模型性能的同时减少计算量。UniRepLKNetBlock 类则是 UniRepLKNet 的基本构建块,包含了深度卷积、归一化、SEBlock 和前馈网络等模块。

UniRepLKNet 类是整个模型的核心实现,构造了模型的各个层次,包括下采样层和多个阶段的 UniRepLKNetBlock。模型的输入通道数、类别数、每个阶段的深度和特征维度等参数可以通过构造函数进行设置。

模型的前向传播方法 forward 根据指定的输出模式(特征或 logits)处理输入数据。最后,提供了一些函数(如 unireplknet_a、unireplknet_f 等)用于实例化不同配置的 UniRepLKNet 模型,并加载预训练权重。

在文件的最后部分,包含了一个简单的测试代码,创建了一个随机输入并通过模型进行推理,展示了模型的基本功能。整体而言,该文件实现了一个灵活且高效的深度学习模型,适用于多种视觉和感知任务。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻