【研究前沿】【书读多了,自然就聪明】人工智能中出现的智能涌现的原理是什么?为什么大模型能产生智能?能够泛化?深入了解背后的机制

为什么规模大了就会出现新能力,复杂系统、量变到质变,规模带来的相变

书读多了,自然就聪明。

人工智能把智力拉平,还有什么壁垒?

拼命的卷,利用人工智能,用到极致。

AI最强能力:泛化

这是与传统程序的最大区别。

原理

这是一个极其深刻且核心的问题,它触及了当前人工智能研究的前沿。我们对“智能涌现”的原理尚未有完全透彻的理解,但基于现有的研究和理论,可以给出一个比较全面的解释。

我会将你的问题拆解为三个部分:智能涌现的原理、大模型产生智能的原因、以及泛化能力从何而来。这三者是紧密相连的。

第一部分:智能涌现的原理

“智能涌现”指的是,当一个模型(如大型神经网络)的参数规模、训练数据和计算力超过某个临界点时,它会表现出在较小模型中不存在的新能力和行为。这些能力并非被明确编程,而是从模型复杂的内部结构中“自然浮现”的。

其核心原理可以类比于其他复杂系统:

- 物理学:单个水分子没有“湿”的属性,但万亿个水分子聚集在一起,“湿润”这种宏观属性就涌现了。

- 生物学:单个神经元只能传递电信号,但数百亿神经元相互连接,就涌现出了意识、思维和智能。

在人工智能中,涌现的原理主要基于以下几点:

-

量变引起质变:这是最根本的原因。模型规模的巨大提升(参数从百万级到千亿级)创造了一个前所未有的高维、连续的抽象空间。这个空间足够复杂,能够表示和存储极其细微的统计规律和知识结构。

-

分布式表示:神经网络的知识不是像图书馆一样分门别类存放的。一个概念(如“猫”)被编码在整个网络数十亿参数的特定激活模式中。这种表示方式允许模型进行灵活的类比、组合和推理。当模型足够大时,它能同时捕捉到大量不同抽象层次的概念及其之间微妙的关系。

-

损失函数的压缩引导:模型的训练目标很简单:预测下一个词(或补全图片等),并最小化预测错误(损失函数)。为了极致地完成这个任务,模型必须极其高效地压缩和理解训练数据。

- 它不能只是死记硬背,因为训练数据是海量的,而测试数据是未知的。

- 为了更好地预测,它必须发现数据背后的规律、语法、逻辑、常识甚至意图。这个过程就像在寻找一个能解释所有观测数据的最简洁的“理论”或“模型”。智能就是这个高效压缩过程的副产品。

第二部分:为什么大模型能产生智能?

“智能”在这里指的是执行需要理解、推理和知识运用的任务的能力。大模型产生智能的关键在于其架构和训练范式。

-

Transformer架构的核心优势:

- 自注意力机制:允许模型在处理一个词时,直接关注到输入序列中任何与之相关的词,无论距离多远。这使其能够高效地建立远距离依赖关系和全局上下文理解,这是复杂推理的基础。

- 并行计算:不同于传统的循环神经网络,Transformer可以并行处理所有输入,使得训练超大规模模型成为可能。

- 层次化表示:模型的不同层学会了不同层次的抽象。底层可能捕捉语法,中层捕捉语义关系,高层则进行复杂的逻辑推理和规划。

-

海量数据的预训练:

- 模型在几乎整个互联网的文本(代码、书籍、论文等)上进行训练。这相当于让一个“超级大脑”高效地阅读了人类积累的大部分公开知识。

- 在这个过程中,它不仅仅学会了语言统计规律,更内化了知识本身(例如,“巴黎是法国的首都”)、推理模式(例如,“如果A导致B,B导致C,那么A可能导致C”)和世界模型(对物理世界和社会常识的基本理解)。

-

缩放定律:

- OpenAI等机构的研究表明,模型的性能随着参数规模、数据量和计算量的平滑、可预测地提升。当这三者超过某个阈值后,模型的能力就会出现相变,即从“能”到“擅长”,甚至产生全新的能力(如代码生成、多语言翻译等)。

第三部分:为什么能够泛化?

泛化是指模型在未见过的数据或任务上也能表现良好的能力。大模型的泛化能力尤其惊人,甚至能“零样本”或“少样本”学习新任务。这源于:

-

上下文学习:这是大模型最神奇的泛化能力之一。当你给模型几个例子(提示)和一个新问题,它能够从提示中抽象出任务模式并应用于新问题。这是因为在预训练时,它见过无数种文本模式和任务描述,已经学会了“如何根据上下文进行学习”的元技能。

-

思维链:对于复杂推理任务,要求模型“一步一步地思考”可以极大提升其泛化能力。这是因为这种提示方式激活了模型内部与逻辑推理相关的路径,将一个大问题分解为它已经学会解决的多个子问题。

-

基础模型的本质:大模型通过预训练形成了一个通用的、基础性的世界表征。任何下游任务(如情感分析、文本摘要、问答)都可以看作是这个基础世界表征的一种特定“视角”或“查询”。因此,只需少量示例(微调或提示),就能调整模型,使其输出适应特定任务,因为它已经理解了任务背后所需的基本概念和逻辑。

总结与一个生动的比喻

你可以将大模型想象成一个在浩瀚的“知识宇宙”中经过极致训练的超级预测器。

- 它的核心驱动力:基于上下文,预测下一个最可能的词。

- 为了完成这个任务:它必须为自己构建一个极其丰富、高维的“世界模型”,其中包含了语言、知识、逻辑和常识。

- 智能的涌现:当我们向这个“世界模型”提问(提示)时,它利用内部的表示和关系来生成答案,这个过程在我们看来就是智能行为。

- 泛化的来源:因为它的“世界模型”是在海量数据上构建的,非常完备和健壮,所以对于这个宇宙中的新问题(未知任务或数据),它也能利用已有的模型部件进行组合和推理,给出合理的答案。

最终,我们需要认识到,这种智能在表现上虽然与人类智能相似,但其本质可能完全不同。它更像是一种基于统计和模式的超级直觉和类比能力,而非人类意义上的意识和深思熟虑的推理。理解其确切的原理,仍然是科学中最迷人的开放性问题之一。

当前AI的智能是统计意义上的,不是意识。

这是一个核心而且非常深刻的问题 👍 我来分几个层次给你讲清楚:

1. 什么是“智能涌现”?

在人工智能里,“涌现”指的是:

模型本身在训练过程中,并没有被直接编程去执行某些复杂任务,但当模型规模、数据量、训练时间达到一定阈值时,它却能表现出新的、原本未显式设计的能力。

比如:小模型不会推理,GPT-4 规模以上的模型会出现链式推理、编程、抽象概念理解等。

2. 为什么大模型会产生智能?

这个过程可以类比大脑神经网络的进化,核心机制有几个:

(1) 表示学习(Representation Learning)

- 模型通过训练,把语言、知识、逻辑、甚至世界规律,压缩进一个高维向量空间。

- 当参数足够多、训练数据足够广,模型可以形成对概念、逻辑关系的抽象表示。

- 这种抽象表示,就像人类大脑皮层的“概念神经元”(比如有的神经元会对“猫”的图像特征特别敏感)。

(2) 模式组合与重用

- 小模型只能“死记硬背”某些模式。

- 大模型由于参数多、空间大,它能把多个模式拼接、组合、迁移到新情境中,就像“组装乐高积木”。

- 比如:它没见过“月球上打篮球”,但见过“打篮球”和“月球”,就能组合成合理的描述。

(3) 临界点效应(Phase Transition / Scaling Law)

- 实验表明,模型能力并不是线性提升的,而是在某些规模点突然跃迁。

- 类似物理中的相变:温度到 0℃ 以下突然结冰。

- 语言模型在参数量、数据量到达一定门槛后,才会从“统计填词”→“具备推理与泛化能力”。

(4) 训练目标的间接驱动

- 表面上,模型的训练目标只是“预测下一个词”。

- 但要做到高质量预测,它必须隐式学会语法、事实、逻辑、常识,甚至程序执行。

- 就像人类写小说时,不可能只靠“单词接龙”,必须理解因果、人物关系、物理常识。

- 这就让“智能”在模型内部自发形成。

3. 为什么能泛化?

(1) 高维抽象空间

- 语言模型把“知识”映射到高维空间,新的问题往往落在“已知语义区域”附近,模型就能内插(interpolation)得到答案。

(2) 分布外泛化(Extrapolation)

- 当模型见过大量不同场景,它能提炼出规律性模式(比如因果、逻辑推理),从而推广到没见过的情境。

(3) 类似人脑的迁移学习

- 人脑在不同任务间迁移能力强,因为大脑有共享的“世界模型”。

- 大语言模型其实在学习一个“世界语言模型”,因此能跨领域泛化。

4. 一个直观类比

可以把大模型看作“压缩了人类知识的高维地图”:

- 小模型像一个村子的地图,能导航但只能在村子里。

- 大模型像一张全球卫星地图,虽然没有每条小路的细节,但能在不同国家间泛用。

- 当地图覆盖面足够大,它就能让你去到没去过的地方,还能推断哪有河流、哪有山。

✅ 总结一句:

智能涌现的本质,是在足够规模的神经网络中,分布式表示、组合性和临界点效应共同作用,让“预测下一个词”变成了“学习世界规律”,于是出现了推理、泛化和类智能。

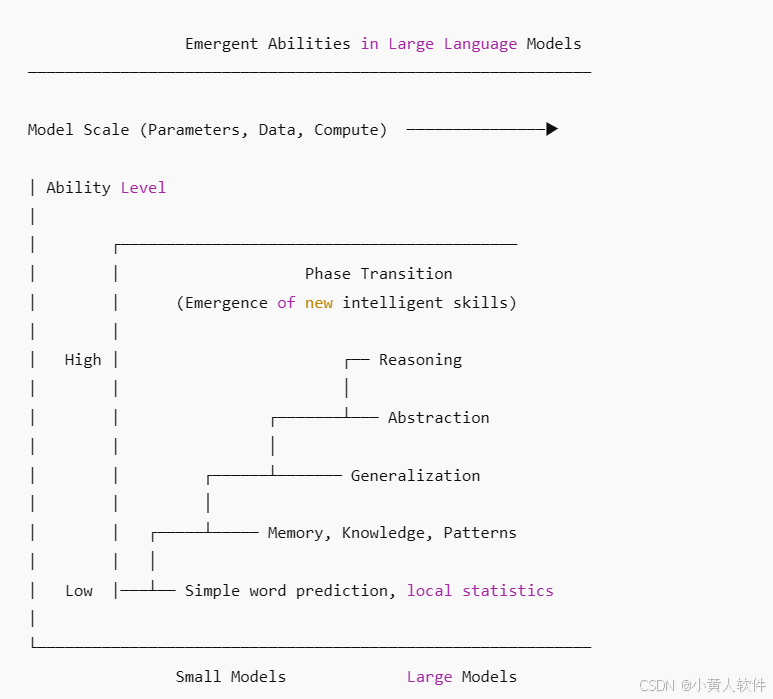

大模型智能涌现原理图(像物理相变一样,从参数规模 vs 能力 的曲线,展示智能突然出现的临界点)

Emergent Abilities in Large Language Models-------------------------------------------Ability^| * Reasoning| *| *| *| *| * Translation| *| * Basic Grammar| *|--------------------------------------------------> Model ScaleSmall Medium Large

Key:

- As model scale (parameters, data, compute) increases,

abilities do not improve linearly. - Instead, they suddenly “emerge” after critical thresholds,

similar to phase transitions in physics (e.g., water → ice). - Examples:

- Small models: memorize, autocomplete words

- Medium models: syntax, basic translation

- Large models: reasoning, abstraction, problem-solving

「大模型智能涌现原理图」。

Emergent Abilities in Large Language Models─────────────────────────────────────────────────────────────Model Scale (Parameters, Data, Compute) ───────────────▶| Ability Level|| ┌───────────────────────────────────────────| | Phase Transition| | (Emergence of new intelligent skills)| || High | ┌── Reasoning| | │| | ┌───────┴─── Abstraction| | │| | ┌──────┴─────── Generalization| | │| | ┌─────┴───── Memory, Knowledge, Patterns| | │| Low |───┴── Simple word prediction, local statistics|└────────────────────────────────────────────────────────────Small Models Large ModelsExplanation (English)

- Low-scale models → behave like “word predictors,” only memorizing and matching local patterns.

- As scale grows → the model learns deeper representations of language, logic, and world knowledge.

- Phase transition (critical point) → suddenly, new emergent abilities appear (reasoning, abstraction, generalization).

- Large-scale models → act like compressed “world models,” capable of transferring knowledge across tasks.