Linux Tun/Tap 多队列技术

🔥 Linux Tun/Tap 多队列技术

引用:Linux tun/tap 驱动多队列模式(C/C++)

📖 引言

Tun/Tap 是 Linux 内核提供的虚拟网络设备,广泛应用于 VPN、虚拟化、网络隧道等领域。传统单队列模式在高吞吐量场景下存在性能瓶颈,多队列模式(Multiqueue)通过并行处理机制显著提升性能。本文将深入分析多队列 Tun/Tap 的技术原理、性能特征和编程实践。

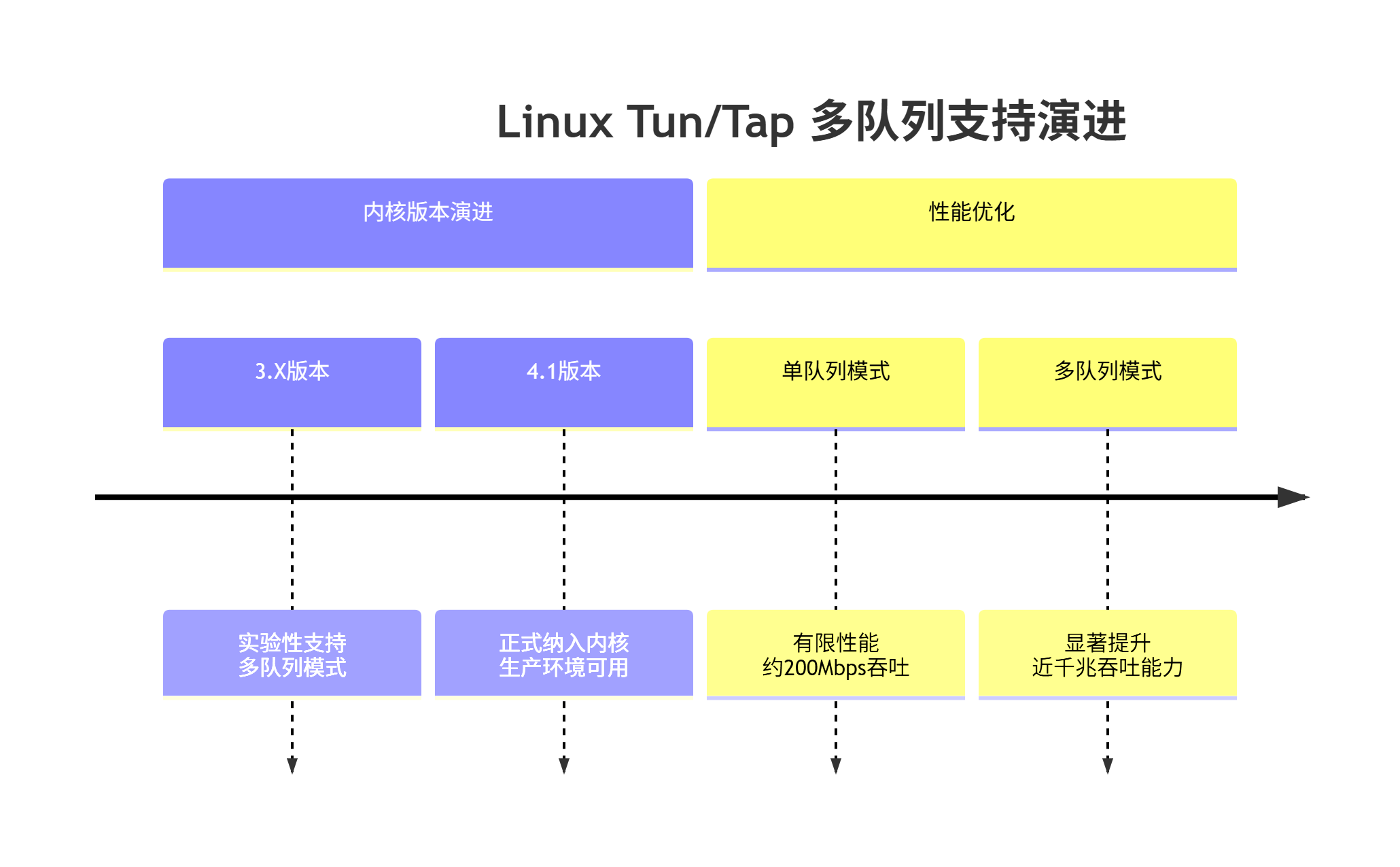

📊 技术演进历程

🏗️ 架构对比分析

传统单队列模式

多队列模式

⚡ 性能特征分析

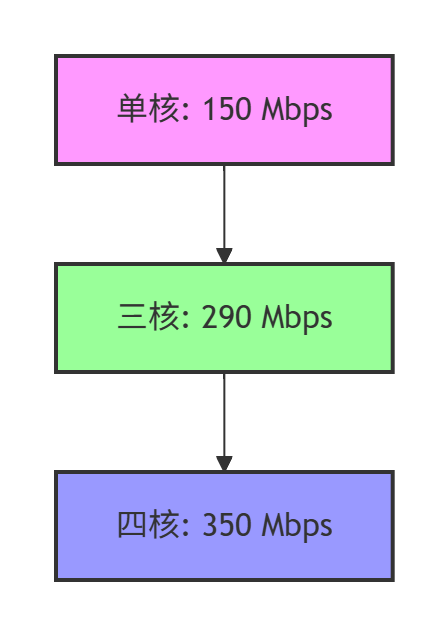

基于玩客云S805芯片的实测数据(运行AES-256-GCM/CFB加密算法):

性能关键发现:

- 多队列模式下性能随核心数增加而提升

- 加密算法消耗大量计算资源

- 三核达到峰值290Mbps,四核因架构限制反而下降

- 与内核直接处理相比约有5倍性能差距

🛠️ 核心实现代码详解

/*** 打开多队列Tun/Tap设备驱动* @param ifrName 设备名称格式(如"tun%d")* @return 文件描述符,失败返回-1*/

int TapLinux::OpenDriver(const char* ifrName) noexcept {// 检查设备名称参数,为空时使用默认值if (NULL == ifrName || *ifrName == '\x0') {ifrName = "tun%d";}// 设置打开文件的标志位// O_RDWR: 可读写模式// O_NONBLOCK: 非阻塞模式int __open_flags = O_RDWR | O_NONBLOCK;// 如果系统支持O_CLOEXEC,添加此标志// O_CLOEXEC: 执行exec()时自动关闭文件描述符

#if defined(O_CLOEXEC)__open_flags |= O_CLOEXEC;

#endif// 尝试打开Tun/Tap设备文件int tun = open("/dev/tun", __open_flags);if (tun == -1) {// fallback: 尝试另一种设备路径tun = open("/dev/net/tun", __open_flags);if (tun == -1) {return -1; // 全部失败,返回错误}}// 设置文件描述符为非阻塞模式Socket::SetNonblocking(tun, true);// 设置执行时关闭(close-on-exec)标志ppp::unix__::UnixAfx::set_fd_cloexec(tun);// 准备网卡接口请求结构体struct ifreq ifr;memset(&ifr, 0, sizeof(ifr)); // 清零初始化// 设置设备名称,IFNAMSIZ定义最大接口名称长度strncpy(ifr.ifr_name, ifrName, IFNAMSIZ);// 多队列模式设置

#if defined(IFF_MULTI_QUEUE)// 设置标志位:// IFF_TUN: 创建TUN设备(三层IP数据包)// IFF_NO_PI: 不提供包信息头// IFF_MULTI_QUEUE: 启用多队列模式ifr.ifr_flags = IFF_TUN | IFF_NO_PI | IFF_MULTI_QUEUE;// 尝试设置多队列模式bool fails = ioctl(tun, TUNSETIFF, &ifr) < 0;if (fails) {// 多队列模式失败,回退到单队列模式ifr.ifr_flags = IFF_TUN | IFF_NO_PI;fails = ioctl(tun, TUNSETIFF, &ifr) < 0;}

#else// 系统不支持多队列,使用单队列模式ifr.ifr_flags = IFF_TUN | IFF_NO_PI;bool fails = ioctl(tun, TUNSETIFF, &ifr) < 0;

#endifif (fails) {// 设备配置失败,清理并返回错误::close(tun);return -1;} else {// 成功打开并配置Tun/Tap设备return tun;}

}

📋 多队列关键技术特性

- 🔁 重复打开能力 - 多队列模式下可重复打开相同Tun/Tap网卡

- 🎯 随机包分发 - 每个句柄随机接收内核派发的数据包(无主从关系)

- 📡 事件监听支持 - 每个Tun/Tap设备句柄可被epoll监听读写事件

- ⚙️ 阻塞模式配置 - 每个句柄可独立设置为阻塞或非阻塞模式

- 📤 并行写入能力 - 每个句柄都可单独向内核写入IP数据包

🚀 高性能编程实践

优化线程模型

重要实践建议

- 避免跨线程操作 - 内核加锁机制导致跨线程读写性能急剧下降

- 专用IO线程 - 每个队列使用专用线程进行处理,读写同线程

- 非阻塞模式设置 - 所有句柄应设置为非阻塞模式

- Epoll结合使用 - 读操作结合epoll进行事件驱动处理

- 直接写入优化 - 写操作直接调用write,无需epoll监听

🧩 关键技术细节

写入特性说明

Tun/Tap驱动的写入操作(tun_write函数)具有以下特性:

- 无视非阻塞设置:写操作总是立即执行,不会阻塞

- 不存在丢包:直接调用内核驱动,无需缓冲

- 内核内部处理:所有写操作最终都由内核网络栈处理

性能差距因素

与传统内核网络处理相比,Tun/Tap存在约5倍性能差距的主要原因:

- 用户空间与内核空间上下文切换

- 数据拷贝开销(缺乏零拷贝机制)

- 系统调用频率较高

- 加密解密计算负担(如AES-256-GCM)

🎯 结论

Linux多队列Tun/Tap技术从内核4.1开始提供生产级支持,通过并行处理机制显著提升虚拟网络设备吞吐性能。正确实现多队列需要遵循专用线程模型、避免跨线程操作、合理使用非阻塞IO和epoll事件机制。

虽然与DPDK的零拷贝方案相比仍有性能差距,但多队列Tun/Tap提供了良好的平衡:在保持操作系统网络栈完整功能的同时,显著提升了吞吐量性能,是VPN、隧道代理等应用的优选方案。

最佳实践:在多核处理器环境下,为每个队列配置专用IO线程,结合epoll实现高效事件驱动,可最大化发挥多队列Tun/Tap的性能潜力。