上海交大具身导航中的感知智能、社会智能和运动智能全面综述

- 作者:Chaoran Xiong1^{1}1, Yulong Huang2^{2}2, Fangwen Yu3^{3}3, Changhao Chen4^{4}4, Yue Wang5^{5}5, Songpengchen Xia1^{1}1, Ling Pei1^{1}1

- 单位:1^{1}1上海交通大学,2^{2}2哈尔滨工程大学,3^{3}3清华大学,4^{4}4香港科技大学(广州),5^{5}5浙江大学

- 论文标题:Sensing, Social, and Motion Intelligence in Embodied Navigation: A Comprehensive Survey

- 论文链接:https://arxiv.org/pdf/2508.15354v1

- 项目主页:https://github.com/Franky-X/Awesome-Embodied-Navigation

主要贡献

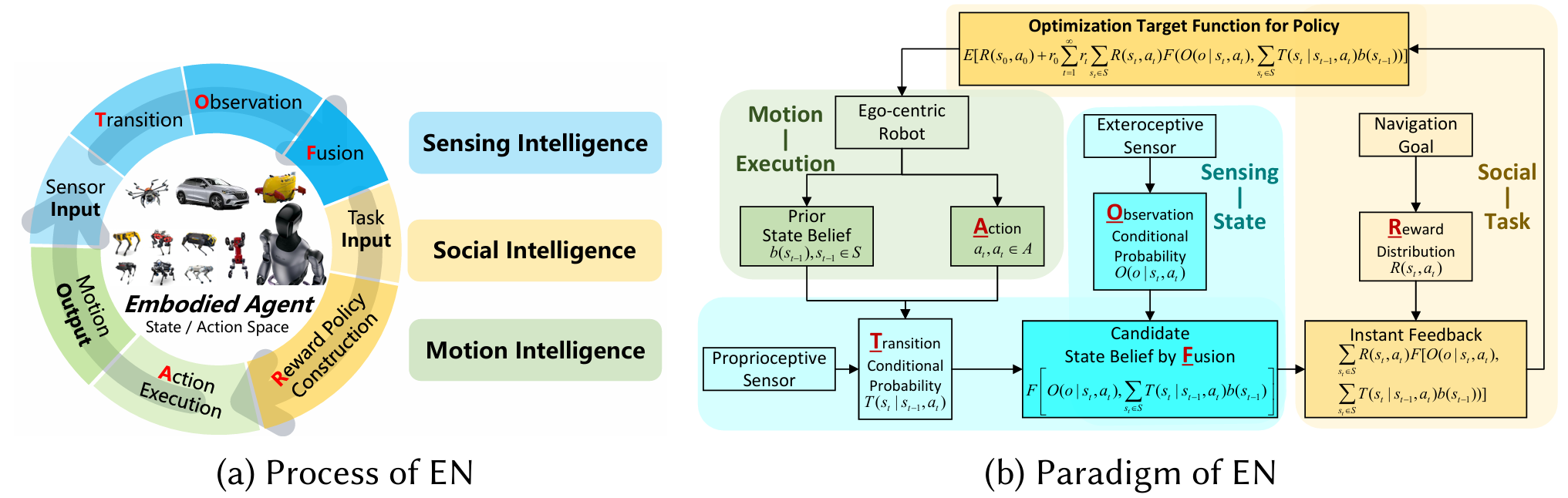

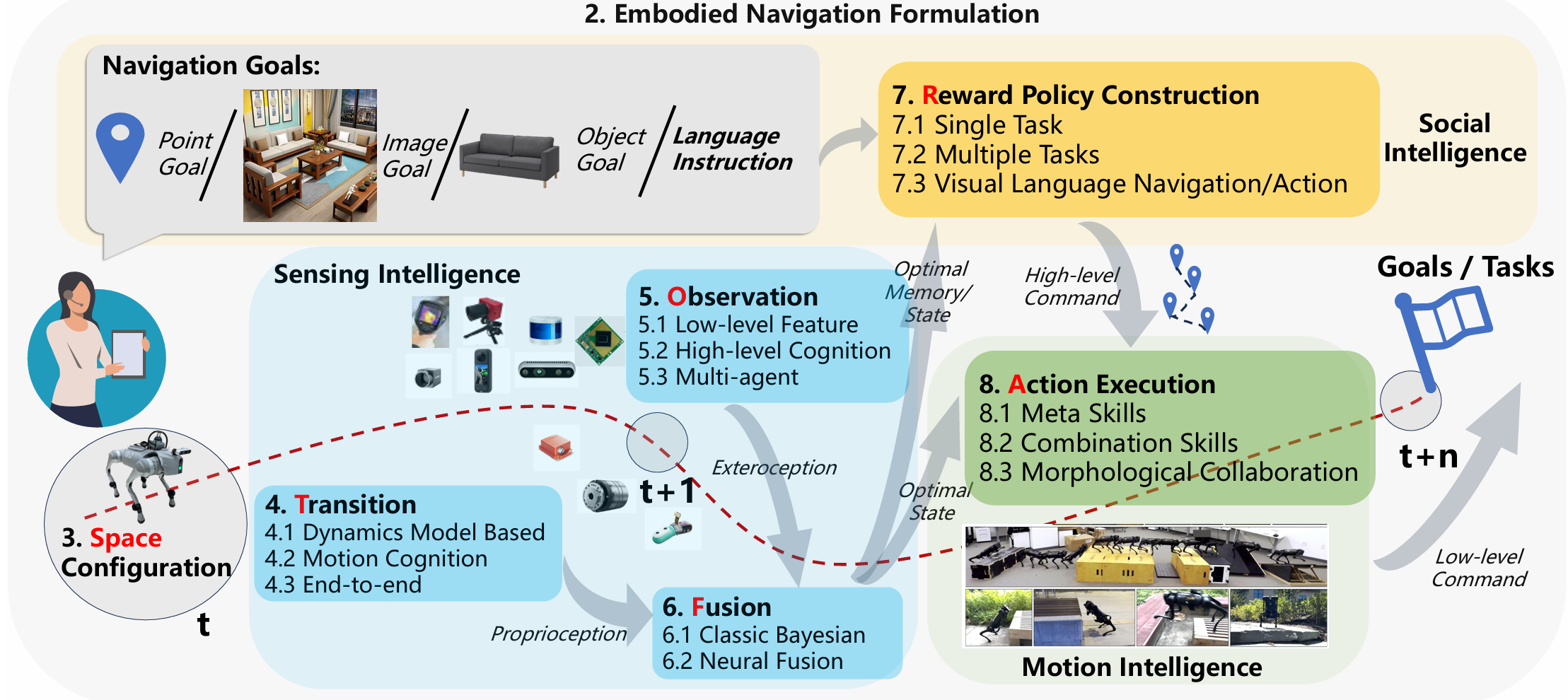

- 提出TOFRA框架:将具身导航过程分解为五个关键阶段——状态转移、环境观测、信息融合、奖励策略构建和动作执行,为具身导航研究提供了统一的结构化分析框架。

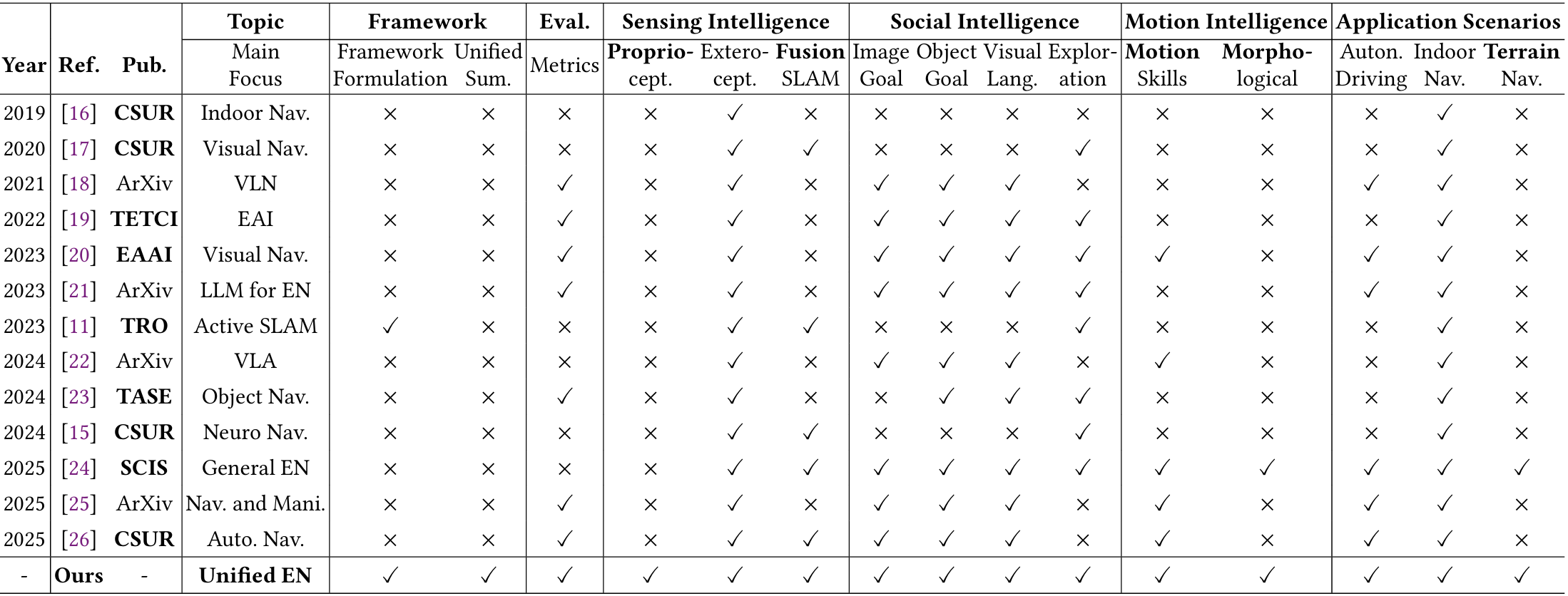

- 首次系统性地整合了计算机视觉、经典机器人和仿生学三大领域在具身导航方面的研究成果,揭示了各领域在感知智能、社交智能和运动智能三个维度上的互补性。

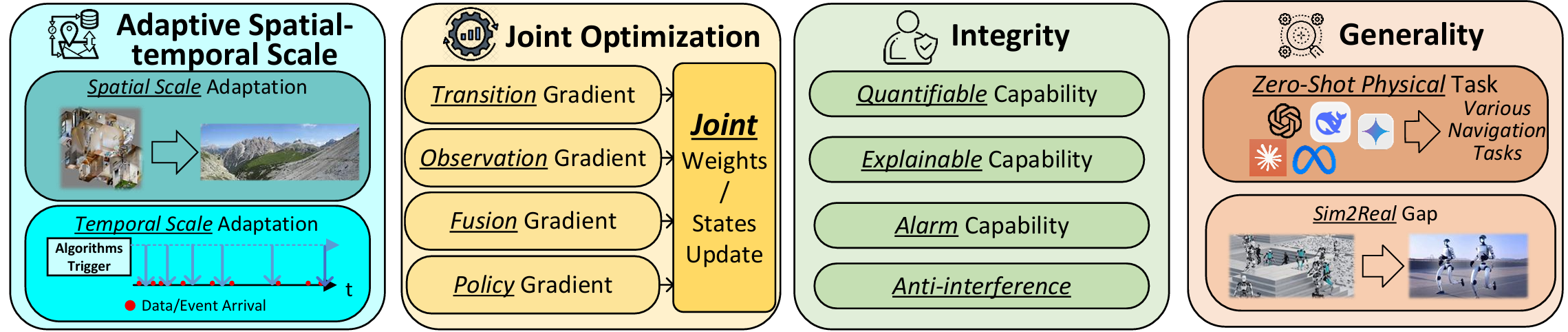

- 指出了具身导航领域面临的四大核心挑战——自适应时空尺度、联合优化、系统完整性和数据任务泛化性,为未来研究指明了方向。

- 详细总结了具身导航相关的平台工具和评估指标,包括仿真环境(AI2-THOR、Habitat系列等)和真实硬件平台(TurtleBot、Spot等),以及覆盖社会任务、感知和运动三个层面的评价体系。

介绍

研究背景

- 具身人工智能(Embodied Artificial Intelligence, EAI) 源于图灵提出的理念,强调通过自我感知和与人类或环境的交互来获取知识,是通向人工通用智能(AGI)的重要途径。

- 在机器人导航中,具身性体现在以自我为中心的感知方式(egocentric perception)和分布式计算能力,区别于传统基于全局地图或外部定位的方式。

- 传统导航研究聚焦于状态估计、点到点路径规划与最优控制,而人工智能的进步推动导航从“路径驱动”向“智能驱动”转变,形成了 具身导航(Embodied Navigation, EN) 的新范式。

具身导航的核心特征

论文指出,相较于依赖预定义地图和GNSS/SLAM 的经典导航,具身导航具备三类智能:

- 感知智能

- 通过多模态自我中心感知(proprioceptive + exteroceptive)获取空间认知;

- 不再完全依赖预构建的全局地图,而是利用主动感知完成环境理解。

- 社会智能

- 能够理解人类的高层语义指令(如自然语言任务描述);

- 支持超越预设路径点的复杂任务执行。

- 运动智能

- 具备高度自由度的运动技能,能够在复杂环境中进行灵活、适应性的物理交互;

- 不局限于固定路径,而是动态适应不同任务与环境。

相关研究与不足

- 计算机视觉(CV)方向:侧重社会智能,如视觉语言导航(VLN),但往往假设状态信息完备,忽视真实感知和运动的不确定性。

- 机器人学方向:聚焦感知智能,如主动 SLAM 和多模态融合,但在高级语义理解和复杂任务执行上有所欠缺。

- 神经形态/生物启发方向:尝试模仿生物导航机制,但同样存在社会智能和运动智能的覆盖不足。

- 现有综述的局限:多基于特定学科视角,未能统一涵盖感知、社会与运动三个维度。

具身导航问题定义

总体目标与理论框架

-

研究目标:在未知环境中,具身导航(EN)的目标是让智能体通过自我感知和交互,高效完成复杂导航任务。

-

理论基础:具身导航的决策过程可建模为 部分可观测马尔可夫决策过程(POMDP):

- 状态 st∈Ss_t \in Sst∈S:包含机器人本体状态和环境状态,由于传感器噪声与不确定性,表示为 概率分布(belief state) b(st)b(s_t)b(st)。

- 动作 at∈Aa_t \in Aat∈A:机器人在时刻 ttt 执行的动作,使得状态发生转移。

- 状态转移模型 T(st∣st−1,at)T(s_t|s_{t-1},a_t)T(st∣st−1,at):描述在执行动作后状态分布的变化。

- 观测模型 O(ot∣st,at)O(o_t|s_t,a_t)O(ot∣st,at):描述智能体在状态 sts_tst 下通过传感器获得的观测。

- 奖励函数 R(st,at)R(s_t,a_t)R(st,at):评估当前状态与动作对任务目标的贡献。

- 最优策略:通过优化累计期望奖励,得到策略函数 π∗\pi^*π∗,生成动作序列 {a0,a1,a2,… }\{a_0,a_1,a_2,\dots\}{a0,a1,a2,…}。

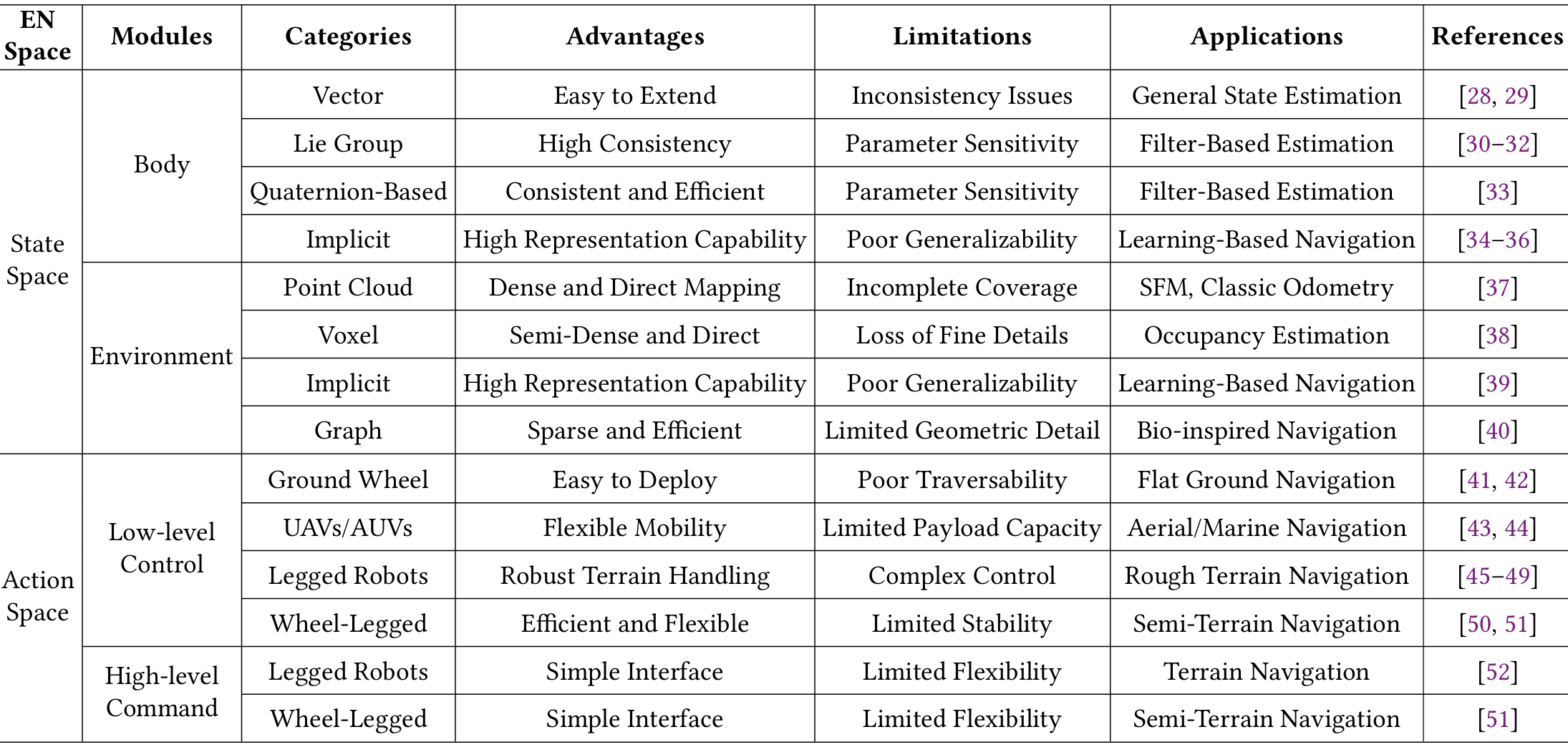

状态与动作空间配置

- 状态空间:由机器人本体(位置、速度、姿态)与环境特征构成,既可采用 显式表示(如向量、李群、四元数)保持几何一致性,也可采用 隐式表示(如深度学习特征向量、神经元格表示),兼顾可解释性与泛化性。

- 动作空间:由机器人平台的物理能力决定,典型分类包括:

- 低层控制:轮式机器人(3DoF)、无人机/水下机器人(6DoF)、足式机器人(12–25DoF)、轮腿混合机器人(高维控制)。

- 高层指令:抽象化的语义动作或控制接口,提升交互性。

TOFRA框架

-

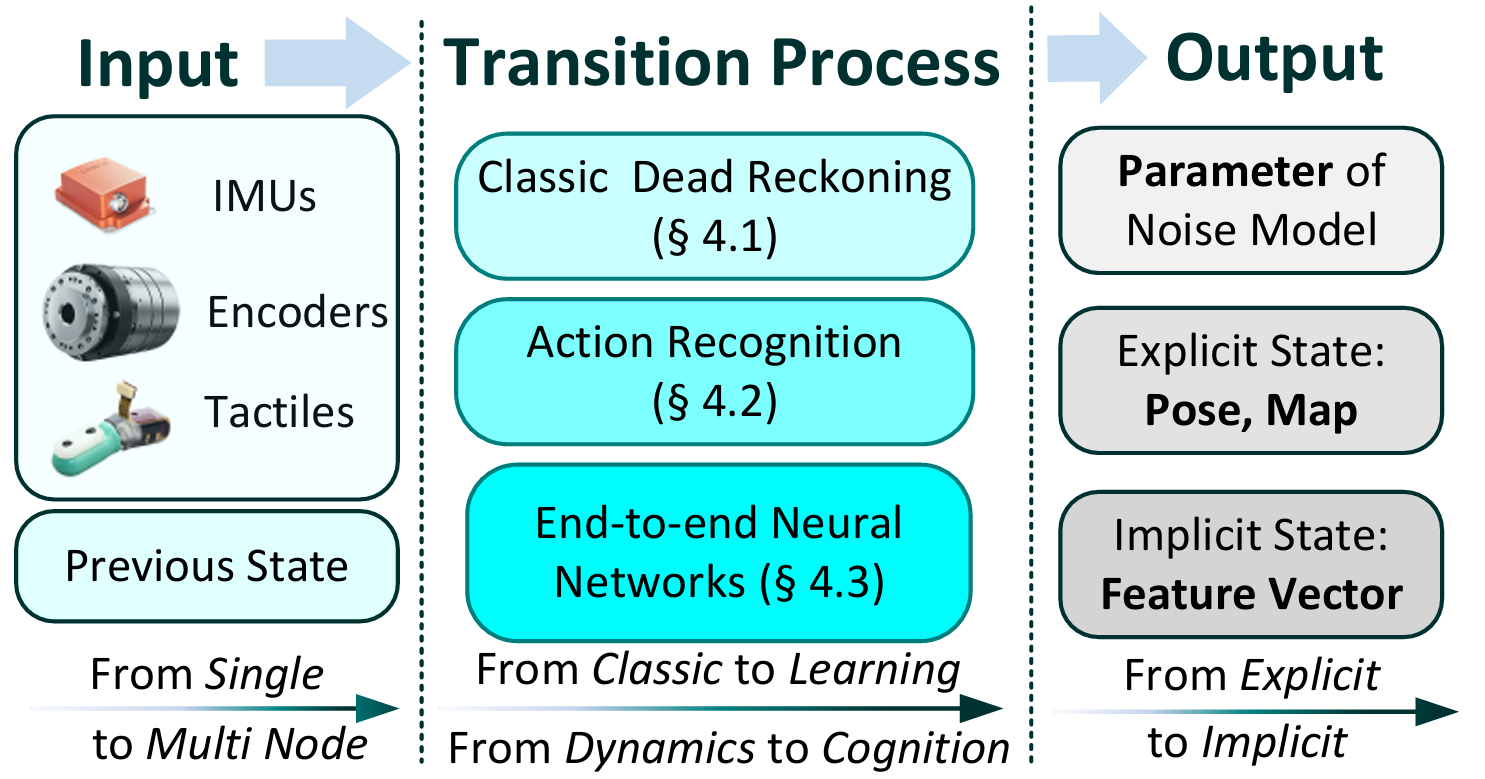

Transition(T,状态转移)

- 通过动力学模型、运动认知(如步态识别)、端到端神经网络等方式,利用本体传感器(IMU、编码器)推算下一个状态。

-

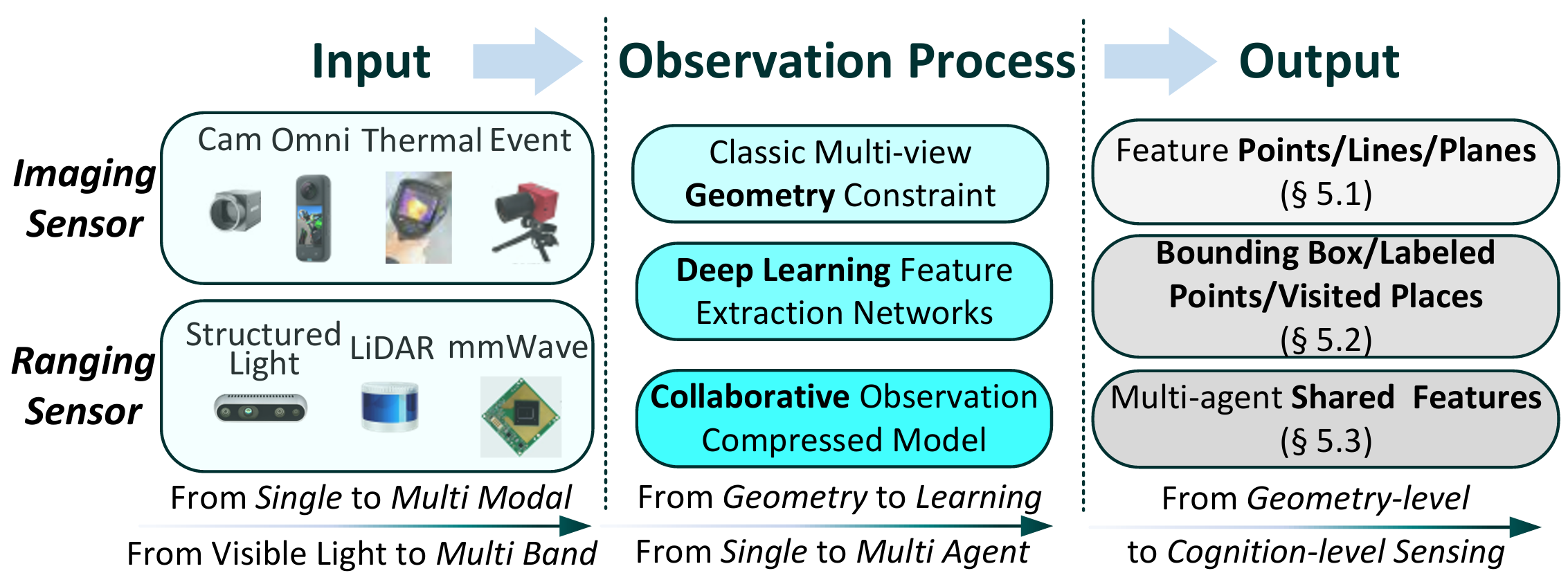

Observation(O,观测)

- 借助外部传感器(RGB、深度、LiDAR、毫米波雷达等)感知环境;

- 包括低层几何特征提取、高层语义认知(目标检测、语义分割、场景识别)、以及多智能体协同感知。

-

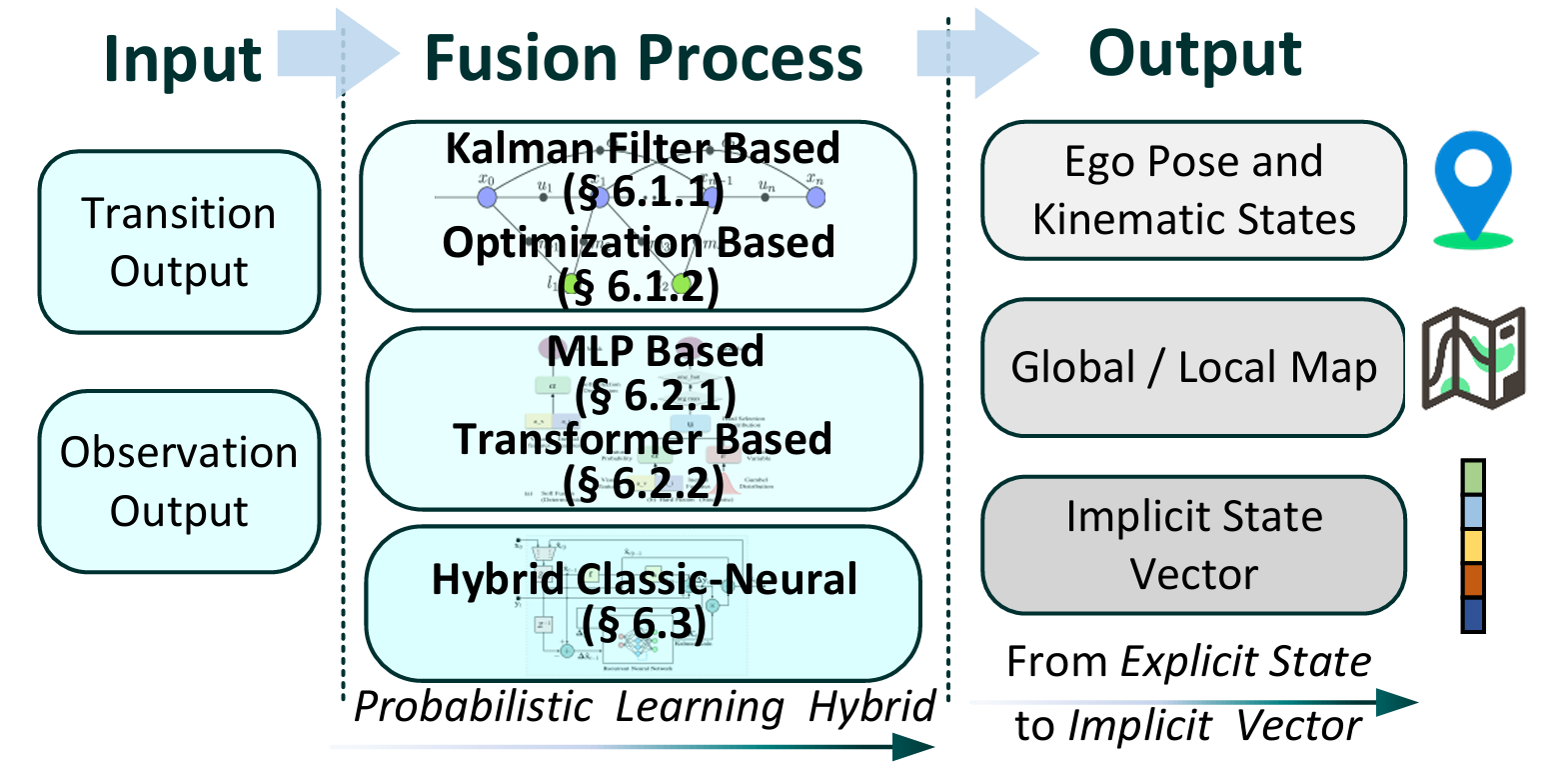

Fusion(F,感知融合)

- 将本体状态预测与外部感知进行融合,获得最优状态估计;

- 方法包括经典 贝叶斯滤波(如卡尔曼滤波、优化法),以及 神经网络隐式融合(如Transformer、多层网络),或二者结合的混合方法。

-

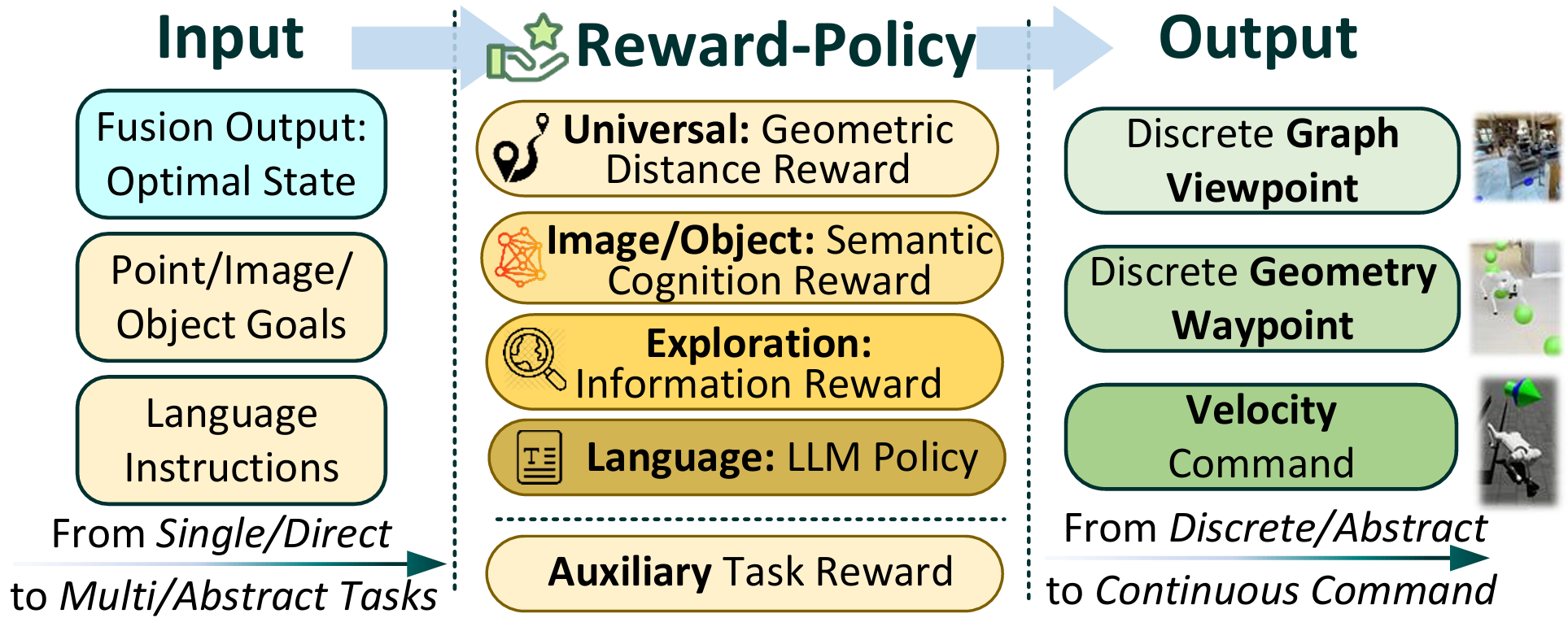

Reward-policy construction(R,奖励与策略构建)

- 将任务目标转化为奖励函数,例如点目标、图像目标、物体目标、探索覆盖率;

- 策略学习可扩展到多任务与视觉语言导航(VLN),结合大语言模型实现自然语言指令解析。

-

Action execution(A,动作执行)

- 智能体利用运动技能完成策略生成的动作序列;

- 包括基础元技能(行走、避障)、复合技能(技能组合、运动+操作协同)、以及形态协同(轮腿混合、空地一体、空水一体)。

优化目标函数

具身导航的核心目标是最大化累计奖励:

π∗=argmaxπ E[∑t=0∞γtr(b,at)]

\pi^* = \arg \max_{\pi} \; \mathbb{E}\left[ \sum_{t=0}^{\infty} \gamma^t r(b,a_t) \right]

π∗=argπmaxE[t=0∑∞γtr(b,at)]

其中:

- γ\gammaγ 为折扣因子;

- r(b,at)=∑st∈SR(st,at)b(st)r(b,a_t) = \sum_{s_t \in S} R(s_t,a_t) b(s_t)r(b,at)=∑st∈SR(st,at)b(st),即当前 belief 状态与动作的奖励期望。

状态与动作空间配置

状态空间

状态空间用于表示 机器人本体状态 与 环境状态,是后续转移、观测和融合算法的核心基础。

显式表示

- 向量拼接:直接将位置 ppp、速度 vvv、姿态 qqq 与环境特征 fif_ifi 拼接成一个大向量,简单易扩展,但存在坐标不一致引发的估计误差。

- 李群(Lie Group)表示:利用群仿射性质,使雅可比计算与当前状态估计无关,提高几何一致性,常用于滤波估计。

- 四元数/三叉四元数:以四元数表示旋转,双四元数进一步引入平移,三叉四元数结合位置、速度、姿态,统一误差坐标系,保证估计一致性。

隐式表示

- 深度学习特征向量:通过神经网络嵌入函数 st=fθ(ot)s_t = f_\theta(o_t)st=fθ(ot),从观测中学习状态表示,适用于复杂、非结构化环境。

- 生物启发的细胞表示:采用神经形态计算方法,利用神经元格编码状态,具有高效性,适合低功耗实现。

发展趋势

- 从 向量表示 → 几何一致性表示(如李群、四元数);

- 从 显式建模 → 隐式学习表示(深度特征);

- 向 类脑高效表示 演进,兼顾数学严谨性与自适应能力。

动作空间

动作空间由机器人平台的 运动系统与自由度(DoFs) 决定,决定了导航中智能体能执行的操作范围。

低层控制

- 轮式机器人(Ground Wheeled):典型 3 DoFs,易于实现,但地形适应性差。

- 无人机/水下机器人(UAVs/AUVs):6 DoFs,具备空间机动性,但受载荷和能量限制。

- 足式机器人(Legged Robots):高自由度(12+ DoFs),适应复杂地形,但控制难度高。

- 轮腿混合机器人(Wheel-Legged Robots):结合两者优势,兼具高效与适应性,通常需 16 维动作控制(12 关节+4 轮子)。

高层指令

- 通过抽象化命令(如“前进/转向”或语义化指令)来简化交互,适用于上层规划与任务驱动。

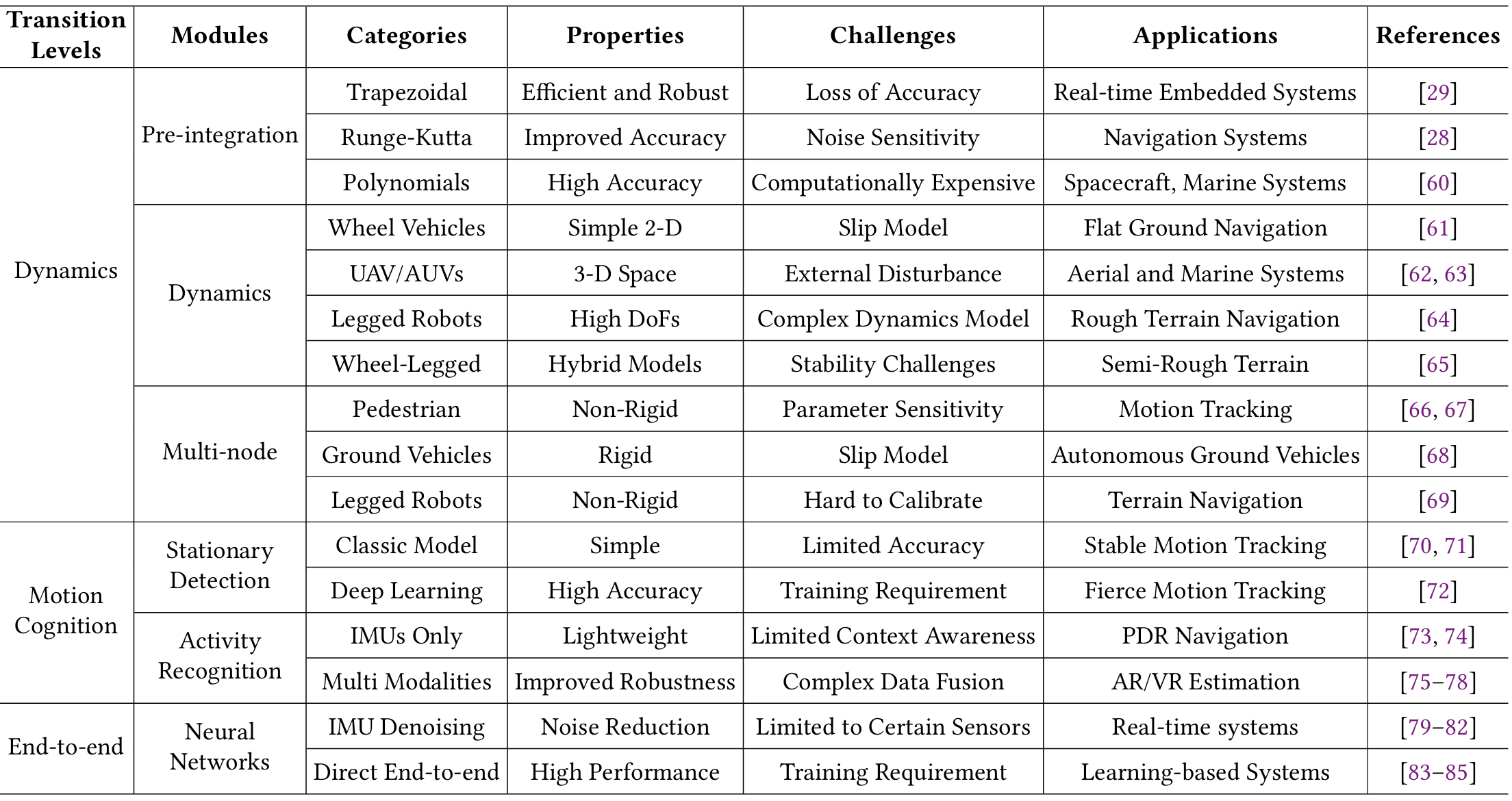

状态转移:本体感知智能

Transition 阶段是具身导航中 本体感知智能(Proprioceptive Intelligence) 的体现,其目标是利用智能体的内部传感器(如 IMU、编码器、触觉传感器等)推测在执行动作后的下一状态。它是具身导航系统中从“动作”到“状态”的映射环节。论文将 状态转移方法 分为三类:动力学建模方法、运动认知增强方法、端到端学习方法。

动力学模型驱动的状态转移

这是最经典的 惯性导航 / 推算(Dead Reckoning) 思路,依赖物理动力学方程:

-

IMU 积分(Pre-integration)

- 梯形法(Trapezoidal Rule):计算高效,但精度有限。

- Runge-Kutta 法:提高精度,但对噪声敏感。

- 多项式积分/切比雪夫多项式:用于高精度任务(如航天、海洋导航),计算量大。

-

不同平台动力学建模

- 轮式机器人:常用二维滑移模型,适合平地导航。

- UAV/AUV:需处理三维空间和外部扰动。

- 足式机器人:高自由度,动力学复杂,难以精确建模。

- 轮腿机器人:需混合动力学模型,控制稳定性是关键挑战。

-

多节点惯性测量(Multi-node IMU)

- 在人体行人定位、足式机器人中,通过多节点 IMU 协同提高估计精度。

运动认知增强的状态转移

引入 高层运动认知(如零速状态、行走步态、人类活动模式)提升状态估计精度:

-

零速检测(ZUPT, Zero Velocity Update)

- 可识别静止状态,修正状态漂移。

- 广泛应用于行人定位和机器人运动约束。

-

活动识别(Activity Recognition)

- 基于 IMU 或 多模态传感器(视觉+IMU) 识别运动模式;

- 对高自由度的足式机器人尤为重要,能够区分不同步态,提升状态预测精度。

-

认知化转移模型

- 状态转移矩阵可表示为不同运动模式的加权和:

T(st∣st−1,at)=∑jT(st∣st−1,at,mj)⋅p(mj) T(s_t|s_{t-1},a_t) = \sum_j T(s_t|s_{t-1},a_t,m_j) \cdot p(m_j) T(st∣st−1,at)=j∑T(st∣st−1,at,mj)⋅p(mj)

其中 mjm_jmj 表示具体运动认知,p(mj)p(m_j)p(mj) 为其概率。

- 状态转移矩阵可表示为不同运动模式的加权和:

端到端学习的状态转移

利用深度学习直接学习复杂动力学,突破传统物理建模的限制。

-

IMU 去噪(Neural Denoising)

- CNN/LSTM/TCN 用于实时去除 IMU 噪声与偏差,提高输入精度。

-

端到端神经建模(Neural Transition)

- 神经网络直接学习状态转移函数,无需显式动力学模型;

- 特别适合多节点 IMU 或复杂机器人系统,可隐式捕获非线性和环境干扰。

发展趋势与挑战

论文总结了 Transition 方法的三条发展路径:

- 从单节点到高自由度:由低维运动模型扩展至高维复杂动力学,支持形态多样的机器人平台。

- 从几何推算到认知增强:由纯数值积分过渡到引入运动认知与模式识别,提升上下文感知能力。

- 从显式物理到隐式学习:由传统动力学建模转向端到端学习模型,更适应动态环境和传感器噪声。

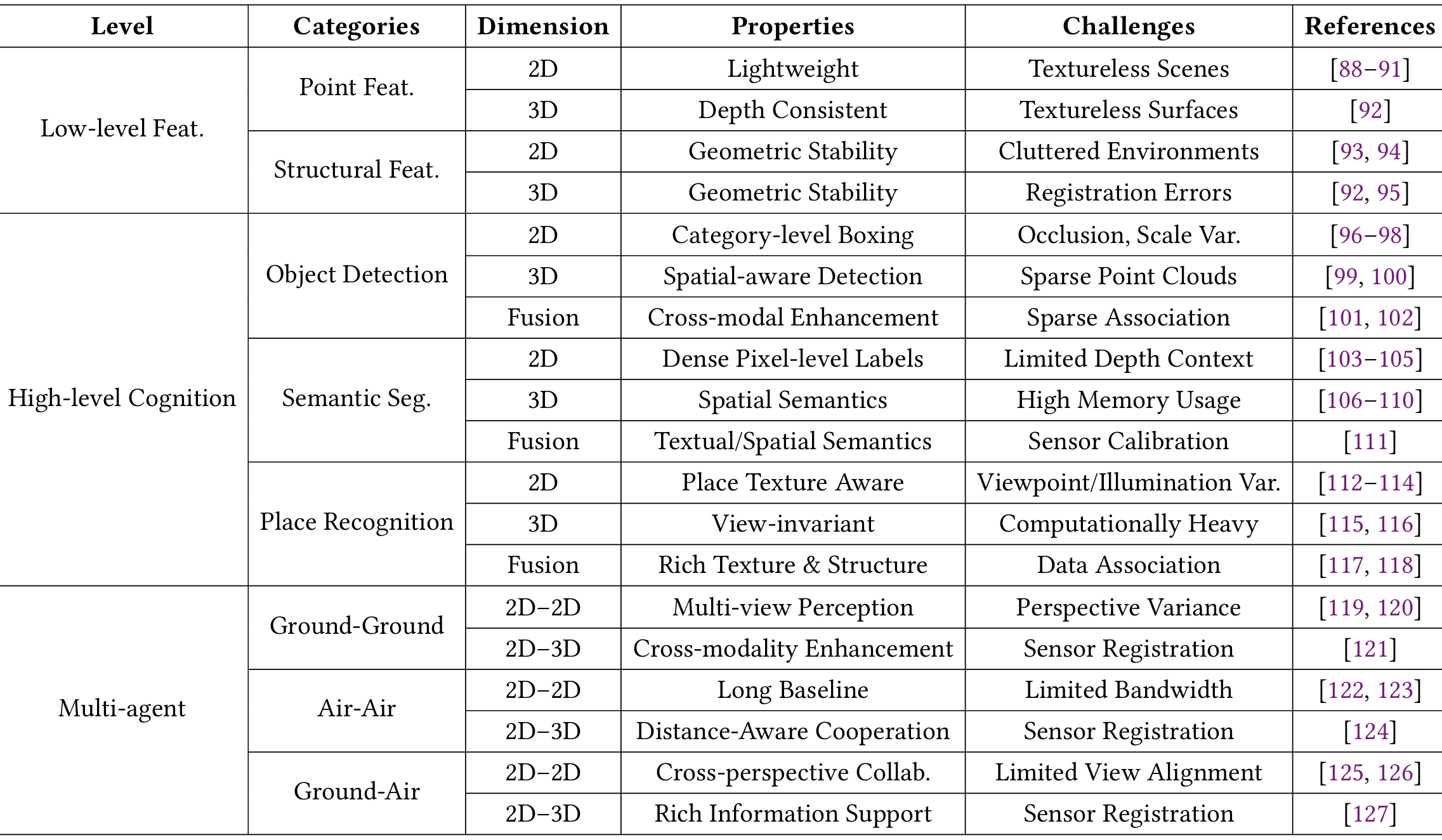

观测与感知:外部感知智能

探讨了在具身导航中,机器人如何通过外部传感器(exteroceptive sensors)感知环境,从而形成对外部世界的认知。介绍了从低层次特征提取到高层次认知理解,再到多智能体协作感知的观察方法。

低层次特征观察:经典SLAM前端

低层次特征提取是经典SLAM(Simultaneous Localization and Mapping,即同时定位与建图)前端的核心,主要通过识别几何基元(如点、线、面)来构建对环境的基础理解。

点特征

- 点特征是基础的几何元素,通过在不同帧之间提取和匹配这些点来实现环境感知。传统的基于梯度的提取器(如SIFT)在纹理缺失的场景中表现不佳,但深度学习技术提高了其鲁棒性。

- 例如,学习型提取器和基于Transformer的匹配器在2D图像中表现出色,类似技术也发展到了3D点云(如LiDAR数据)。

结构特征

- 结构特征(如线和面)在纹理缺失的环境中尤为重要。传统方法依赖于几何原理,特别是“曼哈顿世界假设”来检测线特征。

- 近年来,端到端的深度学习方法也用于线特征的稳健提取和匹配。

- 此外,从深度信息中提取的平面特征作为有效的补充几何基元,有助于环境感知。

高层次认知观察:空间认知

除了低层次的特征提取,高层次的认知观察侧重于通过语义理解来感知环境,这包括目标检测、语义分割和位置识别等技术。这些技术通过深度学习方法实现,能够提供更精确和丰富的环境信息。

目标检测

- 目标检测通过在2D图像和3D点云中定位和分类目标来提供关键的语义信息。2D目标检测领域从实时CNN发展到具有更强上下文推理能力的Transformer,同时增强了对恶劣天气等环境挑战的鲁棒性。

- 3D检测方法通过融合多模态数据或直接利用点几何来解决点云稀疏性问题。这种认知能力通过动态特征移除(直接或概率性)提高了SLAM的鲁棒性,并通过关注特定目标或在目标级SLAM系统中将目标作为持久地标来增强映射。

语义分割

- 语义分割通过为每个像素或点分配类别标签来提供对环境的密集理解。2D方法从基础的全卷积网络(FCN)和上下文感知架构发展到基于Transformer的方法。对于3D点云,技术范围从点级MLP和专用卷积到Transformer,包括基础模型的进步和多模态融合。

- 这种语义能力通过动态目标移除、强化几何特征描述以实现稳健映射,以及通过概率数据关联使SLAM系统能够利用语义目标作为可靠地标来增强环境观察。此外,语义特征可以隐式地集成到端到端的神经映射网络中,以进一步提高观察质量。

位置识别

- 位置识别是导航系统中用于闭环检测和重定位的关键组件。2D应用中,方法从基于CNN的描述符发展到先进的Transformer架构和通用基础模型。对于3D环境,LiDAR方法从经典描述符发展到有效利用时间信息或鸟瞰图投影的深度学习方法。

- 为了增强在不同条件下的鲁棒性,多模态融合技术通过隐式或显式机制整合2D和3D数据。这些方法的实际应用需要解决系统级挑战,包括在线校准和确保机器人平台上实时性能。

多智能体观察:协作感知

除了单智能体感知,多智能体协作感知作为一种有效的策略,通过整合来自多个智能体的观测数据来扩大感知覆盖范围并增强观察的鲁棒性。不同类型的智能体(如地面和空中智能体)提供互补的环境信息,可以克服单个传感器的局限性和遮挡问题。这种协作方法在多智能体感知领域得到了广泛研究,并在导航任务中表现出显著优势。

地面-地面

- 地面-地面协作:多个机器人之间的地面-地面协作显著增强了导航任务中的感知覆盖范围。这些系统采用动态Voronoi划分或分布式势场等技术,有效合并子地图并消除冗余工作。

- 为了克服通信带宽限制,智能体交换轻量级的拓扑地图或压缩描述符,而不是传输密集的地图数据。

- 对于稳健的去中心化定位,这些协作系统可以通过变分贝叶斯方法联合学习和适应非平稳传感器噪声特性,从而提高整个系统的准确性和可靠性。

空中-空中

- 空中-空中协作:无人机(UAV)的卓越感知范围和机动性使其在协作观察任务中特别有效。空中多智能体系统的研究涉及多个操作领域的关键挑战。在协作制图和探索方面,多UAV系统利用协作SLAM技术提高模型精度,同时共享子地图以实现快速环境覆盖。

- 在高级感知能力方面,研究人员开发了协作3D目标检测框架,将多视图2D图像融合成一致的3D表示。此外,为了应对有限通信带宽这一关键瓶颈,实施了空间置信图等技术,以智能地压缩和优先共享空中智能体之间的数据。

地面-空中

- 地面-空中协作:地面-空中协作感知整合了空中和地面传感视角,以克服单一平台观察的局限性。空中智能体通常执行快速、粗略的制图,而地面智能体捕获局部区域的详细特征,通过全局位姿图优化技术融合异构传感器数据。通过引入语义特征来弥合视角差异,进一步增强了这种传感器融合过程的可靠性。

- 除了通用制图,这些协作系统还可以针对特定目标进行优化,例如高效的目标定位任务。为了促进这一领域的系统评估和进步,为这些异构感知系统建立了标准化的基准数据集。

讨论与趋势

观察能力在具身导航系统中的演变揭示了三个关键轨迹:

- 从静态到自适应感知:从固定参数向能够动态适应环境变化和传感器条件的系统转变。

- 从被动到主动感知:从被动数据收集向主动交互转变,以优化信息收集。

- 从预定义到紧急协作:从刚性协议向紧急协作转变,智能体通过学习最优协调策略来实现协作。

本体感知与外感知的融合:感知融合智能

探讨了在具身导航中,如何将来自本体感知(proprioception)和外部感知(exteroception)的信息进行融合,以形成最优的状态估计。这一部分详细介绍了两种主要的融合范式:经典贝叶斯方法和隐式神经技术。

经典贝叶斯方法

经典融合方法基于贝叶斯原理,通过将先验状态信念与观测条件概率相结合来推导最优状态。这一部分介绍了两种主要的经典融合方法:卡尔曼滤波器和基于优化的方法。

卡尔曼滤波器方法

- 卡尔曼滤波器是融合本体感知和外部感知数据的常用方法。在视觉-惯性融合中,多状态约束卡尔曼滤波器(MSCKF)是处理传统相机和异步事件相机的经典框架。在测距-惯性融合中,卡尔曼滤波器也广泛应用于基于激光雷达的系统和测量噪声较大的雷达系统。

- 然而,所有传感器模态都面临非高斯和非平稳噪声分布的挑战,这通过特殊的滤波技术来解决。现代系统通过紧密耦合多种互补模态(如视觉、激光雷达和惯性数据)来提高鲁棒性。

基于优化的方法

- 基于优化的融合方法通过构建统一的成本函数来最小化,该函数通常包括先验成本、传播成本、观测成本和正则化项。对于基于视觉的系统,特征参数直接纳入优化过程。

- 类似地,事件相机的特征也被纳入相同的优化框架。激光雷达或毫米波雷达的范围传感器数据为成本函数提供结构特征。这种方法的优势在于能够将视觉和范围观测与本体感知测量结合,使用基于协方差的加权方案,从而产生稳健的多模态融合解决方案。

神经融合

除了基于贝叶斯的经典融合方法,深度神经网络也可以用于隐式地融合状态转换和观测信息。这一部分介绍了两种主要的神经融合方法:基于多层网络的融合和基于Transformer的融合。

基于多层网络的融合

- 多层网络融合是早期的神经融合方法,通过连接状态转换和观测特征来实现。VINet是这一领域的先驱工作,后来扩展到自监督框架。然而,简单的连接方法对损坏或未对齐的传感器数据不够鲁棒。

- 为了解决这个问题,开发了选择性融合技术,通过识别和优先考虑来自各种传感器模态的可靠特征来提高鲁棒性,从而减少传感器退化的影响。

基于Transformer的融合

- Transformer架构通过其注意力机制提供了一种复杂的传感器融合方法,能够建立时间序列之间的上下文感知关系。

- 与简单的多层方法不同,Transformer可以对异构传感器数据的空间和时间维度的复杂依赖关系进行建模。自注意力机制自动为测量分配适当的权重,基于其可靠性,有效地减少噪声或损坏输入的影响,同时保留有价值的信息。

混合经典-神经融合

- 混合经典-神经融合方法结合了经典卡尔曼滤波技术和神经网络,以有效地学习融合过程中的非线性动态。这种方法在GNSS/INS系统中得到了应用,并显示出在具身感知融合框架中更广泛应用的潜力。

- 这些混合方法旨在结合经典方法的可解释性和理论保证以及神经网络的灵活性和学习能力。

讨论与趋势

传感器融合的演变揭示了三个关键轨迹:

- 从固定参数到自适应融合:从静态参数向动态调整转变,以适应不同的传感器条件,现在正朝着能够在未见数据分布上泛化的鲁棒框架发展。

- 从状态估计到认知生成:从低维状态回归向生成高维导航认知的转变,这些认知具有语义理解能力。

- 从模态特定到通用融合:从针对特定传感器的专门架构向能够通过学习跨模态表示来整合异构传感器的通用框架的转变。

奖励策略构建:社会智能

探讨了在具身导航中,如何构建奖励函数和策略,以使机器人能够理解和执行高级任务指令。这一部分详细介绍了从单任务到多任务,再到基于语言指令的任务的奖励策略构建方法。

单任务

单任务导航是具身导航的基础能力,其奖励函数直接将可观察状态转化为行动指导。

点目标

- 任务描述:机器人需要导航到目标坐标。

- 早期方法依赖于GPS/指南针数据,但最近的研究通过集成学习的自我中心定位模块,使机器人能够在只有视觉观察的情况下进行导航。

图像目标

- 任务描述:机器人需要到达参考图像被拍摄的位置,通过学习将当前视图与目标相关联的策略。

- 研究探索了各种策略架构,包括用于长视野任务的记忆增强网络、用于提高泛化能力和可解释性的模块化设计,以及能够同时处理观察序列、行动和目标的Transformer模型,以更好地捕捉时间依赖性。

物体目标

- 任务描述:机器人需要找到指定类别的物体,这依赖于对场景的语义理解。

- 一种常见的方法是构建显式的语义地图以指导探索策略,尽管研究人员也开发了更有效的无地图方法以减少计算开销。通过引入3D物体几何形状,可以提供更精确的空间理解,从而在复杂环境中提高性能。

- 最近的先进方法扩展到不仅简单地检测物体,还模拟物体之间的常识关系,使用结构化的图卷积网络或更灵活的Transformer架构来优化搜索效率。这些方法最终旨在开发高级的、抽象的场景表示,以促进更智能的导航行为。

探索

- 任务描述:探索任务关注于高效覆盖和重建未知环境。

- 奖励的制定因不同的环境表示和探索区域而异。基于覆盖的方法提供了一种直接的奖励机制,基于机器人已成功探索的区域百分比。

- 补充这种策略的是内在好奇心驱动的奖励,它激励机器人寻找新信息,通过优先考虑与之前遇到的区域差异显著的观察结果,从而促进对环境的全面探索。

多任务

在多任务导航中,研究表明训练机器人完成一种目标类型的导航可以增强其在其他导航目标上的表现。为了有效处理长期视野任务,策略通常会整合持久记忆机制,以减少重复探索。

- 这些机制可以是显式的全局语义地图,也可以是隐式的学到的表示。此外,通过辅助学习目标,如空间推理或预测深度和逆动力学,同时训练机器人,可以得到更稳健的状态表示。

- 尽管端到端的深度学习方法在最近的研究中占主导地位,但经典的模块化架构,将制图与目标定位分开,仍然显示出显著的有效性。

视觉语言导航

除了机器人自我指导的策略学习外,人类语言指令可以促进学习过程,以完成复杂任务。这种方法被称为视觉语言导航(VLN)。

- 一种直接的方法是将语言编码为策略模型的输入特征。随着大型语言模型(LLM)的发展,自然语言可以通过这些模型进行处理以增强理解。

- 一种方法是利用LLM作为零样本导航任务的代码生成器。另一种方法是将检索增强生成(RAG)技术引入EN过程。这些基于RAG的方法利用LLM的逻辑推理能力来处理特定的导航图记忆。

- 对于导航基础模型,研究人员预训练和微调了专门的导航LLM以处理语言指令,使机器人能够生成适当的导航策略。

讨论与趋势

奖励策略构建的演变揭示了向更灵活和直观的人机交互的转变:

- 从显式目标到隐式目标:从几何坐标到语义概念的演变,使得奖励函数更加抽象。

- 从单任务学习到多任务学习:从专门的求解器向能够跨任务转移知识的通用策略的转变。

- 从预定义奖励到语言解释:通过语言模型从自然语言指令中推导奖励,取代预定义的函数。

- 从离散奖励到可微分奖励:从稀疏的二进制信号向具有平滑梯度的密集连续形式的转变,以实现更有效的策略优化。

动作执行:运动智能

探讨了在具身导航中,机器人如何将策略生成的动作序列转化为实际的物理运动。这一部分详细介绍了从基础的动作技能到复杂的组合技能,再到形态协作的运动智能。

动作执行基础:运动技能开发

基础动作技能是机器人进行基本移动和交互的能力。这些技能是所有复杂动作的基础。

轮式机器人

- 动作空间:轮式机器人通常具有3个自由度(DoF),其动作空间可以简化为离散命令,如前进、后退、左转和右转。

- 学习方法:由于其动力学相对简单,通常可以通过无监督学习方法来学习这些基础动作技能。

足式机器人

- 动作空间:足式机器人具有更高的自由度(如四足机器人通常有12个DoF,人形机器人有25个以上DoF),这使得它们能够进行更复杂的动作,如跳跃和爬坡。

- 学习方法:研究集中在基于模型的控制方法,如精确的跳跃控制,以及使用强化学习(常结合课程学习)来发现通过与环境交互的稳定步态。

组合技能

组合技能涉及将多个基础动作技能组合成更复杂的、高层次的能力。这代表了运动智能的一个关键进步。

顺序技能组合

- 显式方法:使用高层次的规划器来按顺序组合技能,这种方法具有可解释性,但可能缺乏平滑的过渡。

- 隐式方法:通过端到端的学习方法创建统一的策略,实现无缝的技能转换,尽管这需要大量的训练数据,但可以实现令人印象深刻的敏捷性。

腿臂协同操作

- 腿基操作:足式机器人可以利用腿部进行物体操作,而无需专门的末端执行器。

- 集成臂腿系统:一些机器人设计了集成的臂腿系统,支持复杂的全身协调运动。这些系统需要复杂的运动规划算法来管理运动学和动力学之间的耦合。

形态协作

形态协作是运动智能的前沿领域,机器人通过可调整的物理配置来优化在多样化环境中的性能。

轮腿机器人

- 动作空间:轮腿机器人结合了轮式机器人的地面效率和足式机器人的地形适应性。

- 控制框架:这些混合平台需要特殊的控制框架,根据地形动态分配轮子和腿部的控制权。

陆空机器人

- 动作空间:陆空机器人可以在地面行走和空中飞行。

- 控制算法:这些机器人需要复杂的状态估计算法来保持在不同动态模式下的定位一致性,同时需要专门的运动规划器来管理复杂的转换阶段。能量优化对于这些系统至关重要,研究集中在最小化模式转换过程中的能耗。

空陆水机器人

- 动作空间:这些多领域机器人可以在空中、陆地和水下环境中操作。

- 控制架构:它们实现了分布式控制架构,每个领域的专用控制器通过元控制层进行协调。尽管这些系统具有很大的潜力,但在可靠性、能效和控制方面仍面临重大挑战。

讨论与趋势

动作执行方法的演变揭示了三个关键转变:

- 从场景特定到形态适应:从为特定环境设计的系统向能够动态重新配置自身的机器人转变,以适应多样化、不可预测的地形。

- 从精确控制到任务导向执行:从追求完美轨迹跟踪向尽管控制不完美但能够实现目标的实用主义转变,这在任务导向的导航中尤为明显。

- 从预定义动作到交互式运动:开发能够通过与环境的交互来完善运动策略的能力,而不是仅仅依赖于预编程的动作。

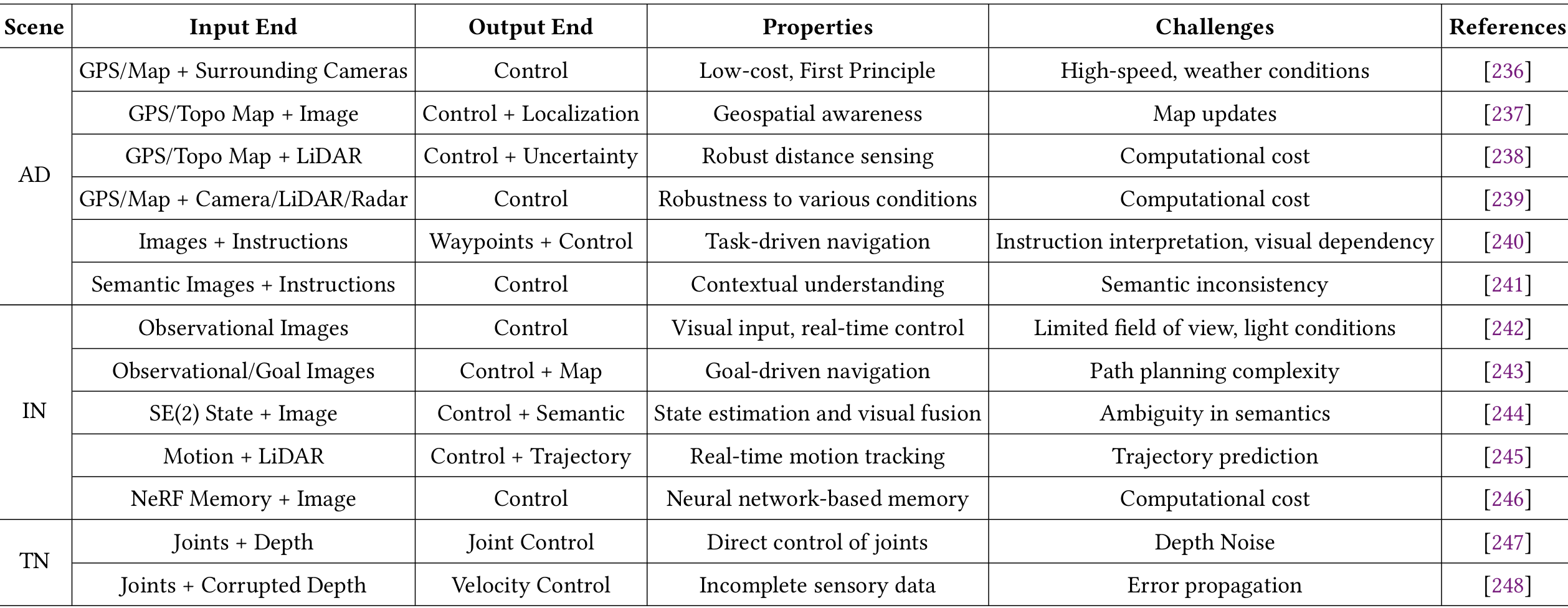

具身导航系统方法

系统地介绍了如何将TOFRA框架应用于三种典型的导航场景:具身自动驾驶、具身室内导航和复杂地形导航。本部分详细阐述了在这些场景中如何整合TOFRA框架的各个阶段,以实现高效的导航系统。

具身自动驾驶系统

- 主要依赖于外部的GPS和地图信息,因此在TOFRA框架中,状态转换(T)被视为已知的。研究的重点在于学习一个鲁棒的端到端策略,用于观察、融合、奖励策略和行动(OFRA)阶段。

- 这些策略学习如何将越来越丰富的感知输入(如环视摄像头、3D激光雷达和天气抗性的雷达)映射到车辆控制。策略的复杂性也在不断提高,从产生概率性输出以处理不确定性,到结合人类指导进行微调。

- 输入:GPS/地图 + 周围摄像头、激光雷达、雷达等。

- 输出:车辆控制。

- 特点:系统在明确的状态转换基础上,隐式地建模了一个复杂的OFRA流程。

具身室内导航

- 与自动驾驶系统不同,具身室内导航系统在没有GPS的情况下运行,完全依赖于自身传感器。这些系统在TOFRA框架中的复杂性各不相同。对于短时间范围的任务,直接将观测映射到即时动作的策略是有效的,但对于规划能力有限。

- 更先进的方法结合了明确的状态表示和通过循环网络或变换器实现的学习转换模型。为了增强空间理解能力,复杂的IN系统使用语义特征或神经辐射场(NeRF)构建丰富的世界模型。这些世界模型显著提高了代理对复杂室内环境的理解和导航决策能力。

- 输入:观测图像、目标图像等。

- 输出:控制信号、地图等。

- 特点:系统需要在没有GPS的情况下,仅依靠自身传感器进行导航,因此需要更强大的感知和决策能力。

复杂地形导航

- 复杂地形导航专注于穿越复杂、不平坦的地形以完成导航任务。这些系统通常使用四足机器人作为主要代理平台。输入通常包括代理的关节传感器数据和周围地形的深度图。

- 对于输出,TN系统要么生成低级控制器跟踪的速度命令,要么提供直接的关节控制命令。虽然基于速度的方法可能会遭受运动执行的不连续性,但直接关节控制提供了更平滑的操作,但为策略带来了更大的挑战。

- 输入:关节传感器数据、深度图等。

- 输出:速度命令或关节控制命令。

- 特点:系统需要应对复杂地形,因此需要更高级的运动控制能力。

讨论与趋势

- 从专用到自适应:从针对特定场景的系统向能够动态适应多样化环境的统一框架演变,无需重新训练。

- 从模块化到集成化:从分别优化各个TOFRA组件,向解决系统间依赖性的联合优化策略转变。

- 从工程化任务到新兴智能:从人类设计的导航层次结构,向能够通过持续学习自主分解复杂指令的系统演变。

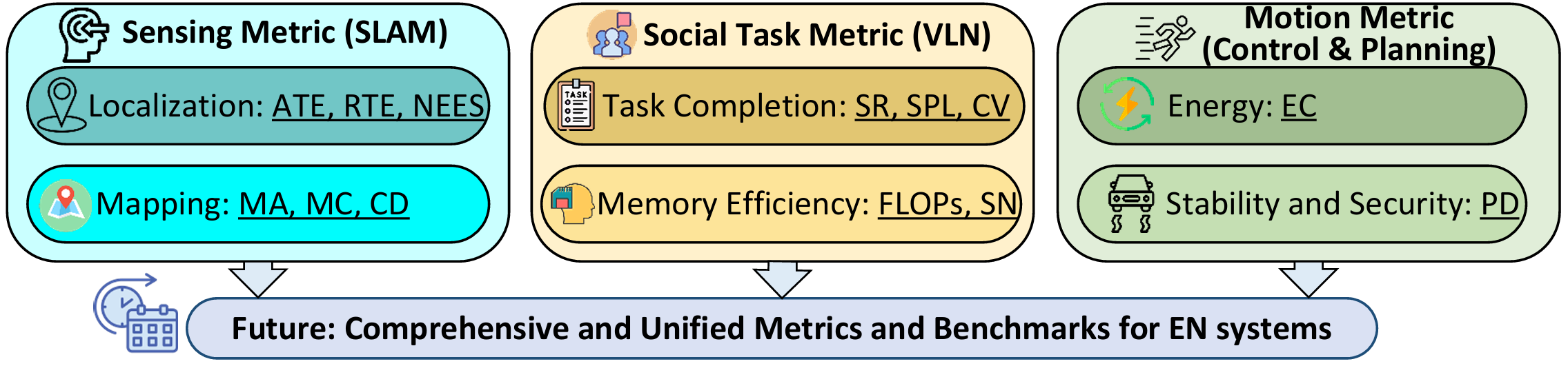

开放平台和评估指标

介绍了用于具身导航研究的开放平台和评估指标。本部分从两个方面展开:开放平台(Open Platforms)和评估指标(Evaluation Metrics)。这些内容对于推动EN研究的发展和评估具身导航系统的性能至关重要。

开放平台

开放平台为具身导航系统的开发和基准测试提供了可扩展、安全且可复现的环境。本部分介绍了几种关键的模拟器和真实世界的平台,并通过TOFRA框架进行了分析。

模拟器

模拟器提供了理想化的环境,用于开发和测试具身导航系统,避免了真实世界中的风险和成本。以下是几种主要的模拟器平台:

- AI2-THOR:一个交互式的房间尺度模拟器,专注于社交/语言任务(R)和操作(A)。其伴随的RoboTHOR便于直接从模拟到现实的转移。

- Habitat系列:一个高度优化的平台,逐步演进以支持复杂的建筑尺度导航。它现在集成了操作、四足机器人和语言指令,扩展了对整个TOFRA框架的覆盖。

- SAPIEN和iGibson:这些模拟器通过提供详细的本体感知传感器(如SAPIEN中的IMU)和外感知传感器(如iGibson中的激光雷达)增强了物理真实感。

- ThreeDWorld:将模拟扩展到户外场景,并提供力反馈以实现更真实的物理交互。

- GRUtopia:基于Isaac Sim构建,提供高照片级和物理真实感。它支持TOFRA框架中的感知、社交和运动智能的完整流程,尽管计算成本较高。

真实世界平台

尽管模拟器对于开发至关重要,但在物理硬件上的验证同样关键。以下是几种标准的真实世界平台:

- 标准轮式平台:包括TurtleBot系列、Fetch和Freight,以及Clearpath Robotics(Jackal、Husky)。

- 复杂地形导航平台:常见的四足平台有Boston Dynamics Spot、ANYbotics ANYmal和Unitree系列(Go1等)。

评估指标

全面评估具身导航系统需要从三个基本维度进行:社交(Social)、感知(Sensing)和运动(Motion)。

社交任务级指标

社交任务性能通过以下几种指标量化:

- Success Rate (SR):衡量成功完成任务的百分比。

- Success weighted by Path Length (SPL):通过惩罚次优路径来评估效率。

- Floating Point Operations (FLOPs):量化策略模型的资源需求。

- Coverage (CV):衡量环境被探索的比例。

- Storage Node count (SN):评估结果空间表示的内存效率。

感知级指标

感知能力通过以下指标评估:

- Absolute Trajectory Error (AT**:量化全局定位一致性。

- Relative Trajectory Error (RTE):衡量短期里程计漂移。

- Normalized Estimation Error Squared (NEES):检验估计不确定性与实际误差之间的一致性。

- Map Accuracy (MA):评估几何精度。

- Map Completion (MC):确定环境覆盖的完整性。

- Chamfer Distance (CD):提供生成点云与参考点云之间整体重建保真度的定量度量。

运动级指标

运动执行指标评估代理如何有效地通过物理运动实现其导航策略:

- Energy Consumption (EC):衡量导航任务期间消耗的总功率。

- Path Deviation (PD):通过测量代理与其预期轨迹的接近程度来评估稳定性。

讨论与趋势

- 平台演变:从抽象的任务导向模拟器向具有真实物理特性的高保真“数字孪生”转变,新兴的焦点是完全可微分的模拟环境,这些环境能够通过整个TOFRA框架的端到端梯度优化,促进感知、规划和控制组件的联合训练。

- 指标趋势:从单一任务指标(例如SR)扩展到一个“平衡计分卡”,全面评估代理的社交(R)、感知(T,O,F)和运动(A)智能。

结论与未来工作

结论

- 该综述通过TOFRA框架统一了EN研究,揭示了经典机器人和数据驱动AI在导航中的融合。

- 关键趋势包括:从固定模型转向自适应进化智能,从专门组件转向集成系统,以及从工程解决方案转向新兴的、语言引导的行为。

- 尽管取得进展,在开发原则性混合自适应模型、缩小仿真与现实差距以及实现长时程推理和导航方面仍存在重大挑战。

未来研究方向

- 自适应时空尺度:具身导航系统需要发展先进的时空尺度自适应策略,包括空间尺度的增量更新机制和时间尺度的高效任务调度算法。

- 联合优化:需要开发混合方法,整合经典方法和基于学习方法的优势,实现具身导航系统参数的联合优化。

- 系统完整性:确保可靠和安全操作的关键能力,包括可量化能力、可解释能力、警报能力和抗干扰能力。

- 数据和任务的泛化性:解决跨不同数据和任务的泛化问题,包括通过物理真实仿真器或教授可迁移的抽象知识来弥合仿真与现实差距。