【MLLM】语音端到端大模型和Voice Agent发展

note

- 主流方案:端到端 or 级联方案(ASR + LLM + TTS)

- 级联方案:语音输入 → ASR(语音转文本) → LLM(文本理解与生成) → TTS(文本转语音) → 语音输出

- CosyVoice模型:对于交互应用(如语音助手),用户希望一说话就有回应。Flow Matching 的确定性特性(每一步计算都是确定的,不像扩散模型可能有随机性)和可控的路径规划,使得 CosyVoice 可以实现流式生成:一边接收文本,一边合成语音,而不需要等全部文本处理完再开始。这显著降低了响应延迟,提升了体验

- Step-Audio 2:架构“真”端到端,直接处理原始音频,保证对副语言信息和非人声信息的有效理解。一改传统的 ASR + LLM + TTS 三级结构,实现原始音频输入→语音响应输出的直接转换;这样架构更简单,能够有效减少时延。

- 此外,技术上采用了连续输入+离散输出范式,能直接处理原始音频波形,避免特征提取造成的信息损失,还能通过离散音频 token 保证声音合成稳定性。

- 最后,在语言建模层,Step-Audio 2 实现了文本与语音 token的 固定比例交错排列,确保文本-语音模态高度对齐,显著提升模型的智商上限。

- Step-Audio 2:或许标志着语音交互从"机械应答"向"情感智能"的重要转变。未来,我们可能会看到:虚拟偶像直播时可以实时切换多种音色和情感状态、方言保护与文化传承借助AI技术得以实现、AI助手能够感知用户情绪并相应调整回复风格,

当然,如何在生成语音的自然度与可控性之间找到最佳平衡,仍是未来需要探索的方向。

文章目录

- note

- 一、CosyVoice模型

- 1、模型架构

- (1)语音量化编码

- (2)自回归语音token生成

- (3)流匹配(flow matching)

- (4)HIFIGAN 声码器

- 2、训练改进

- 二、Step-Audio 2:端到端音频大语言模型,实现行业级理解与对话能力

- 1、模型架构

- 2、模型评测

- 三、级联方案 vs 端到端模型

- 四、ai-voice-agents-2025-update

- Reference

一、CosyVoice模型

官方Github仓库: https://github.com/FunAudioLLM/CosyVoice.git

[1] 项目论文:https://arxiv.org/pdf/2407.05407

[2] 项目主页:https://fun-audio-llm.github.io

[3] 开源代码:https://github.com/FunAudioLLM/CosyVoice

1、模型架构

在人工智能领域,文本到语音(Text-to-Speech, TTS)技术已逐步褪去机器的生硬感,向着自然流畅、富有表现力的语音合成发展。CosyVoice 是阿里最新开源的语音克隆和文本转语音项目,能够生成自然的语音,适用于多种应用场景,支持中文、英语、日语、粤语和韩语五种语言;其可以处理多语言语音生成,在没有训练的情况下克隆新说话者声音,支持跨语言克隆声音,合成带有情感的语音,并通过指令文本对语音输出进行精细调整。

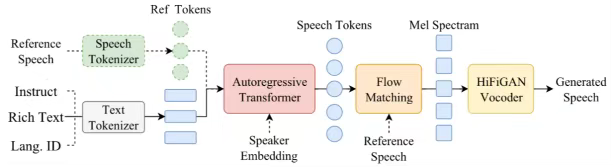

CosyVoice包含一个基于自回归transformer的语言模型用于把输入文本生成语音token;一个基于常微分方程的扩散模型flow matching model,从生成的语音token重建梅尔频谱;一个基于HiFiGAN的声码器从重建梅尔频谱中合成音频波形。整体过程涉及语音量化编码、自回归语音token生成、流匹配(flow matching)、HIFIGAN声码器、零样本学习、指令微调。

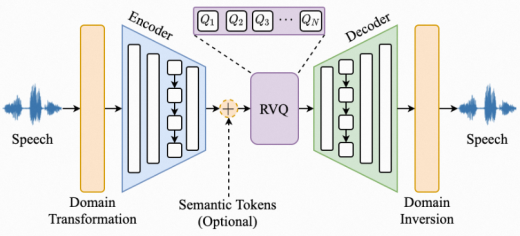

(1)语音量化编码

语音量化编码是将语音的连续信息与离散特征相结合的神经网络音频编码器,目的是为了对音频进行编码,压缩音频以便于传输音频。技术架构通常采用"Encoder-RVQ-Decoder",图2为语音量化编码示意图。其中"Encoder-RVQ"过程用于生成离散特征,例如音高、音量、音色等;"Decoder"将离散特征还原成音频。语音量化编码是语音信号处理的第一步,为后续处理和分析提供基础。

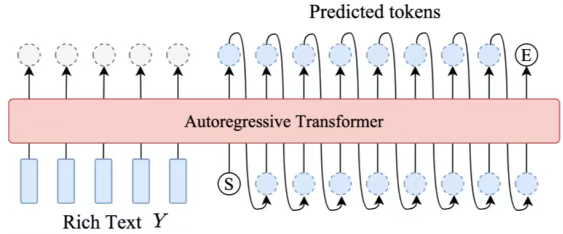

(2)自回归语音token生成

在模型训练阶段,CosyVoice使用教师强制策略来训练基于自回归Transformer 的语言模型(LM)。此过程中,将文本token和向左移位的语音token作为输入,以预测后续的语音token;推理阶段亦是如此。

(3)流匹配(flow matching)

流匹配(Flow Matching)是一种语音合成中使用的优化技术,能够对语音 token 与频谱图间的复杂映射关系加以学习。该技术一般用于对生成的声学特征(如 Mel 频谱)进行调整与优化,保证这些特征更自然、顺畅,也能更精准地体现原始语音信号的特点,让生成的梅尔频谱在动态范围和频域特性方面更接近自然语音,从而为最终的语音合成给予高质量的输入。

在CosyVoice中,依据提供的语音 token 与说话人 embedding 去估算条件概率 P(S|X, v, Sref),这里面 X 和 v 分别代表语音token和说话人embedding,S 和 Sref 分别表示目标和参考语音的梅尔频谱;接着,运用U-Net 确定从先验分布到所需分布的向量场,此向量场是从最优传输 ODE 中获取的;在推理阶段,通常仅需五至十次的迭代,就能产生让人满意的梅尔频谱。同时采用了无分类器指导(CFG)技术,并对 70%~100%的特征条件进行掩盖,以增强上下文学习的能力。

(4)HIFIGAN 声码器

在从预测的梅尔频谱图合成波形,作者使用改进的 HiFTNet 声码器,以支持流式生成。声码器接收来自前一阶段的梅尔频谱作为输入,然后生成连续的语音波形。

2、训练改进

我们现在业务场景的现在具有以下限制:1. 数据音频质量差 2.数据缺乏人工标注 3. 音频长度不统一。为了解决上述问题,小编思考设计了一个数据精筛的Pipeline链路,

我们将数据精筛的流程分为以下步骤:

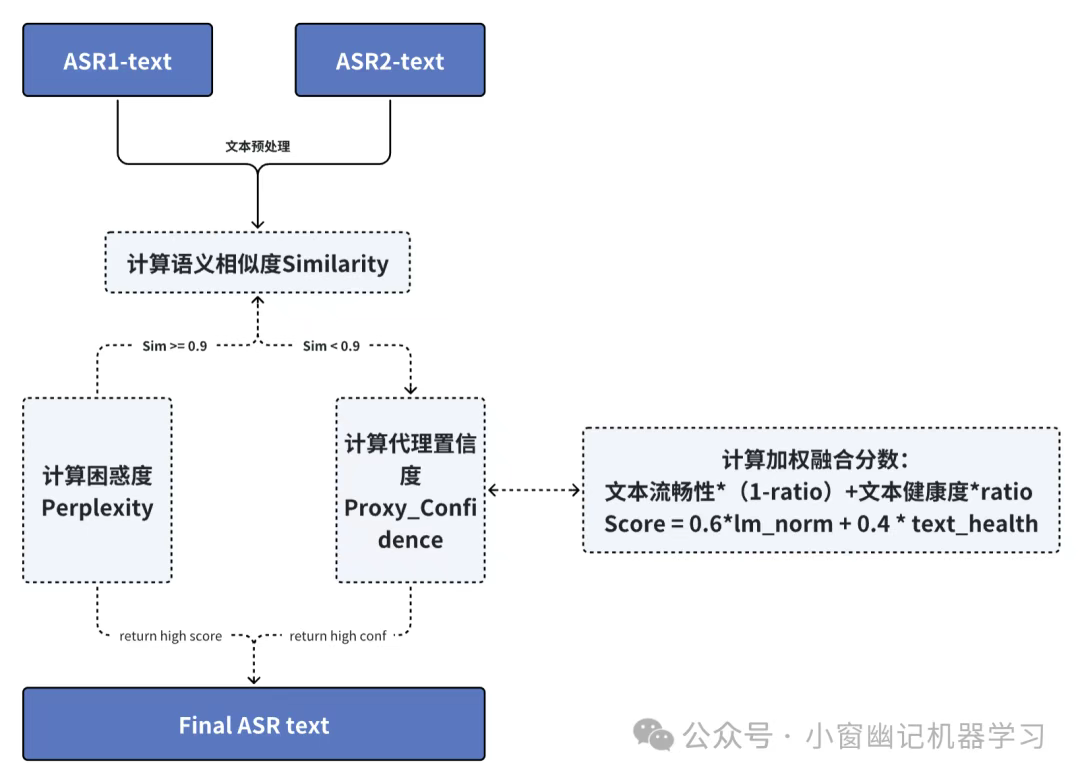

1、设计多ASR融合链路,融合多个ASR模型的结果(如Paraformer、Whisper、SenseVoice等)

2、标准化所有ASR文本结果,去除标点符号、语音标记等标签。

3、通过额外引入的LLM来计算ASR文本之间的语义相似度,若相似度高于0.9则计算文本困惑度,选择语义更加通顺的选项;若相似度低于0.9说明ASR文本差异较大,此时通过代理置信度筛选最佳文本。代理置信度的计算公式为Score = 文本流畅性 *(1-ratio)+文本健康度 * ratio ,通过文本的流畅性及文本健康度来判断。

根据上述思路完整链路流程图如下所示:

二、Step-Audio 2:端到端音频大语言模型,实现行业级理解与对话能力

论文地址:https://arxiv.org/abs/2507.16632

Github:https://github.com/stepfun-ai/Step-Audio2

| 特性维度 | 支持情况 | 说明 |

|---|---|---|

| 输入模态 | ✅ 原始音频 (主要且最核心) ✅ 文本指令 | 可直接处理原始音频波形,也能接受文本指令(例如“用悲伤的语调朗读这段话”)进行控制。 |

| 输出模态 | ✅ 语音输出 (主要且最核心) ✅ 文本输出 | 能生成富有情感和韵律的语音,也可根据任务需求(如语音识别)仅输出文本。 |

| 核心架构理念 | 端到端 (End-to-End) | 摒弃了传统的“ASR→LLM→TTS”串联流水线,实现了从原始音频直接到音频/文本输出的统一建模。 |

1、模型架构

真端到端多模态架构:Step-Audio 2 的架构“真”端到端,直接处理原始音频,保证对副语言信息和非人声信息的有效理解。一改传统的 ASR + LLM + TTS 三级结构,实现原始音频输入→语音响应输出的直接转换;这样架构更简单,能够有效减少时延。此外,技术上采用了连续输入+离散输出范式,能直接处理原始音频波形,避免特征提取造成的信息损失,还能通过离散音频 token 保证声音合成稳定性。最后,在语言建模层,Step-Audio 2 实现了文本与语音 token的 固定比例交错排列,确保文本-语音模态高度对齐,显著提升模型的智商上限。

CoT 推理结合强化学习:团队首创了端到端语音模型中的深度推理能力,能对情绪、副语言、音乐等非文字信号进行精细理解、推理,实现高情商回复。

多模态知识检索增强:模型支持调用 web 搜索,有助于模型解决幻觉问题,同时支持音频检索,让模型可以通过任意自然语言描述来无缝切换音色风格,实现百变音色。

2、模型评测

分别评测了音频模型里主流的综合能力评测榜单。发现 Step-Audio 2 在 AISHELL-2(中文语音识别)、URO-Bench Basic-zh(中文综合语音对话)、LibriSpeech(英文语音识别) 等多个语音任务中均取得 SOTA 成绩,相应表现超越了 GPT-4o Audio、Gemimi-2.5-Pro、Qwen2.5-Omni 等国内外主流模型。

在包含11类副语言信息的测试中,准确率达到了76.55%,远超其他模型。具体来说,它能精准识别:

说话人的性别和年龄特征、声音的音色和音高、表达时的情感状态、说话的节奏和速度、独特的说话风格、背景场景和事件声音

模型比较如下,Step-Audio 2在"情感"和"风格"两个维度表现尤为突出,说明它能真正理解并生成带有情感色彩的语音。

三、级联方案 vs 端到端模型

多模态语音大模型中的 TTS(Text-to-Speech)级联 是一种传统的语音生成架构,其核心是将语音合成任务拆解为多个独立模块串联执行,而非端到端直接处理。以下是具体解析:

- 级联架构的定义

在语音AI领域,级联方案通常指 ASR(语音识别) + LLM(语言模型) + TTS(语音合成) 的三段式流程:

- ASR模块:将用户语音输入转为文本(Speech-to-Text)。

- LLM模块:处理文本生成回复(如对话理解、意图识别)。

- TTS模块:将回复文本转为语音输出(Text-to-Speech)。

这种“语音→文本→语音”的级联设计,本质是通过中间文本格式桥接不同模态的转换。

- 级联的优缺点

优势

• 模块化开发:各模块可独立优化(如ASR专注识别准确率,TTS专注音色自然度)。

• 技术成熟:ASR和TTS技术发展较早,工程落地经验丰富。

• 可控性强:文本中间层便于插入人工规则(如客服话术审核)。

缺陷

• 延迟高:多模块串联导致累积延迟(通常超过1秒),影响交互流畅性。

• 信息丢失:语音情感、语调等非文本信息在转录过程中易丢失。

• 打断困难:僵化的轮流交互模式难以处理用户实时打断。

- 级联 vs 端到端

• 级联方案:依赖文本中介,适合对解释性要求高的场景(如客服日志存档)。

• 端到端模型(如语音原生STS模型):直接处理语音输入输出,延迟更低(300ms内),保留情感和上下文,但训练复杂度高。

- 典型应用场景

• 智能客服:需严格审核文本回复时,级联架构更安全。

• 实时翻译:传统级联方案需优化模块间数据传输以减少延迟。

总结:级联TTS是多模态语音模型的经典实现方式,虽面临端到端技术的挑战,但在可控性和模块化方面仍有不可替代的价值。

四、ai-voice-agents-2025-update

a16z 报告地址:https://a16z.com/ai-voice-agents-2025-update/Gamma

演示文件地址:https://gamma.app/docs/a16z-AI-Voice-Update-2025–ttkorld8iy6wfnj

作者 X 账号:https://x.com/omooretweets

Reference

[1] 文本转语音(TTS)实战:以CosyVoice2为例 | 附代码

[2] 级联vs端到端、全双工、轮次检测、方言语种、商业模式…语音 AI 开发者都在关心什么?丨Voice Agent 学习笔记

[3] 【深度解读 a16z 2025 最新报告】AI Voice Agent 革命:技术重构商业,声波重塑世界

[4] Introducing gpt-realtime and Realtime API updates for production voice agents

[5] Step-Audio 2:端到端音频大语言模型,实现行业级理解与对话能力