前端技术演进录:从 AI 革命到架构新生

目录

AI 重塑开发范式:从工具到驱动者

框架与工具链:性能与全栈的博弈

渲染架构进化:边缘与混合模式崛起

新交互技术突破:GPU 与 WASM 赋能

WebGPU:重塑前端图形渲染底层逻辑

1. 架构层面:摆脱 OpenGL 兼容性束缚,直连现代 GPU 核心

2. 功能层面:引入计算着色器,拓展 GPU 应用边界

3. 内存管理:精细化控制资源生命周期,降低内存泄漏风险

WebAssembly(WASM):突破 JS 性能天花板

跨平台技术质变:轻量化与融合架构

桌面端

移动端

开发者能力模型转型:三维竞争力重构

技术纵深成为护城河

跨界能力决定天花板

AI 协作技能成为分水岭

AI 已能生成 95% 的代码,WebGPU 渲染性能超越原生,边缘计算将 TTFB 压缩至 50ms 以内——我们正站在前端技术革命的临界点。本文将深度解析 2025 年前端领域的六大变革趋势,探讨技术浪潮下开发者的全新机遇与挑战。

AI 重塑开发范式:从工具到驱动者

AI 已从代码补全工具升级为全流程开发代理。2025 年的典型案例震撼业界:某团队通过 Claude Code 生成 95% 的 macOS 应用代码(总量 2 万行),仅手动编写 5% 核心逻辑,开发周期从 3 个月压缩至 1 周。这种颠覆性变革源于三个关键突破:

- 自然语言编程范式:开发者只需输入 “实现支持暗黑模式的登录页,符合 iOS 设计规范” 等指令,AI 直接生成完整 SwiftUI/React 代码。

- 多模态融合:Figma 设计稿自动转 React/Vue 组件成为标配,UI 到代码的链路缩短 70%。

- 闭环自动化:AI 构建 “生成→编译→错误修复→优化” 的无人值守工作流,如自动生成含缓存策略的 GitHub Actions 配置。

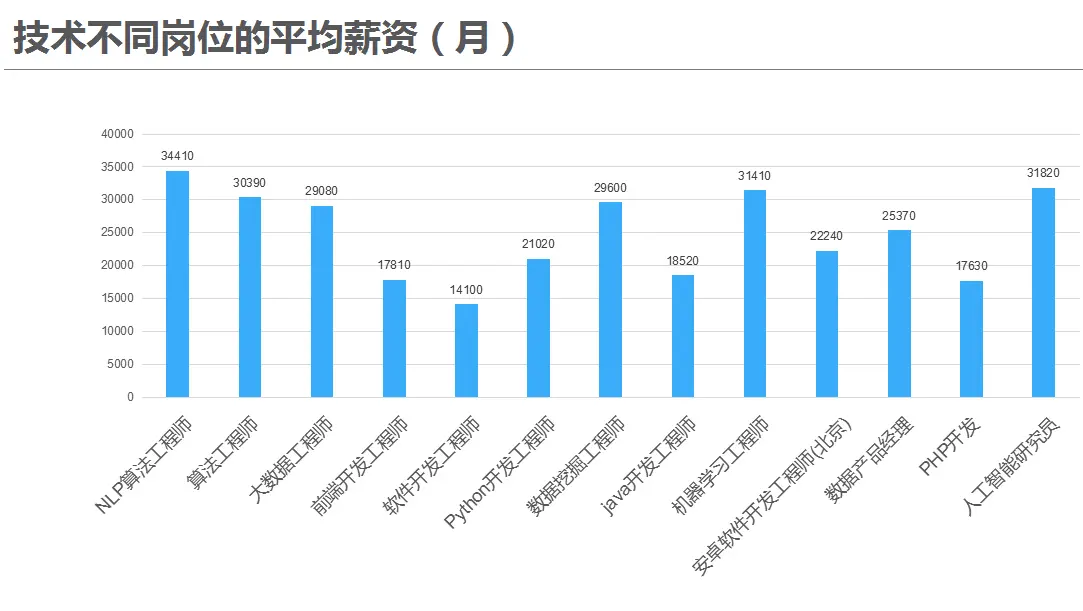

开发者角色正从代码生产者转向 AI 指挥官。核心能力迁移为:需求表达(场景 + 约束描述)、上下文工程(编写 AI 可读的 CLAUDE.md 规范)、架构决策(人工干预关键逻辑)。薪资分化加剧 —— 掌握 AI 协作的开发者薪资高出传统岗位 35%。

框架与工具链:性能与全栈的博弈

编译型框架正颠覆运行时方案。Svelte 5 通过编译器将运行时开销趋近于零,性能对标原生 DOM 操作;Vue 的 Vapor 模式绕过虚拟 DOM 直接操作真实节点,性能提升 40%。React 19 则强化服务端组件(RSC),将数据请求移至服务端,减少客户端 JS 体积达 30%。

全栈框架成为中后台首选:

- Next.js 15:深度整合边缘计算,API 路由 + 数据库连接 + 身份验证开箱即用。

- Remix:优化服务端数据加载,实现 “路由即数据端点” 的范式。

- T3 Stack(Next.js + tRPC + Tailwind + Prisma):成为初创企业全栈标配。

构建工具进入 Rust 时代:

- Turbopack(Rust 驱动):比 Webpack 快 10 倍,增量编译秒级完成。

- Vite 6:采用 Rolldown 替代 Rollup,ESM 原生加载实现毫秒级 HMR。

- Bun:作为全栈工具链,开始替代 Node.js 基础环境。

渲染架构进化:边缘与混合模式崛起

边缘计算下沉重构渲染管线。Cloudflare Workers、Vercel Edge Functions 将动态内容渲染移至全球节点,TTFB(首字节时间)降至 50ms 内。京东采用边缘渲染后,页面加载速度提升 30%,开发周期缩短 40%。

混合渲染范式终结 “CSR/SSR 二选一” 困境:

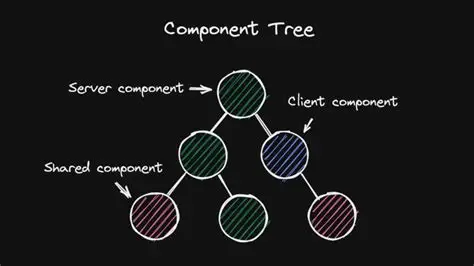

- React Server Components(RSC):服务端组件处理数据,客户端组件处理交互,减少不必要的水合(Hydration)。

- Astro 岛屿架构:按需激活交互组件,首屏性能提升 30%。

- Qwik 的延迟加载:实现 “瞬时交互”,首次点击无需等待 JS 加载。

新交互技术突破:GPU 与 WASM 赋能

WebGPU:重塑前端图形渲染底层逻辑

WebGPU 作为取代 WebGL 的新一代图形标准,其性能飞跃的核心源于对现代 GPU 架构的深度适配,彻底解决了 WebGL 长期存在的性能瓶颈与功能局限。从技术原理来看,WebGPU 主要通过以下三方面实现突破:

1. 架构层面:摆脱 OpenGL 兼容性束缚,直连现代 GPU 核心

WebGL 基于 2003 年发布的 OpenGL ES 标准,为兼容旧硬件保留了大量冗余逻辑,无法充分利用现代 GPU 的 “多核并行” 与 “异步计算” 能力。而 WebGPU 直接对标 Vulkan、Metal、Direct3D 12 等底层图形 API,采用 “设备(Device)- 队列(Queue)- 命令缓冲(Command Buffer)” 的三层架构:

- 设备(Device):作为 WebGPU 与硬件的桥梁,负责初始化 GPU 资源、管理内存分配,支持同时连接多个 GPU(如集成显卡与独立显卡),可根据场景动态切换渲染设备;

- 队列(Queue):分为 “渲染队列” 与 “计算队列”,支持并行调度任务 —— 例如在渲染 3D 模型的同时,通过计算队列异步处理物理碰撞模拟,避免传统单线程渲染的阻塞问题;

- 命令缓冲(Command Buffer):开发者可预先将绘制指令、资源绑定等操作封装为命令缓冲,再提交至队列执行,实现 “指令预编译” 与 “批量执行”,减少 CPU 与 GPU 之间的通信开销。

以 Three.js r160 中的 WebGPU 渲染为例,通过命令缓冲批量提交顶点数据绘制指令,CPU 单次通信即可完成 1000 个三角形的渲染调度,而 WebGL 需逐次发送指令,通信耗时是 WebGPU 的 8 倍以上。

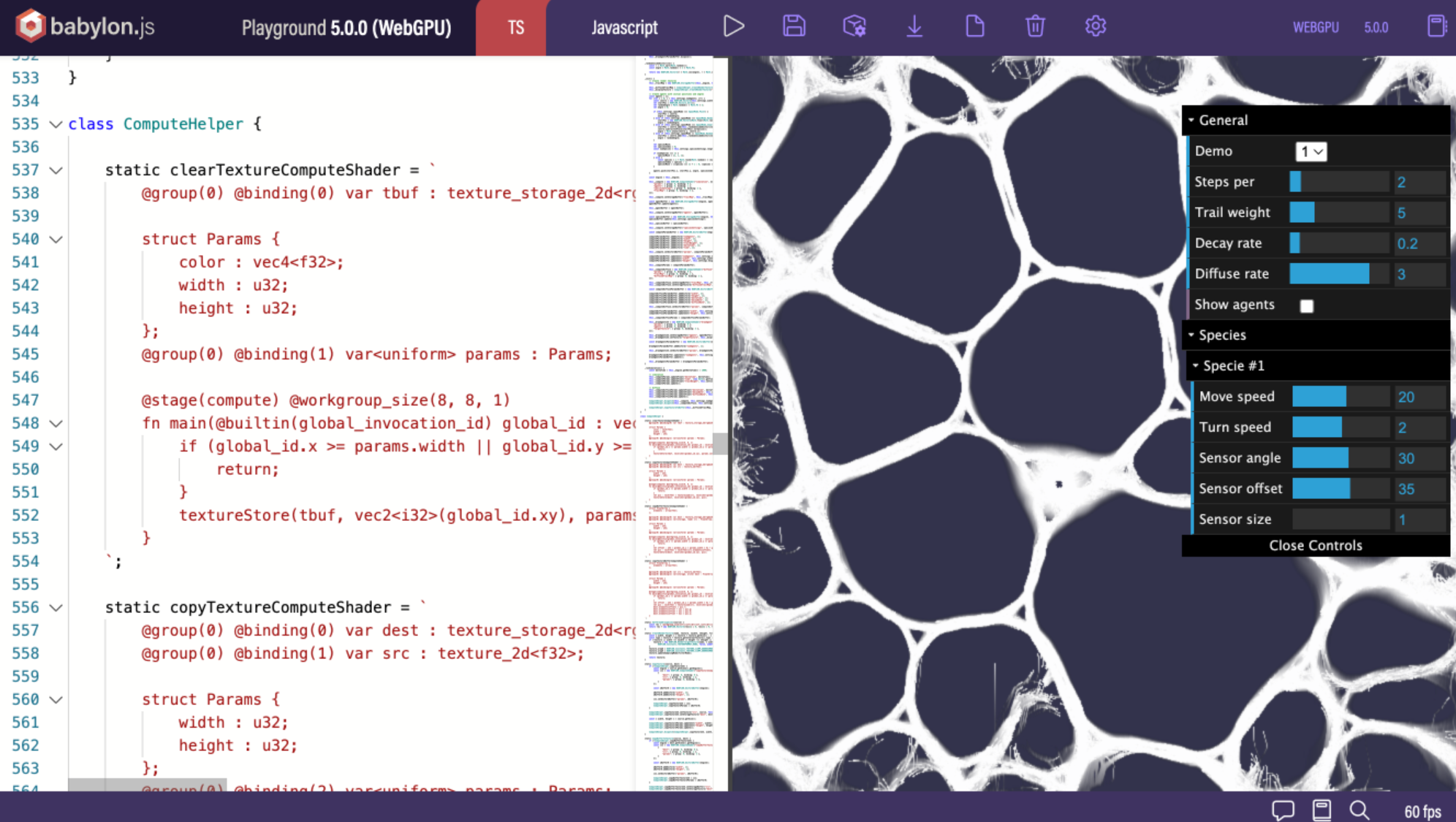

2. 功能层面:引入计算着色器,拓展 GPU 应用边界

WebGPU 首次在前端引入 “计算着色器(Compute Shader)”,打破了 WebGL 仅能处理图形渲染的局限,让 GPU 的并行计算能力可直接用于非图形任务。计算着色器基于 “工作组(Workgroup)” 模型,将任务拆解为大量并行执行的 “工作项(Work Item)”,每个工作项可独立访问 GPU 显存中的数据,特别适合处理矩阵运算、数据排序、图像滤镜等高度并行的场景:

- 在 AR 试穿场景中,计算着色器可实时处理 100 万 + 个顶点的布料模拟,计算速度比 CPU 实现快 20 倍,确保虚拟衣物与人体动作的无缝贴合;

- 在浏览器端视频编辑工具中,通过计算着色器并行处理每一帧的色彩调整,4K 视频的滤镜渲染速度可达 60fps,而 WebGL 需依赖纹理采样间接实现,帧率仅能维持在 15fps 左右。

3. 内存管理:精细化控制资源生命周期,降低内存泄漏风险

WebGL 采用 “隐式内存管理”,开发者无法直接控制纹理、缓冲区等资源的释放时机,容易因资源未及时回收导致内存泄漏。WebGPU 则引入 “显式内存管理” 机制:

- 所有 GPU 资源(如缓冲区、纹理、采样器)均需通过 “资源描述符(Resource Descriptor)” 明确定义类型、用途与内存模式(如 “设备本地内存” 用于高频访问数据,“主机可见内存” 用于 CPU 与 GPU 数据交互);

- 支持 “资源引用计数” 与 “显式销毁(destroy () 方法)”,开发者可根据业务逻辑主动释放不再使用的资源,例如在 3D 场景切换时,即时销毁前一场景的纹理资源,内存占用可降低 60% 以上。

WebGPU 凭借上述技术特性,性能较 WebGL 提升 5 倍,在 Three.js r160 全面适配后,推动三大场景爆发:

- 3D 电商:AR 试穿、产品可视化。某运动品牌采用 WebGPU 实现的 AR 鞋履试穿功能,虚拟鞋模的纹理细节渲染精度提升 3 倍,试穿时的动作延迟从 150ms 降至 30ms,用户转化率提升 25%。

- 科学计算:浏览器内分子结构模拟。某科研团队开发的 Web 端分子模拟工具,通过 WebGPU 计算着色器并行处理 10 万个原子的相互作用力,模拟速度较 CPU 版本快 30 倍,支持实时调整分子参数并可视化结果。

- 工业 HMI:网易 CAD 协作工具实现 Web 端实时渲染。该工具采用 WebGPU 渲染复杂机械图纸,支持 10 万 + 线条的实时缩放与旋转,操作流畅度媲美桌面端 CAD 软件,同时支持 20 人在线协同编辑,延迟控制在 100ms 内。

WebAssembly(WASM):突破 JS 性能天花板

WebAssembly(WASM)作为二进制指令格式,可将 C、C++、Rust 等编译型语言的代码转换为浏览器可执行的模块,解决了 JavaScript 在计算密集型场景下的性能短板,2025 年已进入生产级应用阶段:

- FFmpeg WASM 版:支持浏览器内视频转码。某在线视频平台采用 FFmpeg WASM 实现 “客户端预处理” 功能,用户上传视频时可在本地完成格式转换与压缩,服务器带宽占用降低 40%,转码等待时间缩短 60%。

- TensorFlow.js + WASM:实现边缘 AI 推理。某智能安防企业开发的 Web 端人脸检测工具,通过 WASM 优化 TensorFlow.js 模型加载流程,模型初始化时间从 8 秒降至 2.5 秒,同时推理速度提升 300%,支持每秒处理 20 帧视频流。

2023 年 WASM 使用量同比增长 300%,预计 2026 年成为高性能应用标配。随着 WASM 接口(如 WebAssembly System Interface,WASI)的完善,未来可直接访问文件系统、网络接口等系统资源,进一步拓展前端应用的能力边界。

跨平台技术质变:轻量化与融合架构

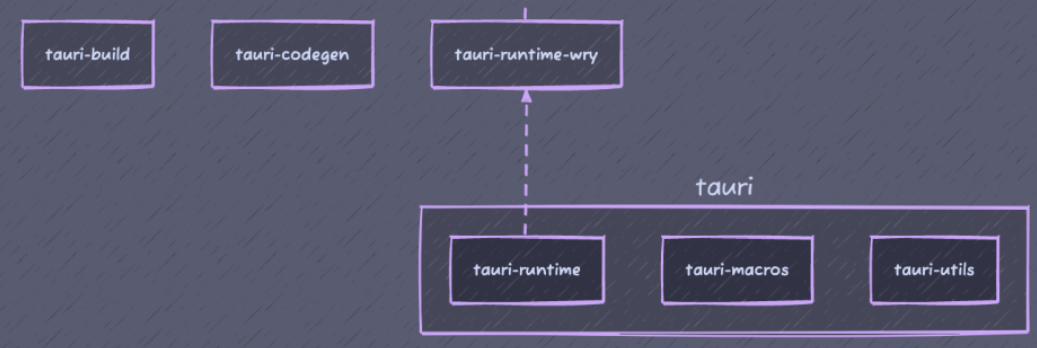

桌面端

Tauri(Rust + WebView)取代 Electron,应用体积缩减 80%,安全性增强。某金融应用采用 Tauri 后,安装包从 180MB 降至 35MB,启动时间从 3 秒缩短至 0.8 秒,同时通过 Rust 的内存安全特性,避免了 Electron 应用常见的内存泄漏与安全漏洞。

移动端

- React Native Fabric 引擎:优化 JS 与原生通信,代码复用率超 90%。Fabric 引擎采用 “异步渲染管线” 与 “共享内存” 技术,将 JS 层面的 UI 指令转换为原生渲染操作的延迟从 200ms 降至 50ms,支持复杂列表的平滑滚动(帧率稳定 60fps)。

- Flutter 5.0:统一 WebGL 渲染,实现像素级多端一致。Flutter 5.0 优化了 “Skia 渲染引擎” 与 WebGL 的适配逻辑,解决了此前在 Web 端渲染模糊、动画卡顿的问题,某社交应用采用 Flutter 开发的 “多端统一聊天界面”,在 iOS、Android、Web 端的 UI 一致性达到 99%,研发成本降低 35%。

- 小程序容器技术(如 FinClip):支持 iOS/Android/ 车机 / IoT 四端统一,某物流企业借此降低 30% 研发成本。该企业通过 FinClip 容器将 “货物跟踪”“司机调度” 等功能封装为小程序,无需为不同设备单独开发原生应用,同时支持动态更新小程序,功能迭代周期从 2 周缩短至 1 天。

超级应用(SuperApp)生态通过小程序聚合服务:微信 / 支付宝整合第三方模块(支付、地图、外卖),形成 “平台 + 生态” 模式,某零售品牌接入微信小程序生态后,三个月内用户增长 40%,线上订单占比从 30% 提升至 65%。

开发者能力模型转型:三维竞争力重构

技术纵深成为护城河

- 源码级改造:手写 React 调度器简化版,参与开源社区优化。某大厂前端团队通过分析 React 调度器的 “时间切片” 逻辑,定制适合自身业务的调度策略,将复杂表单的渲染卡顿率从 15% 降至 2%,并将优化方案贡献至 React 开源仓库。

- 性能全链路监控:从 LCP 加载时延到 Long Task 运行时卡顿分析。某电商平台搭建 “前端性能监控平台”,实时采集用户端的 LCP(最大内容绘制)、FID(首次输入延迟)、CLS(累积布局偏移)等核心指标,结合用户行为日志定位性能瓶颈,页面加载速度提升 28%,用户留存率提升 12%。

- 编译原理实践:定制 Babel 插件、SWC 工具链优化。某工具类产品团队开发自定义 Babel 插件,实现 “业务代码按需裁剪”,将生产环境 JS 体积减少 25%,同时采用 SWC 替代 Babel 进行代码转译,构建速度提升 3 倍。

跨界能力决定天花板

- 服务端:Node.js 性能诊断、NestJS 框架。某出行平台前端团队掌握 Node.js 内存快照分析与 CPU profiling 技术,定位并修复了服务端 API 的内存泄漏问题,API 响应时间从 500ms 降至 80ms;同时使用 NestJS 开发 “用户行程分析” 服务,实现前后端技术栈统一,研发效率提升 40%。

- 数据科学:Pandas 分析 + D3.js 可视化。某金融科技公司前端团队通过 Pandas 处理用户交易数据,识别出 “高频小额转账” 等异常行为模式,再通过 D3.js 构建实时数据看板,帮助风控团队将欺诈识别率提升 30%。

- Rust 基础:用于 WASM 模块开发及工具链贡献。某视频技术团队采用 Rust 开发 WASM 版视频编解码模块,性能较 C++ 版本提升 15%,同时参与 Rust 开源社区的 WASM 工具链优化,修复了内存对齐相关的 bug,被纳入官方稳定版本。

AI 协作技能成为分水岭

- 提示工程(Prompt Engineering):精准描述需求场景。某企业前端团队总结 “AI 代码生成提示模板”,包含 “业务场景(如电商购物车)、技术栈(如 Vue 3 + TypeScript)、性能要求(如支持 1000 条数据渲染)、兼容性约束(如支持 IE 11)” 等维度,AI 生成代码的正确率从 60% 提升至 90%,减少 50% 的手动修改时间。

- 模型微调:教会 AI 理解私有业务逻辑。某大型企业基于开源 LLM 模型(如 LLaMA 3),使用内部业务代码与文档进行微调,让 AI 掌握 “订单状态流转”“库存计算” 等私有逻辑,生成的业务代码适配度从 40% 提升至 85%,新功能开发周期缩短 30%。

前端技术的终极矛盾:当 AI 生成代码、低代码平台完成 80% 标准化开发时,开发者的价值锚点已从 “编写量” 转向 “系统设计能力”。腾讯的微前端架构师通过模块联邦管理 20 个子应用,确保支付宝级体量的应用仍能每日更新;特斯拉工程师用 Rust 重写车载 UI 核心层,将渲染延迟压缩至 8ms—— 这些案例揭示了一个残酷而清晰的未来:唯有掌控 “不可自动化的复杂性”,才能穿越技术变迁周期。

在这场技术革命中,前端开发者唯有主动拥抱变革,构建多维能力体系,才能在浪潮中领航。未来已来,代码正在重写世界,而我们,就是执笔者。