具身智能常用【数据集】汇总篇

本文汇总了【33】个具身智能领域常用的数据集,涵盖抓取与放置、非抓取操作、开关操作、可变形物体处理、组装任务、家务与家庭环境操作、精细操作及移动操作等核心任务类别。每个数据集均提供下载地址及原文链接(详见后文)

每个类别的核心任务特征有:

- 抓取与放置:最基础的机器人操作任务,涉及拾取物体并移动到目标位置,是多数操作的核心环节。

- 非抓取操作(推、拨等):不通过夹持器抓取,而是通过推、拨等方式移动物体的操作。

- 开关操作(门、抽屉、阀门等):针对铰接式物体(门、抽屉、柜门等)的开启 / 关闭,需精确控制力和角度。

- 可变形物体处理:针对柔软、易变形物体(布料、线缆、面团等)的操作,需适应物体形态变化。

- 组装任务:将多个零件组合成整体,需多阶段精细操作,依赖空间感知和力控制。

- 家务与家庭环境操作:模拟家庭场景中的日常任务,涵盖厨房、客厅等环境的多样化交互。

- 精细操作(高精度任务):要求毫米级精度或高接触力控制的任务,如精密装配、动态交互。

- 移动操作(结合移动与操作):机器人在移动过程中完成操作任务,需协调导航与机械臂动作。

欢迎补充纠正

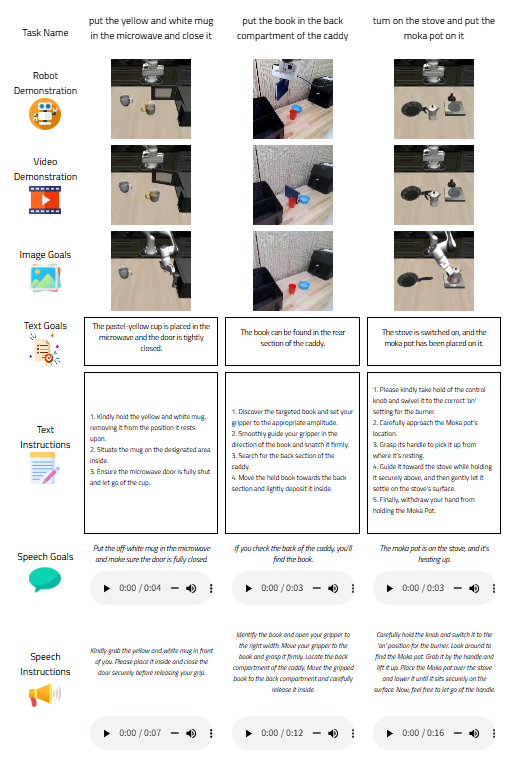

1. Mutex_Dataset(CoRL2023)

数据集包含100 个基于LIBERO-100的模拟任务和50 个真实任务,每个任务分别标注 50 个和30 个演示(行号按任务名称排列)。

并且为每个任务分别标注了以下六种模态(行号从上到下排列):视频演示、图像目标、文本目标、文本说明、语音目标和语音说明。

数据集地址:https://utexas.app.box.com/s/wepivf85cgini0eqpho9jae9c6o99n4e

原文链接:https://arxiv.org/pdf/2309.14320

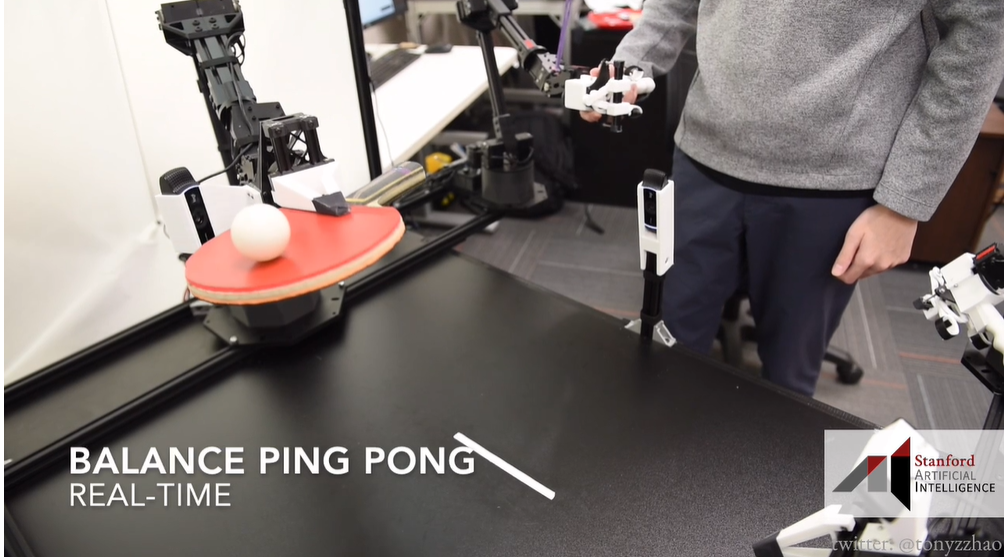

2. ALOHA(RSS2023)

ALOHA 是一款用于双手遥控的低成本开源硬件系统。该系统预算仅 2 万美元,能够远程操作诸如穿扎带之类的精确任务、诸如玩乒乓球之类的动态任务,以及诸如在 NIST 2 号板上组装链条之类的高接触性任务。

数据集地址:https://github.com/tonyzhaozh/aloha

原文链接:https://arxiv.org/pdf/2304.13705

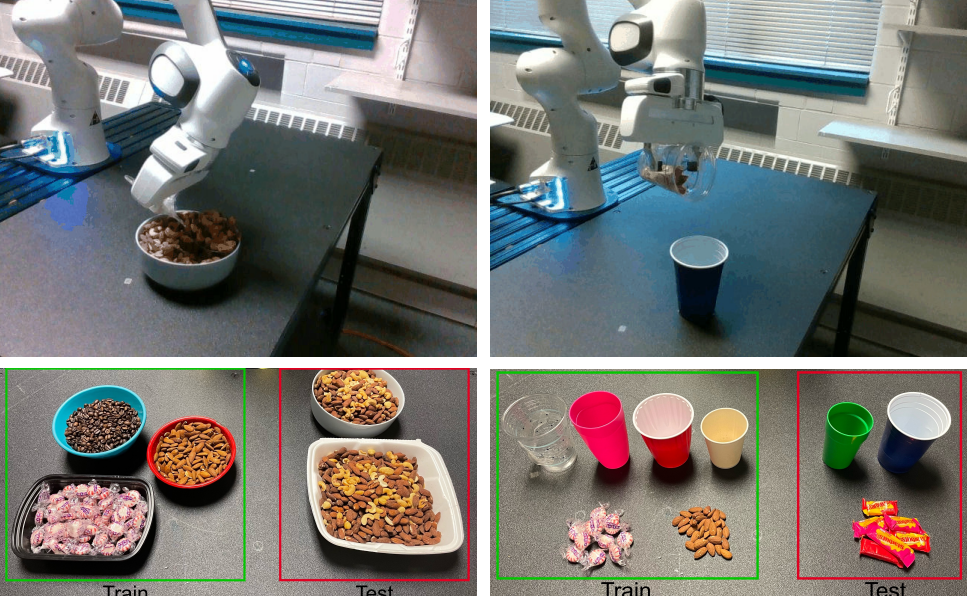

3. Berkeley-UR5

Berkeley-UR5 是一个自适应机器人操作研究平台,利用 UR5 机器人和模仿学习来掌握可变形物体处理和人机协作任务。

数据集包括 4 个机器人操作任务:在容器之间简单地拾取和放置毛绒玩具、扫布、堆叠杯子,以及需要精确抓取和 6 自由度旋转的瓶子的更困难的拾取和放置。

数据集地址:https://sites.google.com/view/berkeley-ur5/home

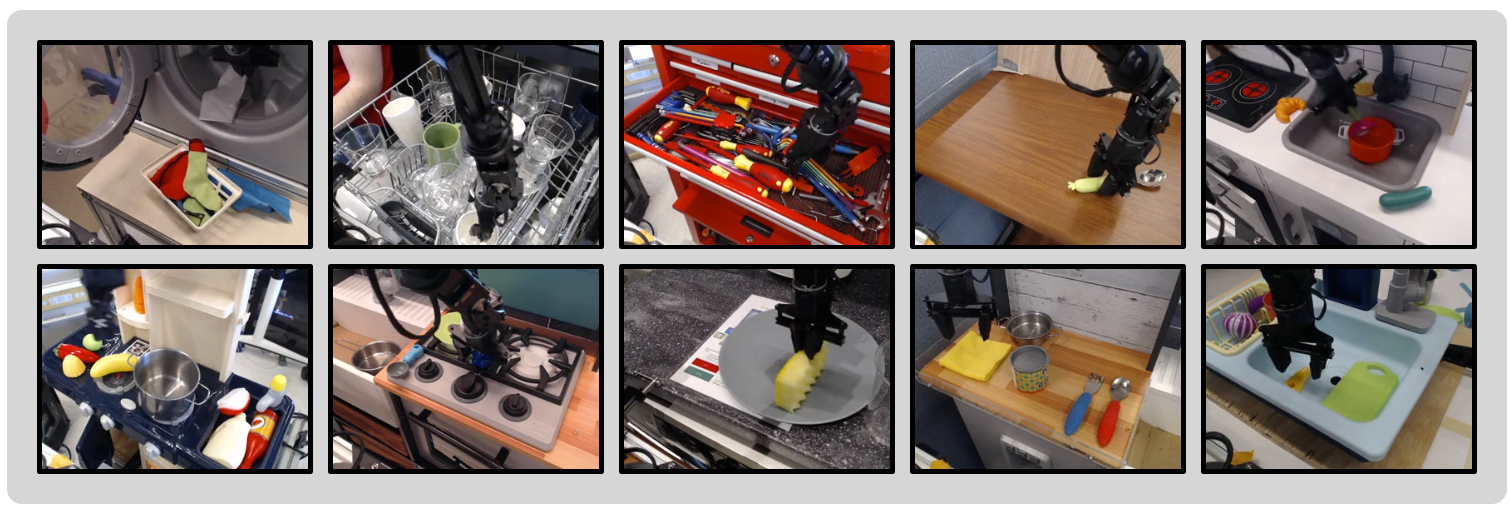

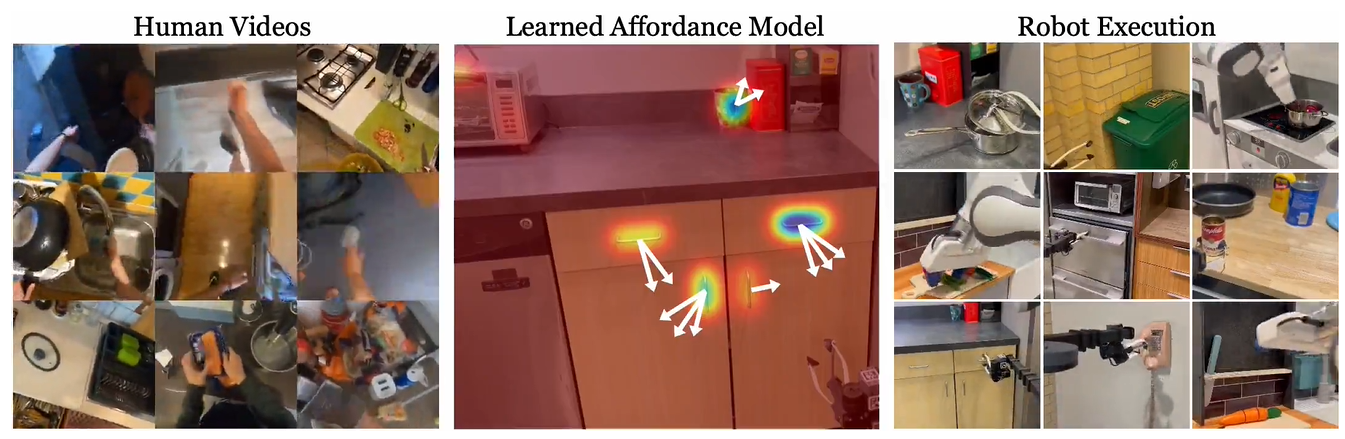

4. BridgeData V2

为了支持广泛的泛化能力,该数据集收集了多种环境下各种任务的数据,这些环境中的物体、相机姿态和工作空间位置各不相同。每条轨迹都标注了与机器人正在执行的任务相对应的自然语言指令。

- 60,096 条轨迹:包含 50,365 次远程操作演示,以及通过脚本化的拾放策略部署 9,731 个产品;

- 24 种环境

- 13项技能

BridgeData V2 中的 24 种环境分为 4 类。大部分数据来自 7 个不同的玩具厨房,其中包含水槽、炉灶和微波炉等各种设备的组合。其余环境则来自不同来源,包括各种桌面、独立的玩具水槽、玩具洗衣机等等。

数据集地址:BridgeData V2

原文链接:https://arxiv.org/pdf/2308.12952

5. Multi-Stage Cable Routing(T-RO2024)

该数据集包含两种训练数据:

低级别策略训练数据:包含 1442 条人类远程操作机器人进行电缆布线的轨迹。每条轨迹约含 20 个时间步,轨迹时长约 3 - 5 秒。这些数据用于训练低级别单夹子电缆布线策略,让机器人学习插入电缆的基本技能。

高级别策略训练数据:由 257 条机器人在执行原语之间的观察轨迹组成,每个时间步对应一次观察和人类选择的原语索引,完整轨迹约 1 分钟。

数据集地址:https://sites.google.com/view/cablerouting/data

原文链接:https://arxiv.org/pdf/2307.08927

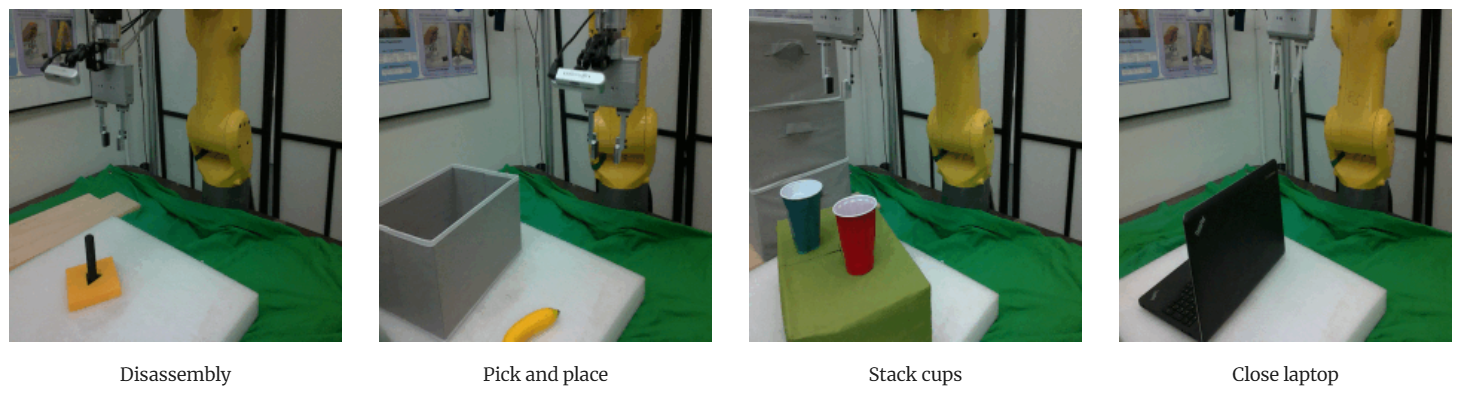

6. Fanuc Manipulation

FANUC 操作数据集基于视觉的机器人模仿学习策略、微调视觉表示模型、训练生成模型,根据任务指令生成机器人动作等。它是在FANUCMate200iD机器人上收集的,同时提供了RGB视频(第三人称视角和自我中心视角)、机器人轨迹(关节值和动作值)以及语言指令。

用于执行各种操作任务。例如,打开抽屉、拾取物体、关门、关闭电脑以及将物体推到指定位置。

数据集地址:https://sites.google.com/berkeley.edu/fanuc-manipulation

7. bc z robot(CoRL2021)

BC-Z 是一个大规模机器人模仿学习数据集,能够通过语言或视频调节对未见过的任务进行零样本泛化,具有 25K+(25,877)个真实世界操作演示,涵盖 100 种不同的 manipulation 任务。

数据集地址:https://sites.google.com/view/bc-z/home?pli=1

原文链接:https://arxiv.org/pdf/2202.02005

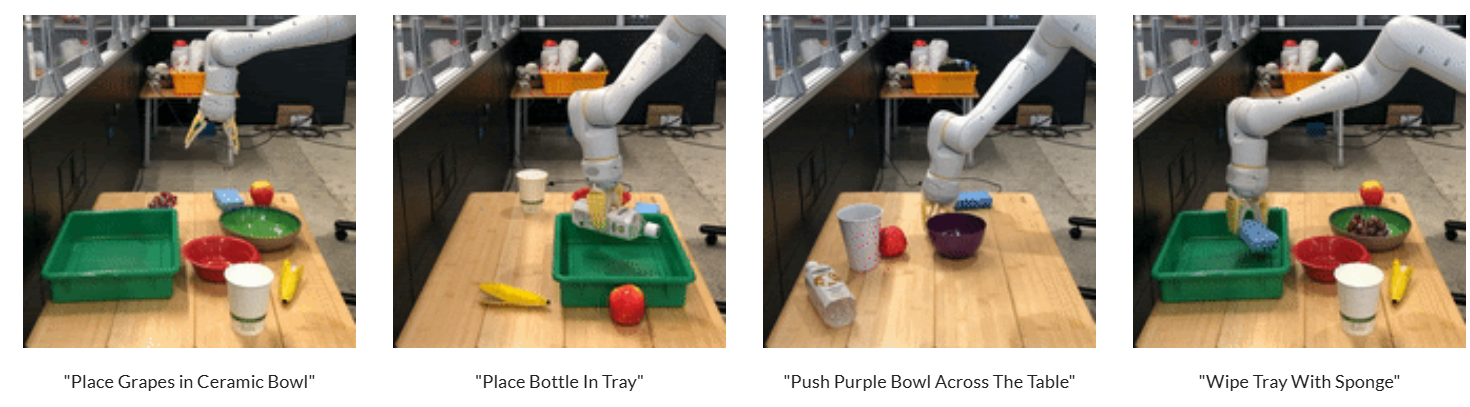

8. Push-T(RSS2023)

扩散策略数据集可用于训练基于扩散的机器人操作视觉运动策略。它涵盖 12 项任务,包括精确的 Push-T 操作,并支持通过迭代去噪生成动作。基于此数据集训练的策略的成功率提高了 46.9%,并具备实时推理能力。

处理任务包括:机器人将T形块推到固定的目标位姿,然后移动到固定的出口区域。

数据集地址:https://diffusion-policy.cs.columbia.edu/data/

原文链接:https://arxiv.org/pdf/2303.04137v4

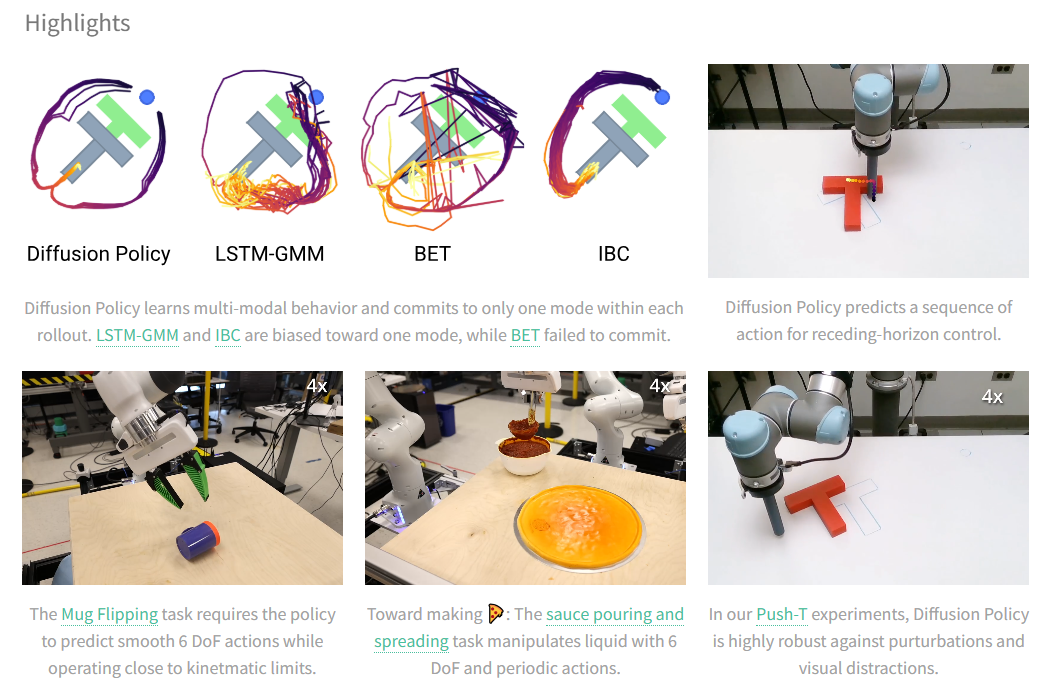

9. PlayFusion(CoRL2023)

Play-Fusion 通过扩散模型和离散技能瓶颈从非结构化游戏数据中学习机器人技能,从而实现跨不同任务的可解释和可概括的行为合成。

机器人将完成三个复杂的场景:一个烤架,上面摆放着烤面包机、平底锅等各种烹饪用具。

- 完成拾取、打开、放置和关闭等动作

- 摆放餐桌,移动盘子、杯子和餐具

- 将碗碟放入水槽、洗碗机、手持杯等

数据集地址:PlayFusion: Skill Acquisition via Diffusion from Language-Annotated Play

原文链接:https://openreview.net/pdf?id=afF8RGcBBP

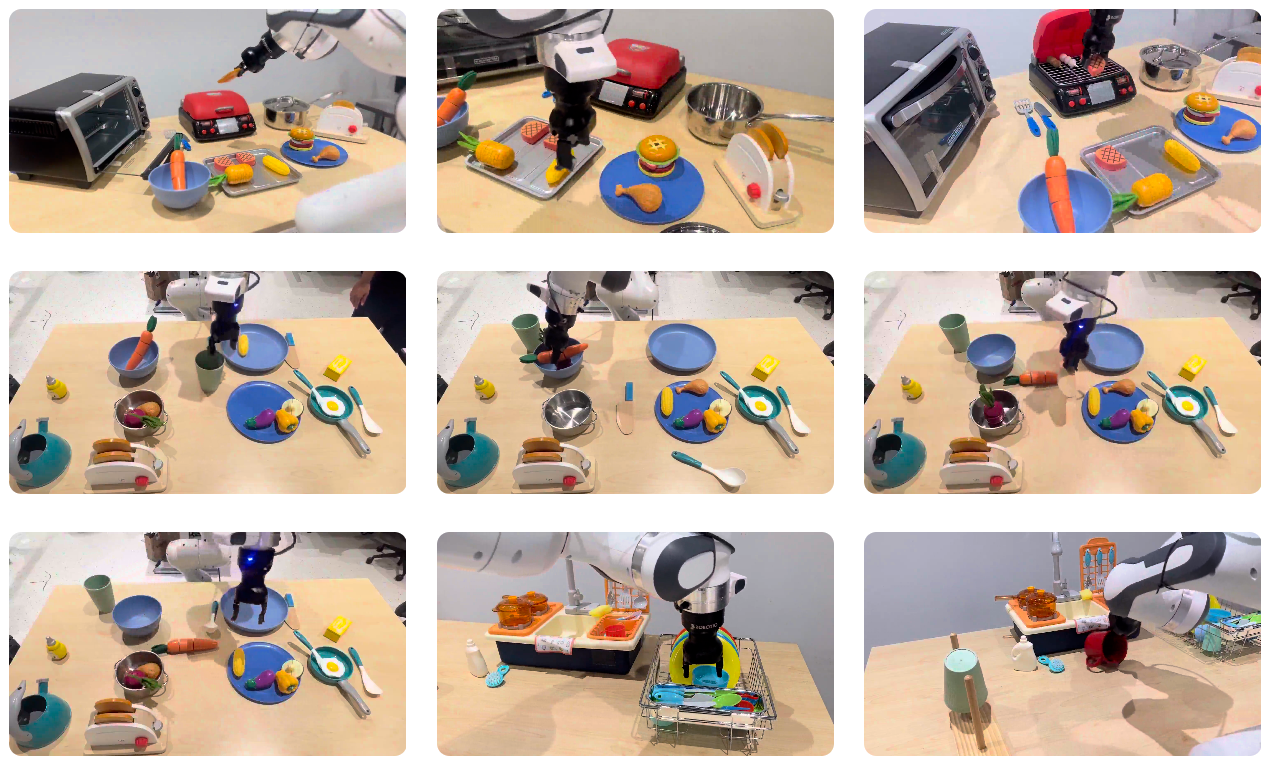

10. CMU VRB(CVPR2023)

VRB 从人类视频中学习视觉可供性,以实现跨任务机器人策略转移,并通过最少的演示在 10 多个真实任务中得到验证。

任务:机器人与不同的家庭环境互动。

数据集地址(暂未开源):VRB: Affordances from Human Videos as a Versatile Representation for Robotics

原文链接:https://robo-affordances.github.io/resources/vrb_paper.pdf

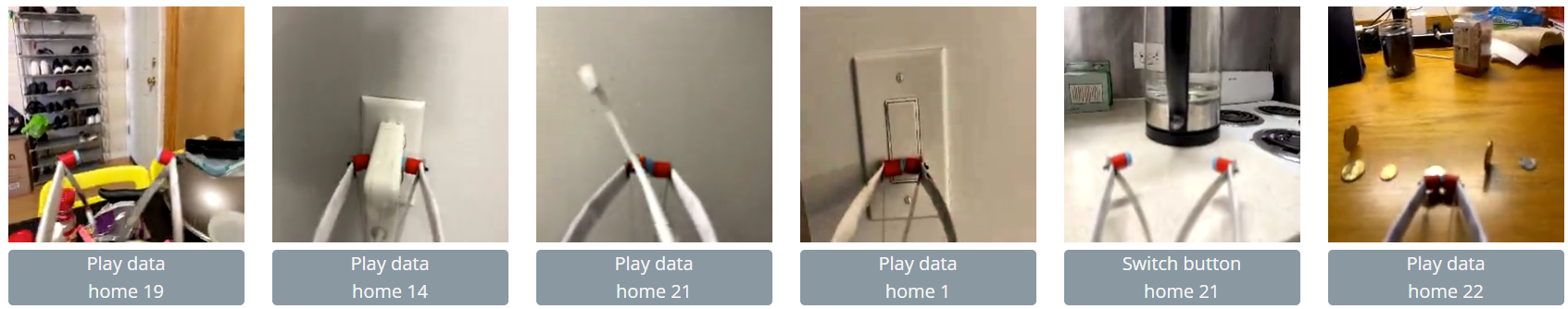

11. Dobb·E

Dobb-E 让机器人能够通过用户演示和自适应预训练表征 (HPR) 在 20 分钟内学习家务。该平台已在 109 个真实家居任务中验证,成功率为 81%。Dobb-E 开源数据、模型和硬件设计,旨在推动家用机器人技术的普及。

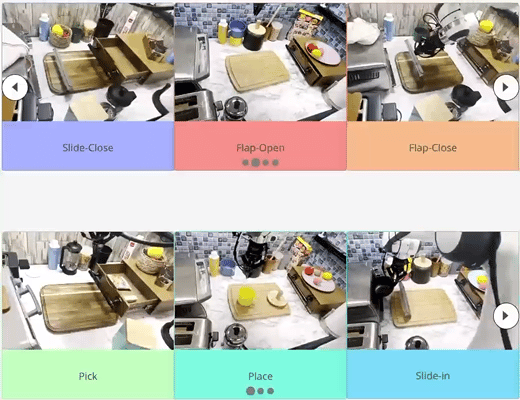

任务:演示收集器使用 Stick 收集 7 个任务的数据,包括门/抽屉的打开/关闭、手柄抓取、拾取和放置以及随机播放数据。

数据集地址:Dobb·E: On Bringing Robots Home

原文链接:https://arxiv.org/pdf/2311.16098

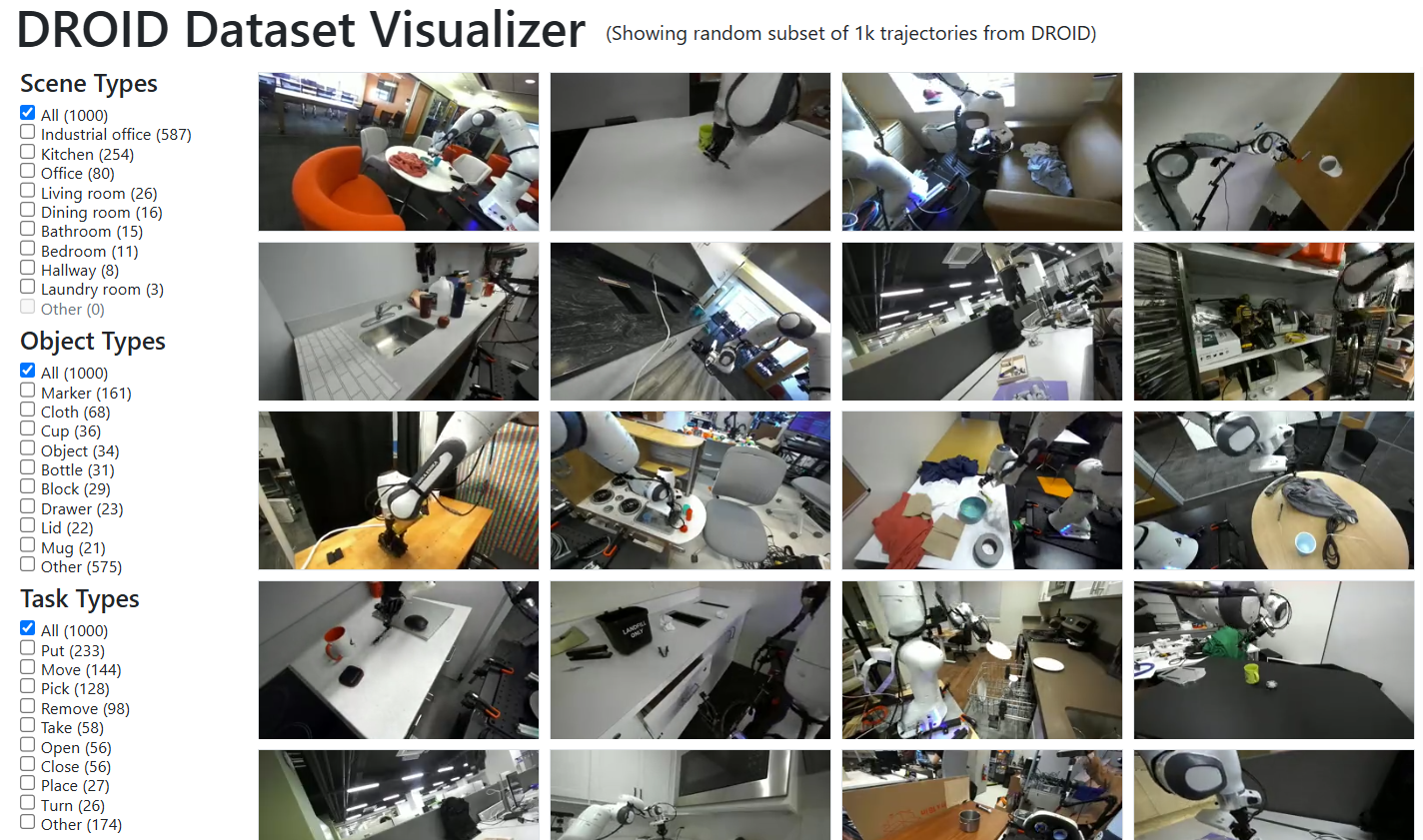

12. DROID

DROID 提供涵盖 564 个场景和 86 个任务的 76,000 条真实机器人轨迹。这些轨迹通过分布式标准化平台收集,能够利用多模态感知(RGB-D、动作、语言标注)训练可泛化的操作策略,并在跨环境自适应方面超越先前的数据集。

任务:各种家庭操作任务。

数据集地址:https://colab.research.google.com/drive/1b4PPH4XGht4Jve2xPKMCh-AXXAQziNQa?usp=sharing

原文链接:https://arxiv.org/pdf/2403.12945

13. FurnitureBench

FurnitureBench 是一个用于长期家具组装的真实世界机器人基准测试,数据集提供了5100 个远程操作演示,总时长219.6 小时。

数据集地址:Dataset — FurnitureBench

原文链接:https://arxiv.org/pdf/2305.12821

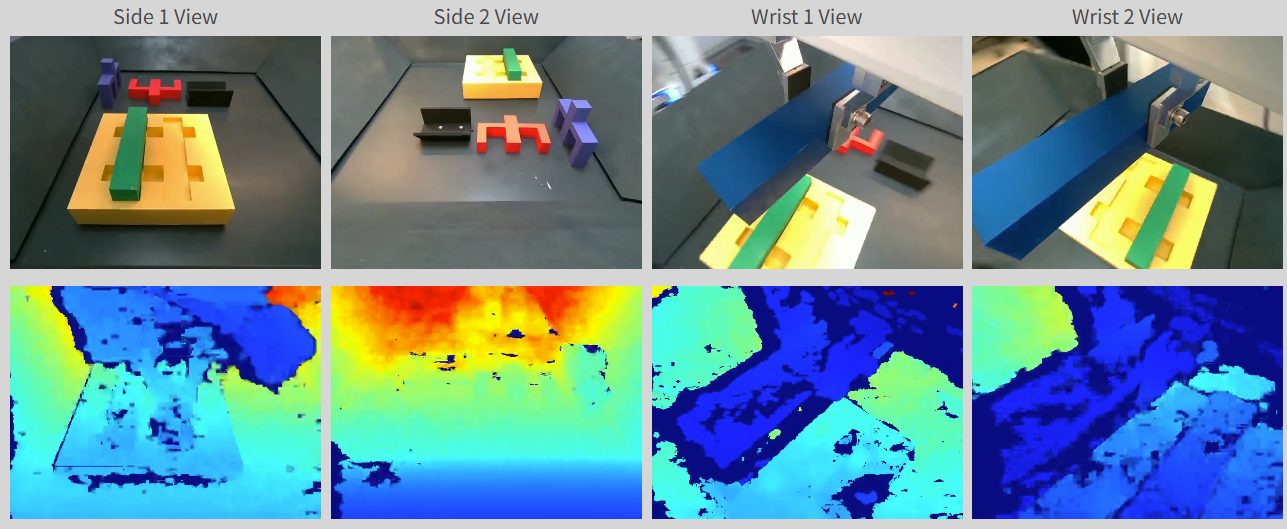

14. FMB(IJRR2024)

该数据集包含外观和几何形状各异的物体。它需要多阶段和多模态的精细运动技能,才能在随机场景中成功地将插销组装到未固定的板上。

通过使用Franka Panda臂在两个不同的任务上总共收集了22,550个轨迹。来自两个全局视角和两个手腕视角的轨迹,每个视角都包含RGB和深度图。

数据集地址:FMB: A Functional Manipulation Benchmark for Generalizable Robotic Learning

原文链接:https://arxiv.org/pdf/2401.08553

15. imsquared non-prehensile manipulation

通过结构化动作空间和课程学习,实现非抓握操作的深度强化学习 (DRL) 框架。该框架消除了对物理参数的依赖,并支持实时规划,在接触密集型任务中实现了 90% 以上的模拟到真实成功率。

任务:机器人在桌面环境中执行各种非抓握操作任务。它可以将各种现实世界和 3D 打印物体平移并重新定位到目标 6 自由度姿态。

数据集地址:https://huggingface.co/kimjaehyung/imsquared-non-prehensile

原文链接:https://arxiv.org/pdf/2205.03532

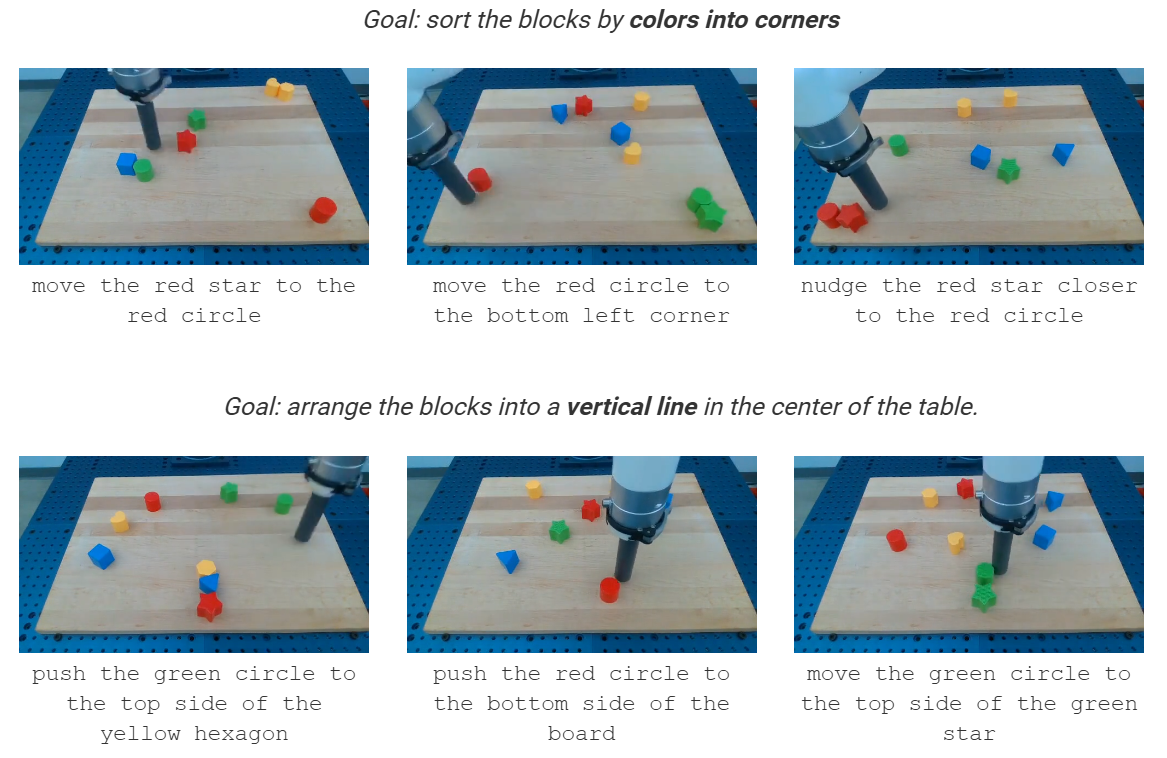

16. Interactive Language

Language-Table 是一个开放词汇、多任务基准数据集,包含 60 万条带语言标记的轨迹,用于训练机器人执行各种实时指令。它能够实现可扩展的视觉运动策略学习,以实现交互式语言驱动控制。

任务:机器人将不同几何形状的积木推到桌面上。

数据集地址:https://github.com/google-research/language-table#datasets

原文链接:https://arxiv.org/pdf/2210.06407

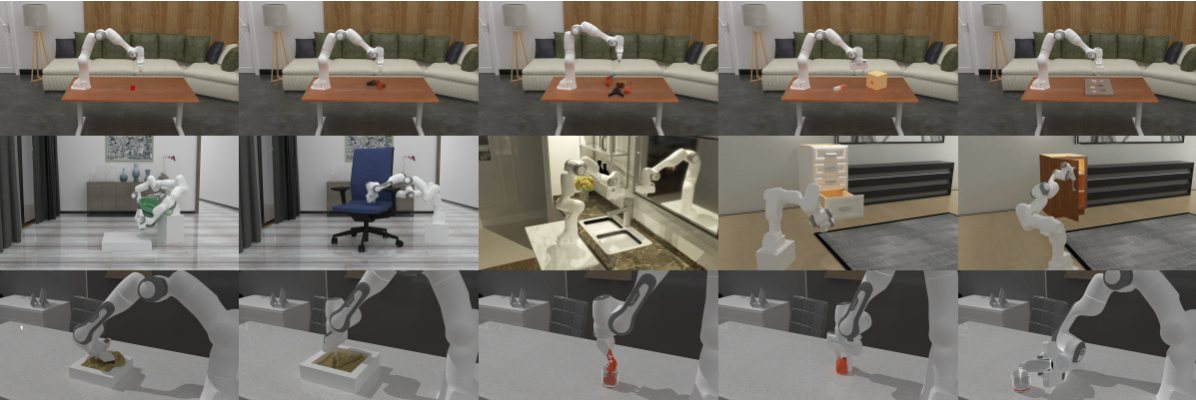

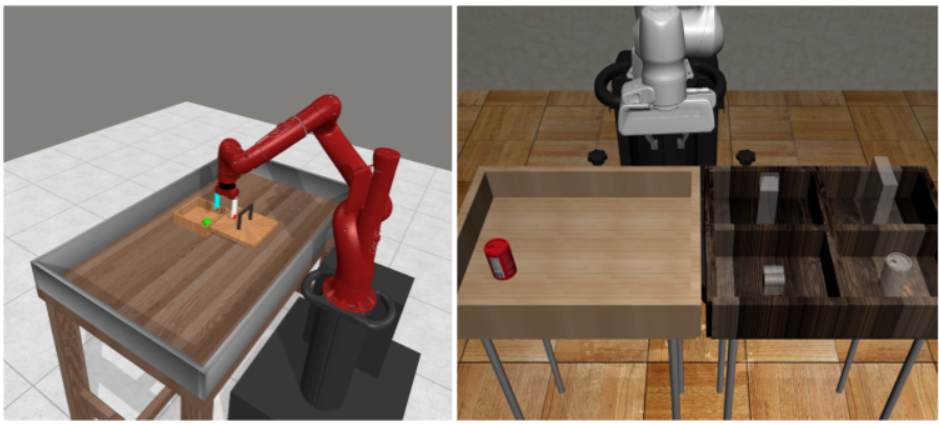

17. ManiSkill

由 SAPIEN 提供支持的统一基准,用于学习可通用的机器人操作技能,具有 20 个任务系列、2000 多个对象模型和 400 万多个演示帧,支持快速视觉学习算法和各种算法类型。

任务:机器人与放置在平面(地面)上的不同物体进行交互。这些任务包括:拾取孤立的物体或从杂乱的物体中拾取物体并将其移动到目标位置;将红色方块堆叠到绿色方块上;将钉子插入盒子;组装套件;将充电器插入墙上的插座;以及打开水龙头。

数据集地址:https://github.com/haosulab/ManiSkill;https://github.com/freekatz/Awesome-Embodied-AI-Datasets/tree/main/datasets/Maniskill

原文链接:https://arxiv.org/pdf/2410.00425v1

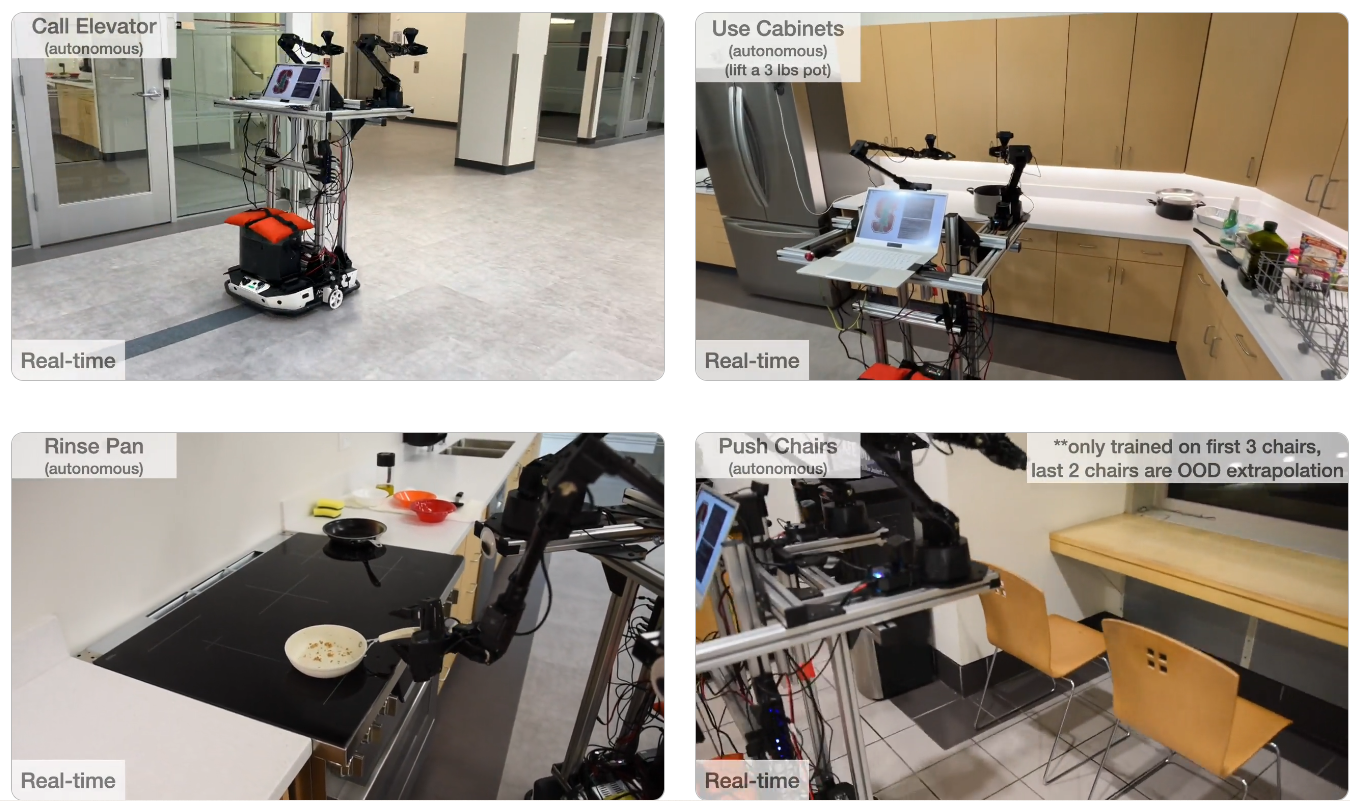

18. Mobile ALOHA

移动 ALOHA 数据集与现有的静态 ALOHA 数据集(包含 825 个演示,涉及密封拉链袋、捡叉子等任务)进行联合训练。

在联合训练中,将静态 ALOHA 数据集中无移动底座动作的数据进行零填充,使其与 Mobile ALOHA 数据维度相同,同时忽略静态 ALOHA 数据中的前摄像头数据,使两个数据集都包含 3 个摄像头数据,并基于 Mobile ALOHA 数据集的统计信息对每个动作进行归一化处理。

任务涵涵盖 7 个具有挑战性的任务,包括擦拭葡萄酒、烹饪虾、冲洗锅、使用橱柜、呼叫电梯、推椅子和击掌。

数据集地址:https://drive.google.com/drive/folders/1FP5eakcxQrsHyiWBRDsMRvUfSxeykiDc

原文链接:https://mobile-aloha.github.io/resources/mobile-aloha.pdf

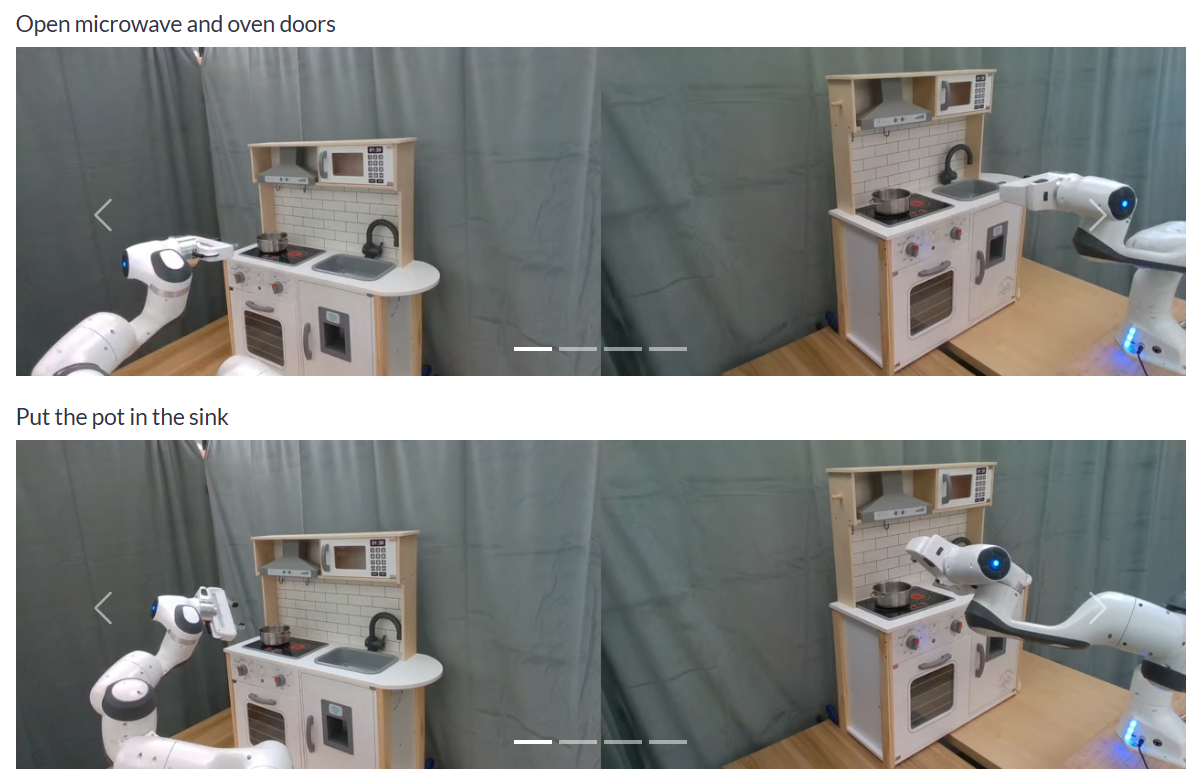

19. From Play to Policy

Play-to-Policy 是一个机器人学习框架,它将非结构化的人类游戏转化为目标条件策略,从而实现对各种操作任务的零样本泛化,而无需特定于任务的演示。

任务:机器人与玩具厨房互动,执行任意任务。它可以打开/关闭微波炉门、打开/关闭烤箱门、转动炉灶旋钮,以及将锅在炉灶和水槽之间移动。

数据集地址:https://github.com/jeffacce/play-to-policy

原文链接:https://arxiv.org/pdf/2210.10047

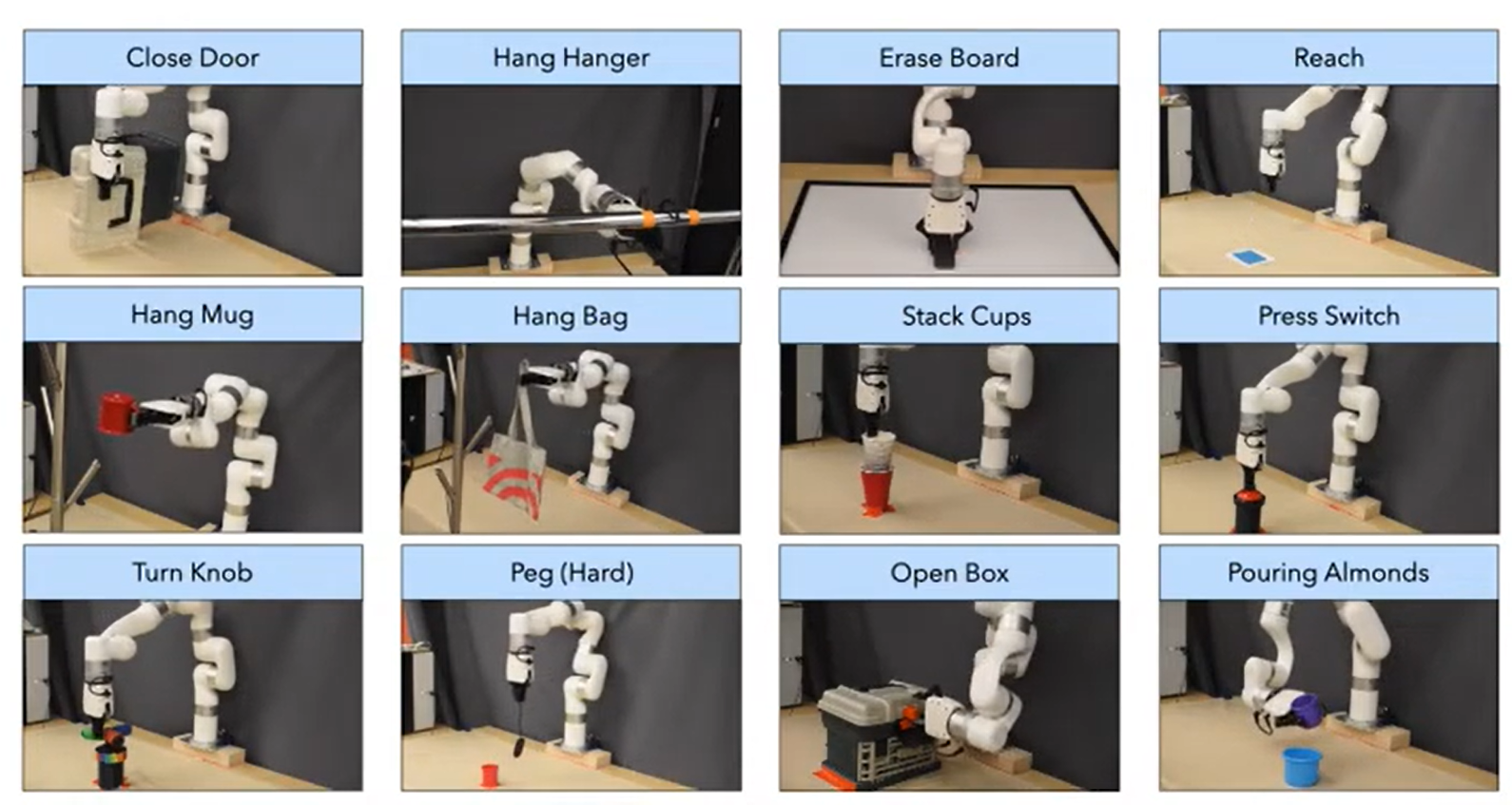

20. ROT (2022 (Oral Presentation, Best Paper Award Finalist))

ROT 是一种高效的模仿学习算法,它将最佳传输轨迹匹配与自适应行为克隆相结合,使机器人只需一次演示和一小时的在线训练就能以 90% 的成功率学习操作策略。

-

20 个模拟任务(来自 DeepMind Control Suite、OpenAI Robotics Suite 和 Meta-World Benchmark)的专家演示数据;

-

14 个真实世界机器人操作任务(在 xArm 机器人上完成,如开门、挂 tote 包、放置钉子等)的人类演示数据。

数据集地址:Watch and Match: Supercharging Imitation with Regularized Optimal Transport

原文链接:https://openreview.net/pdf?id=ZUtgUA0Fuwd

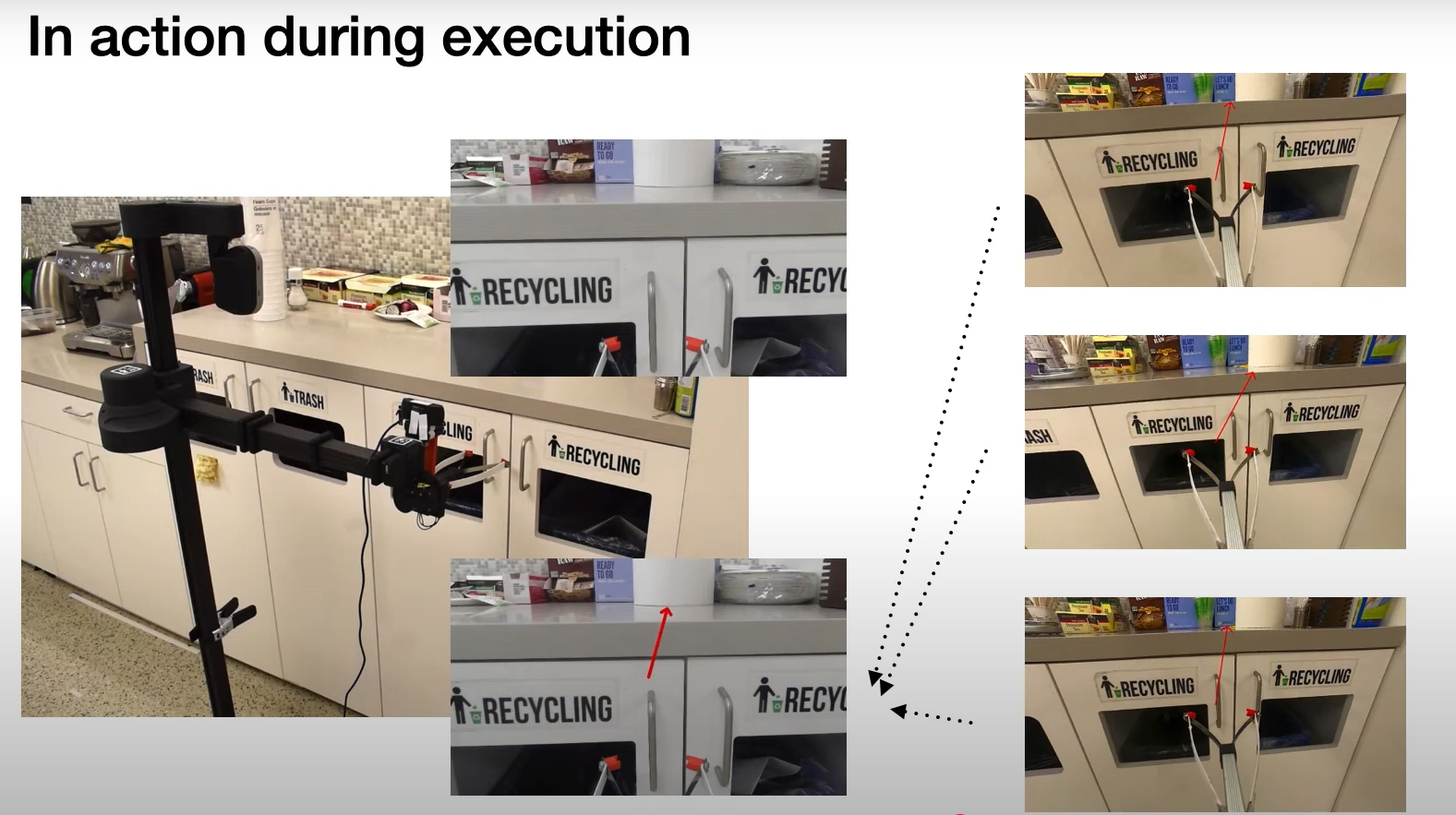

21. VIIN

VINN 通过在语义嵌入空间中进行最近邻匹配,实现机器人的实时视觉模仿,以零训练和最少的演示实现人类水平的任务表现。

任务:机器人打开各种橱柜的柜门。

数据集地址:https://drive.google.com/drive/folders/11-sAN2a-F7G-lvx6qRXnrWjlxNb0PH1m

原文链接:https://arxiv.org/pdf/2112.01511

22. PLEX(CoRL 2023)

PLEX,这是一种基于Transformer的可扩展架构,它可以利用多种形式且数量可观且与机器人操作相关的数据。三类可用于训练机器人操作模型的常见数据:

- 多任务视频演示(MTVD),包含各种任务的高质量且可能带有注释的演示,但没有供机器人模仿的明确动作信息

- 视觉运动轨迹 (VMT),由成对的观察序列和机器人动作组成,但不一定对应有意义的任务

- 目标任务演示 (TTD),是使用感兴趣的机器人收集的特定任务的高质量轨迹

数据集地址:https://github.com/microsoft/PLEX#robosuiterobomimic-data-setup

原文链接:https://arxiv.org/pdf/2303.08789

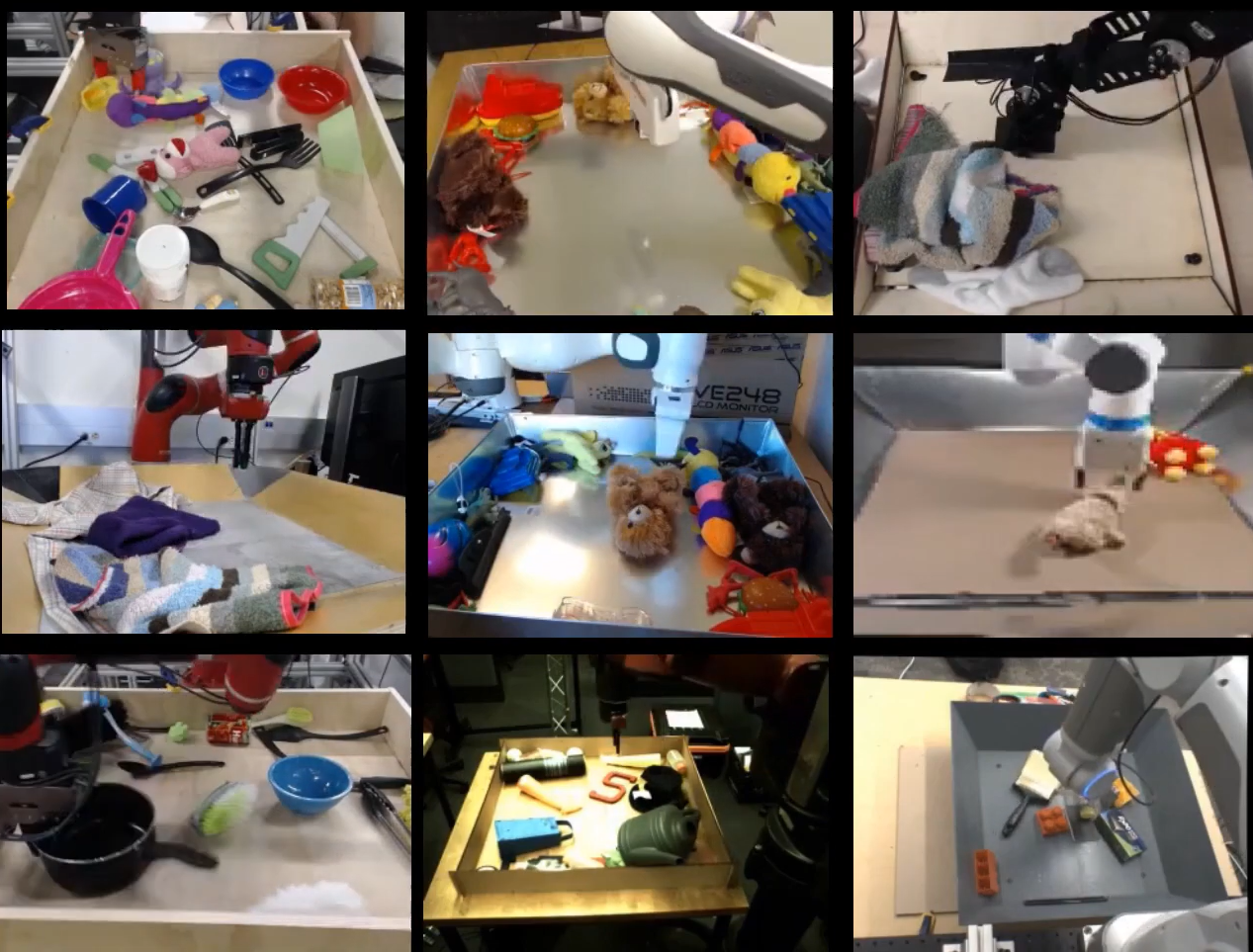

23. RoboNet

数据集包含来自 7 个平台的 1500 万个机器人交互框架,可实现跨机器人技能转移并降低基于视觉的操作任务的 Sim2Real 适配成本。

任务:机器人与放置在其前方的箱子中的物体进行交互

数据集地址:https://github.com/SudeepDasari/RoboNet/wiki/Getting-Started

原文链接:https://arxiv.org/pdf/1910.11215

24. RoboTurk

收集了三个不同现实世界任务的大规模数据集:洗衣布局、塔楼创建和对象搜索。所有三个数据集均使用 RoboTurk 平台收集,由众包工作人员远程收集。包含来自 54 个唯一用户的 2144 个不同演示。既提供完整的数据集用于训练,也提供数据集的较小子样本用于探索。

数据集地址:https://roboturk.stanford.edu/dataset_real.html

25. RoboSet Dataset

RoboSet 数据集基于现实世界,收集了厨房场景中一系列日常家居活动,是一个大规模的真实世界多任务数据集。RoboSet 包含一系列动觉演示和遥控演示。该数据集包含多任务活动,每帧包含四个不同的摄像机视图,并且每个演示的场景都会有所变化。

- 动觉演示数据是通过在每次机器人滚动时播放一个演示轨迹来收集的,该轨迹包含通过重新排列物体获得的新场景。

- 远程操作数据则使用 Oculus Quest 2 控制器收集。远程操作员将使用控制器引导机器人执行任务;远程操作确保每次滚动都是唯一的。

数据集总共包含 28,500 条轨迹,其中 9,500 条通过远程操作收集,19,000 条通过动觉回放收集。

数据集地址:RoboSet Dataset

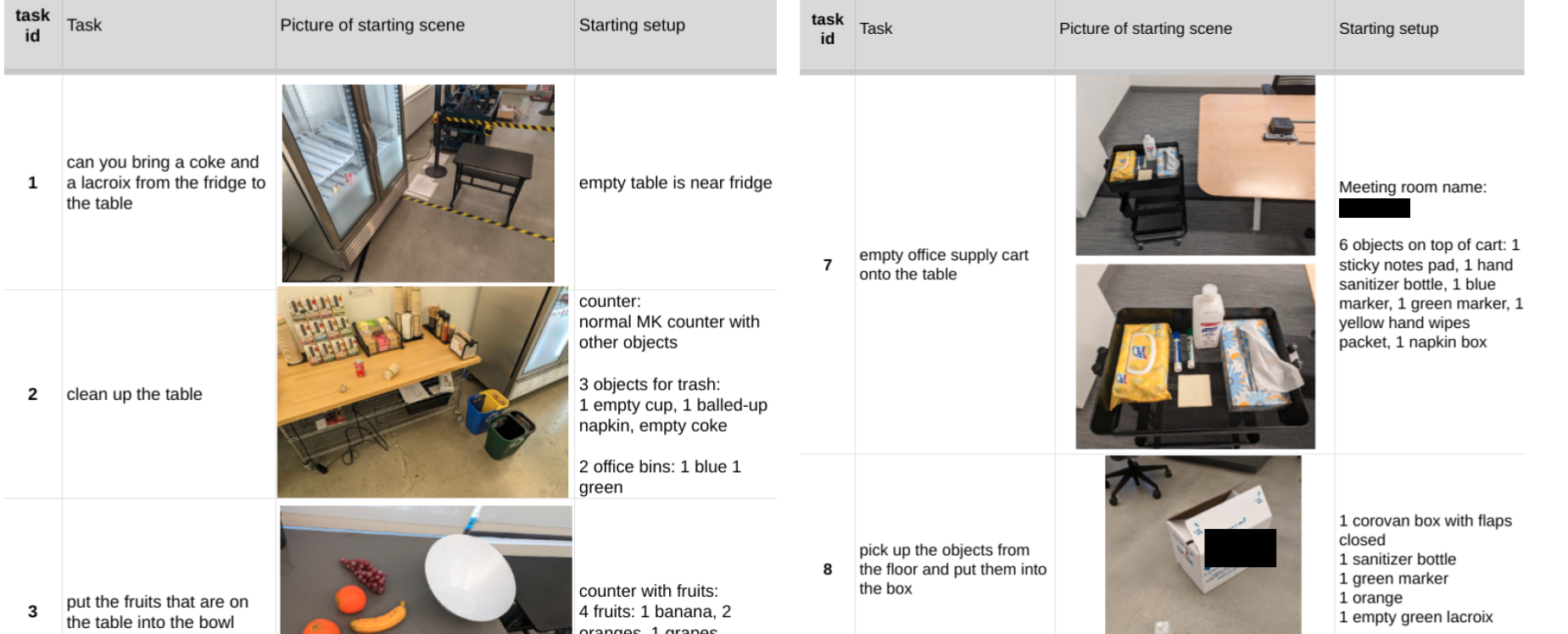

26. RoboVQA

RobotVQA 将 RGB-D 输入转换为可操作的场景图以供机器人操作,从而实现语言引导的任务执行,实际成功率达到 89%。

任务:机器人或人类在 3 栋办公楼内执行用户的任何长期请求。

数据集地址:https://console.cloud.google.com/storage/browser/anon_robovqa

原文链接:https://anonymous-robovqa.github.io/assets/anon_roboplan.pdf

27. RT-1

该数据集包含 13 万个事件,涵盖 700 多项任务,这些数据集由来自Everyday Robots (EDR) 的 13 个机器人组成的队伍在 17 个月内收集而成。

数据集地址:https://github.com/google-research/robotics_transformer

原文链接:https://robotics-transformer.github.io/assets/rt1.pdf

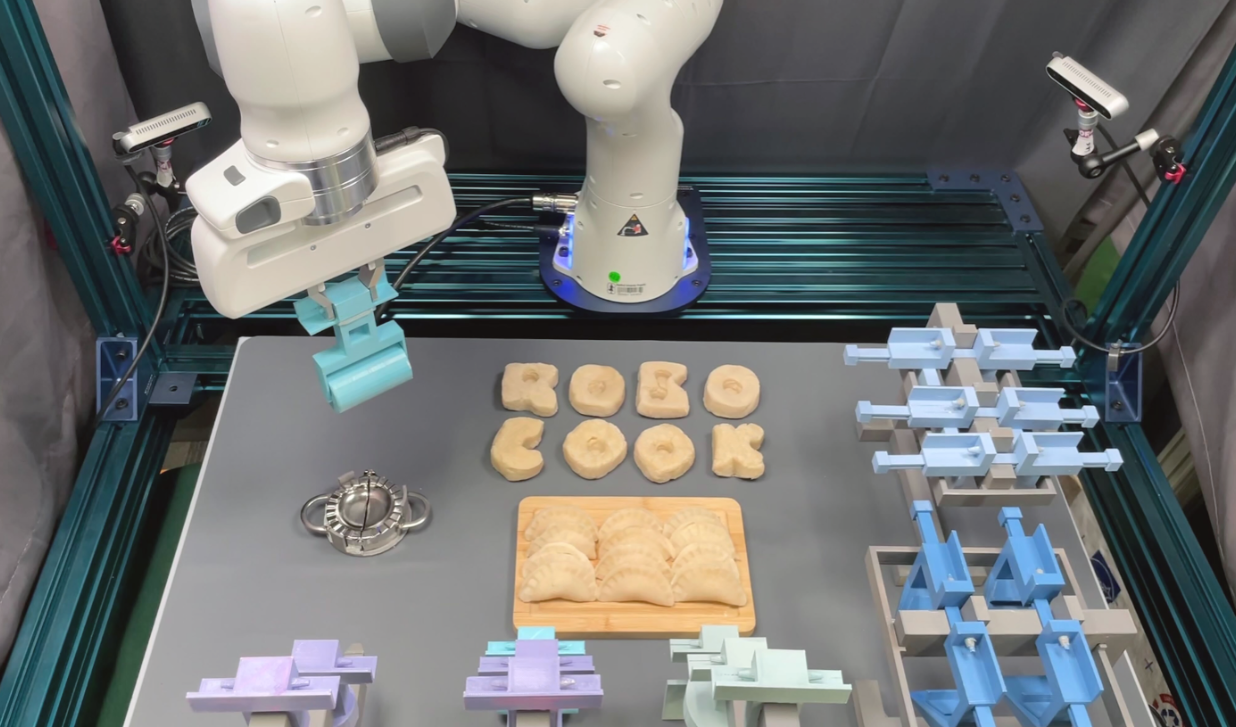

28. RoboCook(CoRL 2023)

机器人能够通过点云 GNN 和自监督学习使用各种工具操纵弹性物体,每个工具仅需 20 分钟的真实世界数据即可实现 85% 的任务成功率。

针对抓取动作,对 300 个不同初始状态,每个状态采样 128 个随机动作,生成 38,400 对数据(覆盖多种面团形状)。

数据集地址:https://drive.google.com/drive/folders/1kEw4rnFWnYpkelfucvtJMEYYwA5P_0CK

原文链接:https://arxiv.org/pdf/2306.14447

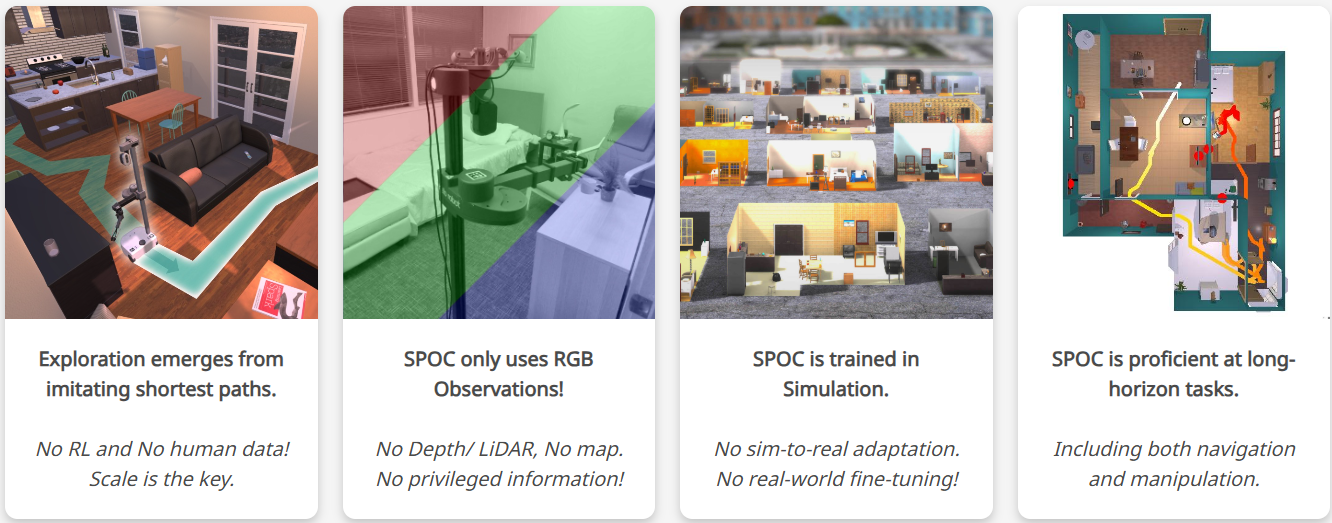

29. SPoC

SPoC 提供两种训练数据类型:在环境中导航并使用开放词汇描述执行拾取和放置操作。

- fifteen 类型:包含机器人导航和抓取 15 种特定物体类型的任务数据;

- all 类型:包含机器人导航和抓取数百种物体类型的任务数据。

数据集地址:https://github.com/allenai/spoc-robot-training

原文链接: https://arxiv.org/pdf/2312.02976

30. RLDS

RLDS 数据集构建器通过无损步进事件记录和 TFDS 集成标准化机器人操作数据收集,从而实现对布料折叠和物体拾取等任务的高效策略训练。

任务:PR2机器人对桌面物体进行操作。它可以拾取和放置面包和葡萄,并折叠布料。

数据集地址:https://github.com/ojh6404/rlds_dataset_builder

31. TOTO Benchmark

一个远程机器人基准,提供共享的物理机器人和标准化数据集,用于可重复的离线训练和在线真实世界策略测试,克服硬件可访问性障碍。

任务:TOTO 基准数据集包含两个任务的轨迹:舀取和倾倒。舀取的目标是将碗中的物质舀入勺中。倾倒的目标是将物质倒入桌上的目标杯中。

数据集地址:TOTO

原文地址:https://arxiv.org/pdf/2306.00942

32. CLVR Jaco Play

CLVR Jaco Play 数据集提供了来自 Kinova Jaco 2 机器人的 1,085 条带有语言注释的轨迹,具有同步多视图视觉、机器人状态和用于训练语言引导操作策略的动作。

任务:机器人在桌面玩具厨房环境中执行拾取和放置任务。例如,“拿起橙色水果”、“将黑色碗放入水槽”。

数据集地址:https://github.com/clvrai/clvr_jaco_play_dataset

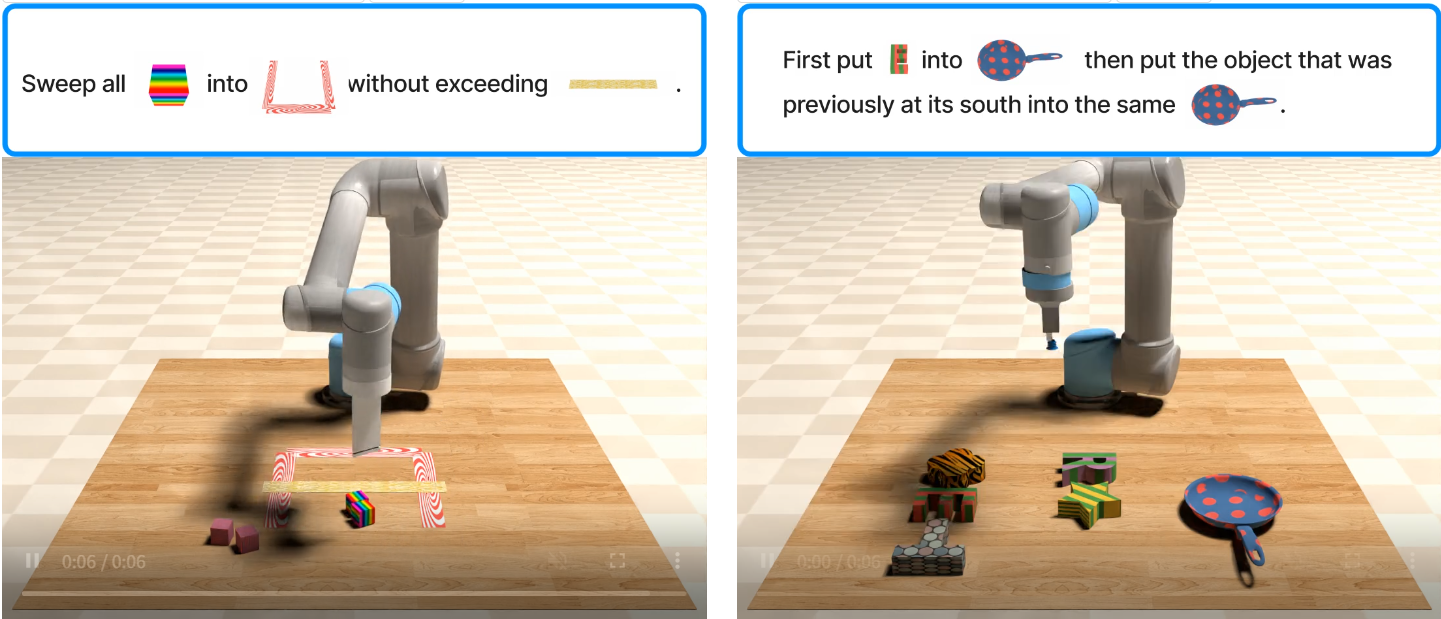

33. VIMA (ICML2023)

用于多模态机器人学习的大规模模拟基准测试,其特点是程序生成的桌面操作任务,并穿插了文本、图像和视频提示。它包含 60 多万条用于模仿学习的专家轨迹,以及一个用于评估零样本适应性的 4 层泛化协议。

机器人根据多模式提示(文本、图像和视频帧的混合)进行桌面操作任务,从重新排列到一次性模仿。

数据集地址:https://huggingface.co/datasets/VIMA/VIMA-Data

原文地址:https://vimalabs.github.io/assets/vima_paper.pdf