Neumann Networks for Linear Inverse Problems in Imaging论文阅读

Neumann Networks for Linear Inverse Problems in Imaging

-

-

- 1. 研究目标与实际意义

- 2. 创新方法:Neumann Network及其理论实现

-

- 2.1 核心思路:Neumann级数展开与传统逆问题的结合

- 2.2 网络架构:递归计算与跳跃连接

- 2.3 预条件改进(Preconditioned NN)

- 2.4 与现有方法的对比分析

-

- 2.4.1 与展开梯度下降(Unrolled GD)的等价性与差异

- 2.4.2 与其他方法的样本复杂度对比

- 2.5 理论保证:子空间并集(UoS)模型下的最优性

- 3. 实验验证

-

- 3.1 实验设计

- 3.2 关键结果(表 I)

- 3.3 理论验证

- 4. 未来方向

- 5. 批判性思考

- 6. 实用创新点与学习建议

-

1. 研究目标与实际意义

目标:提出一种名为 Neumann Network(NN) 的端到端数据驱动方法,用于解决成像中的线性逆问题(如去模糊、解卷积、修复、压缩感知和超分辨率)。核心是通过截断 Neumann 级数直接求解带非线性正则化器的逆问题,而非展开迭代优化算法。

实际问题:传统正则化器(如平滑性或稀疏性假设)难以捕捉复杂图像先验,而数据驱动方法需大量样本学习完整图像空间。NN 通过显式结合前向算子 X X X,显著降低样本复杂度,适用于医学成像等小数据集场景。

产业意义:提升图像重建质量(如医学影像诊断精度),降低深度学习对数据量的依赖,加速实时成像应用(如 MRI 重建)。

2. 创新方法:Neumann Network及其理论实现

2.1 核心思路:Neumann级数展开与传统逆问题的结合

传统线性逆问题表示为:

y = X β ⋆ + ϵ y = X\beta^\star + \epsilon y=Xβ⋆+ϵ

目标最小化正则化最小二乘问题:

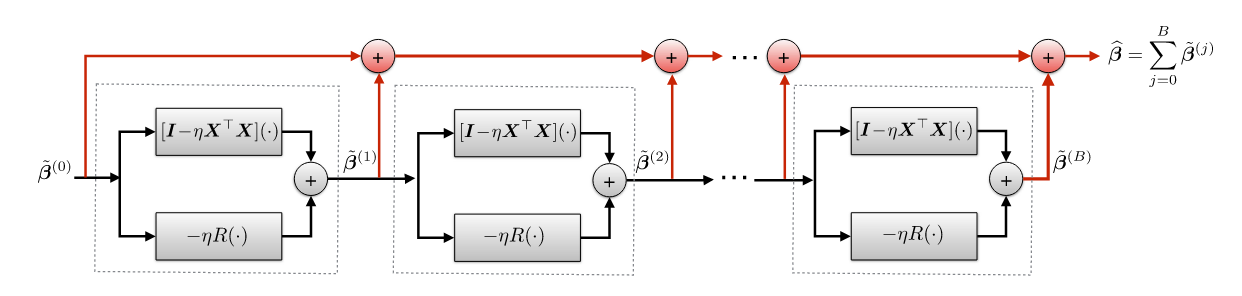

β ^ = arg min β 1 2 ∥ y − X β ∥ 2 2 + r ( β ) (2) \widehat{\beta} = \arg\min_{\beta} \frac{1}{2}\|y - X\beta\|_2^2 + r(\beta) \tag{2} β =argβmin21∥y−Xβ∥22+r(β)(2) 图2:Neumann 网络架构(跳跃连接为红色路径)

核心创新:

- Neumann级数直接近似逆矩阵:

论文将解 β ⋆ = ( X ⊤ X + R ) − 1 X ⊤ y \beta^\star = (X^\top X + R)^{-1}X^\top y β⋆=(X⊤X+R)−1X⊤y(公式5)通过Neumann级数展开(公式7):

B − 1 = η ∑ k = 0 ∞ ( I − η B ) k where B = X ⊤ X + R (7) B^{-1} = \eta \sum_{k=0}^{\infty} (I - \eta B)^k \quad \text{where} \quad B = X^\top X + R \tag{7} B−1=ηk=0∑∞(I−ηB)kwhereB=X⊤X+R(7)

代入后得到迭代形式(公式8):

β ⋆ = ∑ j = 0 ∞ ( I − η X ⊤ X − η R ) j ( η X ⊤ y ) (8) \beta^\star = \sum_{j=0}^{\infty} (I - \eta X^\top X - \eta R)^j (\eta X^\top y) \tag{8} β⋆=j=0∑∞(I−ηX⊤X−ηR)j(ηX⊤y)(8) - 数据驱动正则化器:

将线性算子 R R R 替换为非线性神经网络 R θ R_\theta Rθ,形成Neumann网络(公式9):

β ^ ( y ) = ∑ j = 0 B ( [ I − η X ⊤ X ] ( ⋅ ) − η R θ ( ⋅ ) ) j ( η X ⊤ y ) (9) \widehat{\beta}(y) = \sum_{j=0}^{B} \left( \left[I - \eta X^\top X\right](\cdot) - \eta R_\theta(\cdot) \right)^j \left( \eta X^\top y \right) \tag{9} β (y)=j=0∑B([I−ηX⊤X