让模型不再忽视少数类:MixUp、CutMix、Focal Loss三种技术解决数据不平衡问题

在实际的机器学习应用中,数据集规模有限且类别分布不均衡是一个普遍存在的问题。以医学影像分析为例,正类样本通常仅占总样本的5%左右。基于此类数据训练的分类模型往往会倾向于预测多数类别,虽然能够达到95%的整体准确率,但在识别关键的少数类样本方面表现不佳。

这种现象会引发过拟合、预测偏差以及关键类别召回率偏低等问题,严重影响模型在实际场景中的应用效果。

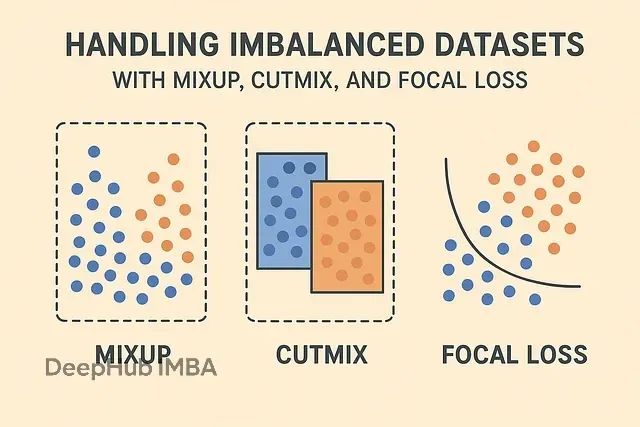

针对不平衡数据集的挑战,研究界通常采用数据增强技术与损失函数优化相结合的策略。本文将深入分析三种主流解决方案:MixUp数据混合技术、CutMix区域替换增强方法以及Focal Loss焦点损失函数。这些方法从不同维度解决不平衡问题,协同使用时能够显著提升小规模不平衡数据集上的模型性能。

不平衡数据集是指各类别样本数量分布极不均匀的数据集合。在典型的医学诊断场景中,病理阳性样本可能仅占5%,而正常样本则占据95%的比例。

这种分布不均衡会在模型训练过程中产生显著的负面影响。分类器容易陷入"多数类偏向"的陷阱,即通过简单地预测多数类别来获得较高的表面准确率。例如,一个始终输出"阴性"结果的分类器在上述医学数据集上可以达到95%的准确率,但这种模型在检测真正的阳性病例时完全失效。

这种现象被称为"准确率悖论",即高准确率指标掩盖了模型在核心任务上的失败。传统的解决方案主要包括过采样技术(通过复制少数类样本来平衡数据分布)和欠采样方法(减少多数类样本数量)。过采样容易导致过拟合问题,而欠采样则可能造成有价值信息的丢失。基于数据增强与损失函数设计的先进方法,如MixUp、CutMix和Focal Loss,在处理此类问题时展现出更优的性能表现。

MixUp:线性插值数据增强技术

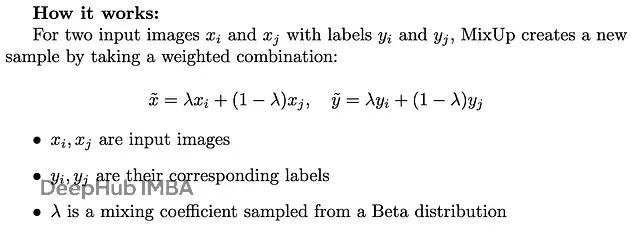

MixUp是一种通过线性插值生成虚拟训练样本的数据增强方法。该技术将两个不同的训练样本按照特定比例进行混合,同时对相应的标签进行相应的线性组合处理。

MixUp技术的核心优势体现在多个方面。1、它能够有效缓解模型过拟合现象,特别是在小规模数据集上表现突出。2、通过样本混合生成的虚拟数据增强了模型对标签噪声的泛化性。3、MixUp还能够改善模型在小数据集上的泛化能力,使决策边界更加平滑。

但是该方法也存在一定的局限性。由于采用全局线性混合策略,图像中的空间结构信息和位置特异性特征可能在混合过程中丢失,这对于依赖空间关系的视觉任务可能产生不利影响。

def mixup_data(x, y, alpha=0.2): lam = np.random.beta(alpha, alpha) batch_size = x.size()[0] index = torch.randperm(batch_size) mixed_x = lam * x + (1 - lam) * x[index, :] y_a, y_b = y, y[index] return mixed_x, y_a, y_b, lam

该函数通过Beta分布采样混合系数,生成线性组合的输入特征和对应的标签对,为后续的MixUp训练策略提供数据支持。

CutMix:基于区域替换的数据增强方法

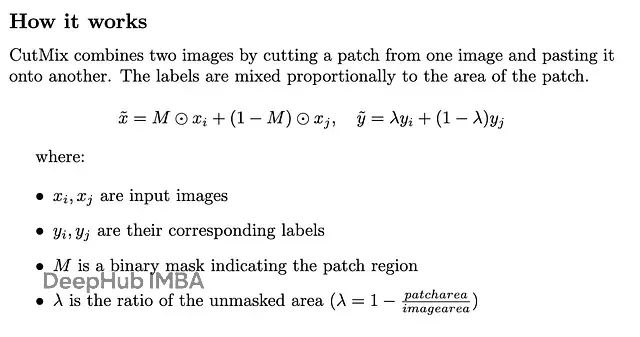

CutMix采用了与MixUp不同的数据增强策略。该方法不对整幅图像进行线性混合,而是从源图像中裁剪出特定区域,并将其粘贴到目标图像的相应位置,同时根据替换区域的面积比例调整标签权重。

CutMix技术在保持图像局部特征完整性方面具有显著优势。与MixUp的全局混合不同,CutMix能够保留图像的空间结构信息,这对于目标检测和语义分割等需要精确空间定位的任务特别重要。同时,该方法提供了比MixUp更强的正则化效果,能够有效提升模型对局部特征的感知能力。

该方法的不足之处主要体现在对极小目标的处理效果有限,以及随机区域替换可能偶尔产生不符合实际分布的合成图像。

import torch

import numpy as np

def cutmix_data(x, y, alpha=1.0): lam = np.random.beta(alpha, alpha) batch_size, _, H, W = x.size() index = torch.randperm(batch_size) # Random patch coordinates cut_rat = np.sqrt(1. - lam) cut_w = int(W * cut_rat) cut_h = int(H * cut_rat) cx = np.random.randint(W) cy = np.random.randint(H) bbx1 = np.clip(cx - cut_w // 2, 0, W) bby1 = np.clip(cy - cut_h // 2, 0, H) bbx2 = np.clip(cx + cut_w // 2, 0, W) bby2 = np.clip(cy + cut_h // 2, 0, H) x[:, :, bby1:bby2, bbx1:bbx2] = x[index, :, bby1:bby2, bbx1:bbx2] lam = 1 - ((bbx2 - bbx1) * (bby2 - bby1) / (W * H)) y_a, y_b = y, y[index] return x, y_a, y_b, lam

该实现通过计算替换区域的精确坐标和面积比例,生成具有混合区域特征的新样本,使模型能够从多样化的特征组合中学习更加鲁棒的表示。

Focal Loss:针对类别不平衡的损失函数设计

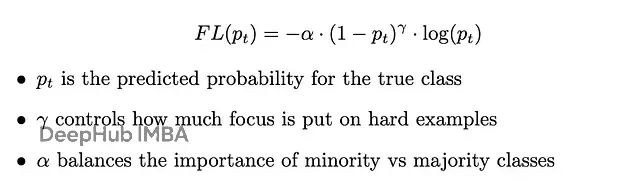

Focal Loss是专门针对分类任务中严重类别不平衡问题而设计的损失函数。标准交叉熵损失在处理不平衡数据时往往被大量易分类的多数类样本所主导,导致模型忽视少数类样本的学习。

Focal Loss通过引入动态加权机制,为难分类样本分配更高的损失权重,从而引导模型将注意力集中在具有挑战性的样本上。

该损失函数的主要优势在于能够自适应地调整不同难度样本的学习权重,显著提升少数类样本的识别效果,特别适用于高度不平衡的数据集场景。

Focal Loss的潜在不足主要体现在超参数调优的复杂性上。参数γ(聚焦参数)和α(平衡因子)的选择对模型性能有显著影响,不当的参数设置可能导致训练收敛速度下降或性能退化。

import torch

import torch.nn as nn class FocalLoss(nn.Module): def __init__(self, alpha=0.25, gamma=2.0, reduction='mean'): super(FocalLoss, self).__init__() self.alpha = alpha self.gamma = gamma self.reduction = reduction def forward(self, inputs, targets): BCE_loss = nn.functional.cross_entropy(inputs, targets, reduction='none') pt = torch.exp(-BCE_loss) F_loss = self.alpha * (1 - pt) ** self.gamma * BCE_loss if self.reduction == 'mean': return F_loss.mean() elif self.reduction == 'sum': return F_loss.sum() else: return F_loss

在医学诊断、欺诈检测以及罕见事件预测等少数类样本具有重要价值的应用场景中,Focal Loss能够显著提升模型的实用性和可靠性。

多技术融合策略与实践应用

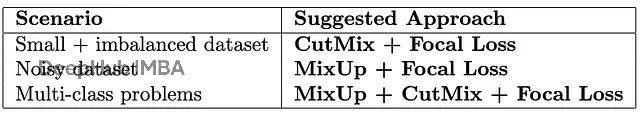

上述三种技术分别从数据增强和损失函数优化的角度解决不平衡数据集问题,它们之间具有良好的互补性。合理的组合策略能够进一步提升模型在复杂场景下的性能表现。

在技术选择和组合方面,CutMix适用于需要保持空间结构完整性的视觉任务,特别是当图像中每个目标区域都具有重要意义时。MixUp则更适合处理具有较强噪声干扰的数据集,通过平滑决策边界来提升模型的泛化能力。Focal Loss作为损失函数层面的解决方案,确保模型在训练过程中给予少数类样本足够的关注度。

for inputs, labels in dataloader: # Apply CutMix inputs, targets_a, targets_b, lam = cutmix_data(inputs, labels) # Forward pass outputs = model(inputs) # Compute loss with Focal Loss loss = lam * focal_loss(outputs, targets_a) + (1 - lam) * focal_loss(outputs, targets_b) # Backward pass optimizer.zero_grad() loss.backward() optimizer.step()

这种集成方案在实际应用中展现出显著的性能提升效果,特别是在资源受限且数据分布极不均衡的场景下。

总结

小规模不平衡数据集在现代机器学习应用中广泛存在,不当的处理方式会导致模型过度拟合多数类别,无法有效识别具有重要价值的少数类样本。

MixUp、CutMix和Focal Loss三种技术从不同的技术维度提供了系统性的解决方案。MixUp通过样本混合策略增强模型对噪声的识别改善泛化能力。CutMix在进行数据增强的同时保持了图像的局部空间特征完整性。Focal Loss则通过损失函数的重新设计,将学习重点转移到具有挑战性的少数类样本上。

当这些技术协同应用时,能够在小规模不平衡数据集上实现显著的性能改进,为解决实际应用中的数据不平衡问题提供了可靠的技术支撑。

在实际项目实施中,建议根据具体的应用场景和数据特征选择合适的技术组合,通过系统性的实验验证来优化模型性能,从而确保模型能够准确识别真正关键的数据模式。

https://avoid.overfit.cn/post/4229858c275748719e5c93324b5acc16

作者:Ahmet Bekir Arslanalp