【大模型本地运行与部署框架】Ollama的使用记录

文章目录

- 0 简介

- 1 安装Ollama

- 1.1 windows系统下的本地安装

- 1.2 python Ollama框架安装

- 2 运行模型

- 2.1 在命令行工具(CLI)运行和部署模型

- 2.1.1 本地运行模型

- 2.2.2 部署模型【待补充】

- 2.2 使用python SDK配置与运行模型

- 2.2.1 简单使用

- 2.2.2 对话模型

- 2.2.3 更多

- 2.3 自定义模型运行和部署【待补充】

0 简介

定位: Ollama是一款开源的本地大模型运行框架。

便于在本地服务器便捷地快速部署、运行和管理大语言模型。

支持常见大模型本地部署,例如deepseek系列、llama系列、qwen系列等等。

1 安装Ollama

本安装教程有两种:1.为基于windows系统的本地安装,要求Windows 10 22H2 或更高版本、家庭版或专业版;2. python ollama库安装。

其余系统或环境下的安装,请见官方文档。

1.1 windows系统下的本地安装

官网软件包的下载地址:https://ollama.com/download

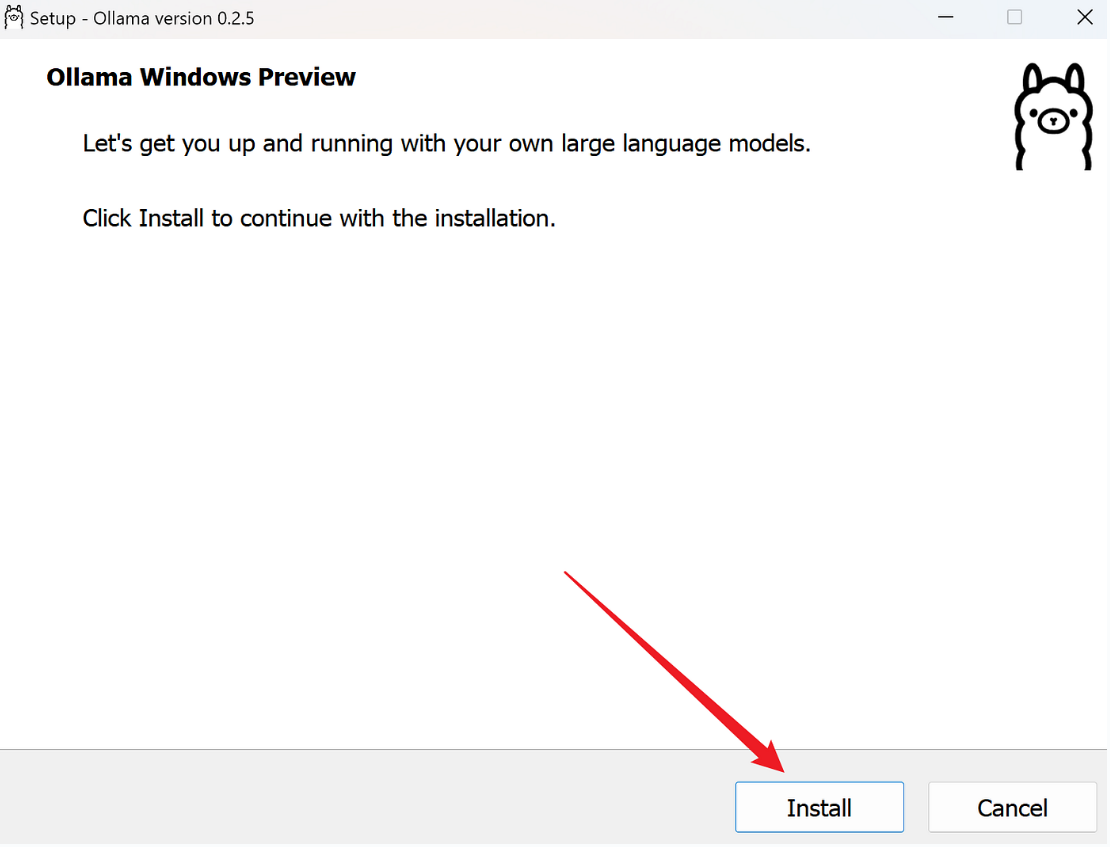

下载后,直接双击运行后,点击install,自动安装完成。(别慌,请往下看完)

这种是默认安装形式,默认安装在主目录,如果你的c盘足够大的话,完全没有问题。

BUT :如果有多个分区,C区主用作系统盘。

随着后期ollama下载了多个模型,每个模型将会占用数十或数百GB的空间。如果主盘没有足够空间的话,将影响系统运行。

那么,建议参考使用官方给出的更改安装位置:

step 1 :自定义ollama安装路径

先进入到下载软件包的文件夹(这个需要你自己去确认),在该处进入控制台界面;

再在控制台界面输入OllamaSetup.exe /DIR="d:\some\location,意为用命令语句来安装ollama,并指定安装地址。

OllamaSetup.exe指的是软件安装包的名字;

/DIR="d:\some\location携带的地址参数,d:\some\location代表你的指定安装路径,可修改此参数值。

例如,我想将ollama安装到 D:\LLM\Ollama,那么我的运行语句为 :OllamaSetup.exe /DIR="D:\LLM\Ollama"

step 2:修改model的安装位置。

安装好后,会自动启动ollama。

这时查看一下model的下载位置,通常依旧还是在c盘。查看方式为:

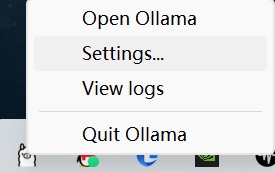

右键图标,点击setting

setting界面查看model location的路径是否默认位置,即C:\users\yourname\.ollama\models,

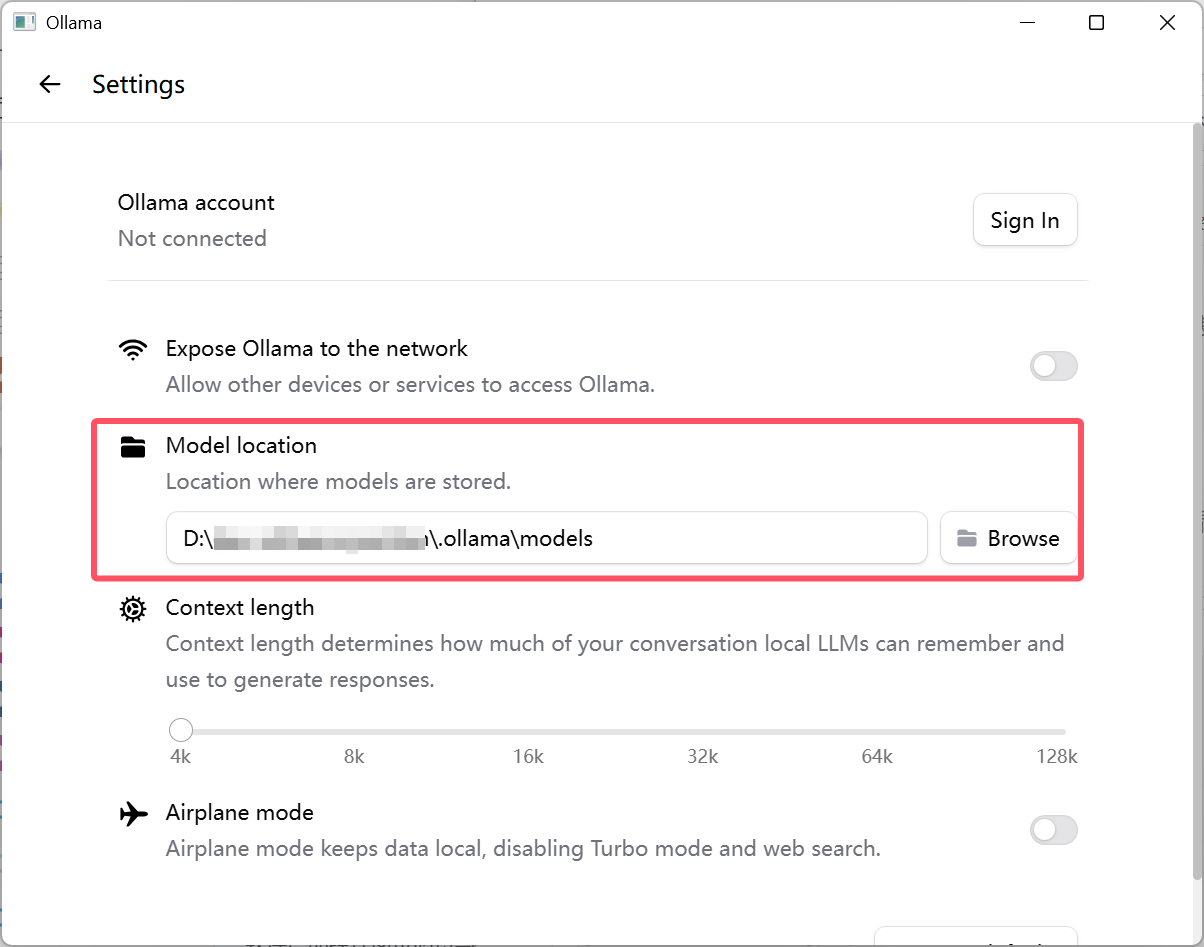

此时,需要我们手动修改:

先新建一个你想存放的空文件夹,可以选择保存相同子目录(.ollama\models),例如我的新路径为D:\

然后将原路径下的所有文件移动到你所新建的地址。

例如,我想将我的模型存放在 D:\LLM下,并且想要保持一样的子目录,我所做的操作是:先在 D:\LLM 目录下,新建二级目录也就是 D:\LLM\.ollama\models接着,在设置界面的model location 的路径进行修改最后,将默认路径 C:\users\yourname\.ollama\models 下的所有东西剪切到D:\LLM\.ollama\models

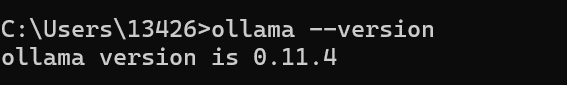

step 3:验证安装结果。

命令行输入ollama --version,若返回版本号,则说明安装成功!

1.2 python Ollama框架安装

使用pip或者conda安装ollama库即可。

2 运行模型

2.1 在命令行工具(CLI)运行和部署模型

2.1.1 本地运行模型

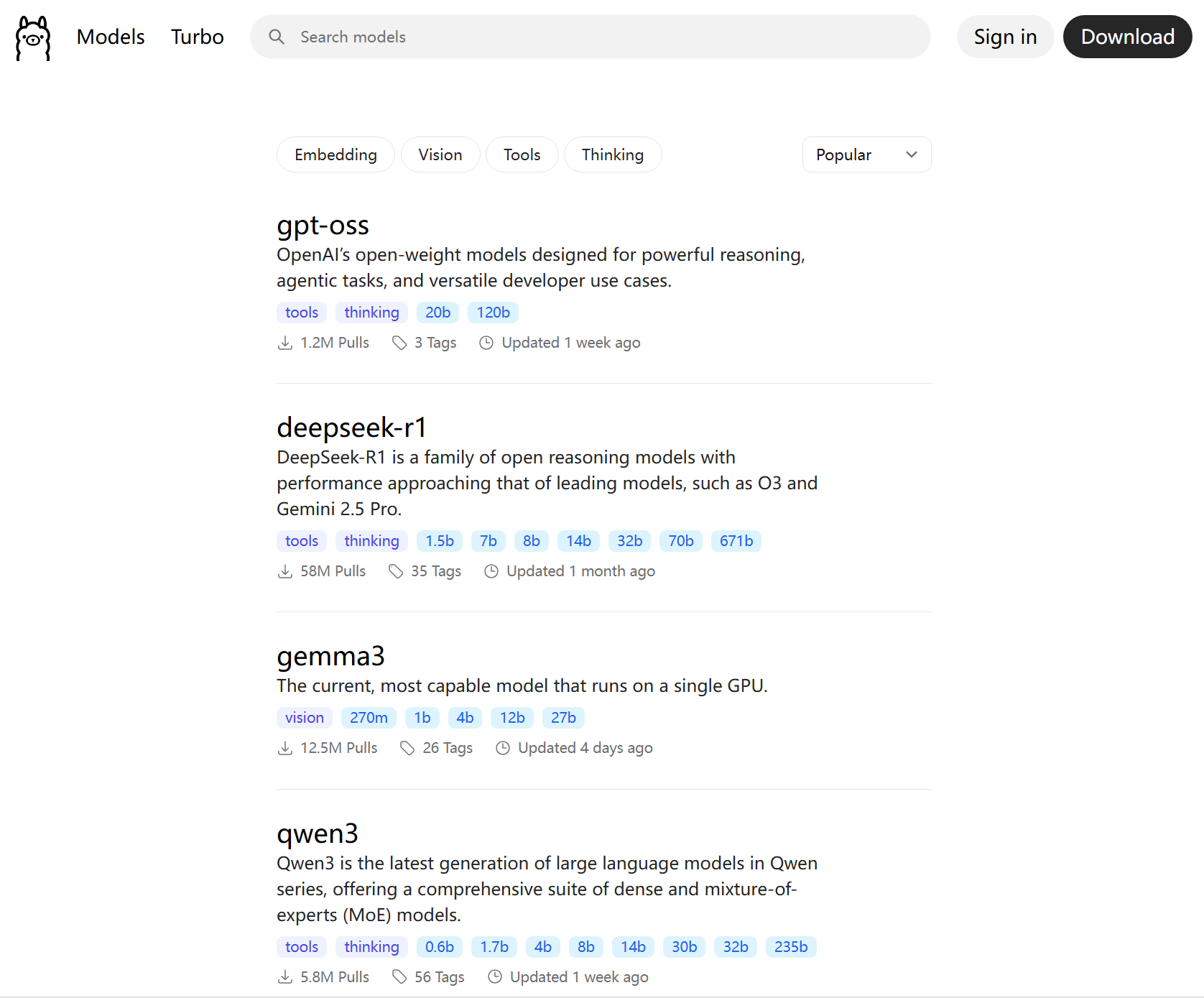

在官网中https://ollama.com/search,查找所支持的模型

直接在搜索框中进行搜索,大部分模型都可以支持,

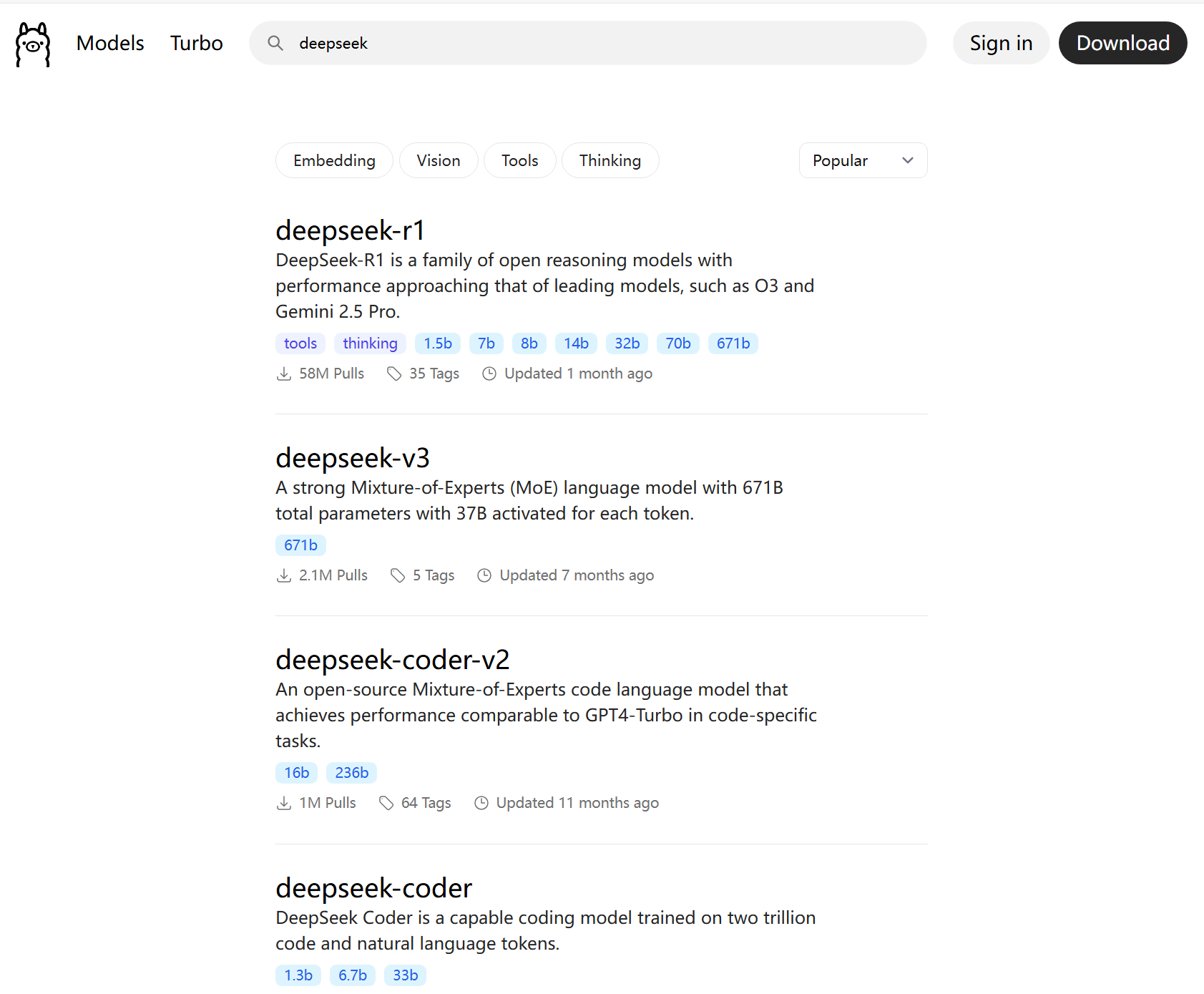

这里以deepseek为例,下图是搜索结果,

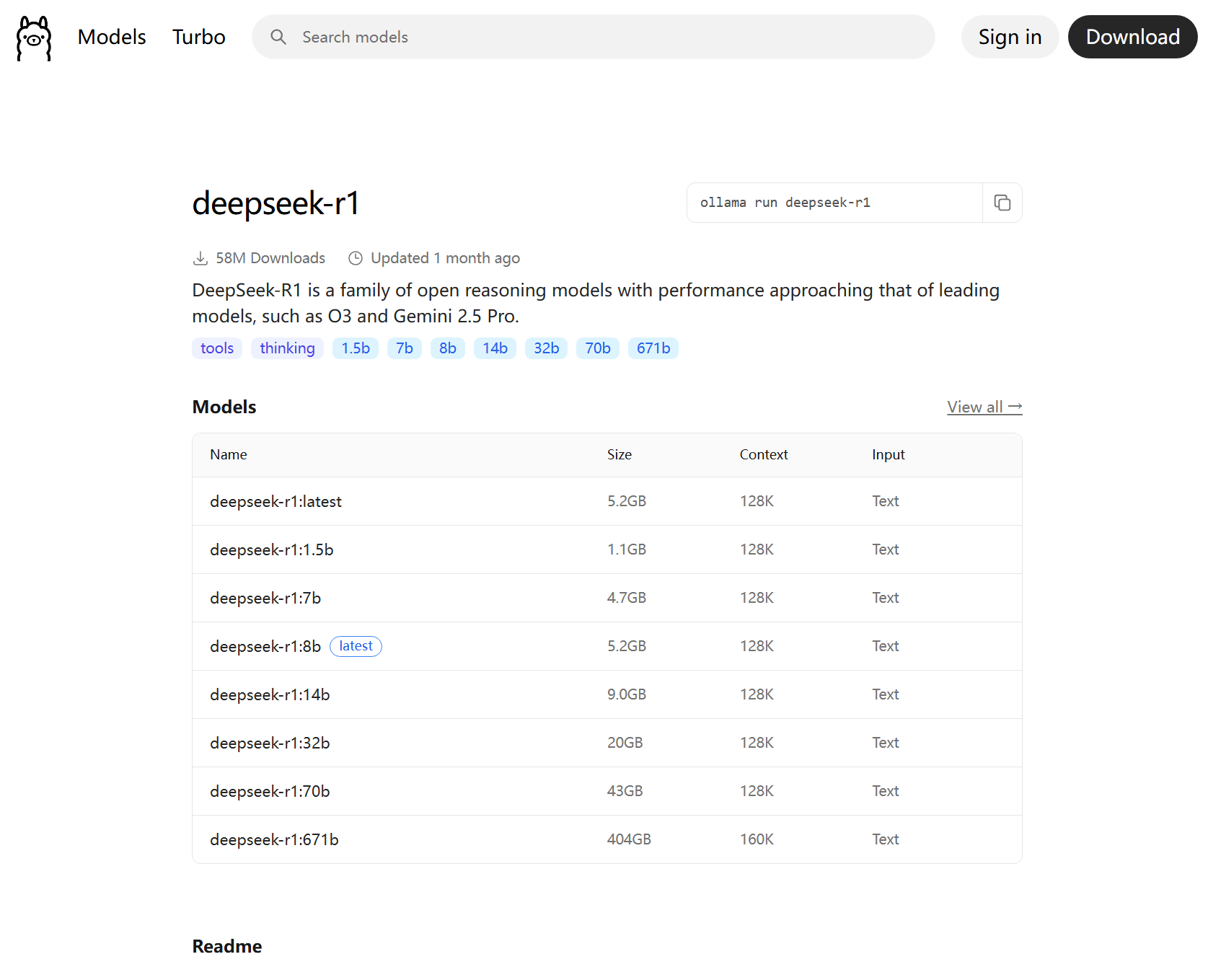

我们选择deepseek-r1,进入后界面:

右上角会显示执行命令;

下方会显示多个不同参数的模型。(这里我们要注意,例如DeepSeek-R1-Distill-Qwen-1.5B,之所以参数量级较少,其实是【等待补充】)

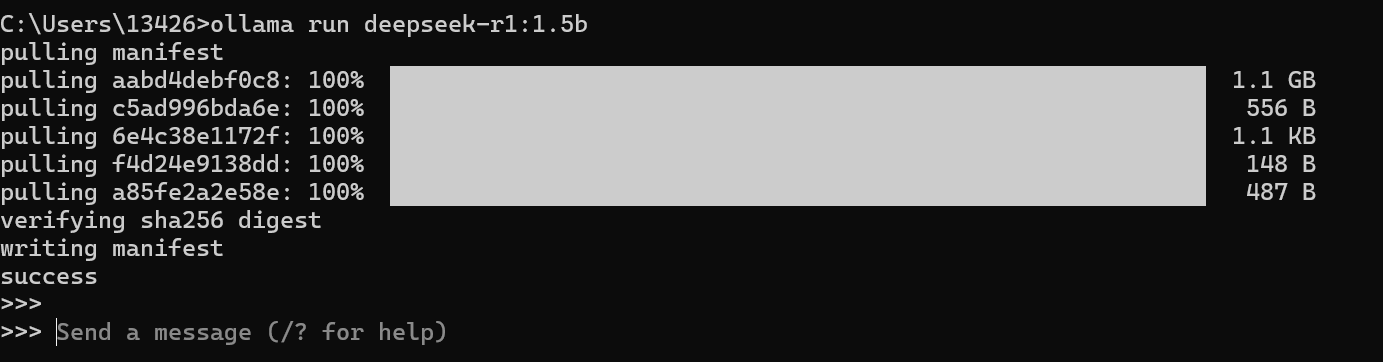

接着选择想要下载的具体参数大小的模型,这里我选择deepseek-r1:1.5b,将该模型安装到本地,即执行 ollama run deepseek-r1:1.5b

等待下载,下载后,会直接运行该模型

到这里,恭喜你在本地运行成功!

结束对话,可以直接在send a message位置输入/bye或 键入ctrl+d,即可关闭对话。

这里,简单记录一下其他的常见命令:

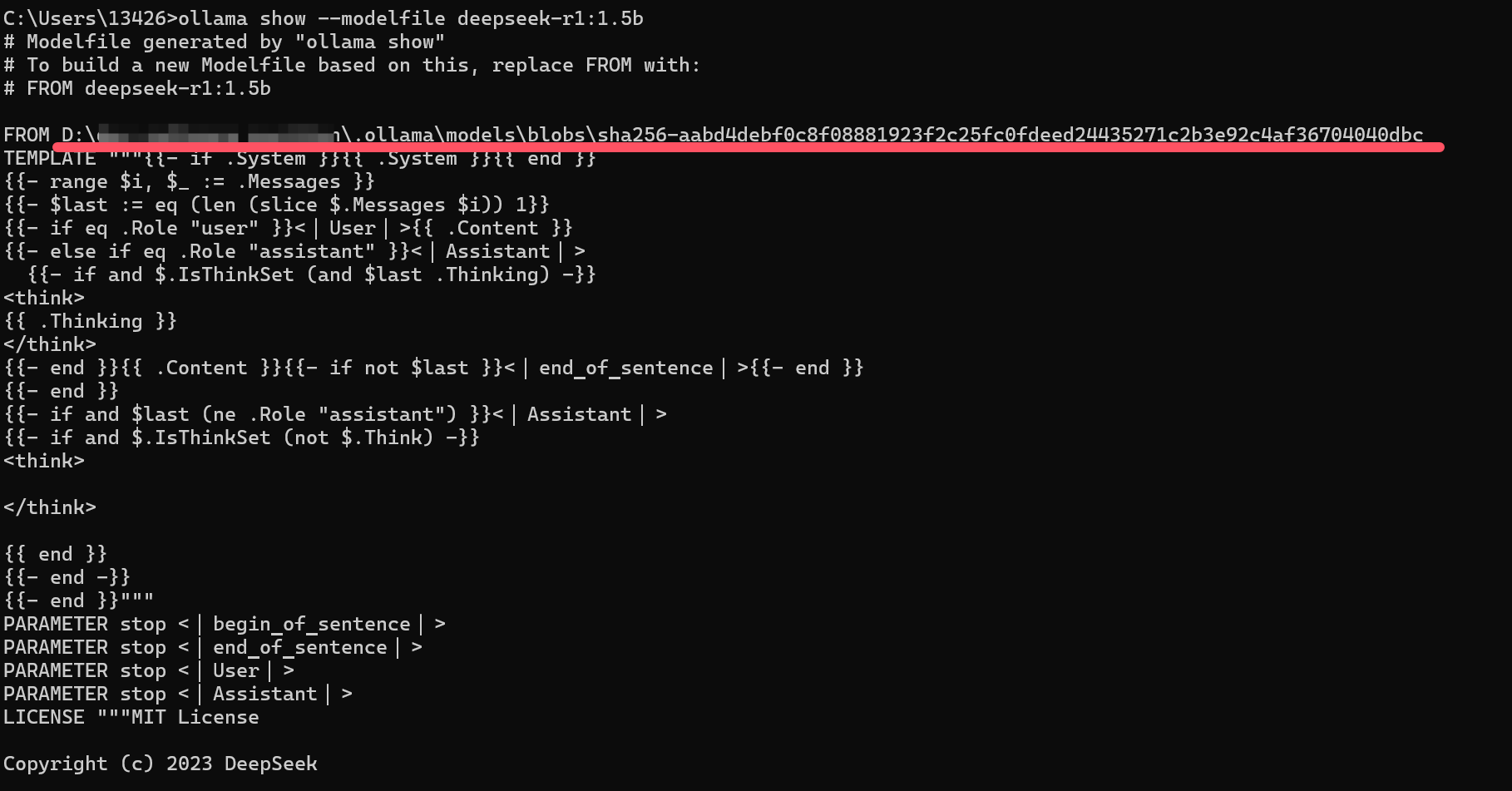

① 查看模型的配置文件:ollama show --modelfile deepseek-r1:1.5b

每个文件都有这个modelfile,我们也可以自己写modelfile,去运行自定义模型。

这里注意看红线部分,这里也可以查看你模型现在在哪个位置。如果你的模型位置显示的是1.1中你所自定义的model location路径,则配置没有问题。

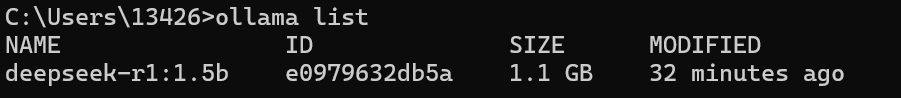

② 查看本地安装的模型列表:ollama list

2.2.2 部署模型【待补充】

2.2 使用python SDK配置与运行模型

适用场景:如果你希望将 Ollama 与 Python 代码集成,进行加载或运行模型。

2.2.1 简单使用

新建文件,可以写以下简单的以下文本。

import ollama

response = ollama.generate(model="deepseek-r1:1.5b", # 模型名称prompt="你好。" # 提示文本

)

print(response)

接下来,运行该python文件,就可以得到输出结果。

2.2.2 对话模型

from ollama import chatmessages = [{'role': 'user','content': '为什么天空是蓝色?',},]response = chat('deepseek-r1:1.5b', messages=messages)

print(response['message']['content'])

2.2.3 更多

更多使用模板见https://github.com/ollama/ollama-python/blob/main/examples/README.md

2.3 自定义模型运行和部署【待补充】

使用场景

步骤

ollama create model -of ./Modelfile