【序列晋升】:9 Service Mesh微服务通信的基础设施革命

Service Mesh(服务网格)是一种专门用于处理微服务间通信的基础设施层,它通过将原本嵌入应用代码的网络通信逻辑下沉到独立的代理层,为分布式系统提供了统一的流量管理、安全通信和可观测性能力。随着微服务架构的普及,服务间通信的复杂性呈指数级增长,传统解决方案(如API网关、Spring Cloud等)在应对跨语言、跨平台、大规模服务治理时显得力不从心。Service Mesh的出现,标志着微服务通信治理进入了一个全新的阶段,从代码层面的治理转向了基础设施层面的统一管理。

一、Service Mesh的诞生背景:微服务架构的必然产物

1.1 微服务通信痛点

当应用从单体架构转向微服务架构后,原本隐藏在单体应用内部的服务交互变得显式且复杂。微服务架构的核心价值在于将复杂系统拆分为独立部署、可独立扩展的小型服务,但随着服务数量的增加,服务间的通信管理成为新的挑战。具体痛点包括:

- 通信逻辑分散:每个服务都需要实现服务发现、负载均衡、重试、熔断等通信逻辑,导致代码冗余和维护困难。

- 跨语言支持不足:不同服务可能使用不同编程语言,但通信治理框架通常绑定特定语言,增加了团队协作的复杂性。

- 可观测性碎片化:服务间的调用链路难以追踪,监控数据分散在不同服务中,故障排查效率低下。

- 安全策略难以统一:服务间通信缺乏统一的安全认证和加密机制,容易出现安全漏洞。

1.2 传统解决方案的局限性

面对这些挑战,业界曾尝试多种解决方案:

- API网关:主要解决外部请求的路由和安全问题,但对服务间通信的治理能力有限。

- 服务注册中心(如Eureka、Consul):提供服务发现和基础通信能力,但缺乏统一的治理策略。

- 微服务框架(如Spring Cloud、Dubbo):虽然提供了完整的微服务治理能力,但需要在每个服务中嵌入框架代码,导致语言耦合和版本兼容性问题。

这些传统方案的核心问题在于将通信治理逻辑与业务代码耦合,导致系统复杂度没有减少,反而转移到了应用层。随着容器化和云原生技术的兴起,微服务实例的动态变化特性进一步放大了这些痛点,亟需一种与应用解耦的通信治理解决方案。

1.3 Service Mesh的概念起源

Service Mesh的概念最早由Buoyant公司在2016年9月29日的"SF Microservices"会议上提出 。Service Mesh的核心思想是将服务间通信的基础设施层独立出来,通过边车(Sidecar)代理接管所有服务间的网络流量,从而实现通信逻辑的统一治理。

2017年,谷歌、IBM和Lyft联合开发了Istio,这是第一个获得广泛认可的服务网格框架。Istio于2018年发布1.0版本,2019年成为GitHub上增长速度第四快的开源项目,超过190家公司开始使用Istio。2022年9月28日,Istio正式成为CNCF孵化项目,2024年1月8日,Istio毕业成为CNCF顶级项目,标志着服务网格技术在云原生生态中的成熟。

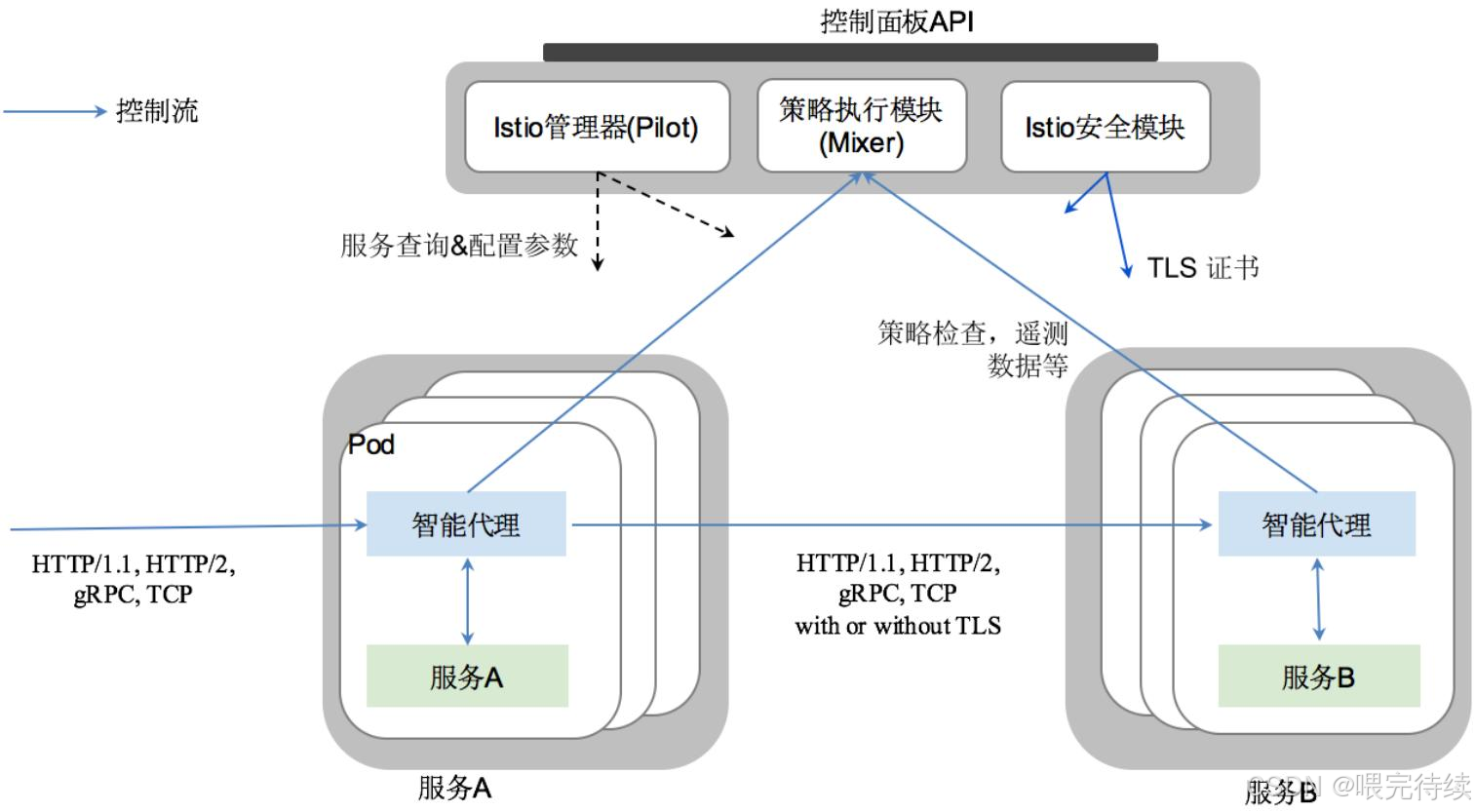

二、Service Mesh的架构设计:数据平面与控制平面的协同

Service Mesh的架构设计遵循了"分层抽象"的原则,将原本分散在应用中的通信逻辑集中到一个专门的基础设施层。典型的Service Mesh架构分为两个核心部分:数据平面(Data Plane)和控制平面(Control Plane)。

2.1 数据平面:边车代理的网络基础设施

数据平面由一组轻量级网络代理组成,这些代理以边车(Sidecar)形式与每个微服务实例部署在一起,负责拦截和转发服务间的网络流量。边车代理的核心特点是:

- 透明代理:代理会自动接管服务的所有网络流量,应用无需感知其存在。

- 语言无关:代理基于标准网络协议(如HTTP、gRPC、TCP等)工作,支持任何语言开发的服务。

- 功能下沉:将原本分散在应用中的通信治理功能(如服务发现、负载均衡、安全认证等)集中到代理层。

主流Service Mesh框架的数据平面代理实现:

| 框架名称 | 代理实现 | 语言 | 协议支持 | 特点 |

|---|---|---|---|---|

| Istio | Envoy | C++ | HTTP/1.1, HTTP/2, gRPC, TCP, UDP | 高性能,功能全面,支持L7层精细控制 |

| Linkerd | linkerd2-proxy | Rust | HTTP/1.1, HTTP/2, gRPC, TCP | 轻量级,启动速度快,资源占用低 |

| Consul Connect | Envoy/Consul代理 | Go/C++ | HTTP, TCP | 与HashiCorp生态深度集成,支持服务分段 |

| Kuma | Envoy | C++ | HTTP/1.1, HTTP/2, gRPC, TCP, UDP | 多云支持,轻量级,支持非Kubernetes环境 |

2.2 控制平面:策略管理的中枢神经系统

控制平面负责管理数据平面代理的行为,提供统一的配置接口和策略执行能力。控制平面的核心功能包括:

- 服务发现与路由:从Kubernetes等平台获取服务实例信息,生成路由规则并下发到代理。

- 策略管理:定义和执行安全策略、流量控制策略、访问控制策略等。

- 证书管理:为服务间通信生成和分发安全证书,实现mTLS加密。

- 遥测数据聚合:收集代理上报的指标、日志和追踪数据,提供统一的可观测性界面。

控制平面的架构设计因框架而异:

- Istio:控制平面包含多个组件,如Pilot(流量管理)、Citadel(证书管理)、Galley(配置验证)等,通过gRPC与数据平面通信。

- Linkerd:控制平面更简洁,包含Identity(证书管理)、Destination(服务发现)、Prometheus(指标收集)等组件。

- Consul Connect:控制平面集成在Consul中,利用Consul的分布式键值存储和ACL系统管理服务实例和策略。

- Kuma:控制平面设计为可扩展的分布式架构,支持多集群和多云环境。

2.3 数据平面与控制平面的协同工作原理

Service Mesh的核心在于数据平面与控制平面的高效协同。这种协同主要通过xDS协议(Envoy的扩展发现服务协议)实现,代理通过xDS协议从控制平面获取配置信息,包括:

- LDS(Listener Discovery Service):定义代理监听的端口和协议。

- CDS(Cluster Discovery Service):定义服务集群和负载均衡策略。

- EDS(Endpoint Discovery Service):定义服务实例的具体地址和端口。

- RDS(Route Discovery Service):定义请求路由规则。

- SDS(Secret Discovery Service):定义证书和密钥信息。

在Kubernetes环境中,控制平面(如Istio的Pilot)会监听Kubernetes API Server的事件(如Pod创建/删除),动态更新服务实例列表,并通过gRPC流式推送配置到代理 。代理根据配置信息动态调整路由行为,实现服务间通信的透明治理。

三、Service Mesh解决的核心问题:微服务通信的全方位治理

Service Mesh通过基础设施层的抽象,解决了微服务架构中的多个核心问题:

3.1 服务发现与负载均衡

在微服务架构中,服务实例的动态变化是常态。传统解决方案要求应用主动注册和发现服务,而Service Mesh通过边车代理透明地完成这一过程。控制平面从Kubernetes API Server获取服务实例信息,生成路由规则并通过xDS协议下发到代理 。代理根据EDS(端点发现服务)动态更新实例列表,实现服务发现。

负载均衡方面,Service Mesh支持多种算法:

- 轮询(Round Robin):请求按顺序分配到各个实例。

- 最少连接数(Least Connections):请求分配给当前连接数最少的实例。

- 一致性哈希(Consistent Hashing):根据请求特征(如用户ID)将请求分配到特定实例,保证同用户请求路由到同一实例。

- 权重分配(Weighted):根据权重比例分配请求,常用于灰度发布和A/B测试。

与传统解决方案相比,Service Mesh的负载均衡具有以下优势:

- 无需应用代码参与,代理自动处理流量分配。

- 支持跨语言和跨平台,任何服务都能享受统一的负载均衡策略。

- 动态感知服务实例变化,无需重启应用即可生效。

3.2 安全通信与零信任架构

微服务架构中,服务间的通信安全是关键挑战。Service Mesh通过mTLS(双向TLS)加密和细粒度访问控制,实现了服务间通信的零信任安全架构。

mTLS密钥管理流程:

- 控制平面(如Istio的Citadel)生成服务身份证书,通常与Kubernetes服务账户(Service Account)绑定 。

- 证书通过SDS协议(Secret Discovery Service)分发给边车代理 。

- 代理在服务间通信时自动验证对方身份,并建立加密通道。

与传统解决方案相比,Service Mesh的安全通信具有以下优势:

- 自动加密:无需修改应用代码即可启用服务间通信加密。

- 身份验证:基于服务身份而非IP地址进行认证,更符合微服务架构的特性。

- 策略统一:通过控制平面实现细粒度访问控制,策略可统一管理。

- 自动轮换:证书自动轮换,无需人工干预。

3.3 可观测性与分布式追踪

微服务架构的可观测性是故障排查和性能优化的关键。Service Mesh通过边车代理收集指标、日志和追踪数据,提供统一的可观测性界面。

可观测性数据采集与聚合:

- 指标:代理收集请求延迟、成功率、吞吐量等指标,通过Prometheus格式暴露数据,控制平面聚合后供Grafana展示。

- 日志:代理记录请求和响应信息,日志可统一收集和分析。

- 分布式追踪:通过OpenTelemetry或Jaeger实现,代理拦截请求头(如traceparent)并上报跨度数据,形成完整的调用链路 。

与传统解决方案相比,Service Mesh的可观测性具有以下优势:

- 透明收集:无需修改应用代码即可获取通信数据。

- 统一视角:提供全局视角的可观测性数据,而非分散在各个服务中的片段。

- 高效分析:数据格式标准化,便于与现有监控工具(如Prometheus、Grafana)集成。

3.4 弹性治理与容错机制

微服务架构需要应对服务故障和网络不稳定等问题。Service Mesh通过边车代理实现熔断、重试、超时等弹性治理机制,确保系统在部分服务不可用时仍能保持整体可用性。

弹性治理机制:

- 熔断:当目标服务响应时间超过阈值或错误率升高时,代理会暂时拒绝请求,防止故障扩散。

- 重试:在特定条件下(如HTTP 5xx错误),代理自动重试请求,提高系统可靠性。

- 超时:设置请求超时时间,避免长时间阻塞。

- 故障注入:模拟网络延迟或服务不可用,测试系统韧性。

与传统解决方案相比,Service Mesh的弹性治理具有以下优势:

- 统一策略:弹性治理策略可统一管理,无需在每个服务中实现。

- 动态调整:策略可动态调整,无需重启应用即可生效。

- 全局视角:控制平面可全局视角监控服务健康状态,做出更智能的路由决策。

3.5 跨云与多集群通信

随着云原生应用的规模扩大,跨云和多集群部署成为常态。Service Mesh通过统一的服务发现和路由机制,解决了跨云和多集群环境中的通信问题。

跨云通信实现:

- 控制平面同步各集群的服务元数据,形成统一的服务目录。

- 代理通过xDS协议获取跨集群路由规则,自动转发流量到目标集群。

- 支持mTLS加密和身份验证,确保跨集群通信的安全性。

多集群部署模式:

- 单控制面多数据平面:一个控制平面管理多个集群的数据平面,适合统一治理场景。

- 多控制面多数据平面:每个集群有自己的控制平面,适合隔离治理场景。

- 混合模式:部分集群使用共享控制平面,部分集群独立,适合复杂组织架构。

四、Service Mesh的关键特性:解耦与统一的平衡艺术

Service Mesh的核心价值在于将通信治理逻辑从应用中解耦,同时提供统一的治理策略 。其关键特性包括:

4.1 边车代理(Sidecar Proxy)

边车代理是Service Mesh的数据平面核心,通过与服务实例部署在同一Pod中,透明地接管所有网络流量。代理的主要功能包括:

- 流量转发:拦截和转发服务间的网络流量。

- 协议解析:解析HTTP、gRPC、TCP等协议,提取请求元数据。

- 策略执行:根据控制平面下发的策略执行路由、安全、弹性等治理功能。

边车代理的优势在于:

- 透明性:应用无需感知代理的存在。

- 解耦性:通信治理逻辑与业务代码分离。

- 可扩展性:代理可独立升级和扩展,不影响应用运行。

4.2 透明代理(Transparent Proxy)

透明代理是Service Mesh的另一核心特性,通过修改Pod的iptables规则或使用eBPF技术,实现流量的自动拦截和转发 。透明代理的优势在于:

- 无需应用代码修改:应用只需像本地调用一样访问服务,无需配置代理地址。

- 协议无关性:支持任何网络协议,只要代理能解析或转发。

- 统一治理:所有流量都经过代理,便于统一管理。

4.3 动态服务发现

Service Mesh通过控制平面与Kubernetes API Server的深度集成,实现了动态服务发现 。控制平面监听服务实例的变化(如Pod创建/删除),实时更新路由规则并下发到代理。代理根据EDS(端点发现服务)动态更新实例列表,实现服务发现。

动态服务发现的优势在于:

- 实时性:服务实例变化立即生效,无需手动更新配置。

- 自动化:无需应用代码参与服务发现过程。

- 统一性:所有服务共享同一服务发现机制。

4.4 策略执行与流量控制

Service Mesh通过控制平面定义和执行统一的策略和流量控制规则,包括:

- 流量路由:根据条件(如请求头、版本标签)将流量路由到不同服务版本。

- 访问控制:基于服务身份和请求特征的细粒度访问控制。

- 速率限制:限制服务的请求速率,防止过载。

- 重试与熔断:定义请求重试策略和熔断机制,提高系统可靠性。

策略执行的优势在于:

- 统一管理:策略可通过控制平面统一管理,无需在每个服务中实现。

- 动态调整:策略可动态调整,无需重启应用即可生效。

- 语言无关:策略适用于任何语言开发的服务。

五、主流Service Mesh产品对比:功能、性能与适用场景

目前市场上主流的Service Mesh产品包括Istio、Linkerd、Consul Connect和Kuma等。这些产品在功能、性能和适用场景上各有特点,选择合适的Service Mesh需要考虑组织规模、技术栈和业务需求。

5.1 Istio:功能全面的CNCF顶级项目

Istio是CNCF的顶级项目,由谷歌、IBM和Lyft联合开发。Istio的核心优势在于功能全面和与CNCF生态的深度集成。

Istio的功能特性:

- 流量管理:支持复杂的路由规则、金丝雀发布、A/B测试等。

- 安全通信:支持mTLS加密、细粒度访问控制、零信任安全架构。

- 可观测性:内置指标收集、分布式追踪和日志记录功能。

- 服务身份:基于SPIFFE标准的服务身份管理系统。

- 多集群支持:支持多种多集群部署模式,包括单控制面多数据平面等。

Istio的性能特点:

- 高资源占用:控制平面组件(如Citadel、Galley)较多,资源消耗较高。

- 高延迟:实验显示,Istio可能导致185%的额外延迟和92%的额外CPU消耗 。

- 复杂配置:需要熟悉多种控制平面组件和配置方法。

Istio的适用场景:

- 大型企业:如Airbnb、Salesforce等,需要复杂的微服务治理能力。

- 多集群环境:需要统一管理多个Kubernetes集群的场景。

- CNCF生态:已有Kubernetes、Envoy、Prometheus等CNCF项目的组织。

5.2 Linkerd:轻量级的快速验证工具

Linkerd是CNCF的孵化项目,由Buoyant公司开发。Linkerd的核心优势在于轻量级和简单易用。

Linkerd的功能特性:

- 基础治理:支持服务发现、负载均衡、重试、熔断等基础功能。

- 简单安装:号称"60秒安装",部署和使用门槛低。

- 可观测性:内置Prometheus和Grafana,提供基础指标和追踪功能。

- 安全通信:支持mTLS加密和基本访问控制。

Linkerd的性能特点:

- 低资源占用:代理资源占用较低,适合资源受限环境。

- 低延迟:相比Istio,Linkerd的延迟较低,但高并发下延迟增长显著 。

- 简单配置:配置简单,适合快速验证和学习。

Linkerd的适用场景:

- 中小团队:需要快速验证Service Mesh价值的团队。

- 资源受限环境:如边缘计算、IoT等资源受限场景。

- 学习与实验:用于学习Service Mesh概念和原理的理想选择。

5.3 Consul Connect:与HashiCorp生态深度集成

Consul Connect是HashiCorp Consul服务的一部分,由HashiCorp开发。Consul Connect的核心优势在于与HashiCorp生态的深度集成和简单易用。

Consul Connect的功能特性:

- 服务分段:基于服务身份的网络分段和访问控制。

- 安全通信:支持mTLS加密和细粒度访问控制。

- 可观测性:集成Consul的指标和日志功能。

- 多数据中心:支持多数据中心部署,通过Gossip协议实现服务发现。

Consul Connect的性能特点:

- 中等资源占用:控制平面集成在Consul中,资源消耗适中。

- 中等延迟:延迟略高于Linkerd,但低于Istio。

- 简单配置:配置简单,适合熟悉HashiCorp生态的团队。

Consul Connect的适用场景:

- HashiCorp生态:已有Consul、Nomad、Vault等HashiCorp工具的组织。

- 多数据中心:需要在多个数据中心间部署微服务的场景。

- 服务分段:需要严格控制服务间通信的场景,如金融、政府等高安全需求行业。

5.4 Kuma:多云与混合云的首选

Kuma是CNCF的孵化项目,由Kuma authors开发。Kuma的核心优势在于多云和混合云支持以及轻量级设计。

Kuma的功能特性:

- 多云支持:支持跨多个云提供商部署微服务。

- 混合云支持:支持Kubernetes、虚拟机、裸机等混合环境。

- 多集群支持:通过Zone资源定义不同集群,实现跨集群通信 。

- 服务身份:基于SPIFFE标准的服务身份管理系统。

- Ambient模式:通过Ztunnel和Waypoint实现无侵入代理,减少资源占用 。

Kuma的性能特点:

- 低资源占用:Ambient模式下资源占用显著降低。

- 低延迟:延迟低于Istio,接近Linkerd。

- 简单配置:配置简单,支持多集群和多云环境。

Kuma的适用场景:

- 多云环境:需要在多个云提供商间部署微服务的场景。

- 混合云环境:需要在Kubernetes、虚拟机、裸机等混合环境中部署微服务的场景。

- 大规模集群:需要管理大量服务实例的场景。

六、Service Mesh与同类产品对比:从治理层面对比

Service Mesh与API网关、服务注册中心、微服务框架等传统解决方案相比,在治理层级和功能范围上存在显著差异 。

6.1 与API网关对比

API网关主要解决外部请求的路由和安全问题,而Service Mesh专注于服务间通信的治理。两者在以下方面存在差异:

| 对比维度 | API网关 | Service Mesh |

|---|---|---|

| 治理层级 | 应用层(L7) | 网络层(L4)和应用层(L7) |

| 通信范围 | 外部请求到内部服务 | 服务间通信 |

| 功能侧重 | 路由、安全、限流 | 服务发现、负载均衡、安全、可观测性 |

| 部署方式 | 独立部署 | 边车代理与服务实例部署在一起 |

| 性能影响 | 较低 | 较高(边车代理引入额外开销) |

API网关和Service Mesh可以协同工作:API网关处理外部请求,Service Mesh处理服务间通信。这种组合被称为"服务网格+API网关"模式,可同时满足外部和内部通信的治理需求。

6.2 与服务注册中心对比

服务注册中心(如Eureka、Consul)主要提供服务发现功能,而Service Mesh提供了更全面的通信治理能力。两者在以下方面存在差异:

| 对比维度 | 服务注册中心 | Service Mesh |

|---|---|---|

| 治理层级 | 应用层(L7) | 网络层(L4)和应用层(L7) |

| 功能范围 | 服务发现、基础通信 | 服务发现、负载均衡、安全、可观测性、弹性治理 |

| 部署方式 | 独立部署 | 边车代理与服务实例部署在一起 |

| 性能影响 | 较低 | 较高(边车代理引入额外开销) |

| 语言支持 | 依赖特定语言客户端 | 语言无关 |

Service Mesh可以集成服务注册中心,但不需要在每个服务中嵌入注册中心客户端。例如,Istio集成Consul作为服务注册中心,Linkerd使用Consul或Kubernetes API实现服务发现。

6.3 与微服务框架对比

微服务框架(如Spring Cloud、Dubbo)提供完整的微服务治理能力,但需要在每个服务中嵌入框架代码。Service Mesh通过边车代理实现了与应用代码的解耦,这是两者最本质的区别 。

微服务框架与Service Mesh的对比:

| 对比维度 | 微服务框架 | Service Mesh |

|---|---|---|

| 治理层级 | 应用层(L7) | 网络层(L4)和应用层(L7) |

| 部署方式 | 代码嵌入 | 边车代理与服务实例部署在一起 |

| 语言支持 | 依赖特定语言框架 | 语言无关 |

| 可观测性 | 分散在各个服务中 | 集中收集和分析 |

| 安全通信 | 需要在每个服务中实现 | 代理层统一实现 |

| 资源开销 | 代码级开销,随服务数量增加而累积 | 边车代理开销,可独立优化 |

微服务框架更适合小型微服务应用,而Service Mesh更适合大型分布式系统。例如,Spring Cloud适合单个团队管理的微服务应用,而Istio适合跨多个团队和多个集群的大型分布式系统。

七、Service Mesh在Kubernetes环境中的部署与最佳实践

在Kubernetes环境中部署Service Mesh是当前最常见的场景。部署Service Mesh的关键在于理解其与Kubernetes的关系和协同工作方式 。

7.1 部署前的准备工作

在部署Service Mesh之前,需要做好以下准备工作:

- Kubernetes集群准备:确保集群满足Service Mesh的最低要求,如Kubernetes版本、资源配额等。

- 网络策略配置:确保网络策略允许边车代理与服务实例之间的通信。

- 存储卷准备:为控制平面组件准备持久化存储。

- 身份认证配置:配置Kubernetes的RBAC,确保Service Mesh组件有权访问集群资源。

7.2 服务网格的两种部署模式

Service Mesh在Kubernetes环境中主要有两种部署模式:

7.2.1 Sidecar模式:经典部署方式

Sidecar模式是Service Mesh的经典部署方式,通过在每个应用Pod中自动注入一个独立的Sidecar代理容器来接管所有进出流量。这种架构为应用提供了包括mTLS加密、精细化流量路由、熔断重试和可观测性在内的强大L4-L7层能力,并实现了基于Pod的强安全隔离。

Sidecar模式的部署步骤:

- 安装控制平面组件:如Istio的

istioctl install或Linkerd的linkerd install。 - 启用Sidecar自动注入:通过标签(如

istio-injection=enabled)或命名空间注解启用自动注入。 - 部署应用:应用部署时会自动注入Sidecar代理。

Sidecar模式的优缺点:

- 优点:

- 强安全隔离:每个服务实例都有独立的代理,实现基于Pod的安全策略。

- 精细治理:可针对单个服务实例或版本配置策略。

- 缺点:

- 资源消耗高:每个服务实例都需要一个代理,资源消耗较大。

- 部署复杂:需要管理大量Sidecar代理。

7.2.2 Ambient模式:无侵入部署方式

Ambient模式是Service Mesh的新兴部署方式,通过将网格代理从应用Pod剥离至共享的节点级Ztunnel和按需的服务级Waypoint,解决了Sidecar模式资源占用高和运维复杂的痛点。

Ambient模式的部署步骤:

- 安装控制平面组件:如Istio的

istioctl install或Kuma的kuma-cp。 - 启用Ambient模式:通过标签(如

istio.io/dataplane-mode=ambient)启用命名空间的Ambient模式。 - 部署Ztunnel:作为节点级代理,处理L4层流量。

- 按需部署Waypoint:作为服务级代理,处理L7层流量。

Ambient模式的优缺点:

- 优点:

- 资源消耗低:代理不再与每个服务实例绑定,资源消耗显著降低。

- 运维简化:代理与应用生命周期解耦,升级无需重启应用。

- 缺点:

- 安全粒度较粗:安全策略只能到服务或服务账户级别,无法到Pod级别。

- 功能受限:部分高级功能可能需要额外配置。

7.3 多集群与跨云部署

随着微服务应用规模扩大,多集群和跨云部署成为必然需求。Service Mesh通过统一的服务发现和路由机制,解决了跨云和多集群环境中的通信问题。

多集群部署步骤:

- 配置共享控制平面:如Istio的

Control Plane组件或Kuma的kuma-cp。 - 连接各个集群:如Istio的

istioctl x create-remote-cluster或Kuma的kuma Zone命令。 - 配置跨集群路由:如Istio的

ServiceEntry或Kuma的TrafficRule。

跨云部署注意事项:

- 网络互通:确保各云平台间的网络可以互通。

- 证书管理:确保各云平台间的证书可以互认。

- 服务发现:确保控制平面可以获取各云平台的服务信息。

- 性能优化:考虑跨云通信的延迟和带宽限制。

7.4 性能优化与资源管理

Service Mesh的引入会带来额外的资源消耗和延迟。性能优化是Service Mesh落地的关键环节,需要从代理配置、控制平面扩展和网络策略等多个维度进行。

性能优化最佳实践:

- 调整代理资源限制:根据业务负载调整代理的CPU和内存限制,如设置

requests.cpu: "100m"。 - 启用增量xDS协议:减少配置推送开销,提高控制平面效率。

- 使用Ambient模式:通过共享代理减少资源消耗。

- 优化网络策略:减少不必要的网络规则,降低代理处理负担。

- 调整协议解析深度:根据业务需求调整Envoy的协议解析深度,降低CPU消耗。

7.5 安全加固与最佳实践

安全是Service Mesh的核心价值之一。安全加固需要从服务身份、通信加密、访问控制和证书管理等多个维度进行。

安全最佳实践:

- 强制启用mTLS:通过标签(如

security.istio.io/enabled=true)启用命名空间的mTLS加密。 - 精细化访问控制:基于服务身份和请求特征的细粒度访问控制。

- 证书自动轮换:确保证书定期轮换,减少安全风险。

- 集成外部身份提供商:如Vault等,实现更灵活的身份管理。

- 审计与监控:定期审计安全策略,并监控异常通信行为。

八、Service Mesh的未来发展趋势:从基础设施到智能治理

Service Mesh技术仍在快速发展,未来趋势包括:

8.1 无侵入式架构的普及

Ambient模式代表了Service Mesh部署方式的未来趋势,通过将代理从应用Pod剥离到节点级和共享层,进一步降低资源消耗和运维复杂度。

8.2 与AI/ML的结合

Service Mesh正在与AI/ML技术结合,实现更智能的流量管理和故障预测。例如,基于机器学习的负载均衡算法可以根据历史数据预测服务负载,动态调整流量分配。

8.3 服务网格标准化

服务网格标准化是行业共识,SPIFFE(服务身份)和SPIRE(服务身份实现)等标准正在推动服务网格的互操作性和可移植性。未来可能出现更多标准化的API和协议,降低不同服务网格之间的迁移成本。

8.4 服务网格与边缘计算的融合

随着边缘计算的兴起,服务网格技术正在向边缘场景延伸,提供轻量级的通信治理能力。例如,Kuma已经支持在边缘设备上部署服务网格,实现边缘服务的统一治理。

九、Service Mesh的实践案例:从理论到落地

9.1 互联网行业的应用

在互联网行业中,Service Mesh被广泛应用于大型分布式系统。例如:

- Airbnb:使用Istio管理内部微服务通信,支持复杂的流量路由和安全策略。

- Netflix:早期使用Netflix OSS,后来逐步引入Service Mesh技术,提高系统可观测性和安全性。

- 阿里巴巴:自研服务网格产品,与Kubernetes和阿里云生态深度集成。

9.2 金融行业的应用

在金融行业中,Service Mesh主要用于提高系统安全性和可观测性。例如:

- Capital One:使用Istio实现零信任安全架构,确保服务间通信的安全性。

- 可口可乐:通过Service Mesh统一管理全球分布式系统的通信和安全策略。

- 高盛:使用Service Mesh实现交易系统的可观测性和弹性治理,提高系统可靠性。

十、Service Mesh的挑战与应对策略:从理论到落地的鸿沟

尽管Service Mesh带来了诸多优势,但在实际落地过程中仍面临一些挑战:

10.1 运维复杂度

Service Mesh引入了多个新组件,增加了运维复杂度。应对策略是采用托管服务(如阿里云ASM、AWS App Mesh)或简化配置流程。

10.2 性能开销

边车代理会增加请求延迟和资源消耗。应对策略是启用Ambient模式、调整代理配置和优化网络策略 。

10.3 学习曲线陡峭

Service Mesh涉及多个新概念和技术栈,学习曲线较陡。应对策略是从小规模场景开始,逐步扩展到复杂场景。

10.4 与现有系统的集成

Service Mesh需要与现有系统(如监控工具、安全系统等)集成。应对策略是选择与现有生态兼容的服务网格产品,或通过适配器实现集成。

十一、总结与展望:Service Mesh的未来在哪里?

Service Mesh代表了微服务通信治理的未来方向,通过将通信治理逻辑下沉到基础设施层,为分布式系统提供了统一的治理能力。随着技术的成熟和标准化,Service Mesh的应用范围将不断扩大,从大型互联网企业扩展到更多行业和场景。

未来Service Mesh的发展将围绕以下几个方向:

- 轻量化:通过Ambient模式等创新架构,降低资源消耗和运维复杂度。

- 智能化:与AI/ML技术结合,实现更智能的流量管理和故障预测。

- 标准化:推动服务网格相关标准(如SPIFFE、SPIRE)的成熟和普及。

- 边缘化:向边缘计算场景延伸,提供轻量级的通信治理能力。

- 云原生化:与云原生技术栈(如Kubernetes、Envoy等)深度集成,提供更流畅的用户体验。

Service Mesh不是万能的解决方案,它最适合那些已经采用容器化和云原生技术,并面临复杂微服务治理挑战的组织。对于小型应用或简单微服务架构,传统解决方案可能更为合适。

随着Service Mesh技术的成熟和应用的普及,我们有理由相信,Service Mesh将成为分布式系统通信治理的基础设施层,就像数据库、消息队列等已成为现代应用的标准组件一样。它将帮助组织更好地管理微服务架构的复杂性,提高系统的可靠性和安全性,为数字化转型提供坚实的技术基础。