基于Python3.10.6与jieba库的中文分词模型接口在Windows Server 2022上的实现与部署教程

该教程详细阐述了在Windows Server 2022上基于Python3.10.6与jieba库实现并部署中文分词模型接口的完整流程,涵盖技术栈(Python3.10.6、jieba、Flask、Waitress、Nginx、NSSM等)与环境准备(Python安装、虚拟环境配置、依赖包安装及服务器额外配置),深入解析jieba库的分词原理与功能,设计并实现了基础分词、词性标注、自定义词典、批量分词及服务状态等接口(含参数、返回格式与错误处理),提供直接部署(通过Waitress运行Flask应用、Nginx反向代理、NSSM注册系统服务)与Docker容器化部署两种方案,还包含接口测试方法、常见问题解决(如权限配置、循环导入、中文显示编码等)及服务监控维护要点,最终实现可稳定对外提供服务的中文分词接口。

一、项目概述与环境准备

(一)项目背景与意义

在人工智能与自然语言处理技术飞速发展的当下,中文信息处理在各类应用中的地位愈发凸显。中文分词作为中文信息处理的基础环节,其准确性与效率直接影响后续的词性标注、命名实体识别、情感分析等高级任务的效果。

在实际应用中,众多企业和开发者对稳定、高效、易于集成的中文分词服务存在迫切需求。然而,自行开发分词系统不仅需要深厚的自然语言处理知识,还需大量的语料训练和优化工作,这对于中小型企业或个人开发者而言门槛过高。

jieba库作为目前最流行的Python中文分词工具之一,具备分词速度快、准确率高、易于使用等特点,非常适合作为中文分词服务的基础。本项目旨在基于Python3.10.6和jieba库,构建一个可在Windows Server 2022上独立部署的中文分词模型接口,为外部提供稳定、高效的分词服务。

(二)技术栈介绍

1.Python3.10.6

作为项目的开发语言,Python具有简洁易学、生态丰富的特点,非常适合快速开发此类服务。选择3.10.6版本是因为该版本稳定性好,同时支持一些较新的语言特性,能够更好地满足项目需求。

2.jieba库

一款优秀的中文分词工具,支持三种分词模式:精确模式、全模式和搜索引擎模式。支持自定义词典,能够满足特定领域的分词需求。具有较高的分词准确率和处理速度,适合在生产环境中使用。

3.Flask框架

轻量级的Python Web框架,适合构建API服务。具有灵活、易用的特点,学习成本低,开发效率高。可以方便地与其他库和工具集成。

4.Waitress

Python WSGI HTTP服务器,用于在Windows生产环境中运行Flask应用。支持多线程模式,能够有效提高服务的并发处理能力。

5.Nginx

高性能的HTTP和反向代理服务器。作为前端代理,负责接收客户端请求并转发给Waitress处理。可以提供负载均衡、静态资源服务、SSL终端等功能。

6.Docker(可选)

容器化技术,用于实现应用的快速部署和环境一致性。可以将应用及其依赖打包成一个容器,方便在不同环境中迁移和运行。

7.NSSM(Non-sucking Service Manager)

Windows平台下的服务管理工具,用于将Python应用注册为系统服务,实现开机自启动和进程监控。

(三)环境准备

1.操作系统选择

本项目选择Windows Server 2022作为部署服务器的操作系统。Windows Server 2022具有强大的稳定性、安全性和兼容性,适合作为企业级应用的运行平台,能够为中文分词服务提供可靠的运行环境。

2.Python3.10.6安装

(1)下载Python安装包

访问Python官方网站(https://www.python.org/downloads/release/python-3106/),下载 Windows x86-64 executable installer(64 位版本)。

(2)运行安装程序

双击下载的安装包,勾选“Add Python 3.10 to PATH”选项,然后点击“Install Now”进行默认安装。若需要自定义安装路径,可点击“Customize installation”,在弹出的界面中设置安装目录,建议安装在非系统盘(如D:\Python310)。

(3)验证安装

安装完成后,打开命令提示符(CMD)或PowerShell,输入以下命令:

python --version

若输出“Python 3.10.6”,则表示安装成功。

2.虚拟环境配置

为避免项目依赖与系统环境冲突,建议使用虚拟环境。

(1)打开命令提示符或PowerShell,进入要创建项目的目录,例如:

cd D:\projects

(2)创建项目目录

mkdir chinese-segmentation-api(windows可以直接手动创建)

cd chinese-segmentation-api

(3)创建虚拟环境

python -m venv csa-venv

(4)激活虚拟环境

在命令提示符中:

csa-venv\Scripts\activate.bat

在PowerShell中(需以管理员身份运行):

.\csa-venv\Scripts\Activate.ps1

激活后,命令行提示符前会显示“(csa-venv)”,表示当前处于虚拟环境中。

3.依赖包安装

在虚拟环境中安装项目所需的依赖包(部分,提示缺什么库,再安装即可):

pip install --upgrade pip

pip install jieba==0.42.1

pip install Flask==2.2.3

pip install waitress==2.1.2

pip install flask-restful==0.3.9

pip install python-dotenv==1.0.0

pip install pytest==7.3.1 # 用于单元测试

pip install psutil==5.9.5 # 用于系统资源监控

安装完成后,使用以下命令生成依赖列表文件:

pip freeze > requirements.txt

该文件记录了项目的依赖信息,方便后续在其他环境中部署。最终文件内容如下:

aniso8601==10.0.1

blinker==1.9.0

certifi==2025.8.3

charset-normalizer==3.4.3

click==8.2.1

colorama==0.4.6

Deprecated==1.2.18

dotenv==0.9.9

Flask==3.1.1

Flask-Limiter==3.12

Flask-RESTful==0.3.10

idna==3.10

itsdangerous==2.2.0

jieba==0.42.1

Jinja2==3.1.6

limits==5.5.0

markdown-it-py==4.0.0

MarkupSafe==3.0.2

mdurl==0.1.2

ordered-set==4.1.0

packaging==25.0

psutil==7.0.0

Pygments==2.19.2

python-dotenv==1.1.1

pytz==2025.2

requests==2.32.4

rich==13.9.4

six==1.17.0

typing_extensions==4.14.1

urllib3==2.5.0

waitress==3.0.2

Werkzeug==3.1.3

wrapt==1.17.3

4.开发工具选择

(1)代码编辑器

Visual Studio Code:微软推出的轻量级代码编辑器,支持Python语法高亮、自动补全、调试等功能,插件丰富,跨平台支持好。

PyCharm:JetBrains推出的Python集成开发环境,功能强大,适合大型Python项目开发,但相对较重量级。

(2)版本控制工具

Git:分布式版本控制系统,用于管理项目代码的版本,支持分支管理、代码合并等功能。在Windows上可安装 Git for Windows(https://git-scm.com/download/win)。

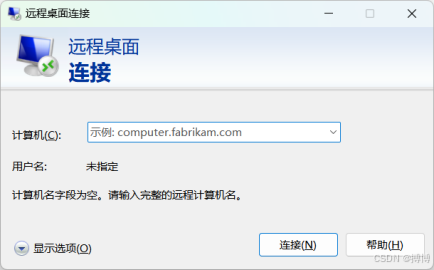

(3)远程连接工具

Remote Desktop Connection:Windows系统自带的远程桌面连接工具,用于连接远程Windows Server 2022服务器。Win+R,输入mstsc即可进入。

PuTTY:支持SSH协议的远程连接工具,可用于连接服务器进行命令行操作。

(4)接口测试工具

Postman:功能强大的API测试工具,支持发送各种HTTP请求,查看响应结果。

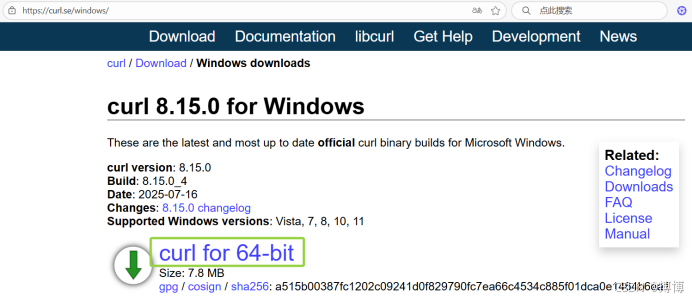

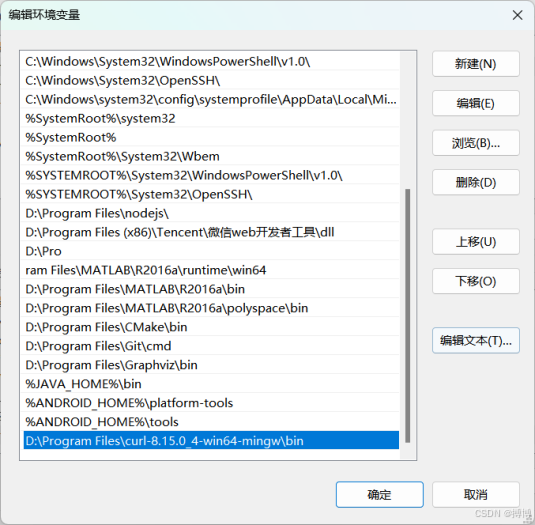

curl:命令行工具,用于发送HTTP请求,适合在服务器上进行简单的接口测试。Windows版本可从https://curl.se/windows/下载。

下载后,解压,将bin目录的路径添加到系统环境变量中。

(四)Windows Server 2022额外配置

1.防火墙设置

打开“Windows Defender防火墙”,点击“高级设置”,在“入站规则”中新建规则,允许端口(如5000、80、443)的连接,确保外部能访问分词服务。

2.安装Nginx

(1)下载Nginx

访问Nginx官方网站(http://nginx.org/en/download.html),下载稳定版本的Windows版本(如nginx-1.24.0.zip)。

(2)解压安装

将下载的压缩包解压到指定目录(如D:\nginx-1.24.0)。

(3)验证安装

打开命令提示符,进入Nginx安装目录,输入:

nginx.exe

在浏览器中访问http://localhost,若出现Nginx欢迎页面,则表示安装成功。

3.安装NSSM

(1)下载NSSM

访问NSSM官方网站(https://nssm.cc/download),下载适合Windows的版本(如nssm-2.24.zip)。

(2)解压配置

将压缩包解压到指定目录(如D:\nssm-2.24),并将该目录添加到系统环境变量PATH中,方便在命令行中使用。

二、jieba库深入理解

(一)jieba库简介

jieba(结巴)是由中国开发者fxsjy开发的一款优秀的中文分词工具,目前在GitHub上拥有超过37k的星标,是Python社区中最受欢迎的中文分词库之一。

jieba库的主要特点包括:

1.支持三种分词模式

(1)精确模式:试图将句子最精确地切开,适合文本分析。

(2)全模式:把句子中所有可以成词的词语都扫描出来,速度非常快,但不能解决歧义。

(3)搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词。

2.支持繁体分词。

3.支持自定义词典,可以根据特定领域的需求添加专业词汇。

4.支持并行分词,能够利用多核 CPU 提高分词速度,但在 Windows 系统上可能存在一些兼容性问题。

5.提供了词性标注功能,可以对分词结果进行词性标注。

6.轻量级,安装简单,使用方便,对新手友好。

(二)jieba的分词原理

jieba库采用的是基于前缀词典的分词方法,结合了统计语言模型。其核心原理如下。

详情内容,可看我CSDN文章:https://lzm07.blog.csdn.net/article/details/150405266

1.前缀词典

jieba内置了一个大规模的中文词典,记录了大量的词语及其词频。在分词过程中,jieba 会从句子的第一个字符开始,查找所有可能的前缀词语,形成一个有向无环图(DAG)。

2.动态规划

利用动态规划算法查找DAG中从起点到终点的最短路径(即最大概率路径),从而得到最优的分词结果。

3.统计语言模型

对于词典中没有的词语(未登录词),jieba采用基于汉字成词能力的HMM(隐马尔可夫模型)进行切分。通过对大量语料的训练,得到汉字之间的转移概率,从而实现对未登录词的识别和切分。

这种结合了规则和统计的方法,使得jieba在保持较高分词速度的同时,也具有较好的分词准确率。

(三)jieba的主要功能与API

1. 基本分词功能

(1)jieba.cut方法

jieba.cut是jieba库最核心的分词函数,其语法如下:

jieba.cut(sentence, cut_all=False, HMM=True)

参数说明:

1)sentence:需要分词的字符串。

2)cut_all:是否使用全模式,默认为False(精确模式)。

3)HMM:是否使用HMM模型识别未登录词,默认为True。

返回值:一个可迭代的生成器,可以通过for循环获取分词结果,也可以使用list()函数转换为列表。

示例:

import jieba

text = "我来到北京清华大学"

# 精确模式

seg_list = jieba.cut(text)

print("精确模式:" + "/ ".join(seg_list)) # 我/ 来到/ 北京/ 清华大学

# 全模式

seg_list = jieba.cut(text, cut_all=True)

print("全模式:" + "/ ".join(seg_list)) # 我/ 来到/ 北京/ 清华/ 清华大学/ 华大/ 大学

# 不使用HMM模型

seg_list = jieba.cut(text, HMM=False)

print("不使用HMM:" + "/ ".join(seg_list)) # 我/ 来到/ 北京/ 清华大学

(2)jieba.cut_for_search方法

jieba.cut_for_search用于搜索引擎模式分词,其语法如下:

jieba.cut_for_search(sentence, HMM=True)

参数说明与jieba.cut类似,但没有cut_all参数,因为搜索引擎模式是在精确模式的基础上进行的。

示例:

import jieba

text = "小明硕士毕业于中国科学院计算所,后在日本京都大学深造"

seg_list = jieba.cut_for_search(text)

print("搜索引擎模式:" + "/ ".join(seg_list))

# 输出:小明/ 硕士/ 毕业/ 于/ 中国/ 科学/ 学院/ 科学院/ 中国科学院/ 计算/ 计算所/ ,/ 后/ 在/ 日本/ 京都/ 大学/ 京都大学/ 深造

2. 自定义词典

jieba支持用户添加自定义词典,以提高特定领域的分词准确率。自定义词典的格式为:

词语 词频 词性

其中,词频和词性为可选参数,默认词频为 1,词性可以省略。

(1)jieba.load_userdict方法

jieba.load_userdict用于加载自定义词典,其语法如下:

jieba.load_userdict(filename)

参数filename为自定义词典的路径。

示例:

假设我们有一个自定义词典user_dict.txt,内容如下:

云计算 5

人工智能 3

机器学习 n

加载并使用自定义词典:

import jieba

jieba.load_userdict("user_dict.txt")

text = "云计算和人工智能是当前热门的技术,机器学习是人工智能的一个重要分支"

seg_list = jieba.cut(text)

print("/ ".join(seg_list))

# 输出:云计算/ 和/ 人工智能/ 是/ 当前/ 热门/ 的/ 技术/ ,/ 机器学习/ 是/ 人工智能/ 的/ 一个/ 重要/ 分支

(2)动态添加/删除词语

除了加载自定义词典外,jieba还提供了动态添加和删除词语的方法:

1)jieba.add_word(word, freq=None, tag=None):添加词语到词典中。

2)jieba.del_word(word):从词典中删除词语。

3)jieba.suggest_freq(segment, tune=True):调整词语的词频,使得词语能够被正确分出来。

示例:

import jieba

text = "李小福是创新办主任也是云计算方面的专家"

# 未添加自定义词语时的分词结果

seg_list = jieba.cut(text)

print("默认:" + "/ ".join(seg_list)) # 李/ 小福/ 是/ 创新/ 办/ 主任/ 也/ 是/ 云/ 计算/ 方面/ 的/ 专家

# 添加自定义词语

jieba.add_word("李小福")

jieba.add_word("创新办")

jieba.add_word("云计算")

seg_list = jieba.cut(text)

print("添加后:" + "/ ".join(seg_list)) # 李小福/ 是/ 创新办/ 主任/ 也/ 是/ 云计算/ 方面/ 的/ 专家

# 调整词频

text = "台中"

seg_list = jieba.cut(text)

print("调整前:" + "/ ".join(seg_list)) # 台/ 中

jieba.suggest_freq(("台", "中"), tune=True)

seg_list = jieba.cut(text)

print("调整后:" + "/ ".join(seg_list)) # 台/ 中(这里可能需要更多上下文才能生效)

3. 词性标注

jieba提供了词性标注功能,可以使用jieba.posseg模块进行词性标注。

jieba.posseg.cut方法的语法如下:

jieba.posseg.cut(sentence, cut_all=False, HMM=True)

返回值:一个可迭代的生成器,每个元素是一个pair对象,包含词语和词性。

常见的词性标签说明:

n:名词

v:动词

a:形容词

d:副词

r:代词

m:数词

q:量词

p:介词

c:连词

u:助词

x:标点符号

示例:

import jieba.posseg as pseg

words = pseg.cut("我爱自然语言处理")

for word, flag in words:

print(f"{word}/{flag}", end=" ")

# 输出:我/r 爱/v 自然/a 语言/n 处理/v

4. 并行分词

为了提高分词速度,jieba支持并行分词。使用并行分词需要先调用jieba.enable_parallel方法开启并行模式。

import jieba

import time

# 开启并行分词,参数为并行进程数,默认使用全部CPU核心

jieba.enable_parallel(4)

text = "这是一段很长的文本..." * 1000 # 构造一段长文本

start_time = time.time()

result = jieba.cut(text)

end_time = time.time()

print(f"并行分词时间:{end_time - start_time:.4f}秒")

# 关闭并行分词

jieba.disable_parallel()

start_time = time.time()

result = jieba.cut(text)

end_time = time.time()

print(f"普通分词时间:{end_time - start_time:.4f}秒")

注意:并行分词在Windows系统上可能存在一些问题,建议在Linux或macOS系统上使用。

(四)jieba的性能优化

在实际应用中,分词性能是一个重要的考量因素。以下是一些优化jieba分词性能的方法:

(1)使用并行分词:如前所述,开启并行分词可以利用多核CPU提高分词速度,对于处理大量文本时效果显著,但在Windows系统上需注意兼容性问题。

(2)减少词典加载次数:jieba的词典加载是一个相对耗时的操作,在应用初始化时加载一次词典,而不是每次分词都加载,可以提高性能。

(3)使用自定义词典过滤低频词:对于一些特定领域的应用,可以通过自定义词典添加高频专业词汇,同时过滤掉一些低频的、不常用的词汇,减少分词时的计算量。

(4)预加载模型:在应用启动时预先加载jieba的模型和词典,避免在处理第一个请求时进行加载,减少首屏延迟。

(5)合理设置HMM参数:对于一些对未登录词识别要求不高的场景,可以关闭HMM模型(HMM=False),以提高分词速度。

(6)批量处理文本:一次性处理多条文本比逐条处理效率更高,因为可以减少一些初始化操作的开销。

(7)考虑使用C扩展版本:jieba有一个C语言扩展版本jieba_fast,分词速度比纯Python版本快很多,可以考虑使用。安装方法:pip install jieba_fast。

三、中文分词接口设计

(一)接口需求分析

在设计中文分词接口之前,我们需要明确接口的需求,包括功能需求和非功能需求。

1.功能需求

(1)基本分词功能:支持对输入的中文文本进行分词,并返回分词结果。

(2)多模式分词:支持精确模式、全模式和搜索引擎模式三种分词模式,用户可以根据需要选择。

(3)词性标注:支持对分词结果进行词性标注,返回每个词语及其对应的词性。

(4)自定义词典:支持用户临时添加自定义词语,以提高特定场景下的分词准确率。

(5)批量处理:支持对多条文本进行批量分词,提高处理效率。

(6)结果过滤:支持过滤掉分词结果中的标点符号、停用词等无关信息。

2.非功能需求

(1)性能:分词接口应具有较高的响应速度,对于普通长度的文本(如1000字以内),响应时间应控制在100ms以内。

(2)稳定性:接口应能够稳定运行,平均无故障时间(MTBF)应不低于72小时。

(3)可扩展性:接口设计应具有良好的可扩展性,便于后续添加新的功能,如关键词提取、实体识别等。

(4)安全性:接口应提供基本的安全机制,如 API 密钥认证,防止未授权访问。

(5)易用性:接口应具有清晰的文档和简单的调用方式,方便用户集成。

(6)可监控性:接口应提供基本的监控指标,如请求量、响应时间、错误率等,便于运维人员监控服务状态。

(二)接口功能设计

根据需求分析,我们设计以下几个主要接口:

(1)基础分词接口:提供基本的分词功能,支持三种分词模式。

(2)词性标注接口:在分词的基础上,返回每个词语的词性。

(3)自定义词典接口:支持添加、删除自定义词语,以及加载自定义词典文件。

(4)批量分词接口:支持对多条文本进行批量分词处理。

(5)服务状态接口:返回服务的基本信息和状态,如版本号、当前负载等。

(三)接口参数设计

1.基础分词接口

请求URL:/api/segment

请求方法:POST

请求参数:

(1)text(必填):待分词的中文文本,字符串类型。

(2)mode(可选):分词模式,字符串类型,取值为 "accurate"(精确模式,默认)、"full"(全模式)、"search"(搜索引擎模式)。

(3)use_hmm(可选):是否使用 HMM 模型,布尔类型,默认为 true。

(4)filter_stopwords(可选):是否过滤停用词,布尔类型,默认为 false。

(5)filter_punctuation(可选):是否过滤标点符号,布尔类型,默认为 false。

2.词性标注接口

请求URL:/api/pos_tag

请求方法:POST

请求参数:

(1)text(必填):待处理的中文文本,字符串类型。

(2)mode(可选):分词模式,字符串类型,取值同上,默认为 "accurate"。

(3)use_hmm(可选):是否使用 HMM 模型,布尔类型,默认为 true。

(4)filter_stopwords(可选):是否过滤停用词,布尔类型,默认为 false。

(5)filter_punctuation(可选):是否过滤标点符号,布尔类型,默认为 false。

3.自定义词典接口

请求URL:/api/custom_dict

请求方法:POST

请求参数:

(1)action(必填):操作类型,字符串类型,取值为 "add"(添加词语)、"delete"(删除词语)、"load"(加载词典文件)。

(2)words(可选):当 action 为 "add" 或 "delete" 时,为要添加或删除的词语列表,数组类型。每个元素可以是字符串(仅词语)或对象(包含 word、freq、tag 字段)。

(3)file_url(可选):当 action 为 "load" 时,为自定义词典文件的 URL,字符串类型。

4.批量分词接口

请求URL:/api/batch_segment

请求方法:POST

请求参数:

(1)texts(必填):待分词的中文文本列表,数组类型。

(2)mode(可选):分词模式,字符串类型,取值同上,默认为 "accurate"。

(3)use_hmm(可选):是否使用 HMM 模型,布尔类型,默认为 true。

(4)filter_stopwords(可选):是否过滤停用词,布尔类型,默认为 false。

(5)filter_punctuation(可选):是否过滤标点符号,布尔类型,默认为 false。

5.服务状态接口

请求URL:/api/status

请求方法:GET

请求参数:无

(四)接口返回格式设计

所有接口均返回JSON格式的数据,包含以下公共字段:

(1)code:状态码,整数类型。0 表示成功,非 0 表示错误。

(2)message:状态描述,字符串类型。成功时为 "success",错误时为具体的错误信息。

(3)data:返回的数据,具体类型根据接口而定。成功时返回实际数据,错误时可能为 null。

1.基础分词接口返回格式

json格式内容:

{"code": 0,"message": "success","data": {"text": "我来到北京清华大学","segments": ["我", "来到", "北京", "清华大学"],"mode": "accurate","use_hmm": true,"timestamp": 1680000000}

}2.词性标注接口返回格式

json格式内容:

{"code": 0,"message": "success","data": {"text": "我爱自然语言处理","tags": [{"word": "我", "tag": "r"},{"word": "爱", "tag": "v"},{"word": "自然", "tag": "a"},{"word": "语言", "tag": "n"},{"word": "处理", "tag": "v"}],"mode": "accurate","use_hmm": true,"timestamp": 1680000000}

}3.自定义词典接口返回格式

json格式内容:

{"code": 0,"message": "success","data": {"action": "add","success_count": 2,"failed_words": [],"timestamp": 1680000000}

}4.批量分词接口返回格式

json格式内容:

{"code": 0,"message": "success","data": {"total": 2,"results": [{"text": "我来到北京清华大学","segments": ["我", "来到", "北京", "清华大学"]},{"text": "我爱自然语言处理","segments": ["我", "爱", "自然", "语言", "处理"]}],"mode": "accurate","use_hmm": true,"timestamp": 1680000000}

}5.服务状态接口返回格式

json格式内容:

{"code": 0,"message": "success","data": {"version": "1.0.0","status": "running","start_time": 1680000000,"current_time": 1680000100,"request_count": 100,"average_response_time": 50,"cpu_usage": 20.5,"memory_usage": 30.2}

}(五)错误处理机制设计

为了提高接口的健壮性,需要设计完善的错误处理机制。

1.错误码设计

定义以下常见的错误码:

0:成功

1001:参数错误(如缺少必填参数、参数格式错误等)

1002:权限错误(如API密钥无效、未授权访问等)

1003:资源不存在(如请求的词典文件不存在等)

1004:请求频率限制(如单位时间内请求次数超过限制)

2001:服务器内部错误(如代码异常、服务崩溃等)

2002:服务暂时不可用(如服务正在重启、维护等)

2.错误处理流程

(1)参数验证:在接口处理之前,先对请求参数进行验证,如发现参数错误,返回 1001 错误码和具体的错误信息。

(2)权限验证:对于需要授权的接口,验证请求中的 API 密钥,如密钥无效或未提供,返回 1002 错误码。

(3)请求频率控制:检查当前请求是否超过频率限制,如超过,返回 1004 错误码。

(4)业务逻辑处理:在处理业务逻辑时,如发生异常,捕获异常并返回 2001 错误码,同时记录详细的错误日志。

(5)服务状态检查:如服务处于维护状态,返回 2002 错误码。

3.错误日志记录

为了便于排查问题,需要记录详细的错误日志,包括:

(1)错误发生的时间

(2)错误码和错误信息

(3)请求的URL、方法、参数

(4)客户端IP地址

(5)堆栈跟踪信息(对于服务器内部错误)

错误日志可以写入文件,也可以发送到专门的日志收集系统(如ELK、Graylog等)。在Windows Server 2022上,可将日志存储在指定的目录(如D:\chinese-segmentation-api\logs)。

四、接口实现代码详解

(一)项目结构设计

为了使项目结构清晰,便于维护和扩展,我们采用以下项目结构:

D:\chinese-segmentation-api\

├── app/

│ ├── __init__.py # 应用初始化

│ ├── config.py # 配置文件

│ ├── api/ # API接口模块

│ │ ├── __init__.py

│ │ ├── segment.py # 分词相关接口

│ │ ├── pos_tag.py # 词性标注接口

│ │ ├── custom_dict.py # 自定义词典接口

│ │ ├── batch.py # 批量处理接口

│ │ └── status.py # 服务状态接口

│ ├── core/ # 核心功能模块

│ │ ├── __init__.py

│ │ ├── segmenter.py # 分词器实现

│ │ ├── pos_tagger.py # 词性标注器实现

│ │ ├── custom_dict_manager.py # 自定义词典管理器

│ │ └── stopwords.py # 停用词处理

│ ├── utils/ # 工具类模块

│ │ ├── __init__.py

│ │ ├── logger.py # 日志工具

│ │ ├── auth.py # 认证工具

│ │ ├── rate_limit.py # 频率限制工具

│ │ └── metrics.py # metrics收集工具

│ └── data/ # 数据目录

│ ├── stopwords.txt # 停用词表

│ └── custom_dicts/ # 自定义词典目录

├── tests/ # 测试模块

│ ├── __init__.py

│ ├── test_segment.py

│ ├── test_pos_tag.py

│ └── test_custom_dict.py

├── .env # 环境变量配置

├── .gitignore # Git忽略文件

├── requirements.txt # 依赖包列表

├── run.py # 应用启动入口

├── start_server.bat # 启动服务的批处理文件

└── README.md # 项目说明文档

(二)核心分词功能实现

1.配置文件(app/config.py)

python代码如下:

import os

from dotenv import load_dotenv# 加载环境变量

load_dotenv()class Config:"""基础配置类"""# 应用配置APP_NAME = os.getenv("APP_NAME", "Chinese Segmentation API")VERSION = os.getenv("VERSION", "1.0.0")DEBUG = os.getenv("DEBUG", "False").lower() == "true"# 服务器配置HOST = os.getenv("HOST", "0.0.0.0")PORT = int(os.getenv("PORT", 5000))WORKERS = int(os.getenv("WORKERS", 4)) # Waitress的工作线程数# 认证配置API_KEY = os.getenv("API_KEY", "")REQUIRE_AUTH = os.getenv("REQUIRE_AUTH", "True").lower() == "true"# 频率限制配置RATE_LIMIT = os.getenv("RATE_LIMIT", "100/minute")# 数据文件路径(适应Windows路径)BASE_DIR = os.path.abspath(os.path.dirname(os.path.dirname(__file__)))DATA_DIR = os.path.join(BASE_DIR, "data")STOPWORDS_PATH = os.path.join(DATA_DIR, "stopwords.txt")CUSTOM_DICTS_DIR = os.path.join(DATA_DIR, "custom_dicts")# 日志配置LOG_DIR = os.path.join(BASE_DIR, "logs")LOG_LEVEL = os.getenv("LOG_LEVEL", "INFO")@classmethoddef init_directories(cls):"""初始化必要的目录"""for dir_path in [cls.DATA_DIR, cls.CUSTOM_DICTS_DIR, cls.LOG_DIR]:if not os.path.exists(dir_path):os.makedirs(dir_path, exist_ok=True)class DevelopmentConfig(Config):"""开发环境配置"""DEBUG = TrueLOG_LEVEL = "DEBUG"class ProductionConfig(Config):"""生产环境配置"""DEBUG = FalseLOG_LEVEL = "INFO"# 根据环境变量选择配置

config = {"development": DevelopmentConfig,"production": ProductionConfig,"default": DevelopmentConfig

}def get_config():"""获取配置实例"""env = os.getenv("ENVIRONMENT", "default")return config[env]2.应用初始化(app/__init__.py)

python代码如下:

from flask import Flask

from flask_restful import Api

from .config import get_config, Config

from .api.segment import SegmentResource

from .api.pos_tag import PosTagResource

from .api.custom_dict import CustomDictResource

from .api.batch import BatchSegmentResource

from .api.status import StatusResource

from .utils.logger import setup_logger

from .utils.auth import AuthMiddleware

from .utils.rate_limit import setup_rate_limit

from .core.segmenter import init_segmenter# 初始化配置

config = get_config()

Config.init_directories()# 初始化日志

logger = setup_logger(config)# 初始化分词器

init_segmenter(config)def create_app():"""创建并配置Flask应用"""app = Flask(config.APP_NAME)app.config.from_object(config)# 设置日志app.logger = logger# 添加认证中间件if config.REQUIRE_AUTH and config.API_KEY:app.wsgi_app = AuthMiddleware(app.wsgi_app, config.API_KEY)# 初始化APIapi = Api(app)# 设置频率限制setup_rate_limit(app, config.RATE_LIMIT)# 注册API资源api.add_resource(SegmentResource, '/api/segment')api.add_resource(PosTagResource, '/api/pos_tag')api.add_resource(CustomDictResource, '/api/custom_dict')api.add_resource(BatchSegmentResource, '/api/batch_segment')api.add_resource(StatusResource, '/api/status')app.logger.info(f"Application {config.APP_NAME} v{config.VERSION} initialized")return app3.分词器实现(app/core/segmenter.py)

python代码如下:

import jieba

import jieba.posseg as pseg

import os

import platform

from datetime import datetime

from ..config import get_config

from .stopwords import StopwordsFilter# 全局变量

segmenter_initialized = False

stopwords_filter = None

start_time = datetime.now()def init_segmenter(config):"""初始化分词器"""global segmenter_initialized, stopwords_filterif segmenter_initialized:returntry:# 延迟导入loggerfrom app import logger# 加载停用词stopwords_filter = StopwordsFilter(config.STOPWORDS_PATH)# 加载默认的自定义词典custom_dict_files = [f for f in os.listdir(config.CUSTOM_DICTS_DIR) if f.endswith('.txt') and os.path.isfile(os.path.join(config.CUSTOM_DICTS_DIR, f))]for dict_file in custom_dict_files:dict_path = os.path.join(config.CUSTOM_DICTS_DIR, dict_file)jieba.load_userdict(dict_path)logger.info(f"Loaded custom dictionary: {dict_path}")# 启用并行分词(Windows系统下不启用)try:if platform.system() != "Windows":jieba.enable_parallel()logger.info("Enabled parallel segmentation")else:logger.info("Parallel segmentation is not enabled on Windows system")except Exception as e:logger.warning(f"Failed to enable parallel segmentation: {str(e)}")segmenter_initialized = Truelogger.info("Segmenter initialized successfully")except Exception as e:# 延迟导入loggerfrom app import loggerlogger.error(f"Failed to initialize segmenter: {str(e)}", exc_info=True)raisedef get_segment_mode(mode):"""获取分词模式对应的函数"""# 延迟导入loggerfrom app import loggerif mode == "full":return jieba.cut, {"cut_all": True}elif mode == "search":return jieba.cut_for_search, {}else: # 默认精确模式return jieba.cut, {"cut_all": False}def segment_text(text, mode="accurate", use_hmm=True, filter_stopwords=False, filter_punctuation=False):"""对文本进行分词参数:text: 待分词的文本mode: 分词模式,"accurate"(精确)、"full"(全模式)、"search"(搜索引擎)use_hmm: 是否使用HMM模型filter_stopwords: 是否过滤停用词filter_punctuation: 是否过滤标点符号返回:分词结果列表"""# 延迟导入loggerfrom app import loggerif not segmenter_initialized:raise Exception("Segmenter not initialized")if not text or not isinstance(text, str):return []try:cut_func, kwargs = get_segment_mode(mode)segments = cut_func(text, HMM=use_hmm, **kwargs)# 转换为列表result = list(segments)# 过滤处理if filter_stopwords or filter_punctuation:result = stopwords_filter.filter(result,filter_stopwords=filter_stopwords,filter_punctuation=filter_punctuation)return resultexcept Exception as e:logger.error(f"Error in segment_text: {str(e)}", exc_info=True)raisedef pos_tag_text(text, mode="accurate", use_hmm=True, filter_stopwords=False, filter_punctuation=False):"""对文本进行词性标注参数:text: 待处理的文本mode: 分词模式use_hmm: 是否使用HMM模型filter_stopwords: 是否过滤停用词filter_punctuation: 是否过滤标点符号返回:词性标注结果列表,每个元素为{"word": 词语, "tag": 词性}"""# 延迟导入loggerfrom app import loggerif not segmenter_initialized:raise Exception("Segmenter not initialized")if not text or not isinstance(text, str):return []try:# 分词并标注词性words = pseg.cut(text, HMM=use_hmm)result = [{"word": word, "tag": flag} for word, flag in words]# 过滤处理if filter_stopwords or filter_punctuation:filtered = []for item in result:if stopwords_filter.should_keep(item["word"],filter_stopwords=filter_stopwords,filter_punctuation=filter_punctuation):filtered.append(item)result = filteredreturn resultexcept Exception as e:logger.error(f"Error in pos_tag_text: {str(e)}", exc_info=True)raisedef add_custom_words(words):"""添加自定义词语参数:words: 词语列表,每个元素可以是字符串或包含"word"、"freq"、"tag"的字典返回:成功添加的词语数量和失败的词语列表"""# 延迟导入loggerfrom app import loggerif not segmenter_initialized:raise Exception("Segmenter not initialized")success_count = 0failed_words = []if not words or not isinstance(words, list):return success_count, failed_wordsfor word_info in words:try:if isinstance(word_info, str):jieba.add_word(word_info)elif isinstance(word_info, dict):word = word_info.get("word")if not word:failed_words.append(word_info)continuefreq = word_info.get("freq")tag = word_info.get("tag")jieba.add_word(word, freq=freq, tag=tag)else:failed_words.append(word_info)continuesuccess_count += 1logger.info(f"Added custom word: {word_info}")except Exception as e:logger.warning(f"Failed to add custom word {word_info}: {str(e)}")failed_words.append(word_info)return success_count, failed_wordsdef delete_custom_words(words):"""删除自定义词语参数:words: 词语列表返回:成功删除的词语数量和失败的词语列表"""# 延迟导入loggerfrom app import loggerif not segmenter_initialized:raise Exception("Segmenter not initialized")success_count = 0failed_words = []if not words or not isinstance(words, list):return success_count, failed_wordsfor word in words:try:if not isinstance(word, str):failed_words.append(word)continuejieba.del_word(word)success_count += 1logger.info(f"Deleted custom word: {word}")except Exception as e:logger.warning(f"Failed to delete custom word {word}: {str(e)}")failed_words.append(word)return success_count, failed_wordsdef load_custom_dict(file_path):"""加载自定义词典文件参数:file_path: 词典文件路径返回:是否加载成功"""# 延迟导入loggerfrom app import loggerif not segmenter_initialized:raise Exception("Segmenter not initialized")try:if not os.path.exists(file_path) or not os.path.isfile(file_path):logger.error(f"Custom dictionary file not found: {file_path}")return Falsejieba.load_userdict(file_path)logger.info(f"Loaded custom dictionary file: {file_path}")return Trueexcept Exception as e:logger.error(f"Failed to load custom dictionary {file_path}: {str(e)}", exc_info=True)return False4.停用词处理(app/core/stopwords.py)

python代码如下:

import os

import reclass StopwordsFilter:"""停用词过滤器"""def __init__(self, stopwords_path):"""初始化停用词过滤器"""self.stopwords = set()self.punctuation_pattern = re.compile(r'[^\w\s]')self.load_stopwords(stopwords_path)def load_stopwords(self, file_path):"""加载停用词表"""# 延迟导入loggerfrom app import loggertry:if os.path.exists(file_path) and os.path.isfile(file_path):with open(file_path, 'r', encoding='utf-8') as f:for line in f:word = line.strip()if word:self.stopwords.add(word)logger.info(f"Loaded {len(self.stopwords)} stopwords from {file_path}")else:logger.warning(f"Stopwords file not found: {file_path}, using empty stopwords list")except Exception as e:logger.error(f"Failed to load stopwords: {str(e)}", exc_info=True)def is_stopword(self, word):"""判断是否为停用词"""# 延迟导入loggerfrom app import loggerreturn word in self.stopwordsdef is_punctuation(self, word):"""判断是否为标点符号"""# 延迟导入loggerfrom app import loggerreturn len(word) == 1 and self.punctuation_pattern.match(word) is not Nonedef should_keep(self, word, filter_stopwords=True, filter_punctuation=True):"""判断是否应该保留该词语"""# 延迟导入loggerfrom app import loggerif filter_stopwords and self.is_stopword(word):return Falseif filter_punctuation and self.is_punctuation(word):return Falsereturn Truedef filter(self, words, filter_stopwords=True, filter_punctuation=True):"""过滤词语列表"""# 延迟导入loggerfrom app import loggerreturn [word for word in words if self.should_keep(word, filter_stopwords, filter_punctuation)](三)接口服务实现

1.基础分词接口(app/api/segment.py)

python代码如下:

from flask_restful import Resource, reqparse

from ..core.segmenter import segment_text

from ..utils.metrics import increment_request_count, record_response_time

import timeimport json

from flask import make_response # json返回中文class SegmentResource(Resource):"""分词接口资源"""def __init__(self):"""初始化请求解析器"""self.parser = reqparse.RequestParser()self.parser.add_argument('text', type=str, required=True, help='Text to segment is required')self.parser.add_argument('mode', type=str, choices=['accurate', 'full', 'search'], default='accurate')self.parser.add_argument('use_hmm', type=bool, default=True)self.parser.add_argument('filter_stopwords', type=bool, default=False)self.parser.add_argument('filter_punctuation', type=bool, default=False)@record_response_time()@increment_request_count()def post(self):"""处理POST请求"""# 延迟导入loggerfrom app import loggerstart_time = time.time()try:# 解析请求参数args = self.parser.parse_args()text = args['text']mode = args['mode']use_hmm = args['use_hmm']filter_stopwords = args['filter_stopwords']filter_punctuation = args['filter_punctuation']logger.info(f"Segment request received: mode={mode}, text_length={len(text)}")# 执行分词segments = segment_text(text,mode=mode,use_hmm=use_hmm,filter_stopwords=filter_stopwords,filter_punctuation=filter_punctuation)# 构造响应数据response = {'code': 0,'message': 'success','data': {'text': text,'segments': segments,'mode': mode,'use_hmm': use_hmm,'timestamp': int(time.time())}}# 手动序列化JSON,强制不转义中文json_str = json.dumps(response, ensure_ascii=False)response = make_response(json_str)response.headers['Content-Type'] = 'application/json'logger.debug(f"Segment request processed in {time.time() - start_time:.4f}s")return responseexcept Exception as e:logger.error(f"Error processing segment request: {str(e)}", exc_info=True)return {'code': 2001,'message': f"Internal server error: {str(e)}",'data': None}, 5002.词性标注接口(app/api/pos_tag.py)

python代码如下:

from flask_restful import Resource, reqparse

from ..core.segmenter import pos_tag_text

from ..utils.metrics import increment_request_count, record_response_time

import timeimport json

from flask import make_response # json返回中文class PosTagResource(Resource):"""词性标注接口资源"""def __init__(self):"""初始化请求解析器"""self.parser = reqparse.RequestParser()self.parser.add_argument('text', type=str, required=True, help='Text to pos tag is required')self.parser.add_argument('mode', type=str, choices=['accurate', 'full', 'search'], default='accurate')self.parser.add_argument('use_hmm', type=bool, default=True)self.parser.add_argument('filter_stopwords', type=bool, default=False)self.parser.add_argument('filter_punctuation', type=bool, default=False)@record_response_time()@increment_request_count()def post(self):"""处理POST请求"""# 延迟导入loggerfrom app import loggerstart_time = time.time()try:# 解析请求参数args = self.parser.parse_args()text = args['text']mode = args['mode']use_hmm = args['use_hmm']filter_stopwords = args['filter_stopwords']filter_punctuation = args['filter_punctuation']logger.info(f"POS tag request received: mode={mode}, text_length={len(text)}")# 执行词性标注tags = pos_tag_text(text,mode=mode,use_hmm=use_hmm,filter_stopwords=filter_stopwords,filter_punctuation=filter_punctuation)# 构造响应response = {'code': 0,'message': 'success','data': {'text': text,'tags': tags,'mode': mode,'use_hmm': use_hmm,'timestamp': int(time.time())}}# 手动序列化JSON,强制不转义中文json_str = json.dumps(response, ensure_ascii=False)response = make_response(json_str)response.headers['Content-Type'] = 'application/json'logger.debug(f"POS tag request processed in {time.time() - start_time:.4f}s")return responseexcept Exception as e:logger.error(f"Error processing pos tag request: {str(e)}", exc_info=True)return {'code': 2001,'message': f"Internal server error: {str(e)}",'data': None}, 5003.自定义词典接口(app/api/custom_dict.py)

python代码如下:

from flask_restful import Resource, reqparse

from ..core.segmenter import add_custom_words, delete_custom_words, load_custom_dict

from ..config import get_config

from ..utils.metrics import increment_request_count, record_response_time

import time

import os

import tempfile

import requestsimport json

from flask import make_response # json返回中文class CustomDictResource(Resource):"""自定义词典接口资源"""def __init__(self):"""初始化请求解析器"""self.parser = reqparse.RequestParser()self.parser.add_argument('action', type=str, required=True, choices=['add', 'delete', 'load'],help='Action must be one of: add, delete, load')self.parser.add_argument('words', type=list, default=[])self.parser.add_argument('file_url', type=str, default='')self.config = get_config()@record_response_time()@increment_request_count()def post(self):"""处理POST请求"""# 延迟导入loggerfrom app import loggerstart_time = time.time()try:# 解析请求参数args = self.parser.parse_args()action = args['action']words = args['words']file_url = args['file_url']logger.info(f"Custom dict request received: action={action}")data = {}if action == 'add':# 添加自定义词语success_count, failed_words = add_custom_words(words)data = {'action': action,'success_count': success_count,'failed_words': failed_words}elif action == 'delete':# 删除自定义词语success_count, failed_words = delete_custom_words(words)data = {'action': action,'success_count': success_count,'failed_words': failed_words}elif action == 'load':# 加载自定义词典文件if not file_url:return {'code': 1001,'message': 'file_url is required for load action','data': None}, 400# 下载词典文件try:response = requests.get(file_url, timeout=30)response.raise_for_status()# 保存到临时文件(Windows系统的临时文件路径处理)with tempfile.NamedTemporaryFile(mode='w', encoding='utf-8', delete=False, suffix='.txt') as f:f.write(response.text)temp_file_path = f.name# 加载词典success = load_custom_dict(temp_file_path)# 删除临时文件os.unlink(temp_file_path)data = {'action': action,'success': success,'file_url': file_url}except Exception as e:logger.error(f"Failed to download or load custom dict file: {str(e)}", exc_info=True)return {'code': 1003,'message': f"Failed to load custom dictionary: {str(e)}",'data': None}, 400# 构造响应response = {'code': 0,'message': 'success','data': {**data,'timestamp': int(time.time())}}# 手动序列化JSON,强制不转义中文json_str = json.dumps(response, ensure_ascii=False)response = make_response(json_str)response.headers['Content-Type'] = 'application/json'logger.debug(f"Custom dict request processed in {time.time() - start_time:.4f}s")return responseexcept Exception as e:logger.error(f"Error processing custom dict request: {str(e)}", exc_info=True)return {'code': 2001,'message': f"Internal server error: {str(e)}",'data': None}, 5004.批量分词接口(app/api/batch.py)

python代码如下:

from flask_restful import Resource, reqparse

from ..core.segmenter import segment_text

from ..utils.metrics import increment_request_count, record_response_time

import time

from concurrent.futures import ThreadPoolExecutorimport json

from flask import make_response # json返回中文class BatchSegmentResource(Resource):"""批量分词接口资源"""def __init__(self):"""初始化请求解析器"""self.parser = reqparse.RequestParser()self.parser.add_argument('texts', type=list, required=True, help='List of texts to segment is required')self.parser.add_argument('mode', type=str, choices=['accurate', 'full', 'search'], default='accurate')self.parser.add_argument('use_hmm', type=bool, default=True)self.parser.add_argument('filter_stopwords', type=bool, default=False)self.parser.add_argument('filter_punctuation', type=bool, default=False)self.executor = ThreadPoolExecutor(max_workers=4) # 线程池大小def process_single_text(self, text, mode, use_hmm, filter_stopwords, filter_punctuation):"""处理单条文本"""# 延迟导入loggerfrom app import loggertry:segments = segment_text(text,mode=mode,use_hmm=use_hmm,filter_stopwords=filter_stopwords,filter_punctuation=filter_punctuation)return {'text': text,'segments': segments,'error': None}except Exception as e:logger.warning(f"Error processing text '{text[:50]}...': {str(e)}")return {'text': text,'segments': [],'error': str(e)}@record_response_time()@increment_request_count()def post(self):"""处理POST请求"""# 延迟导入loggerfrom app import loggerstart_time = time.time()try:# 解析请求参数args = self.parser.parse_args()texts = args['texts']mode = args['mode']use_hmm = args['use_hmm']filter_stopwords = args['filter_stopwords']filter_punctuation = args['filter_punctuation']# 验证texts参数if not isinstance(texts, list) or len(texts) == 0:return {'code': 1001,'message': 'texts must be a non-empty list','data': None}, 400logger.info(f"Batch segment request received: count={len(texts)}, mode={mode}")# 批量处理文本futures = []for text in texts:if not isinstance(text, str):# 跳过非字符串类型的元素continuefuture = self.executor.submit(self.process_single_text,text, mode, use_hmm, filter_stopwords, filter_punctuation)futures.append(future)# 获取结果results = [future.result() for future in futures]# 构造响应response = {'code': 0,'message': 'success','data': {'total': len(results),'results': results,'mode': mode,'use_hmm': use_hmm,'timestamp': int(time.time())}}# 手动序列化JSON,强制不转义中文json_str = json.dumps(response, ensure_ascii=False)response = make_response(json_str)response.headers['Content-Type'] = 'application/json'logger.debug(f"Batch segment request processed in {time.time() - start_time:.4f}s")return responseexcept Exception as e:logger.error(f"Error processing batch segment request: {str(e)}", exc_info=True)return {'code': 2001,'message': f"Internal server error: {str(e)}",'data': None}, 5005.服务状态接口(app/api/status.py)

python代码如下:

from flask_restful import Resource

from ..config import get_config

from ..core.segmenter import start_time, segmenter_initialized

from ..utils.metrics import get_request_metrics

import time

import psutilimport json

from flask import make_response # json返回中文class StatusResource(Resource):"""服务状态接口资源"""def __init__(self):"""初始化配置"""self.config = get_config()def get(self):"""处理GET请求"""# 延迟导入loggerfrom app import loggertry:# 获取系统资源使用情况cpu_usage = psutil.cpu_percent(interval=0.1)memory = psutil.virtual_memory()memory_usage = memory.percent# 获取请求指标request_count, avg_response_time = get_request_metrics()# 构造响应response = {'code': 0,'message': 'success','data': {'version': self.config.VERSION,'status': 'running' if segmenter_initialized else 'initializing','start_time': int(start_time.timestamp()),'current_time': int(time.time()),'request_count': request_count,'average_response_time': round(avg_response_time, 2) if avg_response_time else 0,'cpu_usage': cpu_usage,'memory_usage': memory_usage,'debug_mode': self.config.DEBUG}}# 手动序列化JSON,强制不转义中文json_str = json.dumps(response, ensure_ascii=False)response = make_response(json_str)response.headers['Content-Type'] = 'application/json'return responseexcept Exception as e:logger.error(f"Error processing status request: {str(e)}", exc_info=True)return {'code': 2001,'message': f"Internal server error: {str(e)}",'data': None}, 500(四)工具类实现

1.日志工具(app/utils/logger.py)

python代码如下:

import logging

import os

from logging.handlers import RotatingFileHandlerdef setup_logger(config):"""设置日志配置"""# 创建日志器logger = logging.getLogger(config.APP_NAME)logger.setLevel(config.LOG_LEVEL)# 避免重复添加处理器if logger.handlers:return logger# 日志格式formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')# 控制台处理器console_handler = logging.StreamHandler()console_handler.setFormatter(formatter)logger.addHandler(console_handler)# 文件处理器(轮转日志)log_file = os.path.join(config.LOG_DIR, f"{config.APP_NAME}.log")file_handler = RotatingFileHandler(log_file,maxBytes=1024 * 1024 * 10, # 10MBbackupCount=10,encoding='utf-8')file_handler.setFormatter(formatter)logger.addHandler(file_handler)return logger # 关键:必须返回logger实例2.认证工具(app/utils/auth.py)

python代码如下:

from flask import request, jsonify

import sysclass AuthMiddleware:"""认证中间件"""def __init__(self, app, api_key):self.app = appself.api_key = api_keydef __call__(self, environ, start_response):"""处理请求认证"""# 从环境变量中获取请求路径path = environ.get('PATH_INFO', '')# 不需要认证的路径public_paths = ['/api/status']if path in public_paths:return self.app(environ, start_response)# 获取Authorization头auth_header = environ.get('HTTP_AUTHORIZATION', '')if not auth_header:logger = self.get_logger()logger.warning(f"Unauthorized request to {path}: No Authorization header")response = self.create_error_response(1002, 'Unauthorized: API key is required')return response(environ, start_response)# 解析Authorization头try:auth_type, auth_value = auth_header.split(' ', 1)if auth_type.lower() != 'api-key':raise ValueError("Invalid auth type")# 验证API密钥if auth_value != self.api_key:raise ValueError("Invalid API key")# 认证通过,继续处理请求return self.app(environ, start_response)except (ValueError, Exception) as e:logger = self.get_logger()logger.warning(f"Unauthorized request to {path}: {str(e)}")response = self.create_error_response(1002, f'Unauthorized: {str(e)}')return response(environ, start_response)def get_logger(self):"""获取日志器"""from flask import current_appreturn current_app.loggerdef create_error_response(self, code, message):"""创建错误响应"""response = jsonify({'code': code,'message': message,'data': None})response.status_code = 401return response3.频率限制工具(app/utils/rate_limit.py)

python代码如下:

from flask_limiter import Limiter

from flask_limiter.util import get_remote_addressdef setup_rate_limit(app, rate_limit):"""设置频率限制"""if rate_limit:limiter = Limiter(app=app,key_func=get_remote_address,default_limits=[rate_limit],storage_uri="memory://")app.logger.info(f"Rate limit set to: {rate_limit}")return limiterreturn None4.指标收集工具(app/utils/metrics.py)

python代码如下:

import time

from threading import Lock# 全局指标

request_count = 0

response_times = []

metrics_lock = Lock()def increment_request_count():"""增加请求计数的装饰器"""def decorator(func):def wrapper(*args, **kwargs):global request_countwith metrics_lock:request_count += 1return func(*args, **kwargs)return wrapperreturn decoratordef record_response_time():"""记录响应时间的装饰器"""def decorator(func):def wrapper(*args, **kwargs):start_time = time.time()result = func(*args, **kwargs)end_time = time.time()response_time = (end_time - start_time) * 1000 # 转换为毫秒with metrics_lock:response_times.append(response_time)# 只保留最近1000个响应时间,防止内存溢出if len(response_times) > 1000:response_times.pop(0)return resultreturn wrapperreturn decoratordef get_request_metrics():"""获取请求指标"""with metrics_lock:count = request_countif response_times:avg_time = sum(response_times) / len(response_times)else:avg_time = 0return count, avg_time(五)应用启动入口(run.py)

python代码如下:

from app import create_app

from app.config import get_config

from waitress import servedef main():"""应用主函数"""app = create_app()config = get_config()if config.DEBUG:# 开发环境:使用Flask内置服务器app.run(host=config.HOST,port=config.PORT,debug=config.DEBUG)else:# 生产环境:使用Waitress作为WSGI服务器app.logger.info(f"Starting production server with Waitress: {config.HOST}:{config.PORT}, workers={config.WORKERS}")serve(app, host=config.HOST, port=config.PORT, threads=config.WORKERS)if __name__ == '__main__':main()(六)启动批处理文件(start_server.bat)

batch代码如下:

@echo off

cd /d D:\chinese-segmentation-api

call csa-venv\Scripts\activate.bat

set ENVIRONMENT=production

set API_KEY=your_secure_api_key_here

python run.py

pause

五、服务器部署方案

(一)服务器环境准备

1.服务器硬件要求

部署中文分词API服务的服务器硬件要求如下:

(1)CPU:至少2核,推荐4核及以上,以支持多进程并发处理。

(2)内存:至少2GB,推荐4GB及以上,以应对较大的文本处理需求。

(3)硬盘:至少10GB可用空间,用于安装系统、应用程序和存储日志文件。

(4)网络:稳定的网络连接,带宽根据预期的并发请求量而定。

2.操作系统配置

Windows Server 2022 安装完成后,进行以下基本配置:

(1)启用远程桌面:在“系统属性”->“远程设置”中,允许远程连接到该计算机。

(2)关闭不必要的服务:在“服务”管理界面中,禁用不需要的系统服务,提高系统性能和安全性。

(3)安装必要的系统更新:通过“设置”->“更新和安全”安装最新的系统补丁。

3.必要软件安装

(1)安装Python3.10.6:如前文“环境准备”部分所述。

(2)安装Git:从Git官网下载Windows版本并安装,用于版本控制。

(3)安装Nginx:如前文“环境准备”部分所述。

(4)安装NSSM:如前文“环境准备”部分所述。

(5)安装依赖包:在项目虚拟环境中安装所需的依赖包,如前文所述。

(二)部署方式选择

本项目在Windows Server 2022上支持两种部署方式:直接部署和Docker容器化部署。

1.直接部署

直接部署是将应用程序直接安装在服务器操作系统上,通过Waitress作为WSGI服务器运行,Nginx作为反向代理。

优点:部署简单,不需要额外的容器化知识。性能开销小,适合资源有限的服务器。

缺点:环境依赖管理复杂,可能与服务器上的其他应用产生冲突。部署和升级过程相对繁琐。

2.Docker容器化部署

Docker容器化部署是将应用程序及其依赖打包到Docker容器中,通过容器运行应用。

优点:环境隔离,避免与其他应用产生冲突。部署和升级简单,只需更新容器镜像。便于在不同环境之间迁移。

缺点:需要一定的Docker知识。相比直接部署有一定的性能开销。

(三)直接部署步骤

1.项目部署

(1)将项目代码上传至服务器

通过远程桌面连接或FTP工具,将本地开发完成的项目文件夹(chinese-segmentation-api)上传至Windows Server 2022服务器的指定目录(如D:\services\chinese-segmentation-api)。

(2)配置虚拟环境

在服务器上打开PowerShell,进入项目目录,执行以下命令激活虚拟环境并安装依赖:

cd D:\services\chinese-segmentation-api

.\csa-venv\Scripts\Activate.ps1

pip install -r requirements.txt

(3)配置环境变量

项目配置文件“app/config.py”优先读取环境变量,创建或修改项目根目录下的.env文件,配置生产环境参数(ini):

ENVIRONMENT=production

APP_NAME=Chinese Segmentation API

VERSION=1.0.0

HOST=0.0.0.0

PORT=5000 # 自定义端口(1024-65535之间未被占用的端口)

WORKERS=4

API_KEY=your_secure_api_key_here # 替换为实际的API密钥

REQUIRE_AUTH=True

RATE_LIMIT=100/minute

LOG_LEVEL=INFO

保存文件后重启服务:关闭当前运行的服务(在启动服务的窗口按Ctrl+C);重新激活虚拟环境并启动服务:

csa-venv\Scripts\activate

python run.py

(4)测试服务启动

在虚拟环境中执行启动命令,验证服务是否正常运行:

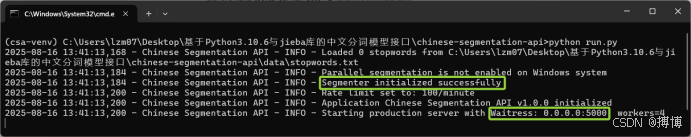

python run.py

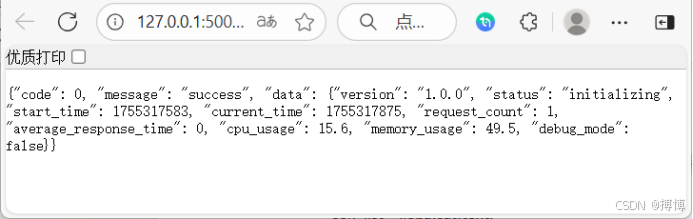

启动后的效果如下:

之后,就可以打开浏览器访问http://localhost:5000/api/status,若返回服务状态JSON数据,则表示服务启动成功,按Ctrl+C停止服务。

2.配置Nginx反向代理

(1)修改Nginx配置文件

打开Nginx安装目录下的conf\nginx.conf文件(如D:\nginx-1.24.0\conf\nginx.conf),在http块中添加以下配置:

server {listen 80;server_name your_domain.com; # 替换为实际域名或服务器IPlocation / {proxy_pass http://127.0.0.1:5000;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;proxy_set_header X-Forwarded-Proto $scheme;}

}(2)启动Nginx服务

在PowerShell中进入Nginx目录,执行以下命令启动Nginx:

cd D:\nginx-1.24.0

.\nginx.exe

通过http://服务器IP/api/status访问服务,验证反向代理是否生效。

3.使用NSSM注册系统服务

(1)打开NSSM服务安装界面

在PowerShell中执行以下命令启动NSSM配置界面:

nssm install ChineseSegmentationAPI

(2)配置服务参数

Path:选择Python可执行文件路径(如D:\services\chinese-segmentation-api\csa-venv\Scripts\python.exe)

Arguments:输入run.py

Working Directory:选择项目根目录(如D:\services\chinese-segmentation-api)

Service name:保持默认ChineseSegmentationAPI或自定义

(3)配置服务启动方式

切换到NSSM界面的“Log on”选项卡,选择“Local System account”;在“Startup type” 中选择“Automatic”,点击“Install service”完成注册。

(4)启动服务

在PowerShell中执行以下命令启动服务:

nssm start ChineseSegmentationAPI

通过http://服务器IP/api/status验证服务是否正常运行,若失败可通过NSSM日志(D:\services\chinese-segmentation-api\logs)排查问题。

(四)Docker容器化部署步骤

1.安装Docker Desktop

(1)下载并安装Docker Desktop for Windows(需启用Hyper-V),重启服务器后启动Docker。

(2)在Docker设置中启用“Container Registry”和“Windows containers”(若使用Windows 容器)或“Linux containers”(推荐)。

2.创建Dockerfile

在项目根目录下创建Dockerfile,内容如下:

# 基于Python3.10.6镜像

FROM python:3.10.6-slim

# 设置工作目录

WORKDIR /app

# 复制依赖文件

COPY requirements.txt .

# 安装依赖

RUN pip install --no-cache-dir -r requirements.txt

# 复制项目文件

COPY . .

# 创建数据和日志目录

RUN mkdir -p /app/data/custom_dicts /app/logs

# 暴露端口

EXPOSE 5000

# 启动命令

CMD ["python", "run.py"]3.创建docker-compose.yml(可选)

yaml代码如下:

version: '3'

services:chinese-segmentation-api:build: .ports:- "5000:5000"environment:- ENVIRONMENT=production- API_KEY=your_secure_api_key_here- REQUIRE_AUTH=Truevolumes:- ./data:/app/data- ./logs:/app/logsrestart: always4.构建并运行容器

(1)在项目目录下打开PowerShell,执行以下命令构建镜像:

docker build -t chinese-segmentation-api:1.0.0 .

(2)运行容器:

docker run -d -p 5000:5000 --name csa-service -e "API_KEY=your_secure_api_key_here" chinese-segmentation-api:1.0.0

或使用docker-compose:

docker-compose up -d

配置Nginx反向代理(同直接部署步骤2)

通过http://服务器IP/api/status验证容器化服务是否正常运行。

(五)服务监控与维护

1.日志管理

(1)项目日志默认存储在logs目录下,通过以下命令查看实时日志:

Get-Content -Path D:\services\chinese-segmentation-api\logs\Chinese Segmentation API.log -Tail 100 -Wait

(2)配置日志轮转:Nginx和应用日志均已配置轮转机制(应用日志最大10MB /文件,保留10个备份)。

2.服务状态监控

(1)通过/api/status接口实时查看服务状态,包括CPU使用率、内存占用、请求计数等指标。

(2)使用Windows“性能监视器”添加计数器(如“Process”->“% Processor Time”)监控服务资源占用。

3.自动重启与故障恢复

(1)直接部署:NSSM配置中已默认启用“自动重启”,服务崩溃后将自动恢复。

(2)Docker部署:通过restart: always配置确保容器退出后自动重启。

4.版本更新

(1)直接部署:替换项目文件后,执行nssm restart ChineseSegmentationAPI重启服务。

(2)Docker 部署:重新构建镜像并替换容器:

docker-compose down

docker-compose up -d --build

六、接口使用示例与文档

(一)接口调用工具

推荐使用Postman或curl进行接口测试,以下为curl示例。

(二)基础分词接口(/api/segment)

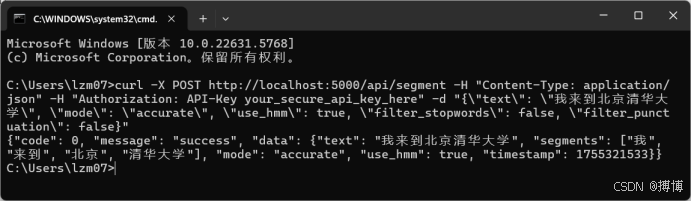

以下Curl命令转换成单行再在CMD中执行:

curl -X POST http://localhost:5000/api/segment \-H "Content-Type: application/json" \-H "Authorization: API-Key your_secure_api_key_here" \-d "{"text": "我来到北京清华大学","mode": "accurate","use_hmm": true,"filter_stopwords": false,"filter_punctuation": false}"转义+单行效果:

curl -X POST http://localhost:5000/api/segment -H "Content-Type: application/json" -H "Authorization: API-Key your_secure_api_key_here" -d "{\"text\": \"我来到北京清华大学\", \"mode\": \"accurate\", \"use_hmm\": true, \"filter_stopwords\": false, \"filter_punctuation\": false}"

如果是部署在服务器,则将本地地址localhost:5000改成你服务器地址your_domain.com。

返回示例(json):

{"code": 0,"message": "success","data": {"text": "我来到北京清华大学","segments": ["我", "来到", "北京", "清华大学"],"mode": "accurate","use_hmm": true,"timestamp": 1718000000}

}效果如下:

(三)词性标注接口(/api/pos_tag)

以下Curl命令转换成单行再在CMD中执行:

curl -X POST http://localhost:5000/api/pos_tag \-H "Content-Type: application/json" \-H "Authorization: API-Key your_secure_api_key_here" \-d "{"text": "我爱自然语言处理","mode": "accurate"}"返回示例(json):

{"code": 0,"message": "success","data": {"text": "我爱自然语言处理","tags": [{"word": "我", "tag": "r"},{"word": "爱", "tag": "v"},{"word": "自然", "tag": "a"},{"word": "语言", "tag": "n"},{"word": "处理", "tag": "v"}],"mode": "accurate","use_hmm": true,"timestamp": 1718000100}

}(四)自定义词典接口(/api/custom_dict)

以下Curl命令转换成单行再在CMD中执行:

curl -X POST http://localhost:5000/api/custom_dict \-H "Content-Type: application/json" \-H "Authorization: API-Key your_secure_api_key_here" \-d "{"action": "add","words": ["李小福", {"word": "创新办", "freq": 5}]}"返回示例(json):

{"code": 0,"message": "success","data": {"action": "add","success_count": 2,"failed_words": [],"timestamp": 1718000200}

}(五)批量分词接口(/api/batch_segment)

以下Curl命令转换成单行再在CMD中执行:

curl -X POST http://localhost:5000/api/batch_segment \-H "Content-Type: application/json" \-H "Authorization: API-Key your_secure_api_key_here" \-d "{"texts": ["我来到北京清华大学", "我爱自然语言处理"],"mode": "accurate"}"返回示例(json):

{"code": 0,"message": "success","data": {"total": 2,"results": [{"text": "我来到北京清华大学","segments": ["我", "来到", "北京", "清华大学"]},{"text": "我爱自然语言处理","segments": ["我", "爱", "自然", "语言", "处理"]}],"mode": "accurate","use_hmm": true,"timestamp": 1718000300}

}(六)服务状态接口(/api/status)

以下Curl命令在CMD中执行:

curl -X GET http://localhost:5000/api/status

返回示例(json):

{"code": 0,"message": "success","data": {"version": "1.0.0","status": "running","start_time": 1718000000,"current_time": 1718000400,"request_count": 50,"average_response_time": 45.2,"cpu_usage": 15.3,"memory_usage": 25.8,"debug_mode": false}

}七、常见问题与解决方案

(一)部署相关问题

1.服务启动后无法访问

检查服务器防火墙是否开放80/5000端口(powershell):

New-NetFirewallRule -DisplayName "Allow Chinese Segmentation API" -Direction Inbound -LocalPort 80,5000 -Protocol TCP -Action Allow

验证Nginx和应用服务是否正常运行(powershell):

nssm status ChineseSegmentationAPI

.\nginx.exe -t # 检查Nginx配置

2.虚拟环境激活失败

若PowerShell提示“无法加载脚本”,执行以下命令修改执行策略:

Set-ExecutionPolicy RemoteSigned -Scope CurrentUser

3.Docker容器启动失败

查看容器日志排查问题:

docker logs csa-service

(二)功能相关问题

1.分词结果不符合预期

尝试添加自定义词典:通过/api/custom_dict接口添加专业词汇。

调整分词模式:使用“full”模式获取更多可能的分词结果。

2.接口响应缓慢

检查服务器资源:通过/api/status接口查看CPU和内存占用,若资源不足需升级服务器配置。

优化请求:减少单次请求的文本长度,或使用批量接口降低请求频率。

3.权限验证失败

检查API密钥是否正确:确保请求头中的Authorization: API-Key值与.env文件中的API_KEY一致。

关闭权限验证(仅测试环境):在.env中设置REQUIRE_AUTH=False,重启服务后生效。

八、总结与扩展

本教程详细介绍了基于Python3.10.6和jieba库的中文分词模型接口在Windows Server 2022上的实现与部署过程,涵盖环境准备、jieba库原理、接口设计、代码实现、服务器部署及接口使用等内容。通过直接部署或Docker容器化部署,可快速搭建稳定、高效的中文分词服务,满足企业或开发者的中文信息处理需求。

未来可扩展的功能包括:

(1)集成关键词提取、实体识别等高级NLP功能;

(2)接入分布式缓存(如Redis)提高响应速度;

(3)开发Web管理界面,可视化配置自定义词典和监控服务状态;

(4)支持多语言分词(如英文、日文),扩展服务适用场景。

通过本教程的指导,读者可掌握中文分词服务的全流程开发与部署方法,并根据实际需求进行二次开发和优化。