深度学习-卷积神经网络-ResNet 残差网络

在深度学习的发展历程中,卷积神经网络(CNN)不断推陈出新,ResNet(Residual Network)作为其中的杰出代表,以其独特的残差学习机制在图像识别领域取得了显著的成果,并推动了 CNN 的进一步发展。

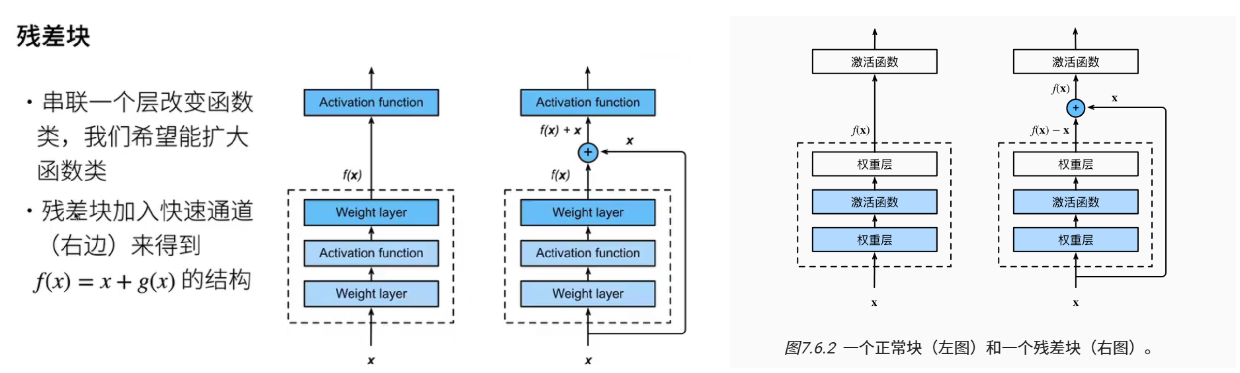

1. 残差学习模块

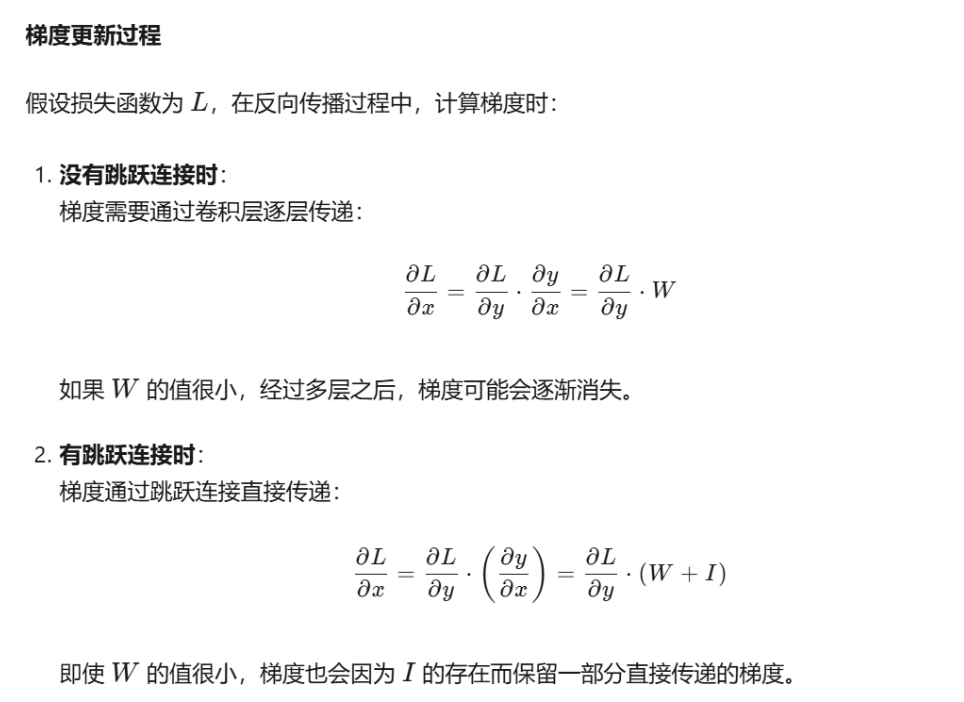

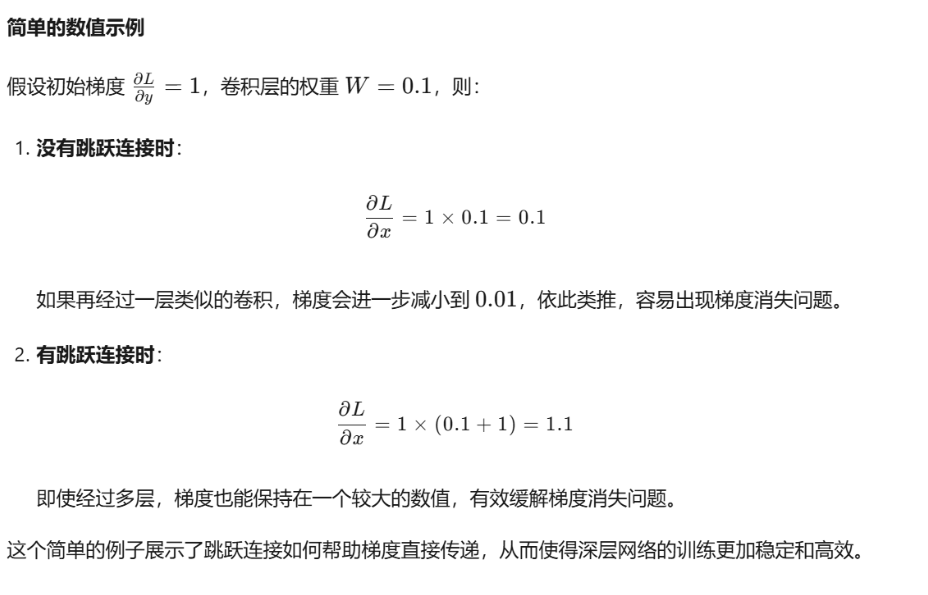

ResNet 的核心创新在于其提出的残差学习模块(Residual Learning Module)。传统卷积神经网络在堆叠多层时,容易出现梯度消失或爆炸问题,导致模型难以训练。ResNet 通过引入残差学习模块解决了这一问题。

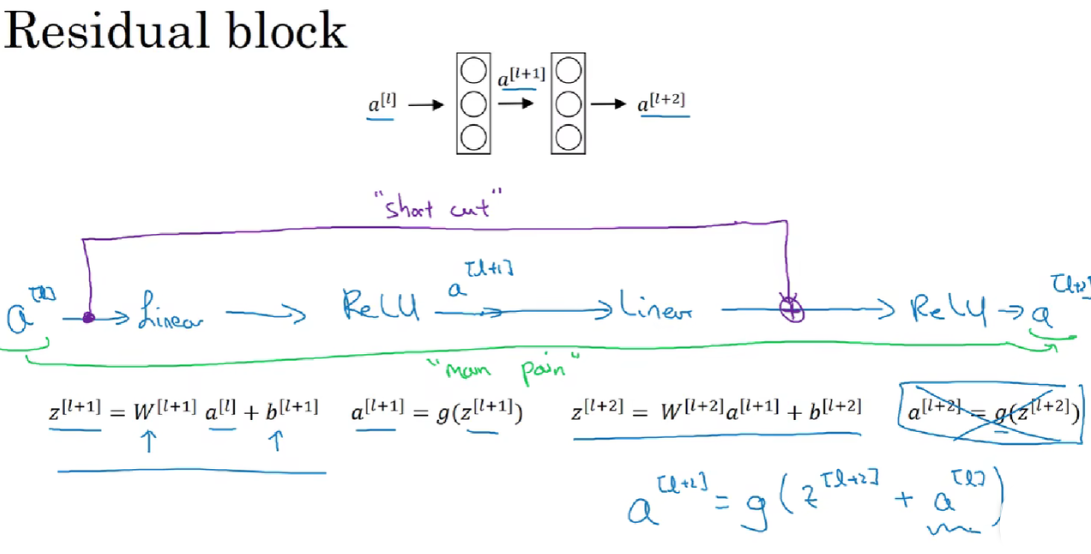

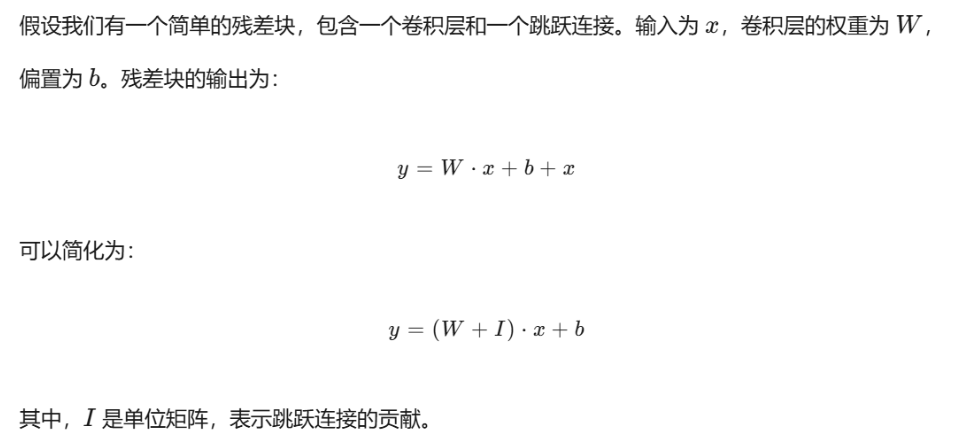

每个残差学习模块包含两个主要部分:一部分是卷积操作的主路径,另一部分是恒等映射的旁路(Skip Connection)。主路径通常包含两个或三个卷积层,用于提取特征。旁路则直接将输入特征图传递到主路径的输出,与主路径的输出进行逐元素相加操作。这种设计使得网络可以学习残差映射,而不是直接学习原始映射,从而更容易优化。

具体而言,残差学习模块的公式可以表示为:

Output=ReLU(X+F(X))

其中,X 是输入特征图,F(X) 表示主路径的卷积操作,ReLU 是激活函数。通过这种方式,残差学习模块能够有效地缓解梯度消失问题,使网络能够更深入地堆叠多层。

残差块一般是放在con1+激活函数+cov2之后,与残差连接相加,然后一起进入第二个激活函数中。

其中,当维度不匹配时,使用1×1的卷积核进行通道调整。

-

第一组操作:

-

Conv1:第一个卷积层(通常3×3卷积) -

BN:批归一化层(Batch Normalization) -

ReLU:激活函数

-

-

第二组操作:

-

Conv2:第二个卷积层(通常3×3卷积) -

BN:批归一化层

-

-

残差连接:

-

将原始输入

x与第二组操作的输出相加(+操作) -

数学表达式:

F(x) + x

-

-

最终激活:在相加后应用激活函数

ReLU即可输出到下一层。

2. 性能优势

ResNet 在 ImageNet 等大型图像分类数据集上取得了优异的性能,显著降低了模型的 Top-5 错误率。通过残差学习模块的设计,ResNet 能够有效地缓解梯度消失问题,使模型能够更深入地堆叠多层,从而提高特征提取能力。

-

学习嵌套函数是训练神经网络的理想情况。在深层神经网络中,学习另一层作为恒等映射(identity function)较容易。

-

残差映射可以更容易地学习同一函数,例如将权重层中的参数近似为零。

-

利用残差块可以训练出有效的深层神经网络:输入可以通过层间的残余连接更快地向前传播。

-

残差网络(ResNet)对随后的深层神经网络设计产生了深远影响。

ResNet 的主要优点包括:

-

解决梯度消失问题:通过旁路连接,梯度可以直接回传到前面的层,避免了梯度消失问题。

-

更深的网络结构:ResNet 能够轻松构建非常深的网络结构(如 100 层、1000 层等),而不会导致训练困难。

-

更好的特征提取能力:残差学习模块的设计使得模型能够更有效地提取图像的特征信息。

3. 代码实现

代码改编自《动手学深度学习》

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lclass Residual(nn.Module): #@savedef __init__(self, input_channels, num_channels,use_1x1conv=False, strides=1):super().__init__()self.conv1 = nn.Conv2d(input_channels, num_channels,kernel_size=3, padding=1, stride=strides)self.conv2 = nn.Conv2d(num_channels, num_channels,kernel_size=3, padding=1)if use_1x1conv:self.conv3 = nn.Conv2d(input_channels, num_channels,kernel_size=1, stride=strides)else:self.conv3 = Noneself.bn1 = nn.BatchNorm2d(num_channels)self.bn2 = nn.BatchNorm2d(num_channels)def forward(self, X):Y = F.relu(self.bn1(self.conv1(X)))Y = self.bn2(self.conv2(Y))if self.conv3:X = self.conv3(X)Y += Xreturn F.relu(Y)

下面我们来查看输入和输出形状一致的情况。

blk = Residual(3,3)

X = torch.rand(4, 3, 6, 6)

Y = blk(X)

Y.shape输出:torch.Size([4, 3, 6, 6])我们也可以在增加输出通道数的同时,减半输出的高和宽。

blk = Residual(3,6, use_1x1conv=True, strides=2)

blk(X).shape输出:torch.Size([4, 6, 3, 3])下面实现RestNet模型:

b1 = nn.Sequential(nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),nn.BatchNorm2d(64), nn.ReLU(),nn.MaxPool2d(kernel_size=3, stride=2, padding=1))def resnet_block(input_channels, num_channels, num_residuals,first_block=False):blk = []for i in range(num_residuals):if i == 0 and not first_block:blk.append(Residual(input_channels, num_channels,use_1x1conv=True, strides=2))else:blk.append(Residual(num_channels, num_channels))return blkb2 = nn.Sequential(*resnet_block(64, 64, 2, first_block=True))

b3 = nn.Sequential(*resnet_block(64, 128, 2))

b4 = nn.Sequential(*resnet_block(128, 256, 2))

b5 = nn.Sequential(*resnet_block(256, 512, 2))net = nn.Sequential(b1, b2, b3, b4, b5,nn.AdaptiveAvgPool2d((1,1)),nn.Flatten(), nn.Linear(512, 10))X = torch.rand(size=(1, 1, 224, 224))

for layer in net:X = layer(X)print(layer.__class__.__name__,'output shape:\t', X.shape)输出:

Sequential output shape: torch.Size([1, 64, 56, 56])

Sequential output shape: torch.Size([1, 64, 56, 56])

Sequential output shape: torch.Size([1, 128, 28, 28])

Sequential output shape: torch.Size([1, 256, 14, 14])

Sequential output shape: torch.Size([1, 512, 7, 7])

AdaptiveAvgPool2d output shape: torch.Size([1, 512, 1, 1])

Flatten output shape: torch.Size([1, 512])

Linear output shape: torch.Size([1, 10])训练模型:

lr, num_epochs, batch_size = 0.05, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=96)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())输出:

loss 0.012, train acc 0.997, test acc 0.893

5032.7 examples/sec on cuda:0