中山清华:基于大模型的具身智能系统综述

- 作者:王文晟1^{1}1,谭 宁1^{1}1,黄 凯1^{1}1,张雨浓1^{1}1,郑伟诗1^{1}1,孙富春2^{2}2

- 单位:1^{1}1中山大学计算机学院,2^{2}2清华大学计算机科学与技术系

- 论文标题:基于大模型的具身智能系统综述

- 出版信息:自动化学报 第51卷第1期

- 论文链接:http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c240542

主要贡献

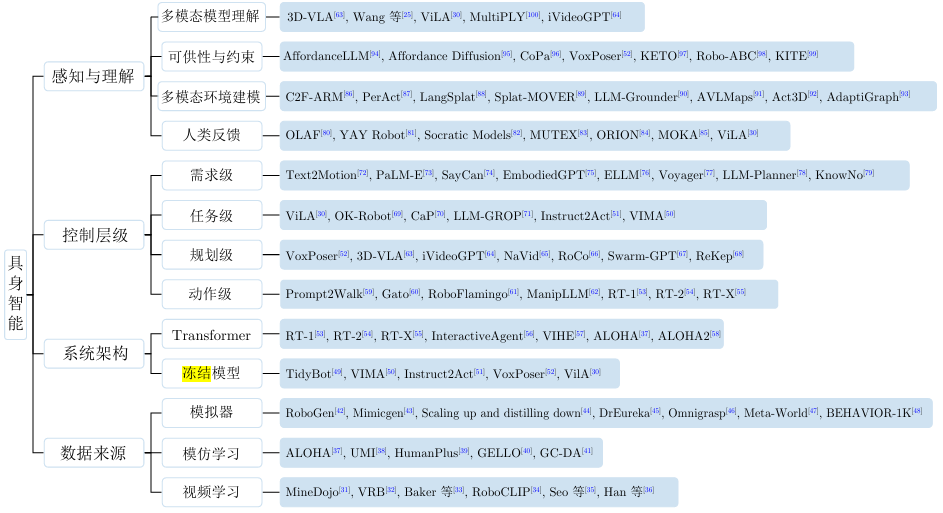

- 本文对基于大模型的具身智能系统进行了全面的综述,涵盖了大模型在具身智能中的作用、控制层级、系统架构、数据来源以及面临的挑战。

- 总结了大模型在具身智能的感知与理解方面的应用,包括多模态模型理解、多模态环境建模、可供性与约束以及人类反馈等方面的工作。

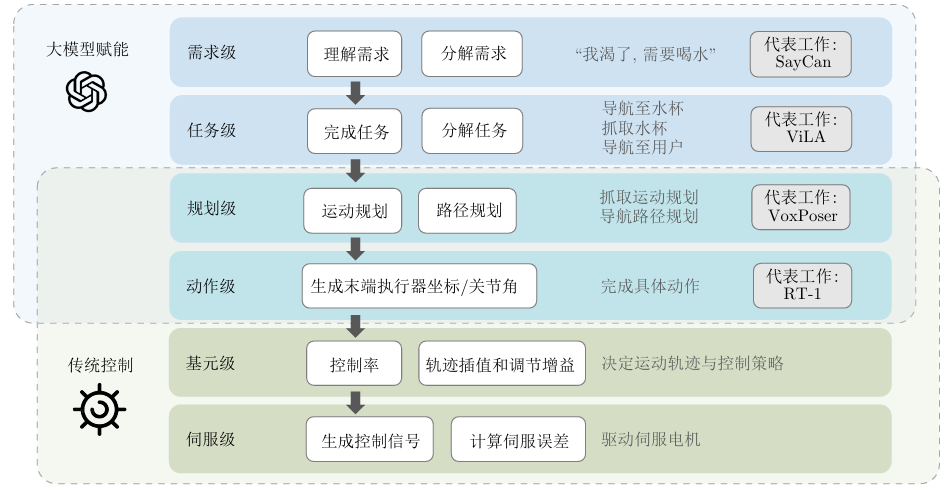

- 将大模型在具身智能中的控制层级分为需求级、任务级、规划级和动作级,并分别介绍了各层级的代表性工作。

- 对基于大模型的具身智能系统架构进行了分类,包括端到端的Transformer架构和冻结参数的大模型结合基础模型的架构。

- 探讨了具身智能模型的数据来源,包括模拟器、模仿学习和视频学习,并分析了大模型如何为机器人训练带来丰富的数据。

- 总结了基于大语言模型的具身智能系统面临的挑战,如真实数据稀缺、推理速度慢以及多智能体协同等问题,并提出了未来可能的发展方向。

引言

- 背景:具身智能的概念最早可以追溯到图灵在1950年的设想,强调机器人通过与环境的交互来学习和解决问题。近年来,随着大模型的发展,具身智能逐渐从概念走向实际应用。

- 研究动机:尽管具身智能领域已经有一些综述性研究,但大多数没有聚焦于大模型。本文旨在从具身智能的角度,系统地介绍大模型与具身智能的结合,并探讨其在不同层级上的应用。

- 研究目的:通过总结和分析当前基于大模型的具身智能系统的研究进展,为研究人员提供参考,并指出未来的研究方向。

感知与理解

多模态模型理解

- 背景:具身智能系统通过摄像头、麦克风等传感器接收原始数据,并解析数据信息以形成对环境的认知。大模型在处理多模态输入数据时具有强大优势,能够有效整合文本、图像、音频等多模态信息,捕获各模态之间的关系,提取统一的高维特征,从而形成对世界的理解。

- 典型方法:

- 多模态大模型(LMM):如GPT-4V等多模态大模型,能够直接用于具身智能对环境的理解。这些模型通过在大量无标签的互联网文本和图像上进行预训练,将图像与文本编码到同一向量空间中,有利于对环境的感知和对用户自然语言指令的理解。

- ViLA:引入GPT-4V,将视觉信息直接融入推理和规划过程中,生成可执行步骤,并能够自然地整合视觉反馈,实现闭环规划。

- MultiPLY:构造了基于LLaVA的多模态、以对象为中心的具身大语言模型,通过定义动作标记和状态标记与环境互动,使模型能够在抽象表示和详细多模态信息之间切换。

- 小结:多模态模型能够有效提升具身智能系统对复杂环境的理解能力,使其更好地完成任务。

多模态环境建模

- 背景:一些工作利用多模态大模型对环境进行建模,以实现具身智能对空间信息的多模态理解。这些模型通过提取多模态模型的知识对场景本身进行建模,从而增强具身智能系统对环境的感知。

- 典型方法:

- CLIP:作为多模态大模型的代表,CLIP能够编码摄像头输入的图片与用户任务的自然语言,实现对环境的语义建模。

- HomeRobot:提出了开放词汇移动操作(OVMM)基准测试,利用CLIP等大规模预训练模型以弱监督的方式学习场景的3D语义表示。

- PerAct:使用基于Transformer的体素编码器得到体素特征,并结合自然语言特征,通过对场景进行三维体素化,实现对环境的有效建模。

- LangSplat:提出基于3D高斯构建3D语言场的方法,使用SAM与CLIP提取语言特征,并优化3D高斯进行表示。

- 小结:多模态环境建模能够使具身智能系统更准确地理解空间信息,从而更好地适应复杂环境。

可供性与约束

- 背景:可供性指的是环境中物体相对于机器人所能提供的潜在交互方式,而约束则是规划和执行机器人操作时需要遵守的限制条件。使用基础模型对可供性与约束进行提取,可以使具身智能有效利用环境中的各种工具,并在使用工具解决问题的过程中考虑各类约束。

- 典型方法:

- AffordanceLLM:将大模型的世界知识与3D几何信息相结合,通过视觉语言模型(VLM)骨干扩展掩码解码器和特殊特征,用于预测可操作性图。

- Affordance Diffusion:提出一种基于扩散模型的图像生成方法,从单个物体的RGB图像出发合成人类手与该物体交互的合理图像,并从中直接提取出可行的3D手部姿态。

- KITE:使用关键点来提取可供性,通过大语言模型从指令中提取任务类型,并结合关键点生成动作序列。

- CoPa:通过部件空间约束实现通用机器人操作,利用大规模预训练模型中的常识知识指导机器人在开放世界场景中的低层次控制。

- 小结:通过大模型对可供性与约束的提取,具身智能系统能够更高效地利用环境中的工具,并在操作过程中遵循物理规律和任务要求。

人类反馈

- 背景:人类的反馈在具身智能系统中尤为重要,因为人类是目标的提出者和整个交互行为的观察者。及时根据人类反馈进行调整可以有效提高具身智能的灵活性和任务完成度。

- 典型方法:

- OLAF:通过大语言模型改进机器人的行为,包含用户交互、数据合成和策略更新三个步骤,利用用户的口头纠正来更新策略。

- YAY Robot:通过语言修正实时修正机器人行为,用户可以通过口头指令让机器人暂停行动并提供纠正指导。

- MOKA:利用视觉提示将动作生成问题转化为视觉语言模型能解决的视觉问答问题,解决了自然语言表达能力不精确的问题。

- 小结:人类反馈能够显著提升具身智能系统的性能,使其更好地适应人类的需求和环境的变化。

控制层级

需求级

- 背景:需求级负责理解用户需求,利用大模型的强大理解能力准确分析用户需求中隐含的任务要求,并分解为机器人可以完成的具体任务。

- 典型方法:

- Text2Motion:构造了一个将自然语言指令转换为符合需求且满足物理执行条件的框架,使用大语言模型进行高层次任务规划,从技能库中选择合适的技能,并优化技能序列参数。

- PaLM-E:一个多模态语言模型,能够结合视觉、语言和机器人传感器数据,自回归地生成文本,用于执行各种任务,如视觉问答、图像描述、机器人任务规划等。

- SayCan:结合大模型的高级语义知识和低级技能,通过“Say”模块生成任务相关的自然语言描述和“Can”模块评估技能的可行性,选择最有可能成功的技能。

- EmbodiedGPT:通过思维链(Chain of Thought, CoT)技术生成更详细和可执行的计划,提高机器人执行任务的成功率。

- 小结:大模型在需求级的应用能够准确理解用户需求,并将其分解为具体任务,为后续的执行提供清晰的指导。

任务级

- 背景:任务级负责完成具体的任务,如抓取、导航、定位等。这些任务通常由预定义的技能完成,而相应的技能可以通过强化学习、行为克隆等方式学习得到。

- 典型方法:

- OK-Robot:结合多种基础模型,用于在真实世界环境中拾取和放置物体。使用OWL-ViT进行对象检测,构建语义记忆,并通过语言查询定位物体。

- CaP (Code as Policies):利用大语言模型生成机器人策略代码,将自然语言命令转换为可执行的策略,通过少量示例引导模型生成新的策略代码。

- LLM-GROP:通过提示技术从大语言模型中提取关于语义有效对象配置的常识知识,并将其实例化到任务和运动规划器中。

- 小结:大模型在任务级的应用能够有效地将自然语言指令转换为具体的机器人操作任务,提高了任务的完成率和泛化能力。

规划级

- 背景:规划级负责根据环境观察动态地决定具身系统的未来动作,完成轨迹生成、语言导航等任务。

- 典型方法:

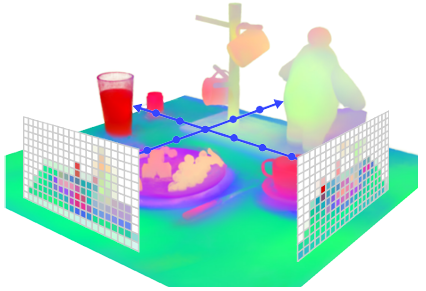

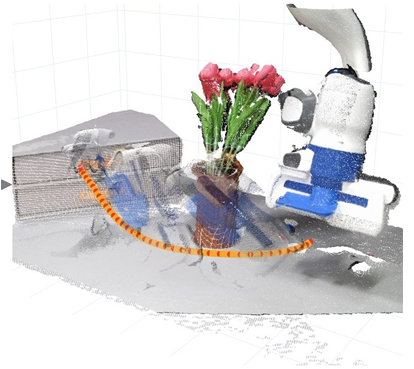

- VoxPoser:利用大语言模型和视觉语言模型提取环境可供性,生成三维价值地图并用于生成机器人轨迹。

- 3D-VLA (3D Vision Language Action):生成视觉模型,能够理解并处理3D空间信息,通过微调模型生成一系列动作特征以控制机器人完成任务。

- iVideoGPT:交互式视频生成模型,通过构建可扩展的世界模型支持基于模型的智能体进行探索、推理和规划。

- NaVid:通过预训练的视觉编码器和大语言模型编码视觉观察和推理导航动作,仅依赖单目RGB相机和人类指令规划下一步行动。

- RoCo:多机器人协作方法,利用预训练的大语言模型进行高层次通信和低层次路径规划。

- 小结:大模型在规划级的应用能够根据环境动态生成灵活的动作计划,提高了具身智能系统在复杂环境中的适应性和任务完成能力。

动作级

- 背景:动作级中,大模型处理环境观察与提示,输出动作序列,这些序列直接用于控制机器人的运动。

- 典型方法:

- Gato:通用智能体,通过在多样化任务上进行预训练,能够完成玩游戏、为图像添加字幕、操控真实机械臂等多种任务。

- RoboFlamingo:通过解耦视觉−语言理解和决策制定,使用模仿学习在语言条件操控数据集上进行微调,输出动作序列以指导机器人完成任务。

- Prompt2Walk:利用大语言模型GPT-4,通过设计良好的文本提示输出机器人的关节目标位置,实现机器人的行走。

- ManipLLM:通过微调多模态大语言模型,使其具备输出机器人执行器位姿的能力,能够识别图像中对象的类别并预测末端执行器的精确姿态。

- 小结:大模型在动作级的应用能够直接生成机器人的动作序列,提高了动作的准确性和灵活性,使机器人能够更好地适应动态环境。

系统架构

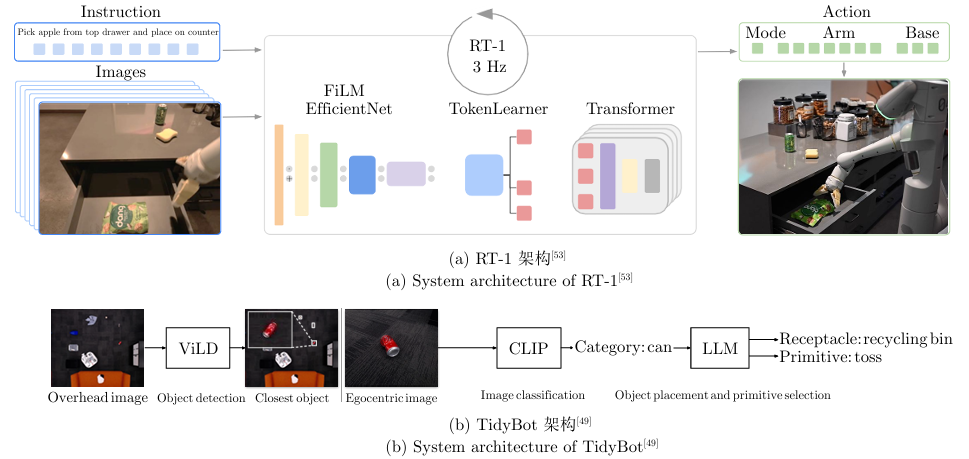

基于Transformer的架构

- 背景:Transformer架构自2017年提出以来,因其高效的并行处理能力和强大的序列数据处理能力,成为自然语言处理领域的重要里程碑。其在具身智能中的应用也逐渐增多,尤其是在端到端的任务中。

- 典型方法:

- RT-1:设计了一个端到端架构,能够吸收多样化的机器人数据,并在真实世界的机器人应用中执行任务。模型同时接受文本和图像输入,通过一系列处理步骤(如USE、EfficientNet、FiLM、TokenLearner等)生成离散动作指令。

- RT-2:在RT-1的基础上,进一步整合了基于互联网规模数据训练的视觉−语言模型,如PaLM-E,将动作表示为文本特征,训练视觉−语言−动作模型(VLA),提高了泛化能力和语义推理能力。

- InteractiveAgent:提出了一种“交互式代理基础模型”,通过多任务代理训练范式,处理文本、视觉数据和动作作为输入,预训练模型以预测三种模态的特征,使其能够在多模态环境中进行有效的交互和任务执行。

- ALOHA (Action chunking with transformers):提出基于Transformer的动作块(Action chunking)算法,通过模仿学习实现复杂动作序列的生成模型,适用于低成本硬件上的精细双手动态操作任务。

- 小结:基于Transformer的架构在具身智能中表现出色,尤其是在规划级和动作级的任务中。其端到端的设计简洁高效,能够快速处理多样化的输入数据并生成相应的动作指令。

参数冻结的大模型结合基础模型

- 背景:随着深度学习技术的发展,预训练大模型逐渐成为一种重要的技术趋势。在具身智能领域,通过结合冻结参数的大模型和基础模型,可以在不牺牲模型泛化能力的前提下,针对特定任务进行灵活的优化和调整。

- 典型方法:

- TidyBot:探讨了如何使机器人在执行家庭清理任务时根据用户偏好进行个性化辅助。通过与机器人的初步交互收集用户偏好,输入到大语言模型中生成放置规则,利用CLIP模型进行图像分类,识别物体类别,并选择合适的操作方式。

- VIMA (Visual Instruction to Action):提出了一种可接受多模态输入的框架,旨在通过多模态提示实现通用机器人操作。基于Transformer架构的模型能够自回归地输出动作序列,利用跨注意力机制条件优于多模态提示,并针对机器人操作任务定制了一系列组件。

- Instruct2Act:通过大语言模型将多模态指令转换为机器人操作任务的序列化动作。框架的核心在于利用预训练的大语言模型生成Python程序,构成一个全面的感知、规划和动作循环。

- 小结:参数冻结的大模型结合基础模型的架构在需求级和任务级表现出色。这种架构不仅利用了大模型在海量数据上学到的丰富知识,还通过基础模型的调整适应了特定任务的需求,提高了系统的灵活性和泛化能力。

数据来源

模拟器

- 背景:模拟器为具身智能提供了一个可控且安全的测试环境,支持多个实例同时运行,大大加快了数据收集的速度。通过模拟器,研究者能够在虚拟环境中快速迭代和测试不同的算法和模型配置,而无需担心实际物理世界中的延时、成本和安全问题。

- 典型方法:

- BEHAVIOR-1K:提出了一个人类中心化的具身智能基准测试,包含1000个日常活动的数据集,覆盖50个不同场景,涉及超过9000个物体。OMNIGIBSON仿真环境通过逼真的物理仿真和渲染支持这些活动,为训练和测试具身智能代理提供了理想的平台。

- RoboGen:通过使用生成模型自动大规模学习多样化的机器人技能,提取嵌入大规模模型中的广泛且多变的知识,并将其转移到机器人领域。机器人通过“提议−生成−学习”循环,生成包含适当空间配置的物体及资产的模拟环境,并选择最优学习方式生成训练监督。

- Scaling up and distilling down:提出了一个在模拟器中进行学习的框架,使用大语言模型指导高层规划,并利用基于采样的机器人规划器生成多样化和丰富的操作轨迹。通过自动标记轨迹的成功/失败,增强数据收集过程的鲁棒性。

- DrEureka:通过LLM合成奖励函数,基于扰动模拟中的初始策略执行,创建物理参数的适当采样范围,并生成有效的领域随机化配置,解决了Sim2Real问题。

- 小结:模拟器在数据收集方面具有显著优势,但模拟环境无法完美复现现实世界的复杂性和不确定性。通过大语言模型生成丰富的模拟环境和专家演示,可以增强机器人策略的任务级泛化能力。

模仿学习

- 背景:人类对机器人进行远程操控并完成任务的过程能够提供对复杂任务处理的深刻见解。专家执行任务的方式中包含了关键的决策点和操作技巧,这些信息可以用于通过模仿学习来训练具身智能模型以完成复杂任务。

- 典型方法:

- ALOHA:使用人类操作员通过一对机器手臂演示任务,记录机械臂的关节位置和多视角图像流,用于训练端到端模型,使机械臂能够仅凭RGB图像输入独立完成复杂任务。

- HumanPlus:通过单目RGB摄像头实现实时人体和手部运动的估计,并将其重新定位到仿人机器人的运动中,实现“影子跟随”。通过这种方式,人类操作员可以远程操作机器人收集全身数据,并进行监督行为克隆,训练基于视觉的技能策略。

- UMI (Universal Manipulation Interface):通过手持夹爪和精心设计的接口,收集复杂的双手和动态操作演示数据。学习到的策略与硬件无关,可以跨多个机器人平台部署。

- 小结:模仿学习能够有效地将人类的技能和经验传递给机器人,使其能够自主完成复杂任务。通过设计便携、低成本且信息丰富的数据收集框架,可以提高数据收集的便利性和效率。

视频学习

- 背景:互联网上的视频包含了巨量的人类与环境交互的信息,这些视频能够提供大规模的、多样的和真实的行为数据,用于训练具有广泛和通用行为能力的模型。然而,这些视频一般不包含标签,如何有效地提取视频中的动作信息用于训练是该方向的重点问题。

- 典型方法:

- VRB (Visual Robotic Behavior):通过利用互联网上的人类行为视频来训练一个视觉可供性模型,该模型能够估计人类在场景中的可能交互位置和方式,使机器人能够更好地理解和预测人类的交互行为。

- VPT (Video Pre-Training):提出了一种预训练方法,通过观察未标记的在线视频来训练能够在序列决策领域(如机器人技术)中行动的智能代理。通过半监督模仿学习的方法,利用少量标记数据训练逆动力学模型,预测视频中每个时间步的动作。

- RoboCLIP:提出了一种在线模仿学习方法,能够使用单个视频演示或文本描述来生成奖励函数,从而训练强化学习代理执行机器人操作任务。该方法利用预训练的视频和语言模型来编码代理行为的视频和任务描述,通过计算它们在潜在空间中的相似度得分来生成奖励。

- 小结:视频学习为具身智能系统提供了丰富的训练数据,通过预训练模型和模仿学习方法,可以有效地从视频中提取有用的动作信息,提高机器人的行为泛化能力。

结束语

具身智能的发展现状

- 潜力与进展:具身智能作为未来智能系统的关键发展方向,通过与物理环境的紧密互动,正逐步展现出超越传统离身智能的潜力。大模型的引入极大地增强了具身智能的感知精度、理解深度、规划智能及数据利用效率,使其在家庭服务、医疗、教育、工业等领域的应用前景广阔。

- 实现闭环:从感知与理解,到规划层面的需求级、任务级、规划级和动作级,大模型通过生成任务计划和序列化动作,展示了具身智能在复杂任务执行中的自主性和灵活性,实现了感知、规划和动作的闭环,彰显了具身智能的高级认知与执行能力。

面临的挑战

- 真实数据稀缺:真实世界数据的获取是具身智能系统训练和验证的关键。与虚拟环境相比,实体环境的数据收集面临着成本高、标注难、多样性不足等问题。此外,环境的多变性和不确定性要求模型能够泛化至未见情景,这进一步加剧了对大规模多样化数据的需求。

- 推理速度:大模型的庞大参数量带来了强大的零样本推理能力,但也带来了推理速度较慢的问题,目前使用大模型进行控制的工作往往无法做到实时响应,对实际应用产生了极大限制。一些工作通过使用轻量级的模型解决此类问题,但获得实时性的同时也损失了泛化性。

- 具身多智能体协同:面对现实世界中诸如灾难救援、智慧城市管理、群体机器人协作等高度复杂的任务,单一具身智能体往往难以有效应对。如何设计有效的通信与协调框架,使各具身智能机器人之间高效沟通并综合各局部信息进行整合决策,将是一个具有极大前景的方向。

未来发展方向

- 数据收集与标注:开发更高效、低成本的真实数据收集方法,提高数据集的规模和多样性,以满足具身智能系统对大规模多样化数据的需求。

- 模型优化:探索大模型的优化方法,如剪枝、量化等,以提高推理速度,使其能够更好地适应实时控制的要求。

- 多智能体协同:研究多具身智能体之间的通信与协调机制,设计有效的协同框架,以应对复杂任务的挑战。

- 跨领域应用:将基于大模型的具身智能技术应用于更多领域,如医疗、教育、工业等,推动具身智能的广泛应用。

- 人机交互优化:进一步提升具身智能系统与人类的交互能力,使其能够更好地理解人类的意图和反馈,提高任务完成的效率和质量。