广义矩估计随机近似中1.2和2.1的差异

1.2和2.1的差异

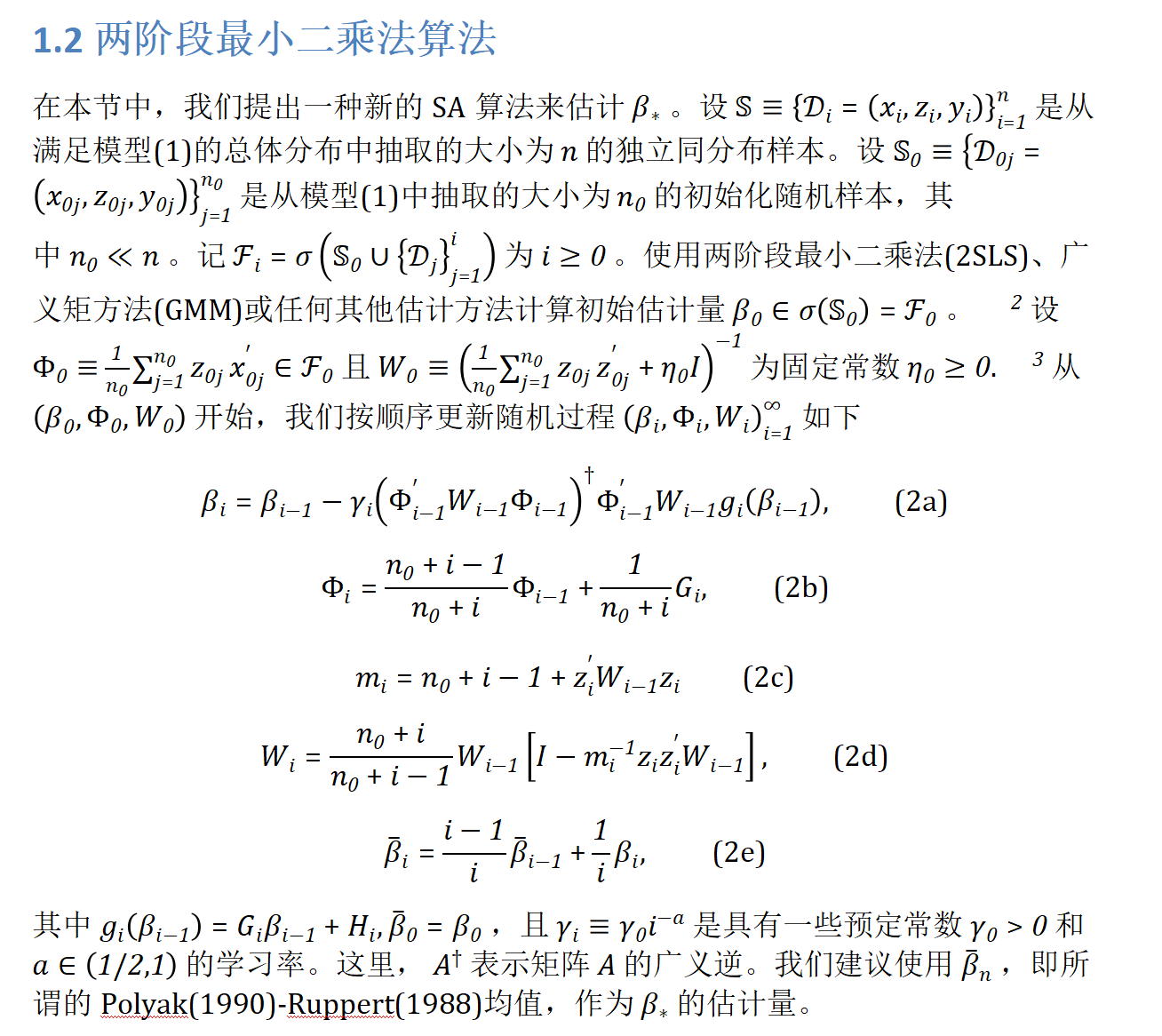

1.2节的S2SLS和2.1节的SGMM虽然公式相似,但存在本质差异,我通过三个维度解析:

1. 算法目标对比

| 维度 | 1.2节 S2SLS | 2.1节 SGMM |

|---|---|---|

| 统计目标 | 一致性估计(非最优) | 渐近有效估计(达到Cramér-Rao下界) |

| 权重矩阵 | Wi≈(E[zizi′])−1W_i \approx (\mathbb{E}[z_i z_i'])^{-1}Wi≈(E[zizi′])−1 | Wi≈Ω−1=(E[gigi′])−1W_i \approx \Omega^{-1} = (\mathbb{E}[g_i g_i'])^{-1}Wi≈Ω−1=(E[gigi′])−1 |

| 计算复杂度 | 低(O(dg2)O(d_g^2)O(dg2)) | 高(需两阶段设计) |

2. 样本分割的统计必要性

为什么必须分割样本?

- 根本矛盾:

最优权重 W=Ω−1=(E[gigi′])−1W = \Omega^{-1} = (\mathbb{E}[g_i g_i'])^{-1}W=Ω−1=(E[gigi′])−1 依赖残差 gi=zi(yi−xi′β)g_i = z_i(y_i - x_i'\beta)gi=zi(yi−xi′β)

→ 但 β\betaβ 本身待估计 → 循环依赖 - 解决方案:

样本分割打破循环:- 第一阶段(S1\mathbb{S}_1S1):

用S2SLS获得初步一致估计 βˉn1\bar{\beta}_{n_1}βˉn1 - 第二阶段(S2\mathbb{S}_2S2):

用冻结的 βˉn1\bar{\beta}_{n_1}βˉn1 计算残差 gi(βˉn1)g_i(\bar{\beta}_{n_1})gi(βˉn1)

→ 构建在线权重 Wi→Ω−1W_i \to \Omega^{-1}Wi→Ω−1

- 第一阶段(S1\mathbb{S}_1S1):

分割比例的意义

- 条件 n1→∞n_1 \to \inftyn1→∞ 且 n1/n→0n_1/n \to 0n1/n→0:

- n1→∞n_1 \to \inftyn1→∞:保证 βˉn1\bar{\beta}_{n_1}βˉn1 的一致性

- n1/n→0n_1/n \to 0n1/n→0:确保第二阶段主导渐近分布(效率不损失)

3. 关键公式解析:gi(βˉn1)g_i(\bar{\beta}_{n_1})gi(βˉn1)

定义与性质

gi(βˉn1)=zi(yi−xi′βˉn1) g_i(\bar{\beta}_{n_1}) = z_i (y_i - x_i' \bar{\beta}_{n_1}) gi(βˉn1)=zi(yi−xi′βˉn1)

- 含义:用第一阶段估计量 βˉn1\bar{\beta}_{n_1}βˉn1 计算的样本 iii 矩条件

- 是否更新?

在第二阶段固定不变(即使 iii 增加) - 为什么固定?

若用当前 βi−1\beta_{i-1}βi−1 会引入偏差(因 βi−1\beta_{i-1}βi−1 依赖历史路径)

在 (5c)-(5d) 中的作用

| 公式 | 角色 | 数学形式 |

|---|---|---|

| (5c) | 构建标量 mim_imi | mi=n0+i−1+gi(βˉn1)′Wi−1gi(βˉn1)⏟冻结残差的加权范数m_i = n_0 + i - 1 + \underbrace{g_i(\bar{\beta}_{n_1})' W_{i-1} g_i(\bar{\beta}_{n_1})}_{\text{冻结残差的加权范数}}mi=n0+i−1+冻结残差的加权范数gi(βˉn1)′Wi−1gi(βˉn1) |

| (5d) | 更新权重矩阵 | Wi∝Wi−1[I−mi−1gi(βˉn1)gi(βˉn1)′⏟冻结外积Wi−1]W_i \propto W_{i-1} \left[ I - m_i^{-1} \underbrace{g_i(\bar{\beta}_{n_1}) g_i(\bar{\beta}_{n_1})'}_{\text{冻结外积}} W_{i-1} \right]Wi∝Wi−1I−mi−1冻结外积gi(βˉn1)gi(βˉn1)′Wi−1 |

- 核心逻辑:

通过冻结的 gi(βˉn1)g_i(\bar{\beta}_{n_1})gi(βˉn1),WiW_iWi 收敛到 Ω−1\Omega^{-1}Ω−1(而非次优的 (Ezizi′)−1(\mathbb{E} z_i z_i')^{-1}(Ezizi′)−1)

4. 两阶段对比(公式级差异)

第一阶段(S2SLS)

- 权重更新(2c-d):

mim_imi 依赖 zi′Wi−1ziz_i' W_{i-1} z_izi′Wi−1zi(工具变量自相关)

→ WiW_iWi 估计 (Ezizi′)−1(\mathbb{E} z_i z_i')^{-1}(Ezizi′)−1 - 统计缺陷:

当 Var(ui∣zi)\text{Var}(u_i \mid z_i)Var(ui∣zi) 非常数(异方差)时非最优

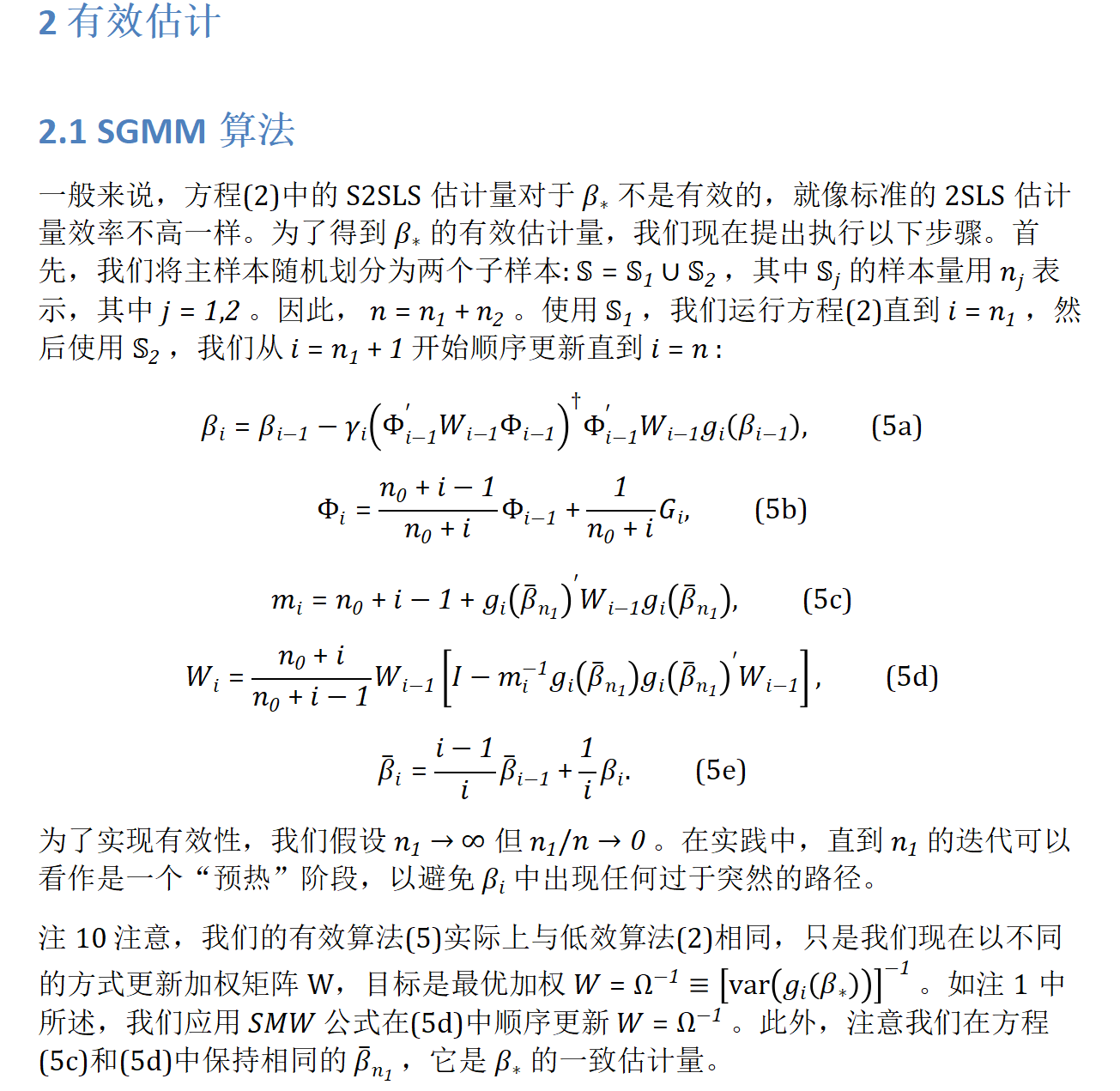

第二阶段(SGMM)

- 权重更新(5c-d):

mim_imi 依赖 gi(βˉn1)′Wi−1gi(βˉn1)g_i(\bar{\beta}_{n_1})' W_{i-1} g_i(\bar{\beta}_{n_1})gi(βˉn1)′Wi−1gi(βˉn1)(条件异方差感知)

→ WiW_iWi 估计 Ω−1=(E[ui2zizi′])−1\Omega^{-1} = (\mathbb{E}[u_i^2 z_i z_i'])^{-1}Ω−1=(E[ui2zizi′])−1 - 效率保证:

即使存在异方差,估计量仍渐近有效

为何需要如此复杂设计?

统计视角

- GMM 的最优性定理:

权重 W=Ω−1W = \Omega^{-1}W=Ω−1 时估计量方差最小 - 在线学习约束:

Ω\OmegaΩ 依赖未知 β\betaβ → 需用预估计 βˉn1\bar{\beta}_{n_1}βˉn1 逼近

计算视角

| 方案 | 计算可行性 | 统计效率 |

|---|---|---|

| 直接在线估计 Ω\OmegaΩ | 不可行 | - |

| 两阶段 SGMM | 可行 | 最优 |

总结:设计哲学

- 分而治之:

用第一阶段(大样本低效估计)为第二阶段提供“锚点” βˉn1\bar{\beta}_{n_1}βˉn1 - 效率解锁:

第二阶段用冻结残差在线构建最优权重 Wi→Ω−1W_i \to \Omega^{-1}Wi→Ω−1 - 渐近无损:

n1/n→0n_1/n \to 0n1/n→0 确保第一阶段不影响最终效率

这种设计是在线学习与统计最优性的黄金交点——它证明:通过精心设计的样本分割和冻结策略,流式算法也能达到离线GMM的统计效率极限。

以下是分阶段执行的精确步骤和冻结逻辑:

第一阶段:在线预热(子集 S1\mathbb{S}_1S1)

- 更新范围:

i=1,2,…,n1i = 1, 2, \dots, n_1i=1,2,…,n1(遍历第一个子集 S1\mathbb{S}_1S1) - 更新规则:

使用 S2SLS算法(公式2a-2e)在线逐样本更新:- βi\beta_iβi:参数估计(公式2a)

- Φi\Phi_iΦi:工具变量-解释变量协方差(公式2b)

- WiW_iWi:权重矩阵(公式2c-2d)

- βˉi\bar{\beta}_iβˉi:Polyak平均(公式2e)

- 输出结果:

在 i=n1i = n_1i=n1 时获得冻结值:

βˉn1=1n1∑j=1n1βj \boxed{\bar{\beta}_{n_1} = \frac{1}{n_1} \sum_{j=1}^{n_1} \beta_j} βˉn1=n11j=1∑n1βj

第二阶段:高效估计(子集 S2\mathbb{S}_2S2)

- 更新范围:

i=n1+1,…,ni = n_1 + 1, \dots, ni=n1+1,…,n(遍历第二个子集 S2\mathbb{S}_2S2) - 关键冻结操作:

对每个新样本 (xi,zi,yi)∈S2(x_i, z_i, y_i) \in \mathbb{S}_2(xi,zi,yi)∈S2:- 固定残差计算:

gi(βˉn1)=zi(yi−xi′βˉn1)(不再更新!) g_i(\bar{\beta}_{n_1}) = z_i (y_i - x_i' \bar{\beta}_{n_1}) \quad \text{(不再更新!)} gi(βˉn1)=zi(yi−xi′βˉn1)(不再更新!) - 权重更新(公式5c-5d):

mi=n0+i−1+gi(βˉn1)′Wi−1gi(βˉn1)⏟固定值Wi=n0+in0+i−1Wi−1[I−mi−1gi(βˉn1)gi(βˉn1)′⏟固定外积Wi−1] \begin{aligned} m_i &= n_0 + i - 1 + \underbrace{g_i(\bar{\beta}_{n_1})' W_{i-1} g_i(\bar{\beta}_{n_1})}_{\text{固定值}} \\ W_i &= \frac{n_0+i}{n_0+i-1} W_{i-1} \left[ I - m_i^{-1} \underbrace{g_i(\bar{\beta}_{n_1}) g_i(\bar{\beta}_{n_1})'}_{\text{固定外积}} W_{i-1} \right] \end{aligned} miWi=n0+i−1+固定值gi(βˉn1)′Wi−1gi(βˉn1)=n0+i−1n0+iWi−1I−mi−1固定外积gi(βˉn1)gi(βˉn1)′Wi−1

- 固定残差计算:

- 参数更新(公式5a, 5b, 5e):

- βi\beta_iβi:仍在线更新(依赖当前 WiW_iWi)

- Φi\Phi_iΦi:仍在线更新(累积 GiG_iGi)

- βˉi\bar{\beta}_iβˉi:Polyak平均(累积 βi\beta_iβi)

为什么必须冻结?

| 操作 | 原因 | 统计意义 |

|---|---|---|

| 冻结 βˉn1\bar{\beta}_{n_1}βˉn1 | 避免 β\betaβ 与 WiW_iWi 的循环依赖 | 保证 Wi→Ω−1W_i \to \Omega^{-1}Wi→Ω−1 |

| 冻结 gi(⋅)g_i(\cdot)gi(⋅) | 用一致估计 βˉn1\bar{\beta}_{n_1}βˉn1 计算残差,而非路径依赖的 βi−1\beta_{i-1}βi−1 | 消除偏差,确保效率最优 |

示例说明(n1=1000,n=106n_1=1000, n=10^6n1=1000,n=106)

-

第一阶段(i=1i=1i=1 到 100010001000):

- 在线更新所有变量 (βi,Φi,Wi,βˉi)(\beta_i, \Phi_i, W_i, \bar{\beta}_i)(βi,Φi,Wi,βˉi)

- 结束时保存 βˉ1000\bar{\beta}_{1000}βˉ1000

-

第二阶段(i=1001i=1001i=1001 到 10610^6106):

- 对每个新样本:

- 计算固定残差 gi=zi(yi−xi′βˉ1000)g_i = z_i(y_i - x_i' \bar{\beta}_{1000})gi=zi(yi−xi′βˉ1000)

- 更新 WiW_iWi(依赖冻结的 gig_igi)

- 更新 βi,Φi,βˉi\beta_i, \Phi_i, \bar{\beta}_iβi,Φi,βˉi(依赖最新 WiW_iWi)

- 最终输出 βˉ106\bar{\beta}_{10^6}βˉ106

- 对每个新样本:

设计必要性

- 统计效率:

冻结操作使 WiW_iWi 收敛到最优权重 Ω−1\Omega^{-1}Ω−1(GMM理论要求) - 计算可行性:

若在第二阶段更新 gi(βi−1)g_i(\beta_{i-1})gi(βi−1),需递归计算残差 → 破坏在线性 - 路径无关性:

冻结 βˉn1\bar{\beta}_{n_1}βˉn1 确保权重更新不受 βi\beta_iβi 随机波动影响

总结

第一阶段在线预热 → 冻结 βˉn1\bar{\beta}_{n_1}βˉn1 → 第二阶段用固定残差在线更新权重。

这是SGMM在不损失统计效率的前提下实现在线学习的核心创新。