linux下部署 dify,并配置本地ollama大模型

一、安装配置dify

1.1、源码路径:

https://github.com/langgenius/dify.git

1.1、配置

cd dify/dockercp .env.example .env1.2、启动

sudo docker compose up -d1.3、检测启动师傅成功

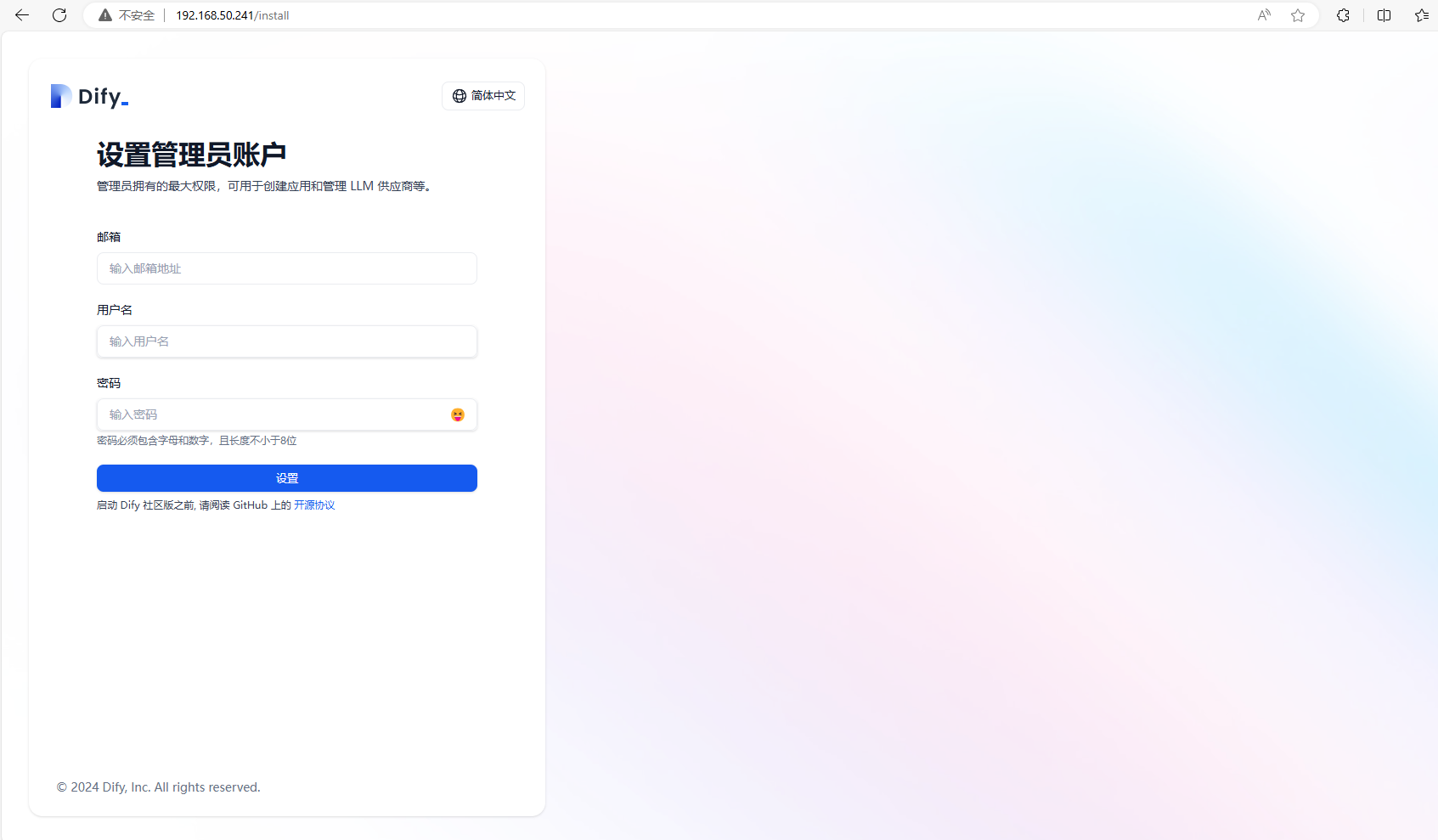

docker compose ps1.4、然后打开一个新的浏览器,输入 localhost:80,或者本机 IP 地址:80,可以看到进入到了 Dify 中。

设置管理员账号:填写邮箱、用户名、密码后,再重新登录一下

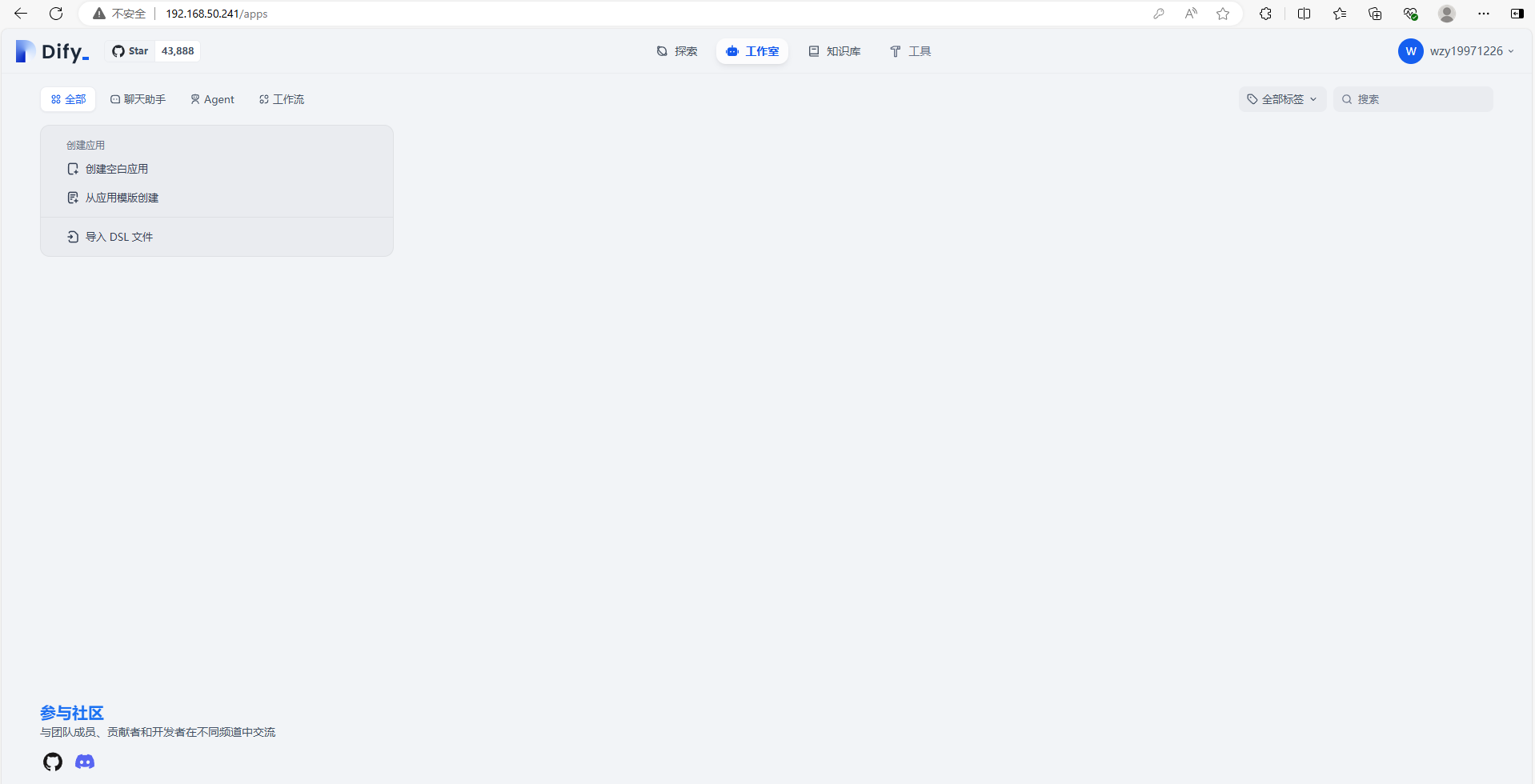

可以看到进入到了 Dify 的主界面当中

二、配置ollama模型

在 Dify 中接入 Ollama 大语言模型

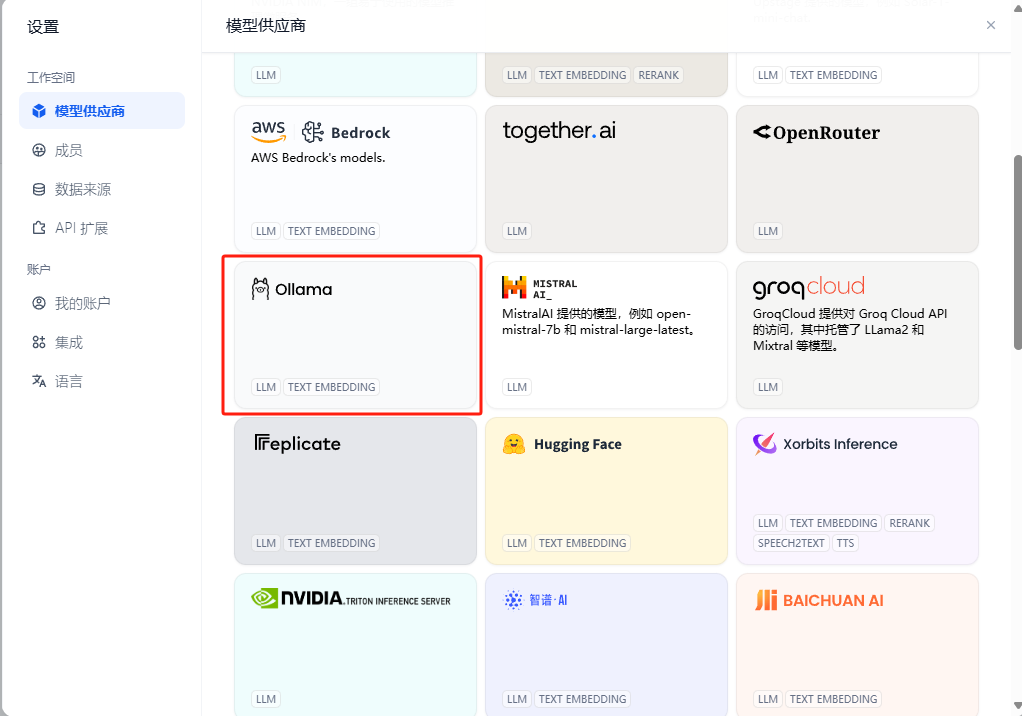

① 在 Dify 主界面,点击右上角个人名字圆圈,点击设置——模型供应商——Ollama

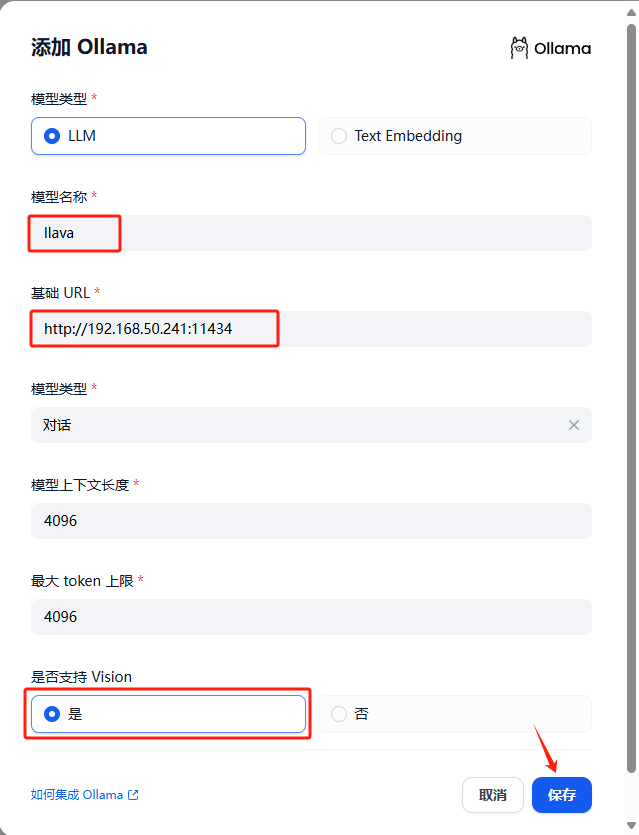

② 点击填入:

模型名称:llava

基础 URL:http://<本机IP地址>:11434

此处需填写可访问到的 Ollama 服务地址。

若 Dify 为 docker 部署,建议填写局域网 IP 地址,如:http://192.168.1.100:11434 或 docker 宿主机 IP 地址,如:http://172.17.0.1:11434。

若为本地源码部署,可填写 http://localhost:11434。

模型类型:对话

模型上下文长度:4096

模型的最大上下文长度,若不清楚可填写默认值 4096。

最大 token 上限:4096

模型返回内容的最大 token 数量,若模型无特别说明,则可与模型上下文长度保持一致。

是否支持 Vision:是

当模型支持图片理解(多模态)勾选此项,如 llava。

点击 “保存” 校验无误后即可在应用中使用该模型。

问题:

在高版本dify配置ollama本地模型时,会出现修改成功,但是模型没有显示的问题

解决方法如下:

修改.env , 放开pip 镜像配置,问题修复

PLUGIN_PYTHON_ENV_INIT_TIMEOUT=120

PLUGIN_MAX_EXECUTION_TIMEOUT=600

PIP_MIRROR_URL=https://pypi.tuna.tsinghua.edu.cn/simple

然后重启 dify服务即可