windows上LM-Studio下载安装教程

环境准备

基础硬件配置,我这里是用了退役笔记本作为服务器,运行 ESXi 虚拟化环境,这次使用的虚拟机参数如下:

- CPU:4 x 3.3 Ghz

- RAM:16GB

- GPU:RTX3050 4GB显存

- OS:Windows 10 Workstation(22H2)

注意,除此以外继续阅读本文还需要你具备以下能力:

- 有自己的网络优化手段,部分资源无法在国内直连

- 基本英语阅读能力,至少报错信息得看的懂

安装 LM Studio

这一步在 Windows 上是非常简单的,前往 LM Studio 官网,点击“Download LM Studio for Windows”就可以下载安装包了,如果下载太慢或者下载不下来可以尝试gitee.com/FIRC/fircfiles/blob/master/lmstudio.md进行下载,这里我就在这下载的。之后双击安装包开始安装。

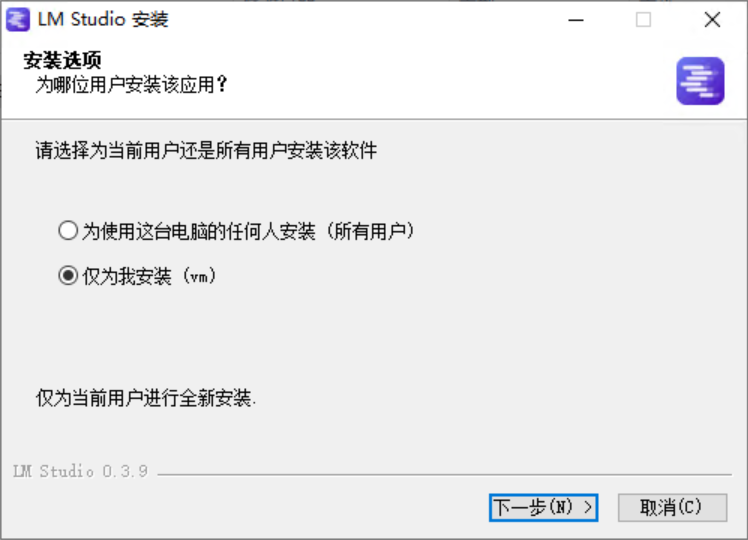

这里的选项没什么大影响,保持默认即可。

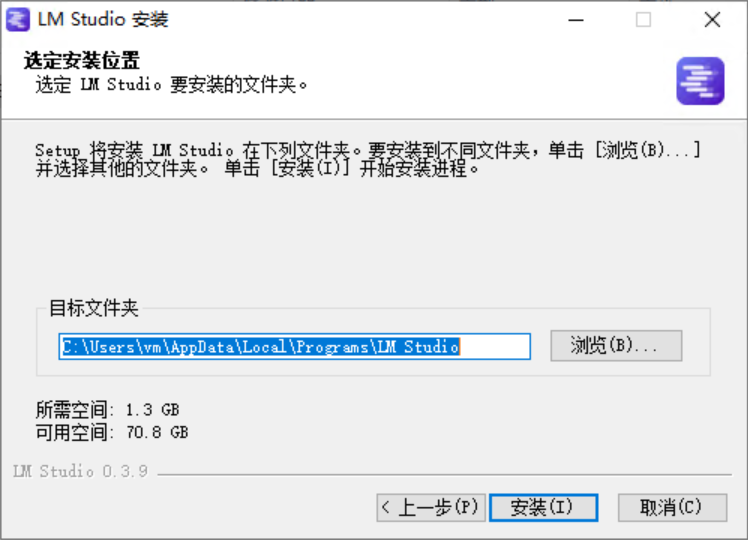

这里可以更改 LM Studio 的安装位置,你可以把它安装到别的磁盘分区或者独立文件夹来方便管理,我这里由于是虚拟机也只有一个分区就没改了。

稍等片刻提示安装完成,默认“运行 LM Studio”是勾选状态,我这里给取消了。至此 LM Studio 安装完成。

部署 Deepseek 模型

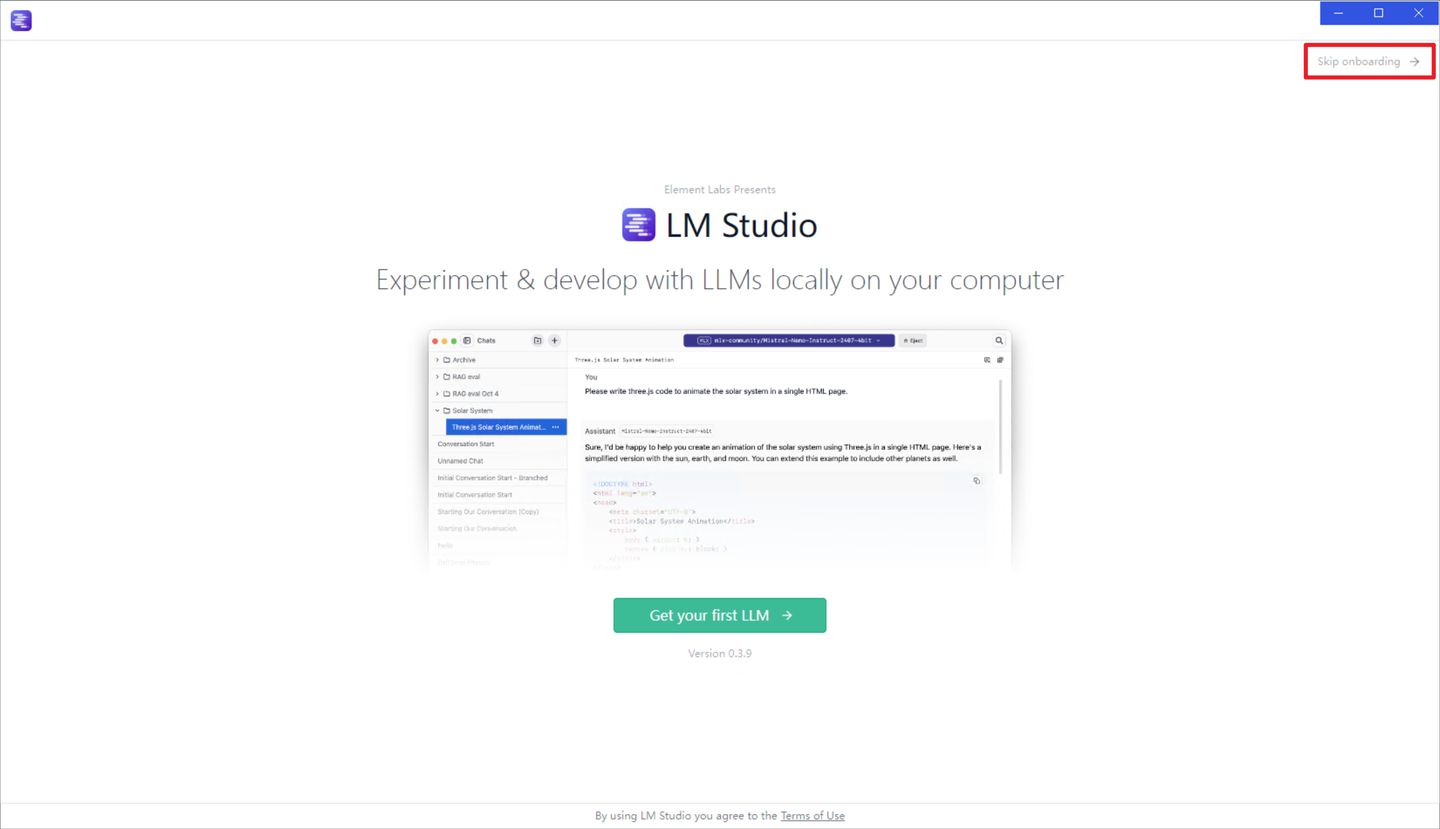

双击桌面 LM Studio 图标打开它:

首次打开软件会出现欢迎界面,此处点击右上角跳过。

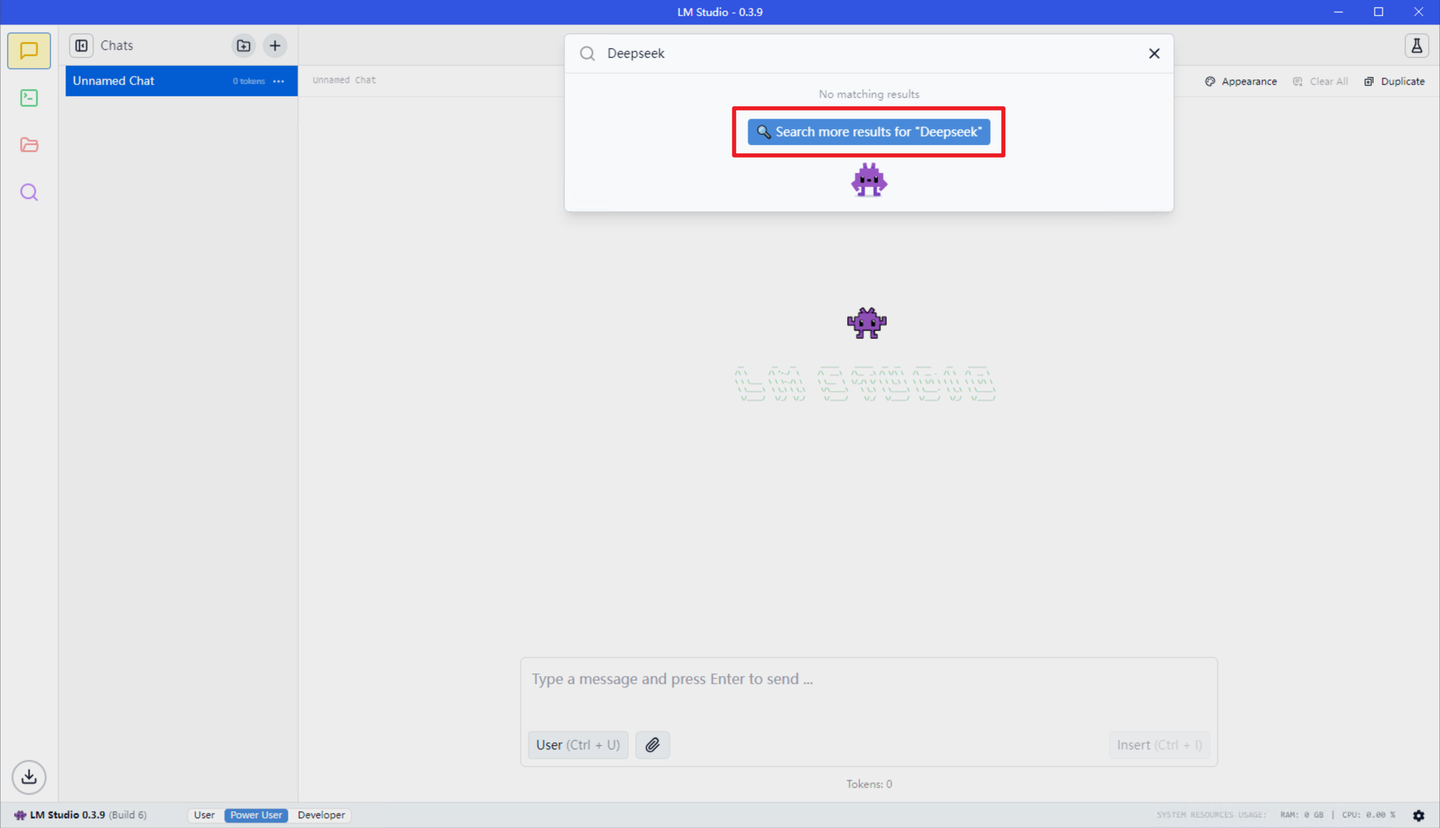

点击顶部灰色框打开模型加载器,搜索 Deepseek,由于此时本地尚未下载 Deepseek 模型,此处点击“Search more result for ‘Deepseek’”。

提示:单击此界面右下角齿轮,在 Language 选项中可切换为简体中文,不过简中目前尚为 Beta 状态,故此教程依旧使用英文演示。

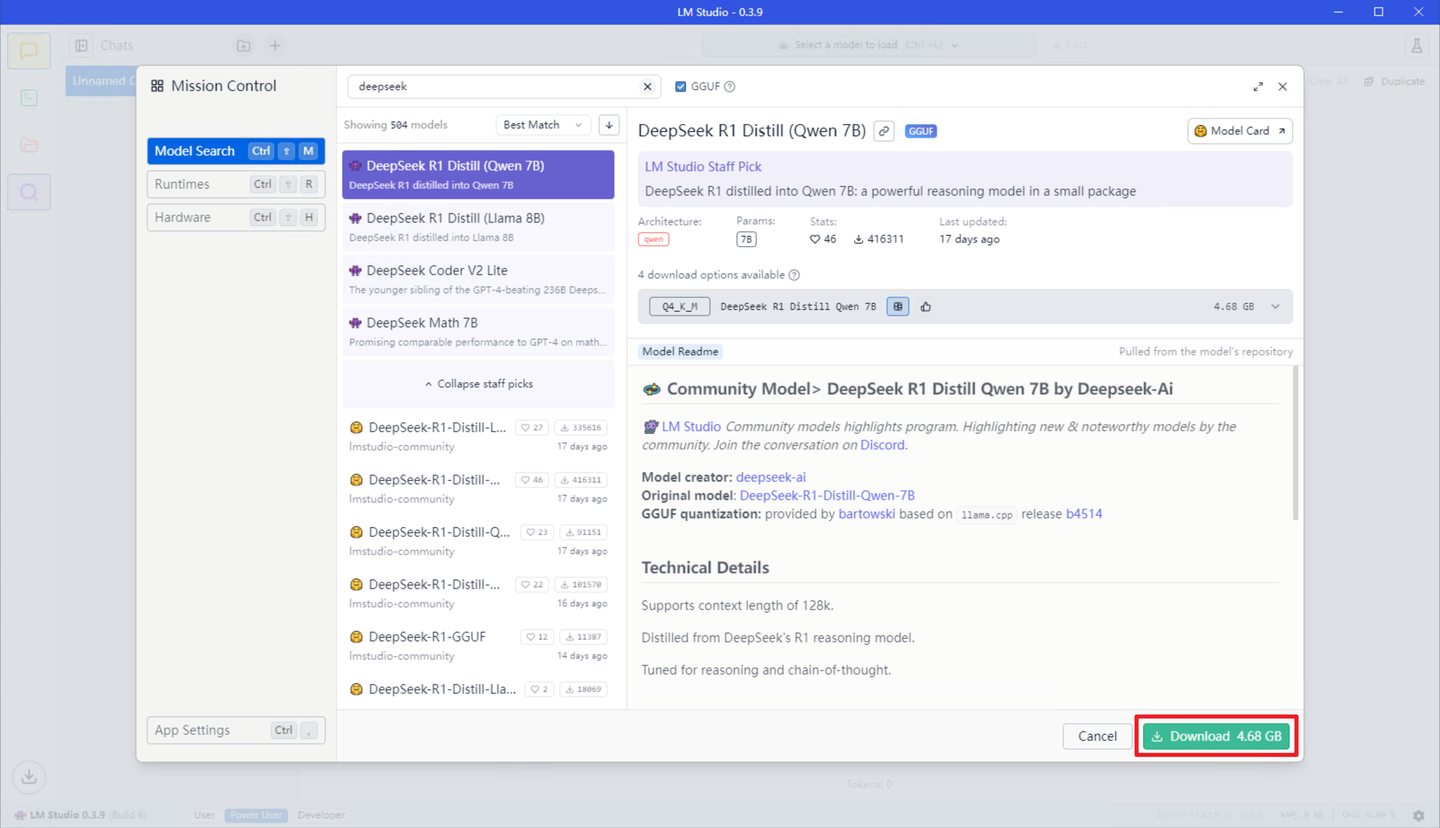

在弹出的模型搜索器中,选择你要下载的模型,单击右下角 Download 下载即可。由于模型较大下载时间可能较长,需要有足够的耐心以及足够稳定的网络条件。

提示:如果你不想等 LM Studio 的单线程下载,你可以选择自行下载相关模型文件,只需要在 LM Studio 中暂停下载后退出软件,然后使用你下载好的模型文件替换 LM Studio 正在下载的模型文件(注意命名要一致),之后重新打开 LM Studio 点击继续下载即可,它会自动检测到文件已下载完成并归档。

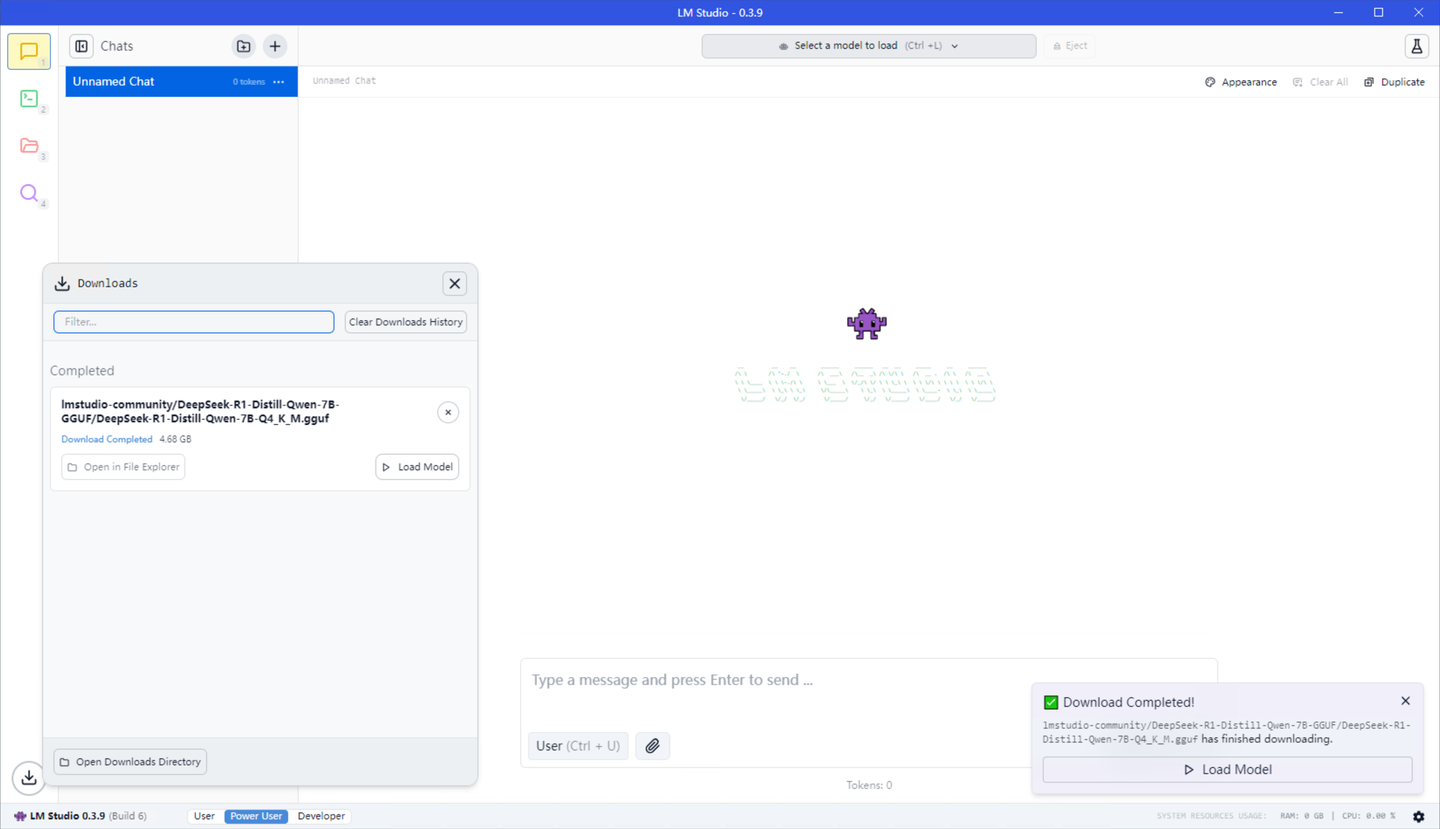

当右下角出现“Download Completed”的时候就是模型下载完成了,此时点击顶部灰色的“Select a model to load”打开模型加载器,并在弹出的界面中点击你要加载的模型。

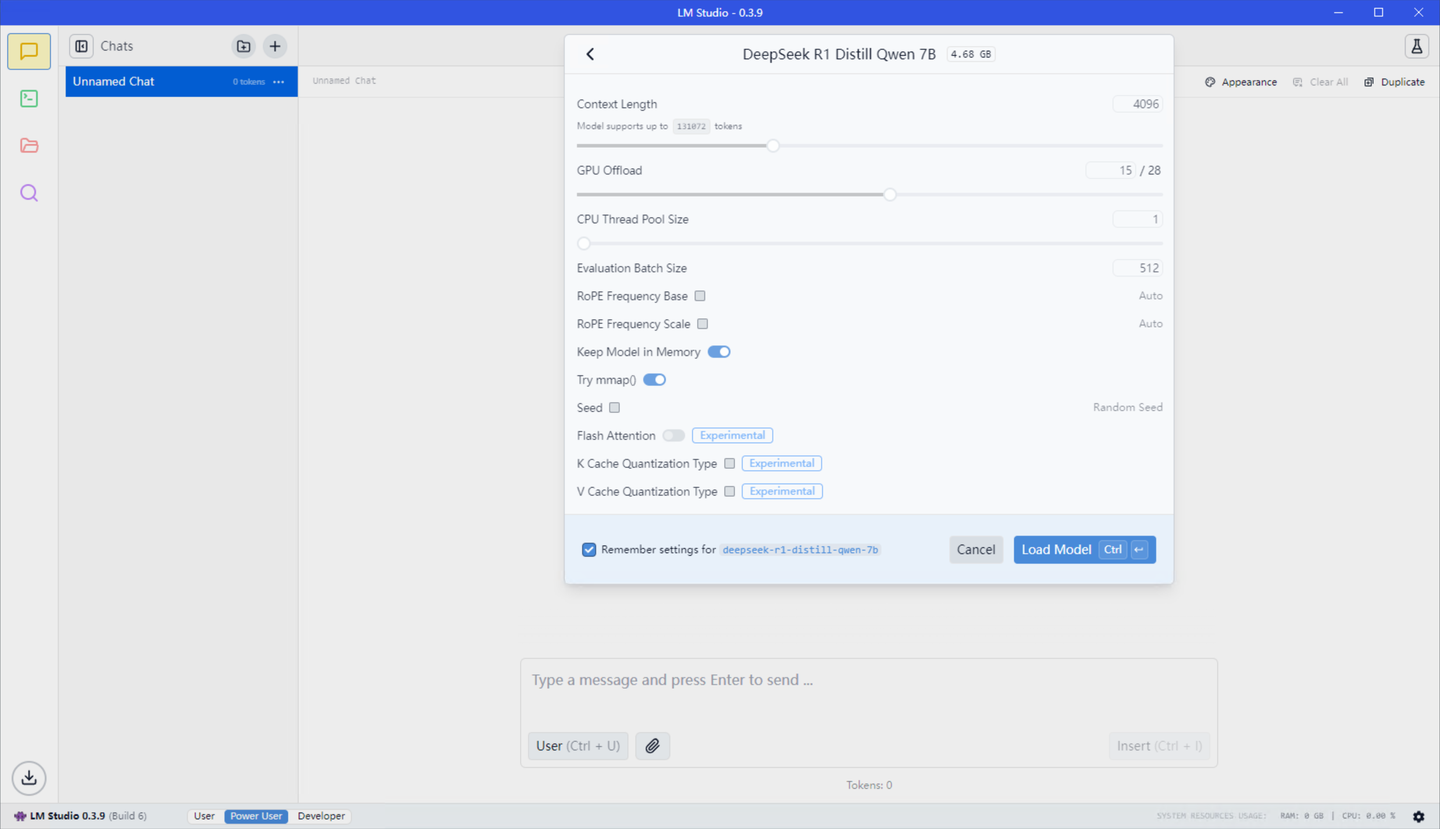

此时会出现模型参数配置页面,在此处你可以根据自己电脑的性能对参数进行调整,但默认参数已经为 LM Studio 调优过的,可以直接用于加载模型。

配置完成后点击“Load Model”或按回车键即可加载模型。

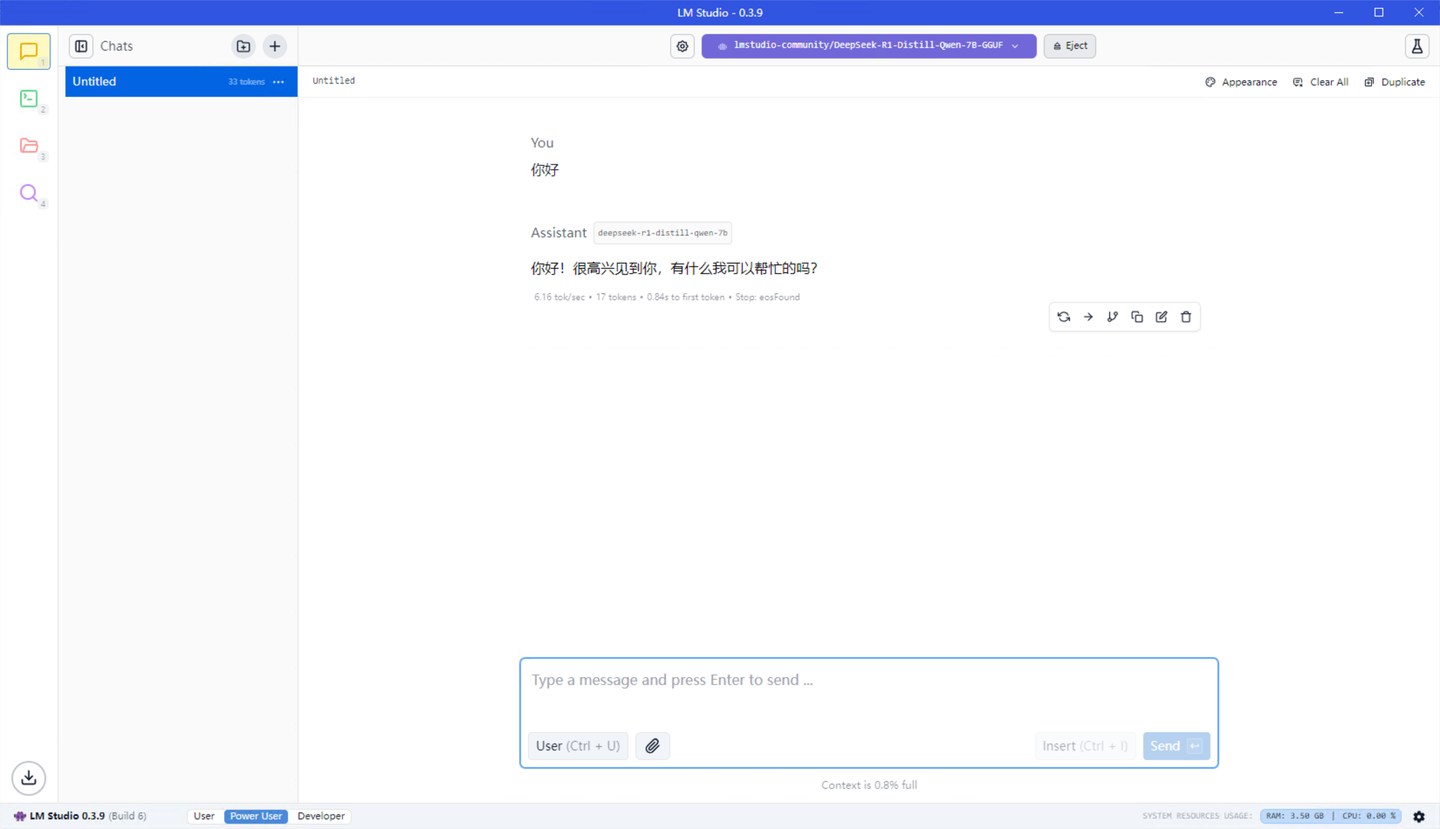

至此 Deepseek 模型部署完成,你可以在此界面内与 LLM 进行深入交流。

开放 LM Studio API

此章节用于介绍如何将 LM Studio 的内部模型开放到局域网,并实现让 Dify 对接 LM Studio 并使用其中的模型。如果你没有此需求则此章节不需要阅读。

首先点击 LM Studio 左侧的绿色终端图标打开 API 服务器配置页面。

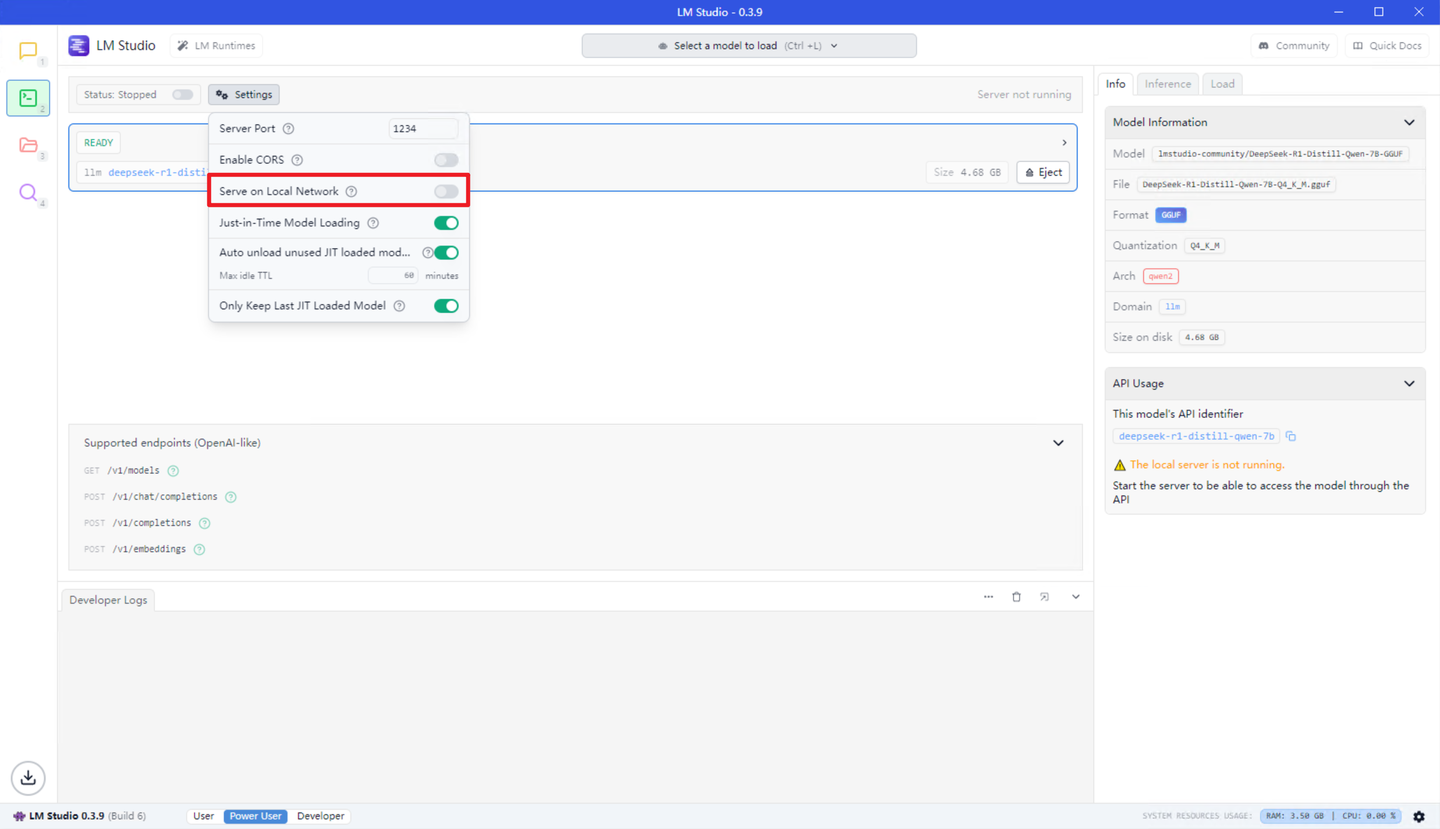

在打开的页面中,点击“Settings”-打开 “Serve on Local Network”。

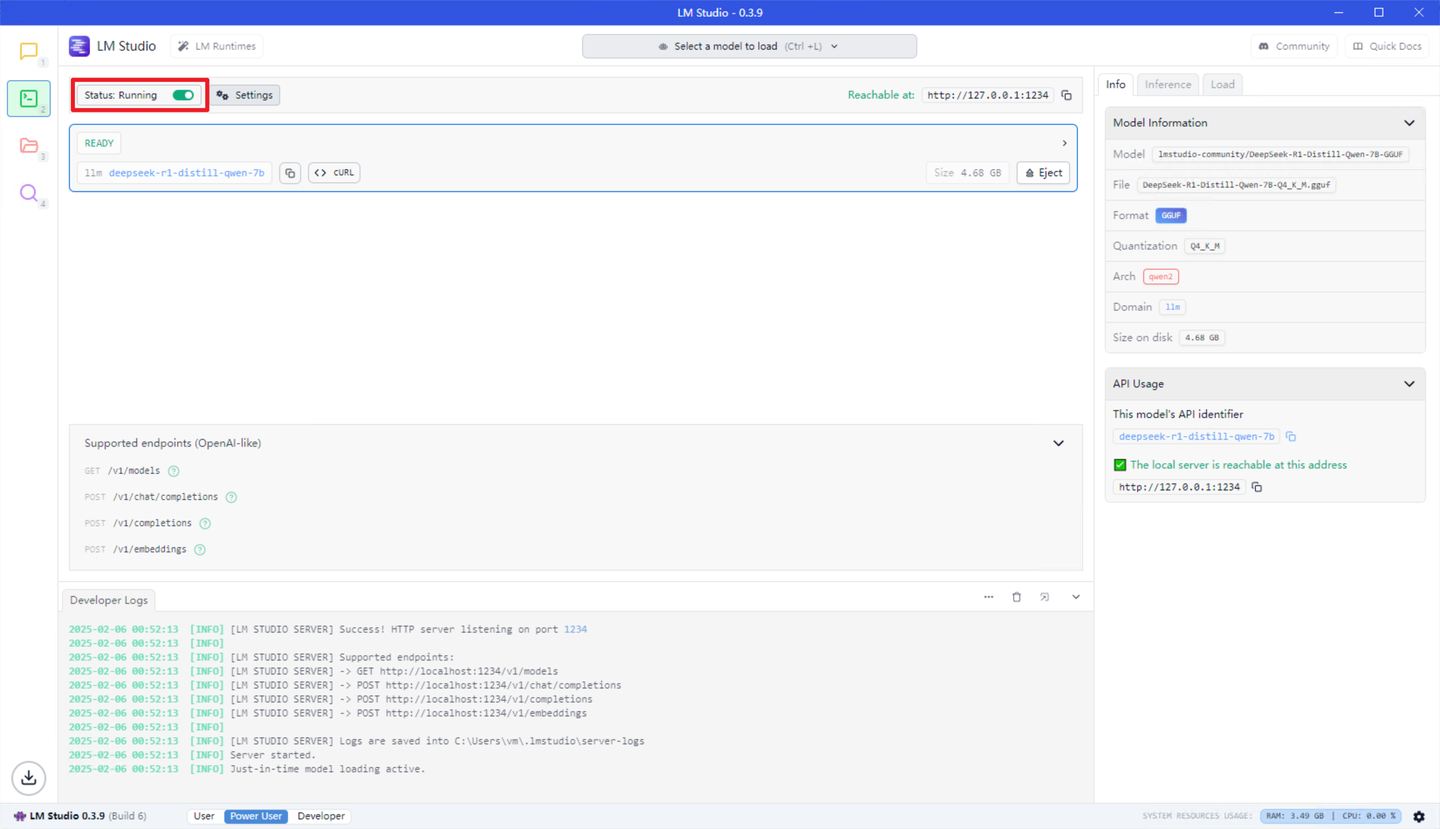

之后点击左侧“Status: Stopped”来打开 API 服务器。

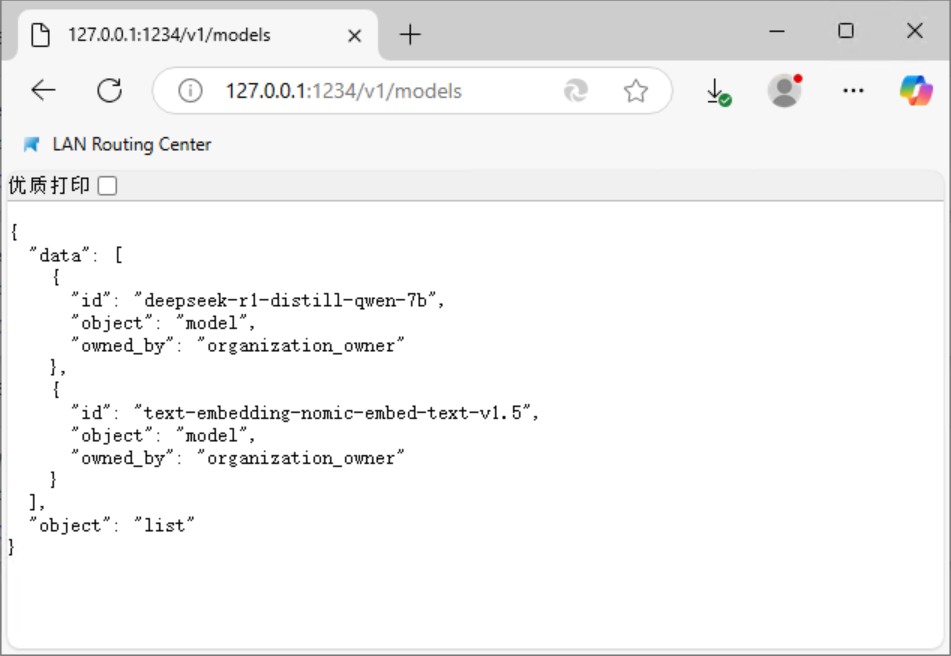

此时打开你的浏览器,输入http://<运行LM Studio设备的局域网IP>:1234/v1/models ,如果出现以下界面则代表 API 服务器已成功运行:

Dify 调用 LM Studio 模型

文章最开始提到了 Dify,简单介绍 Dify 就是一个 LLM 开发平台,它支持对接各种平台的不同模型,并通过流水线与自动化实现 LLM 协作,同时又能够将你的流水线直接包装成 Web App 以供随时使用,此章节介绍如何在 Dify 中对接并使用 LM Studio 的模型。

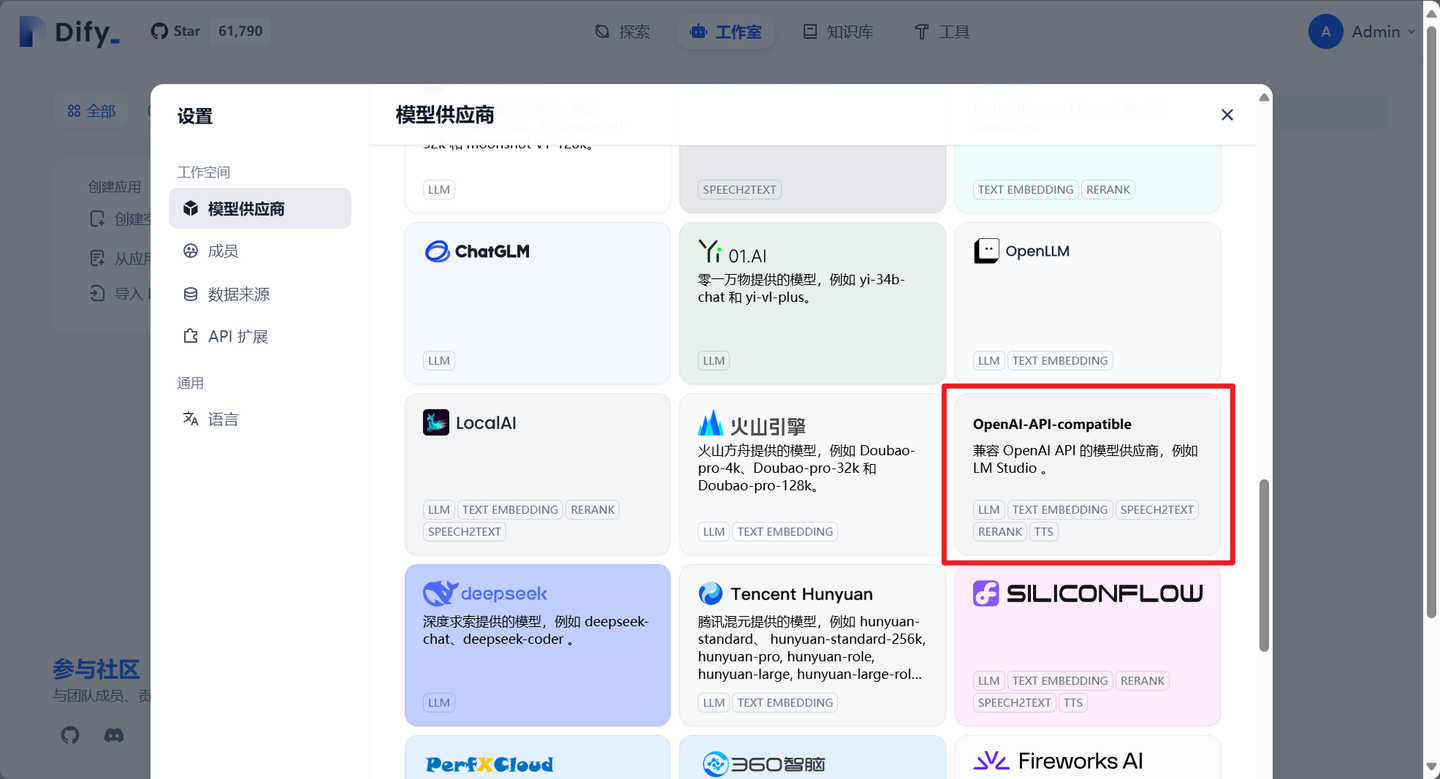

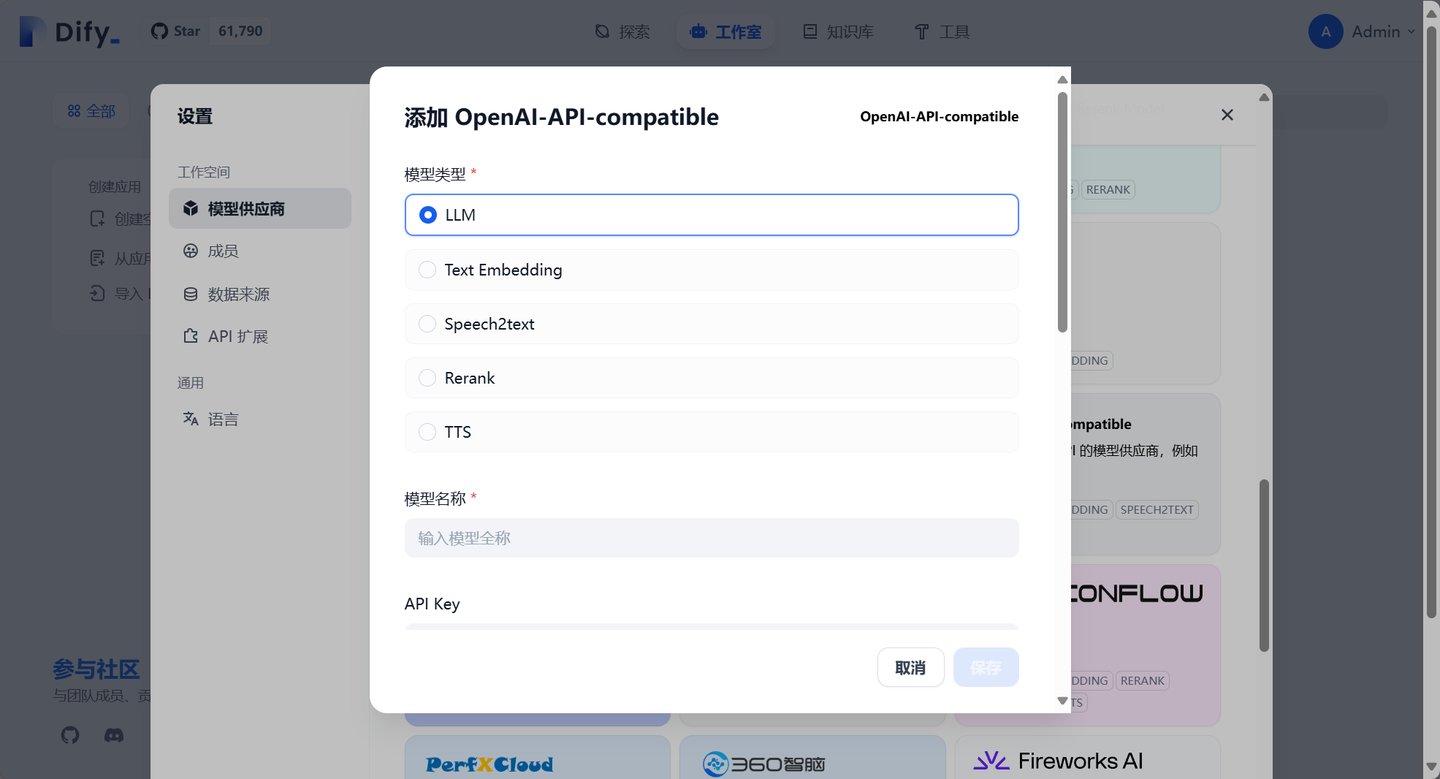

打开 Dify,点击右上角头像-”设置“,在设置面板中选择左侧”模型供应商“,在模型供应商面板中选择”OpenAI-API-compatible“。

在新打开的配置页面中,填入以下参数:

模型类型:LLM

模型名称:deepseek-r1-distill-qwen-7b

API Key:<留空不填>

API endpoint URL:http://<运行LM Studio设备的局域网IP>:1234/v1

Completion mode:对话

模型上下文长度:4096(如果你在 LM Studio 侧自定义了模型上下文长度则此处需同步)

最大 token 上限:4096

Function calling:不支持

Stream function calling:不支持

Vision 支持:不支持

流模式返回结果的分隔符:\n\n补全参数后点击保存即可完成模型新建,之后创建一个 Bot 进行测试即可:

最后放出它生成的诗作为结尾吧:

《种子》种子破土而出

风掠过

带走水分

留下荒芜的地面

和干涸的眼睛

地心深处埋着

无数根相连的神经

它们将我

衔接到永恒的深处雨落下的时候

土地才会张开怀抱

温柔地

接纳这个不属于她的形状

而我已经在这片土地上生了根

发出了声音

和存在的气息我们是相连的

在某个遥远的时刻

我终于明白

所有的语言都已消逝

只剩下等待和生长丰收是在雨后的日落里

当最后一粒种子落下时

它会张开双臂

迎接黎明