【完整源码+数据集+部署教程】海洋物体实例分割系统源码和数据集:改进yolo11-EfficientHead

背景意义

研究背景与意义

随着全球海洋资源的日益枯竭和环境问题的加剧,海洋生态系统的保护与管理变得愈发重要。海洋物体实例分割技术作为计算机视觉领域的一项重要应用,能够有效地识别和分割海洋中的各种物体,为海洋生物监测、环境保护和资源管理提供了强有力的技术支持。近年来,深度学习技术的快速发展,尤其是目标检测和实例分割算法的进步,使得海洋物体的自动识别和分析成为可能。YOLO(You Only Look Once)系列模型因其高效性和准确性,已成为目标检测领域的主流选择。

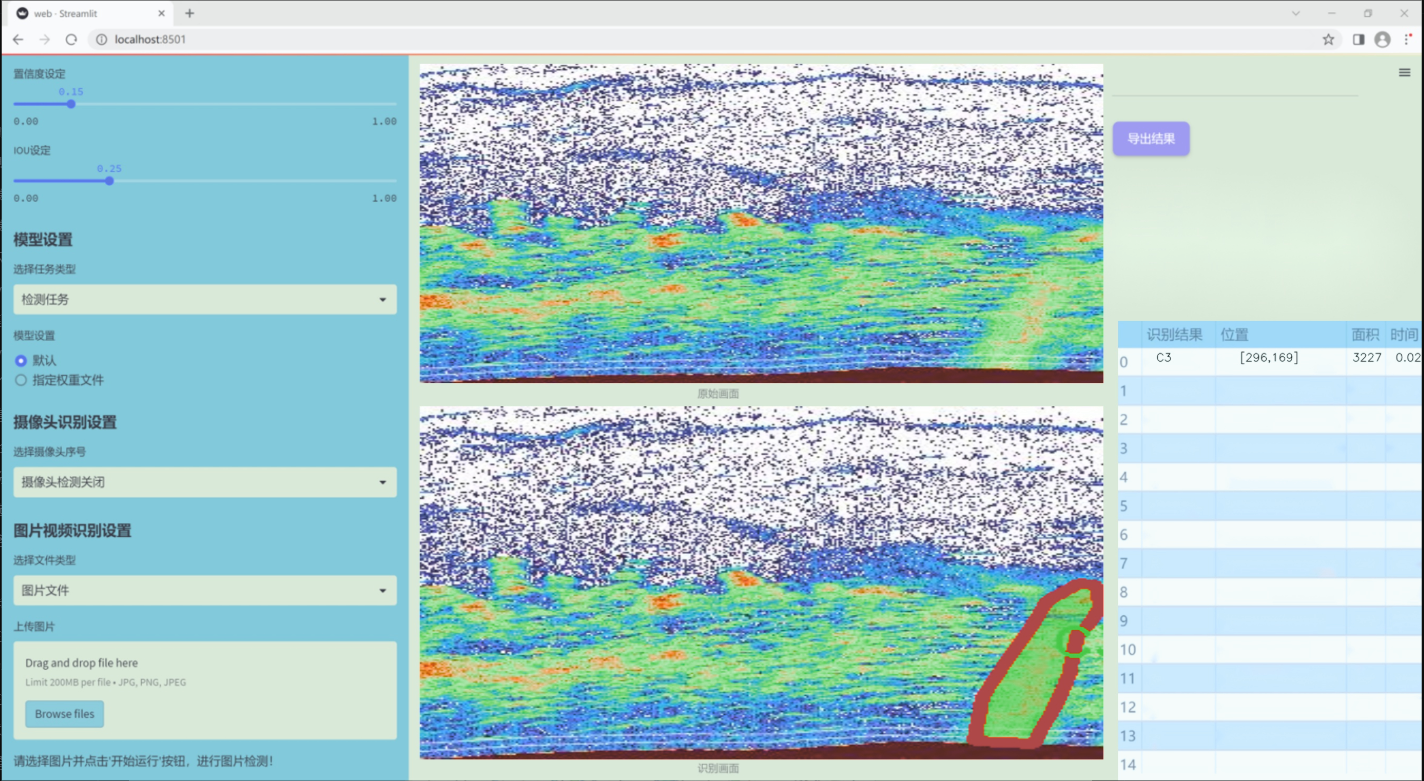

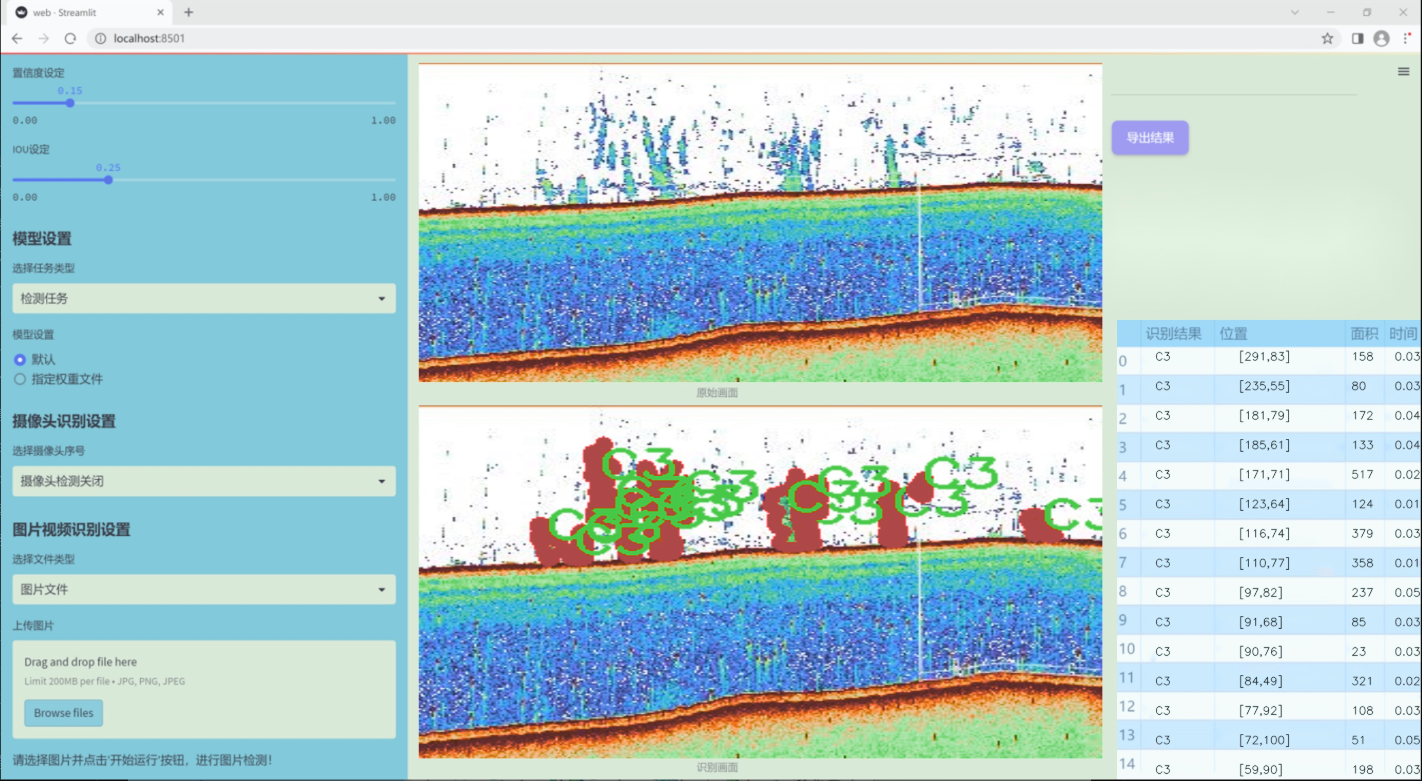

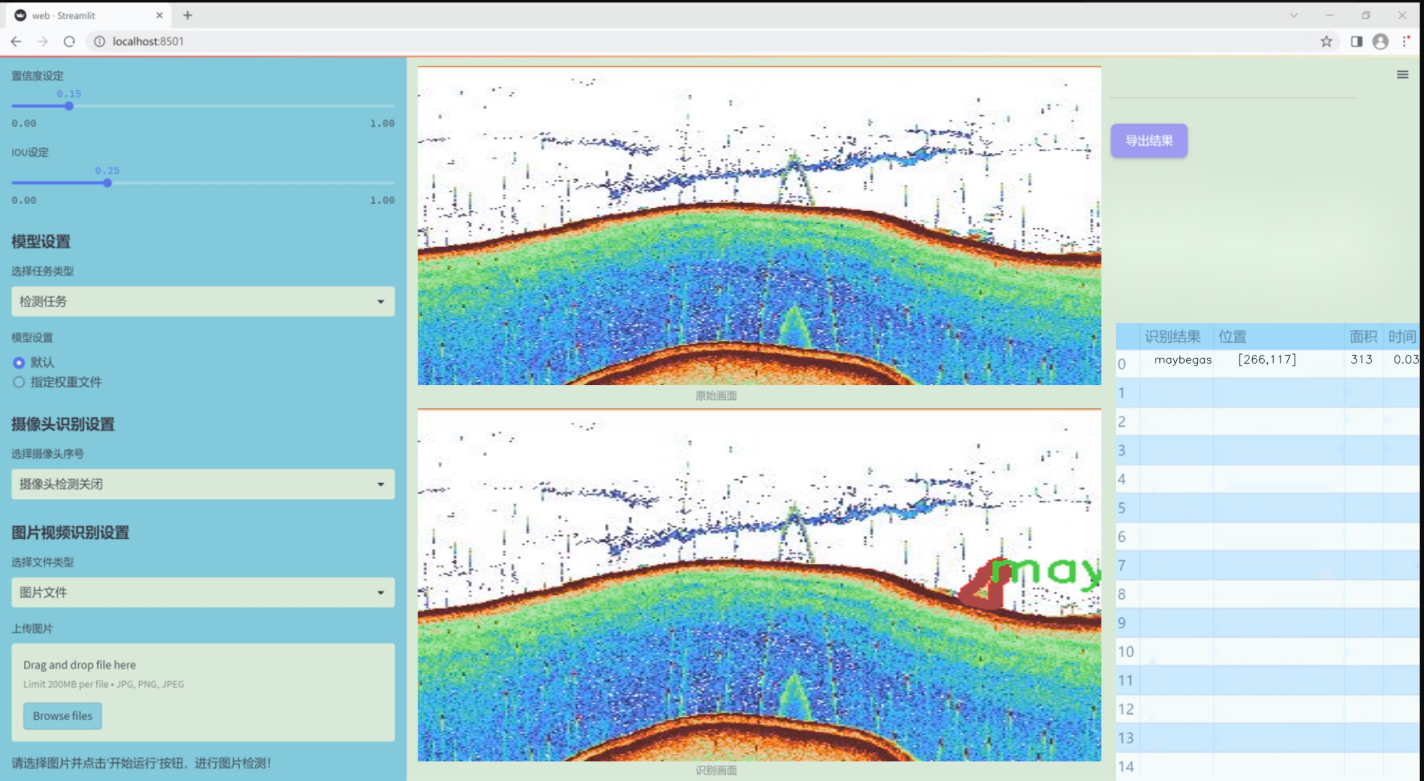

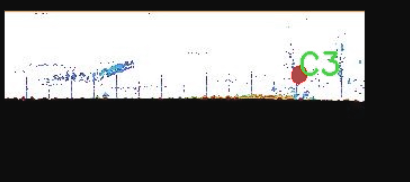

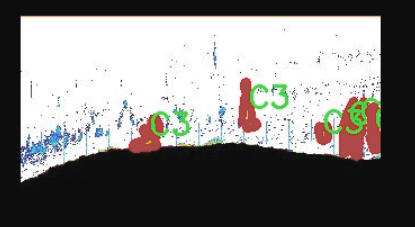

本研究旨在基于改进的YOLOv11模型,构建一个高效的海洋物体实例分割系统。通过对海洋图像数据集的深入分析与处理,我们将重点关注四类海洋物体的识别与分割:C3、C4、C5和maybegas。这些类别的选择不仅涵盖了海洋生态系统中的重要组成部分,还能够为海洋资源的可持续利用提供数据支持。数据集包含1700幅图像,涵盖了多种海洋环境下的物体实例,具备较高的代表性和多样性。

在技术层面,改进YOLOv11模型将通过引入更为先进的特征提取网络和优化的损失函数,提升模型在复杂海洋环境中的分割精度和鲁棒性。同时,实例分割的实现将为后续的海洋物体追踪、行为分析等研究奠定基础。通过本项目的实施,我们期望不仅能推动海洋物体识别技术的发展,还能为海洋生态保护提供科学依据,促进海洋可持续发展目标的实现。

图片效果

数据集信息

本项目数据集信息介绍

本项目旨在开发和改进YOLOv11的海洋物体实例分割系统,为此我们构建了一个高质量的数据集,名为“Pixels 2.0”。该数据集专注于海洋环境中的特定物体识别与分割,涵盖了四个主要类别:C3、C4、C5和maybegas。这些类别代表了在海洋生态系统中具有重要意义的物体,分别对应于不同的海洋生物或物体特征。通过对这些类别的细致标注,我们的目标是提高YOLOv11在复杂海洋环境中的识别精度和分割效果。

数据集的构建过程涉及多种数据采集技术,包括水下摄影、遥感技术以及人工智能辅助的图像处理。每个类别的样本均经过严格筛选,确保其在多种环境条件下的代表性和多样性。这种多样性不仅有助于模型的泛化能力,还能提升其在实际应用中的表现。此外,数据集中包含了丰富的背景信息,以模拟真实海洋环境中的复杂性,确保模型在不同光照、深度和水流条件下的鲁棒性。

为了便于后续的训练和测试,我们对数据集进行了详细的标注和分类,确保每个样本都清晰地标识出其所属类别。这样的标注不仅为模型的训练提供了必要的监督信号,也为后续的评估和验证提供了可靠的基础。通过“Pixels 2.0”数据集的使用,我们期望能够推动海洋物体实例分割技术的发展,为海洋生态保护和资源管理提供更为精确的工具和方法。

核心代码

以下是经过简化和注释的核心代码,主要包括了Swin Transformer的基本结构和功能模块。

import torch

import torch.nn as nn

import torch.nn.functional as F

import numpy as np

class Mlp(nn.Module):

“”" 多层感知机 (MLP) 模块。 “”"

def __init__(self, in_features, hidden_features=None, out_features=None, act_layer=nn.GELU, drop=0.):super().__init__()out_features = out_features or in_features # 输出特征数默认为输入特征数hidden_features = hidden_features or in_features # 隐藏层特征数默认为输入特征数self.fc1 = nn.Linear(in_features, hidden_features) # 第一层线性变换self.act = act_layer() # 激活函数self.fc2 = nn.Linear(hidden_features, out_features) # 第二层线性变换self.drop = nn.Dropout(drop) # Dropout层def forward(self, x):""" 前向传播 """x = self.fc1(x) # 线性变换x = self.act(x) # 激活x = self.drop(x) # Dropoutx = self.fc2(x) # 线性变换x = self.drop(x) # Dropoutreturn x

class WindowAttention(nn.Module):

“”" 窗口基础的多头自注意力模块。 “”"

def __init__(self, dim, window_size, num_heads, qkv_bias=True, attn_drop=0., proj_drop=0.):super().__init__()self.dim = dimself.window_size = window_size # 窗口大小self.num_heads = num_heads # 注意力头数head_dim = dim // num_heads # 每个头的维度self.scale = head_dim ** -0.5 # 缩放因子# 相对位置偏置表self.relative_position_bias_table = nn.Parameter(torch.zeros((2 * window_size - 1) * (2 * window_size - 1), num_heads))# 计算相对位置索引coords_h = torch.arange(self.window_size)coords_w = torch.arange(self.window_size)coords = torch.stack(torch.meshgrid([coords_h, coords_w])) # 生成坐标网格coords_flatten = torch.flatten(coords, 1) # 展平坐标relative_coords = coords_flatten[:, :, None] - coords_flatten[:, None, :] # 计算相对坐标relative_coords = relative_coords.permute(1, 2, 0).contiguous() # 调整维度relative_coords[:, :, 0] += self.window_size - 1 # 偏移relative_coords[:, :, 1] += self.window_size - 1relative_coords[:, :, 0] *= 2 * self.window_size - 1self.relative_position_index = relative_coords.sum(-1) # 计算相对位置索引self.qkv = nn.Linear(dim, dim * 3, bias=qkv_bias) # 计算Q, K, Vself.attn_drop = nn.Dropout(attn_drop) # 注意力的Dropoutself.proj = nn.Linear(dim, dim) # 输出线性变换self.proj_drop = nn.Dropout(proj_drop) # 输出的Dropoutdef forward(self, x, mask=None):""" 前向传播 """B_, N, C = x.shape # B: 批量大小, N: 序列长度, C: 特征维度qkv = self.qkv(x).reshape(B_, N, 3, self.num_heads, C // self.num_heads).permute(2, 0, 3, 1, 4)q, k, v = qkv[0], qkv[1], qkv[2] # 分离Q, K, Vq = q * self.scale # 缩放Qattn = (q @ k.transpose(-2, -1)) # 计算注意力权重# 添加相对位置偏置relative_position_bias = self.relative_position_bias_table[self.relative_position_index.view(-1)].view(self.window_size * self.window_size, self.window_size * self.window_size, -1)attn = attn + relative_position_bias.unsqueeze(0) # 添加偏置attn = F.softmax(attn, dim=-1) # 归一化attn = self.attn_drop(attn) # Dropoutx = (attn @ v).transpose(1, 2).reshape(B_, N, C) # 应用注意力x = self.proj(x) # 输出变换x = self.proj_drop(x) # Dropoutreturn x

class SwinTransformerBlock(nn.Module):

“”" Swin Transformer的基本块。 “”"

def __init__(self, dim, num_heads, window_size=7, shift_size=0, mlp_ratio=4., drop=0., attn_drop=0.):super().__init__()self.norm1 = nn.LayerNorm(dim) # 归一化层self.attn = WindowAttention(dim, window_size, num_heads, attn_drop=attn_drop) # 注意力模块self.norm2 = nn.LayerNorm(dim) # 归一化层self.mlp = Mlp(in_features=dim, hidden_features=int(dim * mlp_ratio), drop=drop) # MLP模块def forward(self, x):""" 前向传播 """shortcut = x # 残差连接x = self.norm1(x) # 归一化x = self.attn(x) # 注意力x = shortcut + x # 残差连接x = self.norm2(x) # 归一化x = self.mlp(x) # MLPreturn x

class SwinTransformer(nn.Module):

“”" Swin Transformer主干网络。 “”"

def __init__(self, depths=[2, 2, 6, 2], num_heads=[3, 6, 12, 24], embed_dim=96):super().__init__()self.layers = nn.ModuleList([SwinTransformerBlock(dim=embed_dim * 2 ** i, num_heads=num_heads[i]) for i in range(len(depths))]) # 构建每一层def forward(self, x):""" 前向传播 """for layer in self.layers:x = layer(x) # 逐层传递return x

def SwinTransformer_Tiny(weights=‘’):

“”" 创建Swin Transformer Tiny模型 “”"

model = SwinTransformer(depths=[2, 2, 6, 2], num_heads=[3, 6, 12, 24])

if weights:

model.load_state_dict(torch.load(weights)[‘model’]) # 加载权重

return model

代码说明:

Mlp类:实现了一个简单的多层感知机,包含两个线性层和一个激活函数。

WindowAttention类:实现了窗口基础的多头自注意力机制,计算注意力权重并应用相对位置偏置。

SwinTransformerBlock类:构建了Swin Transformer的基本块,包含注意力层和MLP层。

SwinTransformer类:构建了整个Swin Transformer模型,包含多个Swin Transformer块。

SwinTransformer_Tiny函数:用于创建一个小型的Swin Transformer模型,并可选择加载预训练权重。

该代码是Swin Transformer的核心实现,适用于图像处理和计算机视觉任务。

这个程序文件实现了Swin Transformer模型,主要用于计算机视觉任务。Swin Transformer是一种层次化的视觉Transformer,采用了移动窗口机制以提高计算效率。文件中包含多个类和函数,下面对其进行逐一说明。

首先,导入了必要的库,包括PyTorch和一些辅助函数。接着定义了一个多层感知机(Mlp)类,它包含两个全连接层和一个激活函数,支持Dropout以防止过拟合。

接下来,定义了两个函数:window_partition和window_reverse。window_partition将输入特征图划分为多个窗口,方便后续的自注意力计算;而window_reverse则用于将经过处理的窗口合并回原来的特征图。

然后是WindowAttention类,它实现了基于窗口的多头自注意力机制。该类支持相对位置偏置,并且可以处理移动窗口(SW-MSA)和非移动窗口(W-MSA)。在前向传播中,输入特征经过线性变换生成查询、键和值,并计算注意力权重,最后通过线性变换输出结果。

SwinTransformerBlock类是Swin Transformer的基本构建块,包含一个窗口注意力层和一个前馈网络。它支持在窗口内进行自注意力计算,并通过残差连接和层归一化来提高模型的稳定性。

PatchMerging类用于将特征图的补丁合并,以减少特征图的分辨率,同时增加通道数。它在每个阶段的末尾使用,以实现下采样。

BasicLayer类代表Swin Transformer的一个基本层,包含多个Swin Transformer块,并在必要时进行下采样。它计算SW-MSA的注意力掩码,并在每个块中传递输入特征。

PatchEmbed类将输入图像划分为补丁,并通过卷积层将其嵌入到更高维度的特征空间中。它还可以选择性地应用归一化。

SwinTransformer类是整个模型的核心,负责构建整个Swin Transformer网络。它包含多个基本层,并在每个层之间进行特征处理。该类还支持绝对位置嵌入和Dropout。

最后,定义了一个update_weight函数,用于更新模型的权重。SwinTransformer_Tiny函数用于创建一个小型的Swin Transformer模型,并在需要时加载预训练权重。

整体来看,这个文件实现了Swin Transformer的各个组成部分,提供了灵活的构建方式,适用于不同的计算机视觉任务。

10.4 dyhead_prune.py

以下是经过简化和注释的核心代码部分:

import torch

import torch.nn as nn

import torch.nn.functional as F

class DyReLU(nn.Module):

“”“动态ReLU激活函数,能够根据输入动态调整其参数。”“”

def init(self, inp, reduction=4, lambda_a=1.0, use_bias=True):

super(DyReLU, self).init()

self.oup = inp # 输出通道数

self.lambda_a = lambda_a * 2 # 动态调整因子

self.avg_pool = nn.AdaptiveAvgPool2d(1) # 自适应平均池化层

# 确定压缩比例squeeze = inp // reductionself.fc = nn.Sequential(nn.Linear(inp, squeeze), # 全连接层,输入到压缩层nn.ReLU(inplace=True), # ReLU激活nn.Linear(squeeze, self.oup * 2), # 压缩层到输出层h_sigmoid() # 使用h_sigmoid激活)def forward(self, x):"""前向传播函数。"""b, c, h, w = x.size() # 获取输入的批次大小、通道数、高度和宽度y = self.avg_pool(x).view(b, c) # 对输入进行自适应平均池化y = self.fc(y).view(b, self.oup * 2, 1, 1) # 通过全连接层得到动态参数# 从y中分离出动态参数a1, b1 = torch.split(y, self.oup, dim=1)a1 = (a1 - 0.5) * self.lambda_a + 1.0 # 调整a1out = x * a1 + b1 # 计算输出return out # 返回经过动态调整的输出

class DyDCNv2(nn.Module):

“”“带有归一化层的可调变形卷积模块。”“”

def init(self, in_channels, out_channels, stride=1, norm_cfg=dict(type=‘GN’, num_groups=16)):

super().init()

self.conv = ModulatedDeformConv2d(in_channels, out_channels, 3, stride=stride, padding=1) # 可调变形卷积

self.norm = build_norm_layer(norm_cfg, out_channels)[1] if norm_cfg else None # 归一化层

def forward(self, x, offset, mask):"""前向传播函数。"""x = self.conv(x.contiguous(), offset, mask) # 进行卷积操作if self.norm:x = self.norm(x) # 如果有归一化层,则进行归一化return x # 返回卷积后的结果

class DyHeadBlock_Prune(nn.Module):

“”“包含三种类型注意力的DyHead模块。”“”

def init(self, in_channels, norm_type=‘GN’):

super().init()

self.spatial_conv_high = DyDCNv2(in_channels, in_channels) # 高层特征卷积

self.spatial_conv_mid = DyDCNv2(in_channels, in_channels) # 中层特征卷积

self.spatial_conv_low = DyDCNv2(in_channels, in_channels, stride=2) # 低层特征卷积

self.spatial_conv_offset = nn.Conv2d(in_channels, 27, 3, padding=1) # 偏移和掩码卷积

def forward(self, x, level):"""前向传播函数。"""offset_and_mask = self.spatial_conv_offset(x[level]) # 计算偏移和掩码offset = offset_and_mask[:, :18, :, :] # 提取偏移mask = offset_and_mask[:, 18:, :, :].sigmoid() # 提取掩码并应用sigmoidmid_feat = self.spatial_conv_mid(x[level], offset, mask) # 中层特征卷积sum_feat = mid_feat # 初始化总特征# 处理低层特征if level > 0:low_feat = self.spatial_conv_low(x[level - 1], offset, mask)sum_feat += low_feat# 处理高层特征if level < len(x) - 1:high_feat = F.interpolate(self.spatial_conv_high(x[level + 1], offset, mask), size=x[level].shape[-2:], mode='bilinear', align_corners=True)sum_feat += high_featreturn sum_feat # 返回加权后的特征

代码说明:

DyReLU: 这是一个动态的ReLU激活函数,它根据输入动态调整其参数。通过自适应平均池化和全连接层来计算动态参数。

DyDCNv2: 这是一个带有归一化层的可调变形卷积模块。它使用可调变形卷积进行特征提取,并可选择性地应用归一化。

DyHeadBlock_Prune: 这是一个包含多种注意力机制的模块。它通过不同层次的卷积处理输入特征,并计算偏移和掩码以进行变形卷积。

这些模块通常用于计算机视觉任务中,特别是在目标检测和分割等任务中。

这个程序文件 dyhead_prune.py 实现了一个深度学习模块,主要用于动态头(Dynamic Head)模型中的注意力机制。代码使用了 PyTorch 框架,并定义了一些自定义的激活函数和卷积层。以下是对代码的详细讲解。

首先,文件导入了必要的库,包括 PyTorch 的核心库和一些可能来自其他库的功能,如 mmcv 和 mmengine。这些库提供了构建激活层、归一化层以及其他深度学习操作的工具。

接下来,定义了一个 _make_divisible 函数,用于确保输入的数值可以被指定的除数整除,并且不会小于最小值的 90%。这个函数在模型设计中常用于调整通道数,以便于后续的计算。

然后,定义了几个自定义的激活函数类,包括 swish、h_swish 和 h_sigmoid。这些激活函数在深度学习中用于引入非线性特性,帮助模型更好地拟合复杂的数据。

DyReLU 类是一个动态激活函数的实现,支持输入通道的动态调整。它的构造函数中包含多个参数,如输入通道数、缩减比例、是否使用偏置等。forward 方法实现了前向传播逻辑,根据输入的特征图计算输出。

DyDCNv2 类实现了带有归一化层的可调变形卷积(Modulated Deformable Convolution),它能够根据输入特征动态计算偏移量和掩码,从而增强卷积操作的灵活性。

DyHeadBlock_Prune 类是整个模块的核心,结合了多个注意力机制。它的构造函数中初始化了多个卷积层和注意力模块。forward 方法负责计算输入特征的偏移量和掩码,并通过不同的卷积层处理输入特征图,最终输出融合后的特征。

在 DyHeadBlock_Prune 中,使用了不同层次的特征图进行融合,以便在多尺度上捕捉信息。通过计算不同层次特征的加权和,结合动态激活函数,模型能够更好地适应输入数据的变化。

整体来看,这个文件实现了一个复杂的动态头模块,能够在特征提取过程中自适应地调整激活函数和卷积操作,增强了模型的表达能力和灵活性。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式👇🏻