借助Rclone快速从阿里云OSS迁移到AWS S3

本文作者: 封磊

Eclicktech SA | AWS Community Builder DevTool | AWS UGL | 亚马逊云科技云博主

阿里云&InfoQ&CSDN签约作者

概述

随着企业云战略的调整和多云架构的普及,数据迁移成为了一个常见需求。本文将详细介绍如何使用Rclone工具,高效、安全地将数据从阿里云对象存储服务(OSS)迁移到Amazon Web Services的Simple Storage Service(S3)。

Rclone是一个功能强大的命令行工具,支持多种云存储服务之间的数据同步和迁移。它提供了丰富的配置选项、断点续传、并发传输等特性,是进行大规模数据迁移的理想选择。

迁移场景和优势

适用场景

- 企业云战略调整,从阿里云迁移到AWS

- 多云架构部署,需要数据备份和同步

- 成本优化,利用不同云服务商的价格优势

- 合规要求,数据需要存储在特定地区

Rclone优势

- 多云支持: 支持超过40种云存储服务

- 高性能: 支持多线程并发传输

- 断点续传: 网络中断后可继续传输

- 数据完整性: 自动校验文件完整性

- 灵活配置: 丰富的命令行参数和配置选项

- 免费开源: 无需额外的许可费用

目录结构

- 概述

- 迁移场景和优势

- 2.1 适用场景

- 2.2 Rclone优势

- 环境准备

- 3.1 系统要求

- 3.1.1 硬件要求

- 3.1.2 操作系统支持

- 3.1.3 网络要求

- 3.2 安装Rclone

- 3.2.1 Linux系统安装

- 3.2.2 macOS系统安装

- 3.2.3 Windows系统安装

- 3.3 获取访问凭证

- 3.3.1 阿里云OSS访问凭证

- 3.3.2 AWS S3访问凭证

- 3.1 系统要求

- 配置Rclone

- 4.1 配置阿里云OSS

- 4.1.1 交互式配置

- 4.1.2 配置参数说明

- 4.1.3 手动配置文件

- 4.2 配置AWS S3

- 4.2.1 交互式配置

- 4.2.2 配置参数说明

- 4.2.3 手动配置文件

- 4.3 验证配置

- 4.3.1 测试阿里云OSS连接

- 4.3.2 测试AWS S3连接

- 4.1 配置阿里云OSS

- 迁移策略规划

- 5.1 数据评估

- 5.1.1 数据量统计

- 5.2 迁移方案选择

- 5.2.1 方案对比

- 5.3 性能优化配置

- 5.3.1 基础性能参数

- 5.3.2 网络优化配置

- 5.1 数据评估

- 执行数据迁移

- 6.1 基础迁移命令

- 6.1.1 简单复制命令

- 6.1.2 同步命令(推荐)

- 6.2 更多命令

- 6.2.1 镜像命令

- 6.3 高级迁移选项

- 6.3.1 过滤和排除

- 6.3.2 时间过滤

- 6.3.3 大小过滤

- 6.1 基础迁移命令

- 验证

- 7.1 数据完整性验证

- 7.1.1 基础验证命令

- 7.1 数据完整性验证

- 故障排除

- 8.1 常见错误及解决方案

- 8.1.1 连接超时错误

- 8.1.2 权限拒绝错误

- 8.1.3 文件已存在错误

- 8.1.4 内存不足错误

- 8.2 性能问题诊断

- 8.2.1 诊断脚本

- 8.3 网络问题处理

- 8.3.1 网络诊断工具

- 8.3.2 网络优化建议

- 8.1 常见错误及解决方案

- 总结

- 9.1 迁移效果评估

- 9.1.1 技术优势

- 9.1.2 成本效益

- 9.1.3 适用场景总结

- 9.1 迁移效果评估

环境准备

系统要求

硬件要求

- CPU: 建议4核心以上,支持多线程并发传输

- 内存: 最少4GB,推荐8GB以上(大文件传输需要更多内存)

- 存储: 足够的临时存储空间用于缓存和日志

- 网络: 稳定的网络连接,建议带宽100Mbps以上

操作系统支持

- Linux (Ubuntu 18.04+, CentOS 7+, RHEL 7+)

- macOS 10.12+

- Windows 10+

网络要求

- 能够访问阿里云OSS和AWS S3的API端点

- 建议使用专线或VPN连接以提高传输稳定性

- 确保防火墙允许HTTPS (443端口) 出站连接

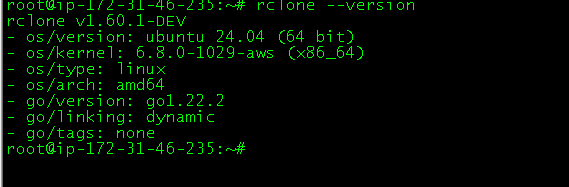

安装Rclone

Linux系统安装

方法1: 官方安装脚本(推荐)

# 下载并安装最新版本的Rclone

curl https://rclone.org/install.sh | sudo bash# 验证安装

rclone version

方法2: 包管理器安装

# Ubuntu/Debian

sudo apt update

sudo apt install rclone# CentOS/RHEL

sudo yum install epel-release

sudo yum install rclone# 或使用dnf (CentOS 8+)

sudo dnf install rclone

方法3: 手动安装

# 下载最新版本

wget https://downloads.rclone.org/rclone-current-linux-amd64.zip# 解压

unzip rclone-current-linux-amd64.zip# 复制到系统路径

sudo cp rclone-*/rclone /usr/local/bin/

sudo chmod +x /usr/local/bin/rclone# 创建配置目录

mkdir -p ~/.config/rclone

macOS系统安装

# 使用Homebrew安装

brew install rclone# 或使用官方脚本

curl https://rclone.org/install.sh | sudo bash

Windows系统安装

- 访问 https://rclone.org/downloads/

- 下载Windows版本的zip文件

- 解压到合适的目录(如 C:\rclone)

- 将rclone.exe所在目录添加到系统PATH环境变量

获取访问凭证

阿里云OSS访问凭证

创建RAM用户

- 登录阿里云控制台,进入RAM管理

- 创建新的RAM用户,选择"编程访问"

- 记录AccessKey ID和AccessKey Secret

设置OSS权限策略【请自行附加到对应的用户上、注意替换存储桶名称】

{"Version": "1","Statement": [{"Effect": "Allow","Action": ["oss:GetObject","oss:PutObject","oss:DeleteObject","oss:ListObjects","oss:GetBucketInfo","oss:GetBucketLocation"],"Resource": ["acs:oss:*:*:your-bucket-name","acs:oss:*:*:your-bucket-name/*"]}]

}

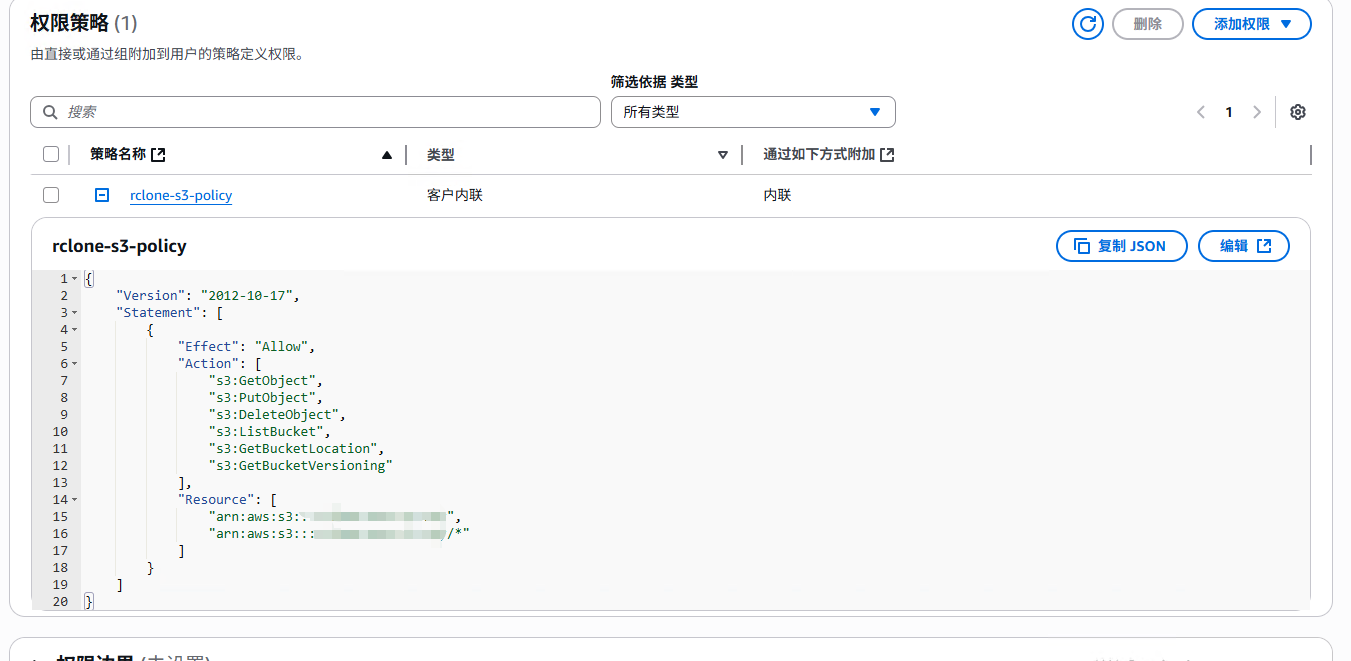

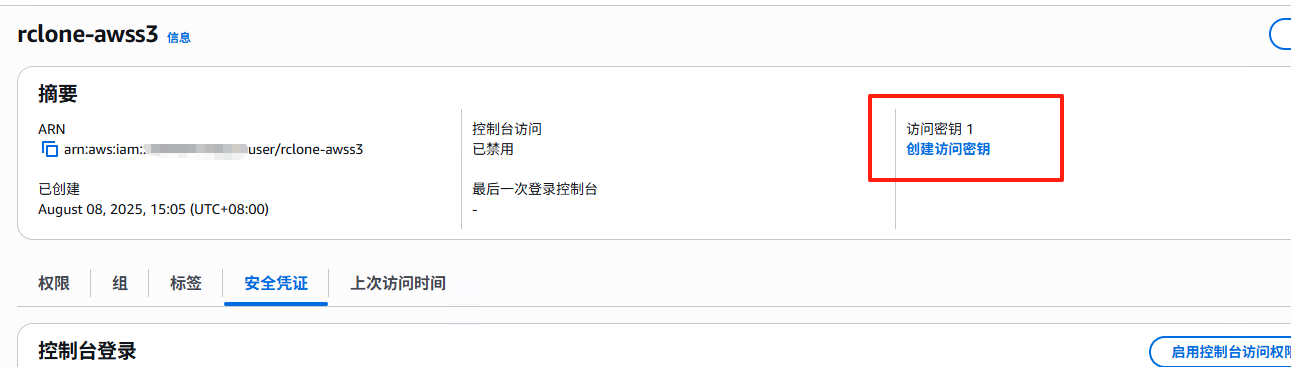

AWS S3访问凭证

创建IAM用户

- 登录AWS控制台,进入IAM服务

- 创建新用户,选择"编程访问"

- 记录Access Key ID和Secret Access Key

设置S3权限策略【注意替换存储桶名称】

{"Version": "2012-10-17","Statement": [{"Effect": "Allow","Action": ["s3:GetObject","s3:PutObject","s3:DeleteObject","s3:ListBucket","s3:GetBucketLocation","s3:GetBucketVersioning"],"Resource": ["arn:aws:s3:::your-bucket-name","arn:aws:s3:::your-bucket-name/*"]}]

}

配置Rclone

配置阿里云OSS

交互式配置

# 启动Rclone配置向导

rclone config# 选择 "n" 创建新的remote

# 输入remote名称,例如: "alioss"

# 选择存储类型: "5" (Alibaba Cloud Object Storage System (OSS))

配置参数说明

Storage> 5 # 选择阿里云OSS

name> alioss # 设置remote名称

provider> Alibaba # 选择Alibaba

env_auth> false # 不使用环境变量认证

access_key_id> YOUR_ACCESS_KEY_ID # 输入AccessKey ID

access_key_secret> YOUR_ACCESS_KEY_SECRET # 输入AccessKey Secret

endpoint> oss-cn-hangzhou.aliyuncs.com # 选择合适的endpoint

acl> private # 设置访问控制列表

storage_class> Standard # 存储类型

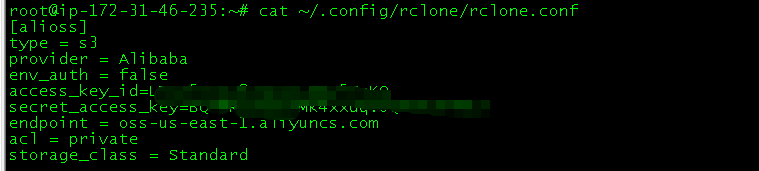

手动配置文件

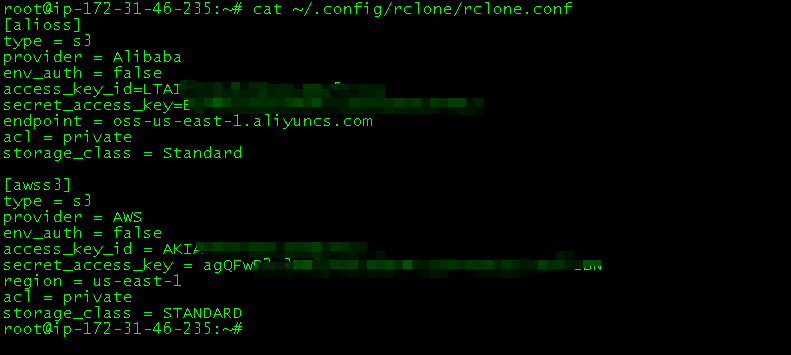

也可以直接编辑配置文件 ~/.config/rclone/rclone.conf:

[alioss]

type = s3

provider = Alibaba

env_auth = false

access_key_id = YOUR_ACCESS_KEY_ID

secret_access_key = YOUR_ACCESS_KEY_SECRET

endpoint = oss-cn-hangzhou.aliyuncs.com

acl = private

storage_class = Standard

配置AWS S3

交互式配置

# 继续在rclone config中添加S3配置

# 选择 "n" 创建新的remote

# 输入remote名称,例如: "awss3"

# 选择存储类型: "4" (Amazon S3 Compliant Storage Providers)

配置参数说明

Storage> 4 # 选择Amazon S3

name> awss3 # 设置remote名称

provider> AWS # 选择AWS

env_auth> false # 不使用环境变量认证

access_key_id> YOUR_AWS_ACCESS_KEY_ID # 输入AWS Access Key ID

secret_access_key> YOUR_AWS_SECRET_ACCESS_KEY # 输入AWS Secret Access Key

region> us-east-1 # 选择AWS区域

endpoint> # 留空使用默认endpoint

location_constraint> us-east-1 # 区域约束

acl> private # 访问控制列表

storage_class> STANDARD # 存储类型

手动配置文件

[awss3]

type = s3

provider = AWS

env_auth = false

access_key_id = YOUR_AWS_ACCESS_KEY_ID

secret_access_key = YOUR_AWS_SECRET_ACCESS_KEY

region = us-east-1

acl = private

storage_class = STANDARD

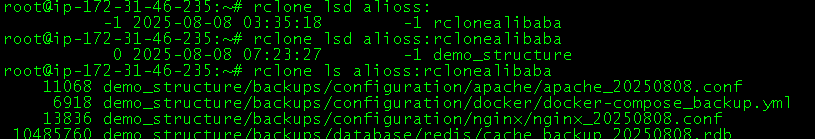

验证配置

测试阿里云OSS连接

# 列出OSS中的存储桶

rclone lsd alioss:# 列出特定存储桶中的文件

rclone ls alioss:your-bucket-name# 检查连接状态

rclone about alioss:your-bucket-name

测试AWS S3连接

# 列出S3中的存储桶

rclone lsd awss3:# 列出特定存储桶中的文件

rclone ls awss3:your-bucket-name# 检查连接状态

rclone about awss3:your-bucket-name

迁移策略规划

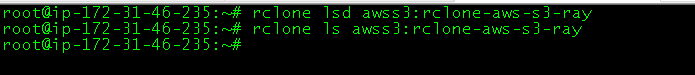

数据评估

数据量统计

# 统计OSS存储桶总大小和文件数量

rclone size alioss:your-bucket-name# 详细统计信息

rclone about alioss:your-bucket-name# 按目录统计

rclone ncdu alioss:your-bucket-name

迁移方案选择

方案对比

| 迁移方案 | 适用场景 | 优点 | 缺点 |

|---|---|---|---|

| 全量同步 | 小规模数据,一次性迁移 | 简单直接 | 时间长,占用带宽 |

| 增量同步 | 大规模数据,持续同步 | 效率高,支持断点续传 | 配置复杂 |

| 分批迁移 | 超大规模数据 | 可控性强,风险分散 | 管理复杂 |

| 并行迁移 | 多个存储桶 | 速度快 | 资源消耗大 |

性能优化配置

基础性能参数

# 创建性能优化配置文件

cat > ~/.config/rclone/rclone.conf.performance << EOF

# 并发传输数

--transfers=10# 检查器数量

--checkers=8# 缓冲区大小

--buffer-size=32M# 使用内存缓存

--use-mmap# 跳过校验和检查(提高速度,但降低安全性)

--ignore-checksum# 重试次数

--retries=3# 重试延迟

--retries-sleep=1s# 超时设置

--timeout=300s

EOF

网络优化配置

# 带宽限制(避免占满带宽)

--bwlimit=80M# TCP保持连接

--s3-no-check-bucket# 禁用SSL验证(仅在内网环境)

--no-check-certificate# 连接超时

--contimeout=60s# 低级别重试

--low-level-retries=10

![性能配置截图]

执行数据迁移

基础迁移命令

简单复制命令

# 基础复制命令

rclone copy alioss:source-bucket awss3:target-bucket# 带进度显示的复制

rclone copy alioss:source-bucket awss3:target-bucket --progress# 详细日志输出

rclone copy alioss:source-bucket awss3:target-bucket -v --log-file=migration.log

同步命令(推荐)

# 同步命令(会删除目标中多余的文件)

rclone sync alioss:source-bucket awss3:target-bucket# 安全同步(先检查差异)

rclone sync alioss:source-bucket awss3:target-bucket --dry-run

rclone sync alioss:source-bucket awss3:target-bucket --interactive

更多命令

镜像命令

# 创建完全镜像

rclone mirror alioss:source-bucket awss3:target-bucket# 保持权限和元数据

rclone copy alioss:source-bucket awss3:target-bucket --preserve-metadata

高级迁移选项

过滤和排除

# 只迁移特定文件类型

rclone copy alioss:source-bucket awss3:target-bucket --include "*.jpg" --include "*.png"# 排除特定文件

rclone copy alioss:source-bucket awss3:target-bucket --exclude "*.tmp" --exclude "*.log"# 使用过滤文件

cat > filter.txt << EOF

+ *.jpg

+ *.png

+ *.pdf

- *.tmp

- *.log

- .DS_Store

EOFrclone copy alioss:source-bucket awss3:target-bucket --filter-from filter.txt

时间过滤

# 只迁移最近30天的文件

rclone copy alioss:source-bucket awss3:target-bucket --max-age 30d# 只迁移指定时间之后的文件

rclone copy alioss:source-bucket awss3:target-bucket --min-age 2023-01-01# 迁移特定时间范围的文件

rclone copy alioss:source-bucket awss3:target-bucket --min-age 2023-01-01 --max-age 2023-12-31

大小过滤

# 只迁移小于100MB的文件

rclone copy alioss:source-bucket awss3:target-bucket --max-size 100M# 只迁移大于1MB的文件

rclone copy alioss:source-bucket awss3:target-bucket --min-size 1M

验证

数据完整性验证

基础验证命令

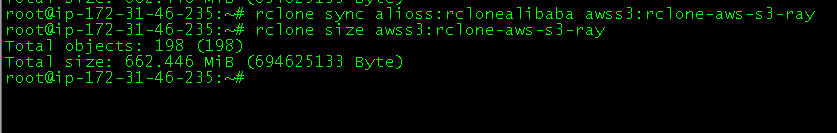

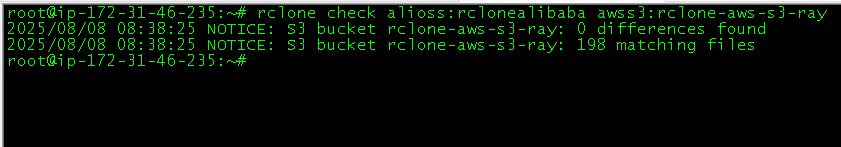

# 检查文件数量和大小是否一致

rclone check alioss:source-bucket awss3:target-bucket# 单向检查(只检查源到目标)

rclone check alioss:source-bucket awss3:target-bucket --one-way# 详细检查报告

rclone check alioss:source-bucket awss3:target-bucket --one-way -v --log-file=check.log

故障排除

常见错误及解决方案

1. 连接超时错误

错误信息: timeout: no response from server

解决方案:

# 增加超时时间和重试次数

rclone copy alioss:source-bucket awss3:target-bucket \--timeout=600s \--contimeout=120s \--retries=5 \--retries-sleep=30s

2. 权限拒绝错误

错误信息: AccessDenied: Access Denied

解决方案:

# 检查IAM权限

aws iam simulate-principal-policy \--policy-source-arn arn:aws:iam::123456789012:user/rclone-user \--action-names s3:PutObject \--resource-arns arn:aws:s3:::target-bucket/*# 验证凭证

rclone config show awss3

3. 文件已存在错误

错误信息: file already exists

解决方案:

# 使用更新模式

rclone copy alioss:source-bucket awss3:target-bucket --update# 或强制覆盖

rclone copy alioss:source-bucket awss3:target-bucket --ignore-existing=false

4. 内存不足错误

错误信息: out of memory

解决方案:

# 减少并发数和缓冲区大小

rclone copy alioss:source-bucket awss3:target-bucket \--transfers=2 \--checkers=1 \--buffer-size=16M

性能问题诊断

诊断脚本

#!/bin/bash

# diagnose_performance.shecho "=== Rclone性能诊断 ==="# 1. 系统资源检查

echo "1. 系统资源状态:"

echo "CPU使用率: $(top -bn1 | grep "Cpu(s)" | awk '{print $2}' | cut -d'%' -f1)"

echo "内存使用: $(free | grep Mem | awk '{printf "%.1f%%", $3/$2 * 100.0}')"

echo "磁盘IO: $(iostat -x 1 1 | tail -n +4 | awk '{print $10}' | tail -1)"# 2. 网络连接测试

echo -e "\n2. 网络连接测试:"

echo "阿里云OSS连接延迟:"

ping -c 3 oss-cn-hangzhou.aliyuncs.com | tail -1 | awk '{print $4}' | cut -d'/' -f2echo "AWS S3连接延迟:"

ping -c 3 s3.amazonaws.com | tail -1 | awk '{print $4}' | cut -d'/' -f2# 3. 带宽测试

echo -e "\n3. 带宽测试:"

echo "测试上传速度到S3..."

dd if=/dev/zero bs=1M count=10 | rclone rcat awss3:test-bucket/speedtest.tmp --stats=0

rclone delete awss3:test-bucket/speedtest.tmp# 4. Rclone配置检查

echo -e "\n4. Rclone配置检查:"

echo "当前transfers设置: $(rclone config show | grep -A 20 '\[awss3\]' | grep transfers || echo '默认值')"

echo "当前checkers设置: $(rclone config show | grep -A 20 '\[awss3\]' | grep checkers || echo '默认值')"# 5. 建议优化

echo -e "\n5. 性能优化建议:"

CPU_CORES=$(nproc)

MEMORY_GB=$(free -g | awk '/^Mem:/{print $2}')if [ $CPU_CORES -gt 4 ]; thenecho "- 可以增加transfers到 $((CPU_CORES * 2))"

fiif [ $MEMORY_GB -gt 8 ]; thenecho "- 可以增加buffer-size到64M"

fiecho "- 考虑使用--fast-list选项加速文件列表"

echo "- 对于大文件,使用--s3-chunk-size=64M"

网络问题处理

网络诊断工具

#!/bin/bash

# network_diagnosis.sh# 检查DNS解析

check_dns() {echo "检查DNS解析..."domains=("oss-cn-hangzhou.aliyuncs.com" "s3.amazonaws.com")for domain in "${domains[@]}"; doif nslookup $domain > /dev/null 2>&1; thenecho "✓ $domain DNS解析正常"elseecho "✗ $domain DNS解析失败"fidone

}# 检查网络连通性

check_connectivity() {echo -e "\n检查网络连通性..."endpoints=("oss-cn-hangzhou.aliyuncs.com:443" "s3.amazonaws.com:443")for endpoint in "${endpoints[@]}"; doif timeout 5 bash -c "</dev/tcp/${endpoint/:/ }" 2>/dev/null; thenecho "✓ $endpoint 连接正常"elseecho "✗ $endpoint 连接失败"fidone

}# 检查防火墙规则

check_firewall() {echo -e "\n检查防火墙规则..."if command -v ufw &> /dev/null; thenecho "UFW状态: $(ufw status | head -1)"elif command -v firewall-cmd &> /dev/null; thenecho "Firewalld状态: $(firewall-cmd --state)"elseecho "未检测到常见防火墙工具"fi

}# 网络质量测试

test_network_quality() {echo -e "\n网络质量测试..."# 测试丢包率echo "测试到阿里云的丢包率:"ping -c 10 oss-cn-hangzhou.aliyuncs.com | tail -2 | head -1echo "测试到AWS的丢包率:"ping -c 10 s3.amazonaws.com | tail -2 | head -1

}# 执行所有检查

check_dns

check_connectivity

check_firewall

test_network_qualityecho -e "\n网络诊断完成"

网络优化建议

#!/bin/bash

# network_optimization.shecho "=== 网络优化建议 ==="# 检查当前网络配置

echo "1. 当前网络配置:"

echo "MTU大小: $(ip link show | grep mtu | head -1 | awk '{print $5}')"

echo "TCP窗口大小: $(cat /proc/sys/net/core/rmem_max)"# 优化建议

echo -e "\n2. 优化建议:"# TCP优化

cat << EOF

临时TCP优化 (需要root权限):

echo 'net.core.rmem_max = 134217728' >> /etc/sysctl.conf

echo 'net.core.wmem_max = 134217728' >> /etc/sysctl.conf

echo 'net.ipv4.tcp_rmem = 4096 87380 134217728' >> /etc/sysctl.conf

echo 'net.ipv4.tcp_wmem = 4096 65536 134217728' >> /etc/sysctl.conf

sysctl -p

EOF# Rclone网络优化参数

echo -e "\n3. Rclone网络优化参数:"

cat << EOF

--contimeout=60s # 连接超时

--timeout=300s # 操作超时

--retries=3 # 重试次数

--retries-sleep=10s # 重试间隔

--low-level-retries=10 # 底层重试

--bwlimit=80M # 带宽限制

EOF

总结

迁移效果评估

通过使用Rclone进行阿里云OSS到AWS S3的数据迁移,我们可以实现:

技术优势

- 高效传输: 支持多线程并发,显著提升传输速度

- 断点续传: 网络中断后可自动恢复,确保大文件传输的可靠性

- 数据完整性: 自动校验文件完整性,确保数据准确性

- 灵活配置: 丰富的参数选项,适应不同的迁移需求

成本效益

- 零软件成本: Rclone是开源免费工具

- 带宽优化: 智能带宽管理,避免影响业务

- 时间节省: 自动化脚本减少人工干预

- 风险控制: 分阶段迁移降低业务风险

适用场景总结

| 数据规模 | 推荐策略 | 预计时间 | 关键配置 |

|---|---|---|---|

| < 10GB | 全量同步 | 1-2小时 | transfers=8, checkers=4 |

| 10GB-100GB | 增量同步 | 4-8小时 | transfers=10, buffer-size=32M |

| 100GB-1TB | 分批迁移 | 1-3天 | transfers=5, 分阶段执行 |

| > 1TB | 并行+分批 | 3-7天 | 多进程并行,专用网络 |

注意: 在实际迁移过程中,请根据具体的业务需求和环境特点,适当调整本文提供的配置参数和脚本内容。建议在生产环境迁移前,先在测试环境中验证所有流程和脚本的有效性。