【第5话:相机模型1】针孔相机、鱼眼相机模型的介绍及其在自动驾驶中的作用及使用方法

相机模型介绍及相机模型在自动驾驶中的作用及使用方法

相机模型是计算机视觉中的核心概念,用于描述真实世界中的点如何投影到图像平面上。在自动驾驶系统中,相机模型用于环境感知,如物体检测和场景理解。下面我将详细介绍针孔相机模型和鱼眼相机模型,然后讨论它们在自动驾驶中的作用及使用方法。

1. 针孔相机模型

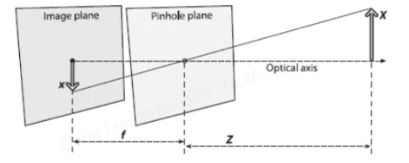

针孔相机模型是最基本的相机模型,基于小孔成像原理。它假设光线通过一个无限小的孔(针孔)投影到成像平面上,形成倒立的图像。这种模型忽略了镜头畸变,适用于理想化场景。

原理:

- 光线从场景中的点通过针孔投射到像平面。

- 投影过程是线性的,使用透视投影方程描述。

- 数学模型涉及齐次坐标和投影矩阵。

数学模型:

- 设世界坐标系中的点为 P=[X,Y,Z,1]⊤\mathbf{P} = [X, Y, Z, 1]^\topP=[X,Y,Z,1]⊤(齐次坐标),相机坐标系中的点为 p=[x,y,z]⊤\mathbf{p} = [x, y, z]^\topp=[x,y,z]⊤。

- 透视投影方程:

p=1ZKP \mathbf{p} = \frac{1}{Z} \mathbf{K} \mathbf{P} p=Z1KP

其中 K\mathbf{K}K 是相机内参矩阵:

K=[fx0cx0fycy001] \mathbf{K} = \begin{bmatrix} f_x & 0 & c_x \\ 0 & f_y & c_y \\ 0 & 0 & 1 \end{bmatrix} K=fx000fy0cxcy1

这里 fxf_xfx 和 fyf_yfy 是焦距(以像素为单位),cxc_xcx 和 cyc_ycy 是主点坐标(图像中心)。 - 图像坐标 (u,v)(u, v)(u,v) 计算为:

u=fxXZ+cx,v=fyYZ+cy u = \frac{f_x X}{Z} + c_x, \quad v = \frac{f_y Y}{Z} + c_y u=ZfxX+cx,v=ZfyY+cy

这表示 uuu 和 vvv 是归一化后的坐标。

优点和缺点:

- 优点:模型简单,计算高效,适用于大多数标准相机和算法。

- 缺点:视野有限(通常小于90度),忽略镜头畸变,导致在广角场景中失真严重。

2. 鱼眼相机模型

鱼眼相机模型是一种广角相机模型,专为捕捉大视野(通常180度或更大)设计。它使用非线性投影来处理镜头畸变,常见于车载相机或监控系统。鱼眼镜头会产生桶形畸变,需要通过数学模型校正。

原理:

- 光线通过鱼眼镜头投射,产生径向畸变(图像边缘弯曲)。

- 投影模型基于角度映射,如等距投影或等立体投影。

- 数学模型包括畸变参数来校正图像。

数学模型:

- 设归一化图像坐标为 (x,y)(x, y)(x,y),实际畸变坐标为 (xd,yd)(x_d, y_d)(xd,yd)。

- 径向畸变模型:

r=x2+y2 r = \sqrt{x^2 + y^2} r=x2+y2

rd=r(1+k1r2+k2r4+k3r6+⋯ ) r_d = r (1 + k_1 r^2 + k_2 r^4 + k_3 r^6 + \cdots) rd=r(1+k1r2+k2r4+k3r6+⋯)

其中 k1,k2,k3k_1, k_2, k_3k1,k2,k3 是畸变系数。 - 畸变坐标计算为:

xd=xrdr,yd=yrdr x_d = x \frac{r_d}{r}, \quad y_d = y \frac{r_d}{r} xd=xrrd,yd=yrrd - 最终图像坐标 (ud,vd)(u_d, v_d)(ud,vd) 通过内参矩阵映射:

[udvd1]=K[xdyd1] \begin{bmatrix} u_d \\ v_d \\ 1 \end{bmatrix} = \mathbf{K} \begin{bmatrix} x_d \\ y_d \\ 1 \end{bmatrix} udvd1=Kxdyd1

这里 K\mathbf{K}K 与针孔模型相同。

优点和缺点:

- 优点:视野广阔(可达180度以上),适合捕捉大范围场景。

- 缺点:畸变严重,需要复杂的校正算法,计算开销较大。

相机模型在自动驾驶中的作用

在自动驾驶系统中,相机模型是环境感知的关键组件,主要用于:

- 环境感知:检测车辆、行人、交通标志和车道线。例如,使用针孔模型进行精确对象定位,鱼眼模型提供全景视野以覆盖盲区。

- 场景理解:结合深度学习模型(如YOLO或SSD)进行语义分割,识别道路结构和障碍物。

- 传感器融合:与激光雷达、雷达和IMU数据融合,提高感知鲁棒性。相机提供丰富的纹理信息,而其他传感器补充深度和运动数据。

- 定位与导航:基于视觉的SLAM(Simultaneous Localization and Mapping)使用相机模型构建环境地图并估计车辆位置。

总体作用:提升自动驾驶的安全性和可靠性,通过实时图像处理实现决策支持。

相机模型在自动驾驶中的使用方法

在自动驾驶应用中,相机模型的使用涉及以下步骤:

-

相机标定:

- 目的:确定相机内参(如焦距 fx,fyf_x, f_yfx,fy、主点 cx,cyc_x, c_ycx,cy)和畸变系数(如 k1,k2k_1, k_2k1,k2)。

- 方法:使用标定板(如棋盘格)采集多张图像,通过优化算法(如OpenCV的

calibrateCamera函数)求解参数。例如,针孔模型标定最小化重投影误差,鱼眼模型额外优化畸变系数。 - 工具:常用OpenCV库实现。代码示例(Python):

import cv2 import numpy as np# 加载标定图像 images = [cv2.imread(f'image_{i}.jpg') for i in range(10)] obj_points = [] # 3D点 img_points = [] # 2D点# 定义棋盘格尺寸 pattern_size = (9, 6) obj_p = np.zeros((pattern_size[0]*pattern_size[1], 3), np.float32) obj_p[:, :2] = np.mgrid[0:pattern_size[0], 0:pattern_size[1]].T.reshape(-1, 2)for img in images:gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)ret, corners = cv2.findChessboardCorners(gray, pattern_size, None)if ret:obj_points.append(obj_p)img_points.append(corners)# 标定相机(针孔模型) ret, K, dist, rvecs, tvecs = cv2.calibrateCamera(obj_points, img_points, gray.shape[::-1], None, None) # 对于鱼眼模型,使用 cv2.fisheye.calibrate

-

畸变校正:

- 目的:消除鱼眼畸变,使图像符合针孔模型,便于后续处理。

- 方法:应用标定得到的参数进行图像变换。针孔模型通常不需要校正,鱼眼模型使用逆畸变映射。

- 工具:OpenCV的

undistort函数。代码示例:# 针孔模型校正(可选) undistorted_img = cv2.undistort(img, K, dist) # 鱼眼模型校正 map1, map2 = cv2.fisheye.initUndistortRectifyMap(K, dist, np.eye(3), K, img.shape[:2], cv2.CV_16SC2) undistorted_img = cv2.remap(img, map1, map2, cv2.INTER_LINEAR)

-

图像处理与感知任务:

- 物体检测:使用校正后的图像输入到神经网络(如CNN)中。例如,YOLO模型检测车辆和行人。

- 特征提取:提取车道线或边缘特征,结合相机模型计算真实世界坐标。例如,从图像坐标 (u,v)(u, v)(u,v) 反投影到3D空间:

[XYZ]=ZK−1[uv1] \begin{bmatrix} X \\ Y \\ Z \end{bmatrix} = Z \mathbf{K}^{-1} \begin{bmatrix} u \\ v \\ 1 \end{bmatrix} XYZ=ZK−1uv1

其中 ZZZ 是估计的深度(来自其他传感器或立体视觉)。 - 实时应用:在自动驾驶系统中,相机模型集成到感知模块,每秒处理多帧图像,输出给规划和控制模块。

-

系统集成:

- 多相机系统:自动驾驶车辆通常使用多个相机(如前视针孔相机、侧视鱼眼相机),覆盖360度视野。通过标定和融合,构建统一的环境模型。

- 挑战与优化:处理动态光照、运动模糊和实时性要求。使用GPU加速和算法优化(如稀疏特征匹配)提高效率。

总结

针孔相机模型简单高效,适合标准视野场景;鱼眼相机模型提供广角覆盖,但需畸变校正。在自动驾驶中,它们通过标定、校正和感知任务实现环境理解。使用方法包括标定参数、校正图像和集成到感知系统。这些模型是自动驾驶视觉感知的基石,结合其他传感器可显著提升系统性能。未来发展方向包括更高效的畸变模型和深度学习融合技术。