linux下非Docker模式部署Xinference并部署Rerank模型

背景:

记上一篇windows环境部署Xinference后尝试在linux下部署,该环境没有GPU,只有CPU。

材料:

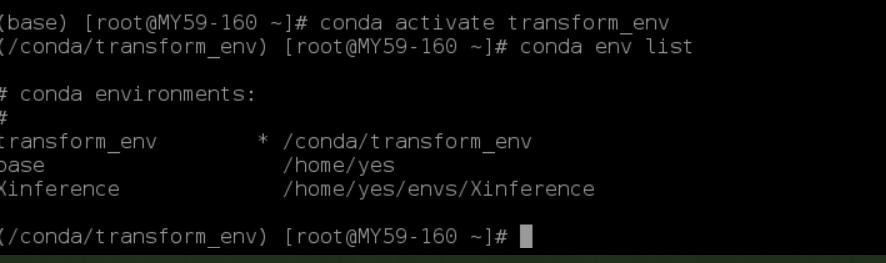

1、运行命令 :conda create -n transform_env python=3.10.18 创建基础环境并制定Python版本。

2、运行命令:conda activate transform_env 激活Xinference环境

3、运行命令:conda env list 查看已创建的虚拟环境,其中带“*”的为当前激活环境

制作:

1、pip install xinference[all]=1.7.0.post1 进行 xinference 的安装。

2、pip show xinference 查看版本

(/conda/transform_env) [root@MY59-160 ~]# pip show xinference

Name: xinference

Version: 1.7.0.post1

Summary: Model Serving Made Easy

Home-page: https://github.com/xorbitsai/inference

Author: Qin Xuye

Author-email: qinxuye@xprobe.io

License: Apache License 2.0

Location: /conda/transform_env/lib/python3.10/site-packages

Requires: aioprometheus, async-timeout, click, fastapi, gradio, huggingface-hub, modelscope, nvidia-ml-py, openai, passlib, peft, pillow, pydantic, pynv

ml, python-jose, requests, setproctitle, sse_starlette, tabulate, timm, torch, tqdm, typing_extensions, uvicorn, xoscar

Required-by: 3、启动xinference(直接启动)

XINFERENCE_MODEL_SRC=modelscope XINFERENCE_HOME='/xinference_model/' xinference-local --host 0.0.0.0 --port 9997解释:1、 XINFERENCE_MODEL_SRC=modelscope 表示模型下载地址为modelscope(阿里)

2、 XINFERENCE_HOME='/xinference_model/' 表示下载的模型在本地的存储路径,如/xinference_model/

4、启动xinference(nohup后台启动)

XINFERENCE_MODEL_SRC=modelscope XINFERENCE_HOME='/xinference_model/' nohup xinference-local --host 0.0.0.0 --port 9997 &> nohup.out &5、启动完成,浏览器访问即可。

注意事项:

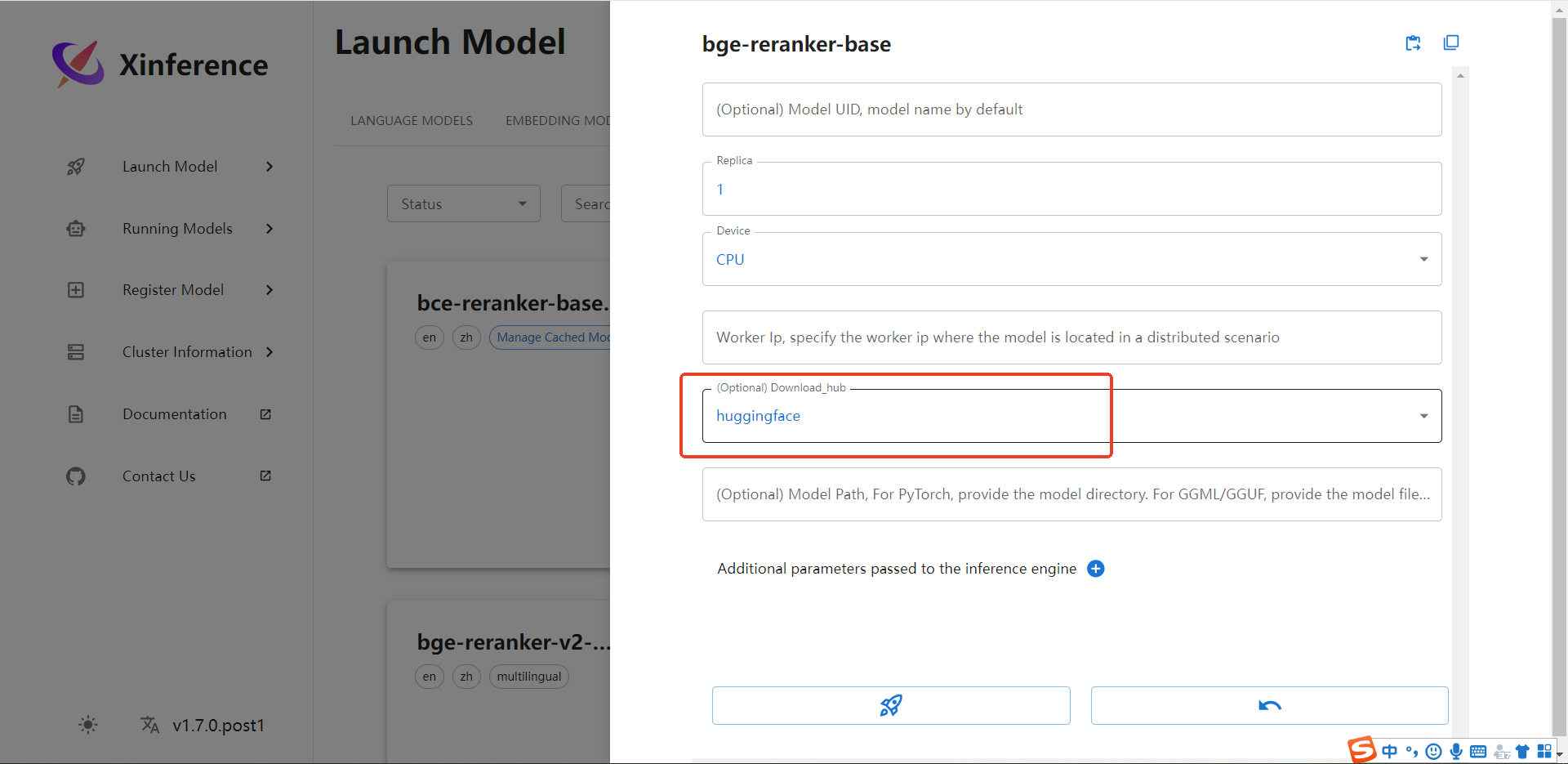

模型无法下载

# 配置模型下载仓库。默认下载源是 “huggingface”,也可以设置为 “modelscope” 作为下载源

XINFERENCE_MODEL_SRC=modelscope (国内),huggingface很大概率拉不到,还有通过页面下载包选择镜像地址并不生效