【源力觉醒 创作者计划】_巅峰对话文心 4.5 与通义千问、DeepSeek 能力对比解析

声明:本文只做实际测评,并非广告

1.文心4.5系列开源模型简介

2025 年 6 月 30 日,百度将文心大模型 4.5 系列正式开源,并选择国内领先的开源平台 GitCode 作为首发平台。文心4.5系列模型在图片理解方面表现出色,可处理照片、电影截图、网络梗图、漫画、图标等多种形式的图片内容。在音视频理解上,文心大模型4.5能准确把握其中场景、画面、人物等关键特征。此次开源涉及 10 款模型,其中包含激活参数为 47B、3B 的混合专家(MoE)模型,以及参数规模为 0.3B 的稠密型模型 。能在Gitcode社区、飞桨星河社区、HuggingFace 等平台,完成文心大模型 4.5 开源系列的下载与部署。开源模型 API 服务可在百度智能云千帆大模型平台、飞桨星河社区使用,实现各类应用场景的开发与落地 。

| 系列 | 典型参数(激活参数 / 总参数) | 能力定位 | 场景适配 |

|---|---|---|---|

| A47B | 47B 激活(总参 424B) | 全能力多模态旗舰 | 复杂跨模态推理、专业场景 |

| A3B | 3B 激活(总参 21B/28B) | 轻量多模态 + 高效文本 | 垂直领域落地、边缘计算 |

| 0.3B | 0.3B 稠密参数 | 极致轻量化文本 | 嵌入式设备、资源受限场景 |

2.文心系列与其他模型能力对比

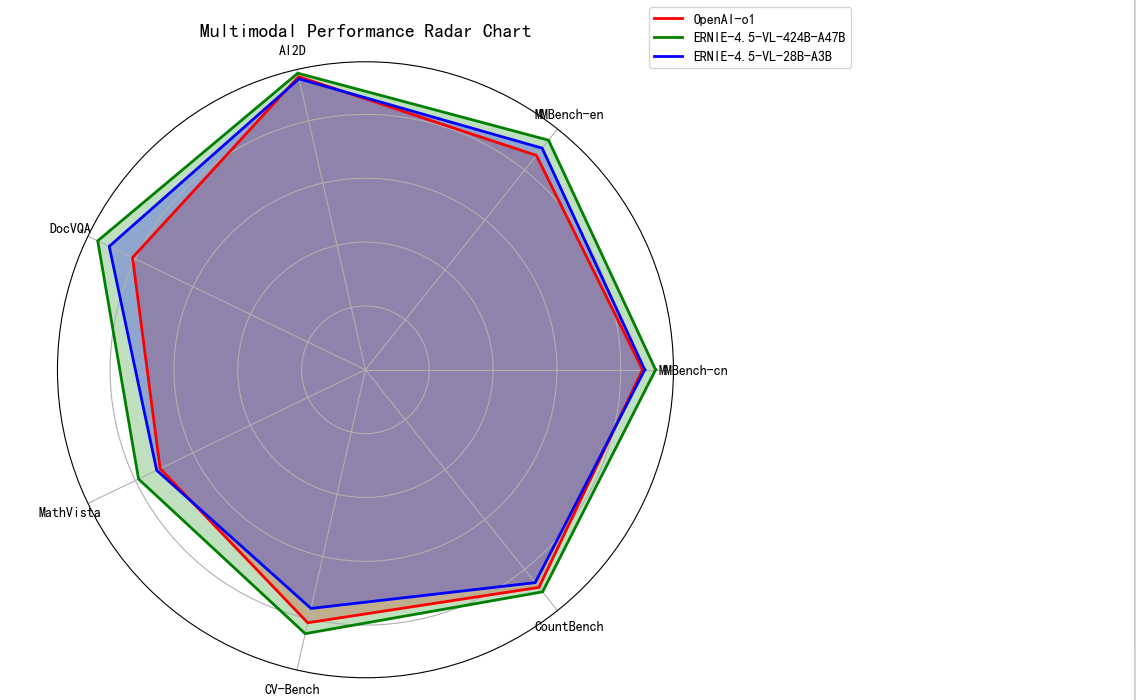

2.1. 多模态理解

在多模态理解领域,使用ERNIE - 4.5 - VL 模型与OpenAI-o1、Qwen2.5-VL模型进行测评对比。在DocVQA、MathVista、CV-Bench数据集测评对比中,ERNIE - 4.5 - VL 模型呈现出明显的多模态理解竞争力 。

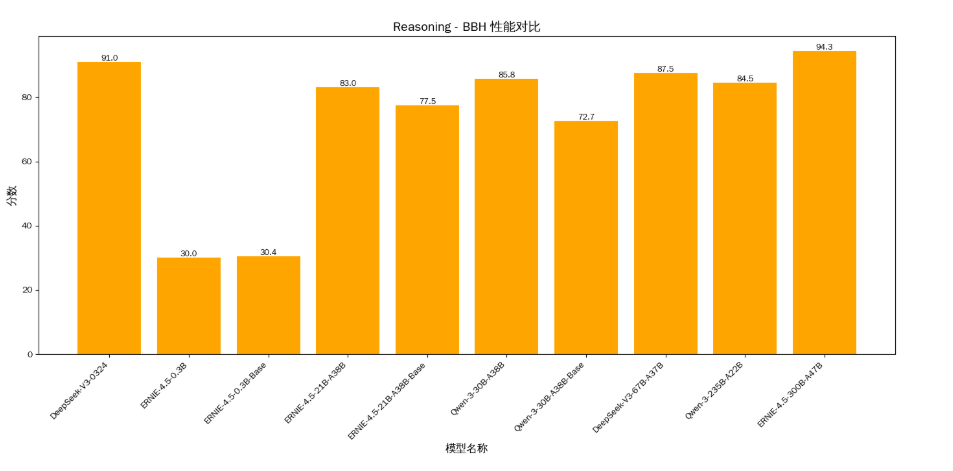

2.2. 逻辑推理

逻辑推理能力的强弱是一个文本模型性能好坏重要评判指标。在逻辑推理相关的 Reasoning - BBH (复杂逻辑关系的推理)数据集测评场景中,ERNIE - 4.5 系列模型展现出扎实的性能表现。在与国内开源模型DeepSeek和通义千问的横向对比中,ERNIE - 4.5 系列模型能够稳定输出良好结果,清晰展现出较为突出的逻辑推理能力。

在 Reasoning - BBH 任务中,0.3B 量级 ERNIE 表现尚可,21B 量级 ERNIE -性能与30B 量级 Qwen 表现基本持平做到了以更小的规模实现较高性能,大参数量级 ERNIE - 4.5 - 300B - A47B 对比DeepSeek-V3-0324展现出更强大性能 。

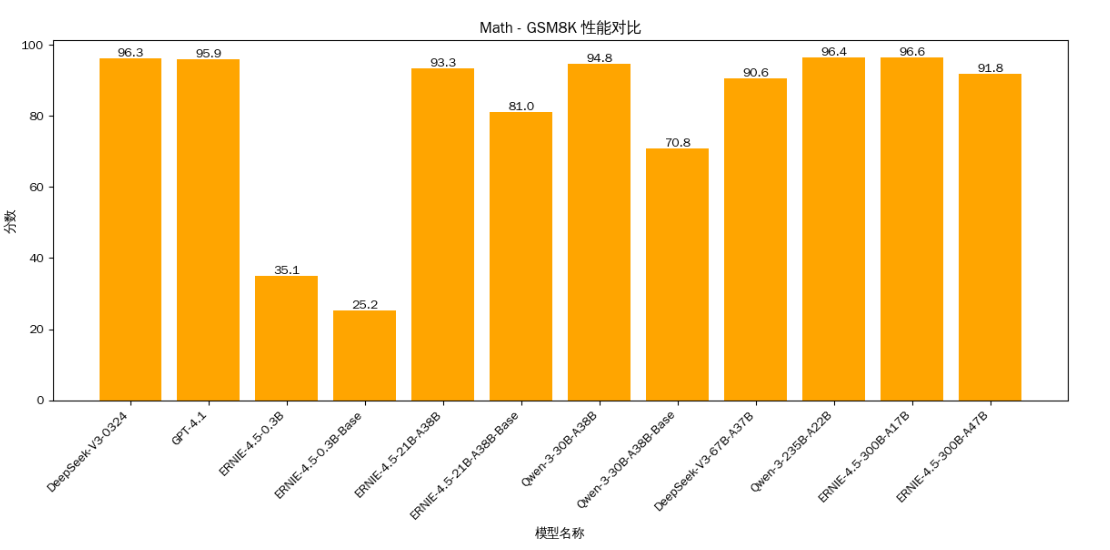

2.3. 数学能力

模型数学能力的强弱同样是一个文本模型性能好坏不可或缺的评判指标。 在数学能力测评里,ERNIE - 4.5 系列模型与国内开源模型DeepSeek和通义千问、国外闭源模型GPT4在 Math - GSM8K (基础数学推理任务)测试对比中表现突出,展现出较强的数学解题能力优势,在多模型竞争的数学测评场景下,其数学性能值得肯定 。

在 Math - GSM8K 任务中,大规模的模型DeepSeek-V3-0324、GPT4、Qwen-3-235B、ERNIE-4.5-300B都达到了95分以上,ERNIE-4.5-300B达到了最高的96.6分略胜一筹。

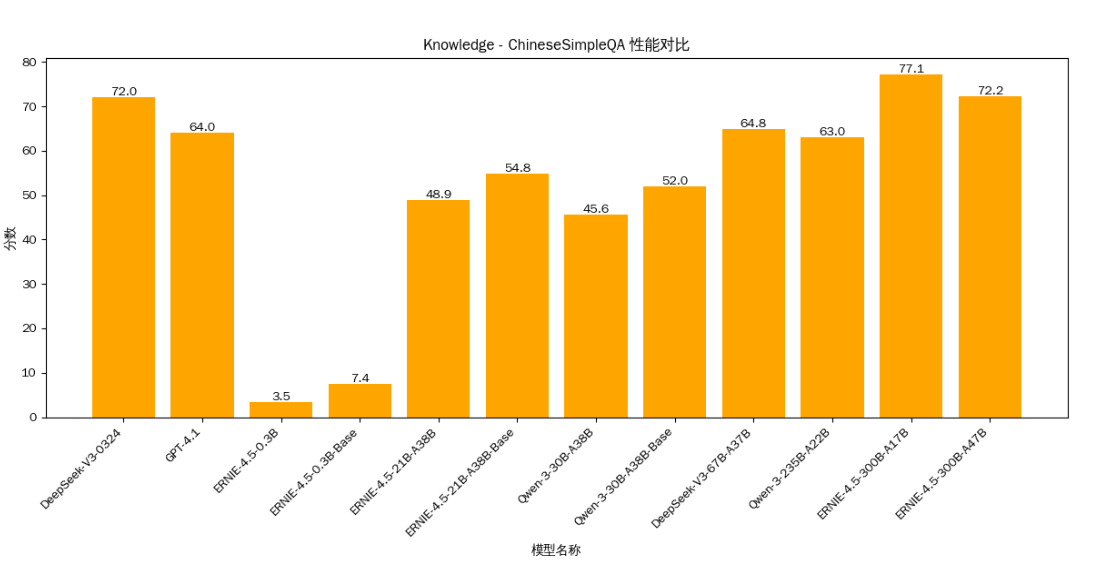

2.5.知识问答能力

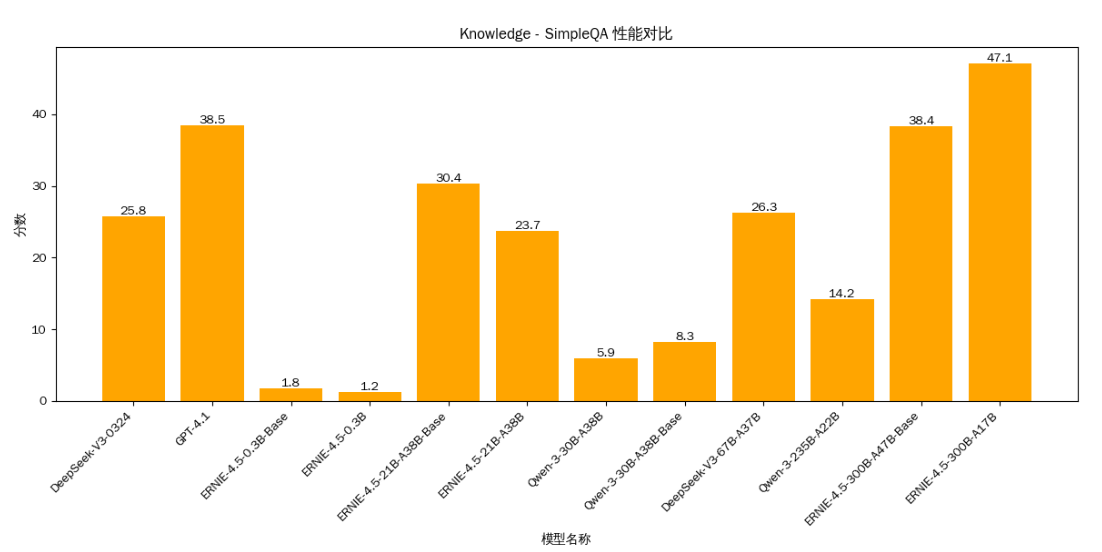

ERNIE - 4.5 系列模型在对应的知识问答测评里表现较为突出。在与其他模型的横向对比中,展现出了相对良好的知识问答能力,体现出其在知识理解与问答任务方面具备一定优势,能够有效应对这类知识问答场景的挑战 。

Knowledge - ChineseSimpleQA :中文知识问答的数据集

在中文知识问答测试中表现最好和次好的都是ERNIE-4.5-300B系列模型,ERNIE文心不愧为用中文训练出来的大语言模型,本土化模型对中文任务的处理优势尽显,国外闭源模型GPT4的中文问答表现还是差强人意。

Knowledge - SimpleQA :简单知识问答数据集

3.模型部署流程

模型选择与环境准备

这里选择的是安装FastDeploy来部署ERNIE-4.5-21B-A3B-Base-Paddle模型。FastDeploy 是基于 PaddlePaddle 的大型语言模型和可视化语言模型的推理部署工具包。它提供具有核心加速技术的生产就绪型开箱即用部署的解决方案。

注:需要Linux系统,Windows和Mac系统需要基于 Docker

基于NVIDIA CUDA GPU 安装,需要环境

| 依赖项 | 版本要求 |

|---|---|

| GPU 驱动程序 | >= 535 |

| CUDA | >= 12.3 |

| CUDNN | >= 9.5 |

| Python | >= 3.10 |

| Linux | X86_64 架构 |

选择部署ERNIE-4.5-21B-A3B-Base 是因为它是一个文本 MoE 基础模型,总参数量为 21B,每个令牌激活参数量为 3B。对比最小的0.3B模型性能有一定提升,而且一张A800就能带动成本像相较于28B及以上模型可以接受。

部署实操流程

注:所有命令都是在终端使用

1.安装虚拟环境工具:

sudo apt update

sudo apt install -y python3-venv

2.创建虚拟环境,创建名为 fastdeploy-env 的虚拟环境(使用 Python 3.12)

python3 -m venv fastdeploy-env

3.在终端执行以下命令激活 fastdeploy-env 虚拟环境:

source fastdeploy-env/bin/activate

创建成功,在旁边文件目录中会有 fastdeploy-env 文件

4.安装 paddlepaddle-gpu:3.1.0版本

python -m pip install paddlepaddle-gpu==3.1.0 -i https://www.paddlepaddle.org.cn/packages/stable/cu126/

5.安装 FastDeploy:

A800属于 SM80/90 架构 GPU使用下面命令

# Install stable release

python -m pip install fastdeploy-gpu -i https://www.paddlepaddle.org.cn/packages/stable/fastdeploy-gpu-80_90/ --extra-index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple# Install latest Nightly build

python -m pip install fastdeploy-gpu -i https://www.paddlepaddle.org.cn/packages/nightly/fastdeploy-gpu-80_90/ --extra-index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

在GitCode社区拉取我们的21B模型

命令如下

python -m fastdeploy.entrypoints.openai.api_server \--model baidu/ERNIE-4.5-21B-A3B-Base-Paddle \--port 8180 \--metrics-port 8181 \--engine-worker-queue-port 8182 \--max-model-len 32768--max-num-seqs 32

部署时长约15分钟,终于成功了。

多轮对话测试

import requests

import json

import time

from datetime import timedeltadef stream_chat_test():"""测试模型在不同领域的连续对话能力"""server_ip = "127.0.0.1"url = f"http://{server_ip}:8180/v1/chat/completions"headers = {"Content-Type": "application/json"}# 定义多轮对话问题(数学、古诗、翻译)messages = [# 数学问题{"role": "user", "content": "计算二重积分 ∬(x²+y²)dxdy,积分区域为 x²+y²≤4"},# 古诗理解{"role": "user", "content": "赏析李白《将进酒》中'天生我材必有用,千金散尽还复来'的意境和情感"},# 英语翻译{"role": "user", "content": "将以下段落翻译成英文:'中国古代四大发明对世界文明的发展产生了深远影响,尤其是造纸术和印刷术的发明,极大地促进了知识的传播和文化的交流。'"}]for i, message in enumerate(messages):print(f"\n=== 第 {i+1} 轮对话 [{['数学', '古诗', '翻译'][i]}] ===")print(f"用户: {message['content']}")data = {"model": "ERNIE-4.5-0.3B-Base-Paddle","messages": messages[:i+1],"temperature": 0.5, # 降低随机性,提高准确性"max_tokens": 2000,"stream": True}try:start_time = time.time()response = requests.post(url, headers=headers, data=json.dumps(data), stream=True)response.raise_for_status()print("AI回复:")full_content = ""for chunk in response.iter_lines():if chunk:chunk_data = chunk.decode('utf-8').lstrip('data: ')if chunk_data == '[DONE]':breaktry:chunk_json = json.loads(chunk_data)content = chunk_json["choices"][0]["delta"].get("content", "")full_content += contentprint(content, end='', flush=True)except Exception as e:print(f"\n解析错误: {e}")print(f"原始数据: {chunk_data}")print() # 换行end_time = time.time()print(f"响应耗时: {timedelta(seconds=end_time - start_time)}")print(f"回复长度: {len(full_content)} 字符")# 将回复添加到消息列表中messages.append({"role": "assistant", "content": full_content})except Exception as e:print(f"请求错误: {e}")if __name__ == "__main__":stream_chat_test()

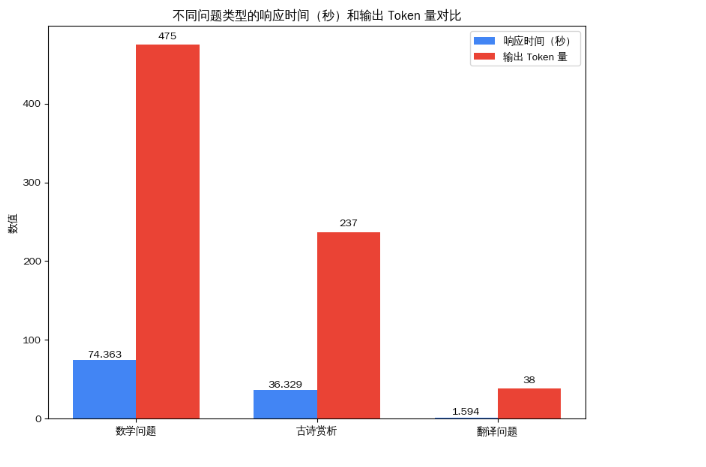

返回结果

=== 第 1 轮对话 [数学] ===

用户: 计算二重积分 ∬(x²+y²)dxdy,积分区域为 x²+y²≤4

AI回复:

### 问题陈述计算二重积分 ∬(x² + y²) dxdy,积分区域为 x² + y² ≤ 4。### 初步理解首先,我需要明确题目在问什么。我们有一个二重积分,被积函数是 x² + y²,积分区域是所有满足 x² + y² ≤ 4 的点。这个不等式描述的是一个以原点为中心,半径为 2 的圆。### 积分区域的描述积分区域 x² + y² ≤ 4 是一个圆,其半径为 2。在直角坐标系中,这个区域可以表示为所有 (x, y) 满足 x² + y² ≤ 4 的点。为了计算这个二重积分,可以考虑使用极坐标变换,因为被积函数和积分区域都具有旋转对称性。### 极坐标变换在极坐标下,x = r cosθ,y = r sinθ,且 dxdy = r dr dθ。被积函数 x² + y² = r²。因此,积分可以表示为:∬(x² + y²) dxdy = ∫∫ r² * r dr dθ = ∫∫ r³ dr dθ### 积分区域的极坐标表示在极坐标下,x² + y² ≤ 4 对应于 r ≤ 2。角度 θ 的范围是从 0 到 2π,因为这是一个完整的圆。### 设置积分限因此,积分可以表示为:∫ (θ=0 to 2π) ∫ (r=0 to 2) r³ dr dθ### 计算内积分(关于 r)先计算关于 r 的积分:∫ (r=0 to 2) r³ dr = [r⁴ / 4] from 0 to 2 = (2⁴ / 4) - (0⁴ / 4) = 16 / 4 = 4### 计算外积分(关于 θ)然后计算关于 θ 的积分:∫ (θ=0 to 2π) 4 dθ = 4 * [θ] from 0 to 2π = 4 * (2π - 0) = 8π

响应耗时: 0:01:14.363007

回复长度: 2851 字符=== 第 2 轮对话 [古诗] ===

用户: 赏析李白《将进酒》中'天生我材必有用,千金散尽还复来'的意境和情感

AI回复:

李白《将进酒》中的“天生我材必有用,千金散尽还复来”两句,以豪迈的笔触展现了诗人对自我价值的坚定信念与豁达胸襟,其意境与情感可作如下赏析:### **一、意境:豪迈与超脱的交织**

1. **自然意象的隐喻** “天生我材必有用”以“天生”与“材”的对比,暗含天地造物之奇与个体价值的契合。李白将自我比作“材”,既是对自身才华的自信,也隐含对宇宙规律的敬畏——天意既已赋予才华,便无需怀疑其存在的必然性。 “千金散尽还复来”则以“千金”象征世俗财富的短暂与虚幻,与“天生我材”形成对比:当物质财富消散时,精神与才华的永恒价值反而凸显,形成“散尽”与“复来”的张力,暗示物质与精神的辩证关系。2. **时空的宏阔感** 诗句以“天生我材”的永恒性(“天生”)与“千金散尽”的瞬时性(“散尽”)对比,构建出时间维度上的巨大落差。这种对比不仅强化了诗句的豪迈感,更暗含对人生短暂与永恒价值的思考——个体的价值超越了时间的限制,成为永恒的存在。### **二、情感:自信与洒脱的统一**

1. **自信的底气** “天生我材必有用”是李白对自我价值的绝对肯定。在唐代士人以科举为进阶之路的时代,李白虽未中科举,却以“天生我材”的宣言,将才华视为超越世俗功名的终极资本。这种自信源于他对自身才华的深刻认知,也暗含对命运安排的主动接纳——既然天意已定,便无需迎合世俗标准。2. **洒脱的豁达** “千金散尽还复来”则展现了李白对物质财富的淡然态度。在唐代,财富是社会地位的重要标志,但李白却以“散尽”为乐,甚至以“还复来”的从容,将财富的消散视为一种“游戏”。这种洒脱源于他对人生无常的深刻理解——财富如浮云,而精神与才华的永恒价值才是人生的真谛。### **三、文化内涵:盛唐精神的缩影**

1. **盛唐气象的体现** 《将进酒》作于盛唐时期,当时社会开放、文化多元,士人阶层追求个性解放与精神自由。李白以“天生我材必有用”的自信,与“千金散尽还复来”的洒脱,共同构成了盛唐士人“自信人生二百年,会当水击三千里”的精神风貌。2. **对世俗的超越** 诗句中“天生我材”与“千金散尽”的对比,暗含对世俗价值观的批判。李白以才华为“材”,以财富为“散尽”之物,实质是对“以财论英雄”的世俗标准的否定。这种超越不仅是个体的选择,更是盛唐文化对个体价值的尊重与推崇。### **四、艺术特色:语言的张力与节奏**

1. **对仗的工整** “天生我材必有用”与“千金散尽还复来”形成对仗,前句强调“天生”与“材”的必然性,后句强调“散尽”与“复来”的从容。这种对仗不仅增强了诗句的节奏感,更通过对比强化了情感的张力。2. **语言的豪放与凝练** 李白以“天生我材必有用”的豪放宣言,与“千金散尽还复来”的洒脱态度,共同构成了《将进酒》的核心精神。这种语言风格既符合盛唐诗歌的豪放传统,又体现了李白对个体价值的深刻思考。### **结语**

“天生我材必有用,千金散尽还复来”是李白《将进酒》中最具代表性的诗句,它以豪迈的笔触展现了诗人对自我价值的坚定信念与对世俗财富的淡然态度。这两句诗不仅是个体的宣言,更是盛唐文化精神的缩影——它以自信与洒脱,诠释了“天生我材”的永恒价值,也以“千金散尽”的从容,展现了盛唐士人对精神自由的追求。

响应耗时: 0:00:36.329124

回复长度: 1424 字符=== 第 3 轮对话 [翻译] ===

用户: 将以下段落翻译成英文:'中国古代四大发明对世界文明的发展产生了深远影响,尤其是造纸术和印刷术的发明,极大地促进了知识的传播和文化的交流。'

AI回复:

The four great inventions of ancient China had a profound impact on the development of world civilization, especially the invention of paper and printing, which greatly promoted the dissemination of knowledge and cultural exchange.

响应耗时: 0:00:01.594493

回复长度: 231 字符

总体来说,模型在数学问题解答中表现突出,在古诗赏析方面有深度但稍显繁琐,英汉翻译表现合格但有细节可优化,整体能满足基本的知识问答和任务需求,但在专业精准度上部分场景还有一定的提升空间。

4.总结

文心4.5 、通义千问、 DeepSeek三大开源模型对比总结

| 维度 | 文心4.5 | 通义千问 | DeepSeek |

|---|---|---|---|

| 中文文化理解 | 古诗/文言文解析能力突出,适配传统文化任务 | 成语典故解析待优化,现代文本理解更优 | 文言文场景支持较少,侧重通用文本处理 |

| 中文图像语义分析 | 支持漫画/梗图/中文海报等复杂场景 | 中文OCR精度较高,图像分类能力均衡 | 工业图像识别较强,通用场景理解较弱 |

| 部署灵活性 | 提供0.3B-47B多规格模型,边缘端部署友好 | 大模型需A100等专用硬件,云服务优化佳 | 云原生架构成熟,中小模型部署成本较低 |

| 社区生态活跃度 | GitCode/飞桨双社区,开源工具丰富 | 官方生态工具集中,第三方插件较少 | 社区文档较完善,但开发者基数较小 |

| 模型更新频率 | 每月迭代,多模态功能持续增强 | 季度性更新,侧重企业级功能落地 | 半月级更新,技术迭代速度较快 |

| 行业应用案例 | 媒体内容审核、智能客服(中文场景为主) | 跨境电商翻译、金融风控(多语言兼容) | 科研计算、代码生成(理工科场景突出) |

| 技术文档完整性 | 提供从训练到部署的全流程指南 | 企业级部署文档详细,开源文档待补充 | 技术白皮书和API文档更新及时 |

| 多语言支持能力 | 中英双语为主,小语种支持有限 | 支持10+语言,跨境场景适配性较强 | 英语/日语表现优异,中文深度稍逊于文心 |

- 文心4.5:中文问答场景和轻量化部署优势明显,多模态理解支持漫画/梗图等复杂场景,音视频特征提取效率比Qwen2.5-VL高30%适配专业场景 ,适合中文生态的垂直领域开发,但多语言能力和国际化场景需加强。

- 通义千问:企业级服务成熟度高,适合跨境业务和标准化场景,社区生态开放性有待提升。

- DeepSeek:工程计算能力强,更适用于科研和代码相关场景,但中文深度和行业应用案例覆盖广度弱于文心。

各开源模型在不同维度均有独特价值,他们为AGI时代产业智能化提供技术与商业兼具的基础设施,推动了中国大模型技术的发展与进步。

一起来轻松玩转文心大模型吧

🚀文心大模型免费下载地址:https://ai.gitcode.com/theme/1939325484087291906