SwinTransformer改进(14):集成MLCA注意力机制的Swin Transformer模型

在计算机视觉领域,注意力机制已成为提升模型性能的重要技术。

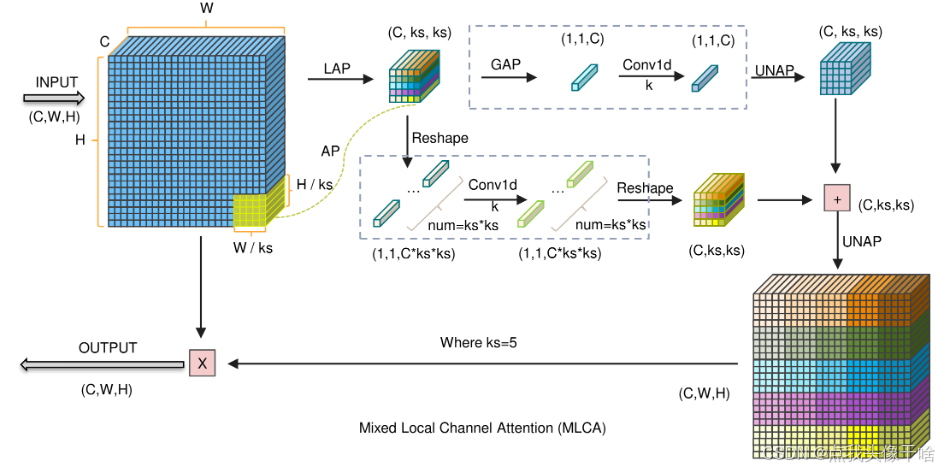

本文将详细解析一个结合了多级通道注意力(MLCA)机制的Swin Transformer模型实现,展示如何通过注意力机制增强视觉模型的性能。

模型概述

这个实现包含两个主要组件:

-

MLCA (Multi-Level Channel Attention):一个轻量级的通道注意力模块

-

SwinWithMLCA:集成了MLCA的Swin Transformer分类模型

MLCA模块详解

MLCA模块是一种高效的通道注意力机制,它通过聚合多级信息来增强特征表示:

class MLCA(nn.Module):def __init__(self, channels, reduction_ratio=16):super(MLCA, self).__init__()self.avg_pool = nn.AdaptiveAvgPool2d(1)self.max_pool = nn.AdaptiveMaxPool2d(1)self.mlp = nn.Sequen