UNet改进(25):集成可变形注意力的高效图像分割方法

可变形注意力机制概述

基本概念

可变形注意力是传统注意力机制的一种扩展,它通过学习输入特征的空间偏移(offset)来动态调整注意力区域,而不是局限于规则的网格采样。这种机制使网络能够更灵活地关注与任务相关的特征区域,尤其适合处理具有复杂几何形状的目标。

与传统注意力的区别

与传统注意力相比,可变形注意力具有以下优势:

-

空间适应性:可以学习输入依赖的空间偏移,适应目标形状

-

计算效率:通常只需要计算局部区域的注意力,而非全局

-

灵活性:可以处理不规则采样模式

可变形注意力模块实现详解

模块结构

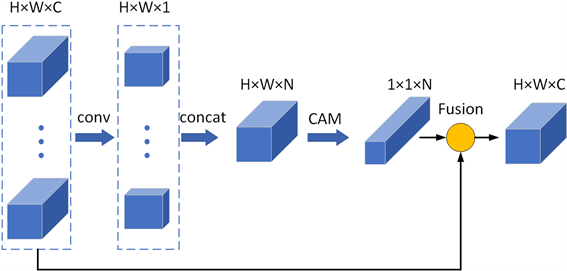

在我们的实现中,可变形注意力模块(DeformableAttention)包含以下几个关键部分:

-

偏移和掩码生成层:

conv_offset_mask -

值投影层: