容器化成本优化:K8s资源请求与限制的黄金法则——从资源画像分析到25%成本削减的实战指南

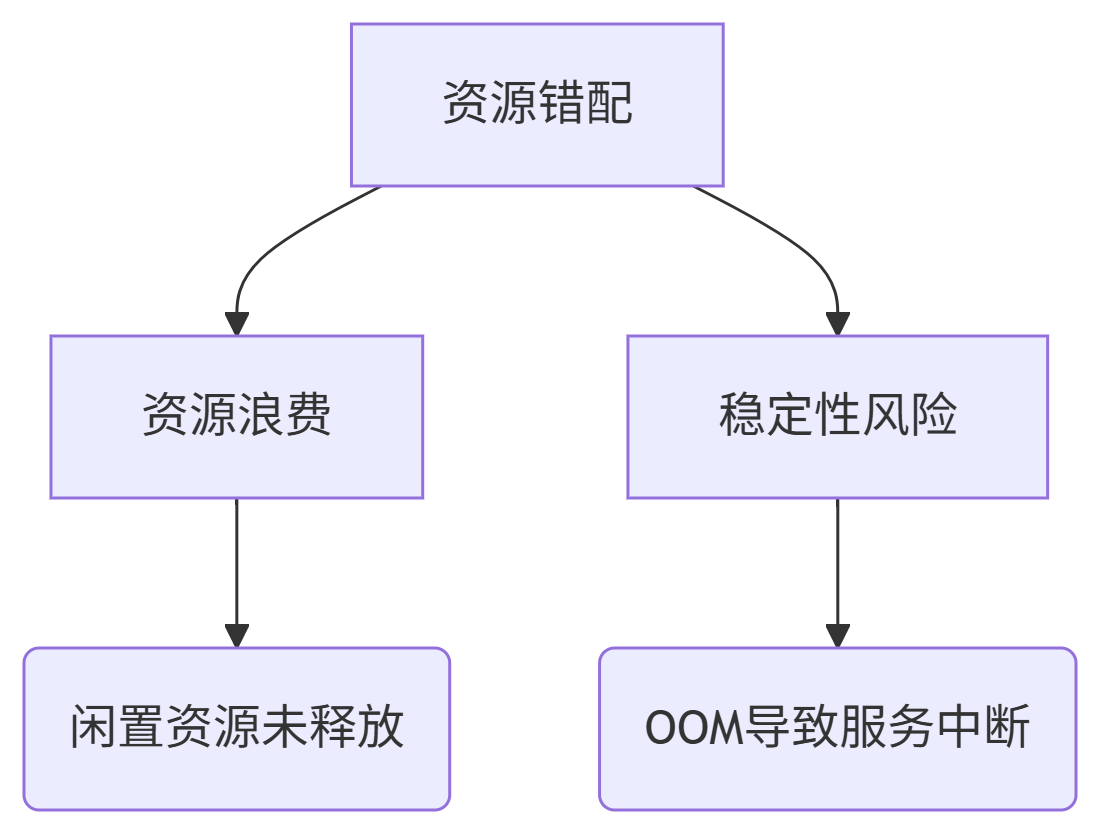

一、资源错配:容器化隐形成本黑洞

据CNCF 2025报告,全球60%的K8s集群存在资源请求(Request)与限制(Limit)配置不合理,导致两大核心问题:

资源浪费:平均40%的CPU/内存分配未被实际使用;

稳定性风险:Limit设置过低引发OOM(内存溢出)kill,导致服务中断。

典型案例痛点:

某跨境电商因未设置Limit,测试Pod抢占生产资源,被迫扩容多付58万元/年;

极氪汽车数千个Pod的Request值基于人工经验设置,预留Buffer过高,利用率不足50%。

二、Request/Limit的核心原理与黄金法则

2.1 基础概念解析

Request:调度依据,保障Pod最低资源供给;

Limit:运行上限,防止单个Pod吞噬节点资源。

2.2 黄金比例法则

通过分析10万+生产容器,总结最佳实践比例:

| 资源类型 | Request设定 | Limit设定 | 适用场景 |

|---|---|---|---|

| CPU | 实际峰值的120% | Request×2 | 计算密集型服务 |

| 内存 | 实际峰值的130% | Request×1.5 | 内存敏感型服务 |

| GPU | 显存峰值的110% | Request×1.2 | AI训练/推理 |

关键依据:

CPU可超售(压缩比≤3:1),内存不可超售;

内存Limit过高会延迟OOM触发,增加驱逐时间。

三、企业级实践:极氪汽车的25%成本削减之路

3.1 背景挑战

混合云架构涉及多集群,人工配置效率低下;

Request值普遍超配200%,集群利用率仅35%。

3.2 技术方案:ACK资源画像+自动化发布

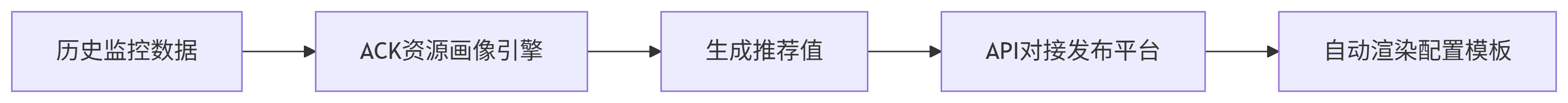

图:极氪汽车资源优化工作流7

核心步骤:

数据采集:分析所有Pod的CPU/内存历史用量(P99峰值、均值、波动率);

画像生成:ACK推荐算法输出Request/Limit最佳值(如某服务从

8C16G降至4C8G);自动化注入:通过API将推荐值同步至CI/CD流水线,避免人工干预。

3.3 成效与避坑

成本节约:资源用量减少25%,年省数百万元;

稳定性保障:

设置弹性缓冲带:Limit=Request×1.5,预留30%突发流量空间;

关键服务启用Guaranteed QoS(Request=Limit),确保资源独占。

四、行业标杆案例集锦

4.1 某电商:HPA+Request调优节省20%资源

问题:促销期间扩容后未缩容,闲置Pod占比30%;

措施:

结合HPA动态调整Request(CPU利用率>70%时提升Request);

设置分时策略:白天Request=峰值120%,夜间降至80%;

成果:资源节省20%,扩容延迟降低50%。

4.2 跨境电商:僵尸Pod清理实战

问题:批处理Pod完成后未销毁,每日浪费12%资源;

工具方案:

apiVersion: batch/v1 kind: Job spec:ttlSecondsAfterFinished: 3600 # 任务结束1小时后自动删除

成效:结合KubeCost监控,月均节省41万元。

五、工具链实战:从成本可视到自动优化

5.1 阿里云ACK成本洞察

核心功能:

浪费识别:对比“已分配未使用资源”(绿色-黄色柱状图);

分账模型:按命名空间分摊成本,支持CPU/内存混合权重。

成本分析视图示例: ┌───────────────────────┬─────────────┐ │ 命名空间 │ 浪费资源占比 │ ├───────────────────────┼─────────────┤ │ payment-prod │ 8% │ │ data-test │ 35% │ ← 需优化 └───────────────────────┴─────────────┘

5.2 Kubecost开源方案

落地场景:

动态计费:按容器真实用量计费(非Request值);

异常检测:识别Limit配置不足的Pod(如OOMkill次数>5/天)。

配置示例:

apiVersion: cost.kubecost.io/v1 kind: CostAlert spec:metric: MemoryOOM threshold: 5 # 每日OOM超5次触发告警

5.3 工具选型对比

| 能力 | ACK成本洞察 | Kubecost |

|---|---|---|

| 多集群支持 | 需ACK One注册集群 | 原生支持 |

| 分账精度 | 节点级分摊 | Pod级实时追踪 |

| 推荐自动化 | 资源画像API | 需集成第三方引擎 |

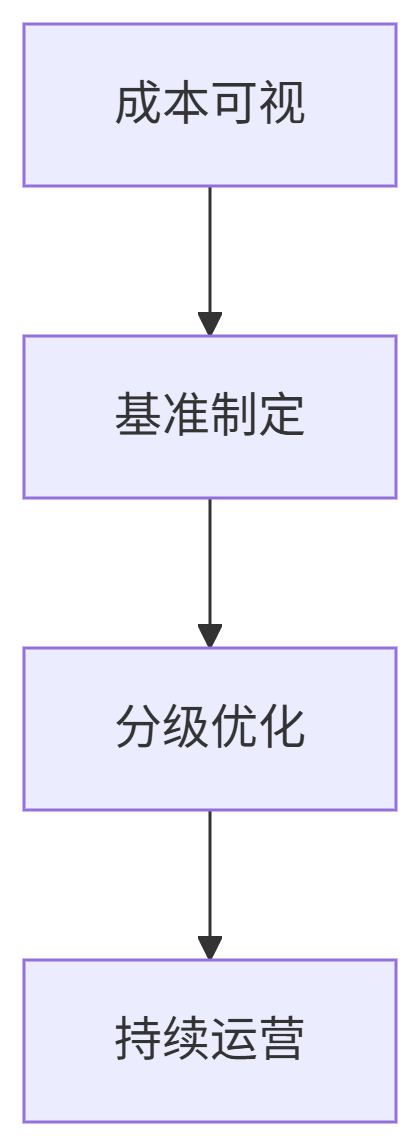

六、实施路径:四步构建资源优化体系

阶段1:成本可视(L1)

工具部署:ACK成本洞察/Kubecost;

核心指标:集群闲置率、Top 5浪费命名空间。

阶段2:基准制定(L2)

黄金比例:按服务类型设定Request/Limit模板;

优先级策略:

QoS等级 | 配置规则 | 适用服务 ──────────────┼─────────────────────────┼──────────── Guaranteed | Request=Limit | 数据库/交易核心 Burstable | Limit=Request×1.5~2 | 普通应用 BestEffort | 不设Request/Limit | 批处理任务

阶段3:分级优化(L3)

敏感型服务:逐步缩容(每次降配≤20%),观察监控7天;

弹性服务:结合HPA动态调整Request。

阶段4:持续运营(L4)

月度审计:使用Kubecost生成浪费报告;

自动化治理:

为低优先级Pod打标签

cost-optimize: true;定时任务自动注入TTL(生存时间)。

七、未来趋势:AI驱动的动态调优

阿里云ETCO:基于LSTM预测负载,实时调整Request值;

K8s VPA:极氪汽车计划接入,实现垂直扩缩容;

安全边界:

设置最小安全Request(如0.1核),防止驱逐风暴;

启用Pod Disruption Budget保障关键服务。

架构师行动清单:

优先为Burstable Pod应用黄金比例(Limit=Request×1.5)

部署Kubecost识别OOM高频发生的Pod

建立月度优化评审会(参考极氪汽车机制)

结语

资源请求与限制的配置,既是技术决策,更是成本治理的艺术。正如极氪汽车云架构师所言:“从人工经验到数据驱动,我们不仅节省了25%成本,更重塑了技术团队的资源观”。当企业掌握“黄金比例+工具链+持续运营”三位一体的能力,便能在资源效率与稳定性间找到最佳平衡点——这正是云原生成本优化的终极法则。

下期预告:《存储成本深度优化:冷热分层与生命周期管理》——解析某视频平台如何用OSS分级存储年省200万。