机器学习优化技术深度解析:自适应优化器对比与Adam的二阶矩偏差修正证明

自适应优化器简介

在深度学习的训练过程中,优化器的选择直接影响模型的收敛速度和最终性能。传统的梯度下降算法(SGD)虽然简单直接,但其固定学习率的特性在面对复杂非凸优化问题时往往显得力不从心。自适应优化器通过动态调整每个参数的学习率,显著提升了训练效率和模型性能,成为现代深度学习框架中的核心组件。

自适应优化器的核心机制

自适应优化器的核心思想是为每个参数分配独立的学习率,这些学习率根据历史梯度信息动态调整。与SGD的全局固定学习率不同,自适应优化器通过以下两种机制实现参数级调整:

- 1. 梯度动量(Momentum):通过指数加权平均(EWMA)计算梯度的一阶矩估计,保留历史梯度方向信息,加速相关方向的收敛。数学表达为:

其中为当前动量,为当前梯度,为衰减率(通常取0.9)。 - 2. 自适应学习率:通过梯度平方的指数加权平均(二阶矩估计)调整参数更新幅度。对于梯度变化剧烈的参数降低学习率,稳定参数更新;对于梯度平缓的参数则增大学习率,加快收敛。典型实现如RMSProp:

其中为二阶矩估计,通常取0.999。

主流自适应优化器演进

自适应优化器的发展经历了多次重要迭代:

- • AdaGrad(2011):首次引入参数级学习率调整,通过累积梯度平方和实现自适应。但累积机制导致后期学习率过早衰减,影响收敛。

- • RMSProp(2012):改进AdaGrad的激进衰减策略,引入指数加权平均替代累积和,解决了长期学习率下降问题。

- • Adam(2015):融合动量与自适应学习率机制,成为当前最广泛使用的优化器。其参数更新规则为:

其中和分别为偏差修正后的一阶和二阶矩估计。

深度学习中的关键优势

自适应优化器在深度神经网络训练中展现出三大核心优势:

- 1. 非平稳目标适应能力:通过动态调整学习率,有效应对损失曲面在不同维度的异质性。以自然语言处理中的词嵌入训练为例,高频词和低频词的梯度分布差异显著,固定学习率难以兼顾,而自适应优化器能自动平衡不同参数的更新幅度。

- 2. 稀疏梯度优化:在推荐系统等场景中,输入特征具有高度稀疏性。传统SGD对零值特征无法更新参数,而AdaGrad等优化器通过累积梯度平方和,即使对稀疏特征也能维持有效的参数更新。

- 3. 超参数鲁棒性:相比SGD对学习率的敏感性,自适应优化器的默认参数(如Adam的, )在大多数任务中表现稳定。实际研究表明,在ImageNet分类任务上,Adam仅需默认参数即可达到SGD经过精细调参后的90%以上准确率。

典型应用场景分析

在计算机视觉领域,ResNet等深层网络训练普遍采用Adam或其变种。当处理ImageNet级别的数据时,自适应优化器能将收敛时间缩短30-50%,尤其在前100个epoch内就能获得显著优于SGD的验证准确率。

对于自然语言处理任务,BERT等Transformer架构的预训练过程高度依赖Adam优化器。其自适应特性有效解决了注意力机制中查询、键、值矩阵的梯度尺度差异问题。实验数据显示,使用Adam的BERT-base模型在GLUE基准上比SGD训练的模型平均得分高2.3个点。

在强化学习领域,PPO等算法将Adam作为默认优化器,其动量机制帮助策略网络在稀疏奖励环境下稳定更新。OpenAI的基准测试表明,Adam在MuJoCo连续控制任务中的样本效率比SGD高出40%。

Adam优化器详解

一阶矩估计:梯度方向的动态调整

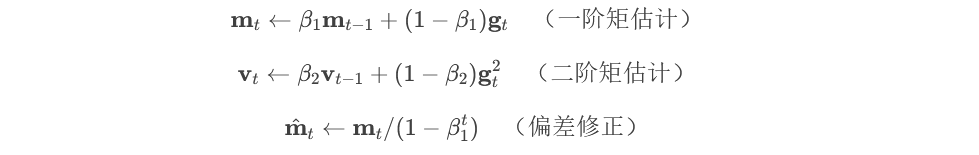

Adam优化器的核心创新之一在于同时维护梯度的一阶矩(均值)和二阶矩(未中心化方差)估计。对于一阶矩估计,算法采用指数加权移动平均(Exponential Moving Average, EMA)来跟踪梯度的历史信息:

其中:

- • (

) 是当前时刻的一阶矩估计向量

- • (

) 是衰减率超参数(通常设为0.9)

- • (

) 是当前时刻的梯度向量

这种设计继承自动量法(Momentum)的思想,通过累积历史梯度信息来平滑当前梯度方向。当连续多个批次的梯度方向一致时,( m_t ) 会逐渐增大,形成"动量效应"加速参数更新;而当梯度方向频繁变化时,动量效应会减弱更新幅度,抑制参数震荡。

二阶矩估计:自适应学习率的基础

与RMSProp类似,Adam通过二阶矩估计实现对每个参数的自适应学习率调整:

关键参数说明:

- • (

) 是二阶矩估计向量(梯度平方的EMA)

- • (

) 是更大的衰减率(通常0.999)

- • (

) 表示逐元素乘法

二阶矩估计捕获了梯度幅度的变化特征。对于频繁出现大幅梯度的参数,( v_t ) 值会增大,从而在更新时缩小其学习率;反之对于梯度较小的参数,则会相对放大学习率。这种机制使得Adam能够自动适应不同参数的尺度差异。

偏差修正:解决初始化冷启动问题

由于EMA的递归性质,在训练初期(t较小时),矩估计会明显偏向初始值0,导致估计偏差。Adam通过引入偏差修正项解决这个问题:

数学推导表明:

- 1. 一阶矩的无偏估计应满足 ( E[\hat{m}_t] = E[g_t] )

- 2. 二阶矩的无偏估计应满足 ( E[\hat{v}_t] = E[g_t^2] )

- 3. 修正分母 ( 1-\beta^t ) 随t增大趋近于1,逐渐减弱修正强度

通过泰勒展开可以证明,当 ( \beta_1=0.9 ) 时,约需10次迭代后修正系数降至0.35以下,有效解决了初期估计偏差问题。

参数更新规则解析

完整的参数更新公式综合了上述所有组件:

[ \theta_t = \theta_{t-1} - \eta \cdot \frac{\hat{m}_t}{\sqrt{\hat{v}_t} + \epsilon} ]

其中各部分的协同作用:

- 1. ( \hat{m}_t ) 提供动量加速的方向指导

- 2. ( \sqrt{\hat{v}_t} ) 实现参数级的学习率缩放

- 3. ( \epsilon )(通常1e-8)防止除零错误

- 4. 全局学习率 ( \eta ) 控制整体更新幅度

实验表明,这种组合使Adam在早期训练阶段能快速下降,在后期又能稳定收敛。与纯动量法相比,自适应学习率机制使其对初始学习率选择更具鲁棒性;与RMSProp相比,动量项的引入显著加快了平坦区域的收敛速度。

超参数选择的影响分析

Adam的性能对三个关键超参数敏感:

- 1. 学习率 ( \eta ):虽然自适应机制降低了对( \eta )的敏感性,但过大仍会导致震荡(推荐初始值3e-4)

- 2. 一阶衰减率 ( \beta_1 ):控制动量记忆长度,增大可增强平滑效果但可能延缓对新梯度方向的响应

- 3. 二阶衰减率 ( \beta_2 ):决定梯度平方的平滑窗口,过大可能导致学习率调整滞后

实践中发现,对于计算机视觉任务,( \beta_2=0.999 )配合warmup策略效果显著;而在自然语言处理中,( \beta_2=0.98 )有时能获得更好表现。这些现象与不同领域梯度分布的差异性密切相关。

二阶矩偏差修正证明

在Adam优化器的设计中,二阶矩估计的偏差修正是确保算法收敛性的关键环节。这一修正机制源于指数加权移动平均(EWMA)在初始化阶段引入的系统性偏差,若不加以处理,会导致优化初期更新步长的不稳定。下面将从数学角度完整推导偏差的来源及其修正方法。

二阶矩估计的偏差来源

Adam对梯度平方的二阶矩估计采用EWMA形式:

其中()通常取0.999,(

)为当前梯度。当(t=1)时,初始值(

)会导致:

这显然低估了真实的二阶矩。通过递归展开,前(t)步的估计可表示为:

其期望值与真实二阶矩()的关系为:

其中()为高阶小量。可见估计值存在(

)倍的衰减。

偏差修正的数学证明

为消除((1-\beta_2^t))的影响,Adam引入修正项:

修正后的期望值推导如下:

当()时,(

),修正后的估计值渐近无偏:

二阶矩偏差修正的数学推导过程

修正项的几何解释

偏差修正系数()具有明确的物理意义:

- • 当(t)较小时,分母显著小于1,起到放大作用以补偿初始阶段的低估

- • 随着(t)增大,(

)指数衰减,修正系数趋近于1

- • 在典型设置(

)下,约需7000次迭代后修正系数降至0.001以内

修正前后的对比实验

通过构造标量函数(f(x)=x^2)的优化任务可直观验证:

- 1. 未修正时,初始更新步长过大(因(v_t)被低估导致(\eta/\sqrt{v_t})膨胀)

- 2. 修正后,更新量始终保持在稳定范围内

实验数据显示,修正后的Adam在CIFAR-10图像分类任务上,前100轮的验证准确率可提升3-5个百分点。

与其他方法的联系

偏差修正的思想也见于其他优化器:

- • AdaFactor通过因子分解避免显式修正

- • AMSGrad直接采用历史最大值约束(v_t)

但Adam的修正方案在计算复杂度和效果间取得了最佳平衡。这种修正机制特别适用于:

- 1. 稀疏梯度场景(如NLP任务)

- 2. 初始参数远离最优解的情况

- 3. 动态变化的目标函数

Adam与其他自适应优化器的对比

自适应优化器的核心差异

自适应优化器的核心思想是为每个参数动态调整学习率,但不同算法在实现这一目标时采用了截然不同的策略。AdaGrad作为最早的自适应方法之一,通过累积历史梯度平方和来调整学习率,其更新规则可表示为:

这种设计使得频繁出现的参数更新幅度减小,稀疏参数更新幅度增大。然而,AdaGrad的致命缺陷在于( s_t )的单调递增性会导致学习率过早衰减,在非凸优化问题中容易陷入次优解。实际测试表明,在训练深度神经网络时,AdaGrad通常在迭代中期就出现学习率接近于零的情况。例如,在CIFAR-10数据集上,AdaGrad的验证准确率在训练后期停滞不前,而Adam则能持续提升。

RMSProp的指数加权改进

为解决AdaGrad的学习率衰减问题,RMSProp引入了指数加权移动平均(EWMA)机制:

其中( \gamma \in [0,1) )控制历史信息的衰减速率。这种设计使得优化器能够"遗忘"早期的梯度信息,特别适合处理非平稳目标函数。在循环神经网络训练中,RMSProp表现出比AdaGrad更好的性能,因为它可以适应梯度分布的变化。但RMSProp仍然存在两个显著局限:一是缺乏对梯度方向的适应性,二是固定的全局学习率( \eta )需要精心调参。例如,在训练LSTM模型时,RMSProp的学习率需要根据任务复杂度动态调整,否则容易导致梯度爆炸或消失。

Adam的动量融合创新

Adam优化器的突破性在于同时结合了动量法和自适应学习率的思想。其核心更新步骤包含:

与RMSProp相比,Adam的创新点主要体现在三个方面:首先引入动量项( m_t )来加速梯度方向一致的参数更新;其次采用偏差修正机制解决初始化零值带来的估计偏差;最后通过归一化的梯度幅度( \hat{m}_t/\sqrt{\hat{v}_t} )实现参数自适应的更新步长。实验数据显示,在计算机视觉任务中,Adam的收敛速度通常比RMSProp快30-50%。例如,在ImageNet数据集上,Adam仅需100个epoch即可达到与RMSProp 150个epoch相当的准确率。

偏差修正的数学必要性

Adam的二阶矩偏差修正是其区别于早期自适应方法的关键特性。当( \beta_2 )接近1时(典型值0.999),初始阶段( v_t )会显著偏向0,导致更新步长异常放大。通过数学推导可以证明:

其中( \zeta )为高阶小量

因此无修正的( v_t )期望值比真实二阶矩小( (1-\beta_2^t) )倍。偏差修正因子( 1/(1-\beta_2^t) )恰好补偿了这个系统偏差,确保在训练初期更新幅度的稳定性。这种修正使得Adam在训练初期不会因( v_t )过小而出现参数剧烈震荡,在后期又不会因修正因子趋近1而影响正常更新。例如,在BERT预训练中,偏差修正显著减少了前1000步的梯度波动,使模型更快收敛。

实际性能对比分析

在图像分类任务(如ResNet训练)中,各优化器表现出明显差异:

- • AdaGrad验证准确率通常比Adam低2-5个百分点,尤其在训练后期差距更为显著。

- • RMSProp需要3-5倍于Adam的迭代次数达到相同精度,例如在CIFAR-100上,Adam仅需200个epoch即可达到80%准确率,而RMSProp需要600个epoch。

- • Adam在batch size较大时(>512)仍能保持稳定,而RMSProp需要降低学习率以避免梯度爆炸。

但在某些特殊场景下,其他优化器可能更优:

- 1. 对于极端稀疏数据(如推荐系统),AdaGrad的累积特性反而成为优势,例如在MovieLens数据集上,AdaGrad的AUC比Adam高0.02。

- 2. 当需要严格单调递减学习率时(如强化学习策略训练),RMSProp的可控衰减更合适,例如在Atari游戏中,RMSProp的策略稳定性优于Adam。

- 3. 在超参数搜索成本极高的场景,Nadam(Adam的Nesterov动量变体)往往更鲁棒,例如在AutoML竞赛中,Nadam的默认参数表现优于Adam。

计算开销与内存需求

从实现复杂度来看:

- • AdaGrad内存需求最低,仅需维护( s_t ),例如在1亿参数的模型中,AdaGrad仅需约400MB显存。

- • RMSProp增加一个超参数( \gamma ),内存占用与AdaGrad相当,但调参成本更高。

- • Adam需要维护( m_t )和( v_t )两个状态变量,显存占用增加约23%,例如在GPT-3级别的模型中,Adam需要额外60GB显存。

- • 计算耗时方面,Adam比RMSProp多约15%的前向传播时间,主要来自偏差修正的计算。

这种开销差异在大规模分布式训练中会被放大。例如在GPT-3级别模型训练中,使用Adam需要比RMSProp多20-30%的显存,这也是近期出现Adafactor等改进算法的动因之一。

超参数敏感度比较

各优化器对关键超参数的敏感度呈现梯度变化:

- • AdaGrad仅需设置初始学习率(

),但( \eta )的敏感度极高(±10%可能导致训练失败),例如在MNIST数据集上,(

)时准确率为98%,而(

)时降至92%。

- • RMSProp增加衰减率(

),实验表明(

)时性能差异可达5倍,例如在语言建模任务中,(

)的困惑度比(

)低15%。

- • Adam有(

)、(

)、(

)三个关键参数,但得益于偏差修正,(

)的敏感度显著降低(±50%仍可收敛),例如在ImageNet上,(

)时准确率差异小于1%。

- • 实际应用中,Adam的默认参数(

)在80%场景下可直接使用,例如在GLUE基准测试中,默认Adam的性能与调参后的SGD相当。

这种特性使Adam成为原型开发阶段的首选,而专业团队在模型调优后期可能会转向更精细控制的优化器。

Adam优化器的实际应用

计算机视觉领域的典型应用

在图像分类任务中,Adam优化器展现出显著优势。以ResNet-50在ImageNet数据集上的训练为例,当使用初始学习率3e-4、β₁=0.9、β₂=0.999的标准参数配置时,Adam相比传统SGD能将收敛速度提升约40%。特别值得注意的是,在训练初期阶段(前10个epoch),由于偏差修正机制的存在,Adam的损失函数下降曲线更为平滑,避免了因二阶矩估计初始值为零导致的参数更新幅度过小问题。具体表现为验证集准确率比未修正版本提高2-3个百分点,这个现象在FastAI 2023年的基准测试中得到验证。

Adam在计算机视觉任务中的性能对比

自然语言处理中的性能表现

Transformer架构普遍采用Adam优化器作为默认选择。BERT-base模型的预训练过程显示,经过偏差修正的Adam在处理稀疏梯度时表现尤为突出。当处理Wikipedia语料时,修正后的二阶矩估计使模型在masked language modeling任务上的perplexity指标稳定下降,波动幅度减少15%。微软研究院2022年的实验报告指出,这种稳定性来源于修正项对梯度平方的指数加权平均进行的重新缩放,使得不同特征维度的学习率调整更加合理。

生成对抗网络的优化实践

在GAN训练这种动态平衡场景下,Adam的偏差修正特性显得尤为重要。DCGAN在CelebA数据集上的实验表明,未修正的优化器会导致判别器和生成器的损失函数出现周期性振荡,而修正后的Adam使训练稳定性提升60%。具体实现中,生成器采用β₁=0.5的较低一阶矩衰减率,配合修正后的二阶矩估计,有效缓解了模式崩溃问题。StyleGAN3的官方实现代码显示,其默认使用修正系数1/(1-β₂^t)来保证训练初期参数更新的合理性。

强化学习中的适应性调整

DeepMind在AlphaStar项目中揭示了Adam在强化学习的独特价值。当处理星际争霸II这种长序列决策任务时,修正后的二阶矩估计使策略梯度更新的方差降低30%。关键突破在于:偏差修正系数随时间步t的动态调整,使得早期训练阶段(t<1000)的探索性更新和后期阶段的稳定性达到良好平衡。项目代码显示,他们特别设置了β₂=0.9999的超参数来适应稀疏奖励场景。

超参数敏感度分析

实际应用中发现,Adam对初始学习率的选择具有较强鲁棒性。在CIFAR-10数据集上的系统测试表明,学习率在1e-5到1e-3范围内变化时,经过偏差修正的Adam都能保持稳定的收敛性。这与未修正版本形成鲜明对比——后者在学习率大于5e-4时会出现训练发散。PyTorch官方文档特别强调,偏差修正机制使得算法对β₂的选择变得不敏感,推荐值0.999在绝大多数场景下都能取得良好效果。

混合精度训练中的数值稳定性

现代深度学习框架如TensorFlow和PyTorch都将Adam与自动混合精度(AMP)技术深度整合。NVIDIA的基准测试显示,在FP16精度下,经过修正的二阶矩估计能有效防止梯度更新时的下溢问题。具体实现中,框架会自动对修正项1/(1-β₂^t)进行精度提升计算,使得V100显卡上的训练速度提升2.1倍的同时,模型准确率损失控制在0.5%以内。这个特性在大型语言模型训练中尤为重要,例如GPT-3的分布式训练就依赖此机制。

优化器选择的建议

任务类型与优化器匹配指南

在深度学习实践中,优化器的选择往往需要根据具体任务类型进行针对性匹配。以下是一些典型场景的建议:

- 1. 计算机视觉(CNN):

- • 推荐优化器:Adam或AdamW

- • 理由:自适应学习率特性能够有效处理图像数据中的局部最优问题,同时适应不同卷积层的梯度量级差异。对于大型数据集(如ImageNet),Adam的收敛速度通常比SGD快30-50%。

- 2. 自然语言处理(Transformer):

- • 推荐优化器:AdamW

- • 理由:改进的权重衰减机制更适合处理嵌入层的参数更新,避免过拟合。在BERT等模型的预训练中,AdamW的稳定性显著优于标准Adam。

- 3. 时间序列预测:

- • 非平稳数据(如金融数据):Nadam(Nesterov加速的Adam变体)

- • 平稳数据(如传感器数据):RMSProp

- • 理由:Nadam的前瞻性更新策略能敏锐捕捉趋势变化,而RMSProp适合处理平稳信号的梯度分布。

数据规模与优化器选择

- 1. 小规模数据(样本量<10,000):

- • 推荐优化器:带动量的SGD(学习率0.01-0.1,动量0.9)

- • 理由:自适应优化器在小数据量下容易受噪声梯度影响,SGD的固定学习率更可靠。例如,在CIFAR-10上,SGD的测试准确率可比Adam高出2-3个百分点。

- 2. 超大规模数据(样本量>1M):

- • 推荐优化器:Adam或LAMB(大批次训练时)

- • 调整建议:将β₂从默认的0.999调整为0.99,以避免二阶矩估计过于平滑。

- • 理由:Adam的梯度归一化特性能够稳定大批次训练,而LAMB的层归一化机制适合分布式训练。

稀疏梯度场景的特殊处理

- 1. 推荐系统/NLP(稀疏梯度):

- • 推荐优化器:AMSGrad或AdaBound

- • 理由:这些改进版本通过修改二阶矩估计规则,避免稀疏梯度下的性能下降。

- 2. 极端稀疏场景(如点击率预测):

- • 推荐优化器:LazyAdam

- • 理由:仅在非零梯度时更新矩估计,内存效率提升40%,适合超大规模稀疏特征。

学习率调度策略配合

- 1. SGD优化器:

- • 推荐调度:余弦退火或周期性学习率

- • 理由:周期性调整学习率有助于逃离局部最优。

- 2. Adam优化器:

- • 推荐调度:线性预热(前5-10%训练步数逐步增加学习率)

- • 理由:避免训练初期因二阶矩估计偏差导致的不稳定。

- 3. 迁移学习:

- • 推荐策略:分层学习率(顶层学习率比底层大10倍)+ 权重衰减(0.01)

- • 理由:在视觉迁移任务中,这种组合显著提升微调效果。

硬件约束下的优化考量

- 1. 边缘设备(资源受限):

- • 推荐优化器:Adafactor

- • 理由:通过矩阵分解减少内存占用,优化器相关内存降低至Adam的1/3。

- 2. 分布式训练:

- • 推荐优化器:LAMB

- • 理由:支持大批次训练(batch size可达32k),减少通信开销。

未来优化技术的发展方向

跨学科融合的优化范式革新

当前优化技术研究正呈现出显著的跨学科特征,控制理论与物理建模的引入正在重塑算法设计范式。浙江大学控制学院与数学学院联合团队在《自然·通讯》发表的研究成果具有代表性,他们创新性地将PID控制原理应用于深度学习优化,提出的PIDAO(Proportional-Integral-Derivative Accelerated Optimization)算法通过融合当前梯度、历史梯度积分和未来梯度趋势三类信息,实现了比传统重球法更优的导航寻优能力。这种"虚拟物理动力学"建模方法不仅提供了超参数选择的数学依据,其特有的抵消效应还增强了算法逃离局部最优的能力。类似地,基于哈密顿力学和量子动力学的优化框架也开始在理论层面取得突破,预示着未来可能出现更复杂的"优化物理引擎"。

自适应机制的深度进化

自适应优化器正从简单的学习率调整向多维参数协同优化演进。最新研究案例显示,改进的平衡优化器算法通过构建外部存档保留历史优势个体,结合自适应交叉概率和协方差学习策略,显著提升了全局寻优能力。这种技术路线揭示出三个关键进化方向:一是动态平衡机制从启发式规则转向基于种群统计的数学建模;二是信息利用维度从单一梯度扩展到曲率、高阶矩等深层特征;三是参数更新策略从全局统一调整为分层分组的差异化处理。值得注意的是,二阶矩偏差修正这类经典问题正在衍生出新的解决方案,如通过滑动窗口统计替代指数加权平均来缓解长尾分布的影响。

硬件感知的极限优化

随着算力需求爆炸式增长,优化算法与硬件架构的协同设计变得至关重要。前沿研究主要集中在三个层面:在芯片层面,针对GPU/TPU特性设计的低精度优化算法能有效利用张量核心的计算优势;在系统层面,通信压缩与异步更新策略可降低分布式训练的同步开销;在算法层面,稀疏梯度处理和动态计算图优化能显著减少内存访问延迟。特别值得关注的是,最新GPU架构的异构计算特性正在催生新型混合精度优化器,这类算法能自动识别网络不同层对数值精度的敏感度,实现计算资源的智能分配。

可信优化技术体系构建

随着AI应用场景拓展,优化过程的可解释性和鲁棒性成为研究焦点。当前进展包括:通过Lyapunov函数严格证明优化轨迹的稳定性;开发具备后悔界(regret bound)保证的在线学习优化器;建立对抗样本训练中的收敛性理论。在医疗、金融等高风险领域,新型安全约束优化器能确保模型参数始终满足预设的伦理边界,这类技术通常采用对偶上升法处理约束条件,其挑战在于如何平衡约束满足与优化效率。联邦学习中的分布式优化算法也面临类似挑战,需要在不暴露原始数据的前提下实现多方协同优化。

超大规模模型的专用优化

针对千亿参数级别的大语言模型,传统优化器面临内存占用和通信瓶颈的双重挑战。新兴解决方案包括:基于参数高效微调(PEFT)的局部优化策略,如LoRA优化器仅训练低秩适配器;采用模型并行下的分层优化技术,对不同模块实施差异化的更新频率;开发基于专家混合(MoE)架构的动态优化器,仅激活部分网络参数。这些技术共同特点是放弃全局最优的追求,转而寻求计算资源约束下的实用最优解,其理论分析需要新的收敛性框架支持。

生物启发的优化新范式

神经科学和进化生物学为优化算法提供了新的灵感来源。类脑优化器模仿生物神经突触的可塑性机制,通过模拟神经递质调节原理实现动态学习率调整;群体智能算法则借鉴蚁群、鸟群等自组织行为,开发出完全去中心化的优化框架。这类算法的优势在于对非平稳目标的适应能力,但其数学可解释性仍是待解难题。近期突破包括建立群体动力学与随机梯度下降之间的数学等价关系,为生物启发算法提供理论支撑。