【AI论文】可追溯证据增强的视觉基础推理:评估与方法论

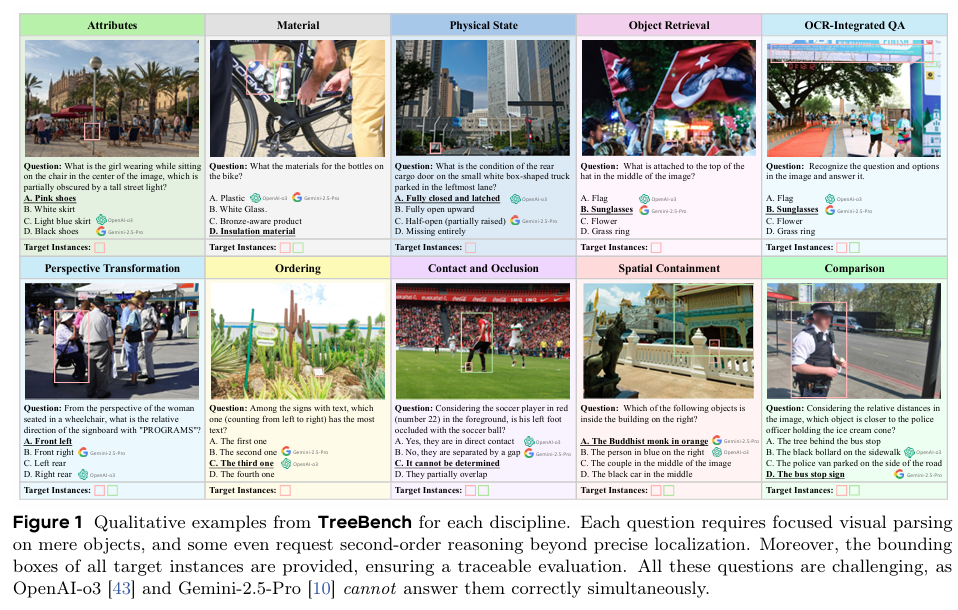

摘要:像OpenAI-o3这类模型通过动态关联视觉区域率先实现了视觉基础推理,其方式如同人类“以图思考”。然而,目前尚无能够全面评估此类能力的基准测试。为填补这一空白,我们提出了TreeBench(可追溯证据评估基准),这是一个基于三项原则构建的诊断性基准测试:(1)在复杂场景中聚焦细微目标的视觉感知;(2)通过边界框评估实现证据可追溯;(3)采用二阶推理测试超越简单目标定位的物体交互与空间层级关系。我们优先选择包含密集物体的图像,从SA-1B数据集中初步采样了1000张高质量图像,并邀请八位多模态大模型(LMM)领域专家为每张图像手动标注问题、候选选项及答案。经过三轮质量控制后,TreeBench最终包含405个极具挑战性的视觉问答对,即便是最先进的模型在该基准测试中也举步维艰,所有模型的准确率均未达到60%,例如OpenAI-o3的得分仅为54.87。此外,我们提出了TreeVGR(可追溯证据增强的视觉基础推理)训练范式,通过强化学习联合监督定位与推理过程,实现精准定位与可解释推理路径。该模型基于Qwen2.5-VL-7B初始化,在V* Bench(+16.8)、MME-RealWorld(+12.6)和TreeBench(+13.4)等基准测试中均取得显著提升,充分证明了可追溯性是推动视觉基础推理发展的关键。代码已开源,详见:https://github.com/Haochen-Wang409/TreeVGR。Huggingface链接:Paper page,论文链接:2507.07999

研究背景和目的

研究背景

近年来,随着深度学习和多模态人工智能技术的快速发展,视觉语言模型(Vision-Language Models, VLMs)在图像理解、视频分析、视觉问答等任务中取得了显著进展。然而,现有的视觉语言模型在处理长视频时面临诸多挑战。长视频通常包含大量复杂场景、密集的目标物体以及丰富的时间动态信息,这对模型的推理能力提出了更高要求。特别是,长视频理解不仅需要模型具备基本的视觉感知能力,还需要能够结合时间线索进行高级推理,如跟踪物体运动、理解事件发展顺序、推断因果关系等。

尽管一些先进的模型如OpenAI-o3已经在视觉基础推理方面取得了突破,通过动态关联视觉区域实现“以图思考”的能力,但目前仍缺乏全面评估此类能力的基准测试。现有的基准测试往往侧重于单一模态或简单任务,无法充分反映模型在处理长视频时的复杂推理能力。因此,开发一种能够全面评估视觉语言模型在长视频中推理能力的基准测试显得尤为重要。

研究目的

本研究旨在填补现有评估基准的空白,提出一种新的基准测试——TreeBench(可追溯证据评估基准),以全面评估视觉语言模型在长视频中的推理能力。具体目标包括:

- 开发全面的评估基准:构建一个包含复杂场景、密集目标物体和丰富时间动态信息的基准测试,以全面评估模型在视觉感知、目标定位、物体交互及空间层级关系等方面的推理能力。

- 引入可追溯证据机制:通过边界框评估实现推理过程的可追溯性,确保模型推理的每一步都有明确的证据支持,提高推理的透明度和可信度。

- 推动视觉基础推理的发展:通过提出TreeVGR(可追溯证据增强的视觉基础推理)训练范式,结合强化学习联合监督定位与推理过程,实现精准定位与可解释推理路径,推动视觉基础推理技术的发展。

研究方法

TreeBench基准构建

- 数据集选择:从SA-1B数据集中优先采样包含密集物体的1000张高质量图像,确保图像具有复杂场景和丰富的时间动态信息。

- 问题与答案标注:邀请八位多模态大模型领域专家为每张图像手动标注问题、候选选项及答案。标注过程强调问题的复杂性和多样性,涵盖目标定位、物体交互、空间关系等多个方面。

- 质量控制:经过三轮严格的质量控制,包括专家评审、模型预测试和人工修正,确保标注数据的准确性和可靠性。最终,TreeBench包含405个极具挑战性的视觉问答对。

TreeVGR训练范式

- 模型初始化:基于Qwen2.5-VL-7B模型进行初始化,该模型在视觉语言任务中表现出色,具备良好的视觉感知和语言理解能力。

- 强化学习训练:引入强化学习算法,结合边界框评估实现定位与推理的联合监督。通过设计合理的奖励函数,鼓励模型生成准确的边界框定位和可解释的推理路径。

- 多阶段训练:训练过程分为冷启动初始化和强化学习微调两个阶段。冷启动阶段利用监督学习对模型进行初步训练,强化学习阶段则通过不断试错和优化,提升模型的推理能力和定位精度。

研究结果

TreeBench评估结果

- 模型性能对比:在TreeBench基准测试中,即使是表现最先进的模型如OpenAI-o3也面临巨大挑战,准确率仅为54.87%。这表明现有模型在处理长视频复杂推理任务时仍存在明显不足。

- 能力分布分析:TreeBench涵盖10个核心能力类别,包括属性识别、材料判断、物理状态感知、目标检索、OCR集成问答、视角转换、顺序排列、接触遮挡、空间包含和比较等。评估结果显示,模型在不同能力类别上的表现存在显著差异,部分类别如空间包含和比较的准确率较低。

TreeVGR训练效果

- 性能提升显著:基于TreeVGR训练范式优化的模型在TreeBench上的准确率提升了13.4%,同时在V* Bench和MME-RealWorld等基准测试中也取得了显著提升(+16.8和+12.6)。这表明TreeVGR训练范式能够有效提升模型的推理能力和定位精度。

- 推理路径可解释性:TreeVGR通过强化学习实现了推理路径的可解释性。模型在生成答案的同时,能够提供清晰的边界框定位和推理步骤,增强了推理的透明度和可信度。

研究局限

- 数据集规模有限:TreeBench目前仅包含405个视觉问答对,虽然这些问答对具有较高的复杂性和挑战性,但数据集规模仍相对有限。未来需要进一步扩大数据集规模,以覆盖更多样化的场景和任务。

- 模型泛化能力待提升:尽管TreeVGR训练范式在TreeBench上取得了显著提升,但模型在跨数据集和跨任务时的泛化能力仍有待提升。未来需要探索更有效的迁移学习和领域适应方法,以提高模型的泛化能力。

- 计算资源消耗较大:强化学习训练过程需要消耗大量计算资源,特别是对于长视频任务而言,训练时间和成本较高。未来需要优化训练算法和硬件资源利用,以降低训练成本和提高训练效率。

未来研究方向

- 扩大数据集规模:未来工作将致力于扩大TreeBench数据集规模,增加更多样化的场景和任务类型,以提高基准测试的覆盖面和挑战性。

- 提升模型泛化能力:探索更有效的迁移学习和领域适应方法,使模型能够在不同数据集和任务之间实现更好的泛化性能。

- 优化训练算法:研究更高效的强化学习算法和训练策略,以降低计算资源消耗并提高训练效率。同时,探索结合其他先进技术如自监督学习、对比学习等,以进一步提升模型的推理能力。

- 拓展应用场景:将TreeBench和TreeVGR应用于更多实际场景中,如视频监控、自动驾驶、医疗影像分析等,以验证其在实际任务中的有效性和实用性。

- 加强跨学科合作:加强与认知科学、神经科学等领域的跨学科合作,深入探讨人类视觉推理的机制和原理,为开发更先进的视觉语言模型提供理论支持。