RICE-YOLO:基于改进YOLOv5的无人机稻穗检测新方法

【导读】

随着智慧农业的发展,如何快速、准确地识别稻穗成为了粮食生产智能化管理的关键任务之一。传统的人工调查方法效率低、成本高,无法满足大规模农业作业的实时需求。本文介绍了一种专为无人机图像优化设计的稻穗检测模型——RICE-YOLO,该模型基于YOLOv5框架,在结构上做出三大改进,有效提升了小目标检测能力、边缘目标定位精度和模型整体性能。>>更多资讯可加入CV技术群获取了解哦

目录

一、背景挑战

二、模型结构与设计细节

C3-EMA 模块

微尺度检测层

SIoU损失函数

三、实验验证与效果评估

整体性能表现

不同生育期下效果对比

与主流模型的横向比较

多场景实拍效果验证

结语

RICE-YOLO不仅仅是对YOLOv5的简单改进,而是结合田间稻穗检测的三大挑战——目标尺度小、遮挡密集、图像边缘扭曲,分别从三个方向提出创新设计:

-

结构性关注稻穗特征,强化边缘感知

通过引入EMA注意力机制,对稻穗在图像中突出的边缘和细节区域进行增强,弥补传统卷积网络在空间局部信息建模上的不足。

-

重新设计检测层,强化对小目标的感知能力

模型重构Neck部分,增加一个用于小目标检测的微尺度分支(P2),并删除用于检测大目标的深层检测头(P5),更符合稻穗在图像中的实际尺寸分布。

-

提出匹配无人机场景的边界框回归方法

改进损失函数,引入SIoU(Scylla IoU),将稻穗在图像边缘的倾斜、偏移纳入回归惩罚项,有效提升对扭曲目标的定位精度。

一、背景挑战

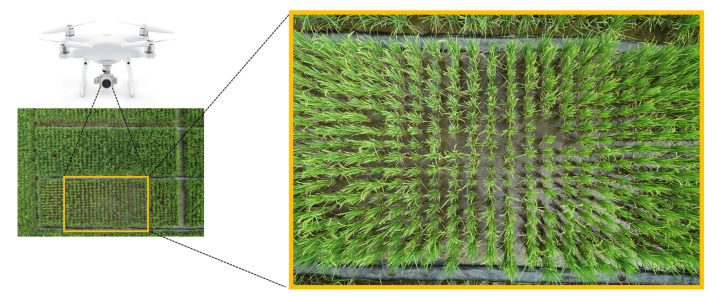

中国是世界上最大的大米生产国与消费国,稻谷产量稳居全球首位。随着我国农业机械化和信息化的推进,“无人机+AI”成为数字农业的重要方向。在稻作区,无人机不仅承担播种、喷药、测绘任务,也逐步成为获取高精度作物图像的关键工具。

然而,在实际田间应用中,面临三大挑战:

-

海量图像数据需要自动化处理,人工标注效率低;

-

俯拍角度导致稻穗目标比例缩小,识别难度显著上升;

-

不同光照、密度、生育期造成检测误差波动大。

因此,开发一套适配无人机图像的、高精度稻穗检测方法,不仅是科研前沿问题,更是粮食安全和管理智能化的现实需求。

二、模型结构与设计细节

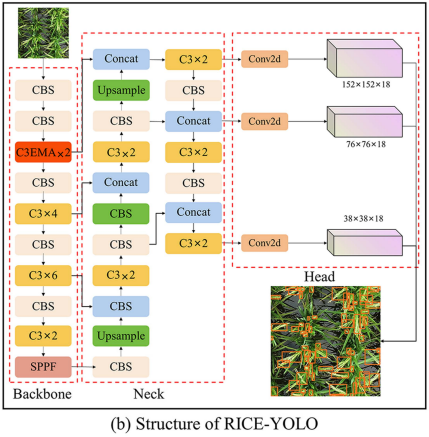

RICE-YOLO是在YOLOv5m版本的基础上,融合了多个结构优化点构建而成。主要包括以下三个模块级改进:

-

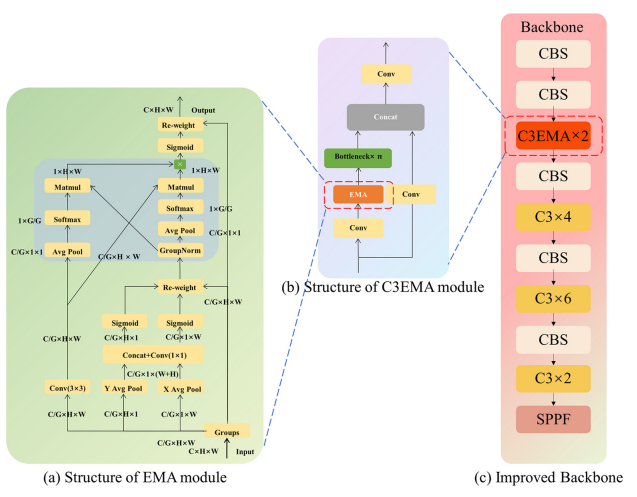

C3-EMA 模块

YOLOv5原始的C3模块使用标准CSP结构对特征通道进行融合,但对稻穗这种边缘突出的物体特征提取能力有限。

作者将EMA(Efficient Multiscale Attention)机制与C3融合,形成C3-EMA模块,具体做法如下:

将特征图按通道划分为多个组;

-

分别沿H(高度)和W(宽度)方向执行1D全局池化;

-

使用Group Normalization增强局部区域关注;

-

最终通过Sigmoid激活生成注意力图,乘以原特征,突出关键区域。

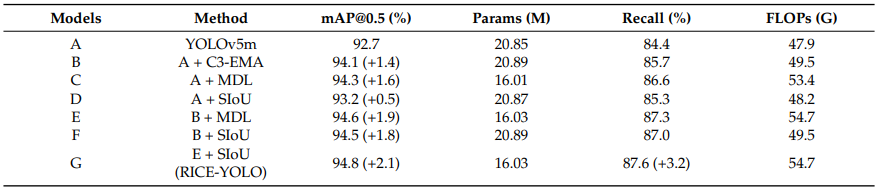

实验显示:仅在Backbone第一个C3中加入EMA模块即可提升mAP@0.5达1.4%(见表3)。

-

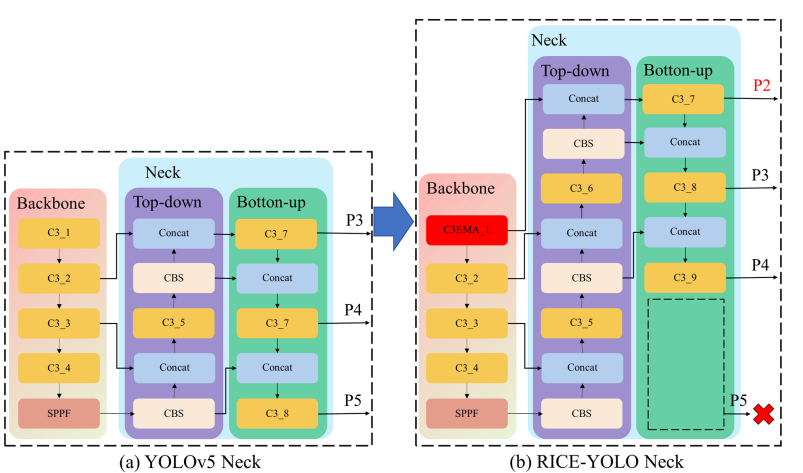

微尺度检测层

为了适应稻穗小目标的分布特性,作者对Neck结构进行了重新配置:

-

将Backbone中浅层C3输出引入Neck,构建一个新的小目标检测层P2;

-

同时,删除了原YOLOv5用于大目标检测的深层检测头P5;

-

这样既提升了小目标检测精度,也降低了网络的总体参数量和计算量。

调整后的网络在保持精度提升的同时,模型参数从原来的20.85M下降到16.03M,非常适合部署在边缘端设备上。

-

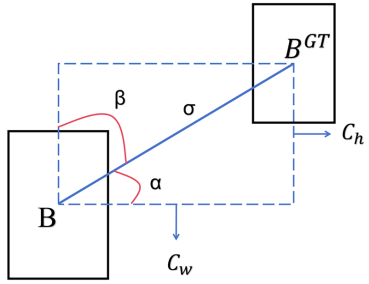

SIoU损失函数

SIoU是一种结合方向角、中心偏移和形状差异的边界框回归损失。相比传统IoU类损失,SIoU更适合稻穗这类“扭曲边界”目标,特别是在图像边缘区域:

-

通过角度惩罚项解决“目标框倾斜方向不一致”问题;

-

引入中心距离和形状偏差加权项;

-

综合提升了检测框的几何对齐程度。

该模块使得模型在复杂环境下定位准确度进一步增强,召回率提高显著。

如果你对AI项目有长期规划,或正处于多项目并行的开发周期中,Coovally全新推出的「RaaS服务年卡」,将为你撬动百万级项目交付能力,提供全栈AI技术支持。

无论是图像识别、视频分析,还是多模态任务(如红外+可见光融合),年卡服务都可为你提供一站式技术解决方案:

💡 我们的承诺:若一年内您无AI项目开发需求,退还50%年费,助你“零风险”布局AI赛道!

无论你是AI初创企业、科研团队,还是政府/高校项目负责人,RaaS年卡都将成为你降本增效、加快交付的核心动力!

👉 添加客服微信,了解年卡详情与签约流程,快速开启AI开发之旅。(点击了解更多 RaaS 服务详情)

添加微信

三、实验验证与效果评估

-

整体性能表现

结合三个模块的完整模型RICE-YOLO,相较于原YOLOv5m,实现了mAP@0.5提高2.1%、Recall提高3.2%、参数减少近25%。这是在保持轻量级特性的同时实现精度突破的重要进展。

-

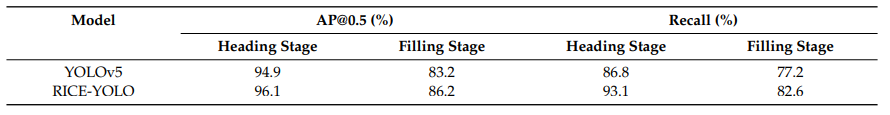

不同生育期下效果对比

在抽穗期和灌浆期两个阶段,RICE-YOLO均优于YOLOv5m,尤其是在灌浆期复杂遮挡条件下依然保持较高召回率。

-

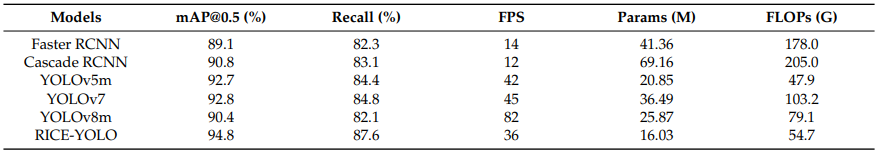

与主流模型的横向比较

与YOLOv7、YOLOv8、Faster RCNN、Cascade RCNN等模型相比,RICE-YOLO在精度和模型复杂度之间取得更优平衡,适合部署在实时无人机平台。

-

多场景实拍效果验证

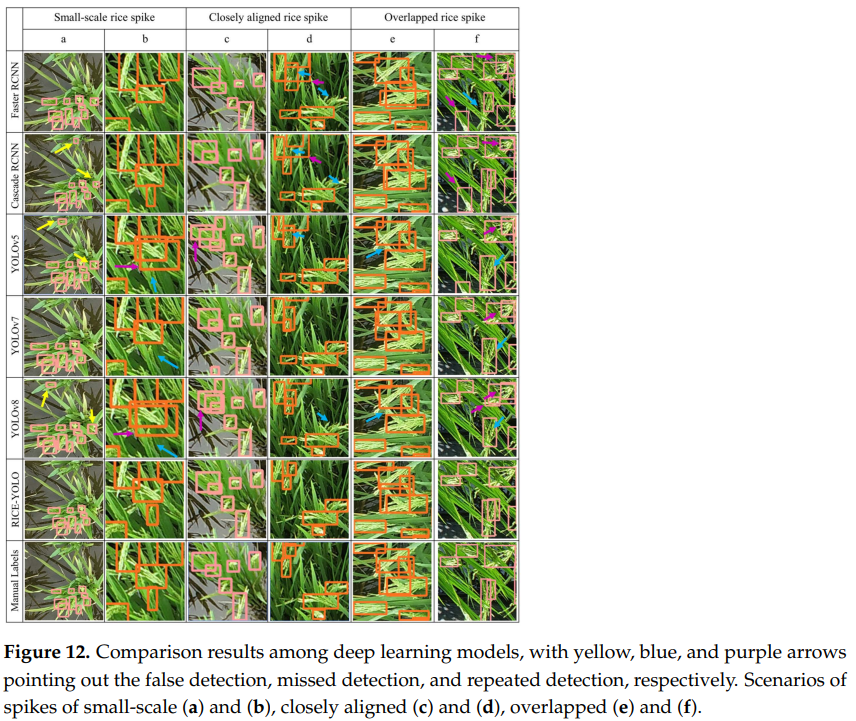

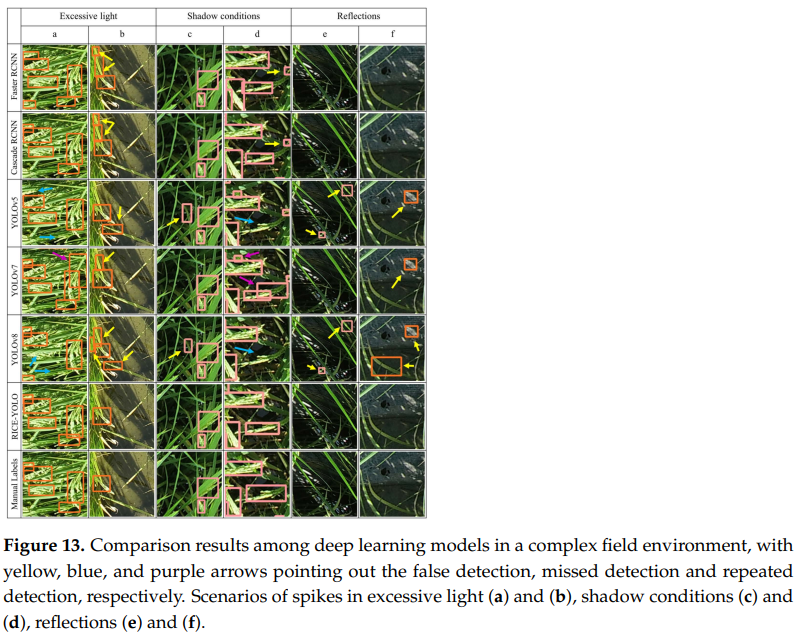

论文中图12与图13展示了RICE-YOLO在不同场景下的表现:

-

小目标密集(图12a、b)

-

遮挡与排列紧密(图12c、d)

-

光照复杂、阴影干扰、水面反光(图13a–f)

相比其他模型,RICE-YOLO能准确排除背景干扰、有效减少重复检与误检。

结语

RICE-YOLO不仅在学术层面提出了针对稻穗目标的新型检测结构,也为农业无人机视觉系统提供了轻量化、高精度的解决方案。其三大改进思路(注意力增强、检测层重构、回归优化)也具有很强的迁移性,未来可应用于更多农业视觉任务。

下一步,我们将继续关注其在其他作物上的迁移能力、与三维时序模型的结合潜力,并探索其与AI平台(如Coovally)结合实现一键化模型部署的实践路径。