小模型的价值重估:从“缩水版DeepSeek”到AI系统的基础执行单元20250716

小模型的价值重估:从“缩水版DeepSeek”到AI系统的基础执行单元

“一个成熟的AI系统架构,不再依赖单一的超级智能,而是善用每一个模型的角色价值。”

🔍 引言:为何重新审视小模型?

在实际构建智能问答、客服系统或Agent系统的过程中,我们常面临这样一个技术困惑:

本地小模型看似安全,但推理能力有限、表现差强人意,是否还有存在的意义?

尤其在对比DeepSeek、qwen3、 GPT-4、Claude 3 这类“满血大模型”时,小模型常被认为只是“功能受限的残血版”。然而,随着项目逐渐走向工程化、合规化与规模化,小模型展现出其在成本、安全、可靠性、架构协作等维度的独特价值。

📚 背景分析:为何小模型依然“火热”?

我们可以从以下几个真实且通用的工程需求出发理解其价值:

- 成本控制:高频请求下,大模型 API 成本难以接受,小模型一次部署即可长期运行;

- 延迟敏感场景:需要低于 500ms 响应的本地交互场景;

- 数据合规场景:金融、医疗、法律等无法将数据传出本地的行业;

- 多模型协同架构:将复杂任务拆解,由多角色协作处理;

- 定制与可控性:小模型更易 LoRA 或 SFT 微调,可实现行为可预测、运行可审计。

这些正是小模型兴起的底层驱动力——它们不是要取代大模型,而是开启了一种更具结构化与可控性的智能部署范式。

🧭 技术方案与实践路径

以下是典型的企业级多模型智能系统架构,来自我们在构建某本地部署AI系统过程中的真实总结:

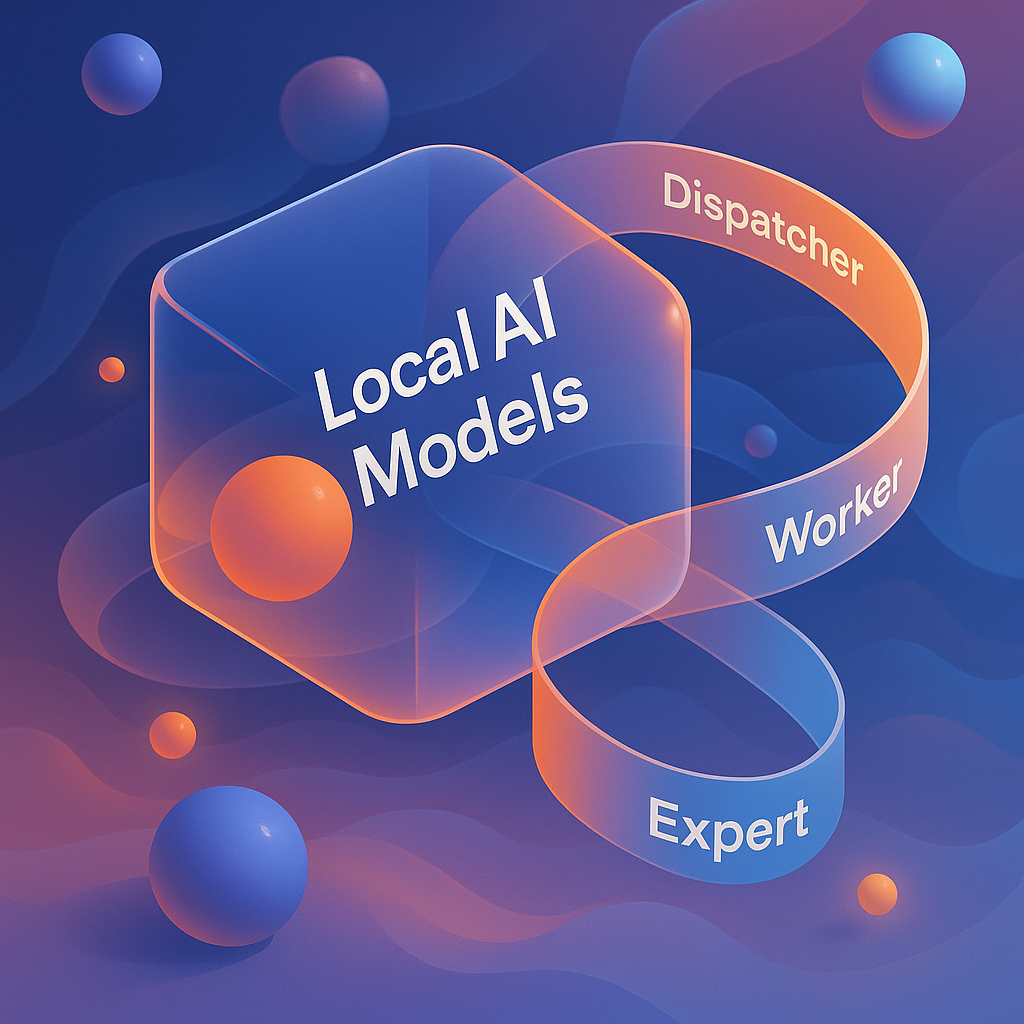

✅ 多角色协同的 Hybrid 架构(Dispatcher → Worker → Expert)

┌────────────────────┐

│ 用户请求(自然语言) │

└────────┬──────────┘▼

┌────────────────────────────┐

│ Dispatcher(本地小模型) │← 意图识别 / 敏感词判断 / 路由分发

└────┬─────────────┬────────┘▼ ▼

Worker-A(本地7B模型) Worker-B(RAG + embedding)│ │

← 结构化问答 ← 知识库检索▼ ▼Expert(云端 DeepSeek/Qwen3/GPT-4/Claude) ← 仅当任务复杂或创造性需求时调用

🔧 模型选型建议

| 角色 | 模型建议 | 适配任务 |

|---|---|---|

| Dispatcher | MiniCPM / FastText / Claude FunctionRouter | 意图识别、敏感词判断、初步分类 |

| Worker-A | Qwen3-14B / DeepSeek-14B | 问答 / 工具调用 / 基本代码理解 |

| Worker-B | BGE-Small + M3E + Faiss | 本地向量检索与知识回答 |

| Expert | GPT-4 / Claude 3 / API服务 | 高创造性生成、开放问答、长文分析 |

🧱 关键难点与解决思路

📌 1. 小模型能力差怎么办?

误区:试图用小模型完成大模型任务。

解决思路:

- 聚焦小模型“结构性任务”(如关键词提取、意图判断);

- 避免开放生成式回答;

- 微调并结合规则系统共同完成任务。

📌 2. Agent 调度失败、不稳定?

问题本质:缺乏明确的“任务划分标准”。

解决思路:

- 建立基于意图识别与任务类型的路由规则;

- 小模型做 Dispatcher,调用多个 Worker 组件而非单点大模型。

📌 3. 合规要求模型全本地?

限制:无法接入 API,需本地可控。

解决思路:

- 构建全本地私有化链路;

- 使用小模型 + 规则系统完成前置处理,规避“幻觉”;

- 采用日志审计与敏感词前置模块作为安全护栏。

✨ 总结与个人思考

在实际构建智能系统的过程中,我逐渐意识到:

小模型的价值从来不是替代大模型,而是在可控性、安全性与结构化协作中承担独特角色。

它们是:

- 架构的“螺丝刀”,精准完成结构性任务;

- 合规系统的“看门人”,阻挡非法请求;

- 多智能体体系的“调度者”,支撑高效执行闭环。

未来的 AI 系统,不会是“一个超大模型解决一切”,而是一群模型各司其职。理解小模型、善用小模型,是成为一个真正成熟的 AI 应用开发者的必经之路。

🔗 推荐金句结尾

“AI不只是模型之争,更是架构之道。懂得用小模型的人,才是真正的系统设计者。”