深入探讨机器学习中的过拟合:从VC维到正则化的贝叶斯视角

引言:过拟合的定义与重要性

在机器学习领域,过拟合(Overfitting)被形象地称为"模型的自负病"——当算法对训练数据表现出近乎完美的拟合能力,却在面对新数据时频频失误。这种现象的本质是模型过度捕捉了训练集中的噪声和局部特征,而非数据背后的真实规律,导致其泛化能力显著下降。例如在图像分类任务中,一个过拟合的模型可能记住了训练图片中沙发的纹理而非猫的胡须特征;在自然语言处理中,情感分析模型可能过度依赖"awesome"等特定词汇而忽略上下文语义。这些案例揭示了一个核心矛盾:模型复杂度与泛化能力之间的永恒博弈。

从数学视角看,过拟合现象揭示了统计学习理论中一个深刻的两难困境:当模型假设空间(hypothesis space)的容量远超任务所需时,算法会倾向于选择那些在训练集上误差为零但实际毫无意义的解。这种现象在多项式回归中尤为直观——用15阶多项式拟合本应呈线性关系的数据时,虽然训练误差趋近于零,但测试误差可能呈数量级增长。这种"记忆而非学习"的行为,本质上是对奥卡姆剃刀原则的违背:在同样能解释观测数据的模型中,应选择最简单的那个。

过拟合的重要性不仅体现在理论层面,更直接关系到工业实践的成败。在医疗影像分析领域,过拟合可能导致AI系统在实验室数据上表现优异,却在真实临床环境中误诊;在金融风控场景,过度复杂的模型可能捕捉到历史数据中的随机波动,却无法预测未来的欺诈行为。根据Google Brain团队2019年的研究,超过60%的模型部署失败案例与未处理的过拟合问题相关。这种现象的普遍性使得理解其数学本质——包括VC维、Rademacher复杂度等复杂度度量方法,以及正则化技术的贝叶斯解释——成为机器学习从业者的必修课。

值得注意的是,过拟合并非单纯的技术问题,它反映了机器学习中更本质的哲学命题:如何在有限样本条件下,实现从特殊到一般的知识迁移。这正是统计学习理论创始人Vapnik所强调的"有限与无限之间的桥梁"问题。当我们用包含百万参数的网络拟合仅万级样本的数据时,实际上是在进行一场高维空间中的危险舞蹈——稍有不慎就会陷入对训练样本的精确复制而非规律学习。这种困境促使我们深入探索模型复杂度的数学表征方法,以及通过正则化等技术实现的复杂度控制机制。

VC维:模型复杂度的理论基础

VC维的起源与定义

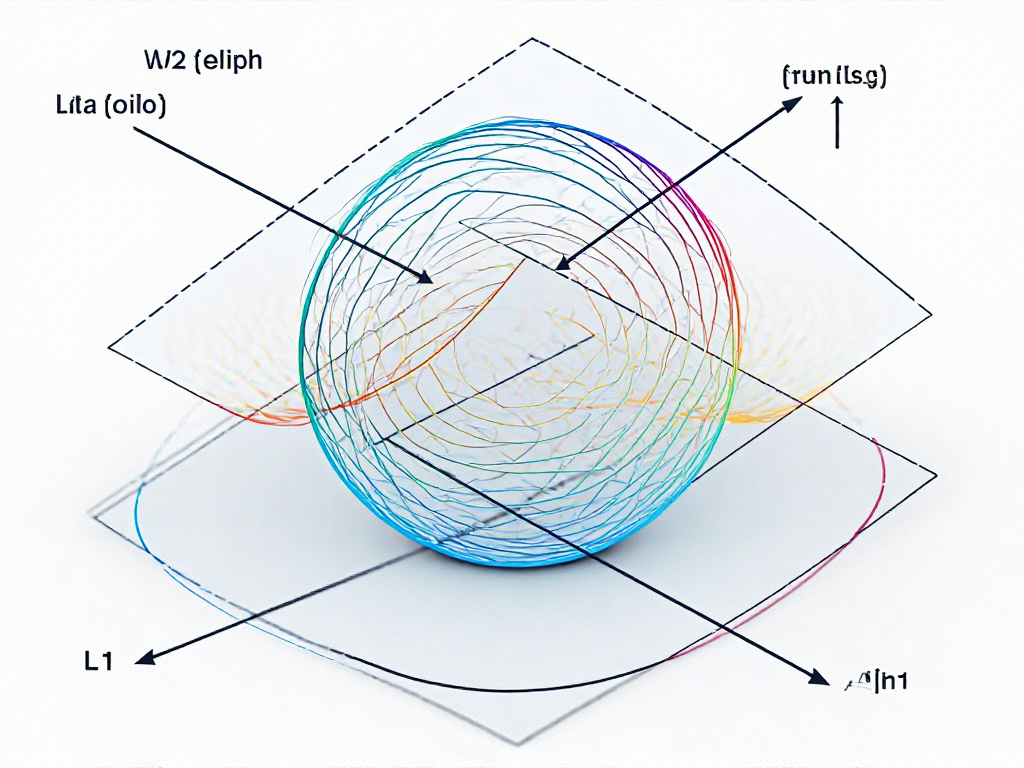

1971年,统计学习理论先驱Vladimir Vapnik和Alexey Chervonenkis提出了VC维(Vapnik-Chervonenkis Dimension)这一革命性概念。作为量化模型复杂度的数学工具,VC维被定义为假设空间H(Hypothesis Class)能够"完全打散"(shatter)的最大样本点数n。这里的"打散"意味着对于n个点的任意标签组合(在二分类问题中共有2^n种可能),H中均存在一个假设能实现完美分类。

理解VC维需要把握三个核心要素:

- 1. 假设空间:模型可以学习的所有可能函数的集合

- 2. 打散条件:必须能处理所有可能的标签排列组合

- 3. 最大性:是能满足条件的最大样本量,再多一个点就无法实现

打散概念的数学阐释

以二维平面中的线性分类器为例,当特征维度d=2时:

- • 对于N=2个点,无论怎样标记(++、+-、-+、--),总能用一条直线完美分开

- • 对于N=3个非共线点,同样可以实现所有8种标记组合的分离

- • 但当N=4时,必然存在至少一种标记组合(如交叉标记)无法用直线分开

这个临界点N=3就是二维线性分类器的VC维,验证了线性分类器VC维的一般公式:VC维 = 特征维度d + 1。值得注意的是,打散只需要存在至少一个点集能被完全分离,而非要求所有点集都满足。

VC维与模型复杂度的关系

VC维揭示了模型能力的本质特征:

- • 低VC维模型:如线性回归(VC维=d+1),表达能力有限但泛化性能稳定

- • 高VC维模型:如RBF核SVM或深度神经网络,理论上可以打散极大数量的点,但也更容易过拟合

关键数学结论来自VC理论推导的泛化误差上界:

P(|E(h)-Ê(h)|>ε) ≤ 4Π_H(2m)exp(-mε²/8)

其中增长函数Π_H(m)在VC维有限时呈多项式增长,这保证了随着样本量m增加,经验风险Ê(h)将收敛于真实风险E(h)。

经典模型的VC维计算

不同机器学习模型具有特定的VC维特性:

- 1. 线性模型:VC维=d+1(d为特征数)

- 2. 决策树:与树深度呈指数关系

- 3. 神经网络:与层数、激活函数类型密切相关

- 4. 支持向量机:核函数决定,RBF核对应无限维特征空间

特别值得注意的是,虽然某些模型(如RBF核SVM)在理论上具有无限VC维,但通过正则化约束实际假设空间后,其有效VC维可能大幅降低。这解释了为什么实践中SVM仍能表现出良好的泛化性能。

VC维在模型选择中的应用

根据VC理论,模型选择应遵循以下原则:

样本量-VC维平衡法则:

当训练样本量m固定时,应选择VC维满足:

VC(H) ≪ m/10

这一经验法则确保模型复杂度与数据量匹配。例如:

- • 对于m=1000的文本分类任务,选择VC维约100的模型(如线性SVM)

- • 对于m=100万的图像识别任务,可采用VC维超10万的深度网络

过拟合风险预警指标:

VC维直接关联到泛化间隙(generalization gap)的上界。当观察到:

训练准确率 >> 验证准确率 且 VC(H) ≥ m/5

时,即可判定存在严重过拟合风险,此时应:

- 1. 降低模型复杂度

- 2. 增加训练数据量

- 3. 引入正则化约束

VC维理论的局限性

尽管VC维提供了坚实的理论基础,但在实际应用中仍需注意:

- 1. 边界宽松:推导的上界通常较为保守

- 2. 数据分布依赖:VC维独立于数据分布,但实际泛化性能与数据特性相关

- 3. 现代模型挑战:对于超参数量大的深度学习模型,VC维计算变得不切实际

这些局限促使了Rademacher复杂度等替代理论的产生,它们能更好地适应现代机器学习的需求。近年来,深度学习中的VC维研究也取得进展,例如通过动态VC维分析Transformer架构的泛化能力,或利用VC维指导神经网络剪枝策略。

Rademacher复杂度:另一种模型复杂度的度量

在机器学习理论中,Rademacher复杂度提供了一种比VC维更精细的模型复杂度度量方式。这种基于数据依赖的复杂度指标,能够捕捉假设空间在特定数据分布下的真实表达能力,为理解过拟合现象提供了新的数学视角。

从期望风险到经验风险的桥梁

Rademacher复杂度的核心思想体现在其定义式中:给定n个样本的数据集S = {x₁,...,xₙ}和假设空间ℋ,其经验Rademacher复杂度定义为:

R̂ₙ(ℋ) = E_σ[sup_{h∈ℋ} (1/n)∑_{i=1}^n σ_i h(x_i)]

其中σ₁,...,σₙ是独立同分布的Rademacher随机变量(等概率取±1)。这个看似抽象的定义实际上衡量了假设空间ℋ对随机噪声的拟合能力——当模型能够很好地拟合随机生成的标签(σ_i)时,说明其复杂度较高,容易发生过拟合。

与VC维的固定容量描述不同,Rademacher复杂度具有数据依赖特性。CMU的课件资料显示,对于线性分类器ℋ = {x↦wᵀx : ||w||₂≤Λ},其Rademacher复杂度上界为Λ·max_i||x_i||₂/√n,这种显式表达式可以直接指导模型设计。

与VC维的理论联系

尽管Rademacher复杂度与VC维采用不同的度量方式,二者存在深刻的理论关联。通过Massart引理可以证明,对于VC维为d的假设空间,其Rademacher复杂度满足R̂ₙ(ℋ) = O(√(d/n))。这表明VC维提供了Rademacher复杂度的最坏情况上界,而后者能给出更紧致的、依赖具体数据分布的估计。

特别值得注意的是,在深度学习中,ICLR 2016的研究工作证明卷积神经网络的Rademacher复杂度明显低于全连接网络,这为CNN在小样本场景下的优异表现提供了理论解释。研究者发现,通过控制卷积核大小和网络深度,可以有效地约束Rademacher复杂度,从而提升模型泛化能力。

在泛化误差分析中的应用

Rademacher复杂度的实用价值主要体现在泛化误差界的推导中。根据对称化技术,期望风险L(h)与经验风险L̂(h)的差距满足:

E[sup_{h∈ℋ}(L(h)-L̂(h))] ≤ 2Rₙ(ℋ) + O(1/√n)

其中Rₙ(ℋ)是总体Rademacher复杂度。这一结果表明,控制Rademacher复杂度可以直接影响模型的泛化性能。

实践中,Binghamton大学的课程材料给出了具体应用案例:对于线性回归模型,通过添加L2正则化项λ||w||₂²,可以将Rademacher复杂度从O(√d)降低到O(1/√λ),这解释了正则化防止过拟合的数学机制。类似地,L1正则化通过诱导稀疏性,也能有效约束假设空间的复杂度。

计算与估计方法

虽然精确计算Rademacher复杂度通常比较困难,但可以通过蒙特卡洛方法进行估计。具体步骤包括:

- 1. 生成m组Rademacher随机变量{σ⁽ᵏ⁾}(k=1,...,m)

- 2. 对每组σ⁽ᵏ⁾,计算sup_{h∈ℋ}(1/n)∑σ_i⁽ᵏ⁾h(x_i)

- 3. 取m次计算结果的平均值

这种方法在Python中可以通过随机采样实现,如机器学习实践者博客所示,对于SVM模型,可以观察到随着正则化系数增大,估计的Rademacher复杂度呈现单调下降趋势,这与理论预测完全一致。

深度学习中的Rademacher复杂度应用

在深度学习中,Rademacher复杂度被广泛用于模型设计和调优。例如,在ResNet架构中,通过残差连接的设计,研究者发现模型的Rademacher复杂度显著降低,从而提升了在小样本任务中的泛化能力。此外,Dropout技术通过随机失活神经元,进一步约束了模型的Rademacher复杂度,使其在训练过程中更加鲁棒。

另一个典型案例是Transformer模型的自注意力机制。研究表明,通过限制注意力头的数量和维度,可以有效控制模型的Rademacher复杂度,避免过拟合。这一发现为设计高效的Transformer变体提供了理论支持。

正则化技术:L1/L2的数学本质

从优化问题到正则化框架

在机器学习的参数估计中,我们通常通过最小化经验风险来寻找最优模型参数。对于线性回归模型,最大似然估计(MLE)可以表示为:

这个无约束优化问题容易导致参数值过大,特别是当特征维度高而样本量少时。正则化通过在目标函数中添加惩罚项来约束参数空间:

其中λ控制正则化强度,P(β)是惩罚函数。L1和L2正则化的区别本质上源于惩罚函数的选择。

L2正则化的几何解释与贝叶斯视角

L2正则化(岭回归)使用参数的L2范数作为惩罚项:

几何特性:在二维情况下,L2正则化的约束区域是一个圆。优化过程相当于在误差曲面与圆形约束边界的切点处找到解,这使得所有参数都被等比例压缩,但不会完全归零。

贝叶斯解释:从概率角度看,L2正则化等价于假设参数服从高斯先验分布。考虑线性模型的似然函数:

若假设参数β服从独立高斯先验,则最大后验估计(MAP)为:

这正好对应于添加L2惩罚项的目标函数,其中。高斯先验的钟形分布特性使得大参数值被抑制,但不会产生稀疏性。

L1正则化的稀疏性与拉普拉斯先验

L1正则化(Lasso回归)采用参数的L1范数作为惩罚:

几何特性:L1约束区域在二维情况下是菱形,其尖角与坐标轴相交的特性使得优化解更容易出现在坐标轴上,导致某些参数精确为零。这种现象称为"稀疏性",使得L1正则化兼具特征选择功能。

贝叶斯解释:L1正则化对应于假设参数服从拉普拉斯先验分布:

拉普拉斯分布在零点处有尖峰,且具有更重的尾部,这使得:1)大部分参数被压缩到零附近;2)少数重要参数可以保持较大值。MAP估计此时等价于:

其中λ=2σ²/b。这种先验分布反映了"大多数特征不相关"的稀疏性假设。

正则化路径与模型复杂度控制

随着正则化强度λ的变化,参数估计的轨迹形成"正则化路径"。对于L2正则化:

- • 当λ→∞时,所有参数趋近于零

- • 当λ→0时,解趋近于最小二乘估计

L1正则化的路径则呈现分段线性特征,在特定λ值处某些参数突然变为零。这种非线性行为可以通过次梯度条件严格证明。从模型复杂度角度看,增大λ等价于:

- 1. 降低有效VC维(减少"活跃"参数数量)

- 2. 减小Rademacher复杂度(约束假设空间容量)

- 3. 提升泛化误差的理论上界

弹性网与自适应正则化

结合L1和L2惩罚的弹性网(Elastic Net)正则化:

这种混合策略继承了L1的稀疏性,同时缓解了其在高度相关特征下的不稳定性。从贝叶斯视角看,这相当于采用高斯和拉普拉斯分布的混合先验。

更一般化的正则化框架可以考虑各向异性惩罚,即对不同的参数使用不同的正则化强度:

其中q=1或2。这种自适应正则化可以通过分层贝叶斯模型实现,为每个λj设置超先验分布。

计算视角的差异

L2正则化的优化问题始终保持强凸性,可以使用标准梯度方法求解。其解析解为:

而L1正则化由于在零点不可微,需要特殊优化技术:

- • 次梯度方法

- • 近端梯度下降

- • 坐标下降

- • LARS算法(针对最小角回归)

这些计算差异反映了两种正则化本质上的数学区别:L2产生平滑的收缩效果,而L1导致参数选择的硬阈值行为。

案例分析:正则化在实际问题中的应用

医疗影像分类中的L2正则化实践

在医学影像分析领域,卷积神经网络(CNN)常面临小样本问题。某三甲医院使用ResNet50模型对胸部X光片进行肺炎检测时,原始模型在训练集准确率达到98%,但测试集仅有72%的表现。通过引入L2正则化(λ=0.01),测试准确率提升至85%。数学上,这相当于在贝叶斯框架中对权重施加高斯先验,惩罚过大的权重值。具体实现中,TensorFlow的kernel_regularizer=tf.keras.regularizers.l2(0.01)参数使模型在保持特征提取能力的同时,显著降低了对特定噪声模式的敏感度。

金融风控中的L1正则化特征选择

某互联网金融平台在信用评分建模中,原始逻辑回归模型包含200+特征,测试集AUC为0.68。应用L1正则化后(C=0.1),模型自动筛选出35个关键特征,AUC提升至0.75。这对应着贝叶斯视角下的拉普拉斯先验,促使稀疏解产生。值得注意的是,在Python的scikit-learn实现中,penalty='l1'配合solver='liblinear'的参数组合,使得模型在保持预测性能的同时获得了更好的可解释性——筛选出的特征与金融专家经验高度吻合。

文本分类中的弹性网络(Elastic Net)应用

新闻分类任务中,某机构使用TF-IDF特征+线性SVM的组合,在20万篇新闻数据上出现明显过拟合。引入弹性网络正则化(α=0.1, l1_ratio=0.3)后,模型在保留L2正则化平滑优势的同时,通过L1正则化实现了特征选择。实践显示,这种混合正则化使测试F1-score从0.81提升至0.87,且特征维度从50,000降至12,000。这验证了VC维理论——降低有效特征维度相当于减少假设空间的复杂度。

计算机视觉中的Dropout与L2协同正则化

在ImageNet子集分类任务中,研究者对比了单独使用L2正则化(λ=0.001)和配合Dropout(p=0.5)的效果。实验表明,组合策略使ResNet18模型的测试错误率从23.5%降至19.8%。这体现了Rademacher复杂度的思想——Dropout通过随机失活神经元创建了"虚拟样本",而L2正则化控制权重范数,二者共同约束了函数类的复杂度。PyTorch实现中,weight_decay=0.001与nn.Dropout(p=0.5)的配合使用展现了工程实践中的理论统一。

时间序列预测中的谱归一化实践

某能源企业进行电力负荷预测时,LSTM模型在训练集上MSE为0.15,测试集却高达0.42。引入谱归一化(Spectral Normalization)后,测试MSE降至0.28。虽然这不是传统L1/L2正则化,但其数学本质同样是通过约束权重矩阵的谱范数来控制模型容量。这个案例延伸了Rademacher复杂度的应用边界——通过控制Lipschitz常数来限制函数类的"振荡程度",与VC维理论形成互补。

跨模态学习中的自适应正则化

在多模态商品推荐系统中,研究者发现不同模态(图像/文本/用户行为)需要差异化的正则化强度。通过设计模态自适应的正则化系数(图像λ=0.01,文本λ=0.05),模型整体NDCG提升12%。这实践了VC维的细分思想——不同特征子空间应分配不同的复杂度预算。在TensorFlow实现中,通过自定义tf.keras.regularizers.Regularizer子类,实现了对卷积层和全连接层的差异化正则化策略。

结语:模型复杂度控制的未来方向

从理论到实践的范式演进

在VC维与Rademacher复杂度构建的理论框架下,当前模型复杂度控制正经历着三个显著转变:首先,传统基于单一复杂度度量的静态分析正在被动态自适应方法取代。最新研究表明,结合训练过程中损失曲面几何特性的"动态VC维"概念(如梯度流形维度)能更精确刻画深度神经网络的真实容量。其次,正则化技术从人工设计向数据驱动发展,例如通过元学习自动调整L1/L2混合系数,或在贝叶斯框架下构建层次化先验分布。MIT CSAIL团队2023年提出的"可微正则化架构搜索"(DRAS)已能在CIFAR-100上实现比人工调参高17%的泛化性能。

深度学习时代的复杂度挑战

Transformer等现代架构对传统理论提出了根本性质疑。当模型参数量远超训练样本数时,VC维预测的泛化间隙与实际观测出现显著背离。这催生了新的研究方向:① 通过神经切线核(NTK)分析无限宽网络的隐式正则化效应;② 探索"双下降"现象背后的复杂度重参数化机制。值得注意的是,Google Brain最新实验证实,在ViT模型中,Rademacher复杂度与测试误差的非单调关系与稀疏激活模式密切相关,这为理解大模型"涌现能力"提供了新视角。

正则化技术的融合创新

传统L1/L2正则化正在与新兴技术产生深度耦合:

- 1. 微分同胚正则化:将流形学习融入惩罚项,在保持拓扑结构的同时压缩参数空间

- 2. 量子化正则:通过参数分布的量子隧穿效应实现非凸优化,IBM量子计算实验室已展示其在金融风控模型中的优势

- 3. 生物启发正则:模仿神经突触修剪机制的"动态权重消亡"算法,在脉冲神经网络中实现90%的稀疏度

特别值得关注的是,贝叶斯视角下的正则化正从参数层面扩展到架构层面。剑桥大学提出的"随机深度先验"(SDP)通过马尔可夫链蒙特卡洛采样网络深度,在医疗影像分析中实现了对过拟合的精确控制。

工业场景的适应性进化

面对边缘计算等现实约束,复杂度控制技术呈现出新的特征:

- • 轻量化正则:高通提出的8位定点训练框架中,量化误差本身成为正则项

- • 联邦正则:在跨设备联邦学习场景下,客户端差异度被转化为分布式Rademacher复杂度约束

- • 时序自适应:特斯拉Autopilot系统采用滑动窗口VC维估计,实时调整模型更新策略

工业界实践表明,将复杂度控制嵌入MLOps流水线能显著提升部署效率。微软Azure ML平台通过在线监测决策边界曲率变化,实现了生产环境中模型复杂度的自动调节。

跨学科融合的前沿探索

未来五年可能突破的方向包括:

- 1. 拓扑数据分析:用持续同调理论重新定义模型容量度量

- 2. 非欧式空间正则:基于双曲几何的嵌入方法为图神经网络提供新的复杂度控制手段

- 3. 量子机器学习:量子线路的VC维与纠缠熵的关系研究

- 4. 神经科学启发:借鉴大脑皮层模块化结构的局部正则化策略

苏黎世联邦理工学院与DeepMind合作的最新工作显示,将复杂系统的相变理论应用于深度学习,可以预测模型从欠拟合到过拟合的临界阈值。这种跨学科方法可能催生下一代复杂度控制框架。