【笔记】NVIDIA AI Workbench 安装记录

前言

NVIDIA AI Workbench 简介

NVIDIA AI Workbench 是一款由 NVIDIA 推出的集成化开发工具,旨在简化人工智能和机器学习的开发流程。它提供从数据准备到模型训练、优化及部署的全套工具链,支持跨平台协作,适合开发者、数据科学家和企业团队快速构建 AI 解决方案。

核心功能与作用

跨平台开发环境

支持本地工作站、云端(如 AWS、Google Cloud)及 NVIDIA DGX 系统的无缝切换,统一开发环境配置,避免因环境差异导致的问题。

简化工作流

集成 Jupyter Notebook、容器化工具(如 Docker)和版本控制(Git),允许用户直接加载预配置的模板(如 PyTorch、TensorFlow),加速模型开发与实验。

高性能计算支持

利用 NVIDIA GPU 的 CUDA 加速库和优化框架(如 RAPIDS),显著提升数据处理和模型训练效率,特别适合大规模深度学习任务。

协作与部署

提供团队协作功能,支持模型打包为容器或导出至 NVIDIA Triton 推理服务器,简化从开发到生产环境的迁移过程。

典型应用场景

- 计算机视觉:快速训练图像分类、目标检测模型。

- 自然语言处理:构建和微调大语言模型(LLM)。

- 数据分析:利用 GPU 加速库处理海量数据。

该工具尤其适合需要快速迭代或资源灵活调配的 AI 项目,降低技术栈复杂度。

一、用户指南

在 Windows 上安装、更新和卸载 — NVIDIA AI Workbench 用户指南

二、安装程序下载

https://workbench.download.nvidia.com/stable/workbench-desktop/latest/NVIDIA-AI-Workbench-Setup.exe

三、安装过程记录

启动安装程序

根据引导继续

这是在下载和安装 WSL(Windows Subsystem for Linux,适用于 Linux 的 Windows 子系统 )分发版,具体是为 AI Workbench 配置的 WSL2 环境,进度已到 79.06% 。因文件较大,需一些时间完成,耐心等待即可,完成后可借助 WSL 在 Windows 系统里使用 Linux 相关功能开展 AI 开发等工作 。

- 已完成项:“Core package(核心软件包 )” 和 “Git - LFS(用于处理大文件的 Git 扩展 )” 都已 100% 安装好,说明基础依赖部分就绪。

- 进行中项:正开始安装 Docker(进度 0% ),还会配置 Docker Desktop,Docker 常用于容器化部署,对 AI 工作流里环境管理、应用部署很重要,耐心等它装完,整个 AI Workbench 安装配置就更完善啦,后续就能用它开展 AI 开发相关工作咯。

- 标题 “You're all set!” 表示安装已全部就绪。

- 下方列出所选安装项状态:核心包(Core)、Git - LFS(大文件存储扩展 )、Docker(容器化工具 )都已成功安装(install complete )。

- 还提示可在 “Preferences(偏好设置 )” 里随时更改这些配置,点击绿色按钮 “Let's Get Started” 就能开启使用 AI Workbench 进行 AI 开发等工作啦,基本已完成安装,能正式上手体验咯 。

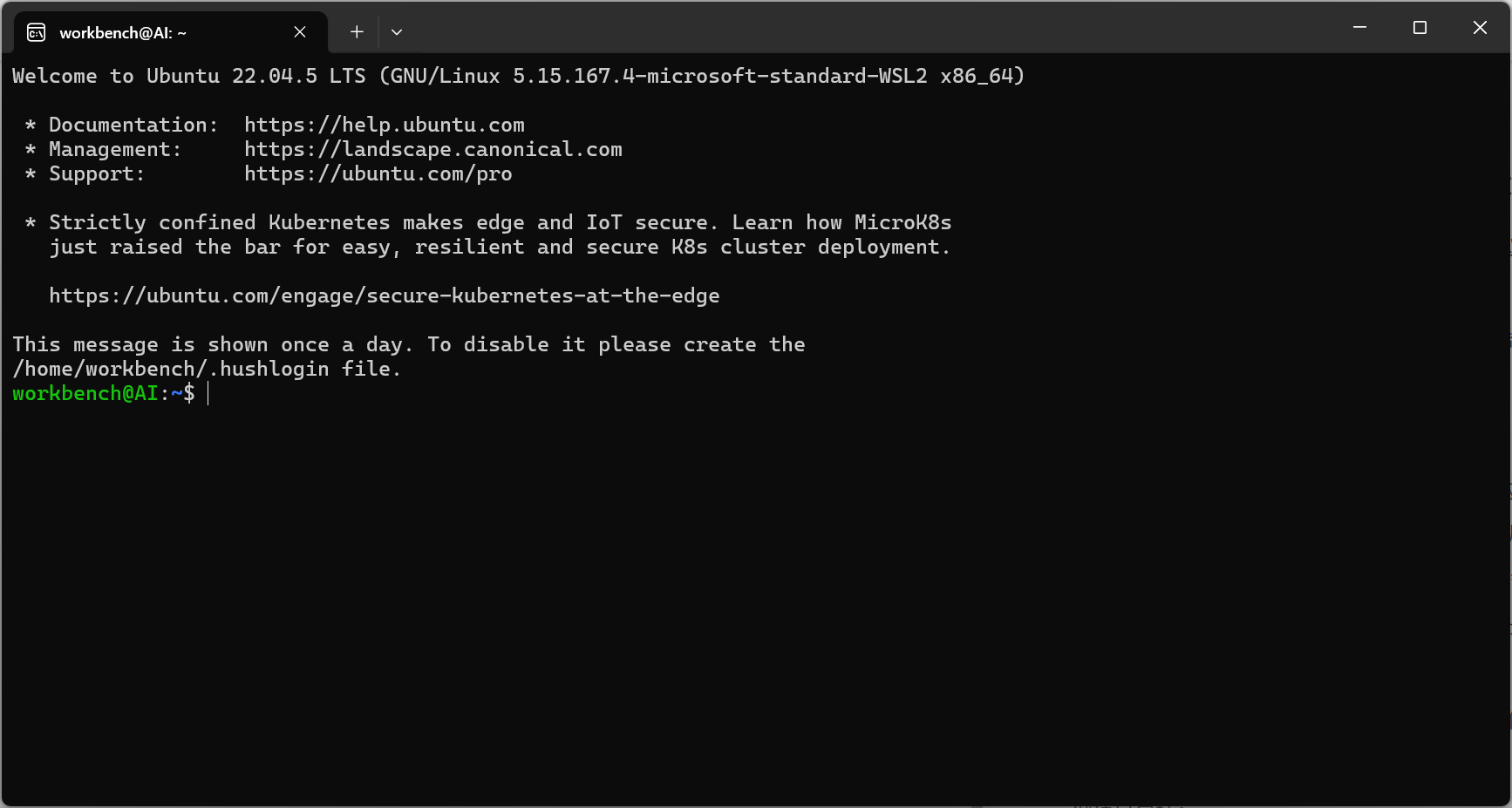

安装完成后得到一个WSL的子系统和组件:

输入nvidia-smi命令可以查看与GPU的通信状况:

nvidia-smi

四、安装过程中会遇到的问题

因为涉及WSL,安装过程中会导致Docker报错,是正常现象,重新启动就行

WSL调试控制台也会弹出显示日志,也是正常现象,有些报错能处理则处理,不处理也不影响系统运行