归一化相关

归一化相关问题

- 归一化方式

- Batch Normalization

- Layer Normalization

- Instance Normalization

- Group Normalization

- RMSNorm(Root Mean Square Layer Normalization):

- RMSNorm 和 LayerNorm区别?

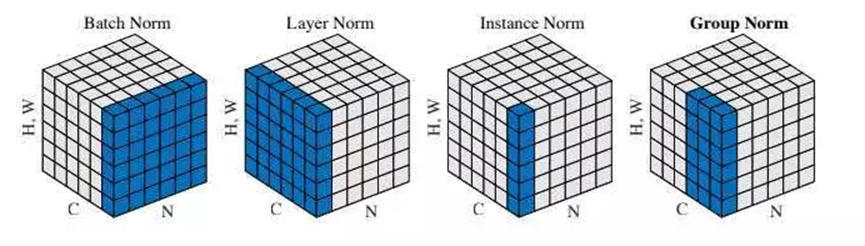

归一化方式

Batch Normalization

在每一层的输入进行归一化处理,使其在每个批次内具有零均值和单位方差。通过标准化减少了内部协方差偏移,从而加速训练。

在测试时,所使用的均值和方差是整个训练集的均值和方差。整个训练集的均值和方差的值通常是在训练的同时用 移动平均法 来计算的。

Layer Normalization

与批量归一化不同,层归一化是在每个样本的所有特征(所有通道一起)上进行归一化,而不是在整个批次的维度上。每个样本都独立处理,适用于序列模型(如 RNN 和 Transformer)。

Instance Normalization

对每个输入样本单独进行归一化,适用于每个个体都是独立的且每个通道都有自己的含义的时候

Group Normalization

将特征划分为多个组&#x