CAU人工智能class5 激活函数

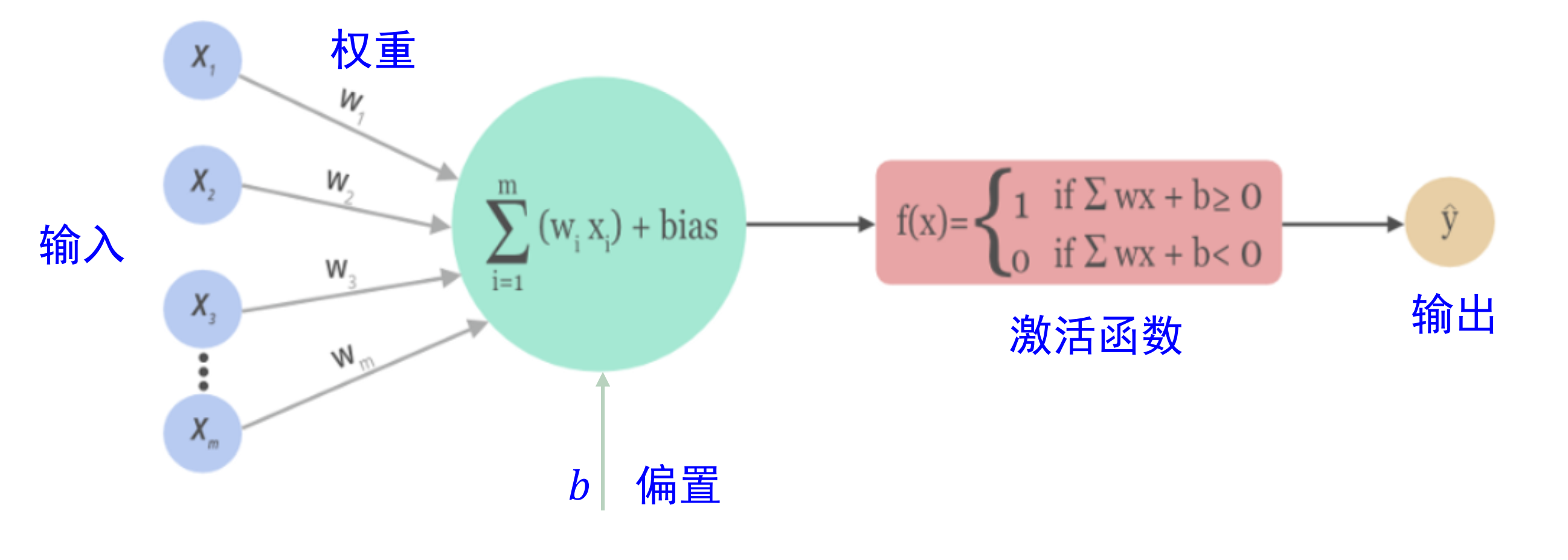

神经元的大致工作原理

传统的脉冲激活函数存在不足,需要改进激活函数

激活函数的特点

常用的激活函数

Sigmoid 函数

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-10,10,50)

y = 1 / (1 + np.exp(-x))

fig = plt.figure()

plt.plot(x, y)

plt.show()

导数

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-10,10,50)

y = 1 / (1 + np.exp(-x))

y = y*(1-y)

fig = plt.figure()

plt.plot(x, y)

plt.show()

Relu函数

x = np.linspace(-10,10,50)

y = np.zeros(x.shape)

for i,v in enumerate(x):

if v >= 0:

y[i] = v

else:

y[i] = 0

fig = plt.figure()

plt.plot(x, y)

plt.show()

优点:

缺点:

Relu函数的变种

Leaky ReLU

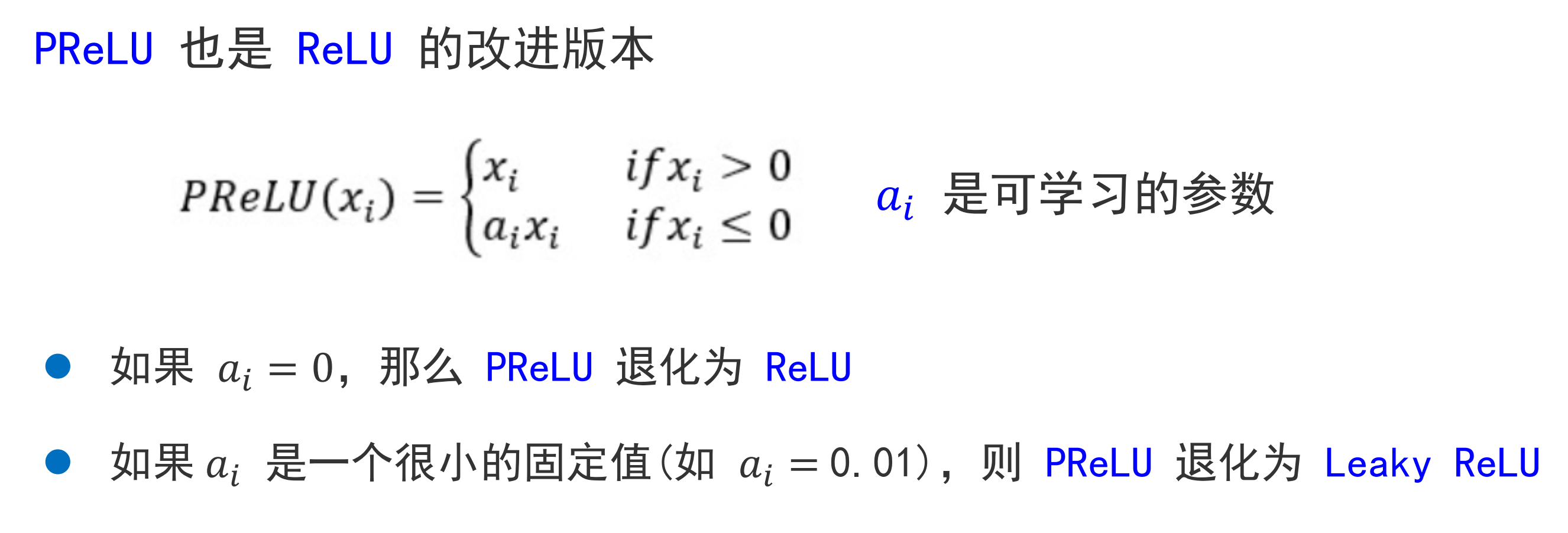

PReLU

指数线性单元(ELU)

高斯误差线性单元(GELU)

Swish 函数

Mesh 函数

关于激活函数的使用建议

为什么初始参数要符合标准正态分布