【AI论文】COMPACT:从原子级到复杂级的组合式视觉能力调优

摘要:多模态大语言模型(MLLM)擅长简单的视觉语言任务,但在面对需要多种能力的复杂任务时却很吃力,例如同时识别物体、计算数量和理解它们的空间关系。 这可能部分是由于视觉指令调整(VIT)这一MLLL的关键训练步骤传统上侧重于扩展数据量,而不是训练示例的组合复杂性。 我们提出了COMPACT(组合原子到复杂视觉能力调优),它生成了一个训练数据集,明确控制训练样本的组合复杂性。 来自COMPACT的数据允许MLLM在原子能力的组合上进行训练,从而更有效地学习复杂的能力。 在所有基准测试中,COMPACT的性能与LLaVA-665k VIT相当,但使用的数据预算不到其10%,甚至在几个方面(尤其是涉及复杂的多功能任务)甚至超过了它。 例如,对于需要四个或更多原子能力的特别复杂的问题,与全尺寸VIT相比,COMPACT在MMStar上实现了83.3%的实质性改进,在MM-Vet上实现了94.0%的改进。 COMPACT提供了一种可扩展的、数据高效的、视觉组合调优方法,以改进复杂的视觉语言任务。Huggingface链接:Paper page,论文链接:2504.21850

研究背景和目的

研究背景

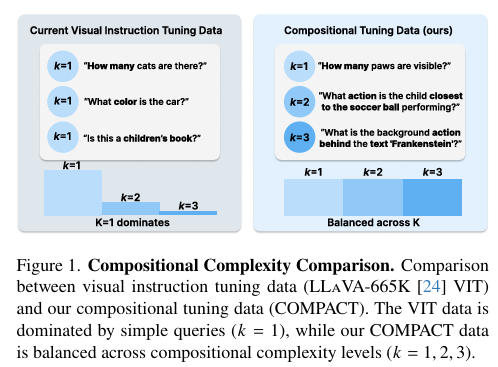

随着人工智能技术的飞速发展,多模态大语言模型(Multimodal Large Language Models, MLLMs)在处理视觉与语言结合的任务中展现出了巨大的潜力。这些模型能够同时理解图像和文本信息,从而在视觉问答、图像描述生成、场景理解等任务中取得显著成效。然而,当前MLLMs在面对需要组合多种视觉能力(如同时识别物体、计数、理解空间关系等)的复杂任务时,表现仍不尽如人意。这一局限部分源于视觉指令调整(Visual Instruction Tuning, VIT)这一关键训练步骤的传统做法。

VIT作为MLLMs训练中的一个重要环节,传统上侧重于扩大数据量,而忽视了训练样本的组合复杂性。这意味着,尽管模型可能接触到了大量的图像-文本对,但这些对往往只涉及单一的视觉能力,缺乏对多种能力组合的训练。因此,当模型遇到需要同时运用多种视觉能力的复杂任务时,其性能会显著下降。

研究目的

针对上述问题,本研究旨在提出一种新的数据调优方法——COMPACT(COMPOSITIONAL ATOMIC-TO-COMPLEX VISUAL CAPABILITY TUNING),以系统性地提升MLLMs在复杂视觉语言任务中的表现。具体而言,本研究的目标包括:

- 开发组合式视觉能力调优数据集:通过定义一组原子视觉能力,并将它们组合成具有不同组合复杂性的训练样本,生成一个专门用于训练MLLMs组合视觉能力的数据集。

- 提升模型在复杂任务中的表现:通过训练MLLMs在COMPACT数据集上,使其能够更有效地学习和整合多种视觉能力,从而在复杂视觉语言任务中取得更好的性能。

- 验证数据效率和模型泛化能力:通过对比实验,验证COMPACT数据集在数据效率上的优势,并评估模型在不同组合复杂性任务中的泛化能力。

研究方法

1. 原子视觉能力定义

本研究首先定义了10种原子视觉能力,这些能力涵盖了视觉理解的基本方面,包括属性识别(如颜色、形状)、识别(如物体识别、动作识别、文本识别、空间识别、计数)和关系(如空间关系、物体交互、场景理解)。每种能力都对应着模型在视觉理解中需要掌握的一项基本技能。

2. 数据集生成

COMPACT数据集的生成过程包括四个关键步骤:

- 能力采样:从预定义的原子视觉能力集中随机选择k(k∈{1,2,3})种能力。

- 对话生成:使用Gemini-2.0-Flash模型生成一个自然整合了所有选定能力的问答对,并附带一个表示问题质量的置信度分数。

- 质量验证:通过独立验证步骤确保生成的问答对满足质量要求,包括答案的准确性、问题的多样性以及能力要求的符合性。

- 数据集组装:将生成的组合调优数据与一小部分LLaVA-665K VIT数据结合,形成最终的COMPACT数据集。

3. 模型训练与评估

本研究使用LLaVA-v1.5-7B-LoRA模型作为基础模型,在其预视觉指令调优检查点上进行COMPACT数据集的训练。训练过程中,保持其他训练配置不变,仅替换训练数据集。评估阶段,使用多个多模态基准测试集来评估模型在复杂视觉语言任务中的表现,包括MM-Vet、MME、LLaVA-in-the-Wild等。

研究结果

1. 整体性能提升

实验结果表明,使用COMPACT数据集训练的模型在多个基准测试集上取得了与全尺寸LLaVA-665K VIT相当甚至更好的性能,而使用的数据量仅为后者的不到10%。特别是在涉及复杂多能力任务时,如MMStar和MM-Vet,COMPACT模型分别实现了83.3%和94.0%的显著改进。

2. 数据效率

通过对比不同规模组合调优数据下的模型性能,发现COMPACT模型在数据效率上具有显著优势。即使使用较少的数据量,COMPACT模型也能达到或超过使用大量随机数据训练的模型性能。这表明,通过精心设计训练样本的组合复杂性,可以有效提升模型的学习效率。

3. 泛化能力

在组合复杂性分析中,发现COMPACT模型在未见过的更高组合复杂性任务上仍能保持良好的性能。这表明,通过训练模型在多种组合复杂性任务上的表现,可以提升其泛化能力,使其能够更好地应对实际应用中的复杂场景。

研究局限

尽管COMPACT方法在提升MLLMs在复杂视觉语言任务中的表现方面取得了显著成效,但仍存在一些局限性:

-

数据生成成本:COMPACT数据集的生成依赖于Gemini-2.0-Flash等闭源模型,这不仅增加了数据生成的成本,还可能引入闭源模型的局限性和偏见。此外,数据生成过程本身也较为耗时。

-

知识密集型任务表现:尽管COMPACT在视觉中心任务上取得了显著改进,但在涉及大量世界知识或领域专长的任务上表现提升有限。这表明,COMPACT方法可能更适用于视觉理解本身,而对于需要广泛知识背景的任务,可能需要结合其他方法进行改进。

-

组合复杂性上限:当前COMPACT方法仅生成了最高组合复杂性为k=3的训练样本,对于更高复杂性的任务,闭源模型的可靠性降低,导致生成的数据质量下降。未来需要探索更高层次的组合复杂性或结合其他数据生成方法以进一步提升模型性能。

未来研究方向

针对COMPACT方法的局限性和当前研究的不足,未来研究可以从以下几个方面展开:

-

优化数据生成过程:探索更高效、更低成本的数据生成方法,减少对闭源模型的依赖。例如,可以开发开源的视觉指令调整模型,或者利用众包等方式收集高质量的训练数据。

-

拓展知识密集型任务表现:研究如何将COMPACT方法与知识图谱、预训练语言模型等结合,以提升模型在知识密集型任务上的表现。例如,可以通过引入外部知识库或设计特定的知识注入机制来增强模型的知识理解能力。

-

探索更高层次的组合复杂性:研究如何生成更高组合复杂性的训练样本,并探索相应的模型训练方法。例如,可以设计层次化的组合方法或混合数据生成流水线,结合多个数据源和验证步骤来提高数据质量。

-

评估模型的可解释性和鲁棒性:除了性能提升外,未来研究还应关注模型的可解释性和鲁棒性。通过开发新的评估方法和指标,可以更全面地了解模型在不同场景下的表现,并为其在实际应用中的部署提供更有力的支持。

综上所述,COMPACT方法为提升MLLMs在复杂视觉语言任务中的表现提供了一种新的思路和方法。通过精心设计训练样本的组合复杂性,可以有效提升模型的学习效率和泛化能力。未来研究可以进一步优化数据生成过程、拓展知识密集型任务表现、探索更高层次的组合复杂性,并评估模型的可解释性和鲁棒性,以推动MLLMs技术的进一步发展。