大模型Benchmark评估体系解析

一、Benchmark评估概述

Benchmark(基准测试)是大模型能力评估的核心方法论,通过标准化的测试集和评估指标,系统化衡量模型在不同任务上的表现。其核心价值在于:

能力量化:将模型能力转化为可比较的数值指标

技术导向:指引模型研发的优化方向

行业参考:为企业选型提供客观依据

主流评估Benchmark分类

| 类型 | 代表Benchmark | 评估重点 |

|---|---|---|

| 通用能力 | MMLU、C-Eval | 语言理解、常识推理 |

| 专业领域 | MedQA、LegalBench | 医学、法律等专业知识 |

| 安全伦理 | TruthfulQA、ToxiGen | 真实性、偏见、有害内容 |

| 中文能力 | CMMLU、GaokaoBench | 中文理解与本土知识 |

二、技术架构设计

1.典型评估系统架构

[测试数据集] → [评估引擎] → [结果分析]↑ ↑

[模型接口] [指标计算模块]2.核心组件

测试数据集构建

题目设计:涵盖不同难度层级和知识领域

答案标注:专家团队多轮校验

数据平衡:确保领域和题型分布合理

评估引擎

def evaluate(model, dataset):results = []for question, ref_answer in dataset:pred_answer = model.generate(question)score = calculate_score(ref_answer, pred_answer)results.append(score)return aggregate_results(results)指标计算

客观题:准确率、F1值

主观题:BLEU、ROUGE、人工评分

综合指标:加权平均分

三、关键技术实现

1.动态测试生成

难度自适应:根据模型表现调整题目难度

graph TDA[初始难度] --> B{正确率>阈值?}B -->|是| C[提升难度]B -->|否| D[保持难度]C --> E[最终能力等级]D --> E2.多维度评估

能力维度:语言、数学、逻辑等

场景维度:开放域、专业领域

安全维度:偏见、有害内容等

3.典型Benchmark实现

MMLU:涵盖57个学科的16000+题目

C-Eval:覆盖52个学科的中文评测集

HELM:全任务、多指标评估框架

四、未来展望

随着AI大模型技术持续突破,Benchmark评估体系将迎来重大变革,呈现三大发展趋势:

1.动态化评估体系

传统静态测试集将升级为持续演进的动态评估系统,通过实时数据流和对抗样本生成技术,构建"评估-模型"协同进化的生态系统,解决数据污染和过拟合问题。

2.多模态融合评估

新一代Benchmark将突破单一文本维度,整合视觉、语音、视频等多模态测试能力,开发跨模态联合评估框架,更全面反映模型真实智能水平。

3.可信评估技术突破

重点发展可解释评估方法、安全伦理量化指标和偏见检测工具,建立包含50+维度的"可信AI"评估矩阵,推动负责任AI发展。

未来评估系统的智能化升级,将使Benchmark从单纯的"测量工具"进化为指导AI发展的"战略罗盘",最终实现评估结果与人类认知标准的精准对齐。

要么驾驭AI,要么被AI碾碎

当DeepSeek大模型能写出比80%人类更专业的行业报告,当AI画师的作品横扫国际艺术大赛,这场变革早已不是“狼来了”的寓言。2025年的你,每一个逃避学习的决定,都在为未来失业通知书签名。

记住:在AI时代,没有稳定的工作,只有稳定的能力。今天你读的每一篇技术文档,调试的每一个模型参数,都是在为未来的自己铸造诺亚方舟的船票。

1.AI大模型学习路线汇总

L1阶段-AI及LLM基础

L2阶段-LangChain开发

L3阶段-LlamaIndex开发

L4阶段-AutoGen开发

L5阶段-LLM大模型训练与微调

L6阶段-企业级项目实战

L7阶段-前沿技术扩展

2.AI大模型PDF书籍合集

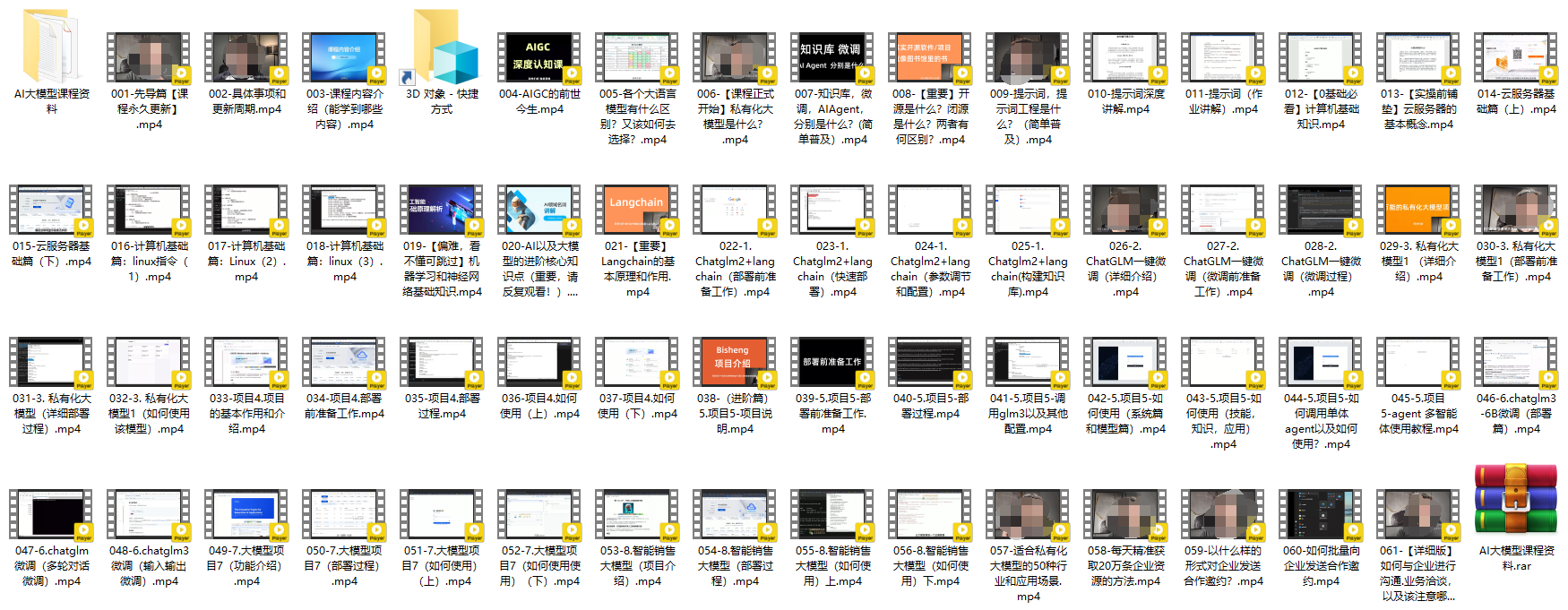

3.AI大模型视频合集

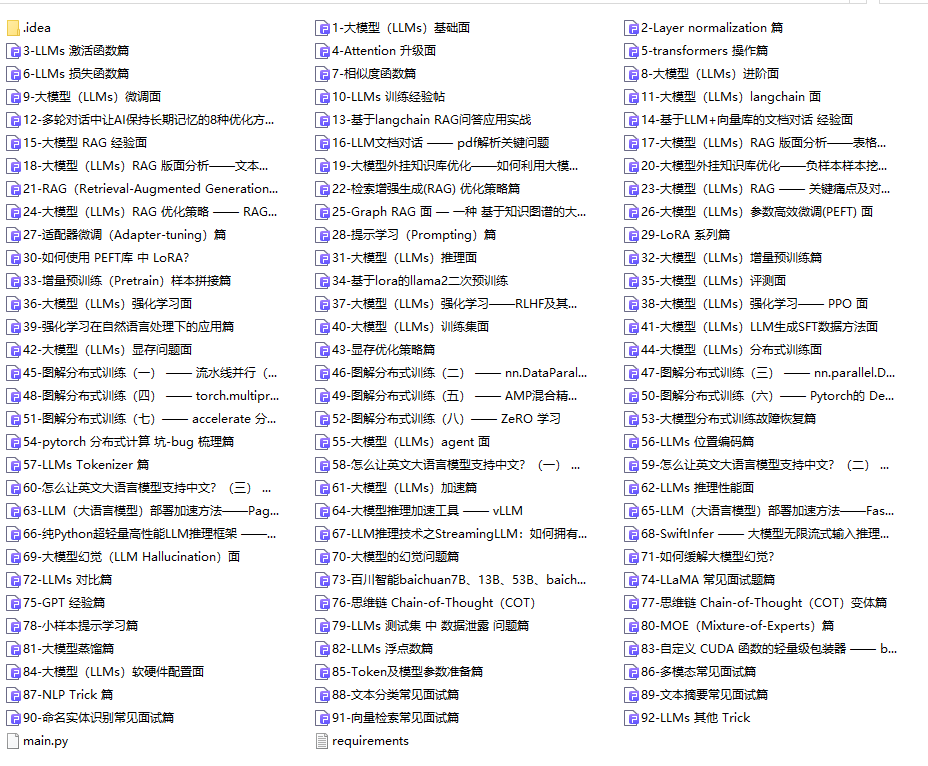

4.LLM面试题和面经合集

5.AI大模型商业化落地方案