广州知名网站推广app如何推广

系列文章目录

文章目录

- 系列文章目录

- @[TOC](文章目录)

- 摘要

- 一、引言

- 二、息肉分割建模

- 2.1 传统方法

- 2.2 深度学习方法

- 基于卷积神经网络(CNN)的方法:

- 1)ACSNet(MICCAI2020)

- 2) EUNet(CRV2021)

- 3) MSNet(MICCAI2021)--Important

- 4)PEFNet (MMM2023)

- 基于Transformer的方法:

- 1)MSRAformer(CBM2022)

- 2)DuAT(PRCV2023)--Important(皮肤癌+结肠息肉)

- 3)SSFormer(MICCAI2022)(皮肤癌+结肠息肉)

- 4)ColonFormer(2022MiT)

- 5)TransNetR(2023MIDL)

- 6)Polyp-PVT

- 混合方法:

- 1) TransFuse(2021MICCAI)--皮肤癌+结肠息肉+其他医学任务

- 2) LAPFormer(2022)

- 3) PPFormer(2022MICCAI)

- 4) HSNet(2022CBM)

- 2.3 边界感知model

- 1) FeDNet(2023BSPC)--important

- 2) BSCA-Net(2022PR)

- 3) BoxPolyp(2022MICCAI)--important:使用bounding box进行辅助分割

- 4) BDG-Net

- 5) ICBNet

- 6) CLD-Net

- 7) BANet

- 8) SFA

- 9) FCBFormer

- 2.4 注意力感知model

- 1) CASCADE

- 2) APCNet

- 3) RA-DENet

- 4) TGANet

- 5) LDNet

- 6) SANet

- 2.5 特征融合model

- 1) CFA-Net

- 2) EFB-Seg

- 3) MSRF-Net

- 4) DCRNet

- 5) PPNet

- 6) PraNet

- 7) PolypSeg

- 2.6 视频息肉分割

文章目录

- 系列文章目录

- @[TOC](文章目录)

- 摘要

- 一、引言

- 二、息肉分割建模

- 2.1 传统方法

- 2.2 深度学习方法

- 基于卷积神经网络(CNN)的方法:

- 1)ACSNet(MICCAI2020)

- 2) EUNet(CRV2021)

- 3) MSNet(MICCAI2021)--Important

- 4)PEFNet (MMM2023)

- 基于Transformer的方法:

- 1)MSRAformer(CBM2022)

- 2)DuAT(PRCV2023)--Important(皮肤癌+结肠息肉)

- 3)SSFormer(MICCAI2022)(皮肤癌+结肠息肉)

- 4)ColonFormer(2022MiT)

- 5)TransNetR(2023MIDL)

- 6)Polyp-PVT

- 混合方法:

- 1) TransFuse(2021MICCAI)--皮肤癌+结肠息肉+其他医学任务

- 2) LAPFormer(2022)

- 3) PPFormer(2022MICCAI)

- 4) HSNet(2022CBM)

- 2.3 边界感知model

- 1) FeDNet(2023BSPC)--important

- 2) BSCA-Net(2022PR)

- 3) BoxPolyp(2022MICCAI)--important:使用bounding box进行辅助分割

- 4) BDG-Net

- 5) ICBNet

- 6) CLD-Net

- 7) BANet

- 8) SFA

- 9) FCBFormer

- 2.4 注意力感知model

- 1) CASCADE

- 2) APCNet

- 3) RA-DENet

- 4) TGANet

- 5) LDNet

- 6) SANet

- 2.5 特征融合model

- 1) CFA-Net

- 2) EFB-Seg

- 3) MSRF-Net

- 4) DCRNet

- 5) PPNet

- 6) PraNet

- 7) PolypSeg

- 2.6 视频息肉分割

好累,还有十来篇论文明天再更新

摘要

早期检测和评估息肉在预防和治疗结直肠癌(Colorectal Cancer, CRC)中起着至关重要的作用。息肉分割为临床医生准确地定位和分割息肉区域提供了一种有效的解决方案。在过去,人们常常依赖于手动提取的低级特征,如颜色、纹理和形状,这些特征常常无法捕捉全局上下文,并且在复杂场景下缺乏鲁棒性。随着深度学习的出现,越来越多基于深度学习网络的医学图像分割算法不断涌现,在该领域取得了显著进展。本文对息肉分割算法进行了全面综述。我们首先回顾了一些基于手动提取特征的传统算法和基于深度学习的分割算法,然后描述了与该主题相关的基准数据集。具体而言,我们根据研究主题的重点和网络结构的差异,对基于息肉大小的最新深度学习模型和结果进行了全面评估。最后,我们讨论了息肉分割面临的挑战以及该领域的未来发展趋势。

一、引言

息肉分割旨在自动识别并分割出结肠内的息肉区域。其主要目标是协助临床医生高效且准确地定位和描绘这些区域,为结直肠癌(Colorectal Cancer, CRC)的早期诊断和治疗提供重要支持。息肉在不同发展阶段呈现出不同的大小和形状,由于它们与邻近器官或黏膜的强附着性,其精确分割面临挑战。

在早期,息肉分割主要依赖于手动提取的特征。例如,Tajbakhsh 等人提出了一种利用形状特征和周围环境信息来自动检测结肠镜视频中息肉的方法。Iwahori 等人则利用边缘和颜色信息生成似然图,并提取了方向梯度直方图特征。然而,依赖手动提取的低级特征进行分割任务,使其在处理复杂场景时较为困难,且无法有效利用全局上下文信息。

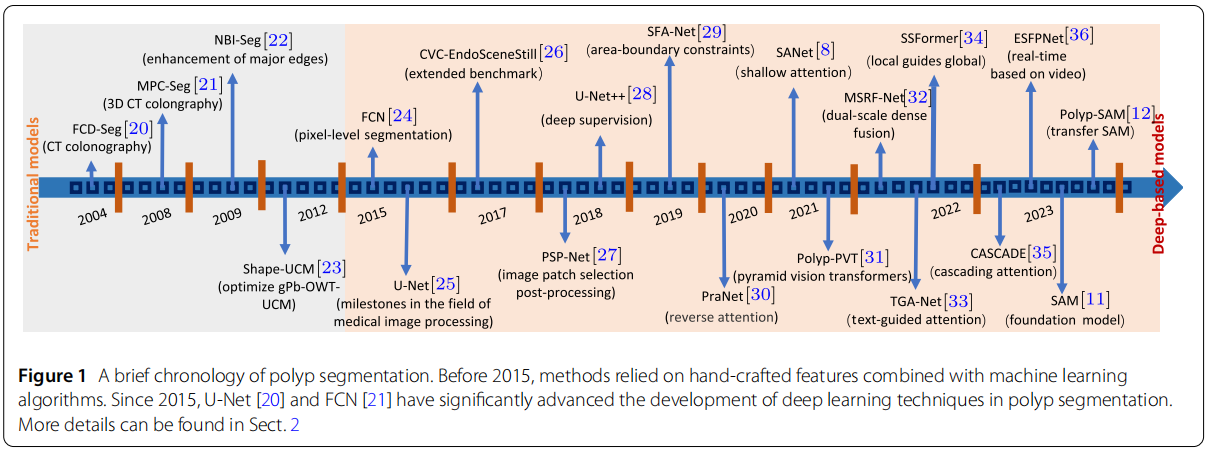

近年来,基于深度学习的息肉分割模型在定位和分割息肉区域方面展现出了令人印象深刻的能力。基于编码器-解码器架构,一些研究专注于增强编码器的输出特征。此外,来自不同设备收集的数据集之间的差异也是一个问题。在分割任何事物模型(Segment Anything Model, SAM)出现之后,基于通用分割网络的细粒度模型在息肉分割方面展现出了良好的发展势头。为了更清晰地描述息肉分割任务的进展,我们在图1中展示了一个简洁的时间线。

现有的综述通常会提供关于息肉分割、定位和检测方法的系统性统计数据,或者回顾不同解剖区域(如腹部、心脏、大脑和肺部)的医学图像分割[14-19]。与以往关于息肉分割或医学图像分割的综述不同,本文旨在提供一个全面的息肉分割方法综述,涵盖传统的算法和基于深度学习模型的方法。我们分别讨论传统方法和基于深度学习的方法。根据模型结构的独特设计,我们将深度模型分为边界感知模型、注意力感知模型和特征融合模型。我们讨论每种方法的优势,并提供关于它们各自适用性和性能特征的宝贵见解。在第2节中,我们从不同方面回顾了现有的息肉分割模型。在第3节中,我们总结并提供了当前用于息肉分割的公开数据集的详细信息和使用情况。然后,在第4节中,我们对不同大小息肉的分割性能进行了全面评估,并分析了几种代表性息肉分割模型的优缺点。之后,在第5节中,我们讨论了该领域发展的挑战和未来趋势。最后,我们在第6节中总结了本文。

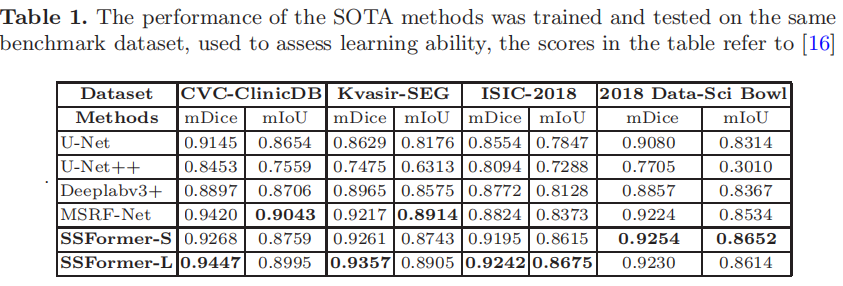

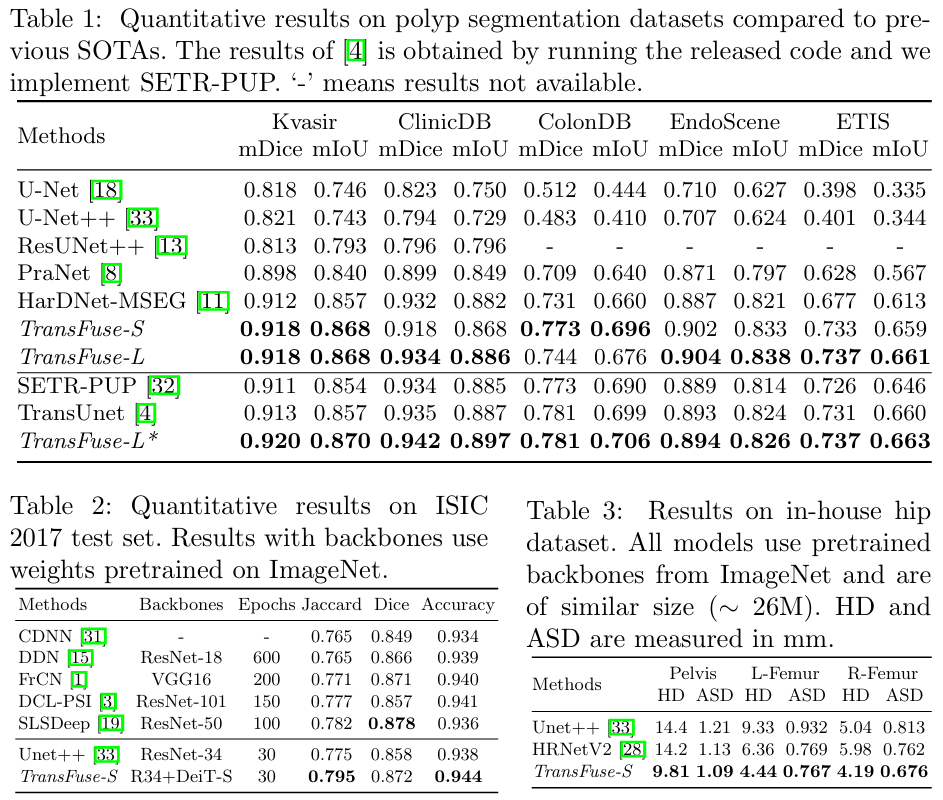

二、息肉分割建模

近期的息肉分割研究利用流行深度学习方法取得了显著成果。相比之下,早期的方法主要依赖于手动设计的特征来实现息肉分割。这些模型的总结可以在表1和表2中找到。为了全面回顾这些息肉分割算法,我们将从传统模型、深度模型、边界感知模型、注意力感知模型、特征融合模型几个方面进行介绍。

- 传统模型:它们主要依赖于手动设计的特征,如颜色、纹理和形状信息来构建算法。

- 深度模型:深度学习模型能够自动学习深度特征,这使它们能够处理非结构化和复杂的数据,并赋予它们更强大的表达能力。

- 边界感知模型:边缘信息在提供边界提示以提升分割性能方面至关重要。因此,我们将讨论一些现有模型中边缘信息的应用。

- 注意力感知模型:对息肉分割研究中使用的不同注意力策略的分析,为未来工作中注意力模块的潜在设计提供了见解。

- 特征融合模型:多级特征的整合和增强可以显著提升模型性能。因此,我们研究了息肉分割模型中特征融合策略的有效性。

2.1 传统方法

早期的研究主要依赖于手动设计的特征,如颜色、纹理和形状,然后运用传统机器学习技术进行启发式建模。例如,Yao 等人提出了一种自动息肉分割方法,该方法结合了知识引导的强度调整、模糊C均值聚类和可变形模型。Lu 等人提出了一种三阶段概率二元分类方法,该方法整合了低级和中级信息,用于在3D CT结肠造影中分割息肉。Gross 等人研究了一种通过多尺度滤波增强主要边缘的分割算法。Ganz 等人利用窄带成像(NBI)中息肉形状的先验知识来优化gPbOWT-UCM的固有尺度选择。这种优化旨在通过纳入息肉的形状信息来实现更好的分割结果。

2.2 深度学习方法

然而,上述方法受到手动特征有限的信息表示能力的限制。它们缺乏泛化能力,不适合大规模部署。接下来,我们将回顾一些在息肉分割领域具有代表性的基于深度学习的方法。

基于卷积神经网络(CNN)的方法:

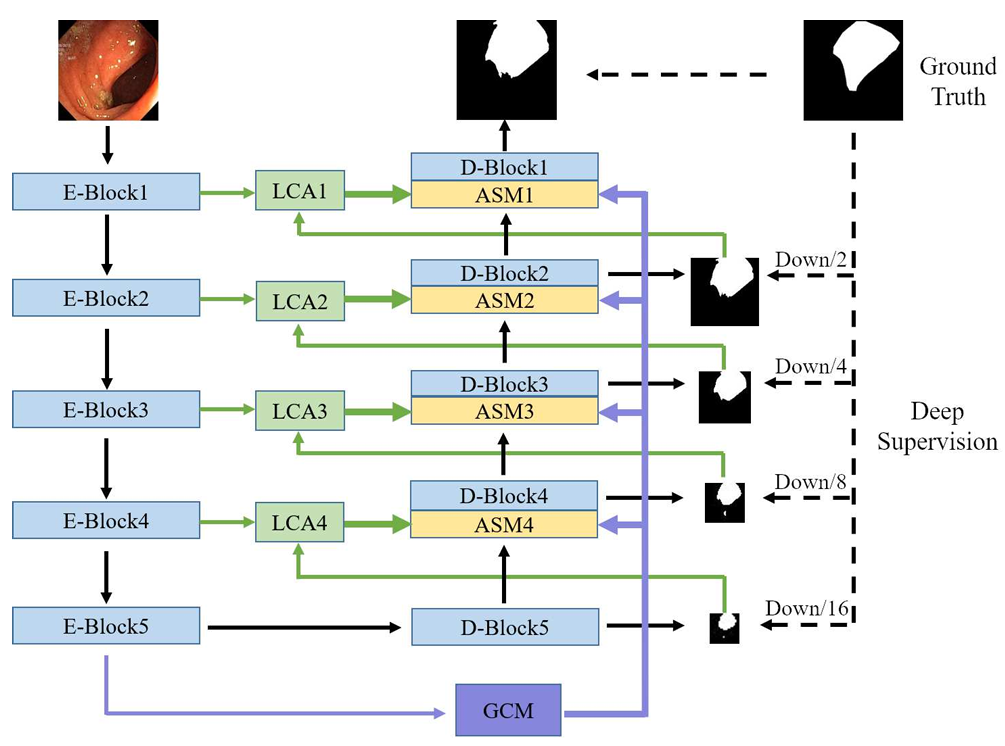

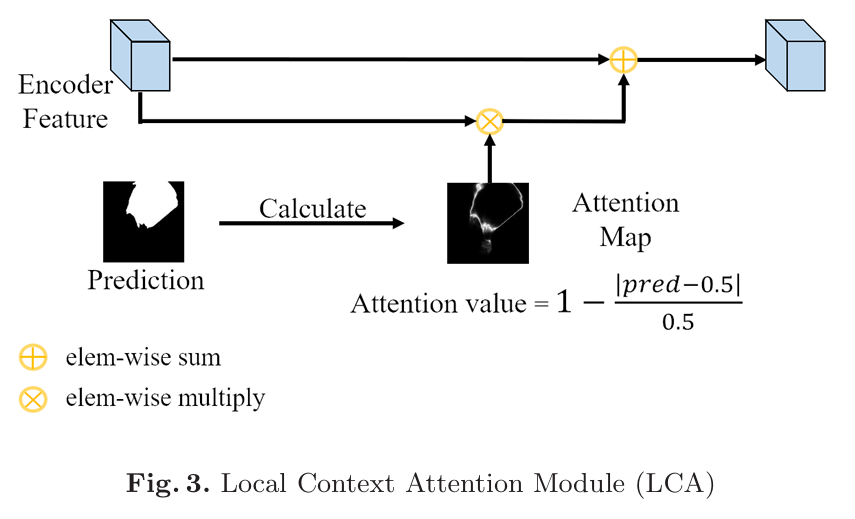

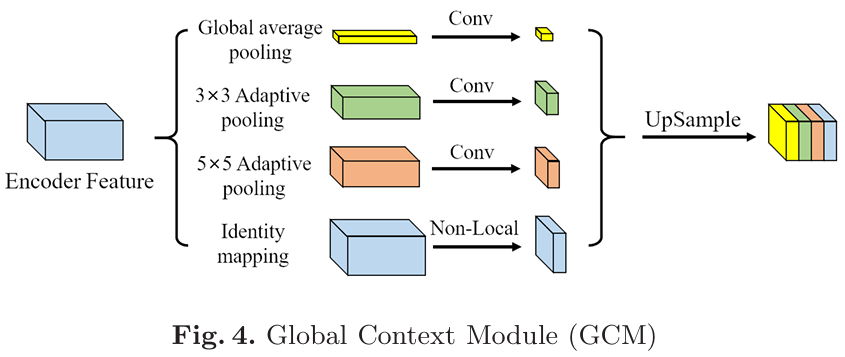

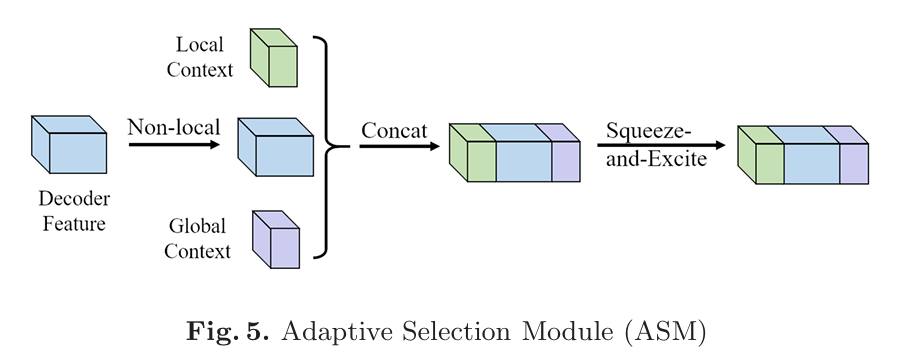

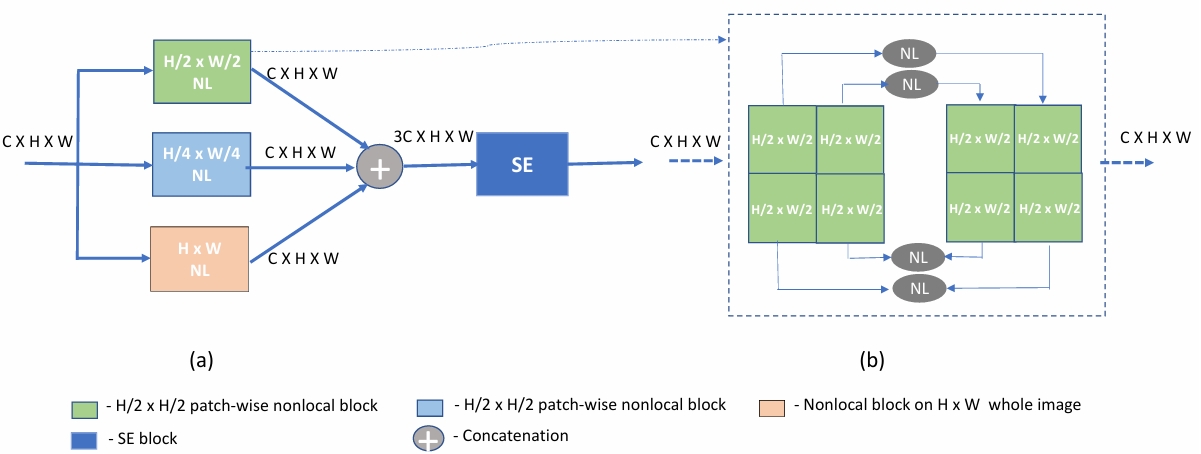

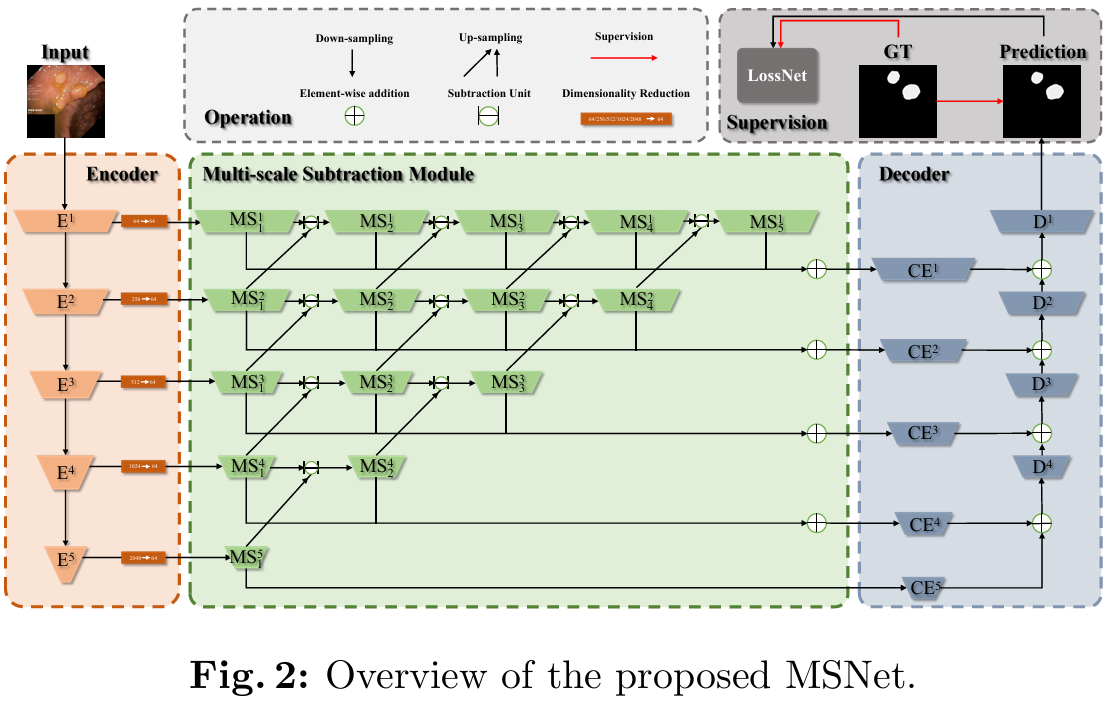

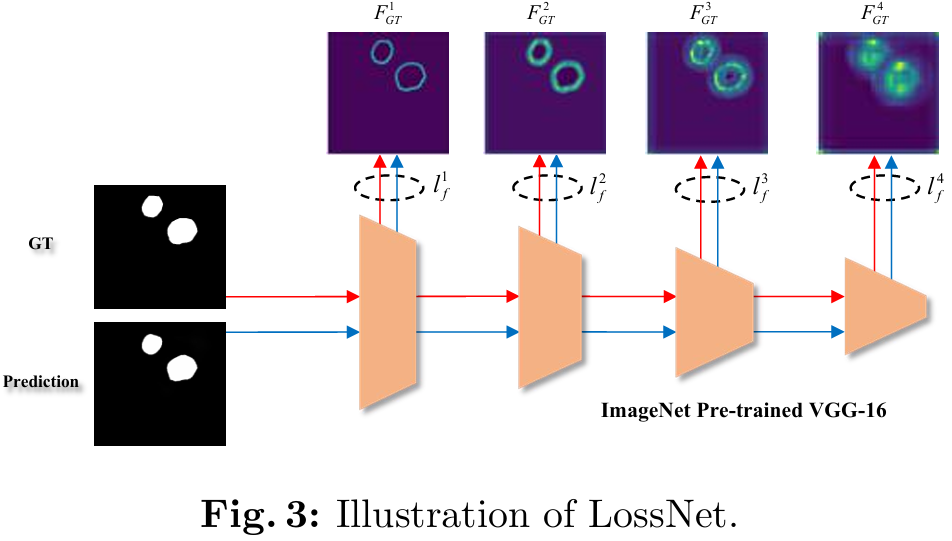

得益于卷积神经网络(CNN)的发展,尤其是U-Net [20] 的引入,许多受此架构启发的模型都展现出了令人期待的结果。ACSNet [25] 将U-Net中的跳跃连接修改为局部上下文提取模块,并添加了一个全局信息提取模块。特征被整合后,再基于通道注意力策略进行自适应选择。EU-Net [31] 是一种增强型的U-Net框架,它增强了语义信息,并引入了一个自适应全局上下文模块来提取关键特征。MSNet [9] 设计了一个减法单元,用于生成相邻层之间的差异特征,并为其配备了不同感受野的金字塔结构,以捕获多尺度信息。此外,它还引入了LossNet来监督每一层的感知特征。PEFNet [71] 在融合阶段使用了改进的U-Net,并嵌入了新的位置特征信息。得益于丰富的定位信息和连接特征,该模型在息肉分割中实现了更高的准确性和通用性。。

1)ACSNet(MICCAI2020)

- 结构:

如图所示,ACSNet是一个标准的UNet架构,在UNet中加入了LCA、ASM和GCM模块,其中LCA的作用是使用反向注意力机制(经典Pranet中使用)进行边界细化,这个信息被称为本地信息。GCM的作用是将feature输入进并行的,卷积核不同的卷积模块中,提取不同大小息肉的特征,这个信息被称为全局信息。ASM的作用就是简单的把本地信息和全局信息以及feature map结合在一起。

2) EUNet(CRV2021)

- 论文

- 结构

主要的创新其实是他的自适应提取机制(打比方就是,A模块要得到B模块的补充信息,以往的model是直接将Bmodel的信息一股脑倒给A,具体要用哪些信息由A自己找。自适应提取器就是A告诉B我需要哪些信息,B找好后再给A)。但是该论文最重要的创新模块没有画框架图,其余的框架图画的也很一言难尽。。。。。

感兴趣的建议看VIT-Comer,最起码这个画的清楚还有代码。

3) MSNet(MICCAI2021)–Important

- 论文

- 摘要

大多数现有方法基于U型结构,使用逐元素相加或连接操作在解码器中逐步融合不同层次的特征。然而,这两种操作都容易产生大量冗余信息,这会削弱不同层次特征之间的互补性,导致息肉定位不准确和边缘模糊。为应对这一挑战,我们提出了一种用于从结肠镜图像中分割息肉的多尺度减法网络(MSNet)。具体来说,我们首先设计了一个减法单元(SU),用于生成编码器中相邻层次之间的差异特征。然后,我们将不同层次的SUs配备不同感受野,以金字塔方式排列,从而获得丰富的多尺度差异信息。此外,我们构建了一个无需训练的网络LossNet,以全面监督从底层到顶层的息肉感知特征,促使MSNet同时捕捉细节和结构线索。

这个net的思想很新颖,尤其是loss net有点像图像风格迁移领域的概念,使用一个cnn网络来比较不同图像的差异,但是很好奇loss net是否真的有用

一般来说,编码器中不同层次的特征具有不同特点。高层次特征包含更多语义信息,有助于定位目标;低层次特征包含更多细节信息,能够捕捉目标的细微边界。解码器利用特定层次和跨层次的特征来生成最终的高分辨率预测。然而,上述方法直接使用逐元素相加或连接操作来融合编码器中的任意两个层次特征,并将其传输到解码器。这些简单操作并未更多关注不同层次之间的差异信息。这一缺点不仅产生了冗余信息以稀释真正有用的特征,还削弱了特定层次特征的特性,导致网络无法平衡精准的息肉定位和细微的边界细化。

在本文中,我们提出了一种用于息肉分割任务的新型多尺度减法网络(MSNet)。我们首先设计了一个减法单元(SU),并将其应用于每对相邻层次特征。为解决息肉的尺度多样性问题,我们以金字塔方式连接多个SUs以捕捉大跨度的跨层次信息。然后,我们在解码器中聚合特定层次特征和多路径跨层次差异特征,以生成最终预测。此外,我们提出了一个LossNet,以自动监督从底层到顶层的提取特征图,这可以通过简单的L2损失函数从细节到结构优化分割。我们的主要贡献可以总结如下:

- 我们提出了一种用于自动息肉分割的新型多尺度减法网络。通过多级和多阶段级联减法操作,可以从不同层次中有效获取从低阶到高阶的互补信息,从而全面增强对息肉区域的感知。

- 我们构建了一个通用的无需训练的损失网络,以在特征层面实施从细节到结构的监督,这为基于预测本身的损失设计提供了重要补充。

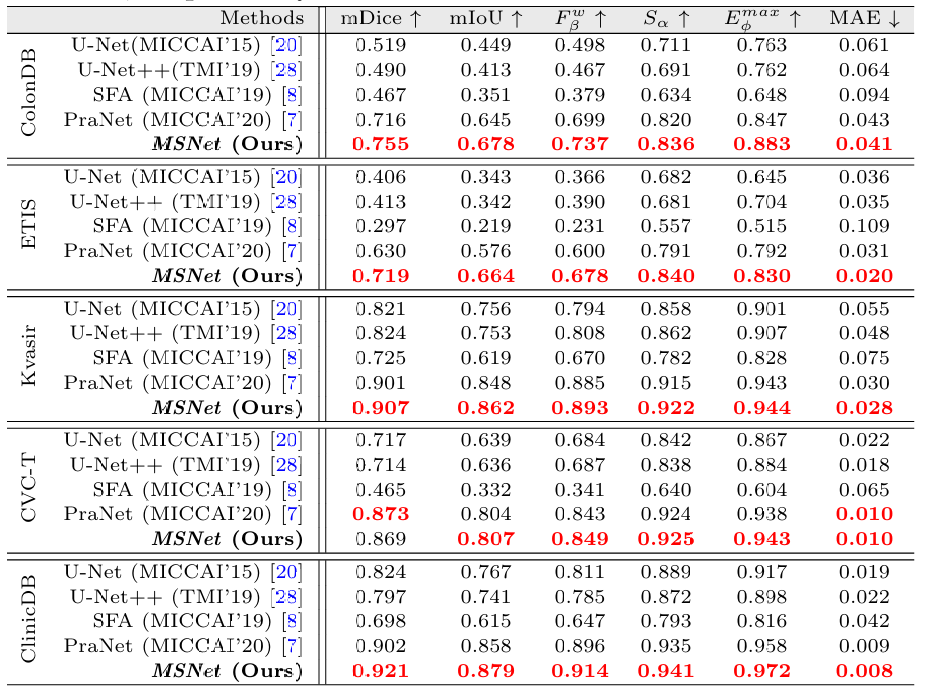

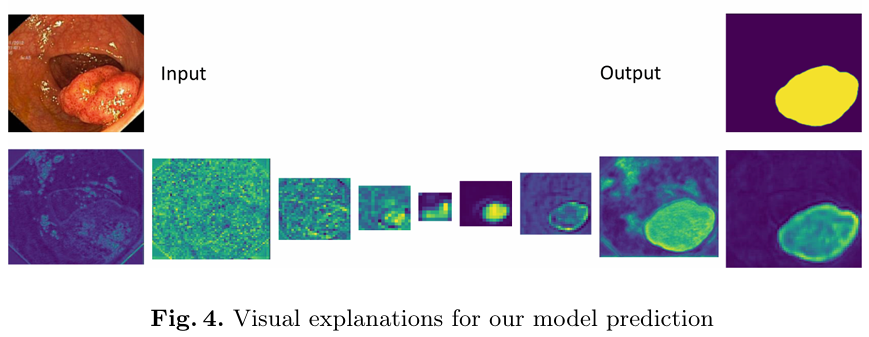

- 如图1所示,所提出的MSNet能够精准地分割息肉。广泛实验表明,在五个具有挑战性的数据集上,我们的MSNet在不同评估指标下大幅提升了最先进的方法,并且具有70fps的实时推理速度。

4)PEFNet (MMM2023)

以往的方法由于缺乏细节和前一层的知识,无法将编码器中的信息完全传递到解码器。为解决这一问题,我们提出了PEFNet,这是一种使用改进的UNet的新模型,在合并阶段加入了新的位置嵌入特征(PEF)模块,在息肉分割方面具有更高的准确性和泛化能力。PEF模块利用位置信息、连接特征和提取特征来丰富所获得的知识,并提高模型的理解能力。

U型结构因其在医学分割方面的能力而受到广泛关注。在U型结构中,编码器和解码器之间的跳跃连接显著减少了丢失的空间信息。然而,跳跃连接上的信息尚未得到足够关注,许多最近的方法仍需更高效地调查跳跃连接上的足够信息。简单跳跃连接方案的关键问题是无法有效增强来自低级编码器特征和高级解码器特征的组合信息。

在本文中,我们提出了PEFNet,它通过定义跳跃连接中信息传递的新方式来解决分割问题。更具体地说,我们提出的架构将EfficientNetV2骨干网络与位置嵌入特征(PEF)模块相结合,增强了跳跃连接特征。PEF的关键思想是利用位置嵌入技术为跳跃连接中的融合特征提供位置信息。

基于Transformer的方法:

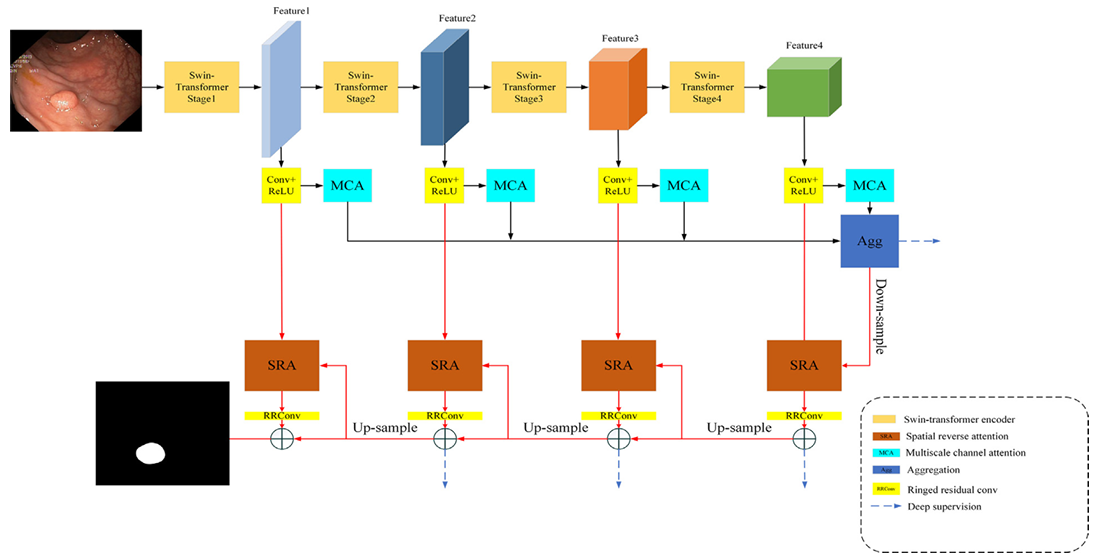

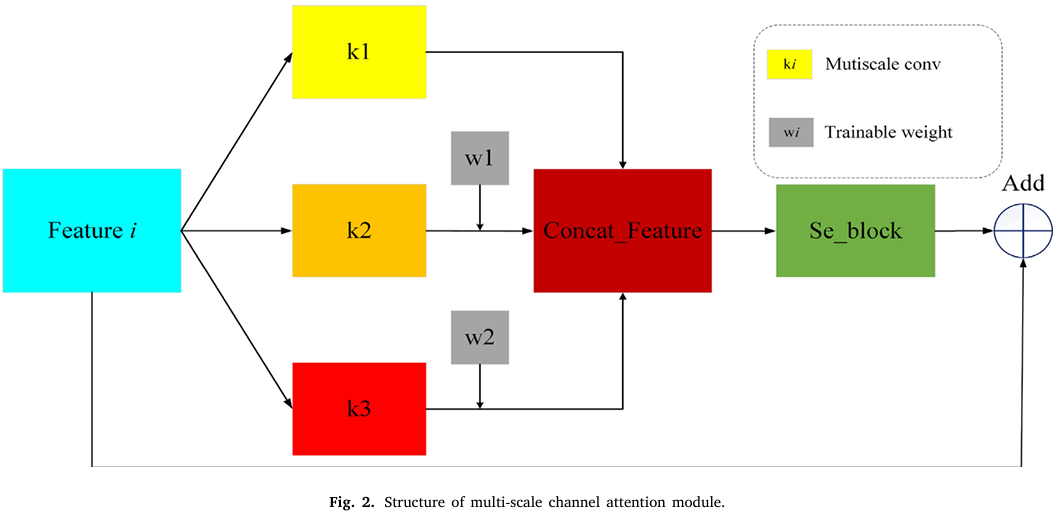

CNN在捕获长距离依赖关系方面存在局限性。然而,最初在自然语言处理领域流行起来的Transformer模型已经被引入到计算机视觉领域。它在捕获长距离依赖关系方面的优势引发了视觉Transformer的研究趋势。MSRAformer [45] 采用具有金字塔结构的Swin Transformer作为编码器,在不同阶段提取特征,并利用多尺度通道注意力模块提取多尺度特征信息。DuAT [62] 是一种用于息肉分割的双聚合Transformer网络,它聚合了全局和局部空间特征,并定位多尺度目标。SSFormer [54] 将PVTv2 [80] 和Segformer作为编码器,同时引入了一种新颖的渐进式局部解码器。这个解码器专门设计用于补充金字塔Transformer主干,通过强调局部特征并减轻注意力分散来实现。ColonFormer [51] 采用基于Transformer的轻量级架构作为编码器,并在解码器中使用分层网络结构来学习多级特征。TransNetR [73] 是一种基于Transformer的残差网络,包括一个预训练的编码器、三个解码器块和一个上采样层,展现出出色的实时处理速度和多中心泛化能力。Polyp-PVT [33] 级联聚合高级语义和位置信息,使用相似性聚合模块将高级特征扩展到整个区域。

1)MSRAformer(CBM2022)

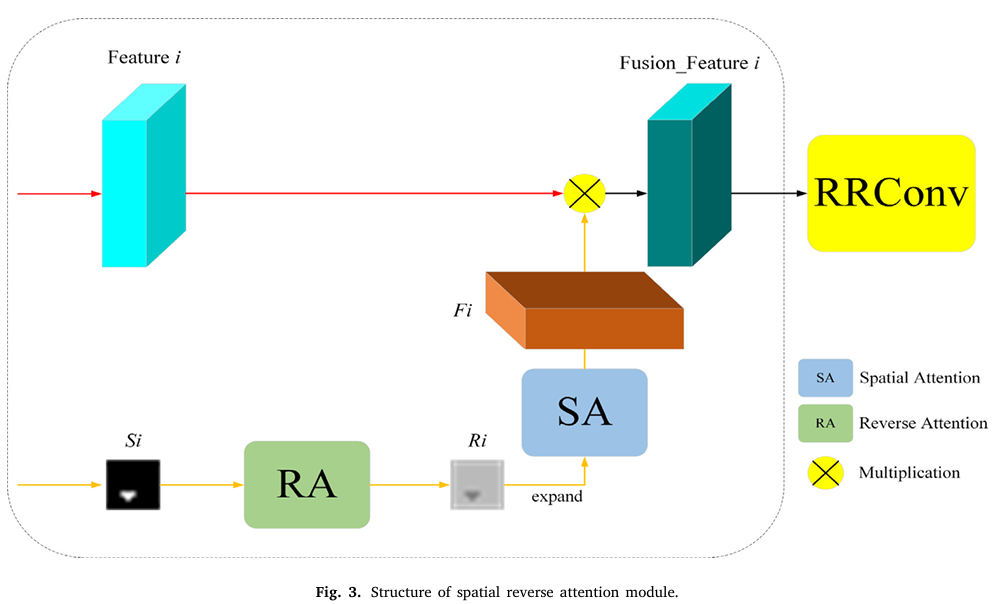

CNN侧重于局部特征的提取,缺乏提取全局特征信息的能力。本文提出了一种在医学分割方面性能优异的多尺度空间反向注意力网络,称为MSRAformer,它采用具有金字塔结构的Swin Transformer编码器来提取四个不同阶段的特征,并通过多尺度通道注意力模块提取多尺度特征信息,增强了网络的全局特征提取能力和泛化能力,并初步聚合了一个预分割结果。本文提出了一个空间反向注意力机制模块,以逐步补充息肉区域的边缘结构和细节信息。

结肠镜图像中息肉的形状、大小、质地和颜色存在巨大差异,很难区分息肉区域与黏膜的边界。因此,结肠镜图像中的息肉分割仍然是一个具有挑战性的任务。结肠镜息肉图像的手动分割需要专家的合作,这非常耗时,不同的专家可能对同一病变区域是否被归类为癌变有不同的看法,因此手动分割和病变区域的评估效率低下,无法保证质量。计算机辅助自动医学图像分割方法提供了一种更高效、准确和高质量的医学图像分割方案,并减少了诊断过程中资源和人力的消耗。近年来,一些基于CNN的模型被设计用于结肠镜息肉分割。尽管取得了一些成果,但CNN结构单一,感受野固定,对长距离信息的建模能力有限,难以提取息肉的多样化外观特征,在提取形状多样且结构简单的息肉时容易过拟合。本文设计了一个基于金字塔Swin Transformer编码器、多尺度通道注意力模块和空间反向注意力机制的模型来解决上述问题。最后一段话把这个论文的创新点概括完了,没什么特别新颖的

2)DuAT(PRCV2023)–Important(皮肤癌+结肠息肉)

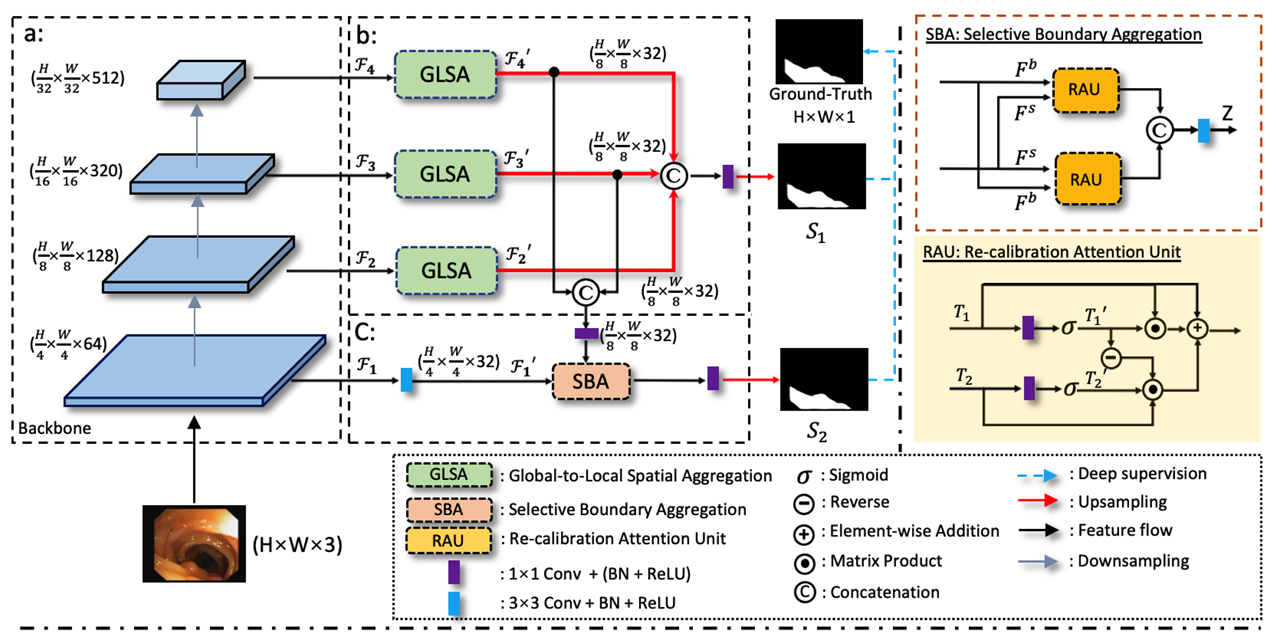

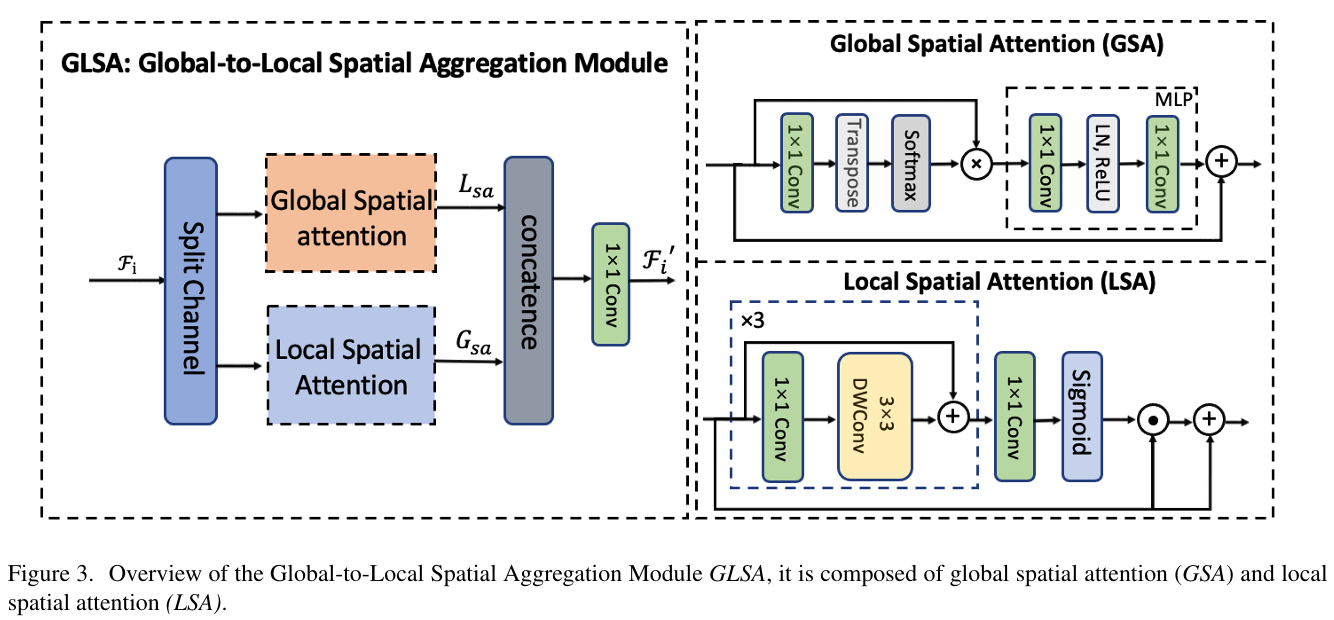

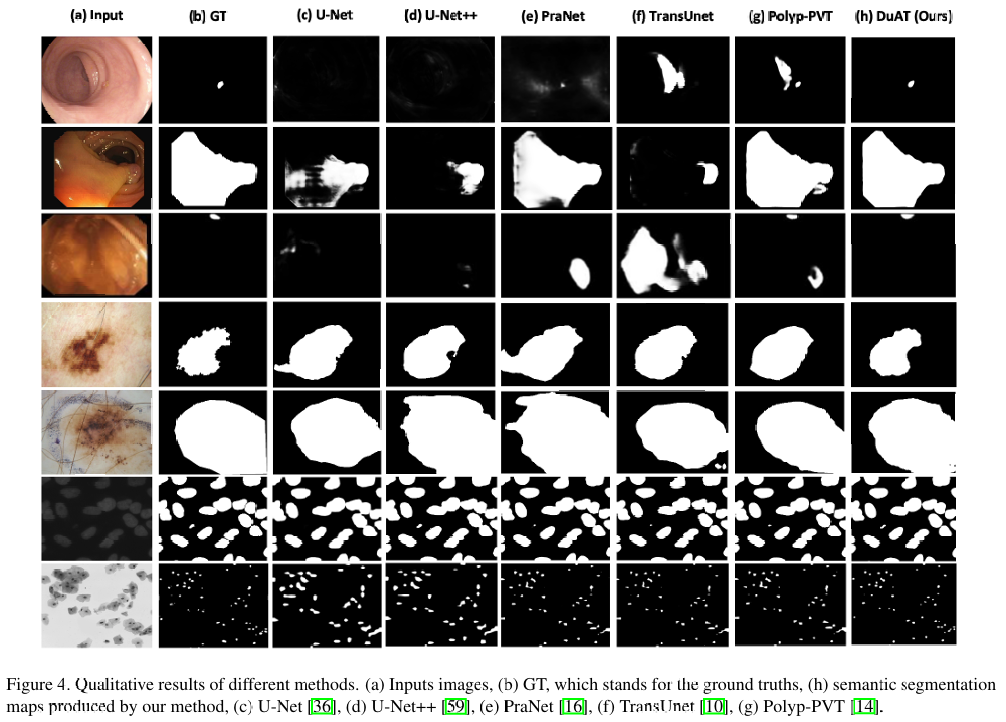

基于 Transformer 的模型通过建模长距离依赖关系和捕获全局表示,在计算机视觉任务中取得了显著的成功。然而,这些模型通常受到大模式特征的主导,导致丢失局部细节(例如边界和小目标),而这些细节在医学图像分割中至关重要。为了解决这一问题,我们提出了一种名为 DuAT 的双聚合 Transformer 网络,其特点在于两个创新设计,即全局到局部空间聚合(GLSA)和选择性边界聚合(SBA)模块。GLSA 具备聚合和表示全局和局部空间特征的能力,分别有助于定位大目标和小目标。SBA 模块用于聚合低层次特征中的边界特征和高层次特征中的语义信息,以更好地保留边界细节并重新校准目标。在六个基准数据集上的广泛实验表明,我们提出的模型在皮肤病变图像和结肠镜图像中息肉的分割方面优于最先进的方法。此外,我们的方法在各种具有挑战性的情况(如小目标分割和模糊目标边界)中比现有方法更具鲁棒性

图1展示了医学图像的主要挑战。挑战1:小目标分割由于对比度低和伪装性强难以分割。挑战2:由于图像采集的影响,医学图像中目标的边界不清晰。从皮肤镜图像中分割皮肤病变是皮肤癌诊断和治疗计划中的一个关键步骤。艾玛,看得我密集恐惧症犯了,拿表情包挡一挡

医学图像分割是一种计算机辅助的自动程序,用于提取感兴趣区域(RoI),例如组织、病变和身体器官。它可以通过使诊断和治疗过程更加高效和精确来协助临床医生。例如,结肠镜检查是检测结直肠病变的黄金标准,准确地定位早期息肉对于直肠癌的临床预防具有重要意义。同样,黑色素瘤皮肤癌是全球增长最快的癌症之一。从皮肤镜图像中分割皮肤病变是皮肤癌诊断和治疗计划中的一个关键步骤。然而,在临床实践中手动标注这些结构是不切实际的,因为这个过程繁琐、耗时且容易出错。因此,对于自动且准确的图像分割的需求日益增长。

最近的研究表明,金字塔结构适用于Transformer,并且更适合各种下游任务。不幸的是,捕获长距离依赖关系会破坏部分局部特征,这可能导致小目标的预测过于平滑,以及目标之间的边界变得模糊。因此,构建一个保留局部和全局特征的模型仍然是一个挑战。Li等人探索了局部上下文,以便更准确地将聚合的长距离关系分布在局部区域…

在本文中,我们提出了一个用于医学图像分割的新型金字塔Transformer,称为双聚合Transformer网络(DuAT),包括全局到局部空间聚合(GLSA)以结合局部和全局特征,以及选择性边界聚合(SBA)模块以增强边界信息并重新校准目标。我们相信全局空间特征有助于定位大目标,局部空间特征对于识别小目标至关重要。最后,聚合边界信息以微调目标边界并重新校准粗略预测。具体来说,GLSA模块负责从主干中提取和融合局部和全局空间特征。我们将通道分开,一个用于由全局上下文(GC)块提取的全局表示,另一个用于由多个深度卷积提取的局部信息。SBA模块旨在模拟生物视觉感知过程,将目标与背景区分开来。具体来说,它结合了浅层和深层特征,以建立身体区域和边界之间的关系,增强边界特征。**我们的实验结果表明,我们的模型具有三个优势:比以前的最先进的方法更轻量级、更好的学习能力和改进的泛化能力。**总之,本文的主要贡献是三方面的…。在五个息肉数据集(ETIS、CVC-ClinicDB、CVC-ColonDB、EndoScene-CVC300、Kvasir)、皮肤病变数据集(ISIC-2018)和2018年数据科学碗上的广泛实验表明,所提出的DuAT方法推进了最先进的(SOTA)性能。

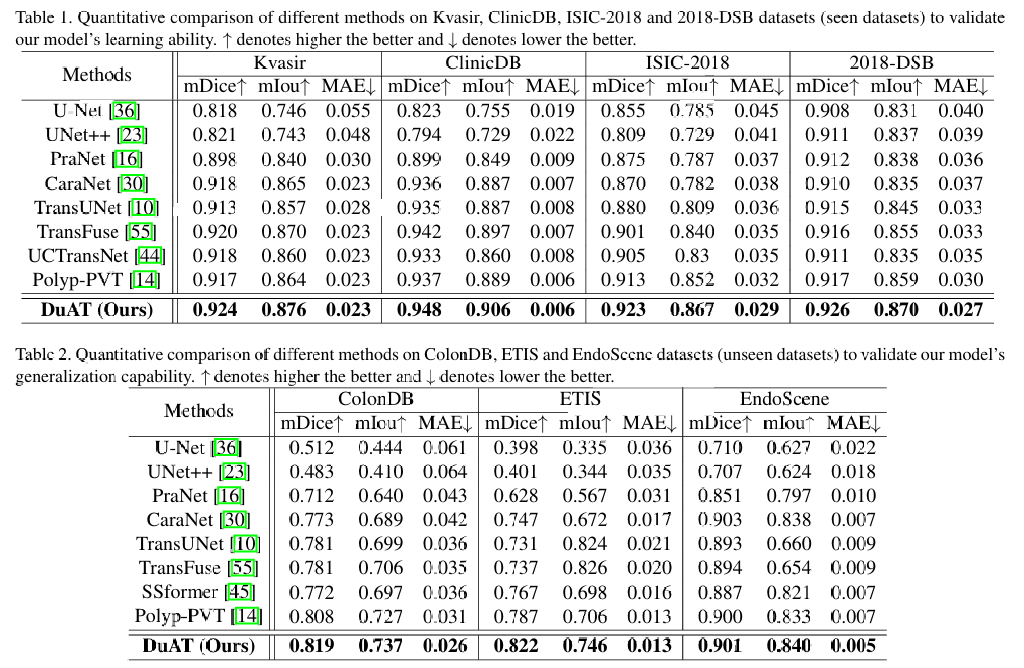

表 1. 在 Kvasir、ClinicDB、ISIC-2018 和 2018-DSB 数据集(已见数据集)上对不同方法进行定量比较,以验证我们模型的学习能力。表示越高越好,表示越低越好。

表 2. 在 ColonDB、ETIS 和 EndoScene 数据集(未见数据集)上对不同方法进行定量比较,以验证我们模型的泛化能力。表示越高越好,表示越低越好。

3)SSFormer(MICCAI2022)(皮肤癌+结肠息肉)

由于结肠息肉的大小不一和复杂的形态特征,以及息肉与黏膜之间不清晰的边界,准确地分割息肉仍然是一个挑战。深度学习因其在准确分割息肉任务中取得的出色成果而变得流行。然而,由于息肉图像的结构和息肉形状的变化,现有的深度学习模型很容易对当前数据集过拟合。因此,该模型可能无法处理未见过的结肠镜数据。为了解决这个问题,我们提出了一种新的最先进的医学图像分割模型SSFormer,该模型使用金字塔Transformer编码器来提高模型的泛化能力。具体来说,我们提出的渐进式局部解码器可以适应金字塔Transformer主干,以强调局部特征并限制注意力分散。SSFormer在学习和泛化评估方面均达到了最先进的性能。

由于CNN模型的自上而下的建模方法以及息肉形态的多样性但息肉图像结构相对简单,该模型缺乏泛化能力,难以处理未见的数据集。为了提高深度学习模型的泛化能力,我们将Transformer架构引入息肉分割任务中。Transformer就能处理从未见过的数据集了??感觉很牵强的说法。

本文的主要贡献如下:1)我们将金字塔Transformer架构引入息肉分割任务,以增强神经网络的泛化能力;2)我们提出了一个新的解码器PLD,适用于Transformer特征金字塔,可以平滑且有效地强调Transformer中的局部特征,提高神经网络对详细信息的处理能力;3)我们提出的SSFormer在ETIS基准测试、CVC-ClinicDB基准测试和Kvasir基准测试中的SOTA性能分别提高了约3%、1.8%和1%。此外,SSFormer在2018年数据科学碗和ISIC-2018基准测试中也取得了SOTA和卓越的性能

实验表明,Transformer 浅层部分获得的局部特征的充分性直接影响模型的性能。然而,我们认为现有的 Transformer 模型缺乏处理局部和详细信息的能力,难以专注于关键的详细特征(如轮廓、血管和纹理)。因此,这使得模型难以定位更具决定性的局部特征分布(黏膜可以被视为由独特的血管和纹理等局部特征组成的分布)。

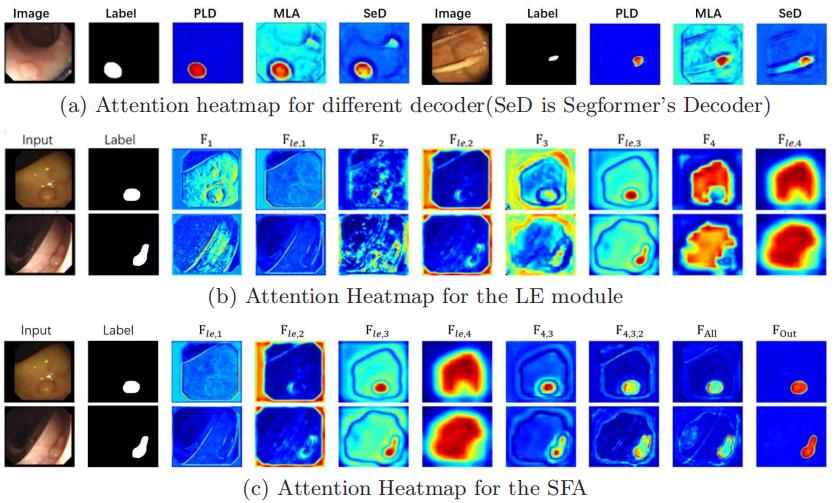

图 2. 特征流通过 PLD 过程的注意力热图。图 (a) 显示 LE 模块成功地将模型的注意力集中在关键细节上。图 (b) 显示 SFA 结构有效地逐步约束模型混乱的注意力,使其聚焦于关键区域。Attention Heatmap

忍不住吐槽,怎么就和这几个model比???

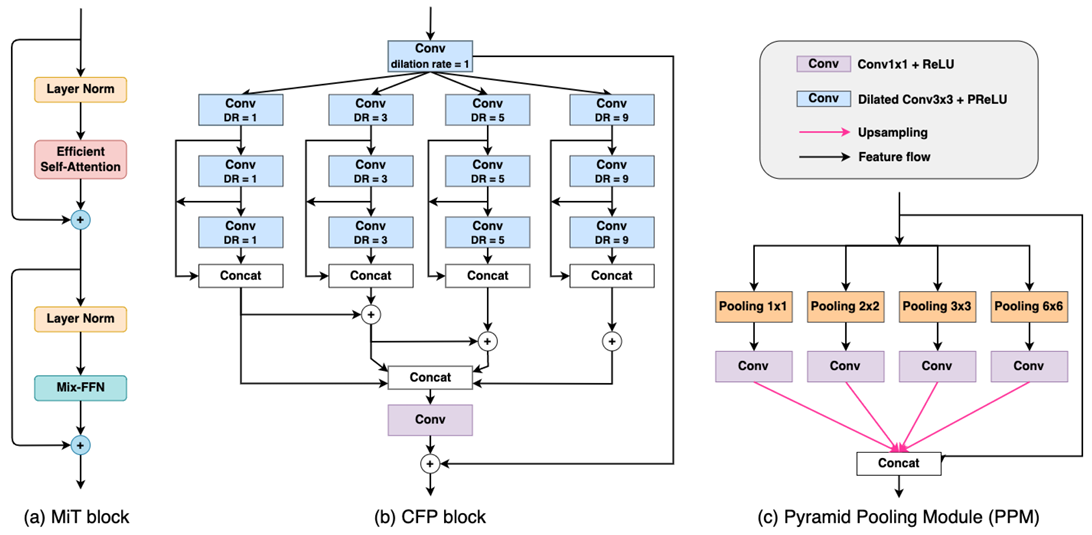

4)ColonFormer(2022MiT)

在计算机辅助临床支持系统中,自动分析内窥镜图像以识别息肉是一项具有挑战性的任务。**基于卷积神经网络(CNN)、Transformer及其组合的模型已被提出用于息肉分割,并取得了有希望的结果。然而,这些方法要么仅能建模息肉的局部外观,要么在解码过程中缺乏用于空间依赖性的多级特征表示。**本文提出了一种新的网络,即 ColonFormer,以解决这些限制。ColonFormer 是一种编码器-解码器架构,能够在编码器和解码器分支中建模长距离语义信息。编码器是一种基于 Transformer 的轻量级架构,用于在多尺度上建模全局语义关系。解码器是一种分层网络结构,旨在学习多级特征以丰富特征表示。此外,添加了一个带有新跳跃连接技术的细化模块,以在全局图中细化息肉对象的边界,从而实现准确分割。已在五个流行的息肉分割基准数据集(包括 Kvasir、CVC-Clinic DB、CVC-ColonDB、CVC-T 和 ETIS-Larib)上进行了广泛的实验。实验结果表明,我们的 ColonFormer 在所有基准数据集上的表现均优于其他最先进的方法。

尽管CNN在分割任务中被广泛使用,并取得了令人印象深刻的性能,但它们存在某些局限性:由于感受野有限,它们只能捕获局部信息,而忽略空间上下文和全局信息。此外,研究表明CNN像一系列高通滤波器一样工作,更倾向于高频信息。

Transformer[9]是一种最近提出的深度神经网络架构,它使用注意力机制对输入组件之间的全局交互进行建模。虽然最初是为了处理自然语言和语音问题而设计的,但Transformer在近年来对计算机视觉产生了重大影响。与CNN不同,Transformer中的自注意力层作为低通滤波器工作,它们可以有效地捕获长距离依赖关系。

我们的ColonFormer的主要设计也包含一个Transformer编码器和一个CNN解码器,但我们的方法在几个方面与上述模型不同。在ColonFormer中,编码器是一个分层结构的轻量级Transformer,用于学习多尺度特征。解码器是一个分层金字塔结构,能够从包含来自不同尺度和子区域的编码器块的特征图的异构数据中学习。此外,我们提出了一个细化模块,以进一步提高对困难区域和小息肉的分割精度。

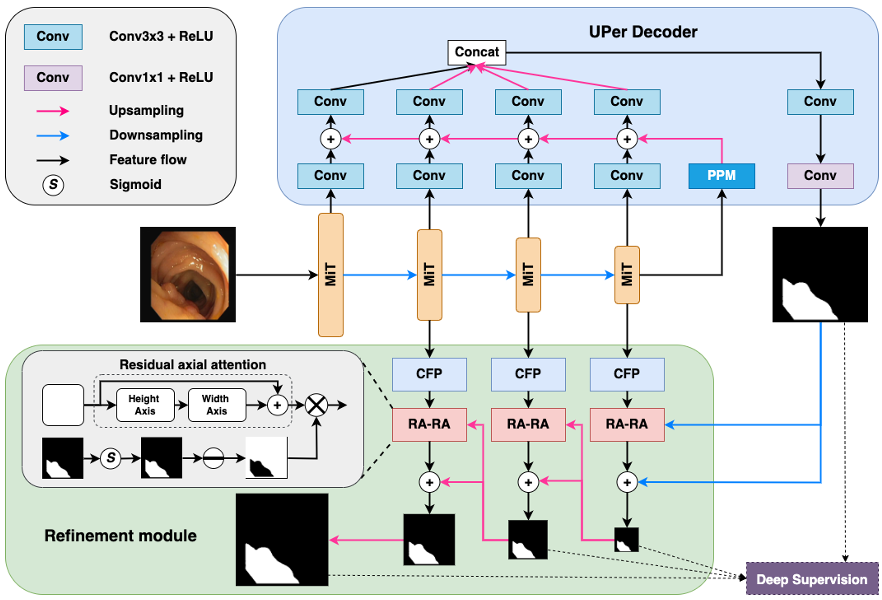

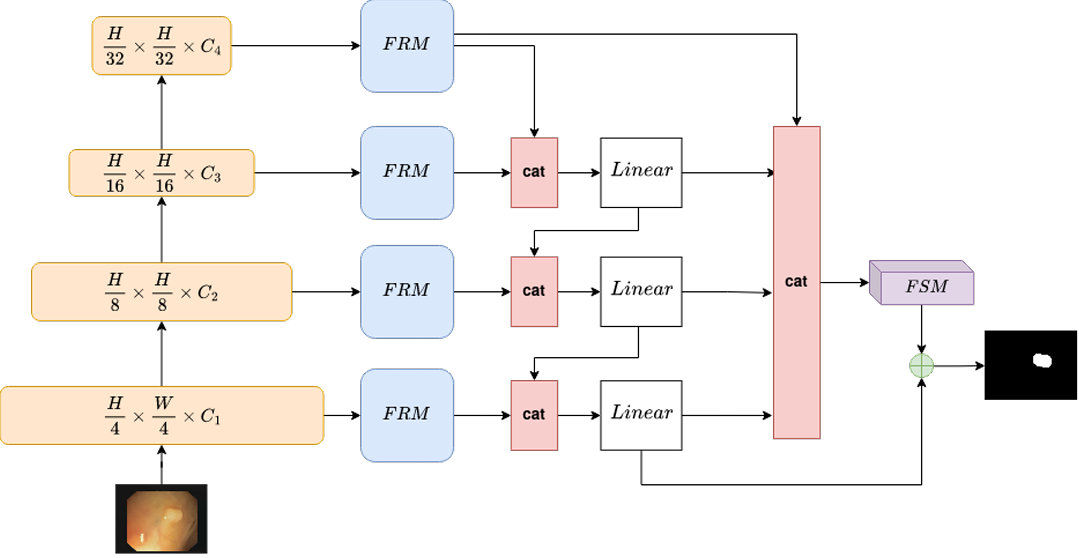

图1:我们的ColonFormer的整体架构包含三个部分:编码器、解码器和细化模块。编码器基于Mix Transformer主干。解码器从金字塔池化模块(PPM)开始,其输出与编码器在多层的输出特征图逐层结合,以产生全局图。细化模块旨在逐步细化全局图的边界,以产生最终准确的分割。除了这个预测输出外,全局图和两个中间图也以深度监督的方式传递到训练损失中。在计算训练损失之前,所有细化的图都被上采样回原始图像输入大小。

5)TransNetR(2023MIDL)

现有的自动化方法在实现实时处理速度方面效率低下。此外,当在不同患者数据(尤其是来自不同中心的数据)上进行评估时,它们的性能会显著下降。因此,我们打算开发一种新的基于实时深度学习的架构,即基于 Transformer 的残差网络(TransNetR),用于结肠息肉分割,并评估其诊断性能。… 这项工作的主要贡献在于通过在分布外(测试分布未知且与训练分布不同)数据集上测试所提出的算法,探索 TransNetR 的泛化能力。作为一个用例,我们在 PolypGen(6 个独特中心)数据集和另外两个流行的息肉分割基准数据集上测试了我们提出的算法。很疑惑,这也是贡献吗?这不是最常见的实验方法吗?好了,结束,鉴定为灌水文

首先,该过程依赖于操作者的经验,以及由于结肠镜回撤速度较快而忽视息肉的风险。其次,息肉在外观上的高度变化,如颜色、大小和形状,进一步使检测任务复杂化。第三,模糊的息肉边界与周围黏膜之间缺乏强烈的对比,使息肉在其他内腔结构中伪装起来(Fan等人,2021年)。这些挑战性因素表明需要自动化系统来执行息肉分割,这可以补充胃肠科医生检测和描绘息肉边界的能力,以实现准确切除。

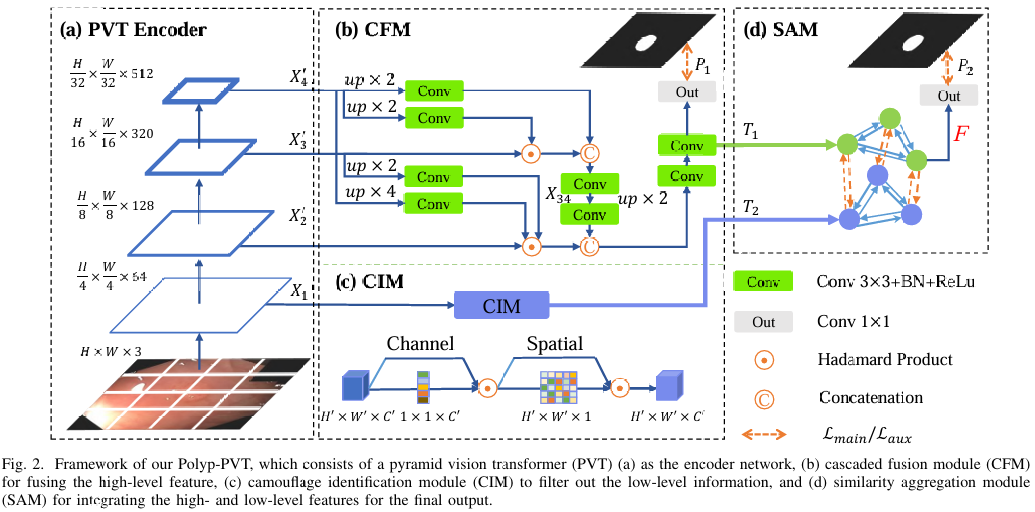

6)Polyp-PVT

大多数息肉分割方法以卷积神经网络(CNN)作为骨干网络,这在编码器和解码器之间传递信息时导致了两个关键问题:一是不同层次特征的贡献存在差异,二是需要设计有效的特征融合机制。与现有的基于CNN的方法不同,我们采用了Transformer编码器,能够学习到更强大且鲁棒的特征表示。此外,考虑到图像获取的影响以及息肉难以捉摸的特性,我们引入了三个标准模块,包括级联融合模块(CFM)、伪装识别模块(CIM)和相似性聚合模块(SAM)。其中,CFM用于从高级特征中收集息肉的语义和位置信息;CIM用于捕捉隐藏在低级特征中的息肉信息;SAM则将息肉区域的像素特征与高级语义位置信息相结合,并将其扩展到整个息肉区域,从而有效地融合了跨层次的特征。我们提出的模型名为Polyp-PVT,能够有效地抑制特征中的噪声,并显著提高其表达能力。在五个广泛采用的数据集上进行的大量实验表明,与现有的代表性方法相比,该模型对各种具有挑战性的情况(例如外观变化、小目标、旋转等)更具鲁棒性。提出的模型可在https://github.com/DengPingFan/Polyp-PVT获取。

尽管这些方法与传统方法相比在准确性和泛化能力方面有了很大的提高,但它们在定位息肉边界方面仍然面临挑战,原因如下:(1)图像噪声。在数据收集过程中,镜头在肠道内旋转,以从不同角度获取息肉图像,这也导致了运动模糊和反射问题。因此,这大大增加了息肉检测的难度;(2)伪装。息肉的颜色和纹理与周围组织非常相似,对比度低,为它们提供了强大的伪装特性[11],[12],使它们难以识别;(3)多中心数据。当前模型难以泛化到具有不同领域/分布的多中心(或未见)数据。

为了解决上述问题,本文的贡献如下:我们提出了一个名为Polyp-PVT的新型息肉分割框架。与现有的基于CNN的方法不同,我们采用金字塔视觉Transformer作为编码器来提取更强大的特征。为了支持我们的框架,我们引入了三个简单的模块。具体来说,级联融合模块(CFM)通过逐步集成从高级特征中收集息肉的语义和位置信息。同时,伪装识别模块(CIM)应用于捕捉隐藏在低级特征中的息肉线索,使用注意力机制更多地关注潜在的息肉,减少低级特征中的错误信息。我们进一步引入了配备有非局部和卷积图层的相似性聚合模块(SAM),以挖掘息肉区域的局部像素和全局语义线索。最后,我们在五个具有挑战性的基准数据集上进行了广泛的实验,包括Kvasir-SEG[13]、ClinicDB[8]、ColonDB[10]、Endoscene[14]和ETIS[9],以评估所提出的Polyp-PVT的性能。在ColonDB上,我们的方法实现了0.808的平均Dice(mDic),比现有的最先进的方法SANet[7]高出5.5%。在ETIS数据集上,我们的模型实现了0.787的平均Dice(mDic),比SANet[7]高出3.7%。

混合方法:

此外,许多模型结合了CNN和Transformer的优势,同时捕获局部上下文信息和长距离依赖关系,从而显著提高了分割性能。TransFuse [37] 并行结合了Transformer和CNN分支。它采用自注意力机制和多模态融合机制来整合不同分支的特征,并使用空间注意力来增强局部细节。LAPFormer [55] 采用分层Transformer编码器和CNN解码器。此外,它引入了一个渐进式特征融合模块来整合多尺度特征,并加入了特征细化模块和特征选择模块来进行特征处理。PPFormer [56] 采用浅层CNN编码器和深层基于Transformer的编码器来提取特征。HSNet [46] 利用由Transformer和CNN网络组成的双分支结构来捕获长距离依赖关系和局部外观细节。Fu-TransHNet [68] 设计了一个新颖的特征融合模块,充分利用从CNN和Transformer网络获得的局部和全局特征。

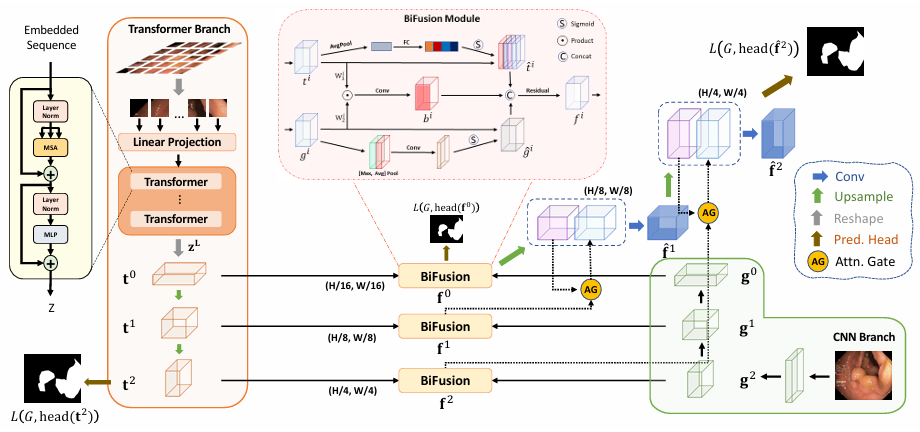

1) TransFuse(2021MICCAI)–皮肤癌+结肠息肉+其他医学任务

由于卷积神经网络(CNN)的最新进展而得到了显著发展。然而,它在建模明确的长距离关系方面表现出一般的局限性,现有的解决方案,即构建深度编码器并结合激进的下采样操作,导致了冗余的深度网络和局部细节的丢失。因此,分割任务亟待一个更好的解决方案,以提高建模全局上下文的效率,同时保持对低级细节的牢固掌握。在本文中,我们提出了一个新颖的并行分支架构TransFuse,以应对这一挑战。TransFuse以并行的方式结合了Transformer和CNN,可以在更浅的层次上高效地捕获全局依赖和低级空间细节。此外,我们还创建了一种新颖的融合技术——BiFusion模块,以高效地融合来自两个分支的多级特征。广泛的实验表明,TransFuse在包括息肉、皮肤病变、髋关节和前列腺分割的2D和3D医学图像集上实现了最新的最先进的结果,并显著减少了参数数量,提高了推理速度。

卷积神经网络(CNN)在众多医学图像分割任务中取得了无与伦比的性能[9,12],例如多器官分割、肝脏病变分割、大脑3D MRI等,因为它们被证明能够通过端到端地训练网络来构建层次化的任务特定特征表示。尽管基于CNN的方法取得了巨大的成功,但其在捕捉全局上下文信息方面的效率不足仍然是一个挑战。感知全局信息的机会与效率的风险相当,因为现有的工作通过生成非常大的感受野来获得全局信息,这需要连续地进行下采样并堆叠卷积层,直到足够深。这带来了几个缺点:1)非常深的网络训练受到特征重用减少问题[23]的影响,低级特征被连续的乘法运算冲淡;2)对于密集预测任务(例如像素级分割)至关重要的局部信息被丢弃,因为空间分辨率逐渐降低;3)用小的医学图像数据集训练参数繁重的深网络往往不稳定且容易过拟合。…

…尽管Transformer擅长建模全局上下文,但在捕捉细粒度细节方面表现出局限性,特别是对于医学图像。我们独立发现,类似SETR的纯Transformer基础分割网络由于缺乏建模局部信息的空间归纳偏差(也在[4]中报告)而产生不令人满意的性能。

为了享受两者的优点,人们已经在将CNN与Transformer结合起来方面做出了努力,例如…以往的工作主要集中在用Transformer层替换卷积或以顺序方式堆叠两者。为了进一步发挥CNN加Transformer在医学图像分割中的力量,在本文中,我们提出了一个不同的架构TransFuse,它并行运行浅层CNN基础编码器和基于Transformer的分割网络,然后通过我们提出的BiFusion模块将来自两个分支的特征融合在一起以共同进行预测。TransFuse具有几个优点:1)可以有效地捕捉低级空间特征和高级语义上下文;2)不需要非常深的网络,这缓解了梯度消失和特征重用减少的问题;3)它在模型大小和推理速度上大大提高了效率,使得不仅可以在云端而且可以在边缘进行部署。据我们所知,TransFuse是第一个合成CNN和Transformer的并行分支模型。实验表明,它与其他竞争的SOTA作品相比具有优越的性能。

2) LAPFormer(2022)

我们的主要贡献包括:

- 我们提出了一个轻量且准确的息肉分割Transformer,称为LAPFormer,它集成了分层Transformer主干作为编码器。

- 为LAPFormer提出了一个新颖的解码器,该解码器利用多尺度特征,并包括特征细化模块和特征选择模块,以产生精细的息肉分割掩码。

- 广泛的实验表明,我们的LAPFormer在CVC-ColonDB上实现了最先进的性能,并在不同的著名息肉分割基准测试中取得了有竞争力的结果,同时比其他基于Transformer的方法计算复杂度更低。

。。。。灌水文,pass

3) PPFormer(2022MICCAI)

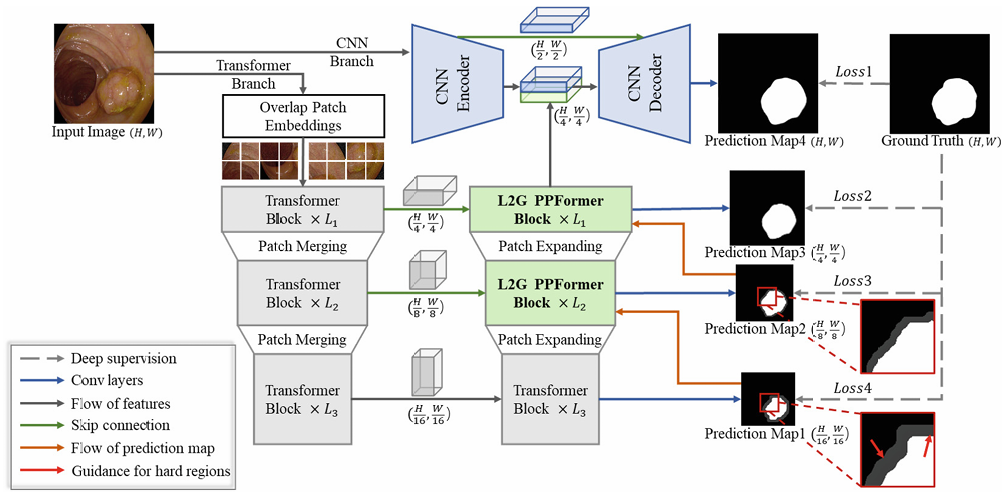

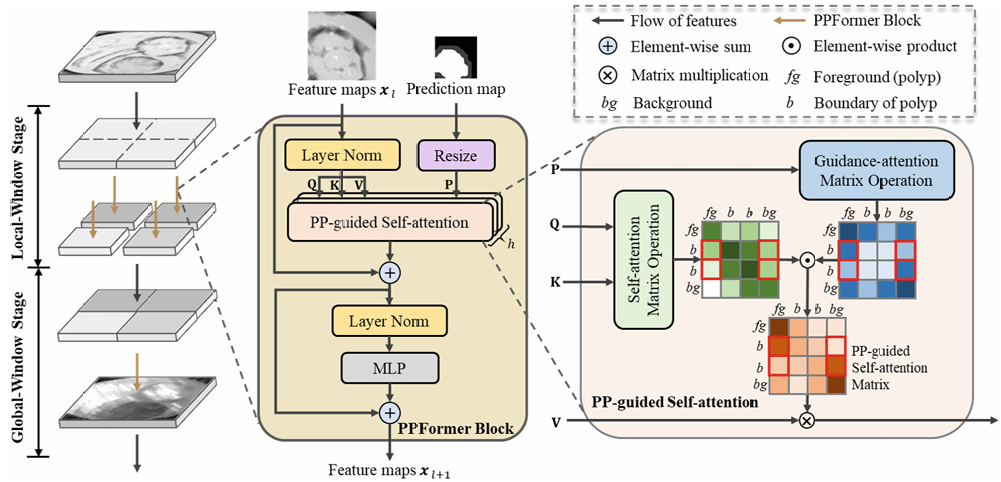

自动且精确的息肉分割对于结直肠癌的早期诊断至关重要。现有的息肉分割方法大多基于卷积神经网络(CNN),它们通常利用全局特征通过精心设计的模块来增强局部特征,从而应对息肉的多样性。尽管基于CNN的方法取得了令人印象深刻的结果,但它们在建模明确的长距离关系方面显得无能为力,这限制了它们的性能。与CNN不同,Transformer由于自注意力机制而具有强大的长距离关系建模能力。然而,自注意力总是将注意力分散到意想不到的区域,并且Transformer的局部特征提取能力不足,导致定位不准确和边界模糊。为了解决这些问题,我们提出了PPFormer以实现准确的息肉分割。具体来说,我们首先采用浅层CNN编码器和深层Transformer编码器来提取丰富的特征。在解码器中,我们提出了PP引导的自注意力机制,该机制使用预测图来引导自注意力集中在困难区域,以增强模型对息肉边界的感知。同时,设计了从局部到全局的机制,以鼓励Transformer在局部窗口中捕获更多信息,从而更好地定位息肉。在五个具有挑战性的数据集上进行的广泛实验表明,PPFormer优于其他高级方法,并在六个指标上实现了最先进的结果,即平均Dice和平均IoU。

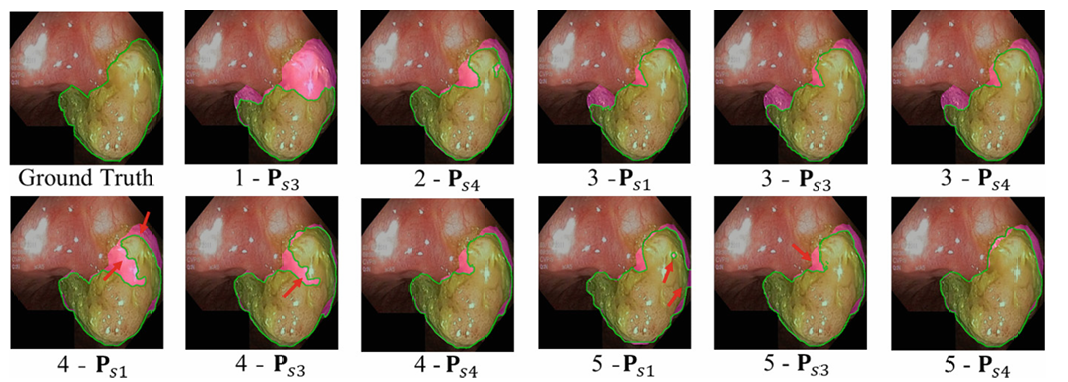

图1. 注意力图的说明。(a)是输入图像,感兴趣的像素用“+”标记。(b)是真实情况。(c)显示了PP引导的自注意力所学习的注意力图。(d)展示了普通自注意力所学习的注意力图。

为此,我们提出了PPFormer,以利用Transformer进行息肉分割任务。PPFormer是一个编码器-解码器框架,其中编码器由深层Transformer分支和浅层CNN分支组成,以便提取丰富的特征。对于自注意力问题,我们提出了PP引导的自注意力,该注意力使用预测图引导自注意力集中在困难区域。为了准确定位息肉,我们引入了从局部到全局(L2G)机制,使Transformer获得更多的局部特征。此外,L2G机制可以促进PP引导的自注意力的边界定位。总之,我们的主要贡献包括:(1)我们提出了PPFormer,用于准确的息肉分割,它利用了Transformer的长距离建模能力和CNN的局部特征提取。(2)我们提出了PP引导的自注意力,以增强模型对息肉边界的感知。(3)设计了L2G机制,以在局部窗口中捕获更多信息,从而更好地定位息肉。(4)广泛的实验表明,PPFormer优于其他先进的息肉分割方法,并在五个具有挑战性的数据集上取得了最先进的(SOTA)结果。

图2展示了所提出的PPFormer的整体架构。其中,(H_n) 和 (W_n) 表示图像或特征图的尺寸,(L_i) 表示Transformer模块的数量。在PPFormer中,Patch Merging通过卷积层合并图像块并增加特征维度,而Patch Expanding则对块进行上采样并减小其特征维度。

图3展示了L2G(从局部到全局)PPFormer模块的结构。在PP引导的自注意力中,红色框表示边界与目标区域之间的关系。(彩色图在线展示)

图5. 消融研究的视觉比较。数字对应于表2中的设置。粉色区域表示结果与真实情况之间的差异。(彩色图在线展示)

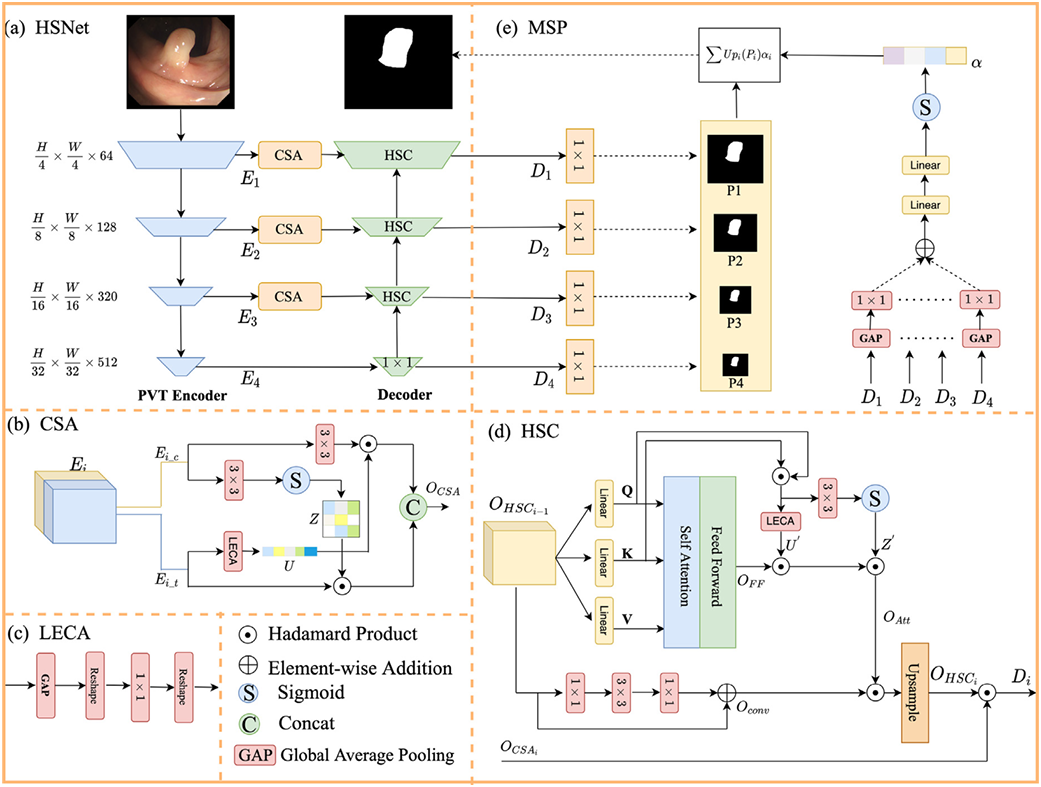

4) HSNet(2022CBM)

1)不同尺度、方向和照明条件下变化的息肉,给准确分割带来了困难。2)目前基于主导的解码器-编码器网络的工作倾向于忽略微小息肉的外观细节(例如纹理),降低了区分息肉的准确性。。。。。。。。在实验中,我们将我们的工作与10种最先进的工作进行了比较,包括最近的和经典的工作,在5个基准数据集上显示出改进的准确性(通过7个评估指标),例如,在Kvasir-SEG上实现了0.926/0.877的mDice/mIoU,在ClinicDB上实现了0.948/0.905的mDice/mIoU,在ColonDB上实现了0.810/0.735的mDice/mIoU,在ETIS上实现了0.808/0.74的mDice/mIoU,在Endoscene上实现了0.903/0.839的mDice/mIoU。所提出的模型可在https://github.com/baiboat/获取。

这个图qiuqiu的,贴上表情包。。。。。。。

自动息肉分割在可靠的临床应用中仍面临许多挑战。这些挑战主要来自息肉丰富的形态多样性以及当前息肉分割模型有限的表示能力。在结肠镜检查的动态过程中,息肉图像是通过镜头移动生成的,从而从不同角度描绘出独特的息肉。此外,镜头的光源可能会在肠黏膜组织液上反射,导致斑点干扰。而且,由于扫描仪器和参数标准的不一致性,不同医疗中心之间息肉成像的领域转移也是一个挑战(如图1所示)。以上所有因素都对息肉检测产生负面影响。此外,深度学习用于视觉任务是一种数据驱动的解决方案。然而,由于其保密性和专业注释,医学图像数据集通常较小。

因此,这项工作的目标是在小数据的医疗场景中构建一个能更好地表示息肉特征的网络。当前对息肉分割的研究主要依赖于CNN[6-8]或Transformer[9,10]。在计算机视觉领域,得益于CNN固有的平移不变性和归纳偏差优势,取得了显著成果[11-15]。此外,随着UNet[16]的出现,U形编码器-解码器CNN网络在生物医学图像分割领域变得流行起来。然而,对于编码器-解码器架构,仍有一些问题需要考虑。在编码器阶段,随着特征尺度的减小,一些小目标和外观细节会丢失,并且很难在编码器阶段恢复。因此,大多数流行的CNN编码器-解码器框架试图通过直接融合在解码器阶段引入同尺度低分辨率语义特征来补充丢失的细节[17-19]。然而,特征表示不一致,导致编码器和解码器之间存在语义差距。而且,这一过程不可避免地会引入背景噪声。此外,CNN[7,20]善于借助局部感受野捕捉邻近细节,但在总结全局上下文方面相对较弱。最近,视觉Transformer在多个视觉任务上取得了与CNN相当的性能。Transformer架构[21,22]使网络能够通过捕捉长距离依赖关系,从全局角度理解语义差异。得益于这种能力,它可以帮助模型做出更可靠的判断,并通过感知全局上下文特征提供更强大的特征表示能力。不幸的是,在分割任务的解码阶段,需要对低分辨率中间特征进行上采样,以获得高分辨率预测掩码。因此,网络恢复详细特征的能力尤为重要。然而,传统的Transformer网络无法建模邻近区域的交互特征,因此对局部细节的表示不够准确。已经提出了将Transformer和CNN直接组合起来分割生物医学图像[23-25]。然而,它们只是进行了简单的结构组合,忽略了两种语义之间的交互。我们提出了一个混合语义网络(HSNet),通过结合CNN和Transformer,旨在分别捕捉息肉中的局部和长期特征。我们的解决方案适应了归纳偏差和全局上下文的有效表示。

2.3 边界感知model

作为引导策略的边缘信息利用最初在目标检测中很流行,并且越来越多地被应用于息肉分割任务。精确的边缘感知表示有助于提高分割精度。

在接下来的部分中,我们将回顾几种在感知和整合边缘信息方面表现出卓越能力的模型。FeDNet [70] 同时优化主体和边缘以提高息肉分割性能。BSCA-Net [57] 利用位平面切片信息有效提取边界信息。BoxPolyp [58] 通过使用框注释来减轻过拟合问题,迭代增强分割模型以生成细粒度的息肉区域。BDG-Net [50] 利用边界分布生成模块聚合高级特征,这些特征被用作补充空间信息,并输入到边界分布引导的解码器中以引导息肉分割。ICBNet [59] 通过整合上下文和边界感知信息,从初步分割和边界预测中增强编码器特征。CLD-Net [60] 采用渐进式策略提取边缘特征,并通过结合局部边缘特征提取模块与局部-全局特征融合模块,解决了下采样过程中特征丢失的问题。BANet [61] 通过注意力感知定位模块确定息肉的主要位置。SFA [22] 通过构建具有区域和边界约束的选择性特征聚合网络来提高分割性能。FCBFormer [52] 充分利用全卷积网络(FCNs)和Transformer的优势进行息肉分割。

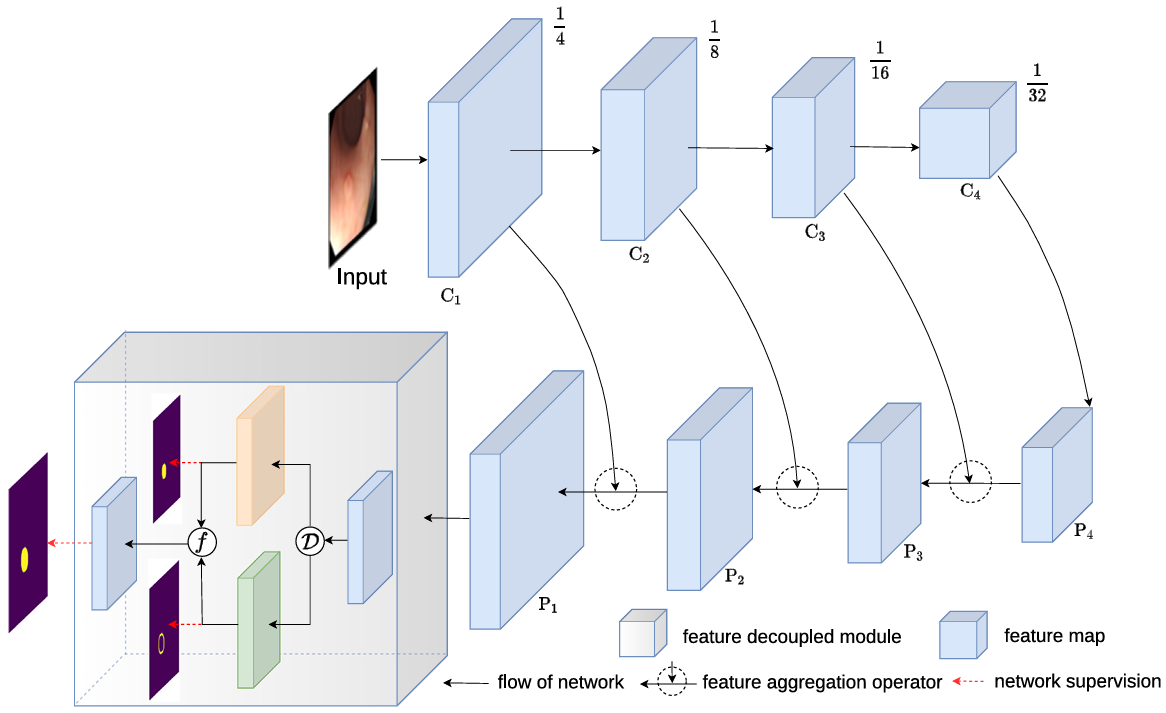

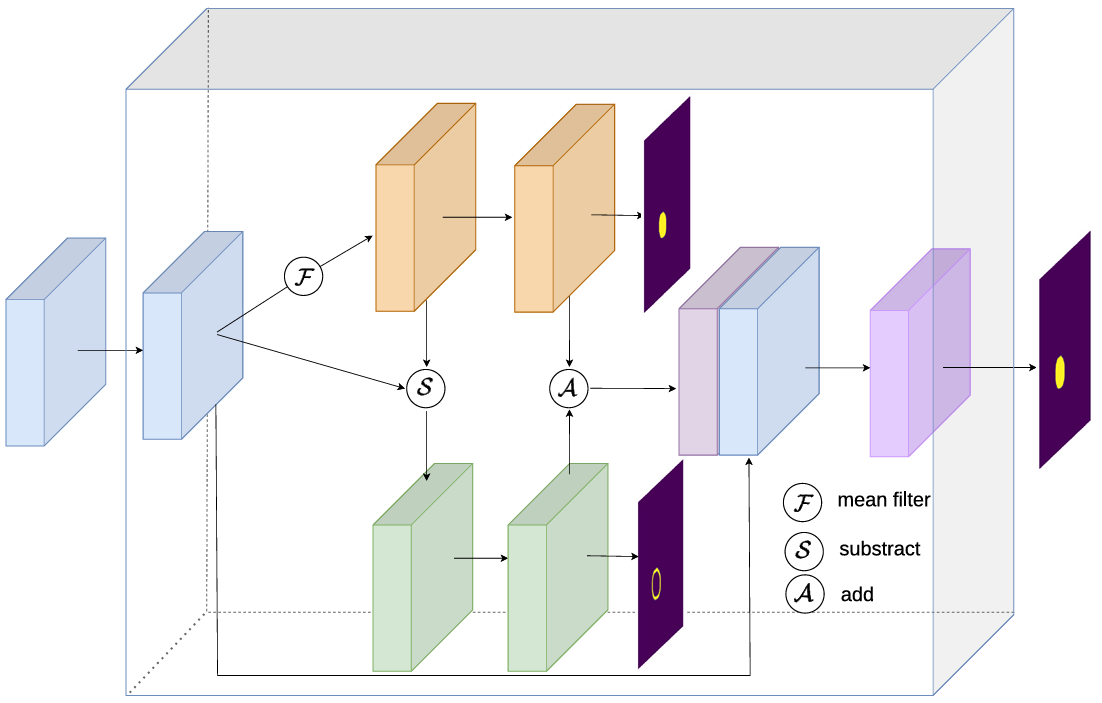

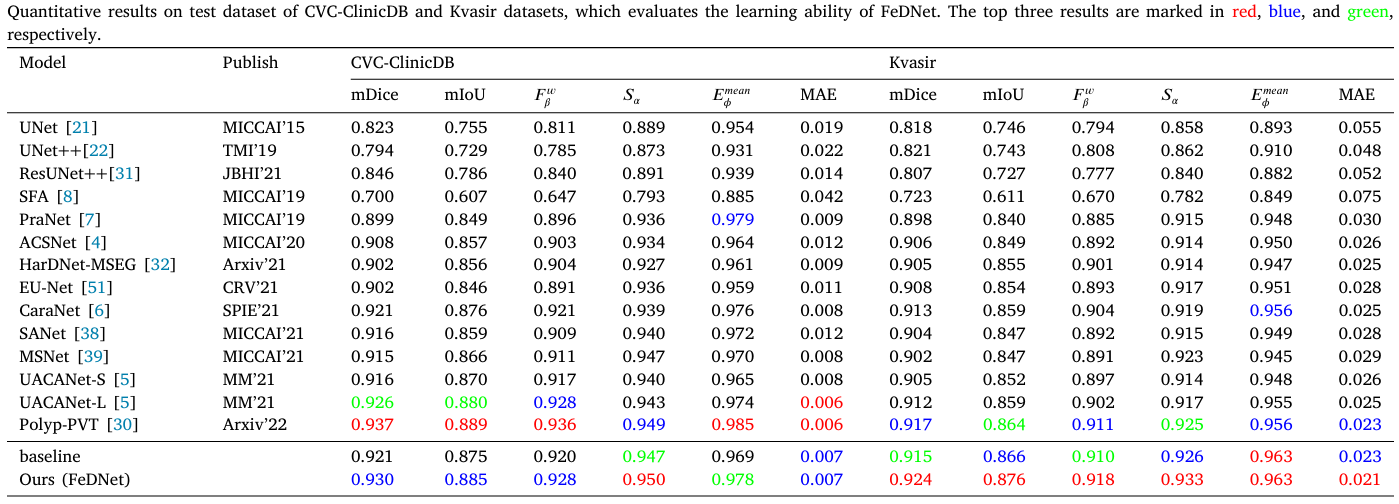

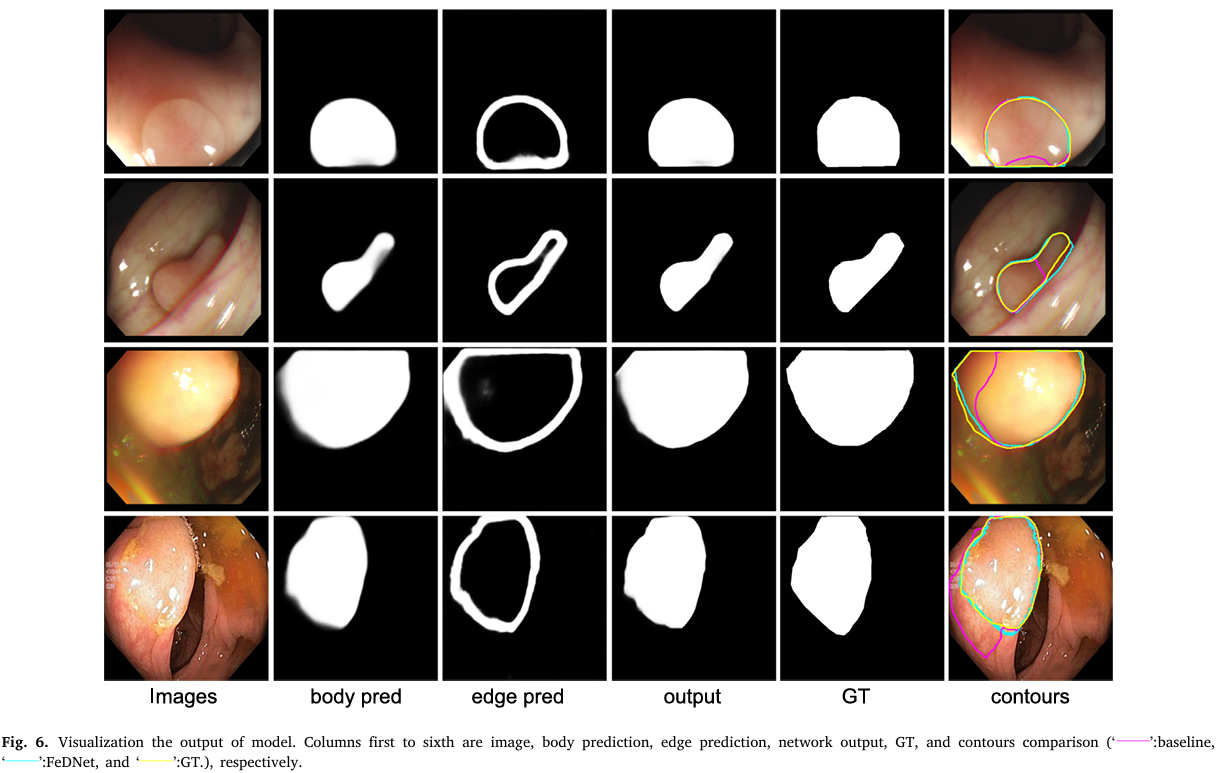

1) FeDNet(2023BSPC)–important

在息肉分割方面,以往的方法无论从全局上下文信息入手以保持息肉内信息的一致性,还是从边缘信息入手以优化预测结果,都存在局限性。因此,要获得良好的息肉分割性能,就需要同时优化这两方面。基于上述分析,我们在本文中探索了如何通过同时优化主体和边缘来提高息肉分割的性能。受拉普拉斯金字塔中特征解耦方法的启发,我们以一种有效且合理的方式明确地将输入特征解耦为主体特征和边缘特征,并通过引入一种新颖的特征解耦模块(Feature Decoupled Module,FDM)进行针对性优化。此外,结合FDM(仅增加0.08M网络参数),我们的方法能够显著优于以往的最先进方法,在基线基础上实现了进一步提升。

在实际医疗场景中的内窥镜图像中的息肉通常表现出各种形状、大小和低对比度,这使得息肉检测具有挑战性。为了说明这一点,我们在图1中展示了几个具有代表性的内窥镜图像。目前,针对这些特征的现有解决方案大致可以分为两类,其中一类考虑引入多尺度或上下文聚合方案以提高类内一致性[3],或者说,保持息肉内部的一致性。。。。。。。。。。。。。。。。。。第二,一些方法考虑利用边缘信息来提高模型性能,特别是对于形状各异或对比度低的息肉[5,7,8]。

理论上,第一种方法利用全局上下文信息来保持息肉主体的一致性。在后一种情况下,纳入边缘信息以提高息肉分割的性能。然而,这些方法只优化主体或边缘,而不是统一两者,这很容易导致分割性能不佳[9,10].。此外,一些方法还研究了在场景图像的语义分割中同时优化边缘和主体。。。。。。。。。。。。。。。。。。。。。然而,以前的方法存在两个缺点。一个是它们没有以合理的方式分离边缘和主体特征,另一个是在实施特征分离时,应该保证被分离的对象既包含高级语义又包含边缘信息。

最终,受拉普拉斯金字塔中的特征分解操作的启发[12],我们提出了一个新颖的特征解耦模块(FDM),其中特征被明确地解耦为低频主体特征和高频边缘特征,在组合成最终表示用于分割之前进行有针对性的优化。具体来说,拉普拉斯金字塔可以用来线性地将图像分解为一组高频和低频分量,从这些分量中可以精确地重建原始图像[12,13]。基于此,我们通过拉普拉斯金字塔分解明确地将特征分解为低频和高频分量。在实现中,可以通过低通滤波器模糊原始特征,然后上采样到原始特征的大小来获得低频分量。而高频分量则是通过从原始特征中减去低频分量生成的。在语义分割中,低频分量和高频分量分别对应于对象的主体和边缘[9,10,13–15]。很新颖的做法,之前没见过。但其实简单来说就是换了一种方式分离边界信息和主体信息,然后对这两者分别进行反向传播。随后,这两个特征分别通过反向传播进行监督和优化。主体特征的学习旨在解决类内不一致性问题,即保持息肉内部的一致性[9]。而边缘部分的优化可以提高边缘的分割性能[10,15]。最后,这两个优化后的特征被组合成综合表示以进行最终预测。

此外,通过将这个FDM整合到基于视觉Transformer的特征金字塔网络(FPN)[16]中,我们得到了最终模型,称为FeDNet。需要注意的是,我们提出的特征解耦技术比以前的特征解耦方法有两大优势。首先,我们的特征解耦方法基于拉普拉斯金字塔中有效且合理的特征分解操作,保证了低频和高频分量的精确分解。其次,我们在FPN的输出特征上进行特征分解,这可以确保被解耦的特征既包含高级语义又包含空间细节信息。基于高级特征的优化更有助于学习鲁棒的表示并提高分割性能[10,15],而空间细节信息则确保了分解后的高频分量的可靠性。此外,另一个令人惊讶的发现是,基于视觉Transformer[17]构建的基线可以获得与当前最先进方法相当的性能。这可能是由于视觉Transformer的引入有效地克服了传统CNN主干网络的感受野限制。此外,它为我们的特征解耦方法提供了足够的全局上下文语义,使类内一致性学习更加有效。

最后,当提出的FDM(仅0.08M网络参数)被整合到基线中时,网络将对边缘和主体进行针对性优化,从而提高整体性能。广泛的实验表明了我们模型的优越性,它在学习能力和泛化方面超过了14种以前的最先进方法,同时在计算效率方面名列前茅,实现了准确性和效率之间的平衡。

图8展示了三种特征解耦方法(包括Flow、FFT和我们的方法)的预测结果的四个案例。从上到下,每一行分别代表Flow、FFT和我们的方法。从左到右,每一列分别显示模型的主体预测结果、边缘预测结果和最终分割结果。前三个案例(a)、(b)和(c)表明,在难以分割的息肉情况下,我们的方法优于Flow和FFT。最后一个案例(d)表明,在一些容易分割的情况下,所有三种方法都能够分割息肉。

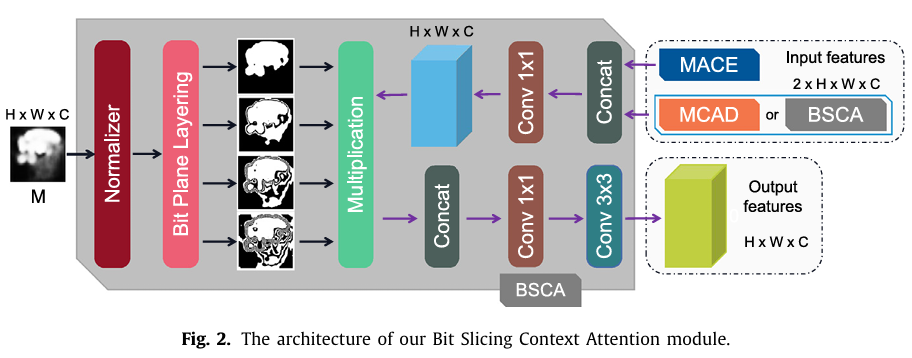

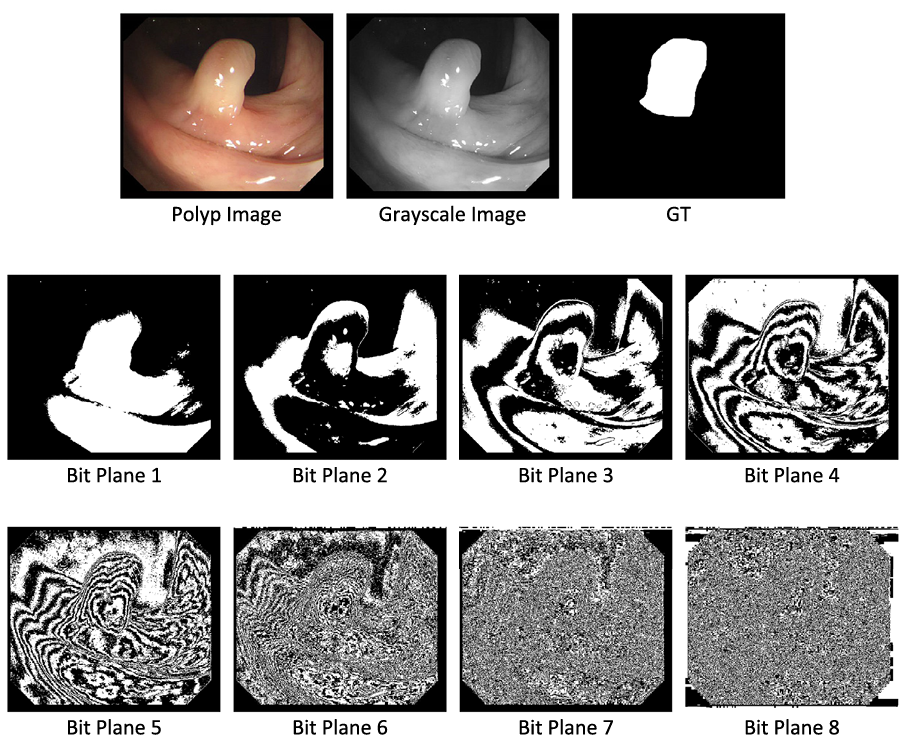

2) BSCA-Net(2022PR)

边缘引导(在SOD中起重要作用)需要额外的边缘数据,这通常会使息肉分割方法遭受计算效率低下的问题。为了获得形状和边界信息,Psi-Net构建了三个平行的解码器用于息肉分割。PraNet引入了反向注意力[10]来反转粗分割图,以获得作为边缘引导的边界线索。SA-Net提出了一个基于不同特征互补性的浅层注意力模块,并将浅层特征与深层特征相乘,以在深层特征中获得更清晰的边界信息。然而,来自Psi-Net、PraNet和SA-Net的边界信息通常模糊不清,这将导致息肉分割的次优性能。

为了解决这一问题,我们开发了一种位切片上下文注意力(BSCA)机制,通过利用位平面切片信息来获取边界信息wow~~~又一个边界信息提取方式。注意,高比特平面包含了大部分有效的边界信息,因为在区域内高比特平面的变化较小。相比之下,低比特平面包含较少的边界线索,并且由于其较大的噪声信息,需要更多的计算资源。因此,我们提出了一个新颖的BSCA模块,它利用高比特平面从全局特征图中捕获有效的边界信息。对于息肉分割,所提出的BSCA模块能够在息肉与其周围环境相似时有效地提取边界信息。

此外,现有的U-Net结构,如U-Net[11]、U-Net++[12]和ResU-Net++[13],通常使用简单的加法或连接操作来逐步融合编码器中的不同级别特征,并将它们传递给解码器。对于特征融合,这两种操作倾向于产生大量冗余信息,这将同时削弱真正有用的特征和特定级别的特征特性,导致息肉的细节不准确和边界粗糙。更具体地说,由于融合操作产生的冗余信息,特征图的表示能力可能会降低,甚至导致丢失对准确息肉分割至关重要的真正有用的特征。

为了解决上述挑战,我们提出了一个新颖的分离-挤压-瓶颈-联合(SSBU)模块,它由分离、挤压、瓶颈和联合操作组成。所提出的SSBU能够从不同方面利用几何信息。具体来说,分离操作生成多个路径,从不同方面利用特征图的几何信息。挤压操作压缩特征图的通道信息以产生通道描述符。瓶颈操作提取通道依赖性以学习每个通道的权重。联合操作符结合和聚合来自多个路径的几何信息。然后,我们设计了一个多路径连接注意力解码器(MCAD),以在融合不同级别的特征时增强特征图的表示能力,以及一个多路径注意力连接编码器(MACE),以提取特定级别特征图的全面信息。

最后,凭借所提出的BSCA、SSBU、MCAD和MACE,我们提出了一个新颖的简单有效的框架,称为位切片上下文注意力网络(BSCA-Net),用于息肉分割。我们在图1中展示了BSCA-Net的整体架构。所提出的BSCA-Net能够提高边界信息的提取能力。

总之,本文的贡献有三个方面:

- 我们提出了一种新颖的注意力机制,通过利用位平面切片信息,用于息肉分割。所提出的注意力机制能够从全局图中捕获边缘引导,并通过高比特平面学习进一步增强特定级别特征图的表示能力。

- 我们设计了一个新颖的SSBU模块,以提取丰富的上下文和几何信息。基于SSBU模块,我们提出了两个有效的解码器和编码器,以提供输入特征的全面表示。

- 广泛的实验表明,我们的方法在息肉分割方面取得了最先进的性能,并优于大多数最先进的模型。特别是在CVC300数据集上,BSCA-Net使平均IoU提高了6.0%,并将平均Dice从88.8%提高到92.7%。

在图像处理中,高比特平面和低比特平面是通过**比特平面分层(Bit-Plane Slicing)**技术得到的。具体来说:

高比特平面:通常包含图像中的主要结构和大范围的灰度变化。这些平面在视觉上具有更重要的意义,因为它们代表了图像的主要特征。例如,在8比特灰度图像中,第8个比特平面(最高位)包含了大部分的视觉信息。

低比特平面:则包含更精细的灰度细节。这些细节对于图像的整体外观贡献较小,但在某些情况下,它们可以提供重要的纹理信息。例如,第1个比特平面(最低位)通常包含更细微的灰度变化。

位切片上下文注意力网络(BSCA-Net)中的应用

在位切片上下文注意力网络(BSCA-Net)中,利用高比特平面来提取边界信息,因为高比特平面包含了更多的结构信息,这对于识别息肉与周围组织的边界非常关键。而低比特平面由于其较大的噪声信息,通常需要更多的计算资源来处理,且对边界信息的贡献较小。因此,BSCA-Net通过利用高比特平面来提高边界信息的提取效率和准确性,同时减少噪声的干扰。

有点没看懂,有能人看懂的请指点一下我

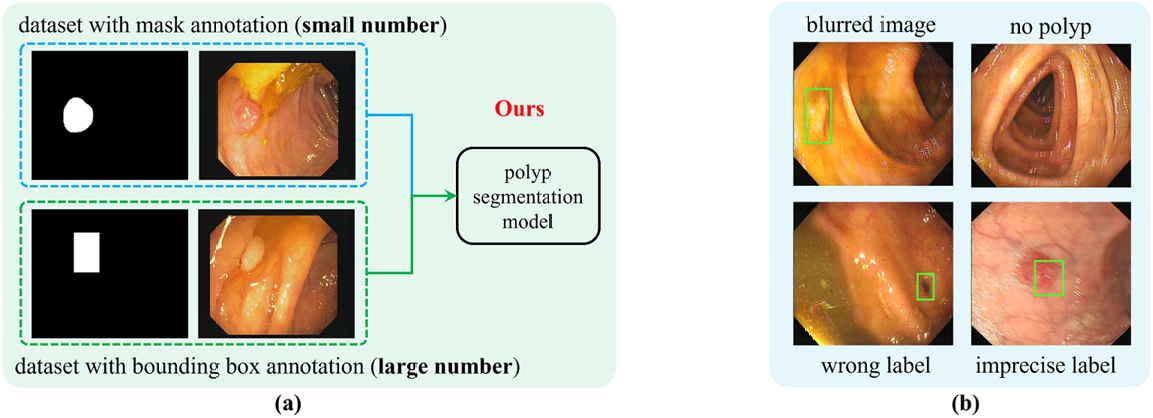

3) BoxPolyp(2022MICCAI)–important:使用bounding box进行辅助分割

啦啦啦,最期待的一篇论文~~~建议和主页的QueryNet搭配起来食用更佳~~~~

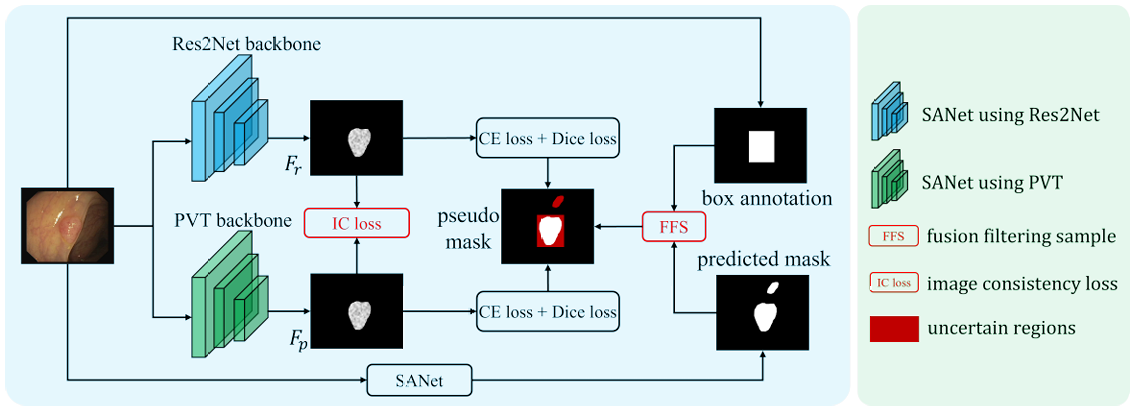

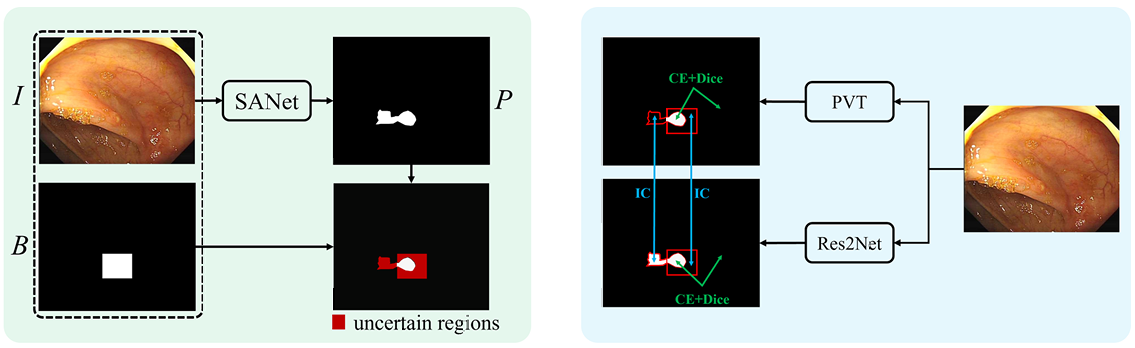

准确的息肉分割对于结直肠癌的诊断和治疗至关重要。然而,由于生成精确掩码注释的成本较高,现有的息肉分割方法面临着严重的数据短缺问题,这限制了模型的泛化能力。相反,粗略的息肉边界框注释更容易获取。因此,本文提出了一种增强的BoxPolyp模型,充分利用精确掩码和额外的粗略边界框注释。在实践中,边界框注释被应用于缓解先前息肉分割模型的过拟合问题,通过迭代增强分割模型生成细粒度的息肉区域。为了实现这一目标,首先提出了一个融合滤波采样(Fusion Filter Sampling, FFS)模块,用于从边界框注释中生成噪声较少的像素级伪标签,从而显著提高性能。此外,考虑到同一息肉的外观一致性,设计了一种图像一致性(Image Consistency, IC)损失。这种IC损失明确地缩小了两个不同网络提取的特征之间的距离,从而提高了模型的鲁棒性。需要注意的是,我们的BoxPolyp是一个即插即用的模型,可以合并到任何吸引人的主干网络中。在五个具有挑战性的基准测试中的定量和定性实验结果证实,我们提出的模型在很大程度上优于先前的最先进的方法

然而,这些模型总是受到数据短缺的困扰,并且存在严重的过拟合问题。自U-Net[17]和FCN[13]流行以来,大多数息肉分割模型[7,23]都基于卷积神经网络(CNNs),这些模型优于传统的手工制作方法,但对数据的需求很大。不幸的是,精确标记息肉掩码是一项耗时且繁琐的工作,需要逐像素操作。因此,现有的息肉分割数据集相对较小。特别是,广泛采用的息肉训练集[7,23]仅包含1451张图像,这对于训练一个大型CNN模型来说远远不够。因此,在该数据集上训练的模型表现出不稳定的性能,并且对噪声敏感,这阻碍了其在实际临床中的应用。

为了提供有效的临床辅助,迫切需要一个泛化的息肉分割模型。在本文中,我们尝试通过使用额外的粗略边界框注释来扩展小的分割数据集来实现这一目标。具体来说,采用了一个大规模公开发布的息肉检测数据集LDPolypVideo[14],该数据集包含160个息肉视频剪辑,共40266帧。尽管所有这些图像都只有粗略的边界框注释,但它们提供了足够的息肉外观信息,并且成本要低得多。

为了充分利用LDPolypVideo注释的优点并减少其缺点,我们提出了新颖的BoxPolyp模型,该模型主要由两个模块组成:融合滤波采样和图像一致性损失。在实践中,融合滤波采样(FFS)旨在为LDPolypVideo中每张图像的高置信度区域生成伪标签。通过结合原始边界框注释和从小型息肉分割数据集训练的模型得出的预测掩码,FFS能够高效地为确定性区域生成像素级伪掩码。对于不确定区域,伪掩码不准确,因此被丢弃。然而,这些被丢弃的区域也包含有价值的信息。为了充分探索这些区域,我们提出了图像一致性(IC)损失,而不是生成伪掩码。IC损失应用两个不同的网络从同一图像中提取特征,并明确减少不确定区域特征之间的距离。通过强制特征对齐,我们的模型可以学习到鲁棒的息肉特征表示,而无需掩码注释。

总结来说,我们的贡献有三个方面:(1)我们首次通过额外的边界框注释增强了一个泛化的息肉分割模型。(2)我们提出了融合滤波采样来生成噪声较少的伪掩码,并设计了图像一致性损失来增强不确定区域的特征鲁棒性。(3)我们提出的BoxPolyp是一个即插即用的模型,可以使用不同的主干网络大幅增强息肉分割性能。

图1(a)展示了我们方法的核心思想。通过少量带有掩码注释的图像和大量带有边界框注释的图像进行训练,可以实现更泛化的息肉分割模型。然而,直接应用LDPolypVideo的边界框注释是次优的。因为边界框区域包含许多背景像素。将边界框区域作为息肉掩码将带来大量噪声。此外,如图1(b)所示,LDPolypVideo包含许多模糊的图像、没有息肉的图像、错误的标签和不精确的标签,这些也会误导模型训练。

图2展示了我们提出的BoxPolyp模型的流程。首先,使用在小规模息肉分割数据集上训练的SANet[23]来预测每个边界框注释图像的像素级掩码。然后,融合滤波采样(FFS)模块结合预测掩码和边界框注释,以获得确定性区域作为伪标签。对于不确定区域,我们提出了图像一致性(IC)损失,以减少从两个不同主干网络(即Res2Net[9]和PVT[22])提取的特征之间的距离。

图3展示了融合滤波采样模块生成的细化伪掩码,包括前景、背景和不确定区域。对于确定性区域和不确定区域,采用不同的监督方式。

4) BDG-Net

5) ICBNet

6) CLD-Net

7) BANet

8) SFA

9) FCBFormer

2.4 注意力感知model

在息肉分割中取得卓越性能需要具备优先处理相关信息的能力。通过引入注意力机制,这一问题可以得到有效解决。这使得模型能够专注于最重要的特征,从而最终提升分割性能。

CASCADE [74] 利用分层视觉Transformer架构中的多尺度特征。APCNet [64] 从金字塔结构中提取多级特征,并利用注意力引导的多级聚合策略来增强每一层的上下文特征。RA-DENet [65] 通过逆注意力增强不同区域的表示,然后通过消除干扰来去除噪声。TGANet [43] 融入了文本注意力机制,利用与息肉大小和数量相关的特征来适应不同大小的息肉,并有效处理多息肉场景。LDNet [48] 从输入图像中提取全局上下文特征,然后根据分割预测的病变特征迭代更新这些特征。SANet [8] 通过颜色交换操作消除颜色的影响,然后基于浅层注意力模块从浅层特征中过滤掉背景噪声。

1) CASCADE

2) APCNet

3) RA-DENet

4) TGANet

5) LDNet

6) SANet

2.5 特征融合model

为了有效处理目标尺寸的变化,整合多尺度特征是至关重要的。此外,通过特征融合整合多级特征,并利用高级和低级特征,可以显著提升分割性能。在息肉分割任务中,为了实现这一目标,各种特征融合策略已被采用。

CFA-Net [75] 是一种新颖的跨层级特征聚合网络,它采用分层策略将边缘特征整合到双流分割网络中。EFB-Seg [66] 通过引入一个特征融合模块来增强多级特征融合,该模块利用学习到的语义偏移场对齐多级特征图,从而解决了特征错位的问题。MSRF-Net [29] 创新性地使用了双尺度密集融合块来交换具有不同感受野的多尺度特征。DCRNet [53] 捕获了图像内和图像间的上下文关系。在图像内,提出了一个位置注意力模块来捕获像素级上下文信息。PPNet [67] 在金字塔特征融合模块中采用通道注意力方案来学习全局上下文特征,从而指导解码器分支的信息转换。PraNet [26] 使用并行部分解码器聚合高级特征,使用反向注意力模块挖掘边界线索,并建立区域和边界线索之间的关系。PolypSeg [24] 聚合多尺度上下文信息,并使用改进的注意力机制聚焦于目标区域。

1) CFA-Net

2) EFB-Seg

3) MSRF-Net

4) DCRNet

5) PPNet

6) PraNet

7) PolypSeg

2.6 视频息肉分割

为了便于在临床环境中部署自动分割方法,一些研究已将重点转向基于视频的息肉分割方法。通过考虑时间信息,这些方法旨在克服单图像分割的局限性,并在临床要求的实时场景中实现更精确、更高效的分割。ESFPNet [72] 构建了一个预训练的混合Transformer(MiT)编码器和一个高效的分阶段特征金字塔解码器,其中MiT使用重叠路径合并模块和自注意力预测。PNS+ [84] 使用全局编码器和局部编码器提取长期时空表示,并通过归一化自注意力块逐步细化它们。SSTAN [85] 提出了一种半监督视频息肉分割任务,该任务仅需要稀疏注释的帧进行训练。PNS-Net [86] 利用标准自注意力模块和CNN,无需后处理即可实时从息肉视频中高效学习表示。NanoNet [87] 参数较少,可与移动和嵌入式设备集成。它使用预训练的MobileNetV2 [88] 作为编码器。在编码器和解码器之间的架构中,纳入了一个改进的残差块,以增强解码器的泛化能力。